Vue d’ensemble de l’activité

Cet article vous aide à comprendre les activités dans Microsoft Fabric et à les utiliser pour créer des workflows pilotés par les données de bout en bout pour vos scénarios de déplacement et de traitement des données.

Vue d’ensemble

Un Microsoft Fabric Workspace peut avoir un ou plusieurs pipelines. Un pipeline constitue un regroupement logique d’activités qui exécutent ensemble une tâche. Par exemple, un pipeline peut contenir un ensemble d’activités qui ingèrent et nettoient les données de journal, puis lancent un flux de données pour analyser les données du journal. Le pipeline vous permet de gérer les activités en tant que groupe et non pas individuellement. Vous pouvez déployer et planifier le pipeline, plutôt que chaque activité séparément.

Les activités d’un pipeline définissent les actions à effectuer sur les données. Par exemple, vous pouvez utiliser une activité de copie pour copier des données d’un serveur SQL Server local vers le Stockage Blob Azure. Ensuite, utilisez une activité Dataflow ou une activité Notebook pour traiter et transformer les données du stockage d'objets blob en un pool Azure Synapse Analytics sur lequel sont construites des solutions de création de rapports de Business Intelligence.

Microsoft Fabric comporte trois types d'activités : les activités de déplacement de données, les activités de transformation de données et les activités de contrôle.

Activités de déplacement des données

L'activité de copie dans Microsoft Fabric copie les données d'un magasin de données source vers un magasin de données récepteur. Fabric prend en charge les magasins de données répertoriés dans l'article de présentation du connecteur. Les données de n’importe quelle source peuvent être écrites dans n’importe quel récepteur.

Pour plus d'informations, voir Comment copier des données à l'aide de l'activité Copy.

Activités de transformation des données

Microsoft Fabric prend en charge les activités de transformation suivantes qui peuvent être ajoutées individuellement ou enchaînées avec une autre activité.

Pour plus d’informations, consultez l’article Activités de transformation des données.

| Activités de transformation des données | Environnement de calcul |

|---|---|

| Copie de données | Gestionnaire de calcul par Microsoft Fabric |

| Dataflow Gen2 | Gestionnaire de calcul par Microsoft Fabric |

| Supprimer des données | Gestionnaire de calcul par Microsoft Fabric |

| Notebook Fabric | Clusters Apache Spark gérés par Microsoft Fabric |

| Activité de HDInsight | Clusters Apache Spark gérés par Microsoft Fabric |

| Définition de la tâche Spark | Clusters Apache Spark gérés par Microsoft Fabric |

| Procédure stockée | Azure SQL, Azure Synapse Analytics ou SQL Server |

| Script SQL | Azure SQL, Azure Synapse Analytics ou SQL Server |

Activités de flux de contrôle

Les activités de flux de contrôle suivantes sont prises en charge :

| Activité de contrôle | Description |

|---|---|

| Ajouter une variable | Ajoutez une valeur à une variable de tableau existante. |

| Activité Azure Batch | Exécute un script Azure Batch. |

| Activité Azure Databricks | Exécute un travail Azure Databricks (Notebook, Jar, Python). |

| Activité Azure Machine Learning | Exécute un travail Azure Machine Learning. |

| Désactiver une activité | Désactive une autre activité. |

| Échec | Provoquez l'échec de l'exécution du pipeline avec un message d'erreur personnalisé et un code d'erreur. |

| Filter | Appliquez une expression de filtre à un tableau d'entrée. |

| ForEach | L’activité ForEach définit un flux de contrôle répétitif dans votre pipeline. Elle permet d’effectuer une itération sur une collection, et exécute des activités spécifiées dans une boucle. L’implémentation en boucle de cette activité est semblable à la structure d’exécution en boucle de Foreach dans les langages de programmation. |

| Activité Functions | Exécute une fonction Azure. |

| Obtenir les métadonnées | L’activité GetMetadata peut être utilisée pour récupérer les métadonnées de n’importe quelle donnée dans un pipeline Data Factory ou Synapse. |

| If Condition | L’activité IfCondition peut être utilisée pour créer une branche en fonction de l’évaluation d’une condition par la valeur true ou false. L’activité IfCondition fournit les mêmes fonctionnalités qu’une instruction «if » dans les langages de programmation. La condition évalue un ensemble d’activités si l’expression retourne true et un autre ensemble d’activités si elle retourne false. |

| Appeler un pipeline | L’activité Execute Pipeline permet à un pipeline Data Factory ou Synapse d’appeler un autre pipeline. |

| Activité KQL | Exécute un script KQL sur une instance Kusto. |

| Activité de recherche | L’activité de recherche peut être utilisée pour lire ou rechercher un enregistrement, un nom de table ou une valeur à partir de n’importe quelle source externe. Cette sortie peut être référencée par des activités complémentaires. |

| Définir une variable | Récupérez la valeur d'une variable existante. |

| Activité Switch | Implémente une expression switch qui autorise plusieurs activités suivantes pour chaque résultat potentiel de l’expression. |

| Activité Teams | Publie un message dans un canal ou une conversation de groupe Teams. |

| Activité Until | Implémente une boucle Exécuter jusqu’à semblable à la structure Do-Until des langages de programmation. Elle exécute un ensemble d’activités dans une boucle jusqu’à ce que la condition associée à l’activité retourne la valeur true. Vous pouvez spécifier une valeur de délai d’attente pour l’activité Until. |

| Activité d’attente | Lorsque vous utilisez une activité Wait dans un pipeline, celui-ci attend pendant la période spécifiée avant de poursuivre l'exécution des activités suivantes. |

| Activité Web | L’activité Web peut être utilisée pour appeler un point de terminaison REST personnalisé à partir d’un pipeline. |

| Activité de webhook | À l'aide de l'activité de Webhook, appelez un point de terminaison et transmettez une URL de rappel. L’exécution du pipeline attend que le rappel soit appelé avant de passer à l’activité suivante. |

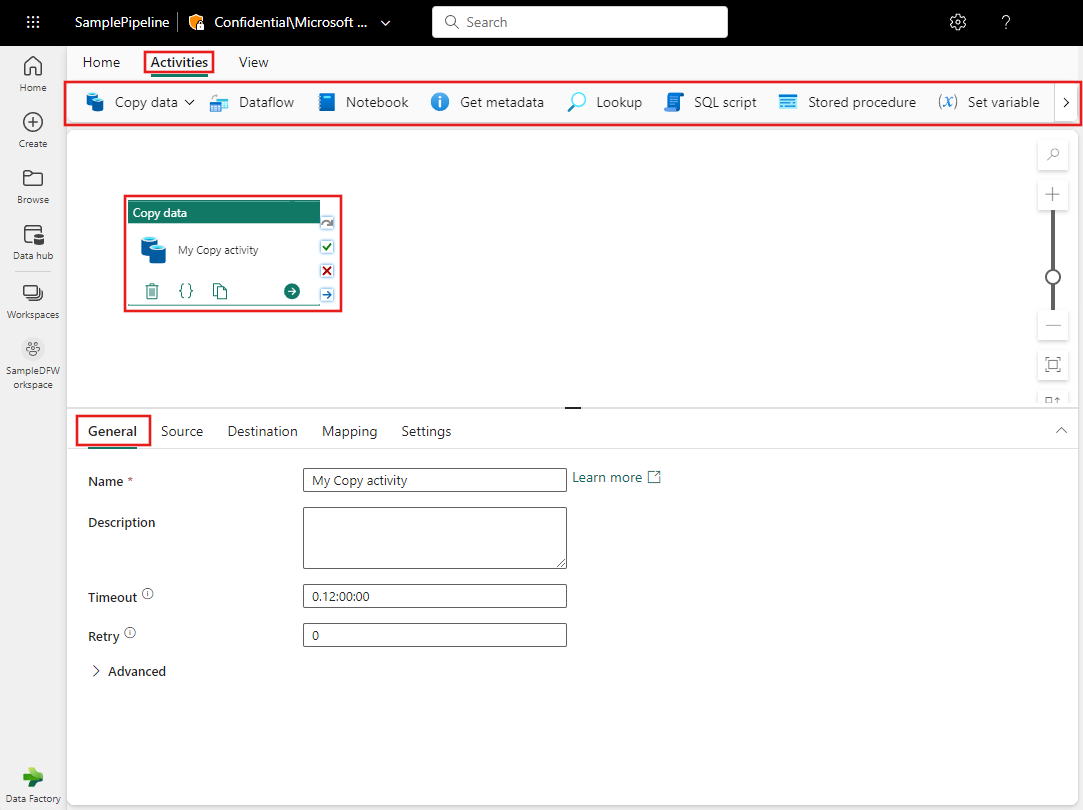

Ajout d'activités à un pipeline avec l'interface utilisateur Microsoft Fabric

Utilisez ces étapes pour ajouter et configurer des activités dans un pipeline Microsoft Fabric :

- Créez un nouveau pipeline dans votre espace de travail.

- Dans l'onglet Activités du pipeline, parcourez les activités affichées, en faisant défiler vers la droite si nécessaire pour voir toutes les activités. Sélectionnez une activité pour l'ajouter à l'éditeur de pipeline.

- Lorsque vous ajoutez une activité et que vous la sélectionnez dans le canevas de l'éditeur de pipeline, ses paramètres généraux s'affichent dans le volet des propriétés sous le canevas.

- Chaque activité contient également des propriétés personnalisées spécifiques à sa configuration sur d'autres onglets du volet des propriétés.

Paramètres généraux :

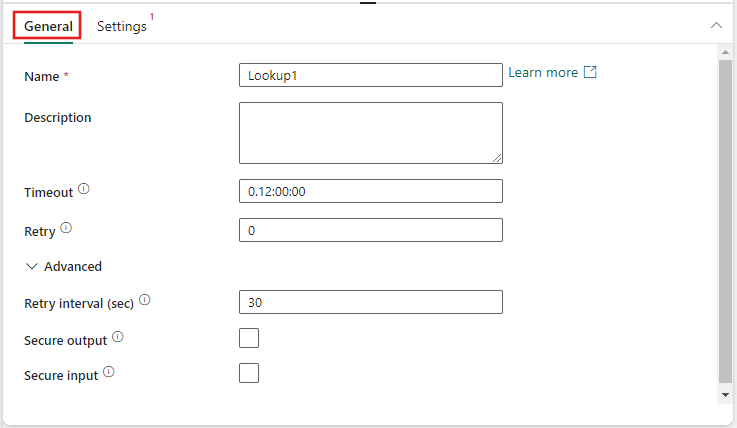

Lorsque vous ajoutez une nouvelle activité à un pipeline et que vous la sélectionnez, vous verrez ses volets de propriétés dans la zone en bas de l'écran. Ces volets de propriétés incluent Général, Paramètres et parfois d'autres volets également.

Les paramètres généraux incluront toujours les champs Nom et Description pour chaque activité. Certaines activités comprennent également les éléments suivants :

| Paramètre | Description |

|---|---|

| Délai d'expiration | La durée maximale d'exécution d'une activité. La valeur par défaut est de 12 heures et la durée maximale autorisée est de sept jours. Le format du délai d'attente est en D.HH:MM:SS. |

| Réessayer | Nombre maximal de nouvelles tentatives. |

| (Propriétés avancées) Intervalle entre les tentatives (sec) | Le nombre de secondes entre chaque nouvelle tentative. |

| (Propriétés avancées) Sortie sécurisée | Lorsque cette case est cochée, la sortie de l'activité n'est pas capturée dans la journalisation. |

| (Propriétés avancées) Saisie sécurisée | Lorsque cette case est cochée, l’entrée de l'activité n'est pas capturée dans la journalisation. |

Remarque

Il s’agit de la limite souple par défaut d’un maximum de 80 activités par pipeline, notamment les activités internes relatives aux conteneurs.