在事件流中添加和管理事件源

创建事件流后,可以将其连接到各种数据源和目标。

注意

现在,创建事件流时,将会默认启用增强功能。 如果你有使用标准功能创建的事件流,则这些事件流将继续正常工作。 你仍然可以像往常一样编辑和使用它们。 建议创建新的事件流来替换标准事件流,以便可以利用增强型事件流的其他功能和优势。

创建事件流后,可以将其连接到各种数据源和目标。

事件流不仅允许从 Microsoft 源流式传输数据,还支持通过新的消息传送连接器从第三方平台(如 Google Cloud 和 Amazon Kinesis)引入数据。 这种扩展的功能提供外部数据流与 Fabric 的无缝集成,带来更大的灵活性,使你能够从多个源获取实时见解。

在本文中,你将了解可添加到事件流的事件源。

先决条件

- 使用“参与者”权限或更高权限在 Fabric 容量许可证模式(或)试用许可证模式下访问工作区。

- 特定于以下源特定文章中记录的每个源的先决条件。

支持的源

具有增强功能的 Fabric 事件流支持以下源。 每篇文章都提供了添加特定源的详细信息和说明。

| 来源 | 说明 |

|---|---|

| Azure 事件中心 | 如果你有 Azure 事件中心,可以使用 Eventstream 将事件中心数据引入 Microsoft Fabric。 |

| Azure IoT 中心 | 如果你有 Azure IoT 中心,可以使用 Eventstream 将 IoT 数据引入 Microsoft Fabric。 |

| Azure SQL 数据库变更数据捕获 (CDC) | 通过使用 Azure SQL 数据库 CDC 源连接器,你可以捕获 Azure SQL 数据库中当前数据的快照。 然后,连接器将监视并记录对此数据进行的任何未来的行级别更改。 |

| PostgreSQL 数据库 CDC | 通过使用 Postgre SQL 数据库变更数据捕获 (CDC) 源连接器,你可以捕获 PostgreSQL 数据库中当前数据的快照。 然后,连接器将监视并记录对此数据进行的任何未来的行级别更改。 |

| MySQL 数据库 CDC | 通过使用 Azure MySQL Database 变更数据捕获 (CDC) 源连接器,你可以捕获 Azure Database for MySQL 数据库中当前数据的快照。 你可以指定要监视的表,事件流将记录对表进行的任何未来的行级更改。 |

| Azure Cosmos DB CDC | 通过使用 Microsoft Fabric 事件流的 Azure Cosmos DB 变更数据捕获 (CDC) 源连接器,你可以捕获 Azure Cosmos DB 数据库中当前数据的快照。 然后,连接器将监视并记录对此数据进行的任何未来的行级别更改。 |

| 虚拟机 (VM) 上的 SQL Server 数据库 (DB) CDC | Fabric 事件流的 VM DB 上的 SQL Server (CDC) 源连接器可支持捕获VM 上的 SQL Server 数据库中当前数据的快照。 然后,连接器将监视并记录对此数据进行的任何未来的行级别更改。 |

| Azure SQL 托管实例 CDC | 通过用于 Microsoft Fabric 事件流的 Azure SQL 托管实例 CDC 源连接器,你可以捕获 SQL 托管实例数据库中当前数据的快照。 然后,连接器将监视并记录对此数据进行的任何未来的行级别更改。 |

| Google Cloud Pub/Sub | Google Pub/Sub 是一种消息传递服务,可用于发布和订阅事件流。 你可以将 Google Pub/Sub 作为源添加到事件流,以捕获、转换实时事件并将其路由到 Fabric 中的各种目标。 |

| Amazon Kinesis 数据流 | Amazon Kinesis 数据流是一种可大规模伸缩、高度持久的数据引入和处理服务,针对流式传输数据进行了优化。 通过将 Amazon Kinesis 数据流作为事件流中的源集成,可以在将实时数据流路由到 Fabric 中的多个目标之前对其进行无缝处理。 |

| Confluent Cloud Kafka | Confluent Cloud Kafka 是一个流式处理平台,该平台使用 Apache Kafka 提供强大的数据流式处理和处理功能。 通过将 Confluent Cloud Kafka 作为事件流中的源集成,可以在将实时数据流路由到 Fabric 中的多个目标之前对其进行无缝处理。 |

| Amazon MSK Kafka | Amazon MSK Kafka 是一种完全托管的 Kafka 服务,可简化设置、缩放和管理。 通过将 Amazon MSK Kafka 作为事件流中的源集成,可以无缝地将 MSK Kafka 中的实时事件引入其中,并在将事件路由到 Fabric 中的多个目标之前对其进行处理。 |

| 示例数据 | 可以选择“自行车”“黄色出租车”或“股票市场事件”作为示例数据源,以在设置事件流时测试数据引入。 |

| 自定义终结点(即标准功能的自定义应用) | 自定义终结点功能让你的应用程序或 Kafka 客户端可以使用连接字符串连接到 Eventstream,从而顺利地将流数据引入到 Eventstream 中。 |

| Azure 服务总线(预览版) | 可以使用 Eventstream 将数据从 Azure 服务总线队列或主题的订阅引入到 Microsoft Fabric 中。 |

| Apache Kafka(预览版) | Apache Kafka 是一个开源分布式平台,用于构建可缩放的实时数据系统。 通过将 Apache Kafka 作为事件流中的源集成,可以无缝地从 Apache Kafka 引入实时事件,并在将事件路由到 Fabric 中的多个目标之前对其进行处理。 |

| Azure Blob 存储事件(预览版) | 当客户端创建、替换或删除 Blob 时,将触发 Azure Blob 存储事件。 连接器允许你将 Blob 存储事件链接到实时中心的 Fabric 事件。 你可以将这些事件转换为连续数据流,并在将其路由到 Fabric 中的各种目标之前对其进行转换。 |

| Fabric 工作区项事件(预览版) | Fabric 工作区项事件是对 Fabric 工作区进行更改时发生的离散 Fabric 事件。 这些更改包括创建、更新或删除 Fabric 项。 使用 Fabric 事件流,可以捕获这些 Fabric 工作区事件,转换这些事件,并将其路由到 Fabric 中的各种目标,以作进一步分析。 |

| Fabric OneLake 事件(预览版) | OneLake 事件允许你订阅 OneLake 中文件和文件夹的更改,然后实时响应这些更改。 使用 Fabric 事件流,可以捕获这些 OneLake 事件、转换事件并将其路由到 Fabric 中的各种目标,以便进一步分析。 在 Fabric 事件流中无缝集成 OneLake 事件可让你更灵活地监视和分析 OneLake 中的活动。 |

| Fabric 作业事件(预览版) | 通过作业事件,可以订阅 Fabric 运行作业时生成的更改。 例如,可以在刷新语义模型、运行计划管道或运行笔记本时对更改做出反应。 其中每个活动都可以生成相应的作业,这反过来又生成一组相应的作业事件。 使用 Fabric 事件流,可以捕获这些作业事件、转换事件并将其路由到 Fabric 中的各种目标,以便进一步分析。 在 Fabric 事件流中,无缝地将作业事件集成,可以让你在监视和分析作业内的活动时更加灵活。 |

注意

一个事件流的源和目标的最大数量为 11。

相关内容

先决条件

开始之前,你必须满足以下先决条件:

- 使用“参与者”权限或更高权限在 Fabric 容量许可证模式(或)试用许可证模式下访问工作区。

- 要将 Azure 事件中心或 Azure IoT 中心添加为事件流源,你需要具有访问其策略密钥的相应权限。 它们必须可供公开访问,并且不能位于防火墙后面或在虚拟网络中受到保护。

支持的源

Fabric 事件流支持以下源。 使用表中的链接导航到相关文章,了解有关添加特定源的更多详细信息。

| 来源 | 说明 |

|---|---|

| Azure 事件中心 | 如果你有 Azure 事件中心,可以使用 Eventstream 将事件中心数据引入 Microsoft Fabric。 |

| Azure IoT 中心 | 如果你有 Azure IoT 中心,可以使用 Eventstream 将 IoT 数据引入 Microsoft Fabric。 |

| 示例数据 | 可以选择“自行车”“黄色出租车”或“股票市场事件”作为示例数据源,以在设置事件流时测试数据引入。 |

| 自定义应用 | 自定义应用功能让你的应用程序或 Kafka 客户端可以使用连接字符串连接到 Eventstream,从而顺利地将流数据引入到 Eventstream 中。 |

注意

一个事件流的源和目标的最大数量为 11。

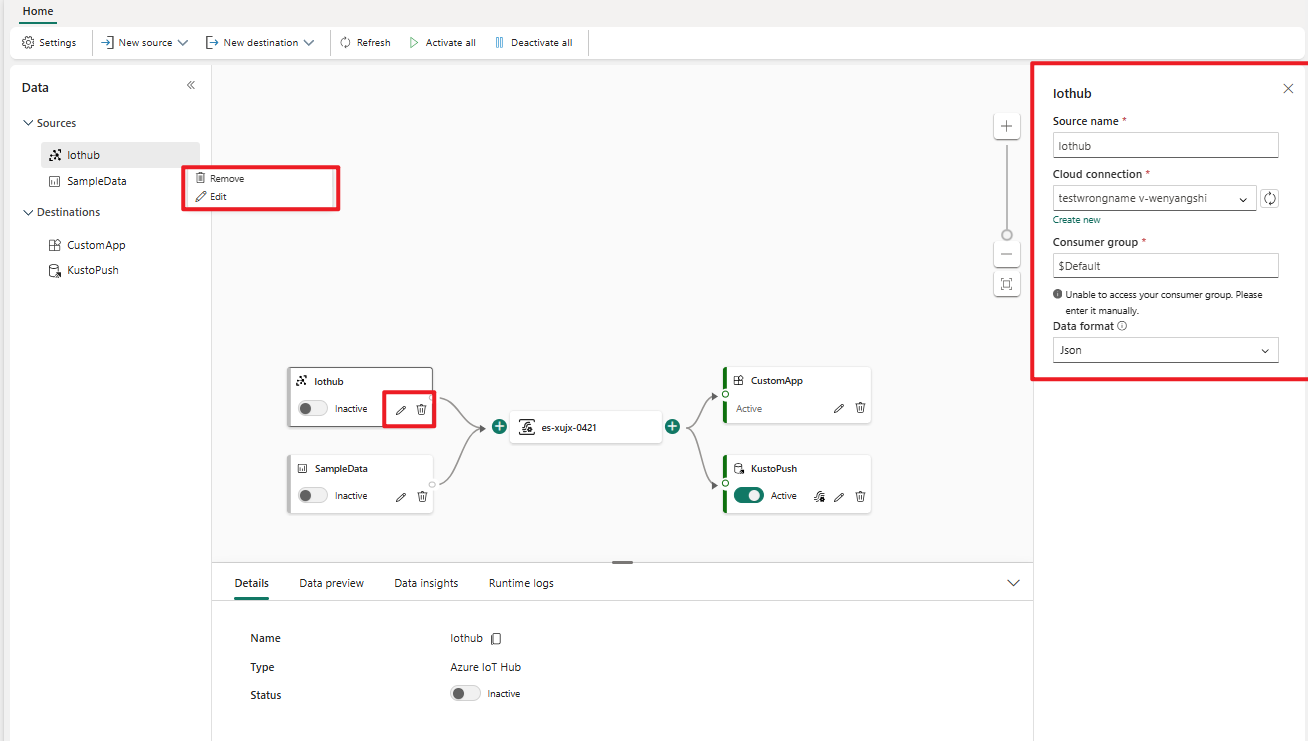

管理源

编辑/删除:可通过导航窗格或画布,选择要编辑或移除的事件流源。 选择“编辑”时,会在主编辑器的右侧打开编辑窗格。

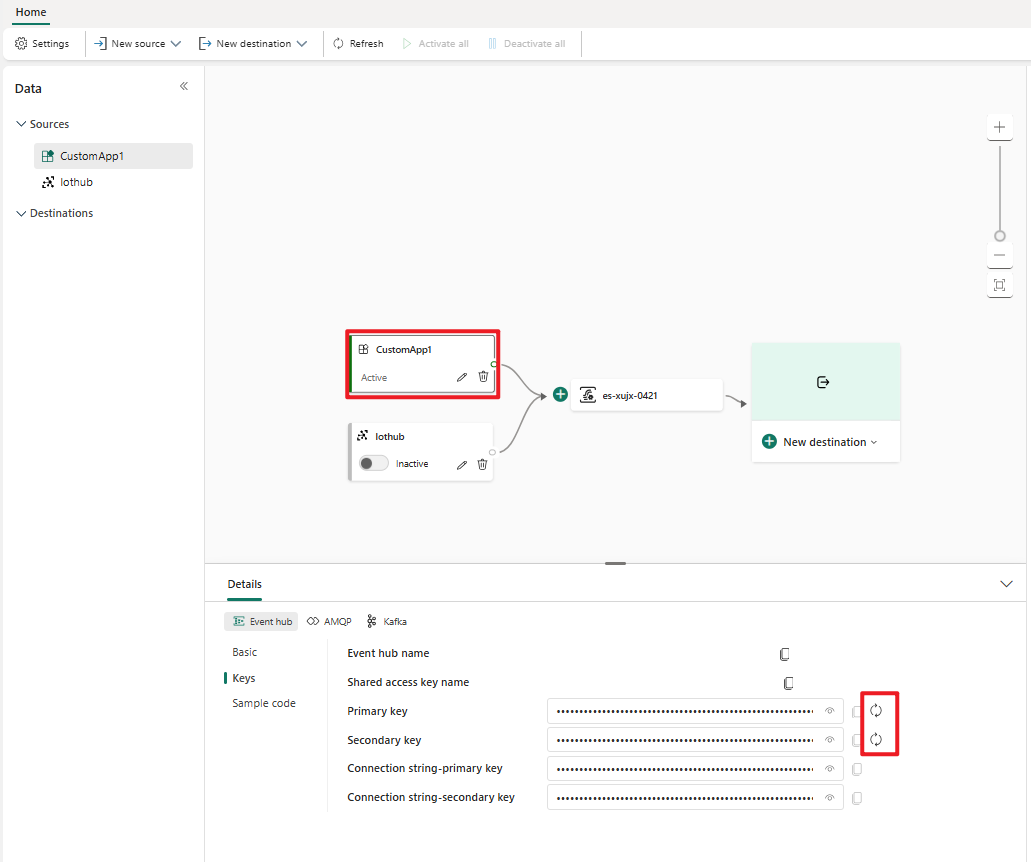

为自定义应用重新生成密钥:如果要为应用程序重新生成新的连接密钥,请在画布上选择一个自定义应用源,然后选择“重新生成”来获取新的连接密钥。