将 Apache Kafka 源添加到 Eventstream(预览)

本文介绍如何将 Apache Kafka 源添加到 Eventstream。

Apache Kafka 是一个开源分布式平台,用于构建可缩放的实时数据系统。 通过将 Apache Kafka 作为事件流中的源集成,可以从 Apache Kafka 无缝引入实时事件,并在路由到 Fabric 中的多个目标之前对其进行处理。

注意

工作区容量的以下区域不支持此源:美国西部 3、瑞士西部。

先决条件

- 使用参与者或更高权限访问 Fabric 工作区。

- 正在运行的 Apache Kafka 群集。

- Apache Kafka 必须可供公开访问,并且不能位于防火墙后面或在虚拟网络中受到保护。

注意

一个事件流的源和目标的最大数量为 11。

将 Apache Kafka 添加为源

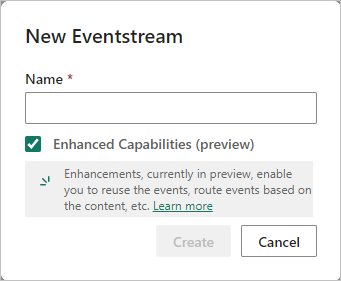

在“Fabric 实时智能”中,选择“Eventstream” 以创建新的事件流。

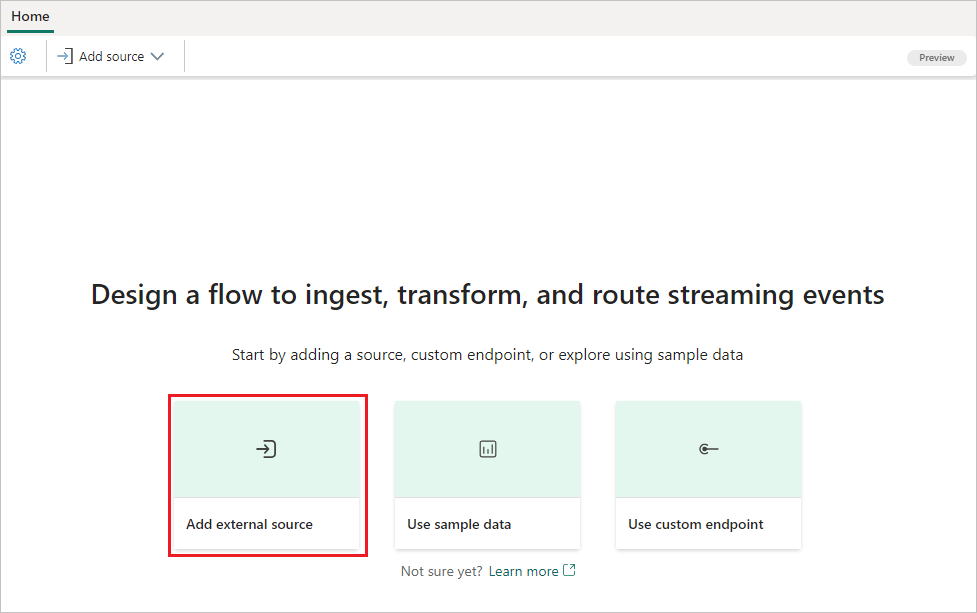

在下一个屏幕上,选择“添加外部源”。

配置并连接到 Apache Kafka

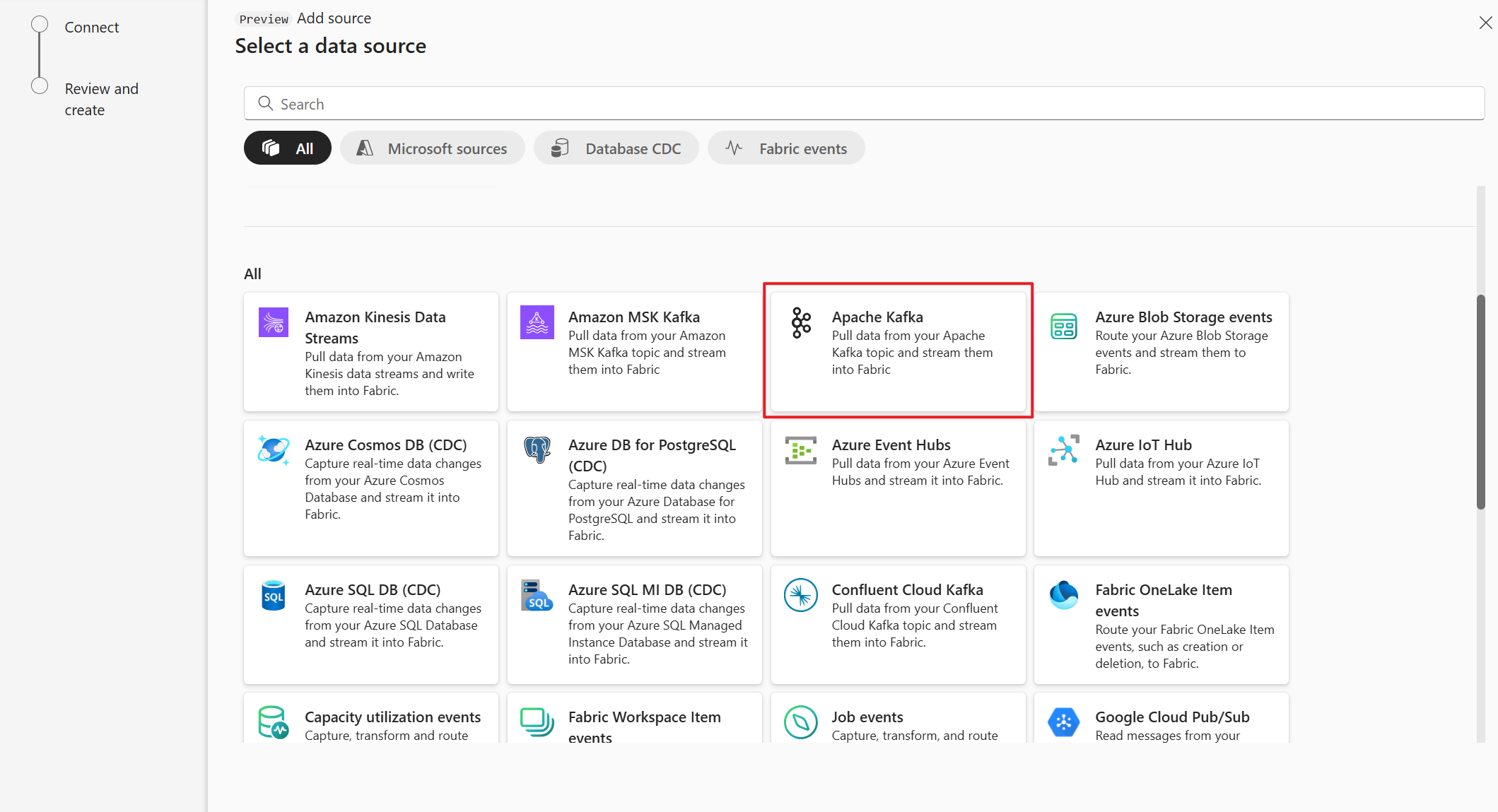

在“选择数据源”页面上,选择“Apache Kafka”。

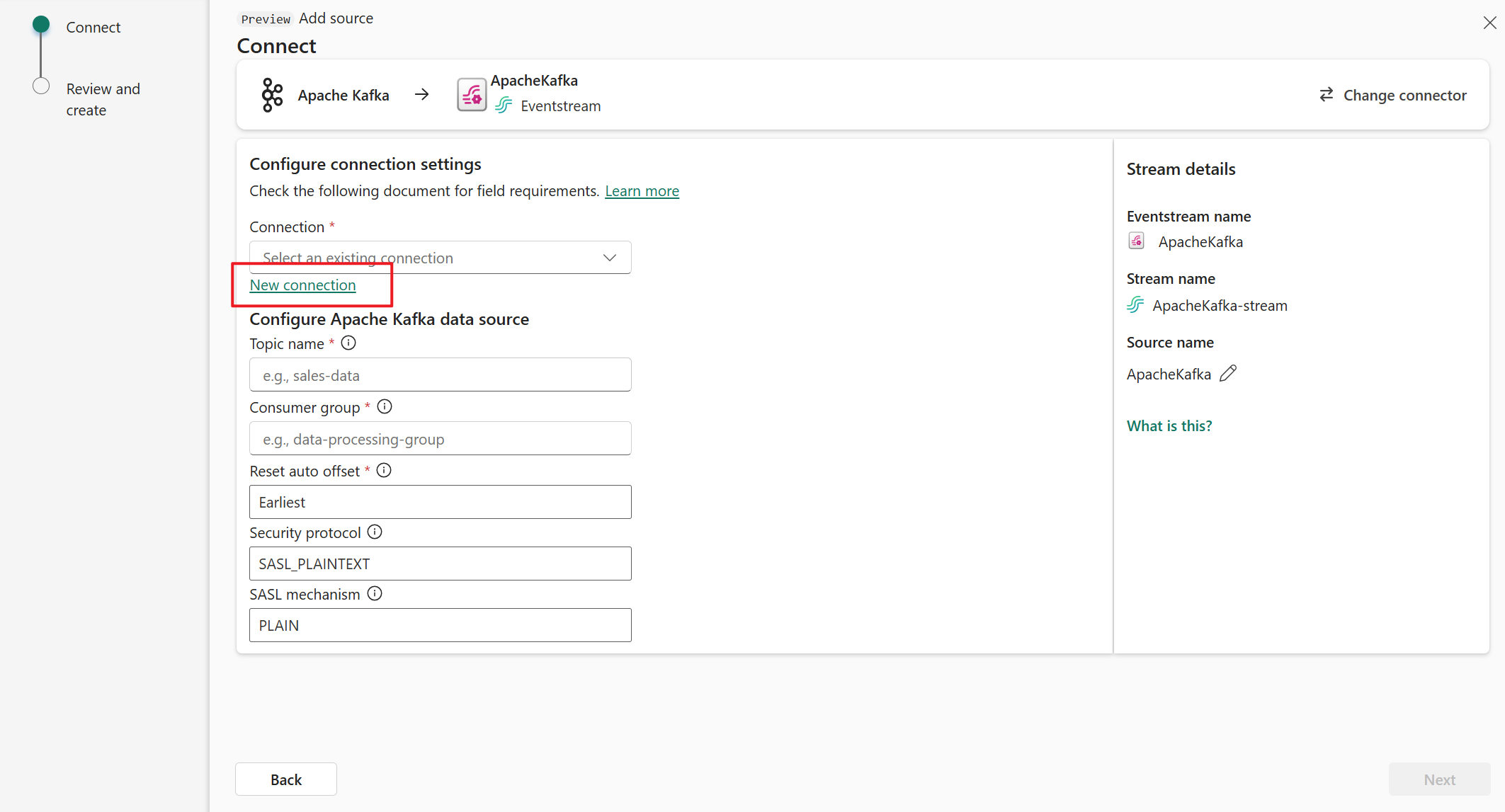

在“连接”页上,选择“新建连接”。

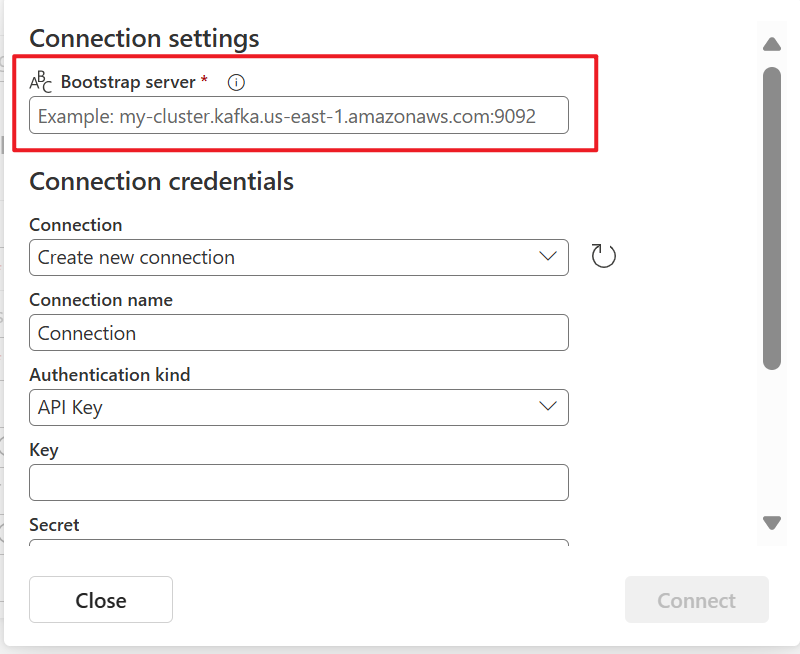

在“连接设置”部分中,针对“启动服务器”输入你的 Apache Kafka 服务器地址。

在“连接凭据”部分中,如果你已有到 Apache Kafka 群集的连接,请从“连接”的下拉列表中选择它。 否则,请执行以下步骤:

- 对于“连接名称”,为连接输入名称。

- 对于“身份验证类型”,请确认已选择“API 密钥”。

- 对于“密钥”和“机密”,输入 API 密钥和密钥机密。

选择“连接” 。

现在,在“连接”页上,按照以下步骤操作。

对于“主题”,输入 Kafka 主题。

对于“使用者组”,输入 Apache Kafka 群集的使用者组。 此字段提供用于获取事件的专用使用者组。

选择“重置自动偏移”以指定在没有提交的情况下从何处开始读取偏移。

对于“安全协议”,默认值是“SASL_PLAINTEXT”。

注意

Apache Kafka 源当前仅支持 Apache Kafka 群集与 Eventstream 之间进行未加密的数据传输(SASL_PLAINTEXT 和 PLAINTEXT)。 即将推出对通过 SSL 进行加密数据传输的支持。

默认的 SASL 机制通常是 PLAIN,除非另有配置。 可以选择符合你的安全要求的 SCRAM-SHA-256 或 SCRAM-SHA-512 机制。

选择下一步。 在“查看并创建”屏幕上,查看摘要,然后选择“添加”。

查看更新的 Eventstream

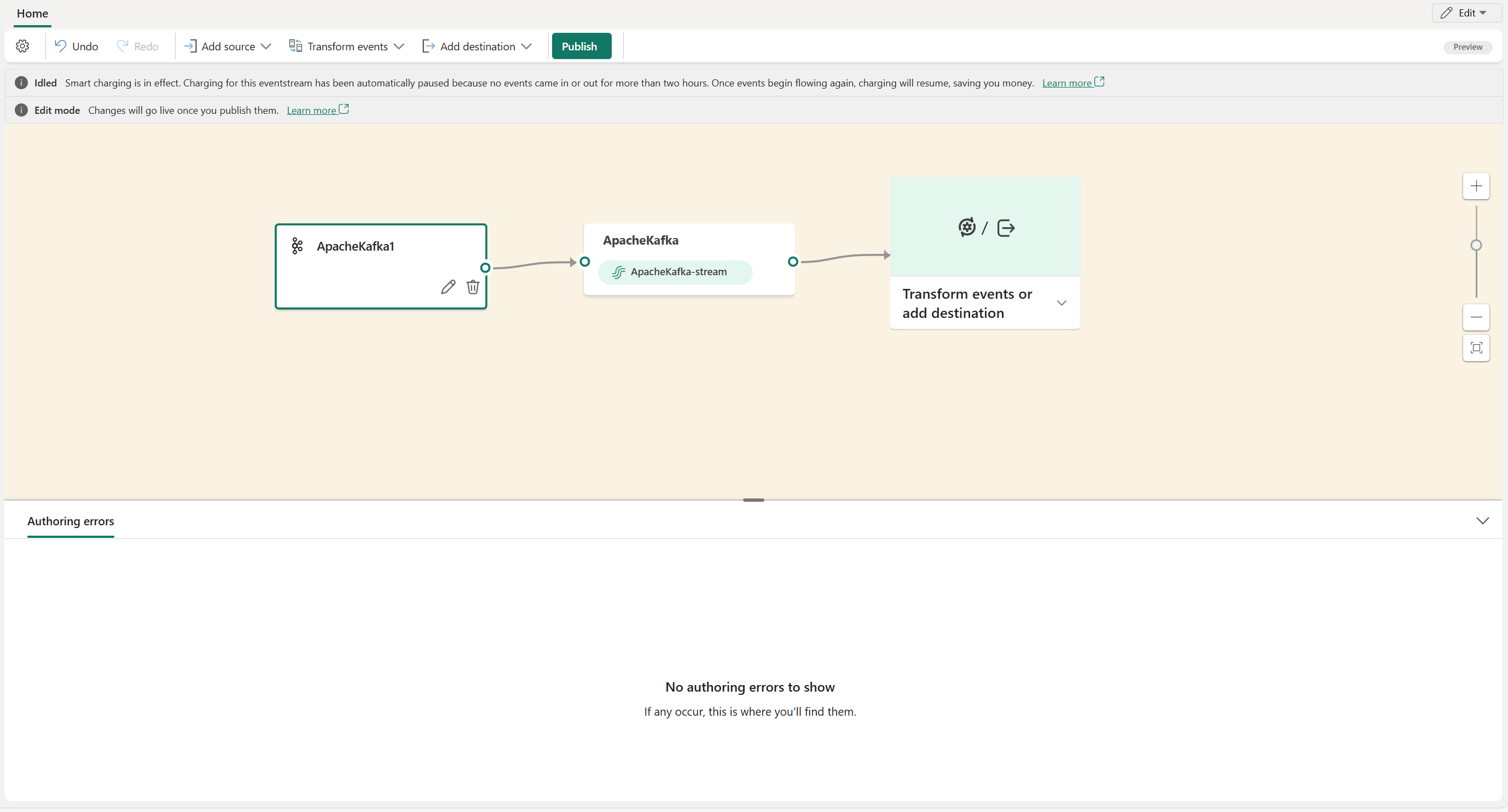

可以在编辑模式中看到添加到 Eventstream 的 Apache Kafka 源。

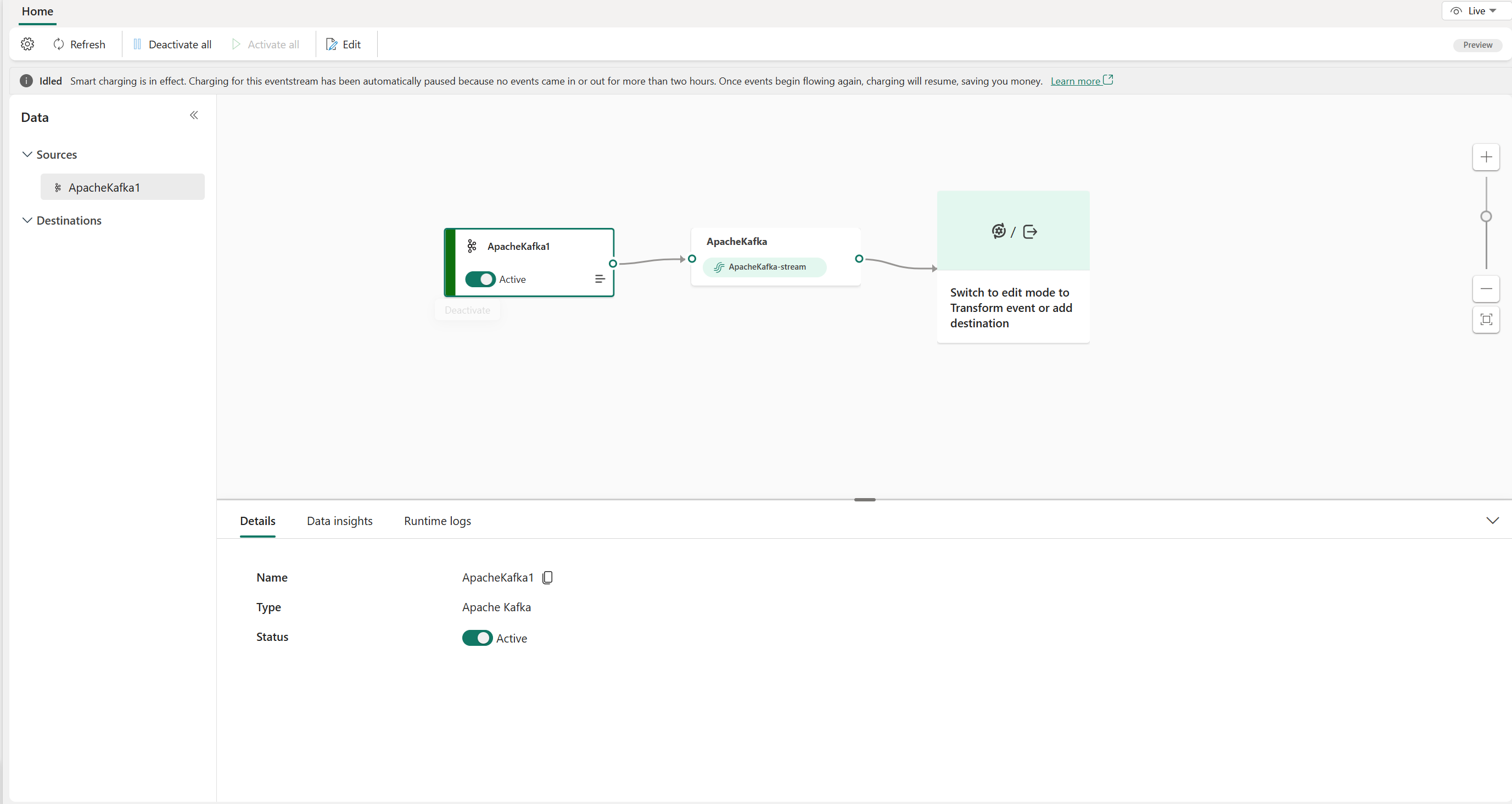

完成这些步骤后,Apache Kafka 源可在“实时视图”中进行可视化。

相关内容

其他连接器: