Fabric Eventstream – Übersicht

Mit dem Eventstreams-Feature in der Microsoft Fabric Real-Time Intelligence-Umgebung können Sie Echtzeitereignisse in Fabric integrieren, transformieren und dann an verschiedene Ziele weiterleiten, ohne Code (No-Code) zu schreiben. Sie erstellen einen Eventstream, bei dem es sich um eine Instanz des Eventstream-Elements in Fabric handelt, Fügen Sie dem Datenstrom Ereignisdaten hinzu, fügen Sie optional Transformationen hinzu, um die Ereignisdaten zu transformieren, und leiten Sie die Daten dann an unterstützte Ziele weiter. Darüber hinaus können Sie mit Apache Kafka-Endpunkten, die für das Eventstream-Element verfügbar sind, Echtzeitereignisse mithilfe des Kafka-Protokolls senden oder nutzen.

Übertragen von Ereignissen in Fabric

Das Feature „Eventstreams“ bietet verschiedene Quellconnectors zum Abrufen von Ereignisdaten aus verschiedenen Quellen. Es stehen weitere Quellen zur Verfügung, wenn Sie zum Zeitpunkt der Erstellung eines Eventstreams erweiterte Funktionen aktivieren.

| Quellen | Beschreibung |

|---|---|

| Azure Event Hubs | Wenn Sie über einen Azure Event Hub verfügen, können Sie Event Hub-Daten mithilfe von Eventstream in Microsoft Fabric erfassen. |

| Azure IoT Hub | Wenn Sie über einen Azure IoT Hub verfügen, können Sie IoT-Daten mithilfe von Eventstream in Microsoft Fabric erfassen. |

| Azure SQL Datenbank Change Data Capture (CDC) | Der Azure SQL-Datenbank CDC Source Connector ermöglicht Ihnen das Erfassen einer Momentaufnahme der aktuellen Daten in einer Azure SQL-Datenbank. Künftige Änderungen an diesen Daten auf Zeilenebene werden dann vom Konnektor überwacht und aufgezeichnet. |

| PostgreSQL Datenbank CDC | Der Postgre SQL-Datenbank Change Data Capture (CDC)-Quellconnector ermöglicht es Ihnen, eine Momentaufnahme der aktuellen Daten in einer PostgreSQL-Datenbank zu erfassen. Künftige Änderungen an diesen Daten auf Zeilenebene werden dann vom Konnektor überwacht und aufgezeichnet. |

| MySQL Datenbank CDC | Mit dem Azure My SQL-Datenbank Change Data Capture (CDC)-Quellconnector können Sie eine Momentaufnahme der aktuellen Daten in einer Azure-Datenbank für MySQL-Datenbank erfassen. Sie können die zu überwachenden Tabellen angeben, und der Eventstream zeichnet alle zukünftigen Änderungen auf Zeilenebene in den Tabellen auf. |

| Azure Cosmos DB CDC | Mit dem Azure Cosmos DB Change Data Capture (CDC)-Quellen-Konnektor für Microsoft Fabric-Eventstreams können Sie eine Momentaufnahme der aktuellen Daten in einer Azure Cosmos DB-Datenbank erfassen. Künftige Änderungen an diesen Daten auf Zeilenebene werden dann vom Konnektor überwacht und aufgezeichnet. |

| SQL Server auf CDC der Datenbank (DB) der virtuellen Maschine (VM) | Der Source Connector des SQL Server auf VM DB (CDC) für Fabric-Eventstreams ermöglicht es Ihnen, einen Snapshot der aktuellen Daten in einer SQL-Serverdatenbank auf einer VM zu erfassen. Künftige Änderungen an den Daten auf Zeilenebene werden dann vom Konnektor überwacht und erfasst. |

| Azure SQL Managed Instance CDC | Der CDC Source Connector der Azure SQL Managed Instance für Microsoft Fabric-Eventstreams ermöglicht es Ihnen, einen Snapshot der aktuellen Daten in einer SQL Managed Instance-Datenbank zu erfassen. Künftige Änderungen an diesen Daten auf Zeilenebene werden dann vom Konnektor überwacht und aufgezeichnet. |

| Google Cloud Pub/Sub | Google Pub/Sub ist ein Messaging-Dienst, mit dem Sie Datenströme von Ereignissen veröffentlichen und abonnieren können. Sie können Google Pub/Sub als Quelle zu Ihrem Eventstream hinzufügen, um Echtzeitereignisse zu erfassen, zu transformieren und zu verschiedenen Zielen in Fabric zu leiten. |

| Amazon Kinesis Data Streams | Amazon Kinesis Data Streams ist ein massiv skalierbarer, äußerst langlebiger Datenaufnahme- und Verarbeitungsdienst, der für Streamingdaten optimiert ist. Durch die Integration von Amazon Kinesis Data Streams als Quelle in Ihren Eventstream können Sie Echtzeit-Streams nahtlos verarbeiten, bevor Sie sie an mehrere Ziele innerhalb von Fabric weiterleiten. |

| Confluent Cloud Kafka | Confluent Cloud Kafka ist eine Streaming-Plattform, die leistungsstarkes Streaming und Verarbeitungsfunktionen mit Apache Kafka bietet. Durch die Integration von Confluent Cloud Kafka als Quelle in Ihren Eventstream können Sie Echtzeit-Streams nahtlos verarbeiten, bevor Sie sie an mehrere Ziele innerhalb von Fabric weiterleiten. |

| Amazon MSK Kafka | Amazon MSK Kafka ist ein vollständig verwalteter Kafka-Dienst, der die Einrichtung, Skalierung und Verwaltung vereinfacht. Durch die Integration von Amazon MSK Kafka als Quelle in Ihren Eventstream können Sie die Echtzeitereignisse von MSK Kafka nahtlos übertragen und verarbeiten, bevor Sie diese an mehrere Ziele innerhalb von Fabric weiterleiten. |

| Beispieldaten | Um beim Einrichten eines Ereignisstreams die Datenerfassung zu testen, können Sie Fahrräder, Yellow Taxi oder Börsenevents als Beispieldatenquelle auswählen. |

| Benutzerdefinierter Endpunkt (d. h. benutzerdefinierte App mit Standardfunktionalität) | Mit dem Feature für einen benutzerdefinierten Endpunkt können Ihre Anwendungen oder Kafka-Clients mithilfe einer Verbindungszeichenfolge eine Verbindung mit Eventstream herstellen – dies ermöglicht die reibungslose Erfassung von Streamingdaten in Eventstream. |

| Azure Service Bus (Vorschau) | Sie können Daten aus einer Azure Service Bus-Warteschlange oder dem Abonnement eines Themas mithilfe von Eventstream in Microsoft Fabric erfassen. |

| Apache Kafka (Vorschau) | Apache Kafka ist eine verteilte Open-Source-Plattform zum Erstellen skalierbarer Systeme mit Echtzeitdaten. Durch die Integration von Apache Kafka als Quelle in Ihren Eventstream können Sie die Echtzeitereignisse von Apache Kafka nahtlos übertragen und verarbeiten, bevor Sie diese an mehrere Ziele innerhalb von Fabric weiterleiten. |

| Azure Blob Storage-Ereignisse (Vorschau) | Azure Blob Storage-Ereignisse werden ausgelöst, wenn ein Client einen Blob erstellt, ersetzt oder löscht. Mit dem Connector können Sie Blob Storage-Ereignisse mit Fabric-Ereignissen im Echtzeithub verknüpfen. Sie können diese Ereignisse in fortlaufende Streams konvertieren und sie transformieren, bevor Sie sie an verschiedene Ziele in Fabric weiterleiten. |

| Fabric-Arbeitsbereichselement-Ereignisse (Vorschau) | Fabric-Arbeitsbereichselement-Ereignisse sind diskrete Fabric-Ereignisse, die auftreten, wenn Änderungen an Ihrem Fabric-Arbeitsbereich vorgenommen werden. Zu diesen Änderungen gehören das Erstellen, Aktualisieren oder Löschen eines Fabric-Artikels. Mit Fabric-Eventstreams können Sie diese Fabric-Arbeitsbereichsereignisse erfassen, transformieren und zur weiteren Analyse an verschiedene Ziele in Fabric weiterleiten. |

| Fabric-OneLake-Ereignisse (Vorschau) | OneLake-Ereignissen ermöglichen es Ihnen, Änderungen an Dateien und Ordnern in OneLake zu abonnieren und dann in Echtzeit auf diese Änderungen zu reagieren. Mit Fabric-Eventstreams können Sie diese OneLake-Ereignisse erfassen, transformieren und zur weiteren Analyse an verschiedene Ziele in Fabric weiterleiten. Dank der nahtlosen Integration von OneLake-Ereignissen in Fabric-Ereignisstreams erhalten Sie eine größere Flexibilität, um Aktivitäten in Ihrem OneLake zu überwachen und zu analysieren. |

| Fabric-Auftragsereignisse (Vorschau) | Auftragsereignisse ermöglichen es Ihnen, Benachrichtigungen über Änderungen zu abonnieren, die erzeugt werden, wenn Fabric einen Auftrag ausführt. Sie können beispielsweise beim Aktualisieren eines Semantikmodells, beim Ausführen einer geplanten Pipeline oder beim Ausführen eines Notebooks auf Änderungen reagieren. Jede dieser Aktivitäten kann einen entsprechenden Auftrag generieren, der wiederum eine Reihe entsprechender Auftragsereignisse generiert. Mit Fabric-Ereignisstreams können Sie diese Job-Ereignisse erfassen, transformieren und zur weiteren Analyse an verschiedene Ziele in Fabric weiterleiten. Diese nahtlose Integration von Auftragsereignissen in Fabric-Ereignisdatenströme bietet Ihnen mehr Flexibilität bei der Überwachung und Analyse von Aktivitäten in Ihrem Auftrag. |

Verarbeiten von Ereignissen ohne Code-Erfahrung

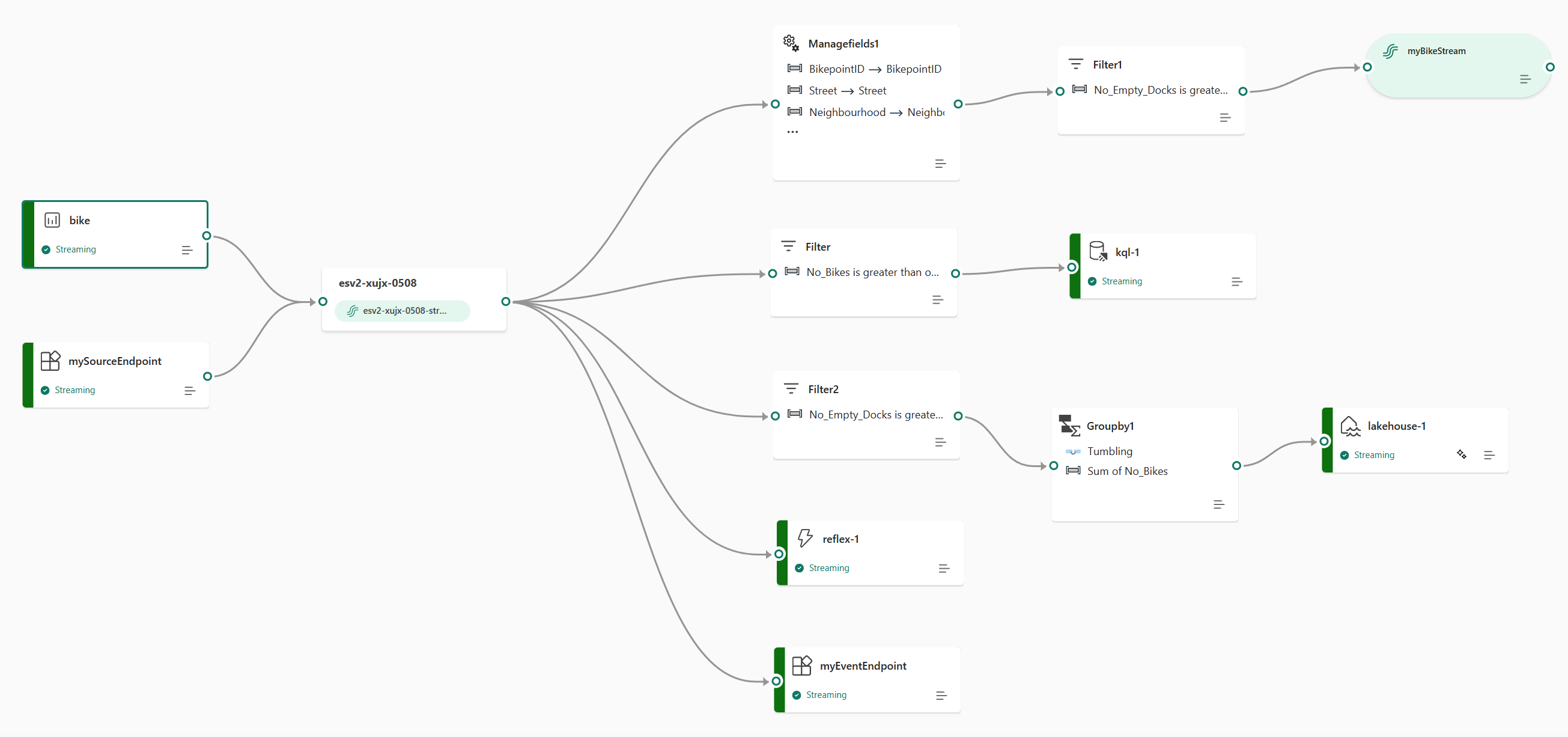

Die Drag & Drop-Erfahrung bietet Ihnen eine intuitive und einfache Möglichkeit, Ihre Ereignisdatenverarbeitungs-, -transformations- und -routinglogik zu erstellen, ohne Code schreiben zu müssen. Ein End-to-End-Datenflussdiagramm in einem Ereignisstream kann Ihnen ein umfassendes Verständnis des Datenflusses und der Organisation bieten. Der Ereignisprozessor-Editor ist ein No-Code-Feature, das Ihnen das Ziehen und Ablegen ermöglicht, um die Ereignisdaten-Verarbeitungslogik zu entwerfen.

| Transformation | Beschreibung |

|---|---|

| Filtern | Verwenden Sie die Filter-Transformation, um Ereignisse basierend auf dem Wert eines Felds in der Eingabe zu filtern. Abhängig vom Datentyp (Zahl oder Text) werden bei der Transformation die Werte beibehalten, die der ausgewählten Bedingung entsprechen, wie beispielsweise is null oder is not null. |

| Verwalten von Feldern | Mit der Transformation Verwalten von Feldern können Sie Felder, die aus einer Eingabe oder einer anderen Transformation stammen, hinzufügen, entfernen oder umbenennen oder den Datentyp ändern. |

| Aggregieren | Mithilfe der Aggregattransformation können Sie jedes Mal, wenn in einem Zeitraum ein neues Ereignis eintritt, eine Aggregation (Summe, Minimum, Maximum oder Durchschnitt) berechnen. Diese Operation ermöglicht auch die Umbenennung dieser berechneten Spalten und das Filtern oder Slicing der Aggregation basierend auf anderen Dimensionen in Ihren Daten. Sie können in derselben Transformation eine oder mehrere Aggregationen verwenden. |

| Gruppieren nach | Verwenden Sie die Gruppieren nach-Transformation, um Aggregationen für alle Ereignisse innerhalb eines bestimmten Zeitfensters zu berechnen. Sie können die Ansicht nach den Werten in einem oder mehreren Feldern gruppieren. Sie ähnelt der Aggregattransformation und lässt die Umbenennung der Spalten zu, bietet jedoch mehr Optionen für die Aggregation und enthält komplexere Optionen für Zeitfenster. Wie bei Aggregat können Sie pro Transformation mehrere Aggregationen hinzufügen. |

| Union | Mithilfe von Union-Transformationen können Sie zwei oder mehr Knoten verbinden und Ereignisse mit gemeinsamen Feldern (mit dem gleichen Namen und Datentyp) in eine Tabelle einfügen. Felder, die nicht übereinstimmen, werden verworfen und sind nicht in der Ausgabe enthalten. |

| Erweitern | Verwenden Sie die Arraytransformationsoption Erweitern, um eine neue Zeile für jeden Wert innerhalb eines Arrays zu erstellen. |

| Join | Verwenden Sie die Verknüpfungstransformation, um Daten aus zwei Datenströmen basierend auf einer übereinstimmenden Bedingung zwischen ihnen zu kombinieren. |

Wenn Sie Erweiterte Funktionen beim Erstellen eines Eventstreams aktiviert haben, werden die Transformationsvorgänge für alle Ziele unterstützt (wobei abgeleiteter Datenstrom als Brücke für einige Ziele fungiert, z. B. benutzerdefinierte Endpunkte, Fabric-Aktivator). Andernfalls sind die Transformationsvorgänge nur für die Ziele Lakehouse und Eventhouse (Ereignisverarbeitung vor Erfassung) verfügbar.

Weiterleiten von Ereignissen an Ziele

Das Fabric-Ereignisstreams-Feature unterstützt das Senden von Daten an die folgenden unterstützten Ziele.

| Destination | Beschreibung |

|---|---|

| Benutzerdefinierter Endpunkt (d. h. benutzerdefinierte App mit Standardfunktionalität) | Mit diesem Ziel können Sie Ihre Echtzeitereignisse ganz einfach an eine benutzerdefinierte Anwendung weiterleiten. Damit können Sie Ihre eigenen Anwendungen mit dem Ereignisstream verbinden und die Ereignisdaten in Echtzeit nutzen. Es ist nützlich, wenn Sie Echtzeitdaten an ein externes System außerhalb von Microsoft Fabric ausgeben möchten. |

| Eventhouse | Mit diesem Ziel können Sie Ihre Echtzeit-Ereignisdaten in ein Eventhouse einspeisen, in dem Sie die leistungsstarke Kusto Query Language (KQL) zur Abfrage und Analyse der Daten verwenden können. Mit den Daten im Eventhouse können Sie tiefere Erkenntnisse aus Ihren Ereignisdaten gewinnen und umfangreiche Berichte und Dashboards erstellen. Sie können zwischen zwei Erfassungsmodi wählen: direkte Erfassung und Ereignisverarbeitung vor der Erfassung. |

| Lakehouse | Dieses Ziel bietet Ihnen die Möglichkeit, Ihre Echtzeitereignisse vor der Erfassung in Ihr Lakehouse zu transformieren. Echtzeitereignisse werden in das Delta Lake-Format konvertiert und dann in den angegebenen Lakehouse-Tabellen gespeichert. Dieses Ziel unterstützt Data Warehouse-Szenarien. |

| Abgeleiteter Stream | Abgeleiteter Datenstrom ist ein spezieller Zieltyp, den Sie nach dem Hinzufügen von Datenstromvorgängen erstellen können, z. B. "Felder filtern" oder "Felder verwalten", zu einem Ereignisstream. Der abgeleitete Datenstrom stellt den transformierten Standarddatenstrom nach der Datenstromverarbeitung dar. Sie können den abgeleiteten Datenstrom an mehrere Ziele in Fabric weiterleiten und den abgeleiteten Datenstrom im Echtzeithub anzeigen. |

| Fabric Activator (Vorschau) | Mit diesem Ziel können Sie Ihre Echtzeitereignisdaten direkt mit einem Fabric Activator verbinden. Activator ist eine Art intelligenter Agent, der alle erforderlichen Informationen enthält, um eine Verbindung mit Daten herzustellen, auf Bedingungen zu überwachen und zu handeln. Wenn die Daten bestimmte Schwellenwerte erreichen oder mit anderen Mustern übereinstimmen, führt Aktivator automatisch geeignete Maßnahmen aus und warnt beispielsweise Benutzer*innen oder startet Power Automate-Workflows. |

Sie können mehrere Ziele in einem Ereignisstream anfügen, um gleichzeitig Daten von Ihren Ereignisstreams zu empfangen, ohne sich gegenseitig zu stören.

Hinweis

Wir empfehlen Ihnen, das Feature für Microsoft Fabric-Eventstreams mit mindestens vier Kapazitätseinheiten (SKU: F4) zu verwenden.

Apache Kafka für Fabric Eventstreams

Das Fabric Eventstreams-Feature bietet einen Apache Kafka-Endpunkt im Eventstream-Element, sodass Benutzer Streamingereignisse über das Kafka-Protokoll verbinden und nutzen können. Wenn Ihre Anwendung bereits das Apache Kafka-Protokoll zum Senden oder Empfangen von Streamingereignissen mit bestimmten Themen verwendet, können Sie sie ganz einfach mit Ihrem Eventstream verbinden. Aktualisieren Sie einfach Ihre Verbindungseinstellungen, um den in Ihrem Eventstream bereitgestellten Kafka-Endpunkt zu verwenden.

Das Fabric Eventstreams-Feature wird von Azure Event Hubs unterstützt, einem vollständig verwalteten cloudeigenen Dienst. Wenn ein Eventstream erstellt wird, wird automatisch ein Event Hub-Namespace bereitgestellt, und ein Event Hub wird dem Standardstream zugewiesen, ohne dass Bereitstellungskonfigurationen erforderlich sind. Weitere Informationen zu den Kafka-kompatiblen Features im Azure Event Hubs-Dienst finden Sie unter Azure Event Hubs für Apache Kafka.

Weitere Informationen zum Abrufen der Kafka-Endpunktdetails zum Senden von Ereignissen an Eventstream finden Sie unter Hinzufügen einer benutzerdefinierten Endpunktquelle zu einem Eventstream, und Informationen zum Verwenden von Ereignissen aus Eventstream finden Sie unter Hinzufügen eines benutzerdefinierten Endpunktziels zu einem Eventstream.

Einschränkungen

Fabric Eventstream hat die folgenden allgemeinen Einschränkungen. Bevor Sie mit Eventstream arbeiten, überprüfen Sie diese Einschränkungen, um sicherzustellen, dass sie ihren Anforderungen entsprechen.

| Begrenzung | Größe |

|---|---|

| Maximale Nachrichtengröße | 1 MB |

| Maximale Aufbewahrungsdauer von Ereignisdaten | 90 Tage |