Aggiungi e gestisci un origine evento in eventstream

Dopo aver creato un flusso di eventi, è possibile connetterlo a varie origini dati e destinazioni.

Nota

Le funzionalità avanzate sono abilitate per impostazione predefinita quando si creano flussi di eventi. Se sono stati creati flussi di eventi che usano funzionalità standard, tali flussi di eventi continueranno a funzionare. È comunque possibile modificarli e usarli come di consueto. È consigliabile creare un nuovo flusso di eventi per sostituire i flussi di eventi standard in modo da poter sfruttare funzionalità aggiuntive e vantaggi dei flussi di eventi avanzati.

Dopo aver creato un eventstream, è possibile connetterlo a varie origini dati e destinazioni.

Eventstream non solo consente di trasmettere dati da origini Microsoft, ma supporta anche l'inserimento da piattaforme di terze parti come Google Cloud e Amazon Kinesis con nuovi connettori di messaggistica. Questa funzionalità estesa offre una perfetta integrazione di flussi dei dati esterni in Fabric, offrendo maggiore flessibilità e consentendo di ottenere informazioni dettagliate in tempo reale da più origini.

In questo articolo vengono fornite informazioni sulle origini eventi che è possibile aggiungere a un flusso di eventi.

Prerequisiti

- Accesso a un'area di lavoro in modalità di licenza della capacità di Infrastruttura (o) modalità licenza di valutazione con autorizzazioni di collaboratore o superiore.

- Prerequisiti specifici per ogni origine documentata negli articoli specifici dell'origine seguenti.

Origini supportate

I flussi di eventi di Fabric con funzionalità avanzate supportano le origini seguenti. Ogni articolo fornisce informazioni dettagliate e istruzioni per l'aggiunta di origini specifiche.

| Origini | Descrizione |

|---|---|

| Hub eventi di Azure | Se si dispone di un hub eventi di Azure, è possibile inserire i dati dell'hub eventi in Microsoft Fabric usando Eventstream. |

| Hub IoT di Azure | Se si ha un hub IoT di Azure, è possibile inserire dati IoT in Microsoft Fabric usando Eventstream. |

| Database SQL di Azure con Change Data Capture (CDC) | Il connettore di origine CDC del Database SQL di Azure consente di acquisire uno snapshot dei dati correnti in un database SQL di Azure. Il connettore monitora e registra poi eventuali modifiche future a livello di riga a questi dati. |

| Database PostgreSQL CDC | Il connettore di origine Change Data Capture (CDC) del Database PostgreSQL consente di acquisire uno snapshot dei dati correnti nel Database di PostgreSQL. Il connettore monitora e registra poi eventuali modifiche future a livello di riga a questi dati. |

| Database MySQL CDC | Il connettore di origine Change Data Capture (CDC) di Database MySQL di Azure consente di acquisire uno snapshot dei dati correnti in un database nel Database di Azure per MySQL. È possibile specificare le tabelle da monitorare e il flusso di eventi registra eventuali modifiche future a livello di riga nelle tabelle. |

| CDC Azure Cosmos DB | Il connettore di origine Change Data Capture (CDC) di Azure Cosmos DB per i flussi di eventi di Microsoft Fabric consente di acquisire uno snapshot dei dati correnti nel database di Azure Cosmos DB. Il connettore monitora e registra poi eventuali modifiche future a livello di riga a questi dati. |

| SQL Server nel database di macchine virtuali (DB) CDC | Il connettore di origine di SQL Server nel database vm (CDC) per i flussi di eventi di Fabric consente di acquisire uno snapshot dei dati correnti in un database di SQL Server nella macchina virtuale. Il connettore monitora e registra quindi eventuali modifiche future a livello di riga ai dati. |

| Istanza gestita di SQL di Azure CDC | Il connettore di origine CDC Istanza gestita di SQL di Azure per i flussi di eventi di Microsoft Fabric consente di acquisire uno snapshot dei dati correnti in un database Istanza gestita di SQL. Il connettore monitora e registra poi eventuali modifiche future a livello di riga a questi dati. |

| Google Cloud Pub/Sub | Google Pub/Sub è un servizio di messaggistica che consente di pubblicare e sottoscrivere flussi di eventi. È possibile aggiungere Google Pub/Sub come fonte al flusso di eventi per acquisire, trasformare e indirizzare gli eventi in tempo reale a varie destinazioni in Fabric. |

| Flussi di dati Amazon Kinesis | Amazon Kinesis Data Streams è un servizio di inserimento ed elaborazione dei dati altamente scalabile e duraturo, ottimizzato per lo streaming di dati. Integrando Amazon Kinesis Data Streams come sorgente all'interno dell'eventstream, è possibile elaborare senza problemi i flussi di dati in tempo reale prima di indirizzarli verso più destinazioni all'interno di Fabric. |

| Confluent Cloud di Kafka | Confluent Cloud di Kafka è una piattaforma di streaming che offre potenti funzionalità di streaming ed elaborazione dei dati con Apache Kafka. Integrando Confluent Cloud di Kafka come sorgente all'interno dell'eventstream, è possibile elaborare senza problemi i flussi di dati in tempo reale prima di indirizzarli verso più destinazioni all'interno di Fabric. |

| Amazon MSK Kafka | Amazon MSK Kafka è un servizio Kafka completamente gestito che semplifica la configurazione, il ridimensionamento e la gestione. Integrando Amazon MSK Kafka come origine all'interno del flusso di eventi, è possibile portare facilmente gli eventi in tempo reale da MSK Kafka ed elaborarli prima di instradarli a più destinazioni all'interno di Fabric. |

| Dati di esempio | È possibile scegliere Biciclette, Taxi Giallo o Eventi del Mercato Azionario come origine dati di esempio per testare l'inserimento dei dati durante la configurazione di un flusso di eventi. |

| Endpoint personalizzato (ovvero app personalizzata nella funzionalità standard) | La funzionalità endpoint personalizzato consente alle applicazioni o ai client Kafka di connettersi a Eventstream usando un stringa di connessione, permettendo l'inserimento uniforme dei dati di streaming in Eventstream. |

| bus di servizio di Azure (anteprima) | È possibile inserire dati da una coda di bus di servizio di Azure o da una sottoscrizione di un argomento in Microsoft Fabric usando Eventstream. |

| Apache Kafka (anteprima) | Apache Kafka è una piattaforma open source distribuita per la creazione di sistemi dati scalabili e in tempo reale. Integrando Apache Kafka come origine all'interno del flusso di eventi, è possibile portare facilmente eventi in tempo reale da Apache Kafka ed elaborarli prima di instradarli a più destinazioni all'interno di Fabric. |

| eventi Archiviazione BLOB di Azure (anteprima) | Gli eventi di Archiviazione BLOB di Azure vengono attivati quando un client crea, sostituisce o elimina un BLOB. Il connettore consente di collegare gli eventi di archiviazione BLOB agli eventi di Fabric nell'hub in tempo reale. È possibile convertire questi eventi in flussi di dati continui e trasformarli prima di indirizzarli a varie destinazioni in Fabric. |

| Eventi dell'elemento dell'area di lavoro infrastruttura (anteprima) | Gli eventi dell'elemento dell'area di lavoro di fabric sono eventi discreti che si verificano quando vengono apportate modifiche all'area di lavoro di Fabric. Queste modifiche includono la creazione, l'aggiornamento o l'eliminazione di un articolo di Fabric. Con i flussi di eventi di Fabric è possibile acquisire questi eventi dell'area di lavoro Fabric, trasformarli e indirizzarli a varie destinazioni in Fabric per un'ulteriore analisi. |

| Fabric OneLake eventi (anteprima) | Gli eventi OneLake consentono di sottoscrivere le modifiche nei file e nelle cartelle in OneLake e quindi reagire a tali modifiche in tempo reale. Con i flussi di eventi di Fabric è possibile acquisire questi eventi OneLake, trasformarli e indirizzarli a varie destinazioni in Fabric per un'ulteriore analisi. Questa perfetta integrazione degli eventi di OneLake all'interno dei flussi di eventi di Fabric offre maggiore flessibilità per il monitoraggio e l'analisi delle attività in OneLake. |

| eventi del processo di |

Gli eventi del job consentono di abbonarsi alle modifiche generate quando Fabric esegue un job. Ad esempio, è possibile reagire alle modifiche durante l'aggiornamento di un modello semantico, l'esecuzione di una pipeline pianificata o l'esecuzione di un notebook. Ognuna di queste attività può generare un lavoro corrispondente, che a sua volta genera un insieme di eventi di lavoro corrispondenti. Con i flussi di eventi di Fabric è possibile acquisire questi eventi di lavoro, trasformarli e instradarli verso varie destinazioni all'interno di Fabric per un'ulteriore analisi. Questa perfetta integrazione degli eventi del lavoro all'interno dei flussi di eventi di Fabric offre una maggiore flessibilità per il monitoraggio e l'analisi delle attività nel lavoro. |

Nota

Il numero massimo di origini e destinazioni per un eventstream è 11.

Contenuto correlato

Prerequisiti

Prima di iniziare, è necessario soddisfare i seguenti prerequisiti:

- Accesso a un'area di lavoro in modalità di licenza della capacità di Infrastruttura (o) modalità licenza di valutazione con autorizzazioni di collaboratore o superiore.

- Per aggiungere un Hub eventi di Azure o un hub IoT di Azure come origine eventstream, è necessario disporre dell'autorizzazione appropriata per accedere alle chiavi dei criteri. Devono essere accessibili pubblicamente e non essere protetti da un firewall o da una rete virtuale.

Origini supportate

I flussi di eventi di Fabric supportano le origini seguenti. Usare i collegamenti nella tabella per passare agli articoli che forniscono altri dettagli sull'aggiunta di origini specifiche.

| Origini | Descrizione |

|---|---|

| Hub eventi di Azure | Se si dispone di un hub eventi di Azure, è possibile inserire i dati dell'hub eventi in Microsoft Fabric usando Eventstream. |

| Hub IoT di Azure | Se si ha un hub IoT di Azure, è possibile inserire dati IoT in Microsoft Fabric usando Eventstream. |

| Dati di esempio | È possibile scegliere Biciclette, Taxi Giallo o Eventi del Mercato Azionario come origine dati di esempio per testare l'inserimento dei dati durante la configurazione di un flusso di eventi. |

| App Personalizzata | La funzione di app personalizzata consente alle applicazioni o ai client Kafka di connettersi a Eventstream utilizzando una stringa di connessione, permettendo l' inserimento senza problemi di dati in streaming in Eventstream. |

Nota

Il numero massimo di origini e destinazioni per un eventstream è 11.

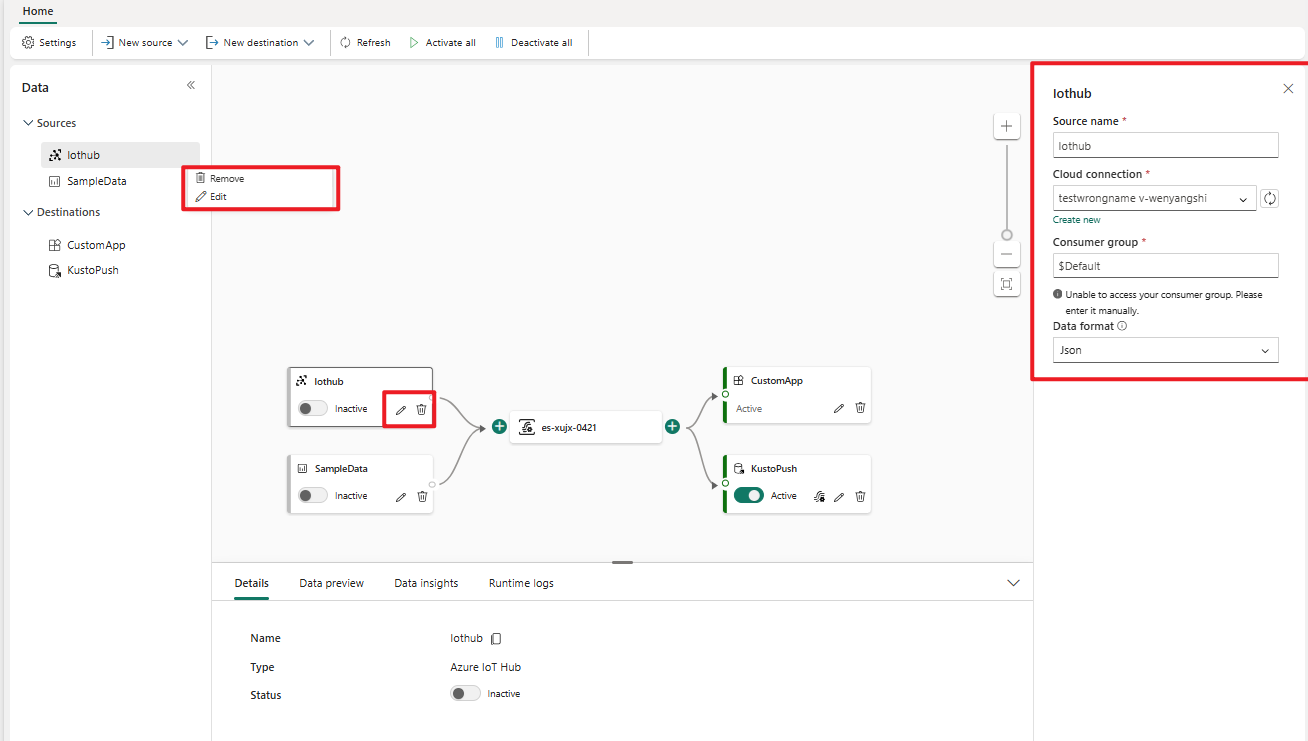

Gestire un’origine

Modifica/rimozione: è possibile selezionare un'origine eventstream da modificare o rimuovere tramite il riquadro di spostamento o l'area di disegno. Quando si seleziona Modifica, il riquadro di modifica viene aperto a destra dell'editor principale.

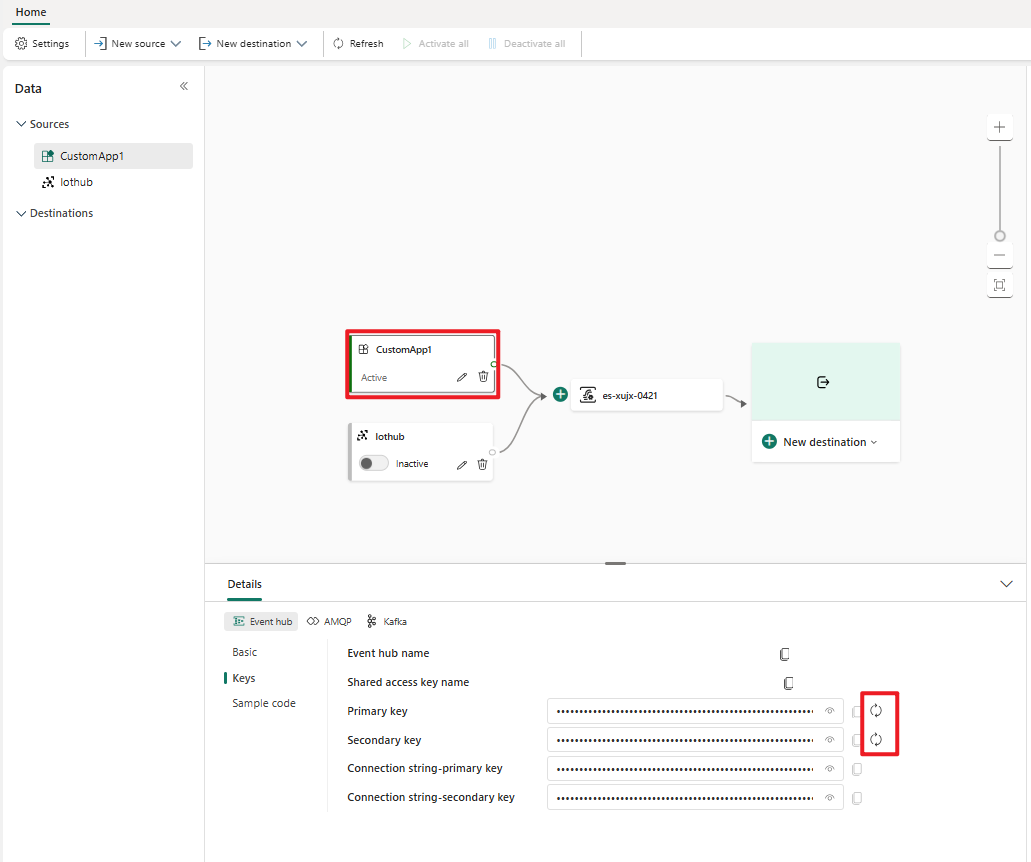

Rigenerare la chiave per un'app personalizzata: se si vuole rigenerare una nuova chiave di connessione per l'applicazione, selezionare una delle origini app personalizzate nell'area di disegno e selezionare Rigenera per ottenere una nuova chiave di connessione.