Aggiungere un'origine Confluent Kafka a un eventstream

Questo articolo illustra come aggiungere un'origine Confluent Kafka a un eventstream.

Confluent Cloud Kafka è una piattaforma di streaming che offre potenti funzionalità di streaming ed elaborazione dei dati con Apache Kafka. Integrando Confluent Cloud di Kafka come sorgente all'interno dell'eventstream, è possibile elaborare senza problemi i flussi di dati in tempo reale prima di indirizzarli verso più destinazioni all'interno di Fabric.

Nota

Questa sorgente non è supportata nelle seguenti regioni della capacità dell'area di lavoro: Stati Uniti occidentali 3, Svizzera occidentale.

Prerequisiti

- Accesso a un'area di lavoro in modalità di licenza della capacità di Infrastruttura (o) modalità licenza di valutazione con autorizzazioni di collaboratore o superiore.

- Un cluster Confluent Cloud Kafka e una chiave API.

- Il cluster Confluent Cloud Kafka deve essere accessibile pubblicamente e non essere protetto da un firewall o in una rete virtuale.

- Se non si dispone di un flusso di eventi, creare un flusso di eventi.

Avviare la procedura guidata Selezionare un'origine dati

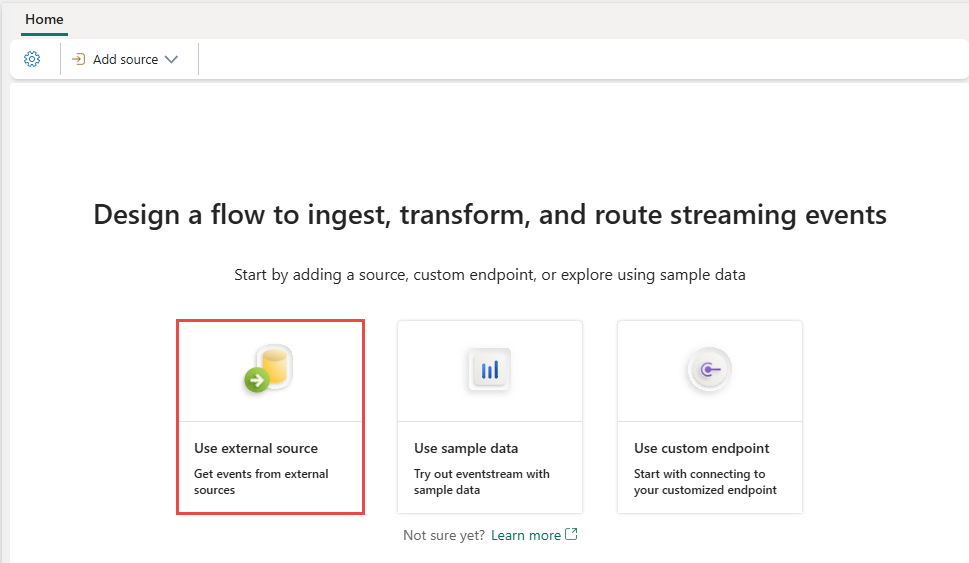

Se non è ancora stata aggiunta alcuna origine al flusso di eventi, selezionare Usa riquadro origine esterna.

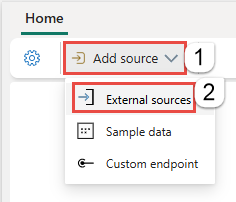

Se si aggiunge l'origine a un flusso di eventi già pubblicato, passare alla modalità modifica, selezionare Aggiungi origine sulla barra multifunzione e quindi selezionare Origini esterne.

Configurare e connettersi a Confluent Kafka

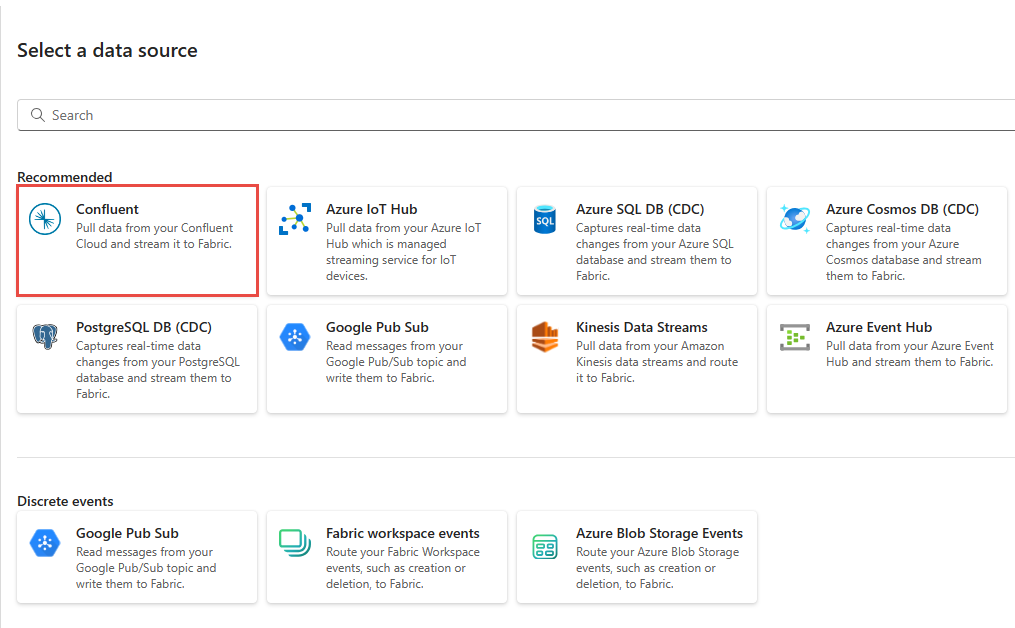

Nella pagina Seleziona un'origine dati, selezionare Confluent.

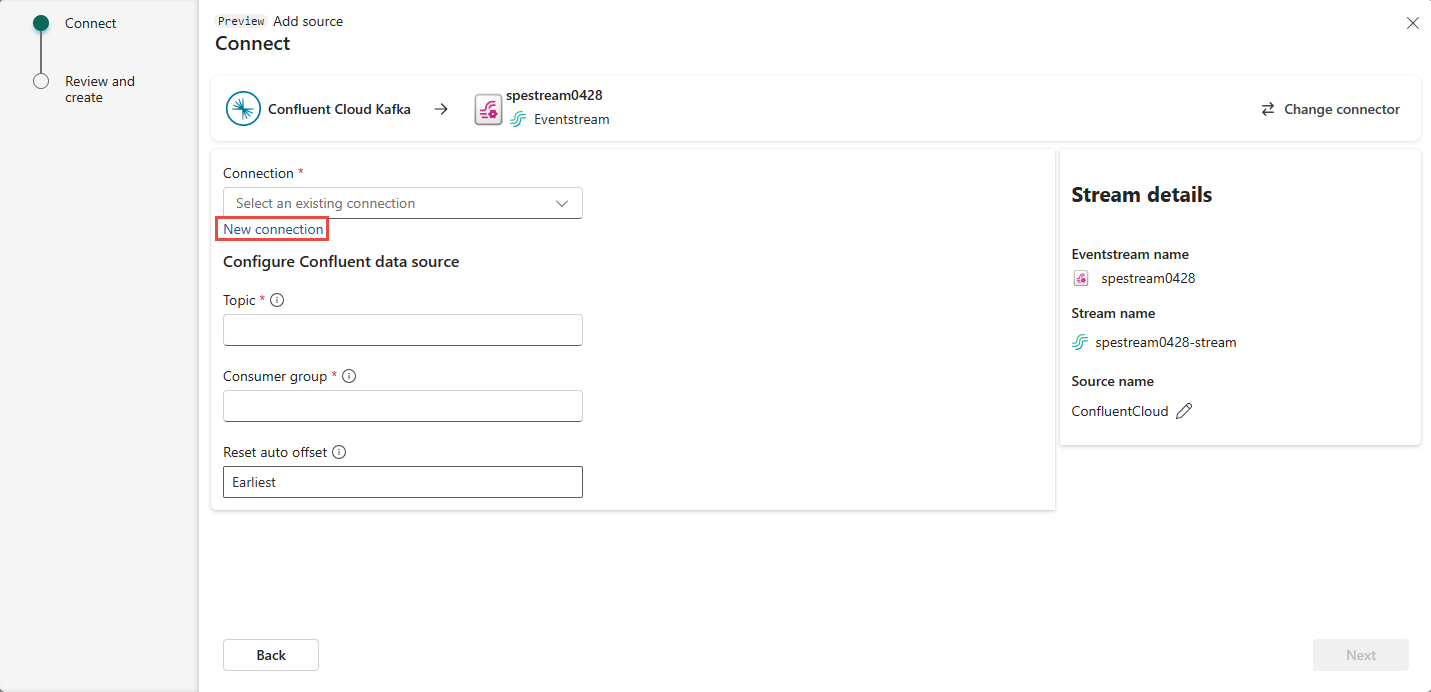

Per creare una connessione all'origine Confluent Cloud Kafka, selezionare Nuova connessione.

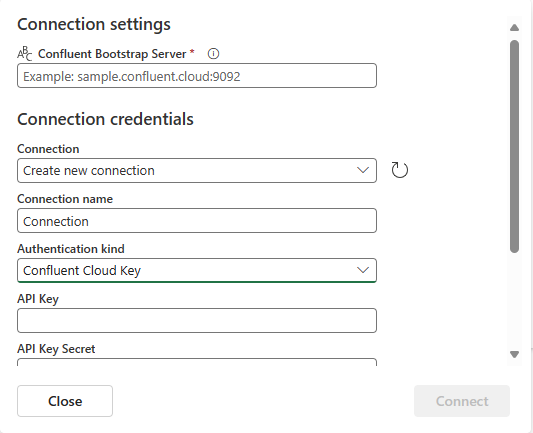

Nella sezione Impostazioni di connessione, immettere Server Bootstrap Confluent. Passare alla home page di Confluent Cloud, selezionare Impostazioni cluster e copiare l'indirizzo nel server Bootstrap.

Nella sezione Credenziali di connessione, se si dispone di una connessione esistente al cluster Confluent, selezionarla nell'elenco a discesa Connessione. Altrimenti, eseguire le seguenti operazioni:

- Per Nome connessione, immetti un nome per la connessione.

- Per Tipo di autenticazione, verificare che sia selezionata l'opzione Chiave cloud Confluent.

- Per chiave API e Segreto chiave API:

Passare al cloud Confluent.

Selezionare Chiavi API nel menu laterale.

Selezionare il pulsante Aggiungi chiave per creare una nuova chiave API.

Copiare la chiave API e il Segreto.

Incollare tali valori nei campi Chiave API e Segreto chiave API.

Seleziona Connetti

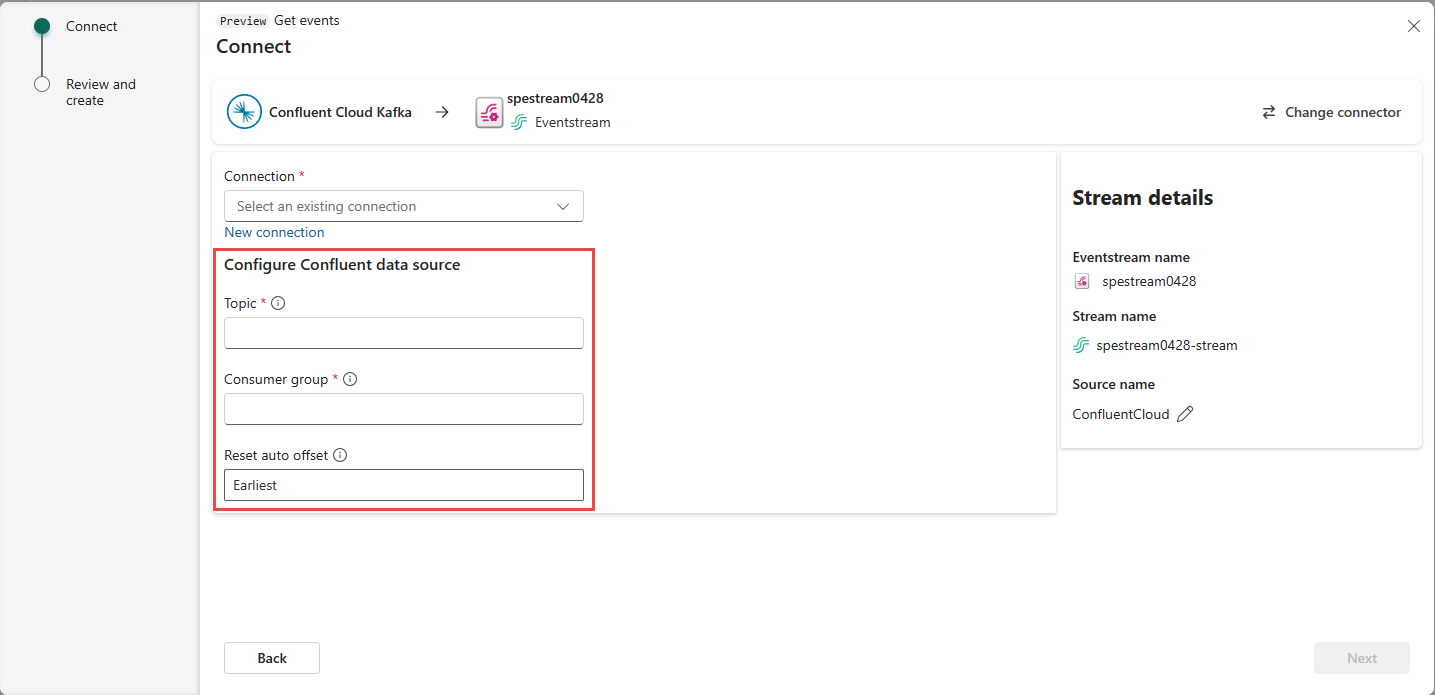

Scorrere per visualizzare la sezione Configura origine dati Confluent nella pagina. Immettere le informazioni per completare la configurazione dell'origine dati Confluent.

- Per Argomento, immettere un nome di argomento da Confluent Cloud. È possibile creare o gestire l'argomento in Confluent Cloud Console.

- Per Gruppo di consumer, immettere un gruppo di consumer del cloud Confluent. Offre il gruppo di consumer dedicato per ottenere gli eventi dal cluster Confluent Cloud.

- Per l’impostazione Reimposta offset automatico, selezionare uno dei valori seguenti:

Primi: i primi dati disponibili dal cluster Confluent

Più recenti: i dati disponibili più recenti

Nessuno: non impostare automaticamente l'offset.

Selezionare Avanti. Nella schermata Rivedi e crea esaminare il riepilogo e quindi selezionare Aggiungi.

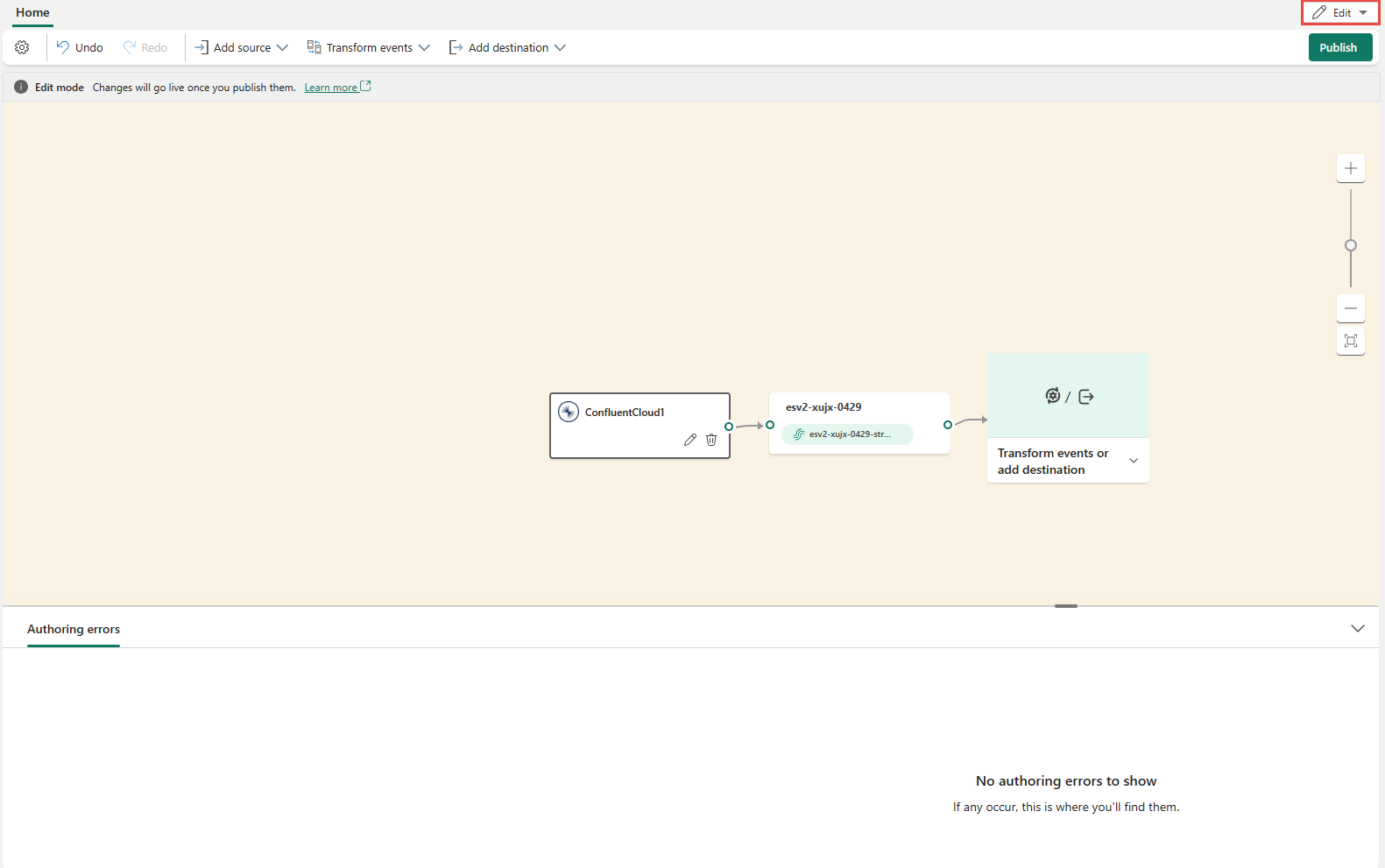

Si noterà che l'origine Confluent Cloud Kafka viene aggiunta all’eventstream nell'area di lavoro in modalità di Modifica. Per implementare questa nuova origine Confluent Cloud Kafka, selezionare Pubblica sulla barra multifunzione.

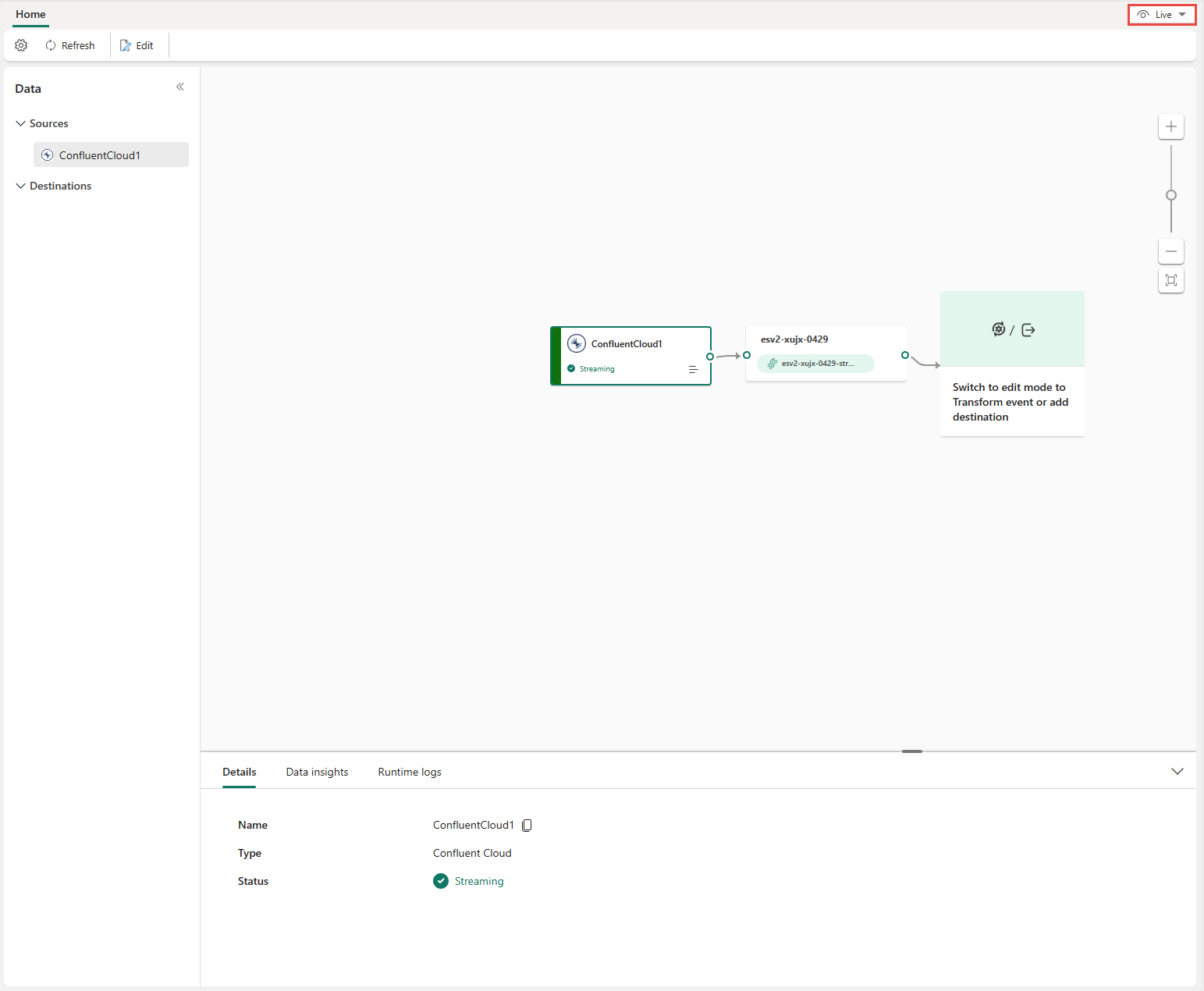

Dopo aver completato questi passaggi, l'origine Confluent Cloud Kafka è disponibile per la visualizzazione in Visualizzazione in diretta.

Limiti

- Confluent Kafka con formati JSON e Avro, usando il Registro di sistema dello schema, non è attualmente supportato.

- La decodifica dei dati da Confluent Kafka tramite il Registro di sistema dello schema confluent non è attualmente supportata.

Nota

Il numero massimo di origini e destinazioni per un eventstream è 11.

Contenuto correlato

Altri connettori:

- Flussi di dati Amazon Kinesis

- Azure Cosmos DB

- Hub eventi di Azure

- Hub IoT di Azure

- Change Data Capture (CDC) del Database SQL di Azure

- Endpoint personalizzato

- Google Cloud Pub/Sub

- Database MySQL CDC

- Database PostgreSQL CDC

- Dati di esempio

- Eventi di archiviazione BLOB di Azure

- Evento dell'area di lavoro di Fabric