Aggiungere un'origine Apache Kafka a un flusso di eventi (anteprima)

Questo articolo illustra come aggiungere un'origine Apache Kafka a un flusso di eventi.

Apache Kafka è una piattaforma open source distribuita per la creazione di sistemi dati scalabili e in tempo reale. Integrando Apache Kafka come origine all'interno del flusso di eventi, è possibile portare facilmente eventi in tempo reale da Apache Kafka ed elaborarli prima del routing a più destinazioni all'interno di Fabric.

Nota

Questa sorgente non è supportata nelle seguenti regioni della capacità dell'area di lavoro: Stati Uniti occidentali 3, Svizzera occidentale.

Prerequisiti

- Accesso all'area di lavoro Infrastruttura con autorizzazioni di collaboratore o superiore.

- Un cluster Apache Kafka in esecuzione.

- Apache Kafka deve essere accessibile pubblicamente e non essere protetto da un firewall o protetto in una rete virtuale.

Nota

Il numero massimo di fonti e destinazioni per un flusso di eventi è 11.

Aggiungere Apache Kafka come origine

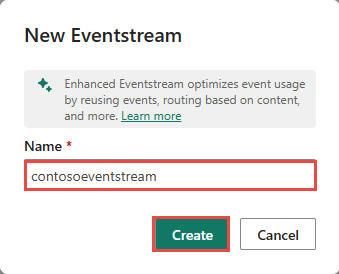

Nell’Intelligence in tempo reale di Fabric selezionare Eventstream per creare un nuovo flusso di eventi.

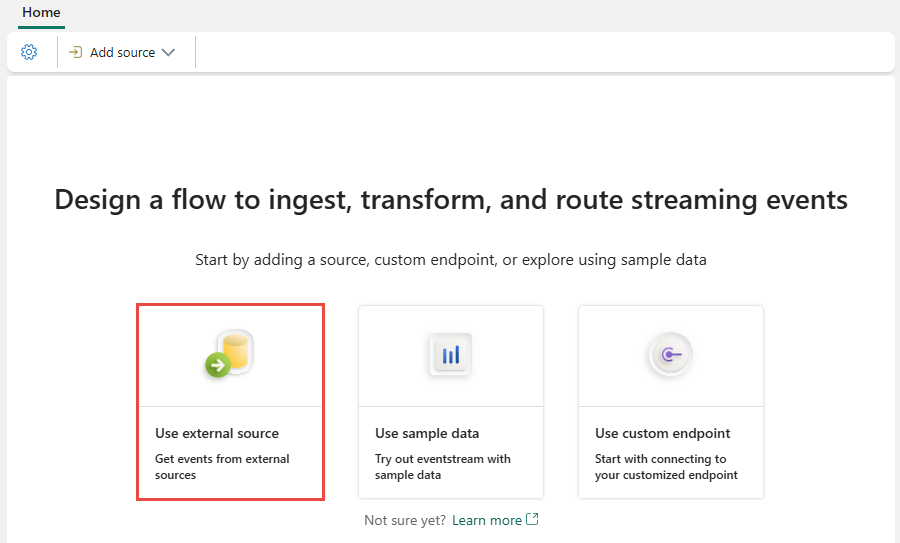

Nella schermata successiva selezionare Aggiungi origine esterna.

Configurare e connettersi ad Apache Kafka

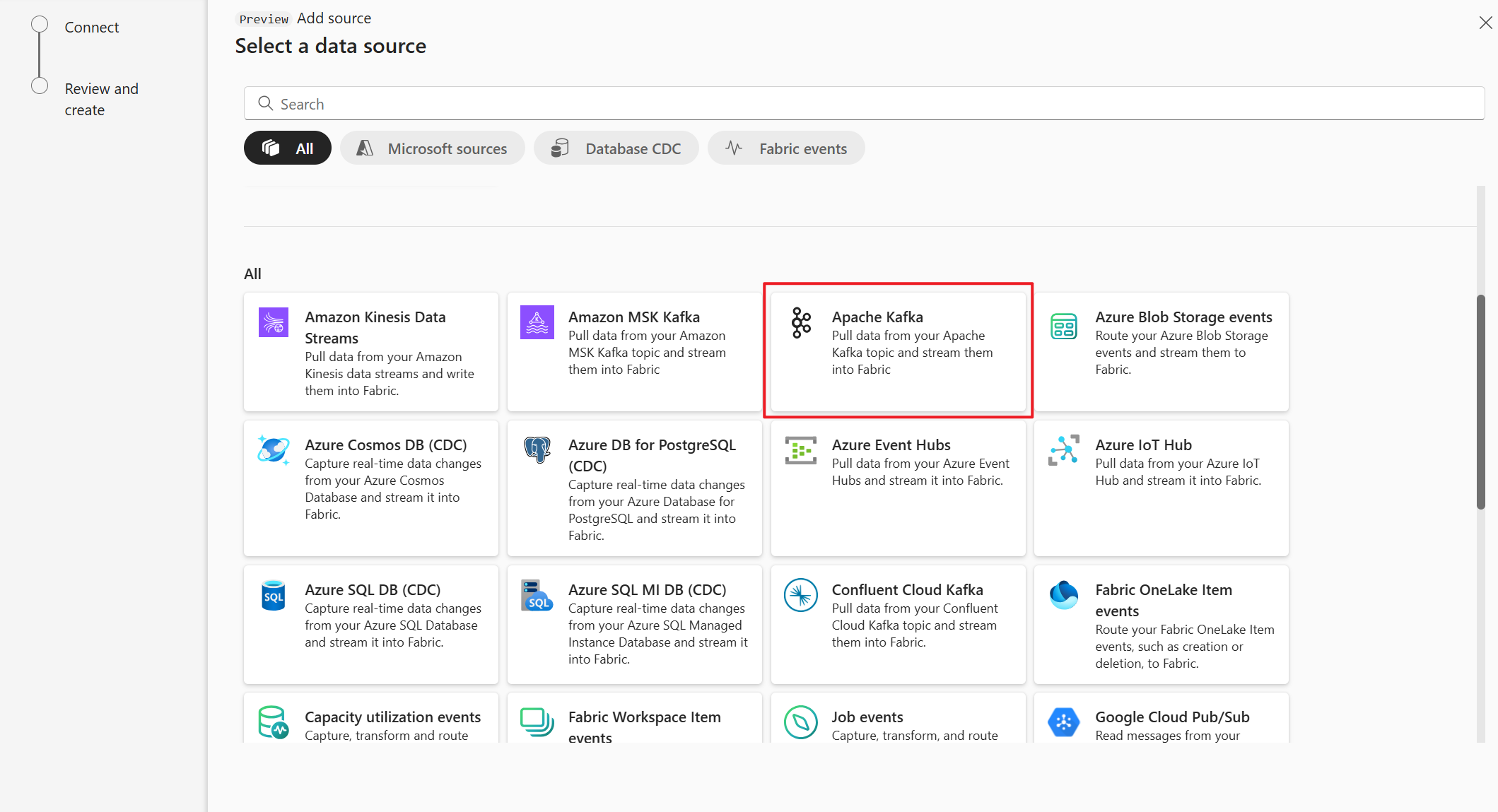

Nella pagina Selezionare un'origine dati selezionare Apache Kafka.

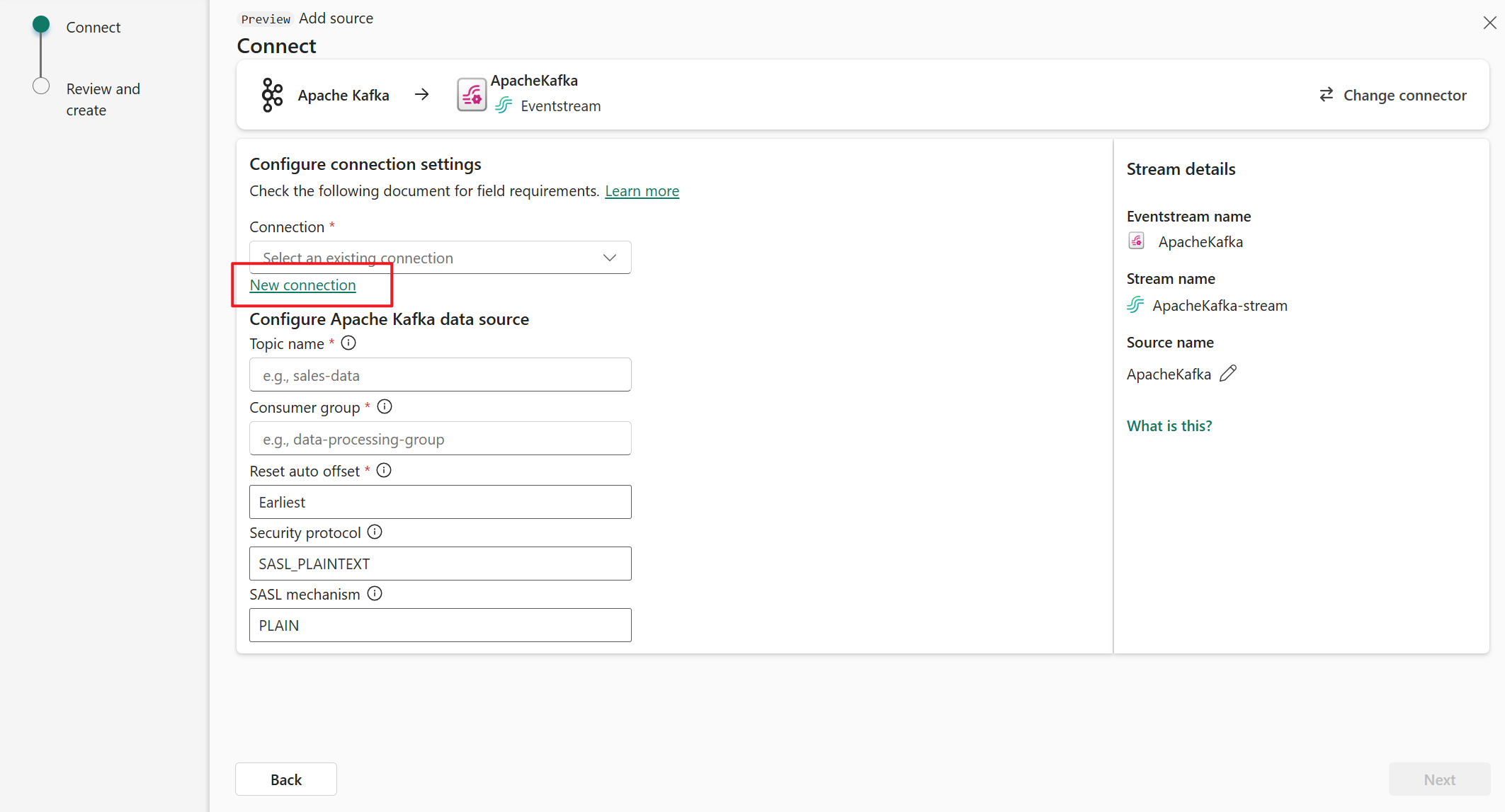

Nella pagina Connetti, seleziona Nuova connessione.

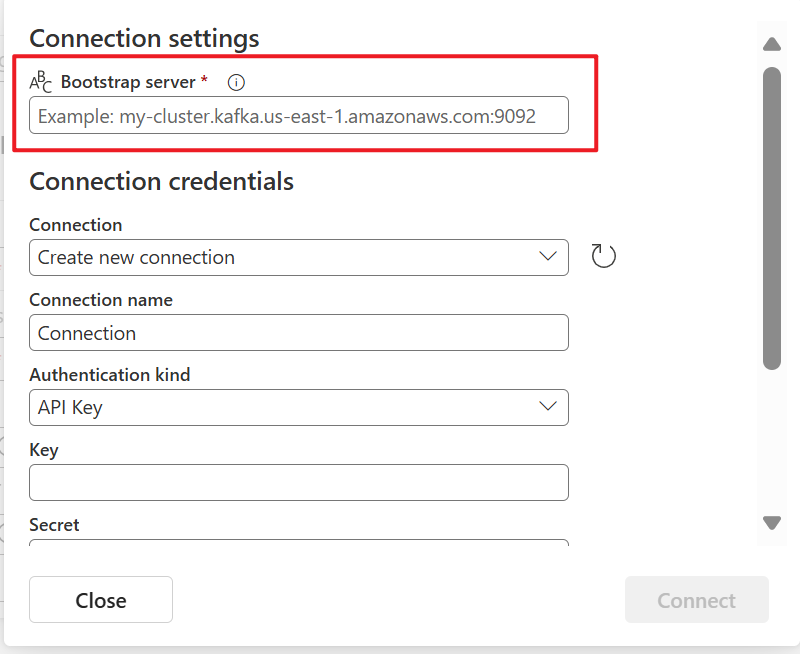

Nella sezione Impostazioni di connessione immettere l'indirizzo del server Apache Kafka per Server Bootstrap.

Nella sezione Credenziali di connessione, se si dispone di una connessione esistente al cluster Apache Kafka, selezionarla nell'elenco a discesa Connessione. Altrimenti, eseguire le seguenti operazioni:

- Per Nome connessione, immetti un nome per la connessione.

- Per Tipo di autenticazione verificare che sia selezionata la chiave API.

- Per Chiave e segreto immettere chiave API e segreto della chiave.

Selezionare Connetti.

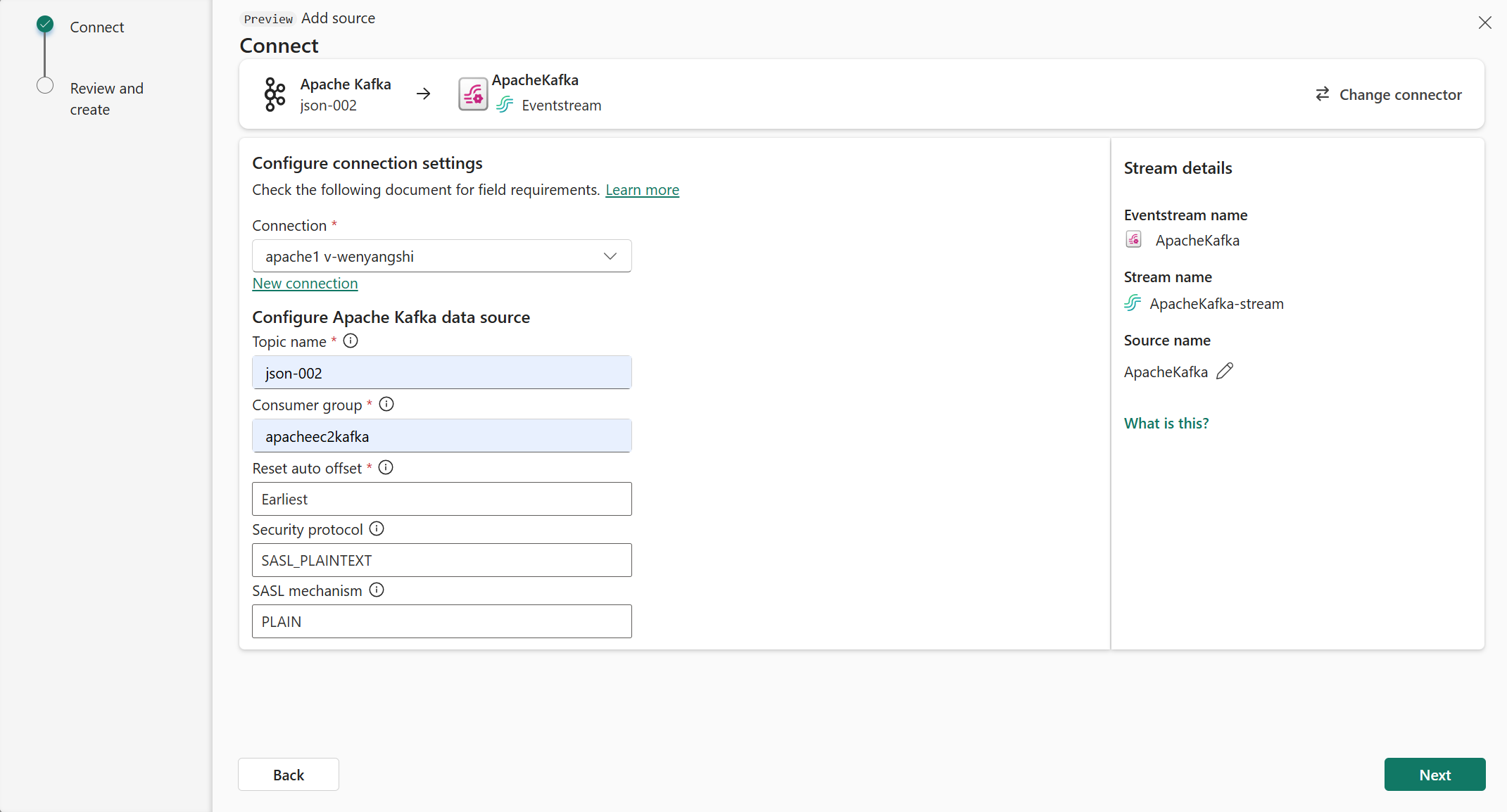

Nella pagina Connetti seguire questa procedura.

In Argomento immettere l'argomento Kafka.

In Gruppo consumer immettere il gruppo di consumer del cluster Apache Kafka. Questo campo fornisce un gruppo di consumer dedicato per ottenere eventi.

Selezionare Reimposta offset automatico per specificare dove iniziare a leggere gli offset se non è presente alcun commit.

Per Protocollo di sicurezza, il valore predefinito è SASL_PLAINTEXT.

Nota

L'origine Apache Kafka supporta attualmente solo la trasmissione di dati non crittografati (SASL_PLAINTEXT e PLAINTEXT) tra il cluster Apache Kafka e Eventstream. Il supporto per la trasmissione di dati crittografati tramite SSL sarà presto disponibile.

Il meccanismo SASL predefinito è in genere PLAIN, a meno che non sia configurato diversamente. È possibile selezionare il meccanismo SCRAM-SHA-256 o SCRAM-SHA-512 che soddisfa i requisiti di sicurezza.

Selezionare Avanti. Nella schermata Rivedi e crea esaminare il riepilogo e quindi selezionare Aggiungi.

Visualizzare il flusso di eventi aggiornato

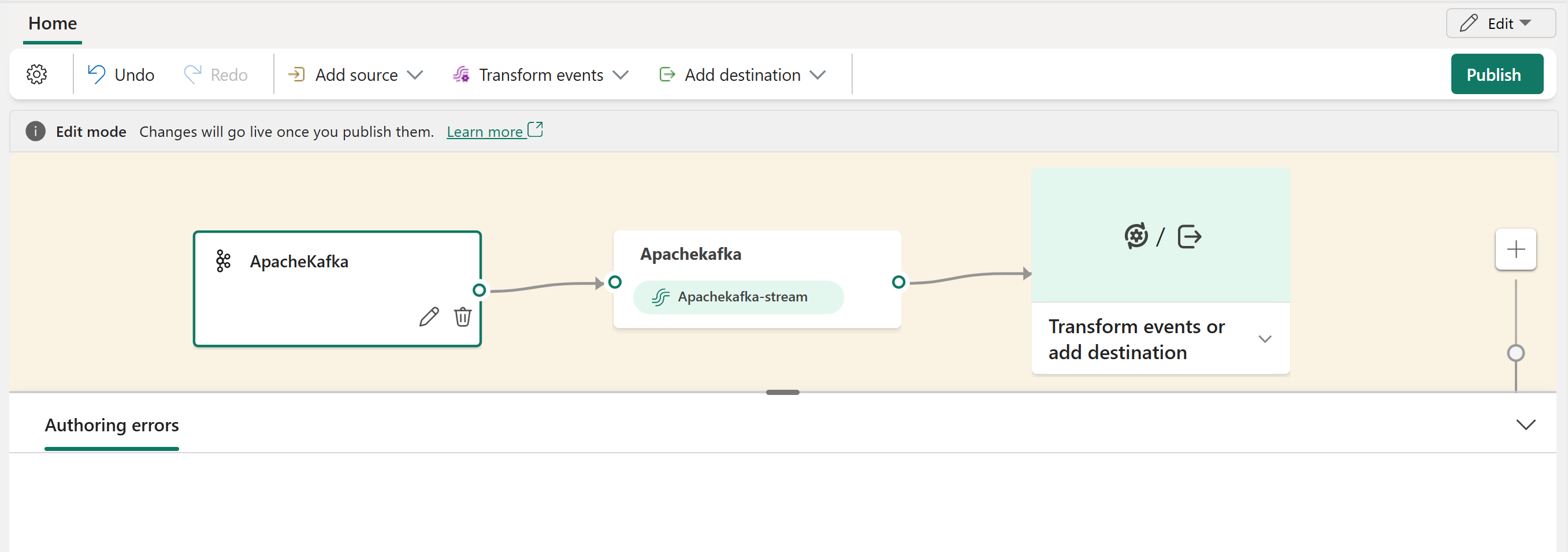

È possibile visualizzare l'origine Apache Kafka aggiunta al flusso di eventi in modalità di modifica.

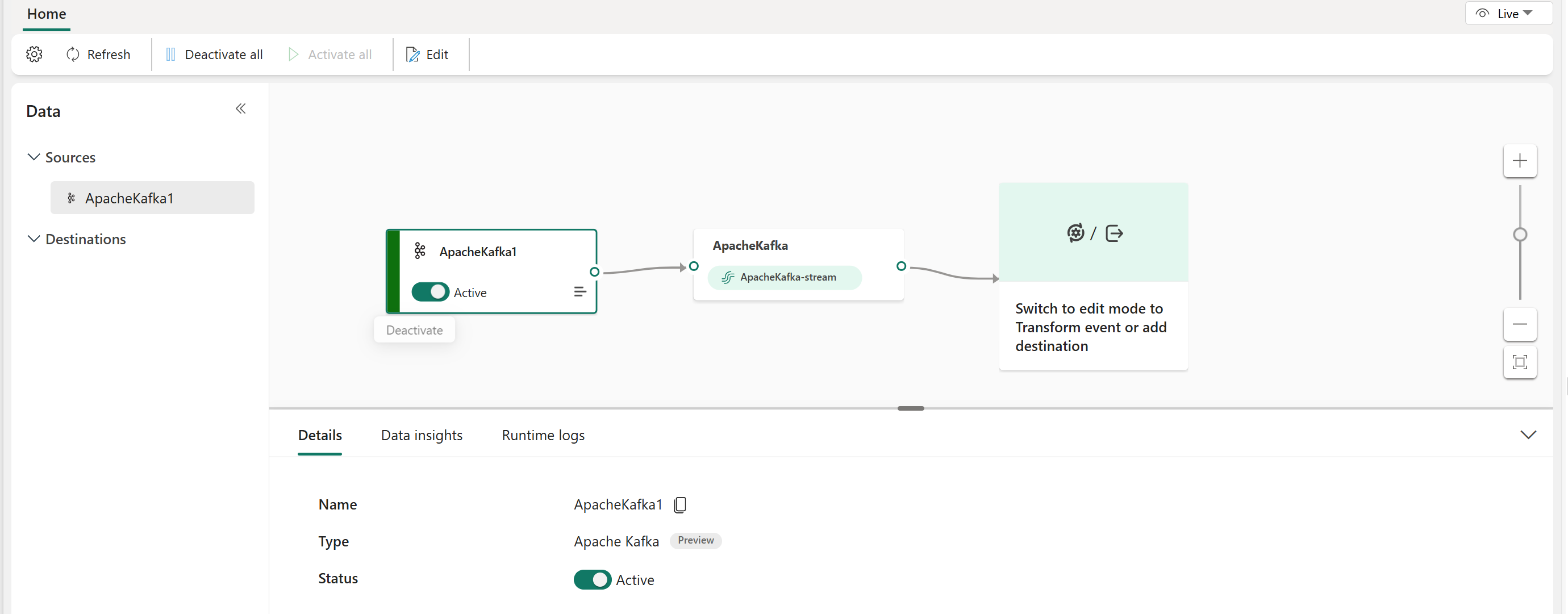

Dopo aver completato questi passaggi, l'origine Apache Kafka è disponibile per la visualizzazione in visualizzazione dinamica.

Contenuto correlato

Altri connettori:

- Flussi di dati Amazon Kinesis

- Azure Cosmos DB

- Hub eventi di Azure

- Hub IoT di Azure

- Change Data Capture (CDC) del Database SQL di Azure

- Endpoint personalizzato

- Google Cloud Pub/Sub

- Database MySQL CDC

- Database PostgreSQL CDC

- Dati di esempio

- Eventi di archiviazione BLOB di Azure

- Evento dell'area di lavoro di Fabric