Flux d'événements Microsoft Fabric – Présentation

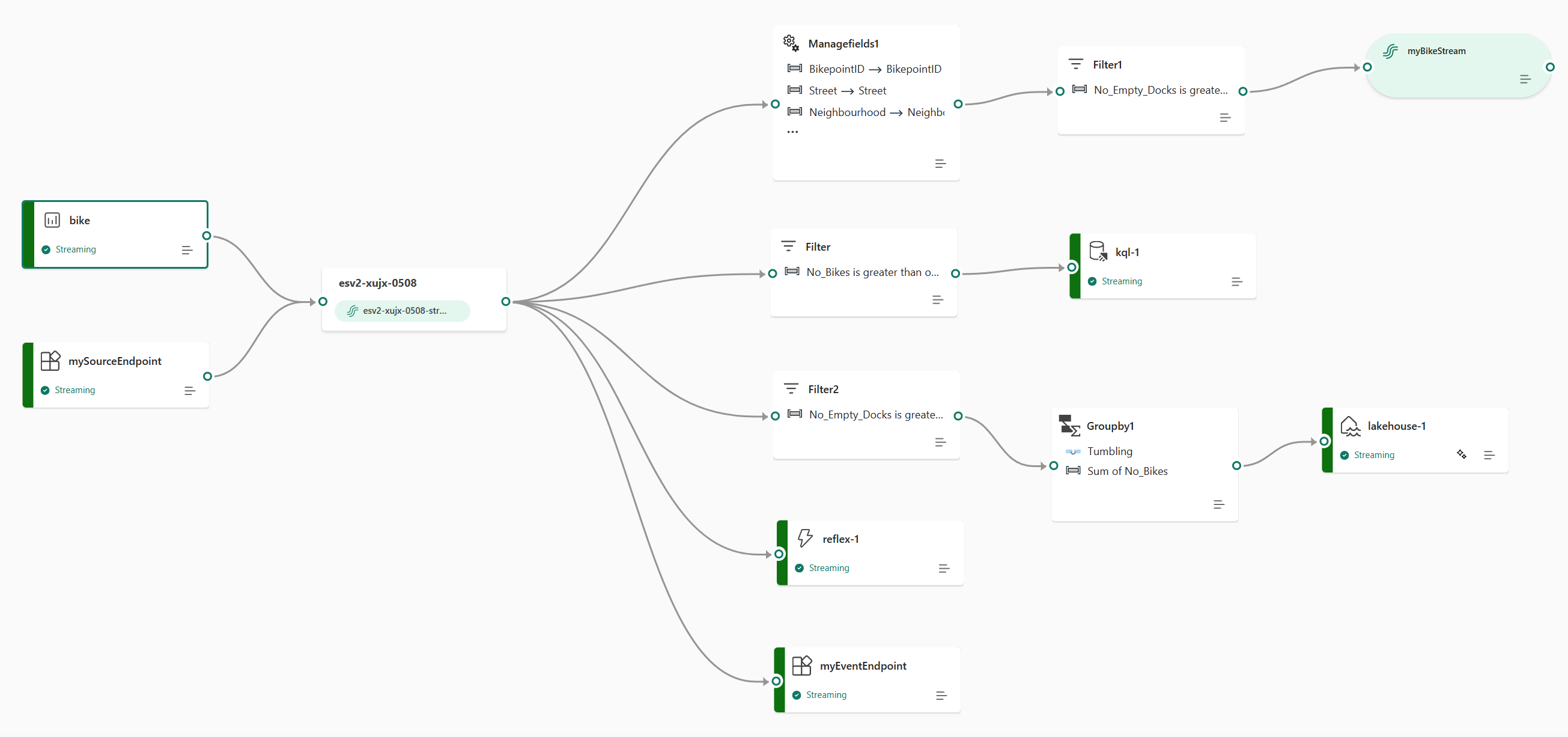

La fonctionnalité eventstreams de l’expérience Microsoft Fabric Real-Time Intelligence vous permet d’intégrer des événements en temps réel dans Fabric, de les transformer, puis de les acheminer vers différentes destinations sans écrire de code (sans code). Créez un Eventstream, qui est une instance de l’élément Eventstream dans Fabric, ajoutez des sources de données d’événement au flux, ajoutez éventuellement des transformations pour transformer les données d’événement, puis routez les données vers des destinations prises en charge. En outre, avec les points de terminaison Apache Kafka disponibles sur l’élément Eventstream, vous pouvez envoyer ou consommer des événements en temps réel à l’aide du protocole Kafka.

Intégrer des événements dans Fabric

La fonctionnalité eventstreams vous fournit différents connecteurs sources pour extraire des données d’événement à partir des différentes sources. Il existe davantage de sources lorsque vous activez les Fonctionnalités améliorées au moment de la création d’un Eventstream.

| Sources | Description |

|---|---|

| Azure Event Hubs | Si vous disposez d’un Event Hub Azure, vous pouvez ingérer des données Event Hub dans Microsoft Fabric à l’aide d’Eventstream. |

| Azure IoT Hub | Si vous disposez d’un Hub Azure IoT, vous pouvez ingérer des données IoT dans Microsoft Fabric à l’aide d’Eventstream. |

| Capture des changements de données (CDC) de la base de données Azure SQL | Le connecteur source Azure SQL Database CDC vous permet de capturer une instantané des données actuelles dans une base de données Azure SQL. Le connecteur surveille et enregistre ensuite les modifications futures au niveau des lignes apportées à ces données. |

| CDC de la base de données PostgreSQL | Le connecteur source de capture des changements de données (CDC) PostgreSQL Database vous permet de capturer un instantané des données actuelles dans une base de données PostgreSQL. Le connecteur surveille et enregistre ensuite les modifications futures au niveau des lignes apportées à ces données. |

| CDC de la base de données MySQL | Le connecteur source de capture des changements de données (CDC) Azure MySQL Database vous permet de capturer un instantané des données actuelles dans une base de données Azure Database pour MySQL. Vous pouvez spécifier les tables à surveiller, et le Eventstreams enregistre toutes les futures modifications au niveau des lignes apportées aux tables. |

| CDC d’Azure Cosmos DB | Le connecteur source de la capture des changements de données (CDC) d’Azure Cosmos DB pour les Eventstreams Microsoft Fabric vous permet de capturer un instantané des données actuelles dans une base de données Azure Cosmos DB. Le connecteur surveille et enregistre ensuite les modifications futures au niveau des lignes apportées à ces données. |

| SQL Server sur capture des changements de données d’une base de données de machine virtuelle (DB) | Le connecteur source SQL Server on VM DB (CDC) pour les flux d'événements Fabric vous permet de capturer un instantané des données actuelles d'une base de données SQL Server on VM. Le connecteur surveille et enregistre ensuite les modifications futures au niveau des lignes apportées aux données. |

| Azure SQL Managed Instance CDC | Le connecteur source CDC Azure SQL Managed Instance pour les Eventstreams Microsoft Fabric vous permet de capturer une instantané des données actuelles dans une base de données Azure SQL. Le connecteur surveille et enregistre ensuite les modifications futures au niveau des lignes apportées à ces données. |

| Google Cloud Pub/Sub | Google Pub/Sub est un service de messagerie qui vous permet de publier et de vous abonner aux Eventstreams. Vous pouvez ajouter Google Pub/Sub en tant que source à votre Eventstreams pour capturer, transformer et acheminer des événements en temps réel vers différentes destinations dans Fabric. |

| Flux de données Amazon Kinesis | Le flux de données Amazon Kinesis est une ingestion des données hautement durable et évolutive massivement évolutive et optimisée pour les données de streaming. Grâce à l’intégration des Flux de données Amazon Kinesis en tant que source au sein de votre Eventstreams, vous pouvez traiter en toute transparence les flux de données en temps réel avant de les router vers plusieurs destinations au sein de Fabric. |

| Confluent Cloud Kafka | Confluent Cloud Kafka est une plateforme de diffusion en continu offrant de puissantes fonctionnalités de diffusion en continu et de traitement des données à l’aide d’Apache Kafka. Grâce à l’intégration de Confluent Cloud Kafka en tant que source au sein de votre Eventstreams, vous pouvez traiter en toute transparence les flux de données en temps réel avant de les router vers plusieurs destinations au sein de Fabric. |

| Amazon MSK Kafka | Amazon MSK Kafka est un service Kafka entièrement managé qui simplifie l’installation, la mise à l’échelle et la gestion. En intégrant Amazon MSK Kafka en tant que source dans votre flux d'événements, vous pouvez apporter de manière transparente les événements en temps réel de votre MSK Kafka et les traiter avant de les acheminer vers plusieurs destinations au sein de Fabric. |

| Exemples de données | Vous pouvez choisir les événements Vélos, Taxi jaune ou Marché boursier comme exemple de source de données pour tester l’ingestion des données lors de la configuration d’un Eventstream. |

| Point de terminaison personnalisé (c’est-à-dire une application personnalisée dans la capacité standard) | La fonctionnalité d’un point de terminaison personnalisé permet à vos applications ou clients Kafka de se connecter à Eventstream à l’aide d’une chaîne de connexion, ce qui permet une ingestion fluide des données de streaming dans Eventstream. |

| Azure Service Bus (préversion) | Vous pouvez ingérer des données à partir d’une file d’attente Azure Service Bus ou d’un abonnement d’une rubrique dans Microsoft Fabric à l’aide d’Eventstream. |

| Apache Kafka (préversion) | Apache Kafka est une plateforme distribuée open source permettant de créer des systèmes de données évolutifs et en temps réel. En intégrant Apache Kafka en tant que source dans votre flux d'événements, vous pouvez apporter de manière transparente des événements en temps réel depuis votre Apache Kafka et les traiter avant de les acheminer vers de multiples destinations au sein de Fabric. |

| Événements de stockage Blob Azure (préversion) | Les événements de Stockage Blob Azure sont déclenchés quand un client crée, remplace ou supprime un objet blob. Le connecteur vous permet de lier des événements de stockage blob à des événements Fabric dans le hub en temps réel. Vous pouvez convertir ces événements en flux de données continus et les transformer avant de les router vers différentes destinations dans Fabric. |

| Événements d’élément d’espace de travail Fabric (préversion) | Les événements d’élément d’espace de travail Fabric sont des événements Fabric discrets qui se produisent lorsque des modifications sont apportées à votre espace de travail Fabric. Ces modifications incluent la création, la mise à jour ou la suppression d’un élément Fabric. Avec les Eventstreams Fabric, vous pouvez capturer ces événements d’espace de travail Fabric, les transformer et les router vers différentes destinations dans Fabric pour une analyse plus approfondie. |

Traiter des événements à l’aide d’une expérience sans code

L'expérience de glisser-déposer vous offre un moyen intuitif et simple de créer votre traitement de données, de transformation et de routage des données d'événement sans écrire de code. Un diagramme de flux de données de bout en bout dans un flux d'événements peut vous fournir une compréhension complète du flux et de l'organisation des données. L'éditeur de processeur d'événements est une expérience sans code qui vous permet d'effectuer un glisser-déposer pour concevoir la logique de traitement des données d'événement.

| Transformation | Description |

|---|---|

| Filter | Utilisez la transformation Filtrer pour filtrer les événements en fonction de la valeur d’un champ dans l’entrée. Selon le type de données (nombre ou texte), la transformation conserve les valeurs qui correspondent à la condition sélectionnée, comme is null ou is not null. |

| Gérer les champs | La transformation Gérer les champs permet d’ajouter, de supprimer, de changer le type de données et de renommer des champs provenant d’une entrée ou d’une autre transformation. |

| Agrégat | Utilisez la transformation Aggregate pour calculer une agrégation (Sum, Minimum, Maximum ou Average) chaque fois qu'un nouvel événement se produit sur une période donnée. Cette opération permet également de renommer ces colonnes calculées et de filtrer ou de découper l’agrégation en fonction d’autres dimensions de vos données. Il peut y avoir plusieurs agrégations dans la même transformation. |

| Regrouper par | Utilisez la transformation Regrouper par pour calculer les agrégations sur tous les événements d’une fenêtre de temps donnée. Vous pouvez regrouper par les valeurs d’un ou plusieurs champs. Il s'agit d'une transformation similaire à la transformation Aggregate qui permet de renommer les colonnes, mais qui offre davantage d'options d'agrégation et des options plus complexes pour les fenêtres temporelles. Comme Aggregate, vous pouvez ajouter plusieurs agrégations par transformation. |

| Union | Utilisez la transformation Union pour connecter deux nœuds ou plus et ajouter des événements qui ont des champs partagés (avec le même nom et le même type de données) dans une table. Les champs qui ne correspondent pas ne sont pas inclus dans la sortie. |

| Développer | Utilisez la transformation Développer le tableau pour créer une ligne pour chaque valeur dans un tableau. |

| Participer | Utilisez la transformation Join pour combiner des données à partir de deux flux en fonction d’une condition de correspondance entre les deux. |

Si vous avez activé Fonctions améliorées lors de la création d’un flux d’événements, les opérations de transformation sont prises en charge pour toutes les destinations (avec un flux dérivé agissant comme pont intermédiaire pour certaines destinations, comme le point de terminaison personnalisé, l’activateur Fabric). Si ce n’est pas le cas, les opérations de transformation sont disponibles uniquement pour les destinations Lakehouse et Eventhouse (traitement des événements avant l’ingestion).

Router des événements vers des destinations

La fonctionnalité Eventstream Fabric prend en charge l’envoi de données aux destinations prises en charge suivantes.

| Destination | Description |

|---|---|

| Point de terminaison personnalisé (par exemple, application personnalisée en fonctionnalité standard) | Avec cette destination, vous pouvez facilement acheminer vos événements en temps réel vers un point de terminaison personnalisé. Vous pouvez connecter vos propres applications au flux d'événements et consommer les données d'événements en temps réel. Cette destination est utile lorsque vous souhaitez faire sortir des données en temps réel vers un système externe à Microsoft Fabric. |

| Eventhouse | Cette destination vous permet d’ingérer vos données d’événements en temps réel dans un Eventhouse, où vous pouvez utiliser le puissant Kusto Query Language (KQL) pour interroger et analyser les données. Grâce aux données contenues dans Eventhouse, vous pouvez obtenir des informations plus approfondies sur vos données d’événements et créer des rapports et des tableaux de bord détaillés. Vous pouvez choisir entre deux modes d’ingestion : l’ingestion directe et le traitement des événements avant l’ingestion. |

| Lakehouse | Cette destination vous permet de transformer vos événements en temps réel avant de les intégrer dans votre lakehouse. Les événements en temps réel sont convertis au format Delta Lake, puis stockés dans les tables lakehouse désignées. Cette destination prend en charge les scénarios d’entrepôt de données. |

| Flux dérivé | Le flux dérivé est un type spécialisé de destination que vous pouvez créer après l’ajout d’opérations de flux, telles que Filtrer ou Gérer les champs, à un Eventstream. Le flux dérivé représente le flux par défaut transformé suivant le traitement de flux. Vous pouvez router le flux dérivé vers plusieurs destinations dans Fabric et afficher le flux dérivé dans le hub en temps réel. |

| Fabric Activator (préversion) | Cette destination vous permet de connecter directement vos données d’événements en temps réel à un Fabric Activator. Activator est un type d’agent intelligent qui contient toutes les informations nécessaires pour se connecter aux données, surveiller les conditions et effectuer des actions. Lorsque les données atteignent certains seuils ou correspondent à d’autres modèles, Activator effectue automatiquement des actions appropriées, comme l’alerte des utilisateurs ou le lancement de flux de travail Power Automate. |

Vous pouvez joindre plusieurs destinations dans un flux d'événements pour recevoir simultanément des données de vos flux d'événements sans interférer les uns avec les autres.

Remarque

Nous vous recommandons d’utiliser la fonctionnalité de flux d’événements Microsoft Fabric avec au moins 4 unités de capacité (référence SKU: F4)

Flux d’événements Apache Kafka sur Fabric

La fonctionnalité flux d’événements Fabric offre un point de terminaison Apache Kafka sur l’élément Eventstream, ce qui permet aux utilisateurs de se connecter et de consommer des événements de streaming en continu via le protocole Kafka. Si vous disposez déjà d’une application qui utilise le protocole Apache Kafka pour envoyer ou consommer des événements de streaming avec des rubriques Kafka spécifiques, vous pouvez facilement adapter la même application pour envoyer ou consommer les événements de streaming dans votre flux d’événements en mettant simplement à jour vos paramètres de connexion pour pointer vers le point de terminaison Kafka fourni dans votre flux d’événements.

La fonctionnalité flux d’événements Fabric est alimentée par Azure Event Hubs, un service natif cloud entièrement managé. Lorsqu’un flux d’événements est créé, un espace de noms Event Hub est automatiquement approvisionné et un hub d’événements est alloué au flux par défaut sans nécessiter de configurations d’approvisionnement. Pour en savoir plus sur les fonctionnalités compatibles Kafka dans le service Azure Event Hubs, consultez Azure Event Hubs pour Apache Kafka.

Pour en savoir plus sur l’obtention des détails du point de terminaison Kafka pour l’envoi d’événements à Eventstream, consultez Ajouter une source de point de terminaison personnalisée à un eventstream et pour consommer des événements à partir d’un eventstream, consultez Ajouter une destination de point de terminaison personnalisée à un eventstream.

Fonctions améliorées

Il existe d’autres fonctionnalités, sources et destinations disponibles lorsque vous activez l’option Fonctionnalités améliorées lors de la création d’un eventstream. Utilisez les onglets Fonctionnalités améliorées et Fonctionnalités standard pour en savoir plus sur les sources et destinations supplémentaires prises en charge avec les fonctionnalités améliorées.

Voici quelques autres fonctionnalités notables des fonctionnalités améliorées :

- Mode Édition et affichage en direct. Explorez deux modes distincts pour visualiser et concevoir un traitement de flux.

- Flux par défaut et dérivés. Créez un flux continu de flux avec le format que vous concevez, avec un processeur d’événements qui peut être consommé ultérieurement dans le hub en temps réel.

- Routage des flux de données en fonction du contenu. Transformez et routez vos flux de données n’importe où dans Fabric en fonction du contenu du flux de données que vous avez conçu avec le processeur d’événements.