Ajouter une destination lakehouse à un Eventstream

Cet article vous montre comment ajouter un Lakehouse en tant que destination à un Eventstream dans les Eventstreams Microsoft Fabric. Pour optimiser les performances de diffusion en continu et les requêtes en temps réel, envisagez de diffuser en continu des données vers un Eventhouse avec l’ajout de la destination Eventhouse à un flux d’événements, puis activez la disponibilité d’Eventhouse dans un OneLake.

Remarque

Les fonctionnalités améliorées sont activées par défaut si vous créez des flux d’événements maintenant. Si des flux d’événements existants ont été créés en utilisant les fonctionnalités standard, ces flux d’événements continueront à fonctionner. Vous pouvez toujours les modifier et les utiliser comme d’habitude. Nous vous recommandons de créer un nouveau flux d’événements pour remplacer les flux d’événements standard afin que vous puissiez tirer parti des fonctionnalités supplémentaires et des avantages des flux d’événements améliorés.

Important

Il existe une application de schéma pour écrire des données dans une table de destination Lakehouse. Toutes les nouvelles écritures dans une table doivent être compatibles avec le schéma de la table cible au moment de l’écriture, ce qui garantit la qualité des données.

En cas d’écriture de la sortie dans une nouvelle table delta, le schéma de table est créé en fonction du premier enregistrement. Tous les enregistrements de données de sortie sont projetés dans le schéma de la table existante.

Si les données entrantes ont des colonnes qui ne figurent pas dans le schéma de table existant, les colonnes supplémentaires ne sont pas incluses dans les données écrites dans la table. Inversement, s’il manque une colonne aux données entrantes par rapport au schéma de la table existante, elles sont écrites dans la table avec la valeur de la colonne définie sur nul.

Prérequis

- Accès à un espace de travail en mode licence de capacité Fabric ou en mode licence d’évaluation avec des autorisations Collaborateur ou supérieures.

- Accédez à un espace de travail lorsque votre Lakehouse est doté d’autorisations Contributor ou supérieures.

Remarque

Le nombre maximal de sources et de destinations pour un flux d’événements est de 11.

Ajouter un lakehouse comme destination

Pour ajouter une destination Lakehouse à un Eventstream par défaut ou dérivé, suivez les étapes suivantes.

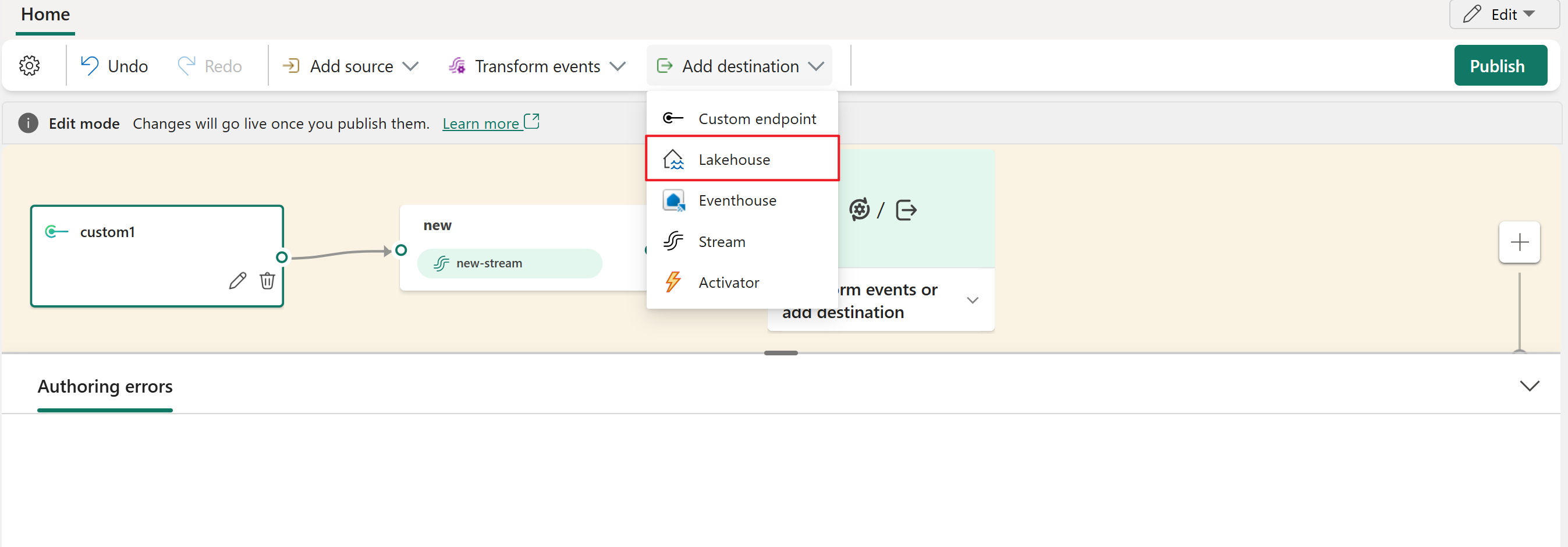

En mode Édition de votre Eventstream, sélectionnez Ajouter une destination dans le ruban et sélectionnez Lakehouse dans la liste déroulante.

Connecter le nœud lakehouse à votre nœud de flux ou à votre opérateur.

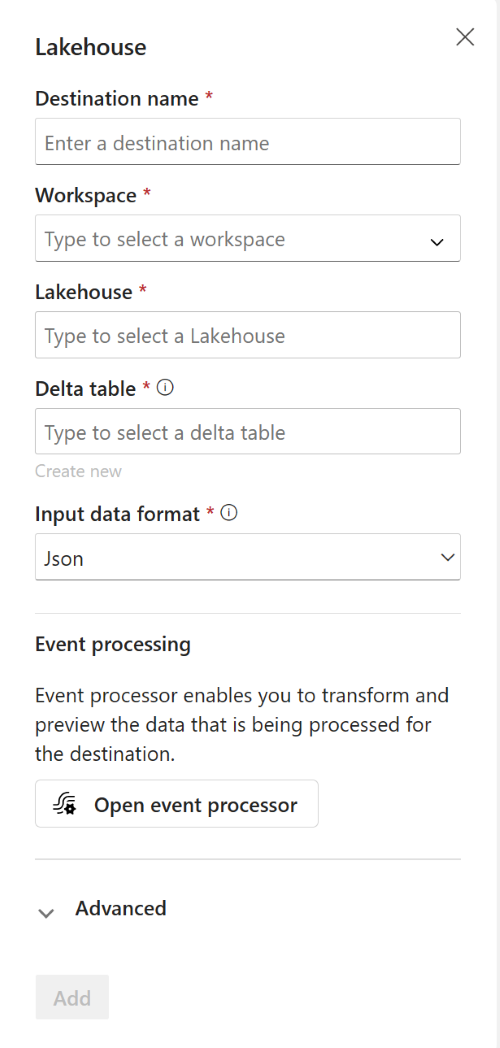

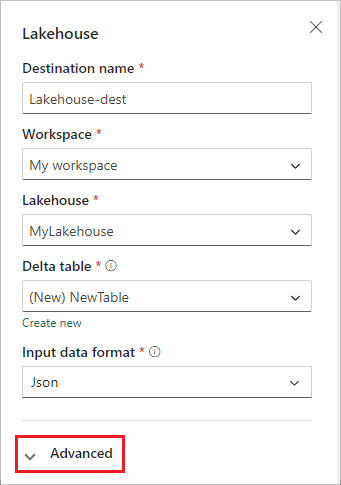

Dans l’écran de configuration de Lakehouse, renseignez les informations suivantes :

- Entrez un Nom de destination.

- Sélectionnez l’espace de travail qui contient votre Lakehouse.

- Sélectionnez un Lakehouse existant dans l’espace de travail que vous avez spécifié.

- Sélectionnez une table delta existante ou créez-en une pour recevoir des données.

- Sélectionnez le format des données d’entrée qui sont envoyées à votre Lakehouse. Les formats de données pris en charge sont JSON, Avro et CSV (avec en-tête).

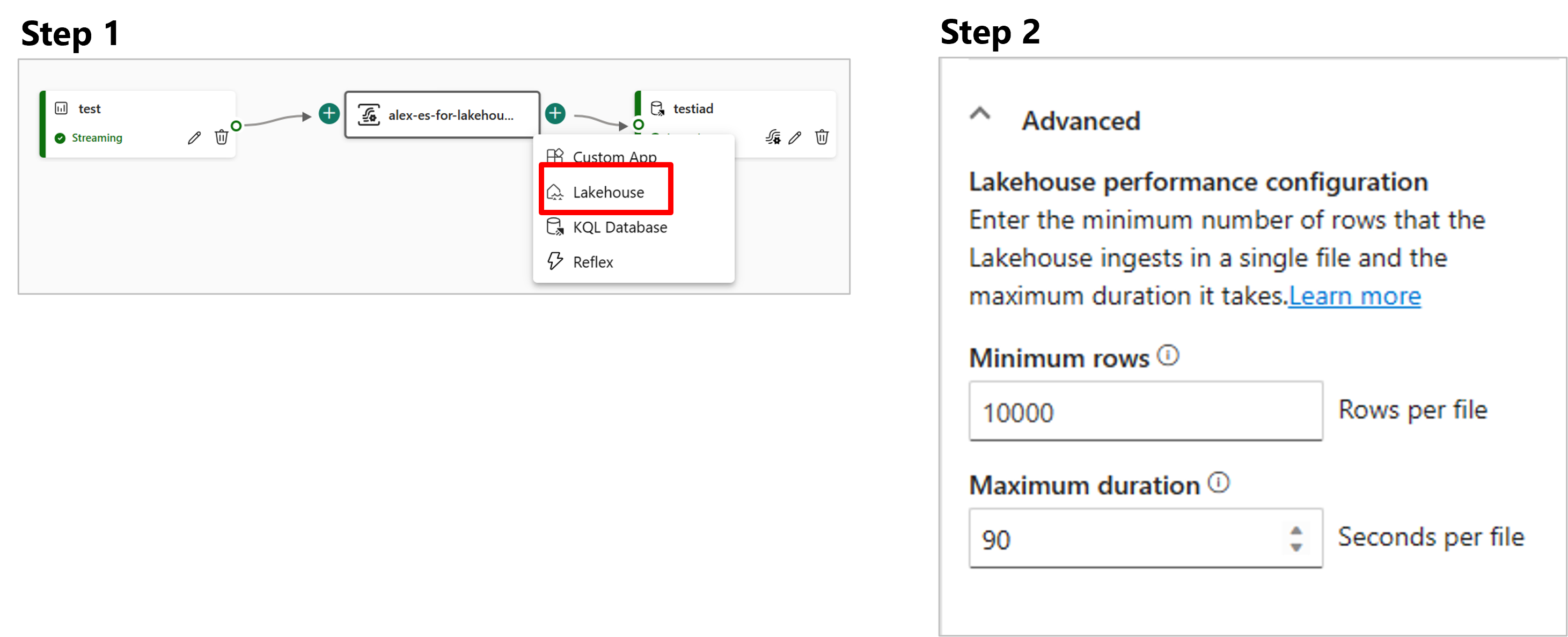

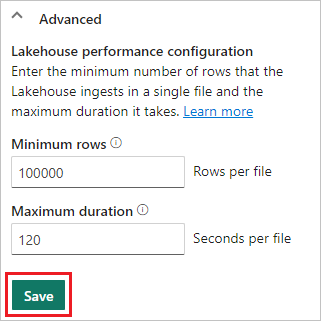

Sélectionnez Avancé.

Deux modes d’ingestion sont disponibles pour une destination lakehouse. Sur la base de votre scénario, configurez ces méthodes pour optimiser la façon dont l’Eventstream de Fabric écrit dans le Lakehouse.

Nombre minimal de lignes est le nombre minimal de lignes ingérées par Lakehouse dans un seul fichier. Le minimum est de 1 ligne et le maximum est de 2 millions de lignes par fichier. Plus le nombre minimum de lignes est faible, plus le Lakehouse créera de fichiers lors de l’ingestion.

Durée maximale est la durée maximale que Lakehouse prend pour ingérer un fichier unique. Le minimum est de 1 minute et le maximum est de 2 heures. Plus la durée est longue, plus le nombre de lignes ingérées dans un fichier est important.

Cliquez sur Enregistrer.

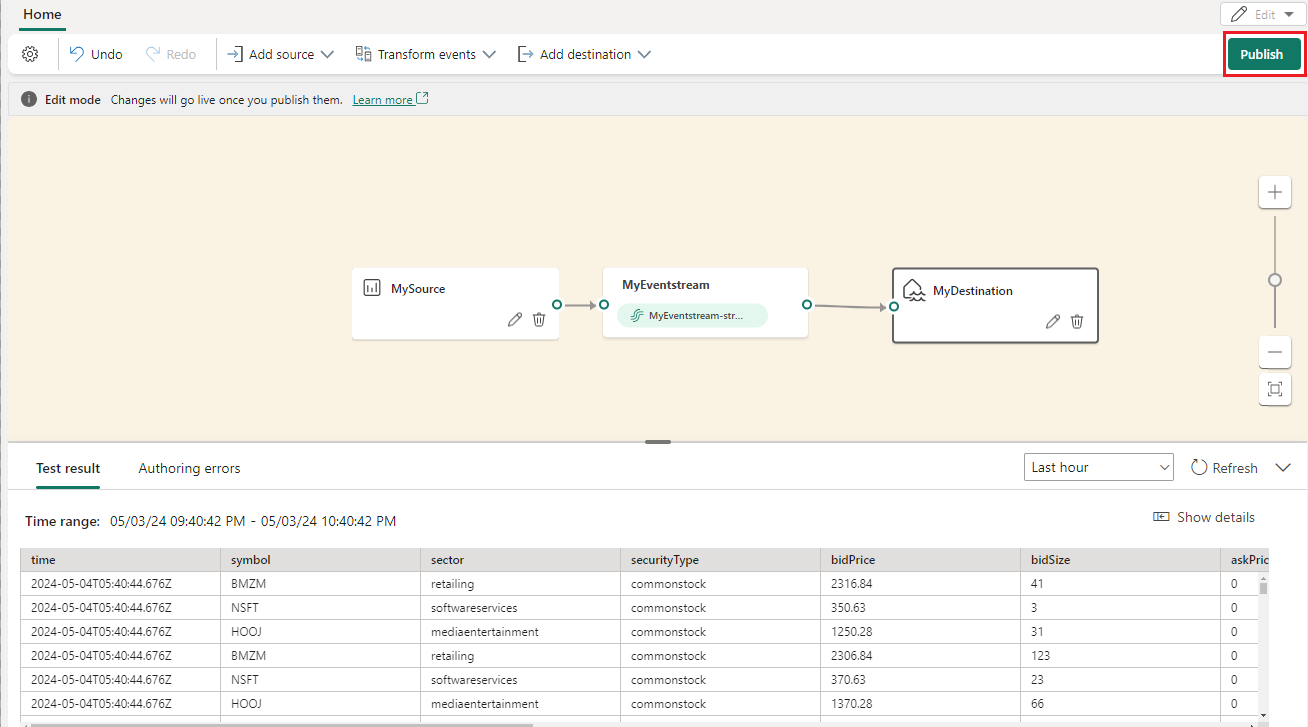

Pour implémenter la destination Lakehouse nouvellement ajoutée, sélectionnez Publier.

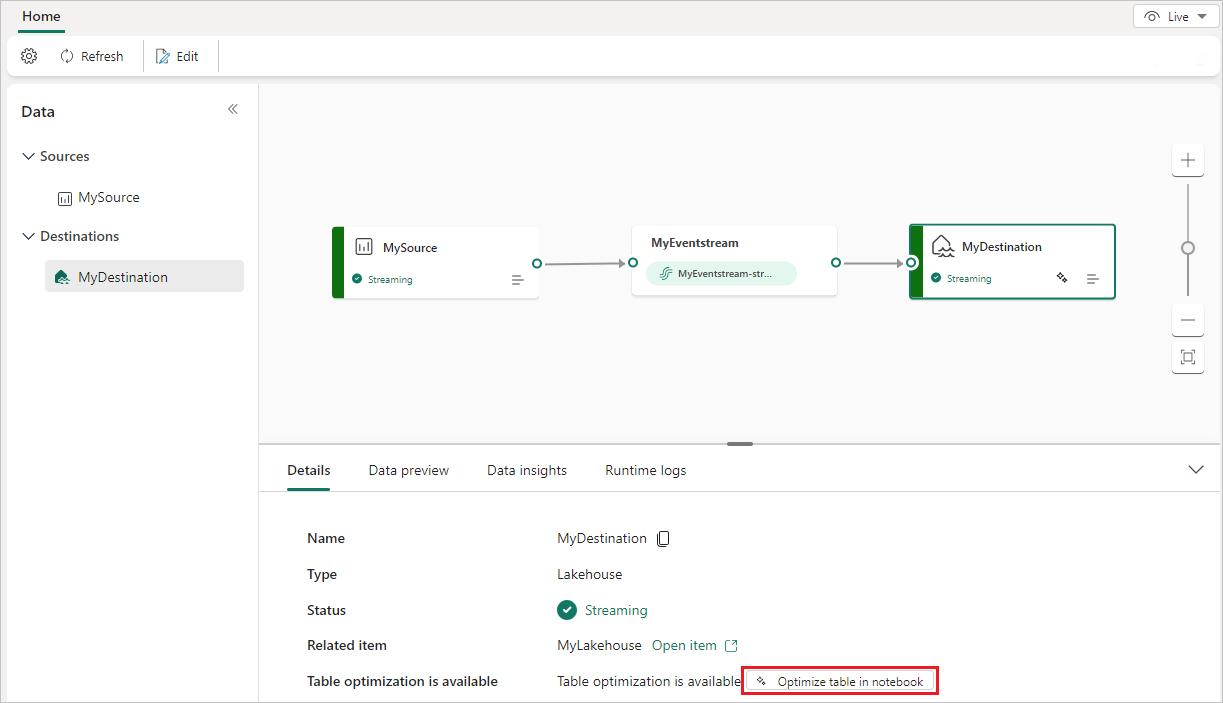

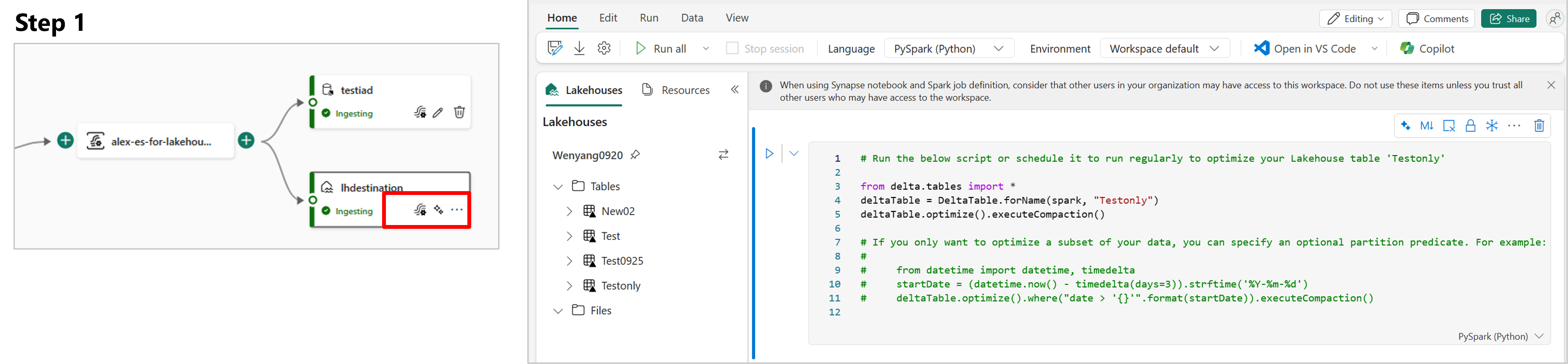

Une fois que vous avez effectué ces étapes, la destination Lakehouse est disponible pour la visualisation en affichage direct. Dans le volet Détails, vous pouvez sélectionner la table Optimiser dans le raccourci du bloc-notes pour lancer une tâche Apache Spark dans un bloc-notes, ce qui consolide les petits fichiers de diffusion en continu dans la table Lakehouse cible.

Contenu connexe

Pour savoir comment ajouter d’autres destinations à un Eventstream, consultez les articles suivants :

Prérequis

Pour commencer, vous devez remplir les conditions préalables suivantes :

- Accès à un espace de travail en mode licence de capacité Fabric ou en mode licence d’évaluation avec des autorisations Collaborateur ou supérieures.

- Accédez à un espace de travail avec des autorisations Contributor ou supérieures là où se trouve votre Lakehouse.

Remarque

Le nombre maximal de sources et de destinations pour un flux d’événements est de 11.

Ajouter un lakehouse comme destination

Si vous avez créé un lakehouse dans votre espace de travail, procédez comme suit pour ajouter ce lakehouse à votre flux d’événements en tant que destination :

Sélectionnez Nouvelle destination dans le ruban ou «+ » dans le canevas de l’éditeur main, puis sélectionnez Lakehouse. L’écran de configuration de la destination Lakehouse s’affiche.

Entrez un nom pour la destination du flux d’événements, puis renseignez les informations relatives à votre lakehouse.

Lakehouse : sélectionnez un lakehouse existant dans l’espace de travail que vous avez spécifié.

Table delta : sélectionnez une table delta existante ou créez-en une pour recevoir des données.

Remarque

Lors de l’écriture de données dans la table lakehouse, il existe une application de schéma. Cela signifie que toutes les nouvelles écritures dans une table doivent être compatibles avec le schéma de la table cible au moment de l'écriture, ce qui garantit la qualité des données.

Tous les enregistrements de données de sortie sont projetés dans le schéma de la table existante. En cas d’écriture de la sortie dans une nouvelle table delta, le schéma de table est créé en fonction du premier enregistrement. Si les données entrantes comportent une colonne supplémentaire par rapport au schéma de table existant, elles sont écrites dans la table sans colonne supplémentaire. Inversement, s’il manque une colonne aux données entrantes par rapport au schéma de la table existante, elles sont écrites dans la table avec la valeur de la colonne définie sur null.

Format des données d’entrée : sélectionnez le format des données (données d’entrée) envoyées à votre lakehouse.

Remarque

Les formats de données d’événement d’entrée pris en charge sont JSON, Avro et CSV (avec en-tête).

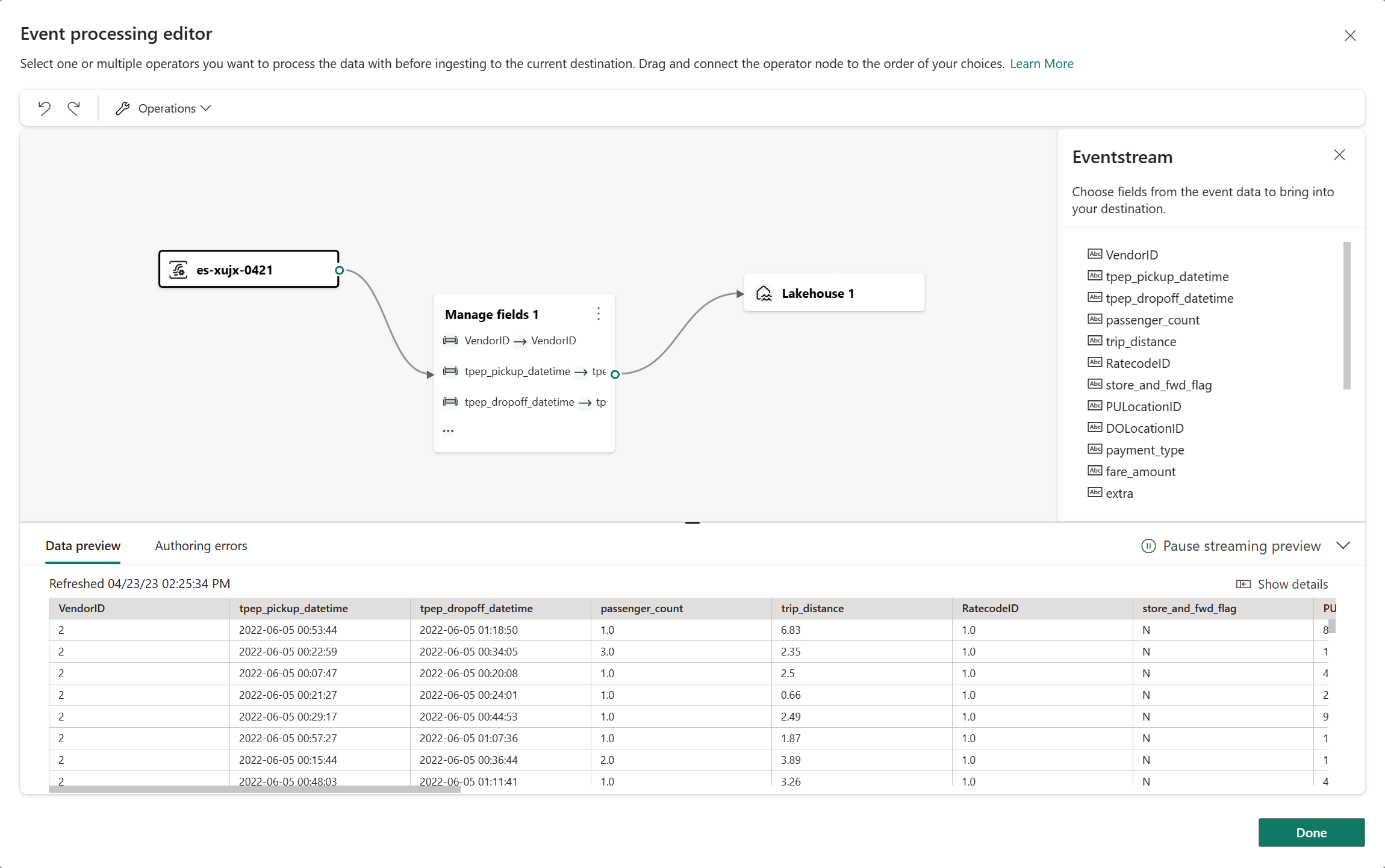

Traitement des événements : vous pouvez utiliser l’éditeur de traitement des événements pour spécifier comment les données doivent être traitées avant d’être envoyées à votre Lakehouse. Sélectionnez Ouvrir le processeur d’événements pour ouvrir l’éditeur de traitement des événements. Pour plus d’informations sur le traitement en temps réel à l’aide du processeur d’événements, consultez l’article Traiter les données d’événement avec l’éditeur du processeur d’événements. Quand vous avez terminé d’utiliser l’éditeur, sélectionnez Terminé pour revenir à l’écran de configuration de la destination Lakehouse.

Deux modes d’ingestion sont disponibles pour une destination lakehouse. Sélectionnez l’un de ces modes pour optimiser la façon dont la fonctionnalité de flux d’événements Fabric écrit dans le lakehouse en fonction de votre scénario.

Lignes par fichier – Nombre minimal de lignes ingérées par Lakehouse dans un seul fichier. Plus le nombre minimum de lignes est faible, plus Lakehouse crée de fichiers lors de l’ingestion. La valeur minimale est 1 ligne. La valeur maximale est de 2 millions de lignes par fichier.

Durée – Durée maximale que Lakehouse prend pour ingérer un fichier unique. Plus la durée est longue, plus le nombre de lignes ingérées dans un fichier est important. Le minimum est de 1 minute et le maximum est de 2 heures.

Sélectionnez Ajouter pour ajouter la destination lakehouse.

Raccourci d’optimisation de table disponible à l’intérieur de la destination lakehouse. Cette solution vous facilite en lançant un travail Spark dans un notebook, qui consolide ces petits fichiers de streaming dans la table Lakehouse cible.

Une destination Lakehouse apparaît sur le canevas, avec un indicateur d’état en rotation. En quelques minutes, le système remplace l’état par Actif.

Gérer une destination

Modifier/supprimer : vous pouvez modifier ou supprimer une destination de flux d’événements via le volet de navigation ou le canevas.

Quand vous sélectionnez Modifier, le volet Modifier s’ouvre à droite de l’éditeur principal. Vous pouvez modifier la configuration comme vous le souhaitez, y compris la logique de transformation des événements via l’éditeur du processeur d’événements.

Contenu connexe

Pour savoir comment ajouter d’autres destinations à un Eventstream, consultez les articles suivants :