Dodawanie źródła zdarzeń i zarządzanie nim w strumieniu zdarzeń

Po utworzeniu strumienia zdarzeń można połączyć go z różnymi źródłami danych i miejscami docelowymi.

Uwaga

Rozszerzone możliwości są domyślnie włączone podczas tworzenia strumieni zdarzeń. Jeśli masz strumienie zdarzeń utworzone przy użyciu standardowych możliwości, te strumienie zdarzeń będą nadal działać. Nadal możesz edytować i używać ich jak zwykle. Zalecamy utworzenie nowego strumienia zdarzeń w celu zastąpienia standardowych strumieni zdarzeń, dzięki czemu można korzystać z dodatkowych możliwości i korzyści z rozszerzonych strumieni zdarzeń.

Po utworzeniu strumienia zdarzeń można połączyć go z różnymi źródłami danych i miejscami docelowymi.

Strumień zdarzeń nie tylko umożliwia przesyłanie strumieniowe danych ze źródeł firmy Microsoft, ale także obsługuje pozyskiwanie z platform innych firm, takich jak Google Cloud i Amazon Kinesis, z nowymi łącznikami obsługi komunikatów. Ta rozszerzona funkcja zapewnia bezproblemową integrację zewnętrznych strumieni danych z siecią szkieletową, zapewniając większą elastyczność i umożliwiając uzyskiwanie szczegółowych informacji w czasie rzeczywistym z wielu źródeł.

W tym artykule dowiesz się więcej o źródłach zdarzeń, które można dodać do strumienia zdarzeń.

Wymagania wstępne

- Dostęp do obszaru roboczego w trybie licencji pojemności sieci szkieletowej (lub) w trybie licencji próbnej z uprawnieniami współautora lub wyższymi uprawnieniami.

- Wymagania wstępne specyficzne dla każdego źródła, które są udokumentowane w następujących artykułach specyficznych dla źródła.

Obsługiwane źródła

Strumienie zdarzeń sieci szkieletowej z rozszerzonymi możliwościami obsługują następujące źródła. Każdy artykuł zawiera szczegółowe informacje i instrukcje dotyczące dodawania określonych źródeł.

| Źródła | opis |

|---|---|

| Azure Event Hubs | Jeśli masz centrum zdarzeń platformy Azure, możesz pozyskiwać dane centrum zdarzeń do usługi Microsoft Fabric przy użyciu strumienia zdarzeń. |

| Azure IoT Hub | Jeśli masz centrum Azure IoT, możesz pozyskiwać dane IoT do usługi Microsoft Fabric przy użyciu usługi Eventstream. |

| Przechwytywanie zmian danych w usłudze Azure SQL Database (CDC) | Łącznik źródłowy usługi Azure SQL Database CDC umożliwia przechwycenie migawki bieżących danych w bazie danych Azure SQL Database. Następnie łącznik monitoruje i rejestruje wszelkie przyszłe zmiany na poziomie wiersza w tych danych. |

| CdC bazy danych PostgreSQL | Łącznik źródłowy przechwytywania zmian danych bazy danych PostgreSQL (CDC) umożliwia przechwycenie migawki bieżących danych w bazie danych PostgreSQL. Następnie łącznik monitoruje i rejestruje wszelkie przyszłe zmiany na poziomie wiersza w tych danych. |

| Usługa CDC bazy danych MySQL | Łącznik źródła przechwytywania zmian danych w usłudze Azure MySQL (CDC) umożliwia przechwycenie migawki bieżących danych w bazie danych usługi Azure Database for MySQL. Możesz określić tabele do monitorowania, a strumień zdarzeń rejestruje wszelkie przyszłe zmiany na poziomie wiersza w tabelach. |

| Azure Cosmos DB CDC | Łącznik źródła przechwytywania zmian danych (CDC) usługi Azure Cosmos DB dla strumieni zdarzeń usługi Microsoft Fabric umożliwia przechwycenie migawki bieżących danych w bazie danych usługi Azure Cosmos DB. Następnie łącznik monitoruje i rejestruje wszelkie przyszłe zmiany na poziomie wiersza w tych danych. |

| Sql Server na maszynie wirtualnej (VM) Database (DB) CDC | Łącznik źródłowy programu SQL Server w usłudze VM DB (CDC) dla strumieni zdarzeń sieci szkieletowej umożliwia przechwycenie migawki bieżących danych w bazie danych programu SQL Server na maszynie wirtualnej. Następnie łącznik monitoruje i rejestruje wszelkie przyszłe zmiany na poziomie wiersza w danych. |

| Azure SQL Managed Instance CDC | Łącznik źródłowy usługi CdC usługi Azure SQL Managed Instance dla strumieni zdarzeń usługi Microsoft Fabric umożliwia przechwycenie migawki bieżących danych w bazie danych usługi SQL Managed Instance. Następnie łącznik monitoruje i rejestruje wszelkie przyszłe zmiany na poziomie wiersza w tych danych. |

| Google Cloud Pub/Sub | Google Pub/Sub to usługa obsługi komunikatów, która umożliwia publikowanie i subskrybowanie strumieni zdarzeń. Możesz dodać usługę Google Pub/Sub jako źródło do strumienia zdarzeń w celu przechwytywania, przekształcania i kierowania zdarzeń w czasie rzeczywistym do różnych miejsc docelowych w usłudze Fabric. |

| Strumienie danych Amazon Kinesis | Strumienie danych Amazon Kinesis to wysoce skalowalne, wysoce trwałe pozyskiwanie danych i usługa przetwarzania zoptymalizowana pod kątem danych przesyłanych strumieniowo. Integrując strumienie danych Amazon Kinesis jako źródło w strumieniu zdarzeń, można bezproblemowo przetwarzać strumienie danych w czasie rzeczywistym przed kierowaniem ich do wielu miejsc docelowych w sieci szkieletowej. |

| Confluent Cloud Kafka | Confluent Cloud Kafka to platforma przesyłania strumieniowego oferująca zaawansowane funkcje przesyłania strumieniowego i przetwarzania danych przy użyciu platformy Apache Kafka. Integrując platformę Confluent Cloud Kafka jako źródło w strumieniu zdarzeń, można bezproblemowo przetwarzać strumienie danych w czasie rzeczywistym przed kierowaniem ich do wielu miejsc docelowych w sieci szkieletowej. |

| Amazon MSK Kafka | Amazon MSK Kafka to w pełni zarządzana usługa platformy Kafka, która upraszcza konfigurowanie, skalowanie i zarządzanie. Dzięki zintegrowaniu platformy Amazon MSK Kafka jako źródła w strumieniu zdarzeń można bezproblemowo przenieść zdarzenia w czasie rzeczywistym z platformy MSK Kafka i przetworzyć je przed kierowaniem ich do wielu miejsc docelowych w usłudze Fabric. |

| Dane przykładowe | Możesz wybrać pozycję Rowery, Żółta taksówka lub Zdarzenia giełdowe jako przykładowe źródło danych, aby przetestować pozyskiwanie danych podczas konfigurowania strumienia zdarzeń. |

| Niestandardowy punkt końcowy (czyli aplikacja niestandardowa w standardowej możliwości) | Funkcja niestandardowego punktu końcowego umożliwia aplikacjom lub klientom platformy Kafka łączenie się z strumieniem zdarzeń przy użyciu parametry połączenia, co umożliwia płynne pozyskiwanie danych przesyłanych strumieniowo do usługi Eventstream. |

| Azure Service Bus (wersja zapoznawcza) | Dane można pozyskiwać z kolejki usługi Azure Service Bus lub subskrypcji tematu do usługi Microsoft Fabric przy użyciu strumienia zdarzeń. |

| Apache Kafka (wersja zapoznawcza) | Apache Kafka to rozproszona platforma typu open source do tworzenia skalowalnych systemów danych w czasie rzeczywistym. Integrując Apache Kafka jako źródło w strumieniu zdarzeń, można bezproblemowo sprowadzać zdarzenia w czasie rzeczywistym z Apache Kafka i przetwarzać je przed ich przekierowaniem do wielu miejsc docelowych w Fabric. |

| Zdarzenia usługi Azure Blob Storage (wersja zapoznawcza) | Zdarzenia usługi Azure Blob Storage są wyzwalane, gdy klient tworzy, zastępuje lub usuwa obiekt blob. Łącznik umożliwia łączenie zdarzeń usługi Blob Storage z zdarzeniami sieci szkieletowej w centrum czasu rzeczywistego. Te zdarzenia można przekonwertować na ciągłe strumienie danych i przekształcić je przed kierowaniem ich do różnych miejsc docelowych w sieci szkieletowej. |

| Zdarzenia elementu obszaru roboczego sieci szkieletowej (wersja zapoznawcza) | Zdarzenia elementu obszaru roboczego sieci szkieletowej to odrębne zdarzenia sieci szkieletowej, które występują po wprowadzeniu zmian w obszarze roboczym sieci szkieletowej. Te zmiany obejmują tworzenie, aktualizowanie lub usuwanie elementu sieci szkieletowej. Strumienie zdarzeń sieci szkieletowej umożliwiają przechwytywanie tych zdarzeń obszaru roboczego sieci szkieletowej, przekształcanie ich i kierowanie ich do różnych miejsc docelowych w sieci szkieletowej w celu dalszej analizy. |

| Wydarzenia Fabric OneLake (podgląd) | Zdarzenia OneLake umożliwiają subskrybowanie zmian w plikach i folderach w usłudze OneLake, a następnie reagowanie na te zmiany w czasie rzeczywistym. Strumienie zdarzeń Fabric umożliwiają przechwytywanie tych zdarzeń OneLake, przekształcanie ich i kierowanie ich do różnych miejsc docelowych w Fabric w celu dalszej analizy. Bezproblemowa integracja zdarzeń OneLake w strumieniach zdarzeń usługi Fabric zapewnia większą elastyczność monitorowania i analizowania działań w usłudze OneLake. |

| |

Zdarzenia zadań umożliwiają subskrybowanie zmian generowanych, gdy Fabric uruchamia zadanie. Na przykład można reagować na zmiany podczas odświeżania modelu semantycznego, uruchamiania zaplanowanego potoku lub uruchamiania notatnika. Każde z tych działań może wygenerować odpowiadające mu zadanie, które z kolei generuje zestaw powiązanych zdarzeń związanych z zadaniem. Strumienie zdarzeń Fabric umożliwiają przechwytywanie tych zdarzeń zadań, przekształcanie ich i kierowanie do różnych miejsc docelowych w Fabric do dalszej analizy. Ta bezproblemowa integracja zdarzeń zadań w strumieniach zdarzeń usługi Fabric zapewnia większą elastyczność monitorowania i analizowania działań w zadaniu. |

Uwaga

Maksymalna liczba źródeł i miejsc docelowych dla jednego strumienia zdarzeń wynosi 11.

Powiązana zawartość

Wymagania wstępne

Przed rozpoczęciem należy spełnić następujące wymagania wstępne:

- Dostęp do obszaru roboczego w trybie licencji pojemności sieci szkieletowej (lub) w trybie licencji próbnej z uprawnieniami współautora lub wyższymi uprawnieniami.

- Aby dodać usługę Azure Event Hubs lub Azure IoT Hub jako źródło strumienia zdarzeń, musisz mieć odpowiednie uprawnienia dostępu do kluczy zasad. Muszą być one publicznie dostępne, a nie za zaporą lub zabezpieczone w sieci wirtualnej.

Obsługiwane źródła

Strumienie zdarzeń sieci szkieletowej obsługują następujące źródła. Użyj linków w tabeli, aby przejść do artykułów, które zawierają więcej szczegółów na temat dodawania określonych źródeł.

| Źródła | opis |

|---|---|

| Azure Event Hubs | Jeśli masz centrum zdarzeń platformy Azure, możesz pozyskiwać dane centrum zdarzeń do usługi Microsoft Fabric przy użyciu strumienia zdarzeń. |

| Azure IoT Hub | Jeśli masz centrum Azure IoT, możesz pozyskiwać dane IoT do usługi Microsoft Fabric przy użyciu usługi Eventstream. |

| Dane przykładowe | Możesz wybrać pozycję Rowery, Żółta taksówka lub Zdarzenia giełdowe jako przykładowe źródło danych, aby przetestować pozyskiwanie danych podczas konfigurowania strumienia zdarzeń. |

| Aplikacja niestandardowa | Funkcja aplikacji niestandardowej umożliwia aplikacjom lub klientom platformy Kafka łączenie się z usługą Eventstream przy użyciu parametry połączenia, co umożliwia płynne pozyskiwanie danych przesyłanych strumieniowo do usługi Eventstream. |

Uwaga

Maksymalna liczba źródeł i miejsc docelowych dla jednego strumienia zdarzeń wynosi 11.

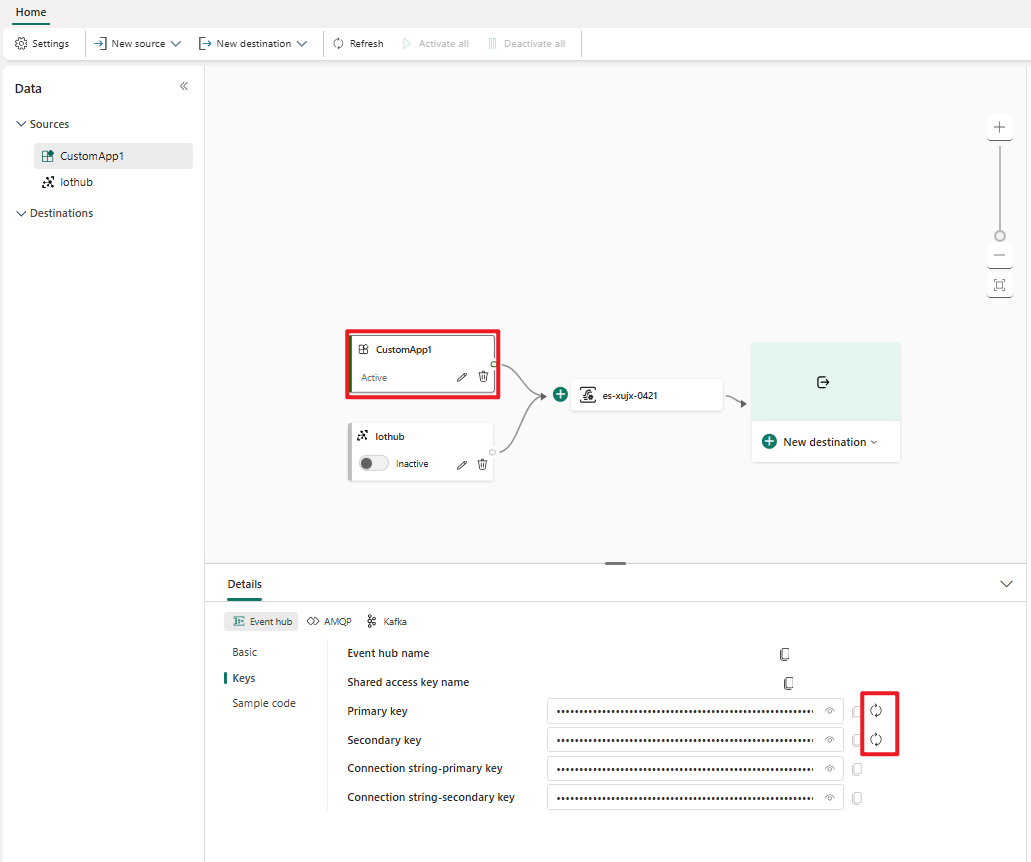

Zarządzanie źródłem

Edytuj/usuń: możesz wybrać źródło strumienia zdarzeń, aby edytować lub usunąć za pośrednictwem okienka nawigacji lub kanwy. Po wybraniu pozycji Edytuj okienko edycji zostanie otwarte po prawej stronie edytora głównego.

Wygeneruj ponownie klucz dla aplikacji niestandardowej: jeśli chcesz ponownie wygenerować nowy klucz połączenia dla aplikacji, wybierz jedno z niestandardowych źródeł aplikacji na kanwie i wybierz pozycję Wygeneruj ponownie , aby uzyskać nowy klucz połączenia.