Dodawanie źródła platformy Kafka confluent do strumienia zdarzeń

W tym artykule pokazano, jak dodać źródło platformy Kafka platformy Confluent do strumienia zdarzeń.

Confluent Cloud Kafka to platforma przesyłania strumieniowego oferująca zaawansowane funkcje przesyłania strumieniowego i przetwarzania danych przy użyciu platformy Apache Kafka. Integrując platformę Confluent Cloud Kafka jako źródło w strumieniu zdarzeń, można bezproblemowo przetwarzać strumienie danych w czasie rzeczywistym przed kierowaniem ich do wielu miejsc docelowych w sieci szkieletowej.

Uwaga

To źródło nie jest obsługiwane w następujących regionach pojemności obszaru roboczego: Zachodnie stany USA3, Szwajcaria Zachodnia.

Wymagania wstępne

- Dostęp do obszaru roboczego w trybie licencji pojemności sieci szkieletowej (lub) w trybie licencji próbnej z uprawnieniami współautora lub wyższymi uprawnieniami.

- Klaster Platformy Kafka w chmurze Confluent i klucz interfejsu API.

- Klaster platformy Kafka w chmurze Confluent musi być publicznie dostępny i nie być za zaporą lub zabezpieczony w sieci wirtualnej.

- Jeśli nie masz strumienia zdarzeń, utwórz strumień zdarzeń.

Uruchamianie kreatora Wybieranie źródła danych

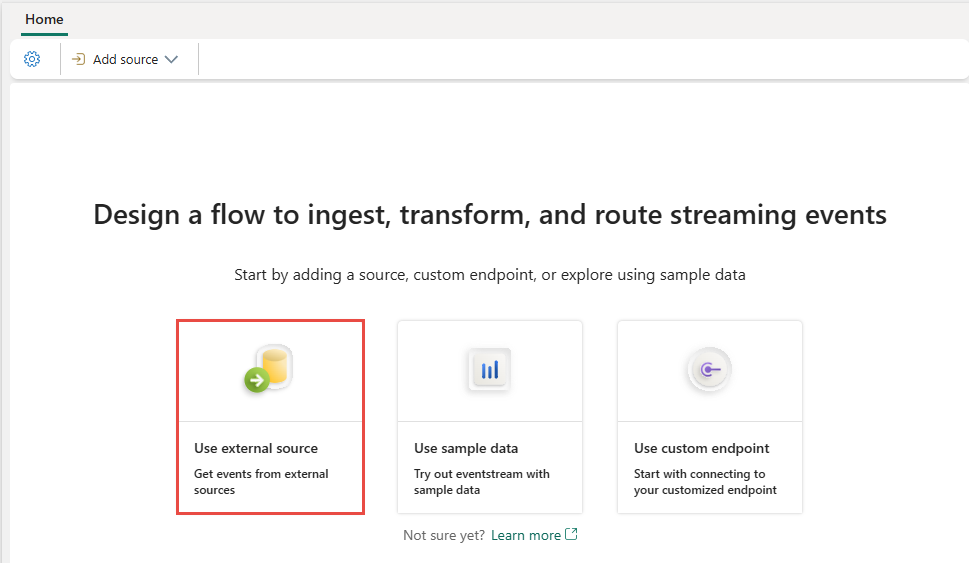

Jeśli jeszcze nie dodano żadnego źródła do strumienia zdarzeń, wybierz pozycję Użyj kafelka zewnętrznego źródła .

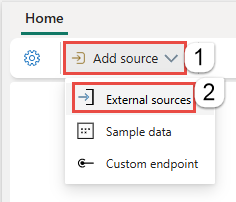

Jeśli dodasz źródło do już opublikowanego strumienia zdarzeń, przełącz się do trybu edycji , wybierz pozycję Dodaj źródło na wstążce, a następnie wybierz pozycję Źródła zewnętrzne.

Konfigurowanie platformy Confluent Kafka i nawiązywanie z nią połączenia

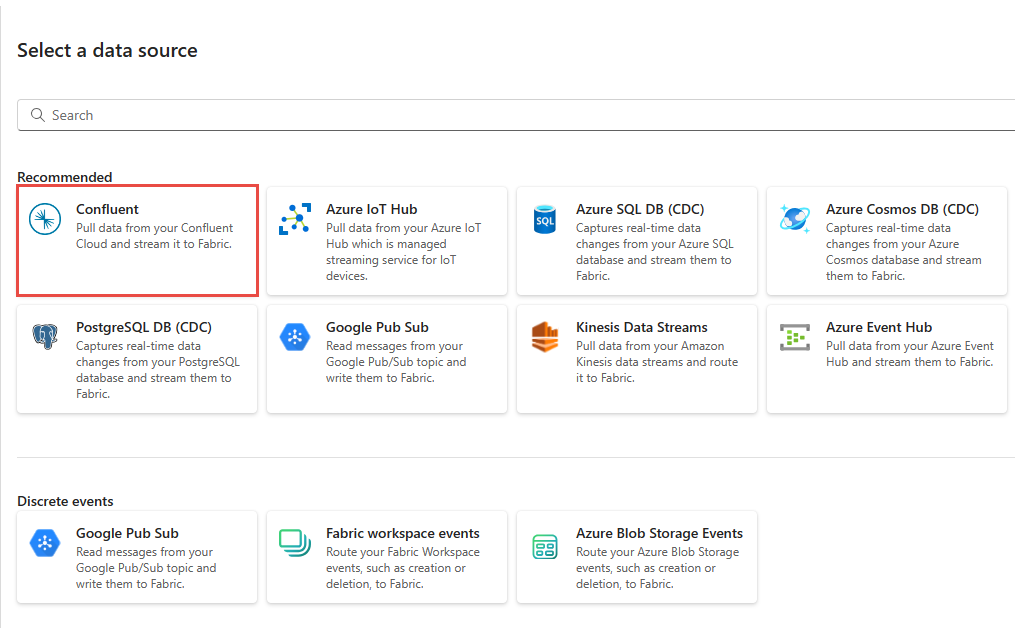

Na stronie Wybieranie źródła danych wybierz pozycję Confluent.

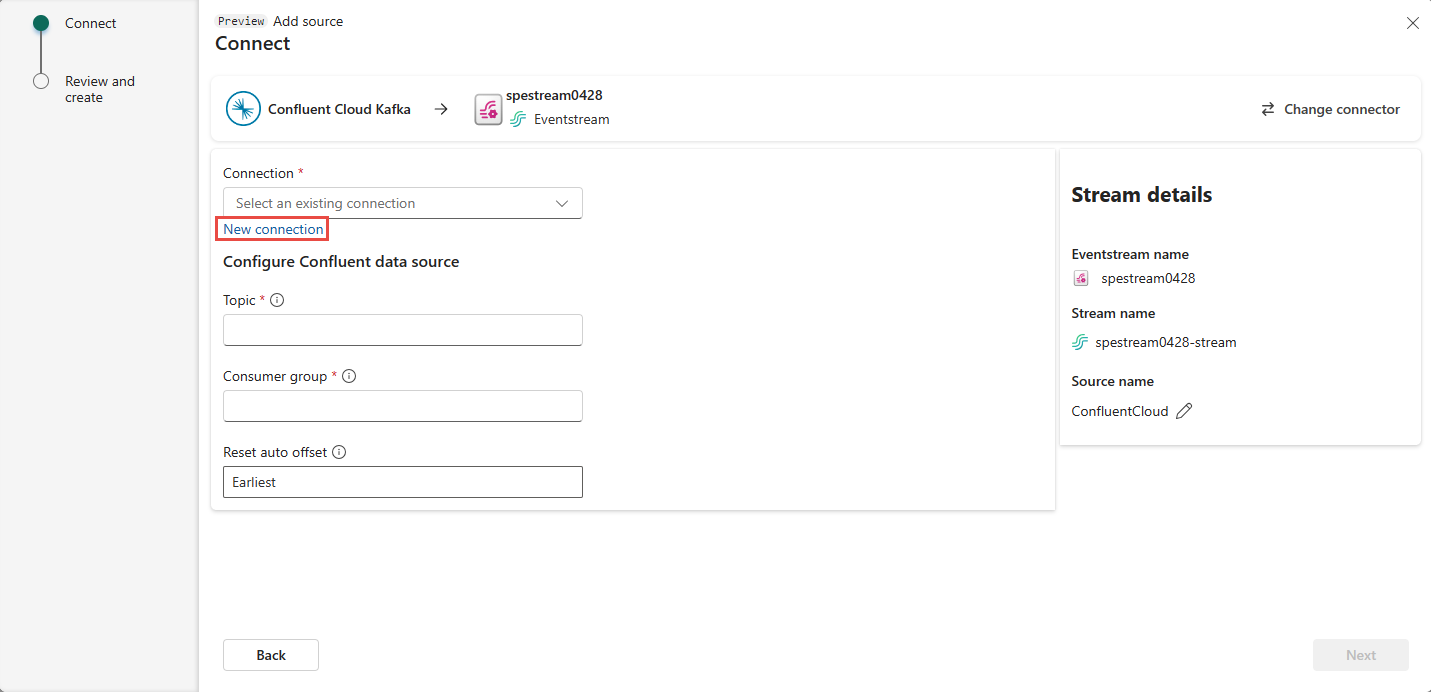

Aby utworzyć połączenie ze źródłem platformy Kafka w chmurze Confluent, wybierz pozycję Nowe połączenie.

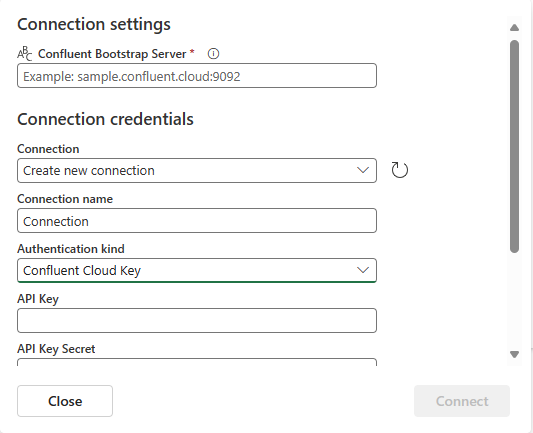

W sekcji Ustawienia połączenia wprowadź ciąg Confluent Bootstrap Server. Przejdź do strony głównej platformy Confluent Cloud, wybierz pozycję Ustawienia klastra i skopiuj adres do serwera Bootstrap.

W sekcji Poświadczenia połączenia, jeśli masz istniejące połączenie z klastrem Confluent, wybierz je z listy rozwijanej Połączenie. W przeciwnym razie wykonaj następujące kroki:

- W polu Nazwa połączenia wprowadź nazwę połączenia.

- W polu Rodzaj uwierzytelniania upewnij się, że wybrano pozycję Confluent Cloud Key (Klucz chmury platformy Confluent).

- Klucz interfejsu API i klucz interfejsu API :

Przejdź do chmury Confluent.

Wybierz pozycję Klucze interfejsu API w menu bocznym.

Wybierz przycisk Dodaj klucz, aby utworzyć nowy klucz interfejsu API.

Skopiuj klucz interfejsu API i klucz tajny.

Wklej te wartości w polach Klucz interfejsu API i Klucz tajny klucza interfejsu API.

Wybierz pozycję Połącz

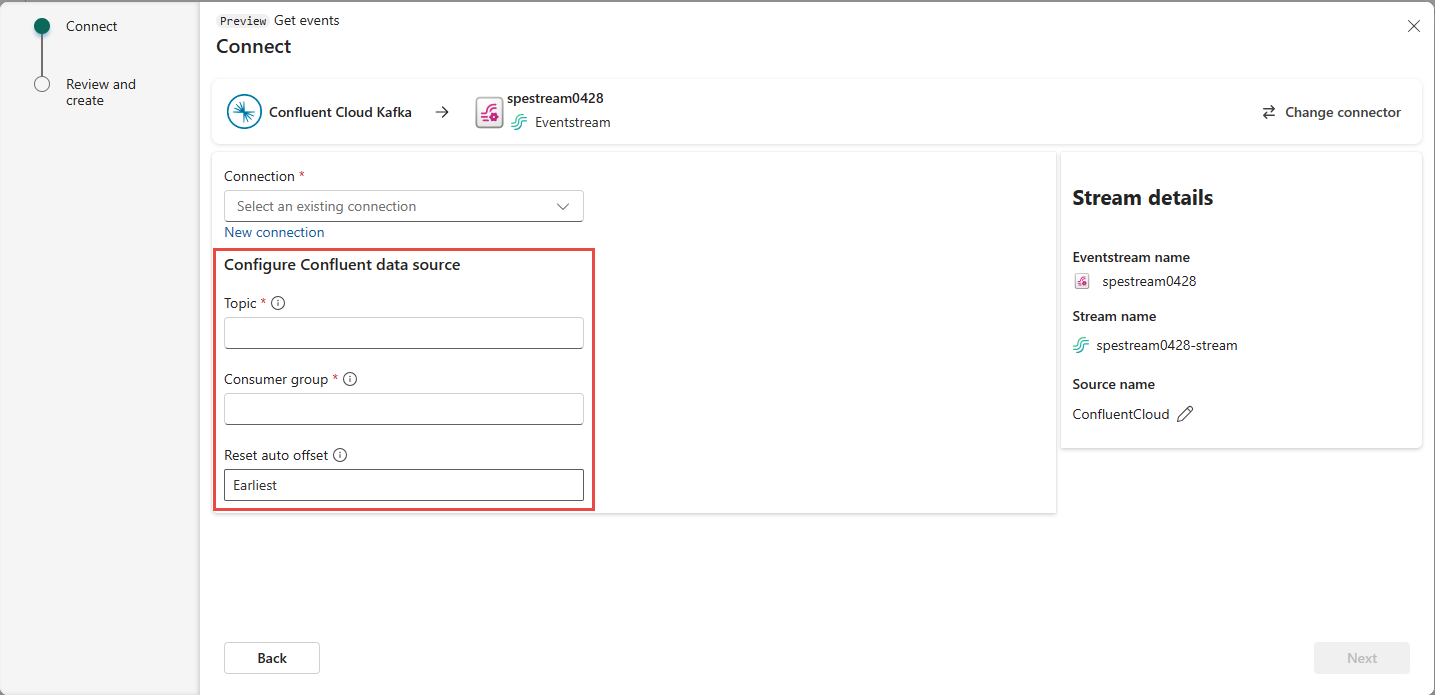

Przewiń, aby wyświetlić sekcję Konfigurowanie źródła danych confluent na stronie. Wprowadź informacje, aby ukończyć konfigurację źródła danych Confluent.

- W polu Temat wprowadź nazwę tematu z chmury Confluent. Temat można utworzyć lub zarządzać nim w konsoli confluent Cloud Console.

- W polu Grupa odbiorców wprowadź grupę odbiorców chmury Confluent. Zapewnia ona dedykowaną grupę odbiorców na potrzeby pobierania zdarzeń z klastra confluent Cloud.

- W obszarze Resetuj ustawienie automatycznego przesunięcia wybierz jedną z następujących wartości:

Najwcześniej — najwcześniejsze dane dostępne z klastra Confluent

Najnowsze — najnowsze dostępne dane

Brak — nie ustawiaj automatycznie przesunięcia.

Wybierz Dalej. Na ekranie Przeglądanie i tworzenie przejrzyj podsumowanie, a następnie wybierz pozycję Dodaj.

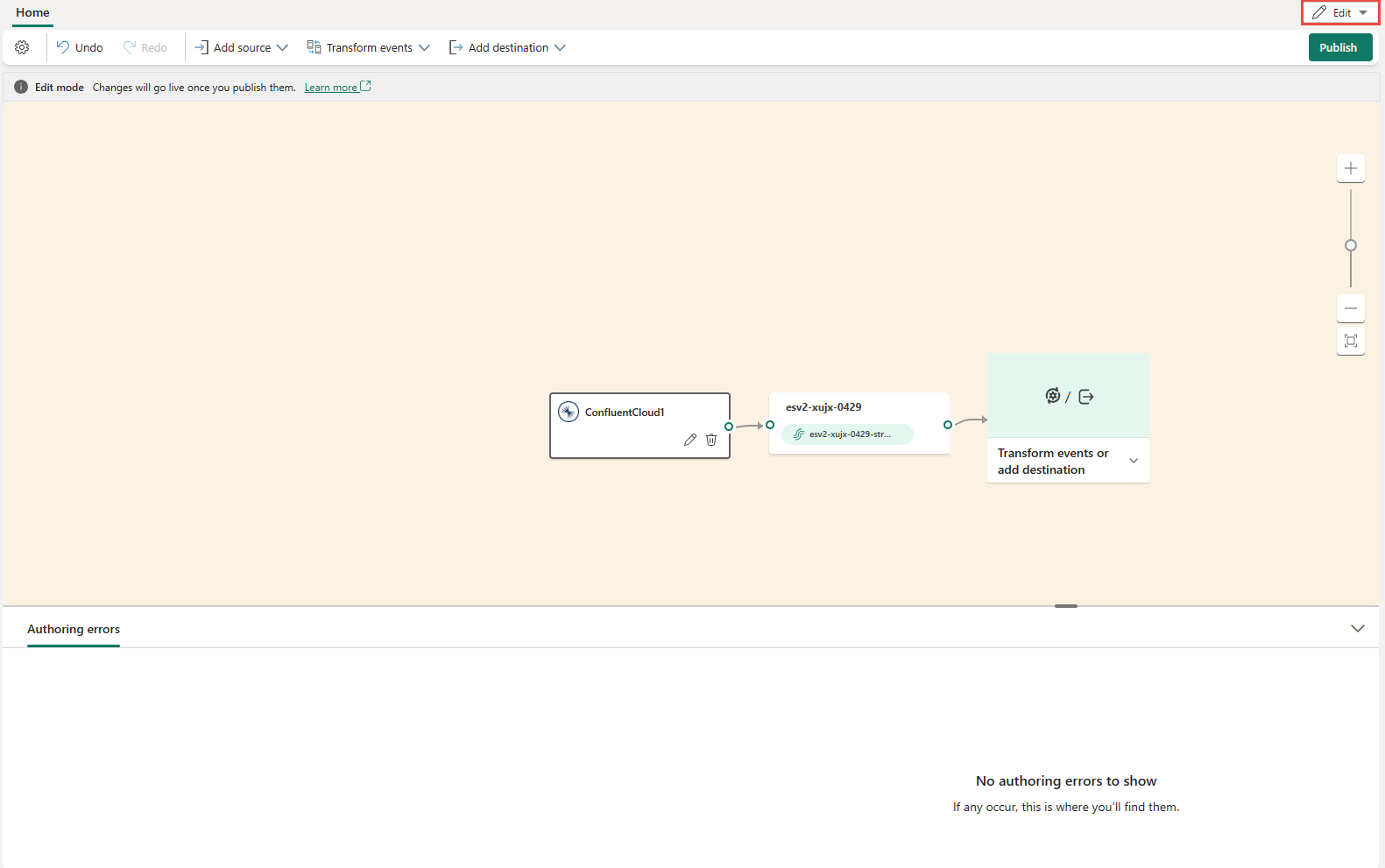

Zobaczysz, że źródło platformy Kafka w chmurze Confluent jest dodawane do strumienia zdarzeń na kanwie w trybie edycji. Aby zaimplementować to nowo dodane źródło platformy Kafka w chmurze Confluent, wybierz pozycję Publikuj na wstążce.

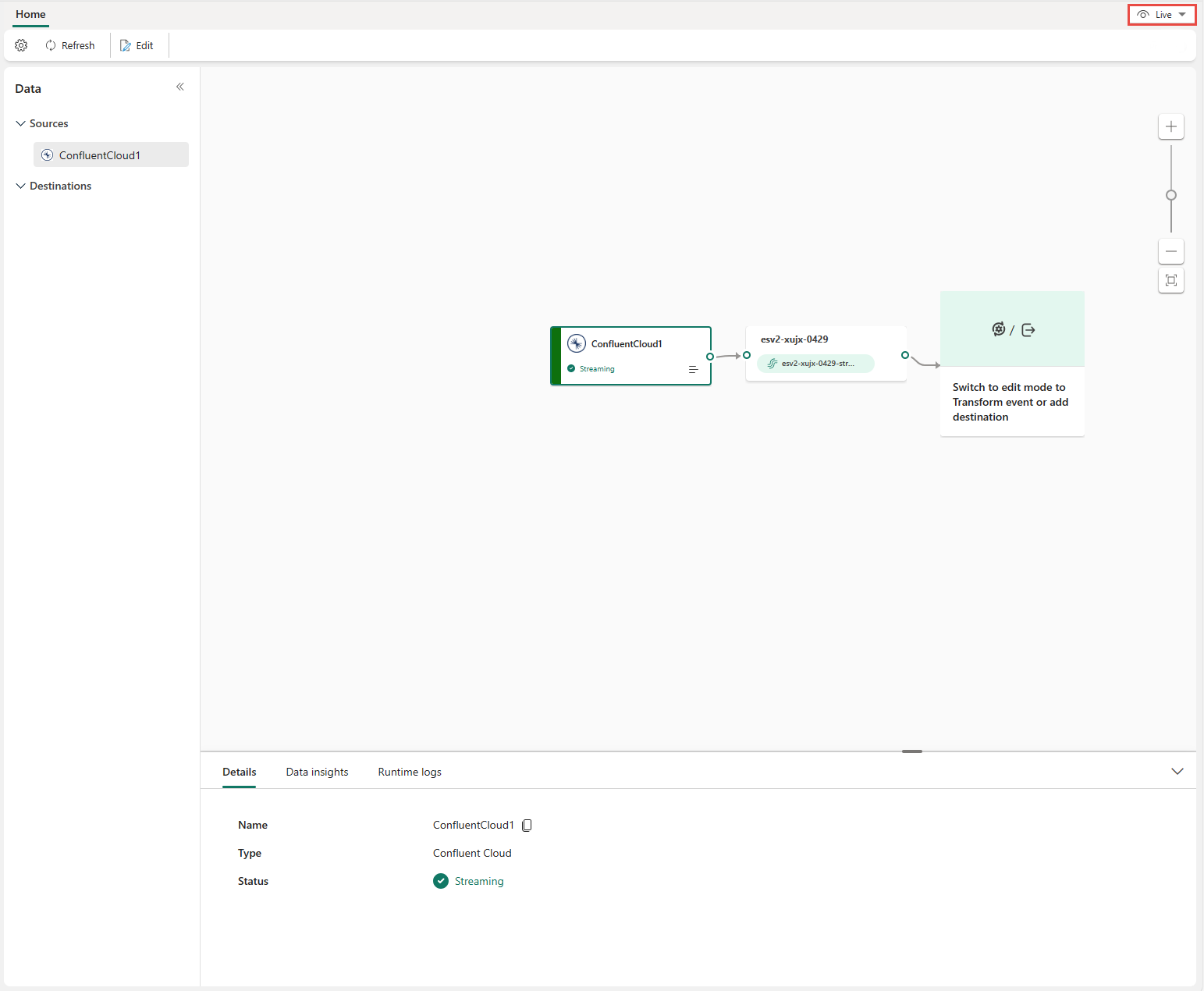

Po wykonaniu tych kroków źródło platformy Kafka w chmurze Confluent jest dostępne do wizualizacji w widoku na żywo.

Ograniczenia

- Platforma Confluent Kafka z formatami JSON i Avro przy użyciu rejestru schematów nie jest obecnie obsługiwana.

- Dekodowanie danych z platformy Confluent Kafka przy użyciu rejestru schematów confluent nie jest obecnie obsługiwane.

Uwaga

Maksymalna liczba źródeł i miejsc docelowych dla jednego strumienia zdarzeń wynosi 11.

Powiązana zawartość

Inne łączniki:

- Strumienie danych Amazon Kinesis

- Azure Cosmos DB

- Azure Event Hubs

- Azure IoT Hub

- Przechwytywanie zmian danych w usłudze Azure SQL Database (CDC)

- Niestandardowy punkt końcowy

- Google Cloud Pub/Sub

- Usługa CDC bazy danych MySQL

- CdC bazy danych PostgreSQL

- Dane przykładowe

- Zdarzenia usługi Azure Blob Storage

- Zdarzenie obszaru roboczego sieci szkieletowej