Note sulla versione archiviate

Riepilogo

Azure HDInsight è uno dei servizi più diffusi fra i clienti enterprise per analisi open source in Azure. Sottoscrivere le note sulla versione di HDInsight per informazioni aggiornate su HDInsight e su tutte le versioni di HDInsight.

Per eseguire la sottoscrizione, fare clic sul pulsante "Watch" nel banner e seguire le versioni di HDInsight.

Informazioni sulla versione

Data di rilascio: 22 ottobre 2024

Nota

Si tratta di una versione hotfix/manutenzione per il provider di risorse. Per altre informazioni, vedere Provider di risorse.

Azure HDInsight rilascia periodicamente gli aggiornamenti di manutenzione per la distribuzione di correzioni di bug, miglioramenti delle prestazioni e patch di sicurezza, consentendo all'utente di rimanere al passo con questi aggiornamenti e garantendo prestazioni e affidabilità ottimali.

Questa nota sulla versione si applica a

HDInsight versione 5.1.

HDInsight versione 5.0.

HDInsight versione 4.0.

La versione di HDInsight sarà disponibile in tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2409240625. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

Ubuntu 18.04 è supportato in Manutenzione della sicurezza estesa (ESM) dal team Linux di Azure per Azure HDInsight di luglio 2023, versione successiva.

Per le versioni specifiche del carico di lavoro, vedere versioni dei componenti di HDInsight 5.x.

Aggiornato

Supporto dell'autenticazione basata su MSI disponibile per l'archiviazione BLOB di Azure.

- Azure HDInsight supporta ora l'autenticazione basata su OAuth per l'accesso all'archiviazione BLOB di Azure sfruttando Azure Active Directory (AAD) e le identità gestite (MSI). Con questo miglioramento, HDInsight usa le identità gestite assegnate dall'utente per accedere all'archiviazione BLOB di Azure. Per altre informazioni, vedere Identità gestite per le risorse di Azure.

Il servizio HDInsight è stato sottoposto a transizione per l'uso di servizi di bilanciamento del carico standard per tutte le configurazioni del cluster a causa dell'annuncio di deprecazione del servizio di bilanciamento del carico basic di Azure.

Nota

Questa modifica è disponibile in tutte le aree. Ricreare il cluster per usare questa modifica. Per qualsiasi assistenza, contattare il supporto tecnico.

Importante

Quando si usa la propria Rete virtuale (rete virtuale personalizzata) durante la creazione del cluster, è consigliabile che la creazione del cluster non abbia esito positivo dopo l'abilitazione di questa modifica. È consigliabile fare riferimento alla guida alla migrazione per ricreare il cluster. Per qualsiasi assistenza, contattare il supporto tecnico.

Presto disponibile

Presto disponibile

Ritiro VM di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le VM di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle VM serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD.

- Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle VM serie A Basic e Standard alle VM serie Av2 prima del 31 agosto 2024.

Notifiche di ritiro per HDInsight 4.0 e HDInsight 5.0.

Per altre domande, contattare il Supporto tecnico di Azure.

È sempre possibile chiedere informazioni su HDInsight in Azure HDInsight - Microsoft Q&A.

Siamo in ascolto: è possibile aggiungere altre idee e altri argomenti e votarli in HDInsight Ideas e seguirci per altri aggiornamenti nella community di AzureHDInsight.

Nota

Si consiglia ai clienti di usare le versioni più recenti delle immagini HDInsight man mano che sfruttano al meglio gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni per la sicurezza. Per altre informazioni, vedere Procedure consigliate.

Data di rilascio: 30 agosto 2024

Nota

Si tratta di una versione hotfix/manutenzione per il provider di risorse. Per altre informazioni, vedere Provider di risorse.

Azure HDInsight rilascia periodicamente gli aggiornamenti di manutenzione per la distribuzione di correzioni di bug, miglioramenti delle prestazioni e patch di sicurezza, consentendo all'utente di rimanere al passo con questi aggiornamenti e garantendo prestazioni e affidabilità ottimali.

Questa nota sulla versione si applica a

HDInsight versione 5.1.

HDInsight versione 5.0.

HDInsight versione 4.0.

La versione di HDInsight sarà disponibile in tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2407260448. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

Ubuntu 18.04 è supportato in Manutenzione della sicurezza estesa (ESM) dal team Linux di Azure per Azure HDInsight di luglio 2023, versione successiva.

Per le versioni specifiche del carico di lavoro, vedere versioni dei componenti di HDInsight 5.x.

Problema risolto

- Correzione bug del database predefinita.

Presto disponibili

-

Ritiro VM di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le VM di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle VM serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD.

- Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle VM serie A Basic e Standard alle VM serie Av2 prima del 31 agosto 2024.

- Notifiche di ritiro per HDInsight 4.0 e HDInsight 5.0.

Per altre domande, contattare il Supporto tecnico di Azure.

È sempre possibile chiedere informazioni su HDInsight in Azure HDInsight - Microsoft Q&A.

Siamo in ascolto: è possibile aggiungere altre idee e altri argomenti e votarli in HDInsight Ideas e seguirci per altri aggiornamenti nella community di AzureHDInsight.

Nota

È consigliabile che i clienti usino le versioni più recenti di HDInsight Images perché consentono di ottenere gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni di sicurezza migliori. Per altre informazioni, vedere Procedure consigliate.

Data di rilascio: 09 agosto 2024

Questa nota sulla versione si applica a

HDInsight versione 5.1.

HDInsight versione 5.0.

HDInsight versione 4.0.

La versione di HDInsight sarà disponibile in tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2407260448. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

Ubuntu 18.04 è supportato in Manutenzione della sicurezza estesa (ESM) dal team Linux di Azure per Azure HDInsight di luglio 2023, versione successiva.

Per le versioni specifiche del carico di lavoro, vedere versioni dei componenti di HDInsight 5.x.

Aggiornamenti

Aggiunta dell'agente di Monitoraggio di Azure per Log Analytics in HDInsight

Aggiunta di SystemMSI e Registrazione guidata automatica per Log Analytics, data la deprecazione della nuova esperienza di Monitoraggio di Azure (anteprima).

Nota

Il numero di immagine effettivo 2407260448, i clienti che usano il portale per Log Analytics avranno l'esperienza predefinita dell'agente di Monitoraggio di Azure. Se si vuole passare all'esperienza di Monitoraggio di Azure (anteprima), è possibile aggiungere i cluster alle immagini precedenti creando una richiesta di supporto.

Data di rilascio: 05 luglio 2024

Nota

Si tratta di una versione hotfix/manutenzione per il provider di risorse. Per altre informazioni, vedere Provider di risorse

Problemi risolti

I tag HOBO sovrascrivono i tag utente.

- I tag HOBO sovrascrivono i tag utente nelle risorse secondarie nella creazione del cluster HDInsight.

Data di rilascio: 19 giugno 2024

Questa nota sulla versione si applica a

HDInsight versione 5.1.

HDInsight versione 5.0.

HDInsight versione 4.0.

La versione di HDInsight sarà disponibile in tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2406180258. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

Ubuntu 18.04 è supportato in Manutenzione della sicurezza estesa (ESM) dal team Linux di Azure per Azure HDInsight di luglio 2023, versione successiva.

Per le versioni specifiche del carico di lavoro, vedere versioni dei componenti di HDInsight 5.x.

Problemi risolti

Miglioramenti della sicurezza

Miglioramenti in HDInsight Log Analytics con il supporto dell'identità gestita dal sistema per il provider di risorse HDInsight.

Aggiunta di una nuova attività per aggiornare la versione dell'agente

mdsdper l'immagine vecchia (creata prima del 2024).Abilitazione di MISE nel gateway come parte dei miglioramenti continui per la Migrazione MSAL.

Incorporare Spark Thrift Server

Httpheader hiveConfin Jetty HTTP ConnectionFactory.Ripristinare RANGER-3753 e RANGER-3593.

L'implementazione

setOwnerUserfornita nella versione di Ranger 2.3.0 presenta un problema critico di regressione quando viene usata da Hive. In Ranger 2.3.0, quando HiveServer2 tenta di valutare i criteri, Ranger Client tenta di ottenere il proprietario della tabella hive chiamando il Metastore nella funzione setOwnerUser che essenzialmente effettua una chiamata all'archiviazione per verificare l'accesso per tale tabella. Questo problema causa un rallentamento dell'esecuzione delle query quando Hive viene eseguito su Ranger 2.3.0.

Nuove aree aggiunte

- Italia settentrionale

- Israele centrale

- Spagna centrale

- Messico centrale

- Jio - India centrale

Aggiungi alle note archivio di giugno 2024

Presto disponibili

-

Ritiro VM di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le VM di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle VM serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD.

- Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle VM serie A Basic e Standard alle VM serie Av2 prima del 31 agosto 2024.

- Notifiche di ritiro per HDInsight 4.0 e HDInsight 5.0.

Per altre domande, contattare il Supporto tecnico di Azure.

È sempre possibile chiedere informazioni su HDInsight in Azure HDInsight - Microsoft Q&A.

Siamo in ascolto: è possibile aggiungere altre idee e altri argomenti e votarli in HDInsight Ideas e seguirci per altri aggiornamenti nella community di AzureHDInsight.

Nota

È consigliabile che i clienti usino le versioni più recenti di HDInsight Images perché consentono di ottenere gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni di sicurezza migliori. Per altre informazioni, vedere Procedure consigliate.

Data di rilascio: 16 maggio 2024

Questa nota sulla versione si applica a

HDInsight 5.0 versione.

HDInsight versione 4.0.

La versione di HDInsight sarà disponibile per tutte le aree in diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2405081840. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

Ubuntu 18.04 è supportato in Manutenzione della sicurezza estesa (ESM) dal team Linux di Azure per Azure HDInsight di luglio 2023, versione successiva.

Per le versioni specifiche del carico di lavoro, vedere versioni dei componenti di HDInsight 5.x.

Problemi risolti

- Aggiunta dell'API nel gateway per ottenere il token per KeyVault, come parte dell'iniziativa SFI.

- Nella nuova tabella

HDInsightSparkLogsMonitoraggio log, per il tipo di logSparkDriverLog, alcuni dei campi erano mancanti. Ad esempio:LogLevel & Message. Questa versione aggiunge i campi mancanti agli schemi e alla formattazione fissa perSparkDriverLog. - I log livy non sono disponibili nella tabella di monitoraggio

SparkDriverLogdi Log Analytics, a causa di un problema relativo al percorso di origine del log Livy e all'analisi dei log nelle configurazioniSparkLivyLog. - Qualsiasi cluster HDInsight che usa ADLS Gen2 come account di archiviazione primario può sfruttare l'accesso basato su MSI a qualsiasi risorsa di Azure (ad esempio SQL, Keyvaults) usata all'interno del codice dell'applicazione.

Prossimamente

-

Ritiro VM di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le VM di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle VM serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD.

- Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle VM serie A Basic e Standard alle VM serie Av2 prima del 31 agosto 2024.

- Notifiche di ritiro per HDInsight 4.0 e HDInsight 5.0.

Per altre domande, contattare il Supporto tecnico di Azure.

È sempre possibile chiedere informazioni su HDInsight in Azure HDInsight - Microsoft Q&A.

Siamo in ascolto: è possibile aggiungere altre idee e altri argomenti e votarli in HDInsight Ideas e seguirci per altri aggiornamenti nella community di AzureHDInsight.

Nota

È consigliabile che i clienti usino le versioni più recenti di HDInsight Images perché consentono di ottenere gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni di sicurezza migliori. Per altre informazioni, vedere Procedure consigliate.

Data di rilascio: 15 aprile 2024

Questa nota sulla versione si applica a HDInsight versione 5.1.

La versione di HDInsight sarà disponibile in tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2403290825. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 5.1: Ubuntu 18.04.5 LTS Kernel Linux 5.4

Nota

Ubuntu 18.04 è supportato in Manutenzione della sicurezza estesa (ESM) dal team Linux di Azure per Azure HDInsight di luglio 2023, versione successiva.

Per le versioni specifiche del carico di lavoro, vedere versioni dei componenti di HDInsight 5.x.

Problemi risolti

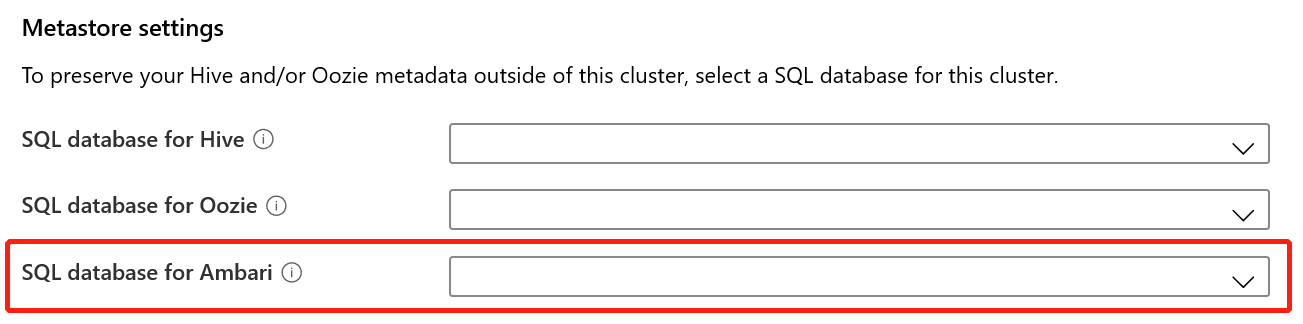

- Correzioni di bug per database Ambar, Hive Warehouse Controller (HWC), Spark, HDFS

- Correzioni di bug per il modulo Log Analytics per HDInsightSparkLogs

- Correzioni di CVE per il provider di risorse HDInsight.

Presto disponibili

-

Ritiro VM di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le VM di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle VM serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD.

- Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle VM serie A Basic e Standard alle VM serie Av2 prima del 31 agosto 2024.

- Notifiche di ritiro per HDInsight 4.0 e HDInsight 5.0.

Per altre domande, contattare il Supporto tecnico di Azure.

È sempre possibile chiedere informazioni su HDInsight in Azure HDInsight - Microsoft Q&A.

Siamo in ascolto: è possibile aggiungere altre idee e altri argomenti e votarli in HDInsight Ideas e seguirci per altri aggiornamenti nella community di AzureHDInsight.

Nota

È consigliabile che i clienti usino le versioni più recenti di HDInsight Images perché consentono di ottenere gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni di sicurezza migliori. Per altre informazioni, vedere Procedure consigliate.

Data di rilascio: 15 febbraio 2024

Questa versione si applica alle versioni di HDInsight 4.x e 5.x. La versione di HDInsight sarà disponibile in tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2401250802. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 4.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Kernel Linux 5.4

Nota

Ubuntu 18.04 beneficia del supporto ESM (Extended Security Maintenance) fornito dal team Linux di Azure dalla release di Azure HDInsight di luglio 2023 in avanti.

Per le versioni specifiche del carico di lavoro, vedere

Nuove funzionalità

- Supporto di Apache Ranger per Spark SQL in Spark 3.3.0 (HDInsight versione 5.1) con Enterprise Security Package. Per altre informazioni, vedere qui.

Problemi risolti

- Correzioni di sicurezza dei componenti di Ambari e Oozie

Prossimamente

Prossimamente

- Ritiro VM di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le VM di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle VM serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD.

- Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle macchine virtuali serie A Basic e Standard alle macchine virtuali serie Av2 prima del 31 agosto 2024.

Per altre domande, contattare il supporto tecnico di Azure.

È sempre possibile chiedere informazioni su HDInsight in Azure HDInsight - Microsoft Q&A

Siamo in ascolto: è possibile aggiungere altre idee e proporre altri argomenti, votarli in HDInsight Ideas e seguirci per altri aggiornamenti nella community di AzureHDInsight

Nota

È consigliabile che i clienti usino le versioni più recenti di HDInsight Images perché consentono di ottenere gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni di sicurezza migliori. Per altre informazioni, vedere Procedure consigliate.

Passaggi successivi

- Azure HDInsight: domande frequenti

- Configurare una pianificazione dell'applicazione di patch al sistema operativo per i cluster di HDInsight basati su Linux

- Nota sulla versione precedente

Azure HDInsight è uno dei servizi più diffusi fra i clienti enterprise per analisi open source in Azure. Se si vogliono sottoscrivere le note sulla versione, seguire questo repository GitHub.

Data di rilascio: 10 gennaio 2024

Questa versione hotfix si applica alle versioni di HDInsight 4.x e 5.x. La versione di HDInsight sarà disponibile in tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2401030422. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 4.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Kernel Linux 5.4

Nota

Ubuntu 18.04 beneficia del supporto ESM (Extended Security Maintenance) fornito dal team Linux di Azure dalla release di Azure HDInsight di luglio 2023 in avanti.

Per le versioni specifiche del carico di lavoro, vedere

Problemi risolti

- Correzioni di sicurezza dei componenti di Ambari e Oozie

Prossimamente

Prossimamente

- Ritiro VM di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le VM di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle VM serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD.

- Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle macchine virtuali serie A Basic e Standard alle macchine virtuali serie Av2 prima del 31 agosto 2024.

Per altre domande, contattare il supporto tecnico di Azure.

È sempre possibile chiedere informazioni su HDInsight in Azure HDInsight - Microsoft Q&A

Siamo in ascolto: è possibile aggiungere altre idee e proporre altri argomenti, votarli in HDInsight Ideas e seguirci per altri aggiornamenti nella community di AzureHDInsight

Nota

È consigliabile che i clienti usino le versioni più recenti di HDInsight Images perché consentono di ottenere gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni di sicurezza migliori. Per altre informazioni, vedere Procedure consigliate.

Data di rilascio: 26 ottobre 2023

Questa versione si applica alle versioni di HDInsight 4.x e 5.x. HDInsight sarà disponibile per tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2310140056. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 4.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Kernel Linux 5.4

Per le versioni specifiche del carico di lavoro, vedere

Novità

HDInsight annuncia la disponibilità generale di HDInsight 5.1 a partire dal 1° novembre 2023. Questa versione introduce un aggiornamento completo dello stack per i componenti open source e le integrazioni di Microsoft.

- Ultime versioni open source - HDInsight 5.1 include la versione open source stabile più recente disponibile. I clienti possono trarre vantaggio da tutte le funzionalità open source più recenti, dai miglioramenti delle prestazioni di Microsoft e dalle correzioni di bug.

- Sicuro - Le ultime versioni sono dotate delle correzioni di sicurezza più recenti, sia delle correzioni di sicurezza open source che dei miglioramenti della sicurezza di Microsoft.

- TCO inferiore - Grazie ai miglioramenti delle prestazioni, i clienti possono ridurre il costo di proprietà con la scalabilità automatica avanzata.

Autorizzazioni del cluster per l'archiviazione sicura

- I clienti possono specificare durante la creazione del cluster se per la connessione dei nodi del cluster HDInsight all'account di archiviazione occorre usare un canale sicuro.

Creazione di cluster HDInsight con reti virtuali personalizzate.

- Per migliorare la postura di sicurezza complessiva dei cluster HDInsight, i cluster HDInsight che usano reti virtuali personalizzate devono verificare che l'utente debba avere l'autorizzazione per

Microsoft Network/virtualNetworks/subnets/join/actionper eseguire operazioni di creazione. Se questo controllo non è abilitato, il cliente potrebbe riscontrare errori di creazione.

- Per migliorare la postura di sicurezza complessiva dei cluster HDInsight, i cluster HDInsight che usano reti virtuali personalizzate devono verificare che l'utente debba avere l'autorizzazione per

Cluster ABFS non ESP [Autorizzazioni cluster per Word leggibile]

- I cluster ABFS non ESP impediscono agli utenti di gruppo non Hadoop di eseguire comandi Hadoop per le operazioni di archiviazione. Questa modifica migliora la postura di sicurezza del cluster.

Aggiornamento della quota inline.

- Ora è possibile richiedere un aumento della quota direttamente dalla pagina Quota personale. Con la chiamata API diretta, l'operazione è molto più veloce. Nel caso in cui la chiamata API non riesca, è possibile creare una nuova richiesta di supporto per l'aumento della quota.

Prossimamente

Prossimamente

La lunghezza massima del nome del cluster viene modificata in 45 da 59 caratteri, per migliorare il comportamento di sicurezza dei cluster. Questa modifica verrà implementata in tutte le aree a partire dalla prossima versione.

Ritiro delle macchine virtuali di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le macchine virtuali di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle macchine virtuali serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD.

- Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle macchine virtuali serie A Basic e Standard alle macchine virtuali serie Av2 prima del 31 agosto 2024.

Per altre domande, contattare il supporto tecnico di Azure.

È sempre possibile chiedere informazioni su HDInsight in Azure HDInsight - Microsoft Q&A

Siamo in ascolto: è possibile aggiungere altre idee e proporre altri argomenti, votarli in HDInsight Ideas e seguirci per altri aggiornamenti nella community di AzureHDInsight

Nota

Questa versione risolve le CVE seguenti pubblicate da MSRC il 12 settembre 2023. L'azione è l'aggiornamento all'immagine più recente 2308221128 o 2310140056. I clienti sono invitati a pianificare di conseguenza.

| CVE | Gravità | Titolo CVE | Commento |

|---|---|---|---|

| CVE-2023-38156 | Importante | Altitudine Apache Ambari per Azure HDInsight di vulnerabilità del privilegio | Incluso nell'immagine 2308221128 o 2310140056 |

| CVE-2023-36419 | Importante | Altitudine dell'Utilità di pianificazione del flusso di lavoro Apache Oozie per Azure HDInsight di vulnerabilità del privilegio | Applicare l'azione Script nei cluster o eseguire l'aggiornamento all'immagine 2310140056 |

Nota

È consigliabile che i clienti usino le versioni più recenti di HDInsight Images perché consentono di ottenere gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni di sicurezza migliori. Per altre informazioni, vedere Procedure consigliate.

Data di rilascio: 7 settembre 2023

Questa versione si applica alle versioni di HDInsight 4.x e 5.x. HDInsight sarà disponibile per tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2308221128. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 4.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Kernel Linux 5.4

Per le versioni specifiche del carico di lavoro, vedere

Importante

Questa versione risolve le CVE seguenti pubblicate da MSRC il 12 settembre 2023. L'azione è l'aggiornamento all'immagine più recente 2308221128. I clienti sono invitati a pianificare di conseguenza.

| CVE | Gravità | Titolo CVE | Commento |

|---|---|---|---|

| CVE-2023-38156 | Importante | Altitudine Apache Ambari per Azure HDInsight di vulnerabilità del privilegio | Incluso nell'immagine 2308221128 |

| CVE-2023-36419 | Importante | Altitudine dell'Utilità di pianificazione del flusso di lavoro Apache Oozie per Azure HDInsight di vulnerabilità del privilegio | Applicare l'azione Script nei cluster |

Presto disponibile

- La lunghezza massima del nome del cluster viene modificata in 45 da 59 caratteri, per migliorare il comportamento di sicurezza dei cluster. Questa modifica verrà implementata entro il 30 settembre 2023.

- Autorizzazioni del cluster per l'archiviazione sicura

- I clienti possono specificare durante la creazione del cluster se i nodi del cluster HDInsight devono usare un canale sicuro per contattare l'account di archiviazione.

- Aggiornamento della quota inline.

- È possibile richiedere un aumento della quota direttamente dalla pagina Quota personale. Si tratterà di una chiamata API diretta, che è più veloce. Se la chiamata APdI ha esito negativo, i clienti devono creare una nuova richiesta di supporto per l'aumento della quota.

- Creazione di cluster HDInsight con reti virtuali personalizzate.

- Per migliorare la postura di sicurezza complessiva dei cluster HDInsight, i cluster HDInsight che usano reti virtuali personalizzate devono verificare che l'utente debba avere l'autorizzazione per

Microsoft Network/virtualNetworks/subnets/join/actionper eseguire operazioni di creazione. I clienti devono tenerne conto per la pianificazione, in quanto questa modifica sarebbe un controllo obbligatorio per evitare errori di creazione del cluster prima del 30 settembre 2023.

- Per migliorare la postura di sicurezza complessiva dei cluster HDInsight, i cluster HDInsight che usano reti virtuali personalizzate devono verificare che l'utente debba avere l'autorizzazione per

- Ritiro delle macchine virtuali di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le VM di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle VM serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD. Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle macchine virtuali serie A Basic e Standard alle macchine virtuali serie Av2 prima del 31 agosto 2024.

- Cluster ABFS non ESP [Autorizzazioni cluster per la leggibilità generale]

- È prevista l'introduzione di una modifica nei cluster ABFS non ESP per impedire agli utenti di gruppo non Hadoop di eseguire comandi Hadoop per le operazioni di archiviazione. Questa modifica migliora la postura di sicurezza del cluster. I clienti devono pianificare gli aggiornamenti prima del 30 settembre 2023.

Per altre domande, contattare il supporto tecnico di Azure.

È sempre possibile chiedere informazioni su HDInsight in Azure HDInsight - Microsoft Q&A

È possibile aggiungere altre proposte e idee e altri argomenti e votarli nella community di HDInsight (azure.com).

Nota

È consigliabile che i clienti usino le versioni più recenti di HDInsight Images perché consentono di ottenere gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni di sicurezza migliori. Per altre informazioni, vedere Procedure consigliate.

Data di rilascio: 25 luglio 2023

Questa versione si applica alle versioni di HDInsight 4.x e 5.x. HDInsight sarà disponibile per tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2307201242. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 4.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Kernel Linux 5.4

Per le versioni specifiche del carico di lavoro, vedere

Novità

Novità

- HDInsight 5.1 è ora supportato con il cluster ESP.

- La versione aggiornata di Ranger 2.3.0 e Oozie 5.2.1 ora fanno parte di HDInsight 5.1

- Il cluster Spark 3.3.1 (HDInsight 5.1) include Hive Warehouse Connector (HWC) 2.1, che funziona insieme al cluster Interactive Query (HDInsight 5.1).

- Ubuntu 18.04 beneficia del supporto ESM (Extended Security Maintenance) fornito dal team Linux di Azure dalla release di Azure HDInsight di luglio 2023 in avanti.

Importante

Questa versione risolve le CVE seguenti pubblicate da MSRC l'8 agosto 2023. L'azione è l'aggiornamento all'immagine più recente 2307201242. I clienti sono invitati a pianificare di conseguenza.

| CVE | Gravità | Titolo CVE |

|---|---|---|

| CVE-2023-35393 | Importante | Vulnerabilità di spoofing di Apache Hive in Azure |

| CVE-2023-35394 | Importante | Vulnerabilità di spoofing di Jupyter Notebook in Azure HDInsight |

| CVE-2023-36877 | Importante | Vulnerabilità di spoofing di Apache Oozie in Azure |

| CVE-2023-36881 | Importante | Vulnerabilità di spoofing di Apache Ambari in Azure |

| CVE-2023-38188 | Importante | Vulnerabilità di spoofing di Apache Hadoop in Azure |

Prossimamente

Prossimamente

- La lunghezza massima del nome del cluster viene modificata in 45 da 59 caratteri, per migliorare il comportamento di sicurezza dei cluster. I clienti devono pianificare gli aggiornamenti prima del 30 settembre 2023.

- Autorizzazioni del cluster per l'archiviazione sicura

- I clienti possono specificare durante la creazione del cluster se i nodi del cluster HDInsight devono usare un canale sicuro per contattare l'account di archiviazione.

- Aggiornamento della quota inline.

- È possibile richiedere un aumento della quota direttamente dalla pagina Quota personale. Si tratterà di una chiamata API diretta, che è più veloce. Se la chiamata API ha esito negativo, i clienti devono creare una nuova richiesta di supporto per l'aumento della quota.

- Creazione di cluster HDInsight con reti virtuali personalizzate.

- Per migliorare la postura di sicurezza complessiva dei cluster HDInsight, i cluster HDInsight che usano reti virtuali personalizzate devono verificare che l'utente debba avere l'autorizzazione per

Microsoft Network/virtualNetworks/subnets/join/actionper eseguire operazioni di creazione. I clienti dovranno pianificare di conseguenza in quanto questa modifica sarebbe un controllo obbligatorio per evitare errori di creazione del cluster prima del 30 settembre 2023.

- Per migliorare la postura di sicurezza complessiva dei cluster HDInsight, i cluster HDInsight che usano reti virtuali personalizzate devono verificare che l'utente debba avere l'autorizzazione per

- Ritiro delle macchine virtuali di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le macchine virtuali di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle macchine virtuali serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD. Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle macchine virtuali serie A Basic e Standard alle macchine virtuali serie Av2 prima del 31 agosto 2024.

- Cluster ABFS non ESP [Autorizzazioni cluster per la leggibilità generale]

- È prevista l'introduzione di una modifica nei cluster ABFS non ESP per impedire agli utenti di gruppo non Hadoop di eseguire comandi Hadoop per le operazioni di archiviazione. Questa modifica migliora la postura di sicurezza del cluster. I clienti devono pianificare gli aggiornamenti prima del 30 settembre 2023.

Per altre domande, contattare il supporto tecnico di Azure.

È sempre possibile chiedere informazioni su HDInsight in Azure HDInsight - Microsoft Q&A

Qui è possibile aggiungere altre proposte, idee e altri argomenti; oltre a votarli - Community di HDInsight (azure.com); per altri aggiornamenti è possibile seguirci su X

Nota

È consigliabile che i clienti usino le versioni più recenti di HDInsight Images perché consentono di ottenere gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni di sicurezza migliori. Per altre informazioni, vedere Procedure consigliate.

Data di rilascio: 08 maggio 2023

Questa versione si applica alle versioni di HDInsight 4.x e 5.x. HDInsight è disponibile in tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2304280205. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 4.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

Per le versioni specifiche del carico di lavoro, vedere

![]()

Azure HDInsight 5.1 aggiornato con

- Apache HBase 2.4.11

- Apache Phoenix 5.1.2

- Apache Hive 3.1.2

- Apache Spark 3.3.1

- Apache Tez 0.9.1

- Apache Zeppelin 0.10.1

- Apache Livy 0.5

- Apache Kafka 3.2.0

Nota

- Tutti i componenti sono integrati con Hadoop 3.3.4 e ZK 3.6.3

- Tutti i componenti aggiornati precedenti sono ora disponibili nei cluster non ESP per l'anteprima pubblica.

![]()

Scalabilità automatica avanzata per HDInsight

Azure HDInsight ha apportato notevoli miglioramenti alla stabilità e alla latenza sulla scalabilità automatica. Le modifiche essenziali includono un ciclo di feedback migliorato per le decisioni di ridimensionamento, un miglioramento significativo della latenza per il ridimensionamento e il supporto per il ripristino dei nodi rimossi. Qui sono disponibili altre informazioni sui miglioramenti e su come personalizzare la configurazione del cluster ed eseguirne la migrazione per usufruire della scalabilità automatica avanzata. La funzionalità di scalabilità automatica avanzata è disponibile a partire dal 17 maggio 2023 in tutte le aree supportate.

Azure HDInsight ESP per Apache Kafka 2.4.1 è ora disponibile a livello generale.

Azure HDInsight ESP per Apache Kafka 2.4.1 è disponibile in anteprima pubblica a partire da aprile 2022. Dopo miglioramenti significativi nella stabilità e nelle correzioni CVE, Azure HDInsight ESP per Kafka 2.4.1 è ora disponibile a livello generale e pronto per i carichi di lavoro di produzione. Leggere le informazioni dettagliate sulla configurazione e la migrazione.

Gestione della quota per HDInsight

Attualmente HDInsight alloca la quota alle sottoscrizioni dei clienti a livello di area. I core allocati ai clienti sono generici e non classificati a livello di famiglia di macchine virtuali (ad esempio,

Dv2,Ev3,Eav4e così via).HDInsight ha introdotto una visualizzazione migliorata, che mostra i dettagli e la classificazione delle quote per le macchine virtuali a livello di famiglia. Questa funzionalità consente ai clienti di visualizzare le quote correnti e rimanenti per un'area a livello di famiglia di VM. Con la visualizzazione migliorata, i clienti usufruiscono di una visibilità più ampia per la pianificazione delle quote e di un'esperienza utente migliore. Questa funzionalità è attualmente disponibile in HDInsight 4.x e 5.x per l'area Stati Uniti orientali (EUAP). Altre aree seguiranno più avanti.

Per altre informazioni, vedere Pianificazione della capacità dei cluster in Azure HDInsight | Microsoft Learn

![]()

- Polonia Centrale

- La lunghezza massima del nome del cluster cambia da 59 a 45 caratteri per migliorare la postura di sicurezza dei cluster.

- Autorizzazioni del cluster per l'archiviazione sicura

- I clienti possono specificare durante la creazione del cluster se i nodi del cluster HDInsight devono usare un canale sicuro per contattare l'account di archiviazione.

- Aggiornamento della quota inline.

- È possibile richiedere un aumento della quota direttamente dalla pagina Quota personale. Si tratta di una chiamata API diretta, che è più veloce. Se la chiamata API ha esito negativo, i clienti devono creare una nuova richiesta di supporto per l'aumento della quota.

- Creazione di cluster HDInsight con reti virtuali personalizzate.

- Per migliorare la postura di sicurezza complessiva dei cluster HDInsight, i cluster HDInsight che usano reti virtuali personalizzate devono verificare che l'utente debba avere l'autorizzazione per

Microsoft Network/virtualNetworks/subnets/join/actionper eseguire operazioni di creazione. I clienti devono pianificare di conseguenza, in quanto si tratta di un controllo obbligatorio per evitare errori di creazione del cluster.

- Per migliorare la postura di sicurezza complessiva dei cluster HDInsight, i cluster HDInsight che usano reti virtuali personalizzate devono verificare che l'utente debba avere l'autorizzazione per

- Ritiro delle macchine virtuali di serie A Basic e Standard.

- Il 31 agosto 2024 verranno ritirate le macchine virtuali di serie A Basic e Standard. Prima di tale data, è necessario eseguire la migrazione dei carichi di lavoro alle macchine virtuali serie Av2, che offrono una maggiore quantità di memoria per vCPU e un'archiviazione più veloce su unità SSD. Per evitare interruzioni del servizio, eseguire la migrazione dei carichi di lavoro dalle macchine virtuali serie A Basic e Standard alle macchine virtuali serie Av2 prima del 31 agosto 2024.

- Cluster ABFS non ESP [Autorizzazioni cluster per la leggibilità generale]

- È prevista l'introduzione di una modifica nei cluster ABFS non ESP per impedire agli utenti di gruppo non Hadoop di eseguire comandi Hadoop per le operazioni di archiviazione. Questa modifica migliora la postura di sicurezza del cluster. I clienti devono pianificare gli aggiornamenti.

Data di rilascio: 28 febbraio 2023

Questa versione si applica a HDInsight 4.0. e 5.0, 5.1. La versione di HDInsight è disponibile per tutte le aree per diversi giorni. Questa nota sulla versione è applicabile per il numero di immagine 2302250400. Come controllare il numero di immagine?

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 4.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

Per le versioni specifiche del carico di lavoro, vedere

Importante

Microsoft ha rilasciato CVE-2023-23408, che è stato risolto nella versione corrente. I clienti sono invitati ad aggiornare i cluster all'immagine più recente.

![]()

HDInsight 5.1

È stata avviata l'implementazione di una nuova versione di HDInsight 5.1. Tutte le nuove versioni open source sono state aggiunte come versioni incrementali in HDInsight 5.1.

Per altre informazioni, vedere versione HDInsight 5.1.0

![]()

Aggiornamento di Kafka 3.2.0 (anteprima)

- Kafka 3.2.0 include diverse nuove funzionalità e miglioramenti significativi.

- Aggiornamento di Zookeeper alla versione 3.6.3

- Supporto di Kafka Streams

- Garanzie di recapito superiori per il producer Kafka abilitate per impostazione predefinita.

-

log4j1.x è stato sostituito conreload4j. - Invio un suggerimento al leader della partizione per recuperare la partizione.

-

JoinGroupRequesteLeaveGroupRequesthanno un motivo collegato. - Aggiunta delle metriche di conteggio broker8.

- Miglioramenti del mirroring

Maker2.

Aggiornamento di HBase 2.4.11 (anteprima)

- Questa versione include nuove funzionalità, tra cui l'aggiunta di nuovi tipi di meccanismi di memorizzazione nella cache a blocchi e la possibilità di modificare

hbase:meta tablee visualizzare la tabellahbase:metadall'interfaccia utente Web di HBase.

Aggiornamento di Phoenix 5.1.2 (anteprima)

- In questa versione, Phoenix è stato aggiornato alla versione 5.1.2. Questo aggiornamento include Phoenix Query Server. Phoenix Query Server offre un proxy per il driver JDBC Phoenix standard e fornisce un protocollo di trasmissione compatibile con le versioni precedenti per richiamare tale driver JDBC.

CVE di Ambari

- Sono stati corretti più CVE di Ambari.

Nota

ESP non è supportato per Kafka e HBase in questa versione.

![]()

Passaggi successivi

- Autoscale

- Scalabilità automatica con una latenza inferiore e diversi miglioramenti

- Limitazione della modifica del nome del cluster

- La lunghezza massima del nome del cluster passa da 59 a 45 nei cloud Pubblico, Azure Cina e Azure per enti pubblici.

- Autorizzazioni del cluster per l'archiviazione sicura

- I clienti possono specificare durante la creazione del cluster se i nodi del cluster HDInsight devono usare un canale sicuro per contattare l'account di archiviazione.

- Cluster ABFS non ESP [Autorizzazioni cluster per la leggibilità generale]

- È prevista l'introduzione di una modifica nei cluster ABFS non ESP per impedire agli utenti di gruppo non Hadoop di eseguire comandi Hadoop per le operazioni di archiviazione. Questa modifica migliora la postura di sicurezza del cluster. I clienti devono pianificare gli aggiornamenti.

- Aggiornamenti open source

- Apache Spark 3.3.0 e Hadoop 3.3.4 sono in fase di sviluppo in HDInsight 5.1 e includono diverse nuove funzionalità, prestazioni e altri miglioramenti significativi.

Nota

È consigliabile che i clienti usino le versioni più recenti di HDInsight Images perché consentono di ottenere gli aggiornamenti open source, gli aggiornamenti di Azure e le correzioni di sicurezza migliori. Per altre informazioni, vedere Procedure consigliate.

Data di rilascio: 12 dicembre 2022

Questa versione si applica a HDInsight 4.0. e la versione di HDInsight 5.0 è resa disponibile per tutte le aree in diversi giorni.

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

Versioni del sistema operativo

- HDInsight 4.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Kernel Linux 5.4

![]()

- Log Analytics - I clienti possono abilitare il monitoraggio classico per ottenere l'ultima versione di OMS 14.19. Per rimuovere le versioni precedenti, disabilitare e abilitare il monitoraggio classico.

- Disconnessione automatica dell'utente dall'interfaccia di Ambari per inattività. Per altre informazioni, vedere qui

- Spark - Questa versione include una versione nuova e ottimizzata di Spark 3.1.3. Abbiamo testato Apache Spark 3.1.2 (versione precedente) e Apache Spark 3.1.3 (versione corrente) usando il benchmark TPC-DS. Il test è stato eseguito usando lo SKU E8 V3 per Apache Spark su un carico di lavoro di 1 TB. Apache Spark 3.1.3 (versione corrente) ha superato le prestazioni di Apache Spark 3.1.2 (versione precedente) di oltre il 40% nel runtime di query totale per le query TPC-DS usando le stesse specifiche hardware. Il team di Microsoft Spark ha aggiunto ottimizzazioni disponibili in Azure Synapse con Azure HDInsight. Per altre informazioni, vedere Velocizzare i carichi di lavoro dei dati con gli aggiornamenti delle prestazioni di Apache Spark 3.1.2 in Azure Synapse

![]()

- Qatar centrale

- Germania settentrionale

![]()

HDInsight è passato da Azul Zulu Java JDK 8 a

Adoptium Temurin JDK 8, che supporta runtime certificati TCK di alta qualità e la tecnologia associata per l'uso nell'intero ecosistema Java.HDInsight è passato a

reload4j. Le modifiche dilog4jsono applicabili a- Apache Hadoop

- Apache Zookeeper

- Apache Oozie

- Apache Ranger

- Apache Sqoop

- Apache Pig

- Apache Ambari

- Apache Kafka

- Apache Spark

- Apache Zeppelin

- Apache Livy

- Apache Rubix

- Apache Hive

- Apache Tez

- Apache HBase

- OMI

- Apache Phoenix

![]()

In futuro HDInsight implementerà TLS1.2. Le versioni precedenti verranno aggiornate sulla piattaforma. Se si eseguono applicazioni in HDInsight che usano TLS 1.0 e 1.1, eseguire l'aggiornamento a TLS 1.2 per evitare interruzioni nei servizi.

Per altre informazioni, vedere Come abilitare TLS (Transport Layer Security)

![]()

Fine del supporto per i cluster Azure HDInsight in Ubuntu 16.04 LTS dal 30 novembre 2022. HDInsight ha iniziato a rilasciare immagini del cluster con Ubuntu 18.04 dal 27 giugno 2021. I clienti che eseguono cluster che usano Ubuntu 16.04 devono ricompilare i cluster con le immagini HDInsight più recenti entro il 30 novembre 2022.

Per altre informazioni su come controllare la versione Ubuntu del cluster, vedere qui

Eseguire il comando "lsb_release -a" nel terminale.

Se il valore della proprietà "Description" nell'output è "Ubuntu 16.04 LTS", questo aggiornamento è applicabile al cluster.

![]()

- Supporto per la selezione delle zone di disponibilità per i cluster Kafka e HBase (accesso in scrittura).

Correzioni di bug open source

Correzioni di bug Hive

| Correzioni di bug | Apache JIRA |

|---|---|

| HIVE-26127 | Errore di INSERT OVERWRITE - File non trovato |

| HIVE-24957 | Risultati errati quando la sottoquery ha COALESCE nel predicato di correlazione |

| HIVE-24999 | HiveSubQueryRemoveRule genera un piano non valido per la sottoquery IN con più correlazioni |

| HIVE-24322 | Se è presente un inserimento diretto, occorre controllare l'ID tentativo quando la lettura del manifesto ha esito negativo |

| HIVE-23363 | Aggiornare la dipendenza DataNucleus alla versione 5.2 |

| HIVE-26412 | Creare l'interfaccia per recuperare gli slot disponibili e aggiungere un'implementazione predefinita |

| HIVE-26173 | Aggiornare derby alla versione 10.14.2.0 |

| HIVE-25920 | Aggiornare Xerce2 alla versione 2.12.2. |

| HIVE-26300 | Aggiornare Jackson databind alla versione 2.12.6.1 o superiore per evitare CVE-2020-36518 |

Data di rilascio: 10/08/2022

Questa versione si applica a HDInsight 4.0. La versione di HDInsight è resa disponibile per tutte le aree in diversi giorni.

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

![]()

Nuova funzionalità

1. Collegare dischi esterni nei cluster HDI Hadoop/Spark

Il cluster HDInsight include spazio su disco predefinito in base allo SKU. Questo spazio potrebbe non essere sufficiente in scenari con processi di grandi dimensioni.

Questa nuova funzionalità consente di aggiungere altri dischi nel cluster, che vengono usati come directory locale di gestione nodi. Aggiungere il numero di dischi ai nodi di lavoro durante la creazione di cluster HIVE e Spark, mentre i dischi selezionati fanno parte delle directory locali dello strumento di gestione nodi.

Nota

I dischi aggiunti sono configurati solo per le directory locali di gestione nodi.

Per altre informazioni, vedere qui

2. Analisi della registrazione selettiva

L'analisi della registrazione selettiva è ora disponibile in anteprima pubblica in tutte le aree. È possibile connettere il cluster a un'area di lavoro Log Analytics. Dopo l'abilitazione è possibile visualizzare i log e le metriche, ad esempio i log di sicurezza di HDInsight, Yarn Resource Manager, le metriche di sistema e così via. È possibile monitorare i carichi di lavoro e vedere in che modo influiscono sulla stabilità del cluster. La registrazione selettiva consente di abilitare/disabilitare tutte le tabelle o di abilitare tabelle selettive nell'area di lavoro Log Analytics. È possibile modificare il tipo di origine per ogni tabella, perché nella nuova versione del monitoraggio di Geneva una tabella ha più origini.

- Il sistema di monitoraggio Geneva usa mdsd (daemon di MDS), che è un agente di monitoraggio, e Fluentd per raccogliere i log usando un livello di registrazione unificato.

- La registrazione selettiva usa l'azione script per disabilitare/abilitare le tabelle e i relativi tipi di log. Poiché non apre nuove porta né modifica impostazioni di sicurezza esistenti, non ci sono modifiche alla sicurezza.

- L'azione script viene eseguita in parallelo in tutti i nodi specificati e modifica i file di configurazione per disabilitare/abilitare le tabelle e i relativi tipi di log.

Per altre informazioni, vedere qui

![]()

Fisso

Log analytics

Log Analytics integrato con Azure HDInsight che esegue OMS versione 13 richiede un aggiornamento a OMS 14 per applicare gli ultimi aggiornamenti della sicurezza. I clienti che usano la versione precedente del cluster con OMS 13 devono installare OMS versione 14 per soddisfare i requisiti di sicurezza. (Come controllare la versione corrente e installare la 14)

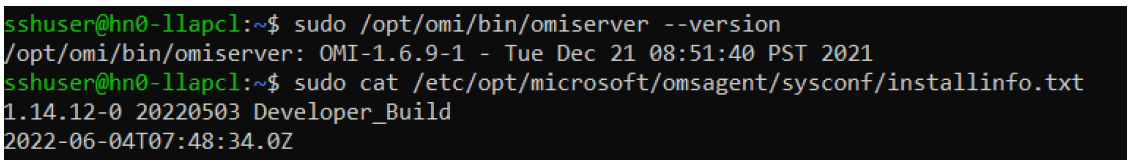

Come controllare la versione corrente di OMS

- Accedere al cluster tramite SSH.

- Nel client SSH eseguire il comando seguente.

sudo /opt/omi/bin/ominiserver/ --version

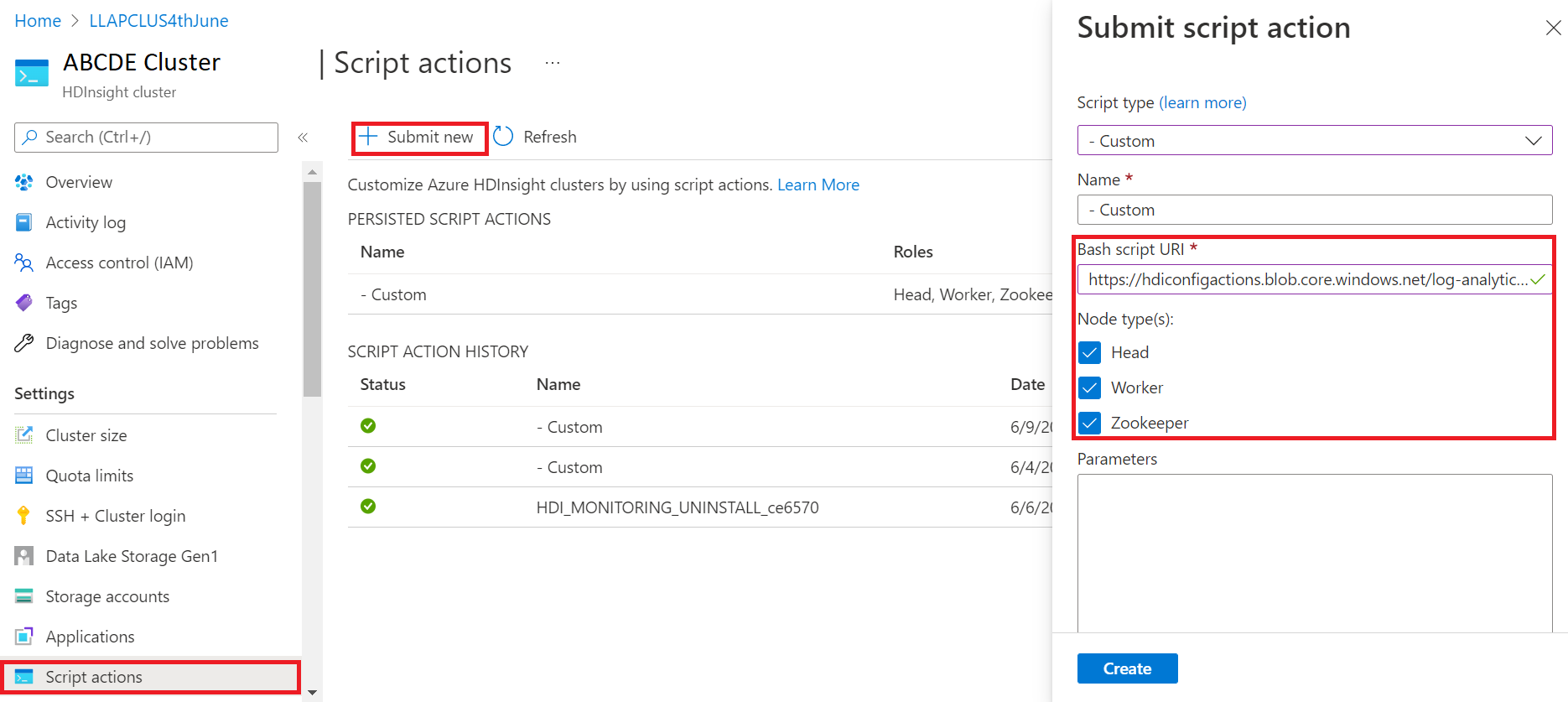

Come aggiornare la versione di OMS da 13 a 14

- Accedere al portale di Azure

- Nel gruppo di risorse selezionare la risorsa cluster HDInsight

- Selezionare Azioni script

- Nel pannello Invia azione script scegliere il Tipo di script personalizzato

- Incollare il collegamento seguente nella casella URL dello script Bash https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Selezionare Tipi di nodo

- Selezionare Crea.

Verificare la corretta installazione della patch attenendosi alla procedura seguente:

Accedere al cluster tramite SSH.

Nel client SSH eseguire il comando seguente.

sudo /opt/omi/bin/ominiserver/ --version

Altre correzioni di bug

- L'interfaccia della riga di comando dei log di Yarn non riusciva a recuperare i log in presenza di

TFiledanneggiati o vuoti. - Risoluzione di un errore di dettagli non validi dell'entità servizio durante il recupero del token OAuth da Azure Active Directory.

- Miglioramento dell'affidabilità nella creazione del cluster quando sono configurati più di 100 nodi di lavoro.

Correzioni di bug open source

Correzioni di bug TEZ

| Correzioni di bug | Apache JIRA |

|---|---|

| Errore di compilazione Tez: FileSaver.js non trovato | TEZ-4411 |

Eccezione FS errato quando il warehouse e scratchdir si trovano in FS diversi |

TEZ-4406 |

| TezUtils.createConfFromByteString in configurazione più grande di 32 MB genera l'eccezione com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils::createByteStringFromConf dovrebbe usare snappy anziché DeflaterOutputStream | TEZ-4113 |

| Aggiornare la dipendenza protobuf a 3.x | TEZ-4363 |

Correzioni di bug Hive

| Correzioni di bug | Apache JIRA |

|---|---|

| Ottimizzazioni delle prestazioni nella generazione suddivisione ORC | HIVE-21457 |

| Evitare di leggere la tabella come ACID quando il nome della tabella inizia con "delta", ma la tabella non è transazionale e viene usata la strategia di suddivisione BI | HIVE-22582 |

| Rimuovere una chiamata FS#exists da AcidUtils#getLogicalLength | HIVE-23533 |

| Vettorializzazione di OrcAcidRowBatchReader.computeOffset e ottimizzazione bucket | HIVE-17917 |

Problemi noti

HDInsight è compatibile con Apache HIVE 3.1.2. A causa di un bug in questa versione, la versione di Hive viene visualizzata come 3.1.0 nelle interfacce hive. Non c'è però alcun impatto sulle funzionalità.

Data di rilascio: 10/08/2022

Questa versione si applica a HDInsight 4.0. La versione di HDInsight è resa disponibile per tutte le aree in diversi giorni.

HDInsight usa procedure di distribuzione sicure, che comportano la distribuzione graduale nelle varie aree. Potrebbero essere necessari fino a 10 giorni lavorativi perché una nuova versione sia disponibile in tutte le regioni.

![]()

Nuova funzionalità

1. Collegare dischi esterni nei cluster HDI Hadoop/Spark

Il cluster HDInsight include spazio su disco predefinito in base allo SKU. Questo spazio potrebbe non essere sufficiente in scenari con processi di grandi dimensioni.

Questa nuova funzionalità consente di aggiungere altri dischi nel cluster, che verranno usati come directory locale di gestione nodi. Aggiungere il numero di dischi ai nodi di lavoro durante la creazione di cluster HIVE e Spark, mentre i dischi selezionati fanno parte delle directory locali dello strumento di gestione nodi.

Nota

I dischi aggiunti sono configurati solo per le directory locali di gestione nodi.

Per altre informazioni, vedere qui

2. Analisi della registrazione selettiva

L'analisi della registrazione selettiva è ora disponibile in anteprima pubblica in tutte le aree. È possibile connettere il cluster a un'area di lavoro Log Analytics. Dopo l'abilitazione è possibile visualizzare i log e le metriche, ad esempio i log di sicurezza di HDInsight, Yarn Resource Manager, le metriche di sistema e così via. È possibile monitorare i carichi di lavoro e vedere in che modo influiscono sulla stabilità del cluster. La registrazione selettiva consente di abilitare/disabilitare tutte le tabelle o di abilitare tabelle selettive nell'area di lavoro Log Analytics. È possibile modificare il tipo di origine per ogni tabella, perché nella nuova versione del monitoraggio di Geneva una tabella ha più origini.

- Il sistema di monitoraggio Geneva usa mdsd (daemon di MDS), che è un agente di monitoraggio, e Fluentd per raccogliere i log usando un livello di registrazione unificato.

- La registrazione selettiva usa l'azione script per disabilitare/abilitare le tabelle e i relativi tipi di log. Poiché non apre nuove porta né modifica impostazioni di sicurezza esistenti, non ci sono modifiche alla sicurezza.

- L'azione script viene eseguita in parallelo in tutti i nodi specificati e modifica i file di configurazione per disabilitare/abilitare le tabelle e i relativi tipi di log.

Per altre informazioni, vedere qui

![]()

Fisso

Log analytics

Log Analytics integrato con Azure HDInsight che esegue OMS versione 13 richiede un aggiornamento a OMS 14 per applicare gli ultimi aggiornamenti della sicurezza. I clienti che usano la versione precedente del cluster con OMS 13 devono installare OMS versione 14 per soddisfare i requisiti di sicurezza. (Come controllare la versione corrente e installare la 14)

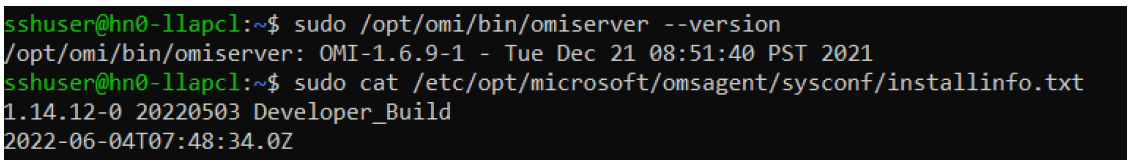

Come controllare la versione corrente di OMS

- Accedere al cluster tramite SSH.

- Nel client SSH eseguire il comando seguente.

sudo /opt/omi/bin/ominiserver/ --version

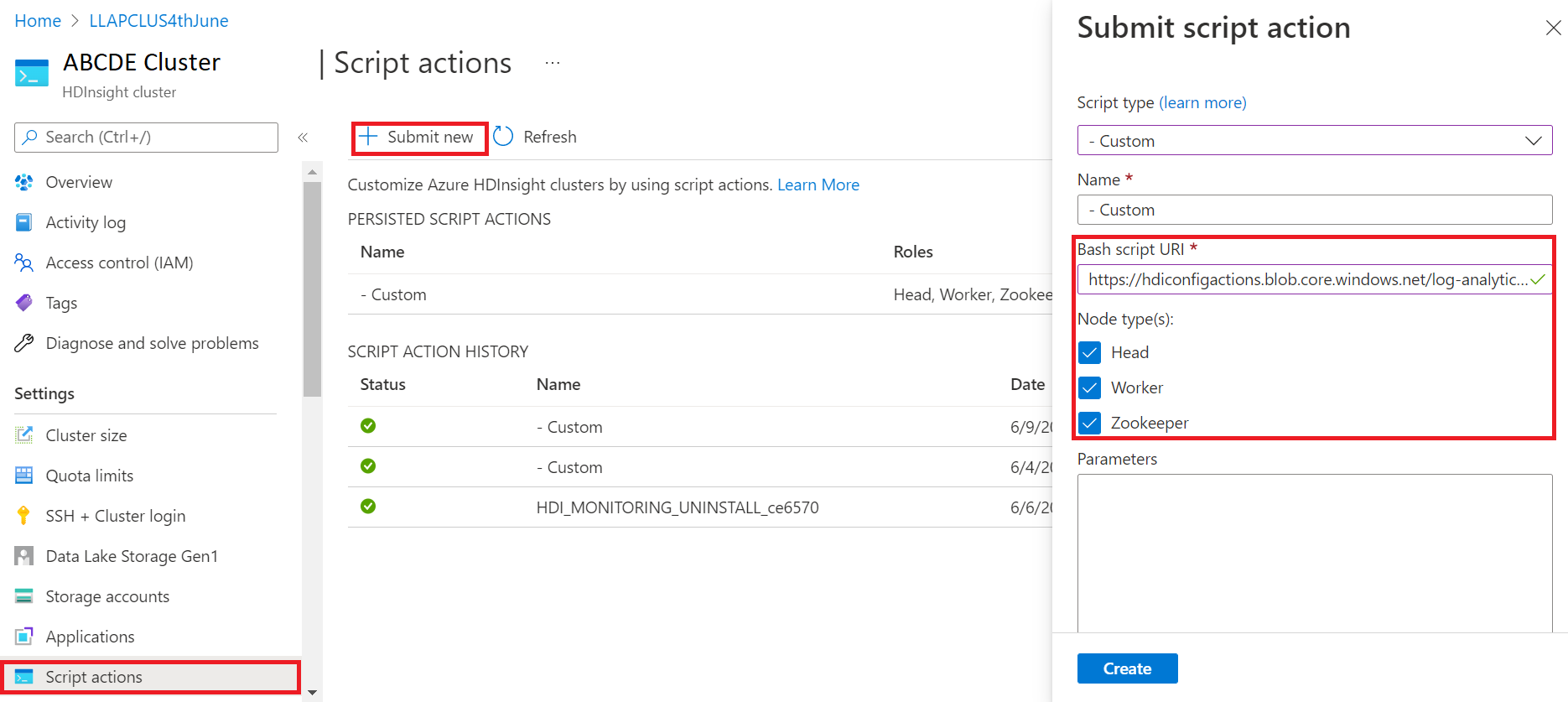

Come aggiornare la versione di OMS da 13 a 14

- Accedere al portale di Azure

- Nel gruppo di risorse selezionare la risorsa cluster HDInsight

- Selezionare Azioni script

- Nel pannello Invia azione script scegliere il Tipo di script personalizzato

- Incollare il collegamento seguente nella casella URL dello script Bash https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Selezionare Tipi di nodo

- Selezionare Crea.

Verificare la corretta installazione della patch attenendosi alla procedura seguente:

Accedere al cluster tramite SSH.

Nel client SSH eseguire il comando seguente.

sudo /opt/omi/bin/ominiserver/ --version

Altre correzioni di bug

- L'interfaccia della riga di comando dei log di Yarn non riusciva a recuperare i log in presenza di

TFiledanneggiati o vuoti. - Risoluzione di un errore di dettagli non validi dell'entità servizio durante il recupero del token OAuth da Azure Active Directory.

- Miglioramento dell'affidabilità nella creazione del cluster quando sono configurati più di 100 nodi di lavoro.

Correzioni di bug open source

Correzioni di bug TEZ

| Correzioni di bug | Apache JIRA |

|---|---|

| Errore di compilazione Tez: FileSaver.js non trovato | TEZ-4411 |

Eccezione FS errato quando il warehouse e scratchdir si trovano in FS diversi |

TEZ-4406 |

| TezUtils.createConfFromByteString in configurazione più grande di 32 MB genera l'eccezione com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils::createByteStringFromConf dovrebbe usare snappy anziché DeflaterOutputStream | TEZ-4113 |

| Aggiornare la dipendenza protobuf a 3.x | TEZ-4363 |

Correzioni di bug Hive

| Correzioni di bug | Apache JIRA |

|---|---|

| Ottimizzazioni delle prestazioni nella generazione suddivisione ORC | HIVE-21457 |

| Evitare di leggere la tabella come ACID quando il nome della tabella inizia con "delta", ma la tabella non è transazionale e viene usata la strategia di suddivisione BI | HIVE-22582 |

| Rimuovere una chiamata FS#exists da AcidUtils#getLogicalLength | HIVE-23533 |

| Vettorializzazione di OrcAcidRowBatchReader.computeOffset e ottimizzazione bucket | HIVE-17917 |

Problemi noti

HDInsight è compatibile con Apache HIVE 3.1.2. A causa di un bug in questa versione, la versione di Hive viene visualizzata come 3.1.0 nelle interfacce hive. Non c'è però alcun impatto sulle funzionalità.

Data di rilascio: 03/06/2022

Questa versione si applica a HDInsight 4.0. La versione di HDInsight è resa disponibile per tutte le aree in diversi giorni. La data di release riportata indica la data di rilascio di release della prima area. Se non vengono visualizzate le modifiche seguenti, attendere che la versione venga rilasciata nella propria area per alcuni giorni.

Principali caratteristiche della versione

Hive Warehouse Connector (HWC) in Spark v3.1.2

Hive Warehouse Connector (HWC) consente di sfruttare le funzionalità esclusive di Hive e Spark per creare potenti applicazioni Big Data. HWC è attualmente supportato solo per Spark v2.4. Questa funzionalità aggiunge valore aziendale consentendo transazioni ACID nelle tabelle Hive tramite Spark. Questa funzionalità è utile per i clienti che usano sia Hive che Spark nel proprio patrimonio di dati. Per altre informazioni, vedere Apache Spark e Hive - Hive Warehouse Connector - Azure HDInsight | Microsoft Docs

Ambari

- Modifiche al ridimensionamento e al provisioning

- HDI Hive è ora compatibile con la versione del software open source 3.1.2

La versione 3.1 di HDI Hive è aggiornata alla versione del software open source Hive 3.1.2. Questa versione include tutte le correzioni e le funzionalità disponibili nella versione open source Hive 3.1.2.

Nota

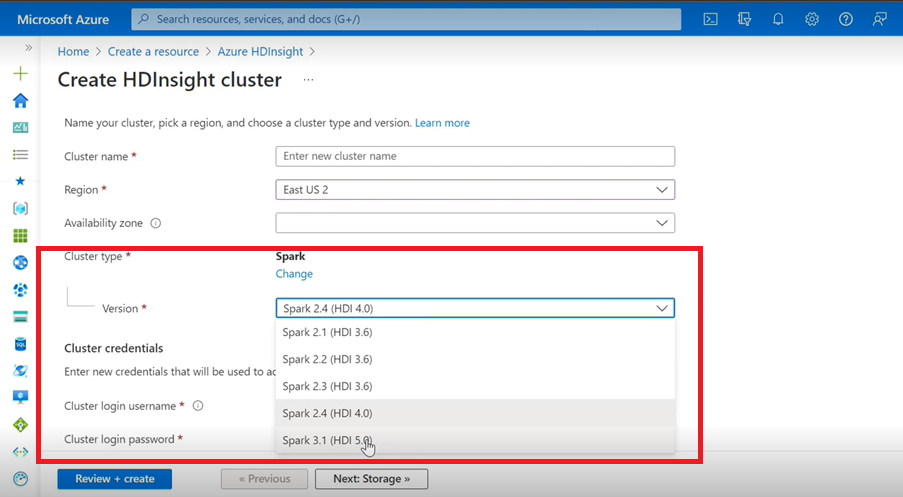

Spark

- Se si usa l'interfaccia utente di Azure per creare un cluster Spark per HDInsight, nell'elenco a discesa verrà visualizzata un'altra versione di Spark 3.1. (HDI 5.0) insieme alle versioni precedenti. Questa versione è una versione rinominata di Spark 3.1. (HDI 4.0). Si tratta solo di una modifica a livello di interfaccia utente, che non influisce in alcun modo sugli utenti esistenti e sugli utenti che usano già il modello di Resource Manager.

Nota

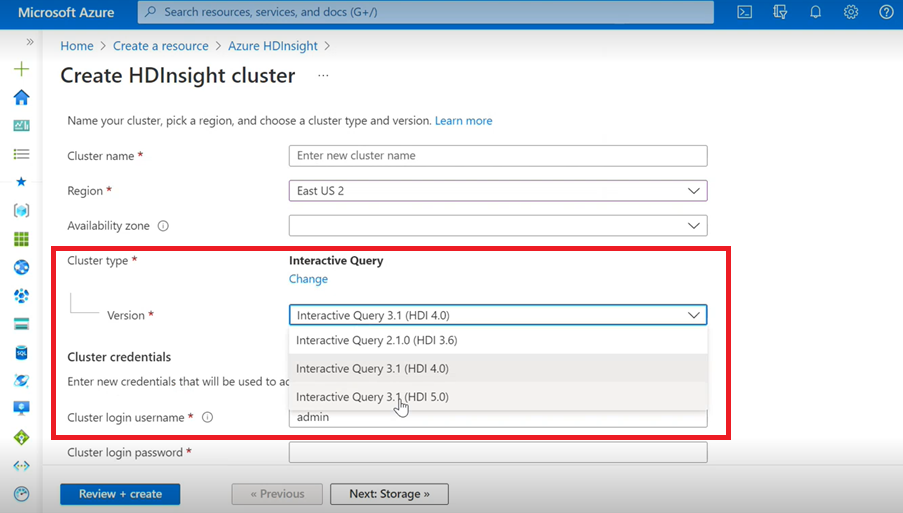

Interactive Query

- Se si crea un cluster Interactive Query, nell'elenco a discesa verrà visualizzata un'altra versione denominata Interactive Query 3.1 (HDI 5.0).

- Se si intende usare Spark 3.1 insieme a Hive, per cui è occorre il supporto ACID, è necessario selezionare la versione Interactive Query 3.1 (HDI 5.0).

Correzioni di bug TEZ

| Correzioni di bug | Apache JIRA |

|---|---|

| TezUtils.createConfFromByteString in configurazione più grande di 32 MB genera l'eccezione com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils createByteStringFromConf dovrebbe usare snappy anziché DeflaterOutputStream | TEZ-4113 |

Correzioni di bug di HBase

| Correzioni di bug | Apache JIRA |

|---|---|

TableSnapshotInputFormat deve usare ReadType.STREAM per l'analisi di HFiles |

HBASE-26273 |

| Aggiunta dell'opzione per disabilitare scanMetrics in TableSnapshotInputFormat | HBASE-26330 |

| Correzione per ArrayIndexOutOfBoundsException quando viene eseguito il servizio di bilanciamento | HBASE-22739 |

Correzioni di bug Hive

| Correzioni di bug | Apache JIRA |

|---|---|

| NPE durante l'inserimento di dati con la clausola "distribute by" con ottimizzazione dell'ordinamento dynpart | HIVE-18284 |

| Il comando MSCK REPAIR con filtro partizioni ha esito negativo durante l'eliminazione delle partizioni | HIVE-23851 |

| Generazione di eccezione errata se capacity<=0 | HIVE-25446 |

| Supporto del caricamento parallelo per HastTables - Interfacce | HIVE-25583 |

| Includere MultiDelimitSerDe in HiveServer2 per impostazione predefinita | HIVE-20619 |

| Rimuovere le classi glassfish.jersey e mssql-jdbc dal JAR jdbc-standalone | HIVE-22134 |

| Eccezione del puntatore Null in caso di compattazione in esecuzione su una tabella MM. | HIVE-21280 |

Le query Hive di dimensioni elevate tramite knox hanno esito negativo con errore Pipe interrotta (scrittura non riuscita) |

HIVE-22231 |

| Aggiunta della possibilità di impostare l'utente bind | HIVE-21009 |

| Implementare una funzione definita dall'utente per interpretare i valori data/timestamp usando la relativa rappresentazione interna e il calendario ibrido gregoriano-giuliano | HIVE-22241 |

| Opzione di Beeline per visualizzare/non visualizzare il report di esecuzione | HIVE-22204 |

| Tez: SplitGenerator prova a cercare i file di piano, che non esistono per Tez | HIVE-22169 |

Rimuovere la registrazione dispendiosa dalla cache LLAP hotpath |

HIVE-22168 |

| Funzione definita dall'utente: FunctionRegistry si sincronizza con classe org.apache.hadoop.hive.ql.udf.UDFType | HIVE-22161 |

| Impedire la creazione dell'appender di routing delle query se la proprietà è impostata su false | HIVE-22115 |

| Rimuovere la sincronizzazione tra query per partition-eval | HIVE-22106 |

| Ignorare la configurazione di directory dei file temporanei per Hive durante la pianificazione | HIVE-21182 |

| Ignorare la creazione di directory dei file temporanei per Tez se RPC è attivo | HIVE-21171 |

Impostare le funzioni definite dall'utente di Hive per l'uso del motore regex Re2J |

HIVE-19661 |

| Le tabelle cluster di cui è stata eseguita la migrazione con bucketing_version 1 in Hive 3 usano bucketing_version 2 per gli inserimenti | HIVE-22429 |

| Bucket: la versione 1 dell'inserimento in bucket erroneamente il partizionamento dei dati | HIVE-21167 |

| Aggiunta dell'intestazione di licenza ASF al file appena aggiunto | HIVE-22498 |

| Miglioramenti dello strumento dello schema a supporto di mergeCatalog | HIVE-22498 |

| Hive con TEZ UNION ALL e UDTF comporta la perdita di dati | HIVE-21915 |

| Dividere i file di testo anche se esiste un'intestazione o un piè di pagina | HIVE-21924 |

| MultiDelimitSerDe restituisce risultati errati nell'ultima colonna quando il file caricato contiene più colonne di quelle presenti nello schema della tabella | HIVE-22360 |

| Client esterno LLAP - È necessario ridurre il footprint di LlapBaseInputFormat#getSplits() | HIVE-22221 |

| Il nome della colonna con parola chiave riservata non ha caratteri di escape quando una query che include un join su una tabella con colonna mask viene riscritta (Zoltan Matyus tramite Zoltan Haindrich) | HIVE-22208 |

Impedire l'arresto di LLAP con RuntimeExceptionAMReporter correlata |

HIVE-22113 |

| Il driver del servizio di stato LLAP potrebbe rimanere bloccato con l'ID app Yarn errato | HIVE-21866 |

| OperationManager.queryIdOperation non pulisce correttamente più queryId | HIVE-22275 |

| Disattivare un gestore di nodi blocca il riavvio del servizio LLAP | HIVE-22219 |

| Stack OverflowError quando si eliminano un numero elevato di partizioni | HIVE-15956 |

| Il controllo dell'accesso non riesce quando viene rimossa una directory temporanea | HIVE-22273 |

| Correzione di risultati errati/eccezione ArrayOutOfBound nei left outer join di mapping in condizioni limite specifiche | HIVE-22120 |

| Rimuovere il tag di gestione della distribuzione da pom.xml | HIVE-19667 |

| Il tempo di analisi può essere elevato se sono presenti sottoquery annidate in profondità | HIVE-21980 |

Per ALTER TABLE t SET TBLPROPERTIES ('EXTERNAL'='TRUE'); le modifiche dell'attributo TBL_TYPE non vengono riglesse riflettono per il testo senza maiuscole |

HIVE-20057 |

JDBC: HiveConnection oscura le interfacce log4j |

HIVE-18874 |

Aggiornare gli URL del repository in poms - versione 3.1 del ramo |

HIVE-21786 |

Test DBInstall non funzionanti su master e branch-3.1 |

HIVE-21758 |

| Il caricamento dei dati in una tabella con bucket ignora le specifiche delle partizioni e carica i dati nella partizione predefinita | HIVE-21564 |

| Le query con condizione di join con timestamp o timestamp con valore letterale del fuso orario locale generano una SemanticException | HIVE-21613 |

| L'analisi delle statistiche di calcolo per le colonne lascia una directory di gestione temporanea in HDFS | HIVE-21342 |

| Modifica incompatibile nel calcolo bucket Hive | HIVE-21376 |

| Fornire un provider di autorizzazioni di fallback quando nessun altro provider di autorizzazioni è in uso | HIVE-20420 |

| Alcune chiamate alterPartitions generano "NumberFormatException: null" | HIVE-18767 |

| HiveServer2: in alcuni casi il soggetto preautenticato per il trasporto HTTP non viene conservato per l'intera durata della comunicazione HTTP | HIVE-20555 |

Data di rilascio: 10/03/2022

Questa versione si applica a HDInsight 4.0. La versione di HDInsight è resa disponibile per tutte le aree in diversi giorni. La data di release riportata indica la data di rilascio di release della prima area. Se non vengono visualizzate le modifiche seguenti, attendere che la versione venga rilasciata nella propria area per alcuni giorni.

Le versioni del sistema operativo per questa versione sono:

- HDInsight 4.0: Ubuntu 18.04.5

Spark 3.1 è ora disponibile a livello generale

Spark 3.1 è ora disponibile a livello generale nella versione HDInsight 4.0. Questa versione include

- Esecuzione adattiva di query,

- Conversione di merge join di ordinamento in hash join di trasmissione,

- Spark Catalyst Optimizer,

- Eliminazione dinamica delle partizioni,

- I clienti potranno creare nuovi cluster Spark 3.1 e non cluster Spark 3.0 (anteprima).

Per altre informazioni, vedere Apache Spark 3.1 è ora disponibile a livello generale in HDInsight - Microsoft Tech Community.

Per un elenco completo dei miglioramenti, vedere le note sulla versione di Apache Spark 3.1.

Per altre informazioni sulla migrazione, vedere la guida alla migrazione.

Kafka 2.4 è ora disponibile a livello generale

Kafka 2.4.1 è ora disponibile a livello generale. Per altre informazioni, vedere le note sulla versione di Kafka 2.4.1. Altre funzionalità includono la disponibilità di MirrorMaker 2, una nuova categoria di metriche AtMinIsr per le partizioni dei topic, il miglioramento del tempo di avvio del broker attraverso mmap lazy su richiesta dei file di indice e un numero maggiore di metriche di consumer per osservare il comportamento di polling degli utenti.

Il tipo di dati Map in HWC è ora supportato in HDInsight 4.0

Questa versione include il supporto del tipo di dati Map per HWC 1.0 (Spark 2.4) tramite l'applicazione spark-shell e tutti gli altri client Spark supportati da HWC. Sono inclusi i miglioramenti seguenti, come per qualsiasi altro tipo di dati:

Un utente può

- Creare una tabella Hive con qualsiasi colonna contenente il tipo di dati Map, inserirvi dati e leggere i risultati.

- Creare un dataframe Apache Spark con tipo di mappa ed eseguire operazioni di lettura e scrittura in batch/flusso.

Nuove aree

HDInsight ha ampliato la sua presenza geografica a due nuove aree: Cina orientale 3 e Cina settentrionale 3.

Modifiche di backport del software open source

Backport del software open source inclusi in Hive, tra cui HWC 1.0 (Spark 2.4) che supporta il tipo di dati Map.

Di seguito sono riportati i problemi JIRA di Apache per backport del software open source di questa versione:

| Funzionalità interessata | Apache JIRA |

|---|---|

| Le query SQL dirette del metastore con IN/(NOT IN) devono essere suddivise in base ai parametri massimi consentiti dal database SQL | HIVE-25659 |

Aggiornare log4j 2.16.0 alla versione 2.17.0 |

HIVE-25825 |

Aggiornare la versione di Flatbuffer |

HIVE-22827 |

| Supportare il tipo di dati Map in modo nativo in formato Arrow | HIVE-25553 |

| Client esterno LLAP: gestire i valori annidati quando lo struct padre è Null | HIVE-25243 |

| Aggiornare Arrow alla versione 0.11.0 | HIVE-23987 |

Informativa sulle funzionalità deprecate

Set di scalabilità di macchine virtuali di Azure in HDInsight

HDInsight non userà più i set di scalabilità di macchine virtuali di Azure per effettuare il provisioning dei cluster. Non è prevista alcuna modifica che causa un'interruzione. I cluster HDInsight esistenti in set di scalabilità di macchine virtuali non subiscono alcun impatto, i nuovi cluster nelle immagini più recenti non useranno più i set di scalabilità di macchine virtuali.

Il ridimensionamento dei carichi di lavoro HBase di Azure HDInsight sarà ora supportato solo usando la scalabilità manuale

A partire dal 01 marzo 2022, HDInsight supporterà solo la scalabilità manuale per HBase, senza alcun impatto sui cluster in esecuzione. I nuovi cluster HBase non saranno in grado di abilitare la scalabilità automatica basata sulla pianificazione. Per altre informazioni su come ridimensionare manualmente i cluster HBase, vedere la documentazione relativa al ridimensionamento manuale dei cluster Azure HDInsight

Data di rilascio: 27/12/2021

Questa versione si applica a HDInsight 4.0. La versione di HDInsight è resa disponibile per tutte le aree in diversi giorni. La data di release riportata indica la data di rilascio di release della prima area. Se non vengono visualizzate le modifiche seguenti, attendere che la versione venga rilasciata nella propria area per alcuni giorni.

Le versioni del sistema operativo per questa versione sono:

- HDInsight 4.0: Ubuntu 18.04.5 LTS

L'immagine di HDInsight 4.0 è stata aggiornata per mitigare la vulnerabilità di Log4j, come descritto nella Risposta di Microsoft a CVE-2021-44228 Apache Log4j 2.

Nota

- I cluster HDI 4.0 creati dopo le 00:00 UTC del 27 dicembre 2021 vengono creati con una versione aggiornata dell'immagine, che mitiga le vulnerabilità di

log4j. Di conseguenza, i clienti non devono applicare patch o riavviare questi cluster. - Per i nuovi cluster HDInsight 4.0 creati tra il 16 dicembre 2021 alle 01:15 UTC e il 27 dicembre 2021 alle 00:00 UTC, in HDInsight 3.6 o nelle sottoscrizioni aggiunte dopo il 16 dicembre 2021 la patch viene applicata automaticamente entro l'ora in cui viene creato il cluster. Tuttavia i clienti devono riavviare i nodi per il completamento dell'applicazione della patch (ad eccezione dei nodi di gestione Kafka, che vengono riavviati automaticamente).

Data di rilascio: 27/07/2021

Questa versione si applica a HDInsight 3.6 e HDInsight 4.0. La versione di HDInsight è resa disponibile per tutte le aree in diversi giorni. La data di release riportata indica la data di rilascio di release della prima area. Se non vengono visualizzate le modifiche seguenti, attendere che la versione venga rilasciata nella propria area per alcuni giorni.

Le versioni del sistema operativo per questa versione sono:

- HDInsight 3.6: Ubuntu 16.04.7 LTS

- HDInsight 4.0: Ubuntu 18.04.5 LTS

Nuove funzionalità

Il supporto di Azure HDInsight per la connettività pubblica con restrizioni è disponibile a livello generale dal 15 ottobre 2021

Azure HDInsight supporta ora la connettività pubblica con restrizioni in tutte le aree. Di seguito sono riportate alcune delle principali caratteristiche di questa funzionalità:

- Possibilità di invertire la comunicazione tra provider di risorse e cluster in modo che sia in uscita dal cluster verso il provider di risorse