Ajouter et gérer une source d’événement dans un flux d’événements

Une fois que vous avez créé un eventstream, vous pouvez le connecter à différentes sources de données et destinations.

Remarque

Les fonctionnalités améliorées sont activées par défaut si vous créez des flux d’événements maintenant. Si des flux d’événements existants ont été créés en utilisant les fonctionnalités standard, ces flux d’événements continueront à fonctionner. Vous pouvez toujours les modifier et les utiliser comme d’habitude. Nous vous recommandons de créer un nouveau eventstream pour remplacer les eventstreams standard. Ainsi, vous pourrez tirer parti des fonctionnalités supplémentaires et des avantages des eventstreams améliorés.

Une fois que vous avez créé un Eventstream, vous pouvez le connecter à différentes sources de données et destinations.

Le Eventstreams vous permet non seulement de diffuser en continu des données à partir de sources Microsoft, mais également de prendre en charge l’ingestion à partir de plateformes tierces telles que Google Cloud et Amazon Kinesis avec de nouveaux connecteurs de messagerie. Cette fonctionnalité étendue offre une intégration transparente des flux de données externes à Fabric, offrant une plus grande flexibilité et vous permettant d’obtenir des insights en temps réel à partir de plusieurs sources.

Dans cet article, vous allez découvrir les sources d’événements que vous pouvez ajouter à un eventstream.

Prérequis

- Accès à un espace de travail en mode licence de capacité Fabric ou en mode licence d’évaluation avec des autorisations Contributeur ou supérieures.

- Conditions préalables spécifiques à chaque source documentées dans les articles spécifiques à la source suivants.

Sources prises en charge

Les Eventstreams Fabric avec des fonctionnalités améliorées prennent en charge les sources suivantes. Chaque article fournit des détails et des instructions pour l’ajout de sources spécifiques.

| Sources | Description |

|---|---|

| Azure Event Hubs | Si vous disposez d’un Event Hub Azure, vous pouvez ingérer des données Event Hub dans Microsoft Fabric à l’aide d’Eventstream. |

| Azure IoT Hub | Si vous disposez d’un Hub Azure IoT, vous pouvez ingérer des données IoT dans Microsoft Fabric à l’aide d’Eventstream. |

| Capture des changements de données (CDC) de la base de données Azure SQL | Le connecteur source Azure SQL Database CDC vous permet de capturer une instantané des données actuelles dans une base de données Azure SQL. Le connecteur surveille et enregistre ensuite les modifications futures au niveau des lignes apportées à ces données. |

| CDC de la base de données PostgreSQL | Le connecteur source de capture des changements de données (CDC) PostgreSQL Database vous permet de capturer un instantané des données actuelles dans une base de données PostgreSQL. Le connecteur surveille et enregistre ensuite les modifications futures au niveau des lignes apportées à ces données. |

| CDC de la base de données MySQL | Le connecteur source de capture des changements de données (CDC) Azure MySQL Database vous permet de capturer un instantané des données actuelles dans une base de données Azure Database pour MySQL. Vous pouvez spécifier les tables à surveiller, et le Eventstreams enregistre toutes les futures modifications au niveau des lignes apportées aux tables. |

| CDC d’Azure Cosmos DB | Le connecteur source de la capture des changements de données (CDC) d’Azure Cosmos DB pour les Eventstreams Microsoft Fabric vous permet de capturer un instantané des données actuelles dans une base de données Azure Cosmos DB. Le connecteur surveille et enregistre ensuite les modifications futures au niveau des lignes apportées à ces données. |

| SQL Server sur capture des changements de données d’une base de données de machine virtuelle (DB) | Le connecteur source SQL Server on VM DB (CDC) pour les flux d'événements Fabric vous permet de capturer un instantané des données actuelles d'une base de données SQL Server on VM. Le connecteur surveille et enregistre ensuite les modifications futures au niveau des lignes apportées aux données. |

| Azure SQL Managed Instance CDC | Le connecteur source CDC Azure SQL Managed Instance pour les Eventstreams Microsoft Fabric vous permet de capturer une instantané des données actuelles dans une base de données Azure SQL. Le connecteur surveille et enregistre ensuite les modifications futures au niveau des lignes apportées à ces données. |

| Google Cloud Pub/Sub | Google Pub/Sub est un service de messagerie qui vous permet de publier et de vous abonner aux Eventstreams. Vous pouvez ajouter Google Pub/Sub en tant que source à votre Eventstreams pour capturer, transformer et acheminer des événements en temps réel vers différentes destinations dans Fabric. |

| Flux de données Amazon Kinesis | Le flux de données Amazon Kinesis est une ingestion des données hautement durable et évolutive massivement évolutive et optimisée pour les données de streaming. Grâce à l’intégration des Flux de données Amazon Kinesis en tant que source au sein de votre Eventstreams, vous pouvez traiter en toute transparence les flux de données en temps réel avant de les router vers plusieurs destinations au sein de Fabric. |

| Confluent Cloud Kafka | Confluent Cloud Kafka est une plateforme de diffusion en continu offrant de puissantes fonctionnalités de diffusion en continu et de traitement des données à l’aide d’Apache Kafka. Grâce à l’intégration de Confluent Cloud Kafka en tant que source au sein de votre Eventstreams, vous pouvez traiter en toute transparence les flux de données en temps réel avant de les router vers plusieurs destinations au sein de Fabric. |

| Amazon MSK Kafka | Amazon MSK Kafka est un service Kafka entièrement managé qui simplifie l’installation, la mise à l’échelle et la gestion. En intégrant Amazon MSK Kafka en tant que source dans votre flux d’événements, vous pouvez apporter en toute transparence les événements en temps réel à partir de votre MSK Kafka et les traiter avant de les router vers plusieurs destinations au sein de Fabric. |

| Exemples de données | Vous pouvez choisir les événements Vélos, Taxi jaune ou Marché boursier comme exemple de source de données pour tester l’ingestion des données lors de la configuration d’un Eventstream. |

| Point de terminaison personnalisé (c’est-à-dire une application personnalisée dans la capacité standard) | La fonctionnalité d’un point de terminaison personnalisé permet à vos applications ou clients Kafka de se connecter à Eventstream à l’aide d’une chaîne de connexion, ce qui permet une ingestion fluide des données de streaming dans Eventstream. |

| Azure Service Bus (préversion) | Vous pouvez ingérer des données à partir d’une file d’attente Azure Service Bus ou d’un abonnement d’une rubrique dans Microsoft Fabric à l’aide d’Eventstream. |

| Apache Kafka (préversion) | Apache Kafka est une plateforme distribuée open source permettant de créer des systèmes de données évolutifs et en temps réel. En intégrant Apache Kafka en tant que source dans votre flux d’événements, vous pouvez apporter en toute transparence des événements en temps réel à partir de votre apache Kafka et les traiter avant de les router vers plusieurs destinations au sein de Fabric. |

| Événements de stockage Blob Azure (préversion) | Les événements de Stockage Blob Azure sont déclenchés quand un client crée, remplace ou supprime un objet blob. Le connecteur vous permet de lier des événements de stockage blob à des événements Fabric dans le hub en temps réel. Vous pouvez convertir ces événements en flux de données continus et les transformer avant de les router vers différentes destinations dans Fabric. |

| Événements d’élément d’espace de travail Fabric (préversion) | Les événements d’élément d’espace de travail Fabric sont des événements Fabric discrets qui se produisent lorsque des modifications sont apportées à votre espace de travail Fabric. Ces modifications incluent la création, la mise à jour ou la suppression d’un élément Fabric. Avec les Eventstreams Fabric, vous pouvez capturer ces événements d’espace de travail Fabric, les transformer et les router vers différentes destinations dans Fabric pour une analyse plus approfondie. |

| Événements Fabric OneLake (préversion) | Les événements OneLake vous permettent de vous abonner aux modifications apportées aux fichiers et dossiers dans OneLake, puis de réagir à ces modifications en temps réel. Avec les flux d’événements Fabric, vous pouvez capturer ces événements OneLake, les transformer et les router vers différentes destinations dans Fabric pour une analyse plus approfondie. Cette intégration transparente des événements OneLake dans les flux d’événements Fabric vous offre une plus grande flexibilité pour la supervision et l’analyse des activités dans votre OneLake. |

| Événements Fabric Job (préversion) | Les événements de travail vous permettent de vous abonner aux modifications produites lorsque Fabric exécute un travail. Par exemple, vous pouvez réagir aux modifications lors de l’actualisation d’un modèle sémantique, de l’exécution d’un pipeline planifié ou de l’exécution d’un notebook. Chacune de ces activités peut générer un travail correspondant, qui génère à son tour un ensemble d’événements de travail correspondants. Avec les flux d’événements Fabric, vous pouvez capturer ces événements de travail, les transformer et les router vers différentes destinations dans Fabric pour une analyse plus approfondie. Cette intégration transparente des événements job dans les flux d’événements Fabric vous offre une plus grande flexibilité pour la supervision et l’analyse des activités dans votre travail. |

Remarque

Le nombre maximal de sources et de destinations pour un flux d’événements est de 11.

Contenu connexe

Prérequis

Pour commencer, vous devez remplir les conditions préalables suivantes :

- Accès à un espace de travail en mode licence de capacité Fabric ou en mode licence d’évaluation avec des autorisations Contributeur ou supérieures.

- Pour ajouter Azure Event Hubs ou Azure IoT Hub en tant que source de flux d’événements, vous devez disposer de l’autorisation appropriée pour accéder à ses clés de stratégie. Ils doivent être accessibles publiquement et non derrière un pare-feu ou sécurisés dans un réseau virtuel.

Sources prises en charge

Les flux d’événements Fabric prennent en charge les sources suivantes. Les liens dans le tableau permettent de naviguer vers des articles qui fournissent plus de détails sur l’ajout de sources spécifiques.

| Sources | Description |

|---|---|

| Azure Event Hubs | Si vous disposez d’un Event Hub Azure, vous pouvez ingérer des données Event Hub dans Microsoft Fabric à l’aide d’Eventstream. |

| Azure IoT Hub | Si vous disposez d’un Hub Azure IoT, vous pouvez ingérer des données IoT dans Microsoft Fabric à l’aide d’Eventstream. |

| Exemples de données | Vous pouvez choisir les événements Vélos, Taxi jaune ou Marché boursier comme exemple de source de données pour tester l’ingestion des données lors de la configuration d’un Eventstream. |

| Application personnalisée | La fonctionnalité d’application personnalisée permet à vos applications ou clients Kafka de se connecter à Eventstream à l’aide d’une chaîne de connexion, ce qui permet une ingestion fluide des données de streaming dans Eventstream. |

Remarque

Le nombre maximal de sources et de destinations pour un flux d’événements est de 11.

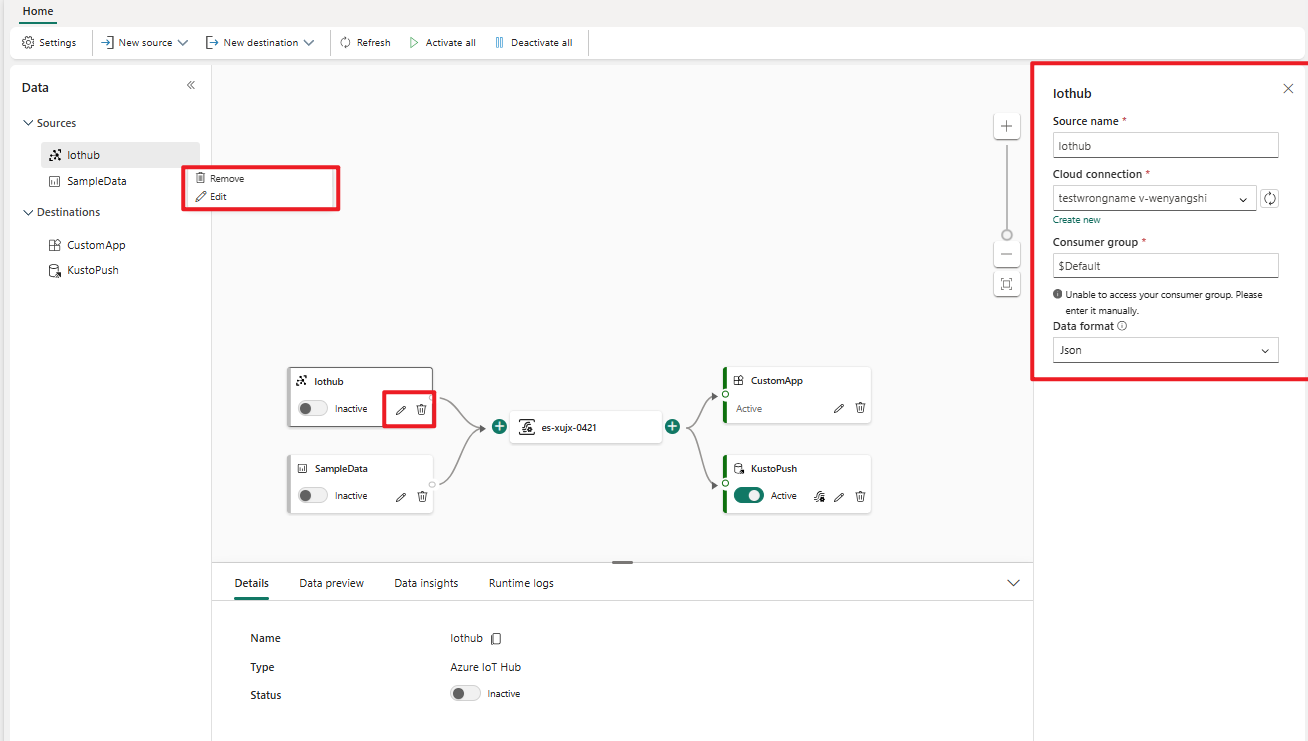

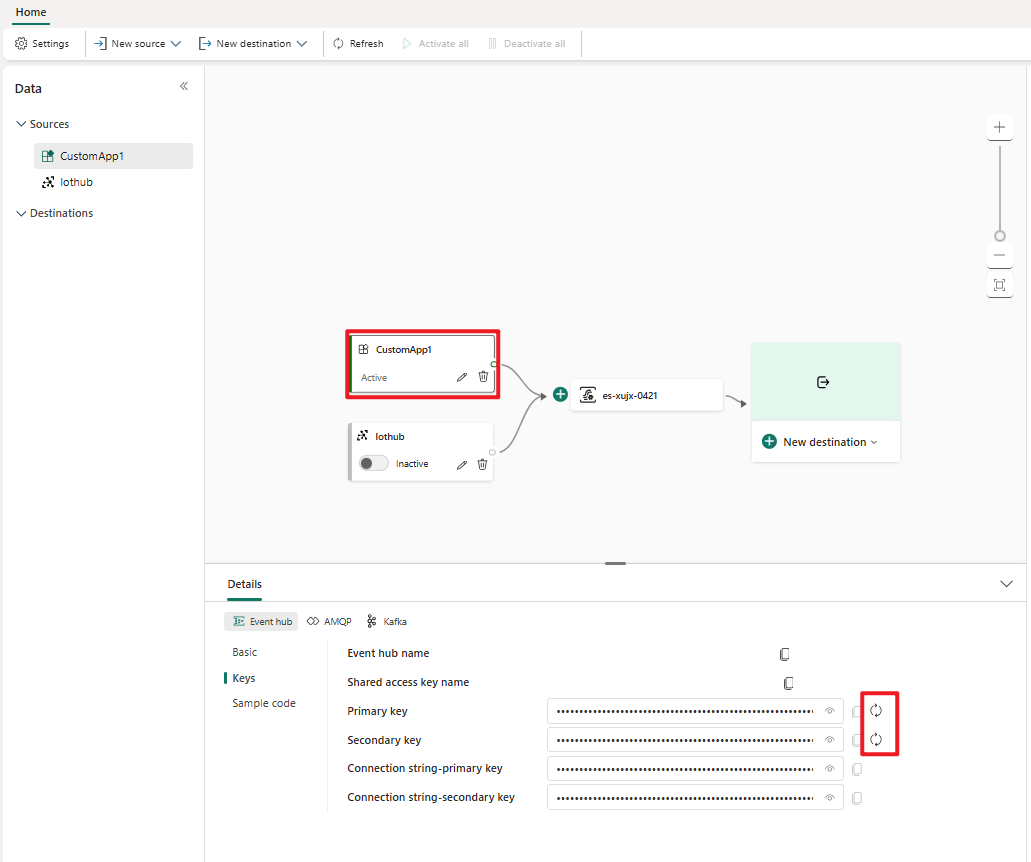

Gérer une source

Modifier/supprimer : vous pouvez sélectionner une source de flux d’événements à modifier ou à supprimer via le volet de navigation ou le canevas. Lorsque vous sélectionnez Modifier, le volet Modifier s’ouvre à droite de l’éditeur principal.

Régénérer la clé pour une application personnalisée : si vous souhaitez régénérer une clé de connexion pour votre application, sélectionnez l’une de vos sources d’application personnalisée sur le canevas, puis sélectionnez Regénérer pour obtenir une nouvelle clé de connexion.