Notes de publication archivées

Résumé

Azure HDInsight est l’un des services les plus populaires parmi les clients d’entreprise pour l’analytique open source sur Azure. Abonnez-vous aux notes de publication de HDInsight pour obtenir des informations à jour concernant HDInsight et toutes ses versions.

Pour vous abonner, cliquez sur le bouton « watch » dans la bannière et surveillez les versions de HDInsight.

Informations de version

Date de publication : 22 octobre 2024

Remarque

Ceci est un correctif logiciel / une version de maintenance pour le fournisseur de ressources. Pour plus d’informations, consultez Fournisseur de ressources.

Azure HDInsight publie régulièrement des mises à jour de maintenance pour fournir des correctifs de bogues, des améliorations du niveau de performance et des correctifs de sécurité. Veillez à effectuer ces mises à jour pour garantir des performances et une fiabilité optimales.

Cette note de publication s’applique à

HDInsight version 5.1.

HDInsight version 5.0.

HDInsight version 4.0.

La version HDInsight va être disponible dans toutes les régions sur plusieurs jours. Cette note de publication s’applique au numéro d’image 2409240625. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 5.1 : noyau Linux Ubuntu 18.04.5 LTS 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Remarque

Ubuntu 18.04 est pris en charge dans le cadre de la maintenance ESM (maintenance de sécurité étendue) par l’équipe Azure Linux pour Azure HDInsight juillet 2023, et ses versions ultérieures.

Pour connaître les versions spécifiques à la charge de travail, consultez les versions des composants HDInsight 5.x.

Mis à jour

Prise en charge de l’authentification basée sur MSI disponible pour le stockage d’objets blob Azure.

- Azure HDInsight prend désormais en charge l’authentification basée sur OAuth pour accéder au stockage Blob Azure en s’appuyant sur Azure Active Directory (AAD) et les identités managées (MSI). Avec cette amélioration, HDInsight utilise des identités managées attribuées à l’utilisateur pour accéder au stockage Blob Azure. Pour plus d’informations, consultez Identités managées pour les ressources Azure.

Le service HDInsight est passé à l’utilisation d’équilibreurs de charge standard pour toutes ses configurations de cluster en raison de l’annonce de dépréciation de l’équilibreur de charge de base Azure.

Remarque

Cette modification est disponible dans toutes les régions. Recréez votre cluster pour utiliser cette modification. Pour obtenir de l'aide, contactez le support.

Important

Si vous utilisez votre propre réseau virtuel (réseau virtuel personnalisé) lors de la création du cluster, notez que la création du cluster n’aboutira pas une fois cette modification activée. Nous vous recommandons de faire référence au guide de migration pour recréer le cluster. Pour obtenir de l'aide, contactez le support.

À venir

À venir

Mise hors service des machines virtuelles de la série A Essentiel et Standard.

- Le 31 août 2024, nous procéderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD.

- Pour éviter les interruptions de service, migrez vos charges de travail des machines virtuelles de la série A De base et Standard vers des machines virtuelles de la série Av2 avant le 31 août 2024.

Notifications de mise hors service pour HDInsight 4.0 et HDInsight 5.0.

Si vous avez d’autres questions, contactez le support Azure.

Vous pouvez toujours nous poser des questions concernant HDInsight sur Azure HDInsight – Microsoft Q&A.

Nous sommes à l’écoute : nous vous invitons à ajouter d’autres idées et d’autres sujets ici et à voter en leur faveur (Idées HDInsight). Pour rester au fait des dernières nouveautés, inscrivez-vous à la communauté AzureHDInsight.

Remarque

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d’informations, consultez Meilleures pratiques.

Date de publication : 30 août 2024

Remarque

Ceci est un correctif logiciel / une version de maintenance pour le fournisseur de ressources. Pour plus d’informations, consultez Fournisseur de ressources.

Azure HDInsight publie régulièrement des mises à jour de maintenance pour fournir des correctifs de bogues, des améliorations du niveau de performance et des correctifs de sécurité. Veillez à effectuer ces mises à jour pour garantir des performances et une fiabilité optimales.

Cette note de publication s’applique à

HDInsight version 5.1.

HDInsight version 5.0.

HDInsight version 4.0.

La version HDInsight va être disponible dans toutes les régions sur plusieurs jours. Cette note de publication s’applique au numéro d’image 2407260448. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 5.1 : noyau Linux Ubuntu 18.04.5 LTS 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Remarque

Ubuntu 18.04 est pris en charge dans le cadre de la maintenance ESM (maintenance de sécurité étendue) par l’équipe Azure Linux pour Azure HDInsight juillet 2023, et ses versions ultérieures.

Pour connaître les versions spécifiques à la charge de travail, consultez les versions des composants HDInsight 5.x.

Problème corrigé

- Correction d’un bogue affectant la base de données par défaut.

Bientôt disponible

-

Mise hors service des machines virtuelles de la série A Essentiel et Standard.

- Le 31 août 2024, nous procéderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD.

- Pour éviter les interruptions de service, migrez vos charges de travail des machines virtuelles de la série A De base et Standard vers des machines virtuelles de la série Av2 avant le 31 août 2024.

- Notifications de mise hors service pour HDInsight 4.0 et HDInsight 5.0.

Si vous avez d’autres questions, contactez le support Azure.

Vous pouvez toujours nous poser des questions concernant HDInsight sur Azure HDInsight – Microsoft Q&A.

Nous sommes à l’écoute : nous vous invitons à ajouter d’autres idées et d’autres sujets ici et à voter en leur faveur (Idées HDInsight). Pour rester au fait des dernières nouveautés, inscrivez-vous à la communauté AzureHDInsight.

Remarque

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d'informations, consultez Meilleures pratiques.

Date de publication : 09 août 2024

Cette note de publication s’applique à

HDInsight version 5.1.

HDInsight version 5.0.

HDInsight version 4.0.

La version HDInsight va être disponible dans toutes les régions sur plusieurs jours. Cette note de publication s’applique au numéro d’image 2407260448. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 5.1 : noyau Linux Ubuntu 18.04.5 LTS 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Remarque

Ubuntu 18.04 est pris en charge dans le cadre de la maintenance ESM (maintenance de sécurité étendue) par l’équipe Azure Linux pour Azure HDInsight juillet 2023, et ses versions ultérieures.

Pour connaître les versions spécifiques à la charge de travail, consultez les versions des composants HDInsight 5.x.

Mises à jour

Ajout de l’agent Azure Monitor pour Log Analytics dans HDInsight

Ajout de SystemMSI et d’une règle de collecte de données (DCR) automatisée pour Log Analytics, compte tenu de la dépréciation de la nouvelle expérience Azure Monitor (préversion).

Remarque

Numéro d’image efficace 2407260448, les clients utilisant le portail pour l’analytique des journaux d’activité ont l’expérience Agent Azure Monitor par défaut. Au cas où vous souhaitez basculer vers l’expérience Azure Monitor (préversion), vous pouvez épingler vos clusters à d’anciennes images en créant une demande de support.

Date de publication : 5 juillet 2024

Remarque

Ceci est un correctif logiciel / une version de maintenance pour le fournisseur de ressources. Pour plus d’informations, consultez Fournisseur de ressources.

Problèmes résolus

Les balises HOBO remplacent les balises utilisateur.

- Les balises HOBO remplacent les balises utilisateur sur les sous-ressources dans le cadre de la création d’un cluster HDInsight.

Date de publication : 19 juin 2024

Cette note de publication s’applique à

HDInsight version 5.1.

HDInsight version 5.0.

HDInsight version 4.0.

La version HDInsight va être disponible dans toutes les régions sur plusieurs jours. Cette note de publication s’applique au numéro d’image 2406180258. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 5.1 : noyau Linux Ubuntu 18.04.5 LTS 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Remarque

Ubuntu 18.04 est pris en charge dans le cadre de la maintenance ESM (maintenance de sécurité étendue) par l’équipe Azure Linux pour Azure HDInsight juillet 2023, et ses versions ultérieures.

Pour connaître les versions spécifiques à la charge de travail, consultez les versions des composants HDInsight 5.x.

Problèmes résolus

Améliorations de la sécurité

Améliorations apportées à HDInsight Log Analytics avec la prise en charge de l’identité managée système pour le fournisseur de ressources HDInsight.

Ajout de nouvelles activités pour mettre à niveau la version de l’agent

mdsdpour l’ancienne image (créée avant 2024).Activation de MISE dans la passerelle dans le cadre des améliorations continues apportées à la migration MSAL.

Incorporation de

Httpheader hiveConfdu serveur Spark Thrift à Jetty HTTP ConnectionFactory.Rétablissement de RANGER-3753 et RANGER-3593.

L’implémentation

setOwnerUserdonnée dans Ranger 2.3.0 a un problème de régression critique lorsqu’elle est utilisée par Hive. Dans Ranger 2.3.0, lorsque HiveServer2 tente d’évaluer les stratégies, Ranger Client tente d’obtenir le propriétaire de la table Hive en appelant le metastore dans la fonction setOwnerUser qui effectue essentiellement l’appel au stockage pour vérifier l’accès à cette table. Ce problème entraîne l’exécution lente des requêtes lorsque Hive s’exécute sur Ranger 2.3.0.

Nouvelles régions ajoutées

- Italie Nord

- Israël Central

- Espagne Centre

- Mexique Centre

- JIO Inde Centre

Ajout aux notes d’archive de juin 2024

Bientôt disponible

-

Mise hors service des machines virtuelles de la série A Essentiel et Standard.

- Le 31 août 2024, nous procéderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD.

- Pour éviter les interruptions de service, migrez vos charges de travail des machines virtuelles de la série A De base et Standard vers des machines virtuelles de la série Av2 avant le 31 août 2024.

- Notifications de mise hors service pour HDInsight 4.0 et HDInsight 5.0.

Si vous avez d’autres questions, contactez le support Azure.

Vous pouvez toujours nous poser des questions concernant HDInsight sur Azure HDInsight – Microsoft Q&A.

Nous sommes à l’écoute : nous vous invitons à ajouter d’autres idées et d’autres sujets ici et à voter en leur faveur (Idées HDInsight). Pour rester au fait des dernières nouveautés, inscrivez-vous à la communauté AzureHDInsight.

Remarque

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d'informations, consultez Meilleures pratiques.

Date de publication : 16 mai 2024

Cette note de publication s’applique à

HDInsight version 5.0.

HDInsight version 4.0.

La version HDInsight va être disponible dans toutes les régions sur plusieurs jours. Cette note de publication s’applique au numéro d’image 2405081840. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Remarque

Ubuntu 18.04 est pris en charge dans le cadre de la maintenance ESM (maintenance de sécurité étendue) par l’équipe Azure Linux pour Azure HDInsight juillet 2023, et ses versions ultérieures.

Pour connaître les versions spécifiques à la charge de travail, consultez les versions des composants HDInsight 5.x.

Problèmes résolus

- Ajout de l’API dans la passerelle pour obtenir un jeton pour Keyvault, dans le cadre de l’initiative SFI.

- Dans la nouvelle table moniteur

HDInsightSparkLogsde journal, pour le type de journalSparkDriverLog, certains des champs étaient manquants. Par exemple :LogLevel & Message. Cette version ajoute les champs manquants aux schémas et à la mise en forme fixe pourSparkDriverLog. - Les journaux Livy ne sont pas disponibles dans la table de surveillance Log Analytics

SparkDriverLog, ce qui était dû à un problème lié au chemin d’accès source du journal Livy et à l’analyse des journaux d’activité dans les configurationsSparkLivyLog. - N’importe quel cluster HDInsight, à l’aide de ADLS Gen2 en tant que compte de stockage principal, peut tirer parti de l’accès MSI à l’une des ressources Azure (par exemple, SQL, Coffres de clés) utilisées dans le code de l’application.

À venir

-

Mise hors service des machines virtuelles de la série A Essentiel et Standard.

- Le 31 août 2024, nous procéderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD.

- Pour éviter les interruptions de service, migrez vos charges de travail des machines virtuelles de la série A De base et Standard vers des machines virtuelles de la série Av2 avant le 31 août 2024.

- Notifications de mise hors service pour HDInsight 4.0 et HDInsight 5.0.

Si vous avez d’autres questions, contactez le support Azure.

Vous pouvez toujours nous poser des questions concernant HDInsight sur Azure HDInsight – Microsoft Q&A.

Nous sommes à l’écoute : nous vous invitons à ajouter d’autres idées et d’autres sujets ici et à voter en leur faveur (Idées HDInsight). Pour rester au fait des dernières nouveautés, inscrivez-vous à la communauté AzureHDInsight.

Remarque

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d'informations, consultez Meilleures pratiques.

Date de publication : 15 avril 2024

Cette note de publication s’applique à HDInsight version 5.1.

La version HDInsight va être disponible dans toutes les régions sur plusieurs jours. Cette note de publication s’applique au numéro d’image 2403290825. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 5.1 : noyau Linux Ubuntu 18.04.5 LTS 5.4

Remarque

Ubuntu 18.04 est pris en charge dans le cadre de la maintenance ESM (maintenance de sécurité étendue) par l’équipe Azure Linux pour Azure HDInsight juillet 2023, et ses versions ultérieures.

Pour connaître les versions spécifiques à la charge de travail, consultez les versions des composants HDInsight 5.x.

Problèmes résolus

- Correctifs de bogues pour Ambari DB, Hive Warehouse Controller (HWC), Spark, HDFS

- Correctifs de bogues pour le module Log Analytics pour HDInsightSparkLogs

- Correctifs CVE pour le fournisseur de ressources HDInsight.

Bientôt disponible

-

Mise hors service des machines virtuelles de la série A Essentiel et Standard.

- Le 31 août 2024, nous procéderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD.

- Pour éviter les interruptions de service, migrez vos charges de travail des machines virtuelles de la série A De base et Standard vers des machines virtuelles de la série Av2 avant le 31 août 2024.

- Notifications de mise hors service pour HDInsight 4.0 et HDInsight 5.0.

Si vous avez d’autres questions, contactez le support Azure.

Vous pouvez toujours nous poser des questions concernant HDInsight sur Azure HDInsight – Microsoft Q&A.

Nous sommes à l’écoute : nous vous invitons à ajouter d’autres idées et d’autres sujets ici et à voter en leur faveur (Idées HDInsight). Pour rester au fait des dernières nouveautés, inscrivez-vous à la communauté AzureHDInsight.

Remarque

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d'informations, consultez Meilleures pratiques.

Date de publication : 15 février 2024

Cette publication s’applique aux versions 4.x et 5.x de HDInsight. La version HDInsight va être disponible dans toutes les régions sur plusieurs jours. Cette publication s’applique à l’image numéro 2401250802. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1 : noyau Linux Ubuntu 18.04.5 LTS 5.4

Remarque

Ubuntu 18.04 est pris en charge dans le cadre de la maintenance ESM (maintenance de sécurité étendue) par l’équipe Azure Linux pour Azure HDInsight juillet 2023, et ses versions ultérieures.

Pour les versions propres à la charge de travail, voir

Nouvelles fonctionnalités

- Prise en charge de Spark SQL par Apache Ranger dans Spark 3.3.0 (HDInsight version 5.1) avec le Pack Sécurité Entreprise. Cliquez ici pour en savoir plus.

Problèmes résolus

- Correctifs de sécurité des composants Ambari et Oozie

À venir

À venir

- Mise hors service des machines virtuelles de la série A Essentiel et Standard.

- Le 31 août 2024, nous procéderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD.

- Pour éviter les interruptions de service, migrez vos charges de travail des machines virtuelles de la série A De base et Standard vers des machines virtuelles de la série Av2 avant le 31 août 2024.

Si vous avez d’autres questions, contactez le support Azure.

Vous pouvez toujours nous poser des questions concernant HDInsight sur Azure HDInsight : Microsoft Q&A

Nous sommes à l’écoute : nous vous invitons à y ajouter d’autres t idées et d’autres sujets et à voter en leur faveur : Idées HDInsight. Suivez-nous sur la Communauté AzureHDInsight pour rester au fait des dernières nouveautés

Remarque

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d'informations, consultez Meilleures pratiques.

Étapes suivantes

- Azure HDInsight : Forum Aux Questions

- Configurer la planification de la mise à jour corrective du système d’exploitation pour les clusters HDInsight sous Linux

- Note de publication précédente

Azure HDInsight est l’un des services les plus populaires parmi les clients d’entreprise pour l’analytique open source sur Azure. Si vous souhaitez vous abonner aux notes de publication, regardez les communiqués sur ce référentiel GitHub.

Date de publication : 10 janvier 2024

Cette mise en production de correctif logiciel s’applique aux versions 4.x et 5.x de HDInsight. La version HDInsight va être disponible dans toutes les régions sur plusieurs jours. Cette mise en production s’applique à l’image numéro 2401030422. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1 : noyau Linux Ubuntu 18.04.5 LTS 5.4

Remarque

Ubuntu 18.04 est pris en charge dans le cadre de la maintenance ESM (maintenance de sécurité étendue) par l’équipe Azure Linux pour Azure HDInsight juillet 2023, et ses versions ultérieures.

Pour les versions propres à la charge de travail, voir

Problèmes résolus

- Correctifs de sécurité des composants Ambari et Oozie

À venir

À venir

- Mise hors service des machines virtuelles de la série A Essentiel et Standard.

- Le 31 août 2024, nous procéderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD.

- Pour éviter les interruptions de service, migrez vos charges de travail des machines virtuelles de la série A De base et Standard vers des machines virtuelles de la série Av2 avant le 31 août 2024.

Si vous avez d’autres questions, contactez le support Azure.

Vous pouvez toujours nous poser des questions concernant HDInsight sur Azure HDInsight : Microsoft Q&A

Nous sommes à l’écoute : nous vous invitons à y ajouter d’autres t idées et d’autres sujets et à voter en leur faveur : Idées HDInsight. Suivez-nous sur la Communauté AzureHDInsight pour rester au fait des dernières nouveautés

Remarque

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d'informations, consultez Meilleures pratiques.

Date de publication : 26 octobre 2023

Cette note de publication s’applique à HDInsight 4.x ; la version 5.x de HDInsight sera disponible dans toutes les régions dans les prochains jours. Cette mise en production s’applique au numéro d’image 2310140056. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1 : noyau Linux Ubuntu 18.04.5 LTS 5.4

Pour les versions propres à la charge de travail, voir

Nouveautés

HDInsight annonce la disponibilité générale de HDInsight 5.1 à partir du 1 novembre 2023. Cette version apporte une actualisation de la pile complète des composants open source et des intégrations de Microsoft.

- Dernières versions open source : HDInsight 5.1 est fourni avec la dernière version open source stable disponible. Les clients peuvent tirer parti de toutes les dernières fonctionnalités open source, des améliorations des performances Microsoft et des correctifs de bogues.

- Sécurisé : les dernières versions sont fournies avec les correctifs de sécurité les plus récents, à la fois les correctifs de sécurité open source et les améliorations de sécurité de Microsoft.

- Réduction du coût TCO : avec des améliorations de performances, les clients peuvent réduire le coût d’exploitation, ainsi que la mise à l’échelle automatique améliorée.

Autorisations de cluster pour un stockage sécurisé

- Les clients peuvent indiquer (lors de la création du cluster) si un canal sécurisé doit être utilisé pour permettre aux nœuds de cluster HDInsight de se connecter au compte de stockage.

Création de clusters HDInsight avec des réseaux virtuels personnalisés.

- Pour améliorer la posture de sécurité globale des clusters HDInsight, les clusters HDInsight utilisant des VNET personnalisés doivent s'assurer que l'utilisateur doit avoir l'autorisation

Microsoft Network/virtualNetworks/subnets/join/actiond'effectuer des opérations de création. Le client peut rencontrer des échecs de création si cette vérification n’est pas activée.

- Pour améliorer la posture de sécurité globale des clusters HDInsight, les clusters HDInsight utilisant des VNET personnalisés doivent s'assurer que l'utilisateur doit avoir l'autorisation

Clusters ABFS non-ESP [Autorisations de cluster pour Word Readable]

- Les clusters ABFS non ESP empêchent les utilisateurs de groupe non Hadoop d’exécuter des commandes Hadoop pour les opérations de stockage. Cette modification améliore la posture de sécurité du cluster.

Mise à jour de quota en ligne.

- Vous pouvez maintenant demander une augmentation du quota directement de la page Mon quota. Avec l’appel direct de l’API, c’est beaucoup plus rapide. En cas d’échec de l’appel de l’API, vous pouvez créer une demande de support pour une augmentation de quota.

À venir

À venir

La longueur maximale des noms de clusters passe de 59 à 45 caractères dans le but d’améliorer la posture de sécurité des clusters. Cette modification sera déployée dans toutes les régions à compter de la prochaine version.

Mise hors service des machines virtuelles de la série A De base et Standard.

- Le 31 août 2024, nous procéderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD.

- Pour éviter les interruptions de service, migrez vos charges de travail des machines virtuelles de la série A De base et Standard vers des machines virtuelles de la série Av2 avant le 31 août 2024.

Si vous avez d’autres questions, contactez le support Azure.

Vous pouvez toujours nous poser des questions concernant HDInsight sur Azure HDInsight : Microsoft Q&A

Nous sommes à l’écoute : nous vous invitons à y ajouter d’autres t idées et d’autres sujets et à voter en leur faveur : Idées HDInsight. Suivez-nous sur la Communauté AzureHDInsight pour rester au fait des dernières nouveautés

Remarque

Cette version corrige les CVE suivants publiés par MSRC le 12 septembre 2023. L’action consiste à mettre à jour la dernière image 2308221128 ou 2310140056. Les clients sont invités à planifier en conséquence.

| CVE | Gravité | Titre CVE | Remarque |

|---|---|---|---|

| CVE-2023-38156 | Important | Vulnérabilité d’élévation de privilèges Dans Azure HDInsight Apache Ambari | Inclus dans l’image 2308221128 ou 2310140056 |

| CVE-2023-36419 | Important | Vulnérabilité d’élévation de privilèges du planificateur de workflow dans Azure HDInsight Apache Oozie | Appliquer Action de script sur vos clusters ou effectuer une mise à jour vers l’image 2310140056 |

Remarque

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d'informations, consultez Meilleures pratiques.

Date de publication : 7 septembre 2023

Cette note de publication s’applique à HDInsight 4.x ; la version 5.x de HDInsight sera disponible dans toutes les régions dans les prochains jours. Cette mise en production s’applique au numéro d’image 2308221128. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1 : noyau Linux Ubuntu 18.04.5 LTS 5.4

Pour les versions propres à la charge de travail, voir

Important

Cette version corrige les CVE suivants publiés par MSRC le 12 septembre 2023. L'action consiste à mettre à jour la dernière image 2308221128. Les clients sont invités à planifier en conséquence.

| CVE | Gravité | Titre CVE | Remarque |

|---|---|---|---|

| CVE-2023-38156 | Important | Vulnérabilité d’élévation de privilèges Dans Azure HDInsight Apache Ambari | Inclus sur l’image 2308221128 |

| CVE-2023-36419 | Important | Vulnérabilité d’élévation de privilèges du planificateur de workflow dans Azure HDInsight Apache Oozie | Appliquer Action de script sur vos clusters |

Bientôt disponible

- La longueur maximale des noms de clusters passe de 59 à 45 caractères dans le but d’améliorer la posture de sécurité des clusters. Cette modification sera implémentée d’ici le 30 septembre 2023.

- Autorisations de cluster pour un stockage sécurisé

- Les clients peuvent indiquer (lors de la création du cluster) si un canal sécurisé doit être utilisé pour permettre aux nœuds de cluster HDInsight de contacter le compte de stockage.

- Mise à jour de quota en ligne.

- Les demandes d’augmentation de quota s’effectuent directement dans la page Mon quota. Il s’agit d’un appel d’API direct, ce qui est plus rapide. En cas d’échec de l’appel d’APdl, les clients doivent alors créer une demande de support pour augmentation de quota.

- Création de clusters HDInsight avec des réseaux virtuels personnalisés.

- Pour améliorer la posture de sécurité globale des clusters HDInsight, les clusters HDInsight utilisant des VNET personnalisés doivent s'assurer que l'utilisateur doit avoir l'autorisation

Microsoft Network/virtualNetworks/subnets/join/actiond'effectuer des opérations de création. Les clients devraient planifier en conséquence car ce changement serait une vérification obligatoire pour éviter les échecs de création de cluster avant le 30 septembre 2023.

- Pour améliorer la posture de sécurité globale des clusters HDInsight, les clusters HDInsight utilisant des VNET personnalisés doivent s'assurer que l'utilisateur doit avoir l'autorisation

- Mise hors service des machines virtuelles de la série A De base et Standard.

- Le 31 août 2024, nous procéderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD. Pour éviter les interruptions de service, migrez vos charges de travail des machines virtuelles de la série A De base et Standard vers des machines virtuelles de la série Av2 avant le 31 août 2024.

- Clusters ABFS non-ESP [Autorisations de cluster pour Word Readable]

- Prévoyez d’introduire une modification dans les clusters ABFS non-ESP qui empêche l’exécution par les utilisateurs de groupe non Hadoop de commandes Hadoop pour les opérations de stockage. Cette modification permet d’améliorer l’état de la sécurité du cluster. Les clients doivent planifier les mises à jour avant le 30 septembre 2023.

Si vous avez d’autres questions, contactez le support Azure.

Vous pouvez toujours nous poser des questions concernant HDInsight sur Azure HDInsight : Microsoft Q&A

Nous vous invitons à y ajouter d’autres propositions et idées et d’autres sujets et à voter en leur faveur – Communauté HDInsight (azure.com).

Remarque

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d'informations, consultez Meilleures pratiques.

Date de sortie : 25 juillet 2023

Cette note de publication s’applique à HDInsight 4.x ; la version 5.x de HDInsight sera disponible dans toutes les régions dans les prochains jours. Cette version s'applique à l'image numéro 2307201242. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1 : noyau Linux Ubuntu 18.04.5 LTS 5.4

Pour les versions propres à la charge de travail, voir

Quoi de neuf

Quoi de neuf

- HDInsight 5.1 est désormais pris en charge avec le cluster ESP.

- La version mise à jour de Ranger 2.3.0 et Oozie 5.2.1 fait désormais partie de HDInsight 5.1

- Le cluster Spark 3.3.1 (HDInsight 5.1) est fourni avec Hive Warehouse Connector (HWC) 2.1, qui fonctionne avec le cluster Interactive Query (HDInsight 5.1).

- Ubuntu 18.04 est pris en charge sous ESM (Maintenance de sécurité étendue) par l’équipe Azure Linux pour Azure HDInsight juillet 2023, version ultérieure.

Important

Cette version corrige les CVE suivants publiés par MSRC le 8 août 2023. L'action consiste à mettre à jour la dernière image 2307201242. Les clients sont invités à planifier en conséquence.

| CVE | Gravité | Titre CVE |

|---|---|---|

| CVE-2023-35393 | Important | Vulnérabilité d'usurpation d'Azure Apache Hive |

| CVE-2023-35394 | Important | Vulnérabilité d'usurpation de bloc-notes Azure HDInsight Jupyter |

| CVE-2023-36877 | Important | Vulnérabilité d'usurpation Azure Apache Oozie |

| CVE-2023-36881 | Important | Vulnérabilité d'usurpation Azure Apache Ambari |

| CVE-2023-38188 | Important | Vulnérabilité d'usurpation d'Azure Apache Hadoop |

À venir

À venir

- La longueur maximale des noms de clusters passe de 59 à 45 caractères dans le but d’améliorer la posture de sécurité des clusters. Les clients doivent planifier les mises à jour avant le 30 septembre 2023.

- Autorisations de cluster pour un stockage sécurisé

- Les clients peuvent indiquer (lors de la création du cluster) si un canal sécurisé doit être utilisé pour permettre aux nœuds de cluster HDInsight de contacter le compte de stockage.

- Mise à jour de quota en ligne.

- Les demandes d’augmentation de quota s’effectuent directement dans la page Mon quota. Il s’agit d’un appel d’API direct, ce qui est plus rapide. En cas d’échec de l’appel d’API, les clients doivent créer une demande de support pour augmentation de quota.

- Création de clusters HDInsight avec des réseaux virtuels personnalisés.

- Pour améliorer la posture de sécurité globale des clusters HDInsight, les clusters HDInsight utilisant des VNET personnalisés doivent s'assurer que l'utilisateur doit avoir l'autorisation

Microsoft Network/virtualNetworks/subnets/join/actiond'effectuer des opérations de création. Les clients devraient planifier en conséquence car ce changement serait une vérification obligatoire pour éviter les échecs de création de cluster avant le 30 septembre 2023.

- Pour améliorer la posture de sécurité globale des clusters HDInsight, les clusters HDInsight utilisant des VNET personnalisés doivent s'assurer que l'utilisateur doit avoir l'autorisation

- Mise hors service des machines virtuelles de la série A De base et Standard.

- Le 31 août 2024, nous procèderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD. Pour éviter les interruptions de service, migrez vos charges de travail des VM de base et standard de la série A vers les VM de la série Av2 avant le 31 août 2024.

- Clusters ABFS non-ESP [Autorisations de cluster pour Word Readable]

- Prévoyez d’introduire une modification dans les clusters ABFS non-ESP qui empêche l’exécution par les utilisateurs de groupe non Hadoop de commandes Hadoop pour les opérations de stockage. Cette modification permet d’améliorer l’état de la sécurité du cluster. Les clients doivent planifier les mises à jour avant le 30 septembre 2023.

Si vous avez d’autres questions, contactez le support Azure.

Vous pouvez toujours nous poser des questions concernant HDInsight sur Azure HDInsight : Microsoft Q&A

Nous vous invitons à rejoindre la communauté HDInsight (azure.com) pour y ajouter d’autres propositions et idées et d’autres sujets et voter en leur faveur. Pour rester au fait des dernières nouveautés, suivez-nous sur X.

Remarque

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d'informations, consultez Meilleures pratiques.

Date de publication : 08 mai 2023

Cette note de publication s’applique à HDInsight 4.x ; la version 5.x de HDInsight est disponible dans toutes les régions dans les prochains jours. Cette mise en production s’applique au numéro d’image 2304280205. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Pour les versions propres à la charge de travail, voir

![]()

Azure HDInsight 5.1 mis à jour avec

- Apache HBase 2.4.11

- Apache Phoenix 5.1.2

- Apache Hive 3.1.2

- Apache Spark 3.3.1

- Apache Tez 0.9.1

- Apache Zeppelin 0.10.1

- Apache Livy 0.5

- Apache Kafka 3.2.0

Remarque

- Tous les composants sont intégrés à Hadoop 3.3.4 et ZK 3.6.3

- Tous les composants mis à niveau ci-dessus sont désormais disponibles dans les clusters non ESP pour la préversion publique.

![]()

Mise à l’échelle automatique améliorée pour HDInsight

Azure HDInsight a apporté d’importantes améliorations à la stabilité et la latence concernant la mise à l’échelle automatique. Les modifications essentielles comprennent l’amélioration de la boucle de commentaires pour les décisions de mise à l’échelle, une amélioration significative de la latence pour la mise à l’échelle et la prise en charge de la remise en service de nœuds désactivés. En savoir plus sur les améliorations, la configuration personnalisée et la migration de votre cluster vers une mise à l’échelle automatique améliorée. La fonctionnalité de mise à l’échelle automatique améliorée est disponible depuis 17 mai 2023 dans toutes les régions prises en charge.

Azure HDInsight ESP pour Apache Kafka 2.4.1 est désormais en disponibilité générale.

Azure HDInsight ESP pour Apache Kafka 2.4.1 est en préversion publique depuis avril 2022. Après les améliorations notables au niveau des correctifs CVE et de la stabilité, Azure HDInsight ESP Kafka 2.4.1 passe désormais en disponibilité générale et est prêt pour les charges de travail de production. Découvrez les procédures détaillées deconfiguration et de migration.

Gestion de quota pour HDInsight

HDInsight alloue actuellement un quota aux abonnements des clients à un niveau régional. Les cœurs alloués aux clients sont génériques et ne sont pas classifiés au niveau d’une famille de machines virtuelles (par exemple,

Dv2,Ev3,Eav4, etc.).HDInsight a introduit une vue améliorée, qui fournit des détails et une classification de quotas pour les machines virtuelles au niveau de la famille. Cette fonctionnalité permet aux clients d’examiner les quotas actuels et restants pour une région au niveau de la famille de machines virtuelles. Cette vue améliorée confère aux clients une plus grande visibilité, ce qui facilite la planification de quotas, ainsi qu’une meilleure expérience utilisateur. Cette fonctionnalité est actuellement disponible sur HDInsight 4.x et 5.x pour la région USA Est EUAP. D’autres régions suivront ultérieurement.

Pour plus d’informations, consultez Planification de la capacité de cluster dans Azure HDInsight | Microsoft Learn

![]()

- Pologne Centre

- La longueur maximale des noms de clusters passe de 59 à 45 caractères dans le but d’améliorer la posture de sécurité des clusters.

- Autorisations de cluster pour un stockage sécurisé

- Les clients peuvent indiquer (lors de la création du cluster) si un canal sécurisé doit être utilisé pour permettre aux nœuds de cluster HDInsight de contacter le compte de stockage.

- Mise à jour de quota en ligne.

- Les demandes d’augmentation de quota s’effectuent directement dans la page Mon quota. Il s’agit d’un appel d’API direct, ce qui est plus rapide. En cas d’échec de l’appel d’API, les clients doivent créer une demande de support pour augmentation de quota.

- Création de clusters HDInsight avec des réseaux virtuels personnalisés.

- Pour améliorer la posture de sécurité globale des clusters HDInsight, les clusters HDInsight qui utilisent des réseaux virtuels personnalisés doivent vérifier que l’utilisateur a besoin d’une autorisation pour permettre à

Microsoft Network/virtualNetworks/subnets/join/actiond’effectuer des opérations de création. Les clients doivent prendre des dispositions en conséquence, car il s’agit d’une vérification obligatoire pour éviter les échecs de création de cluster.

- Pour améliorer la posture de sécurité globale des clusters HDInsight, les clusters HDInsight qui utilisent des réseaux virtuels personnalisés doivent vérifier que l’utilisateur a besoin d’une autorisation pour permettre à

- Mise hors service des machines virtuelles de la série A De base et Standard.

- Le 31 août 2024, nous procèderons à la mise hors service des machines virtuelles des plans De base et Standard de la série A. Avant cette date, vous devez avoir migré vos charges de travail vers des machines virtuelles de la série Av2, qui offrent une plus grande capacité de mémoire par processeur virtuel et un stockage plus rapide sur disque SSD. Pour éviter les interruptions de service, migrez vos charges de travail des machines virtuelles de la série A De base et Standard vers des machines virtuelles de la série Av2 avant le 31 août 2024.

- Clusters ABFS non-ESP [Autorisations de cluster pour Lecture dans le Monde]

- Prévoyez d’introduire une modification dans les clusters ABFS non-ESP qui empêche l’exécution par les utilisateurs de groupe non Hadoop de commandes Hadoop pour les opérations de stockage. Cette modification permet d’améliorer l’état de la sécurité du cluster. Les clients ont à prévoir les mises à jour.

Date de publication : 28 février 2023

Cette version s’applique à HDInsight 4.0. et 5.0, 5.1. La version HDInsight est disponible dans toutes les régions sur plusieurs jours. Cette version est valable pour le numéro d’image 2302250400. Comment vérifier le numéro d’image ?

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Pour les versions propres à la charge de travail, voir

Important

Microsoft a émis CVE-2023-23408, lequel est fixe sur la version actuelle et il est conseillé aux clients de mettre à niveau leurs clusters vers l’image la plus récente.

![]()

HDInsight 5.1

Nous avons commencé le déploiement d’une nouvelle version de HDInsight 5.1. Toutes les nouvelles versions open source ajoutées en tant que versions incrémentielles à HDInsight 5.1.

Pour plus d’informations, consultez HDInsight version 5.1.0

![]()

Mise à niveau de Kafka 3.2.0 (préversion)

- Kafka 3.2.0 apporte plusieurs nouvelles fonctionnalités/améliorations significatives.

- Mise à niveau vers la version 3.6.3 de Zookeeper

- Prise en charge de Kafka Streams

- Des garanties de livraison plus fortes activées par défaut pour le producteur Kafka.

-

log4j1.x remplacé parreload4j. - Envoyez un conseil au responsable de partition pour récupérer la partition.

-

JoinGroupRequestetLeaveGroupRequestsont lié à une raison. - Ajout de métriques du nombre de répartiteur8.

- Améliorations de Mirror

Maker2.

Mise à niveau de HBase 2.4.11 (Préversion)

- Cette version apporte de nouvelles fonctionnalités comme l’ajout de nouveaux types de mécanismes de mise en cache pour la mise en cache de blocs, la possibilité de modifier

hbase:meta tableet d’afficher le tableauhbase:metaà partir de l’interface utilisateur WEB HBase.

Mise à niveau de Phoenix 5.1.2 (Préversion)

- Mise à niveau vers la version 5.1.2 de Phoenix dans cette version. Cette mise à niveau comprend le serveur Phoenix Query Server. Le serveur Phoenix Query Server mandate le pilote standard JDBC Phoenix et fournit un protocole filaire rétrocompatible pour appeler ce pilote JDBC.

Ambari CVE

- Plusieurs Ambari CVE ont été corrigés.

Notes

ESP n’est pas pris en charge pour Kafka et HBase dans cette version.

![]()

Étapes suivantes

- Mise à l’échelle automatique

- Mise à l’échelle automatique avec une meilleure latence et plusieurs améliorations

- Limitation des modifications de nom de cluster

- La longueur maximale du nom du cluster passe de 45 à 59 dans Public, Azure Chine et Azure Government.

- Autorisations de cluster pour un stockage sécurisé

- Les clients peuvent indiquer (lors de la création du cluster) si un canal sécurisé doit être utilisé pour permettre aux nœuds de cluster HDInsight de contacter le compte de stockage.

- Clusters ABFS non-ESP [Autorisations de cluster pour Lecture dans le Monde]

- Prévoyez d’introduire une modification dans les clusters ABFS non-ESP qui empêche l’exécution par les utilisateurs de groupe non Hadoop de commandes Hadoop pour les opérations de stockage. Cette modification permet d’améliorer l’état de la sécurité du cluster. Les clients ont à prévoir les mises à jour.

- Des mises à niveau open source

- Apache Spark 3.3.0 et Hadoop 3.3.4 sont en cours de développement sur HDInsight 5.1 et comportent plusieurs nouvelles fonctionnalités, performances et autres améliorations significatives.

Notes

Nous conseillons aux clients d’utiliser les dernières versions des Images HDInsight, car elles proposent le meilleur des mises à jour open source, des mises à jour Azure et des correctifs de sécurité. Pour plus d'informations, consultez Meilleures pratiques.

Date de publication : 12 décembre 2022

Cette version s’applique à HDInsight 4.0. et la version 5.0 HDInsight est mise à disposition dans toutes les régions sur plusieurs jours.

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

Versions du système d’exploitation

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

![]()

- Log Analytics : les clients peuvent activer la surveillance classique pour obtenir la dernière version d’OMS 14.19. Pour supprimer les anciennes versions, désactivez et activez la surveillance classique.

- Déconnexion automatique de l’interface utilisateur de l’utilisateurAmbari en raison d’une inactivité. Vous trouverez plus d’informations ici.

- Spark : une nouvelle version optimisée de Spark 3.1.3 est incluse dans cette version. Nous avons testé Apache Spark 3.1.2 (version précédente) et Apache Spark 3.1.3 (version actuelle) à l’aide du benchmark TPC-DS. Le test a été effectué à l’aide de la référence SKU E8 V3, pour Apache Spark sur une charge de travail de 1 To. Apache Spark 3.1.3 (version actuelle) a dépassé Apache Spark 3.1.2 (version précédente) de plus de 40 % dans le runtime de requête total pour les requêtes TPC-DS utilisant les mêmes spécifications matérielles. L’équipe Microsoft Spark a ajouté des optimisations disponibles dans Azure Synapse avec Azure HDInsight. Pour plus d’informations, consultez Accélérer vos charges de travail de données avec les mises à jour des performances d’Apache Spark 3.1.2 dans Azure Synapse

![]()

- Qatar Central

- Allemagne Nord

![]()

HDInsight est passé du JDK Java Azul Zulu 8 à

Adoptium Temurin JDK 8, qui prend en charge les runtimes certifiés TCK de haute qualité et la technologie associée pour une utilisation dans l’écosystème Java.HDInsight a migré vers

reload4j. Les modificationslog4js’appliquent à- Apache Hadoop

- Apache Zookeeper

- Apache Oozie

- Apache Ranger

- Apache Sqoop

- Apache Pig

- Apache Ambari

- Apache Kafka

- Apache Spark

- Apache Zeppelin

- Apache Livy

- Apache Rubix

- Apache Hive

- Apache Tez

- Apache HBase

- OMI

- Apache Pheonix

![]()

HDInsight doit implémenter TLS1.2 à l’avenir, et les versions antérieures sont mises à jour sur la plateforme. Si vous exécutez des applications sur HDInsight et qu’elles utilisent TLS 1.0 et 1.1, effectuez une mise à niveau vers TLS 1.2 pour éviter toute interruption des services.

Pour plus d’informations, consultez Guide pratique pour activer le protocole TLS (Transport Layer Security)

![]()

Fin de la prise en charge des clusters Azure HDInsight sur Ubuntu 16.04 LTS à partir du 30 novembre 2022. HDInsight commence à publier des images de cluster à l’aide d’Ubuntu 18.04 à compter du 27 juin 2021. Nous recommandons à nos clients qui exécutent des clusters à l’aide d’Ubuntu 16.04 de reconstruire leurs clusters avec les dernières images HDInsight d’ici le 30 novembre 2022.

Pour plus d’informations sur la vérification de la version Ubuntu du cluster, consultez ici

Exécutez la commande « lsb_release -a » dans le terminal.

Si la valeur de la propriété « Description » dans la sortie est « Ubuntu 16.04 LTS », cette mise à jour s’applique au cluster.

![]()

- Prise en charge de la sélection Zones de disponibilité pour les clusters Kafka et HBase (accès en écriture).

Correctifs de bogues open source

Correctifs de bogues pour Hive

| Correctifs de bogues | Apache JIRA |

|---|---|

| HIVE-26127 | Erreur INSERT OVERWRITE - Fichier introuvable |

| HIVE-24957 | Résultats incorrects lorsque la sous-requête a COALESCE dans le prédicat de corrélation |

| HIVE-24999 | HiveSubQueryRemoveRule génère un plan non valide pour la sous-requête IN avec plusieurs corrélations |

| HIVE-24322 | S’il existe une insertion directe, l’ID de tentative doit être vérifié lors de la lecture des manifestes échoue |

| HIVE-23363 | Mettre à niveau la dépendance DataNucleus vers la version 5.2 |

| HIVE-26412 | Créer une interface pour extraire les emplacements disponibles et ajouter la valeur par défaut |

| HIVE-26173 | Mettre à niveau derby vers 10.14.2.0 |

| HIVE-25920 | Placez Xerce2 à 2.12.2. |

| HIVE-26300 | Mettre à niveau la version de liaison de données Jackson vers la version 2.12.6.1+ pour éviter CVE-2020-36518 |

Date de publication : 10/08/2022

Cette version s’applique à HDInsight 4.0. La version HDInsight est mise à disposition dans toutes les régions sur plusieurs jours.

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

![]()

Nouvelle fonctionnalité

1. Attacher des disques externes dans des clusters Hadoop/Spark HDI

Un cluster HDInsight est fourni avec un espace disque prédéfini basé sur une référence SKU. Cet espace peut ne pas suffire dans des scénarios de travail volumineux.

Cette nouvelle fonctionnalité vous permet d’ajouter des disques dans un cluster utilisé comme répertoire local du gestionnaire de nœuds. Ajoutez des disques aux nœuds Worker pendant la création de clusters HIVE et Spark, alors que les disques sélectionnés font partie des répertoires locaux du gestionnaire de nœuds.

Notes

Les disques ajoutés sont configurés uniquement pour les répertoires locaux du gestionnaire de nœuds.

Vous trouverez plus d’informations ici.

2. Analyse de journalisation sélective

L’analyse de journalisation sélective est désormais disponible dans toutes les régions pour la préversion publique. Vous pouvez connecter votre cluster à un espace de travail Log Analytics. Une fois l’analyse activée, vous pouvez voir les journaux et métriques tels que les journaux de sécurité HDInsight, Yarn Resource Manager, les métriques système, etc. Vous pouvez surveiller les charges de travail et voir comment elles affectent la stabilité du cluster. La journalisation sélective vous permet d’activer/désactiver toutes les tables ou d’activer des tables sélectives dans l’espace de travail Log Analytics. Vous pouvez ajuster le type de source pour chaque table car, dans la nouvelle version de Geneva Monitoring, une table a plusieurs sources.

- Le système Geneva Monitoring utilise mdsd (démon MDS) qui est un agent de surveillance, et fluentd pour collecter des journaux à l’aide de la couche de journalisation unifiée.

- La journalisation sélective utilise une action de script pour activer/désactiver des tables et leurs types de journaux. Étant donné qu’elle n’ouvre aucun nouveau port et ne modifie aucun paramètre de sécurité existant, il n’y a aucune modification de sécurité.

- L’action de script s’exécute en parallèle sur tous les nœuds spécifiés, et modifie les fichiers de configuration pour activer/désactiver des tables et leurs types de journaux.

Vous trouverez plus d’informations ici.

![]()

Fixe

Analytique des journaux d'activité

Log Analytics intégré avec Azure HDInsight exécutant OMS version 13 nécessite une mise à niveau vers OMS version 14 pour appliquer les dernières mises à jour de sécurité. Les clients qui utilisent une version antérieure du cluster avec OMS version 13 doivent installer OMS version 14 pour répondre aux exigences de sécurité. (Comment vérifier la version actuelle et Installer 14)

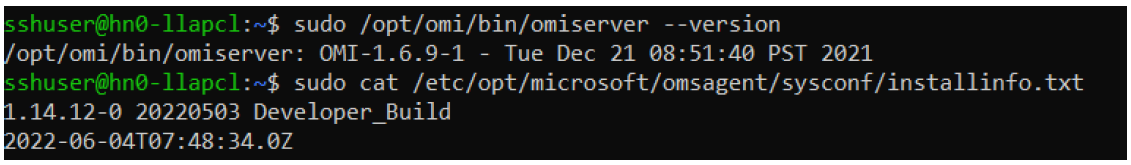

Comment vérifier votre version d’OMS actuelle

- Connectez-vous au cluster en utilisant SSH.

- Exécutez la commande suivante dans votre client SSH.

sudo /opt/omi/bin/ominiserver/ --version

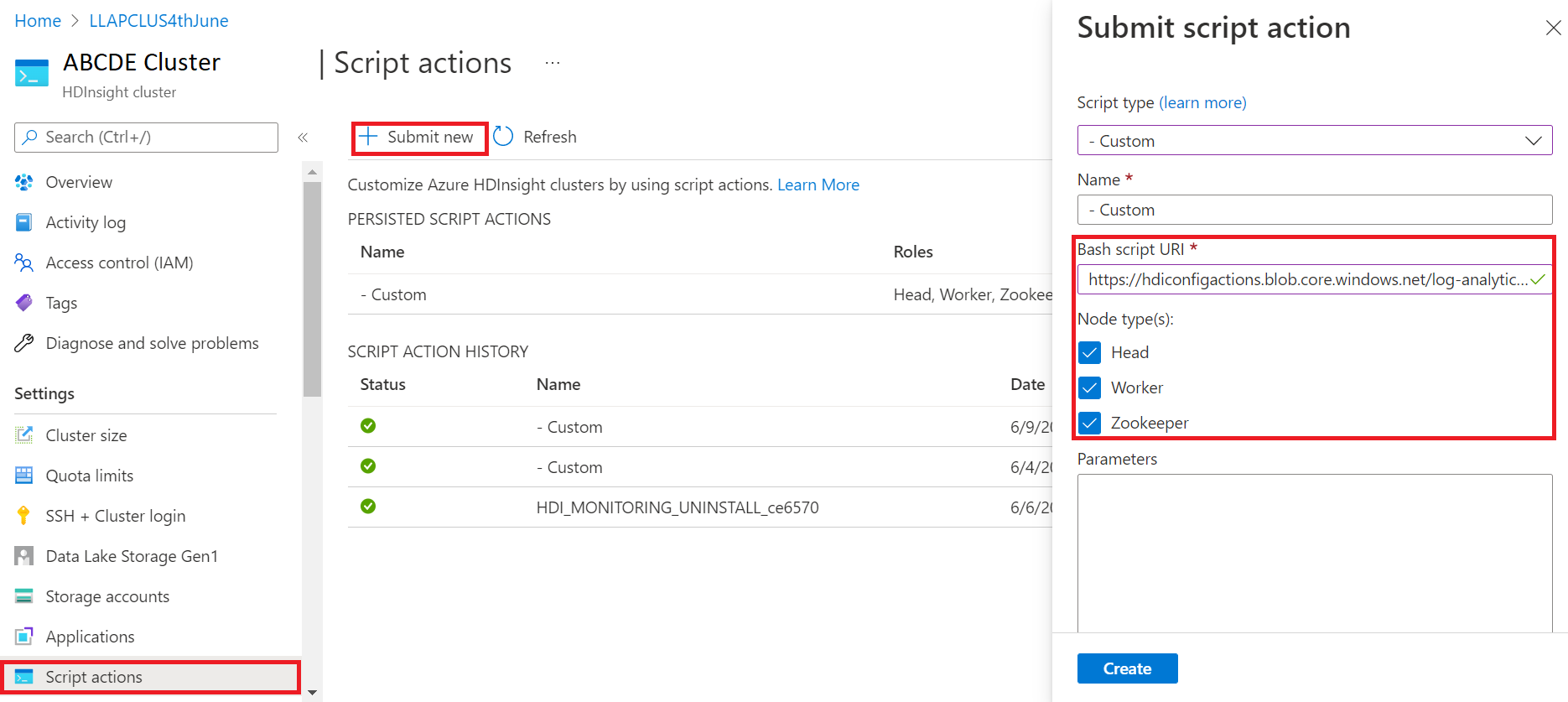

Comment mettre à niveau votre version d’OMS de 13 à 14

- Connectez-vous au portail Azure

- Dans le groupe de ressources, sélectionnez la ressource de cluster HDInsight

- Sélectionnez Actions de script

- Dans le panneau Envoyer une action de script, choisissez un Type de script personnalisé

- Collez le lien suivant dans la zone URL du script Bash https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Sélectionnez Type(s) de nœud

- Sélectionnez Créer

Vérifiez la réussite de l’installation du correctif en procédant comme suit :

Connectez-vous au cluster en utilisant SSH.

Exécutez la commande suivante dans votre client SSH.

sudo /opt/omi/bin/ominiserver/ --version

Autres correctifs de bogues

- L’interface CLI du journal Yarn ne pouvait pas récupérer les journaux si un fichier

TFileétait endommagé ou vide. - Résolution de l’erreur de détails du principal de service non valide lors de l’obtention du jeton OAuth à partir d’Azure Active Directory.

- Amélioration de la fiabilité de la création de cluster lorsque plus de 100 nœuds worker sont configurés.

Correctifs de bogues open source

Résolution des bogues TEZ

| Correctifs de bogues | Apache JIRA |

|---|---|

| Échec de build Tez : FileSaver.js introuvable | TEZ-4411 |

Exception de FS incorrecte quand l’entrepôt et scratchdir se trouvent sur des FS différentes |

TEZ-4406 |

| TezUtils.createConfFromByteString sur une configuration supérieure à 32 Mo lève l’exception com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils createByteStringFromConf devrait utiliser snappy au lieu de DeflaterOutputStream | TEZ-4113 |

| Mise à jour de la dépendance protobuf vers 3.x | TEZ-4363 |

Correctifs de bogues pour Hive

| Correctifs de bogues | Apache JIRA |

|---|---|

| Optimisations des performances de génération de fractionnement ORC | HIVE-21457 |

| Éviter de lire la table comme ACID quand son nom commence par « delta », mais que la table n’est pas transactionnelle et qu’une stratégie de fractionnement BI est utilisée | HIVE-22582 |

| Suppression d’un appel FS#exists d’AcidUtils#getLogicalLength | HIVE-23533 |

| Vectorisation d’OrcAcidRowBatchReader.computeOffset et optimisation du compartiment | HIVE-17917 |

Problèmes connus

HDInsight est compatible avec Apache HIVE 3.1.2. En raison d’un bogue dans cette version, la version de Hive affichée est 3.1.0 dans les interfaces de Hive. Toutefois, cela n’a aucun impact sur les fonctionnalités.

Date de publication : 10/08/2022

Cette version s’applique à HDInsight 4.0. La version HDInsight est mise à disposition dans toutes les régions sur plusieurs jours.

HDInsight applique des pratiques de déploiement sécurisé qui impliquent un déploiement graduel des régions. La mise à disposition d’une nouvelle version dans toutes les régions peut durer jusqu’à 10 jours ouvrés.

![]()

Nouvelle fonctionnalité

1. Attacher des disques externes dans des clusters Hadoop/Spark HDI

Un cluster HDInsight est fourni avec un espace disque prédéfini basé sur une référence SKU. Cet espace peut ne pas suffire dans des scénarios de travail volumineux.

Cette nouvelle fonctionnalité vous permet d’ajouter des disques dans le cluster, qui seront utilisés comme répertoire local du gestionnaire de nœuds. Ajoutez des disques aux nœuds Worker pendant la création de clusters HIVE et Spark, alors que les disques sélectionnés font partie des répertoires locaux du gestionnaire de nœuds.

Notes

Les disques ajoutés sont configurés uniquement pour les répertoires locaux du gestionnaire de nœuds.

Vous trouverez plus d’informations ici.

2. Analyse de journalisation sélective

L’analyse de journalisation sélective est désormais disponible dans toutes les régions pour la préversion publique. Vous pouvez connecter votre cluster à un espace de travail Log Analytics. Une fois l’analyse activée, vous pouvez voir les journaux et métriques tels que les journaux de sécurité HDInsight, Yarn Resource Manager, les métriques système, etc. Vous pouvez surveiller les charges de travail et voir comment elles affectent la stabilité du cluster. La journalisation sélective vous permet d’activer/désactiver toutes les tables ou d’activer des tables sélectives dans l’espace de travail Log Analytics. Vous pouvez ajuster le type de source pour chaque table car, dans la nouvelle version de Geneva Monitoring, une table a plusieurs sources.

- Le système Geneva Monitoring utilise mdsd (démon MDS) qui est un agent de surveillance, et fluentd pour collecter des journaux à l’aide de la couche de journalisation unifiée.

- La journalisation sélective utilise une action de script pour activer/désactiver des tables et leurs types de journaux. Étant donné qu’elle n’ouvre aucun nouveau port et ne modifie aucun paramètre de sécurité existant, il n’y a aucune modification de sécurité.

- L’action de script s’exécute en parallèle sur tous les nœuds spécifiés, et modifie les fichiers de configuration pour activer/désactiver des tables et leurs types de journaux.

Vous trouverez plus d’informations ici.

![]()

Fixe

Analytique des journaux d'activité

Log Analytics intégré avec Azure HDInsight exécutant OMS version 13 nécessite une mise à niveau vers OMS version 14 pour appliquer les dernières mises à jour de sécurité. Les clients qui utilisent une version antérieure du cluster avec OMS version 13 doivent installer OMS version 14 pour répondre aux exigences de sécurité. (Comment vérifier la version actuelle et Installer 14)

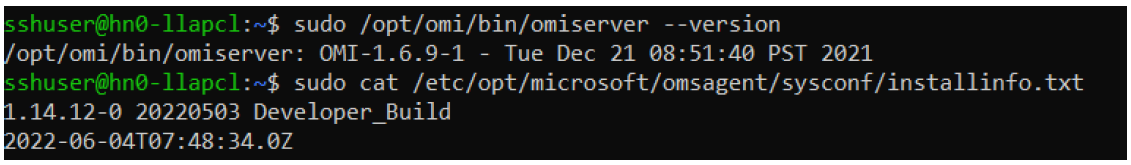

Comment vérifier votre version d’OMS actuelle

- Connectez-vous au cluster en utilisant le protocole SSH.

- Exécutez la commande suivante dans votre client SSH.

sudo /opt/omi/bin/ominiserver/ --version

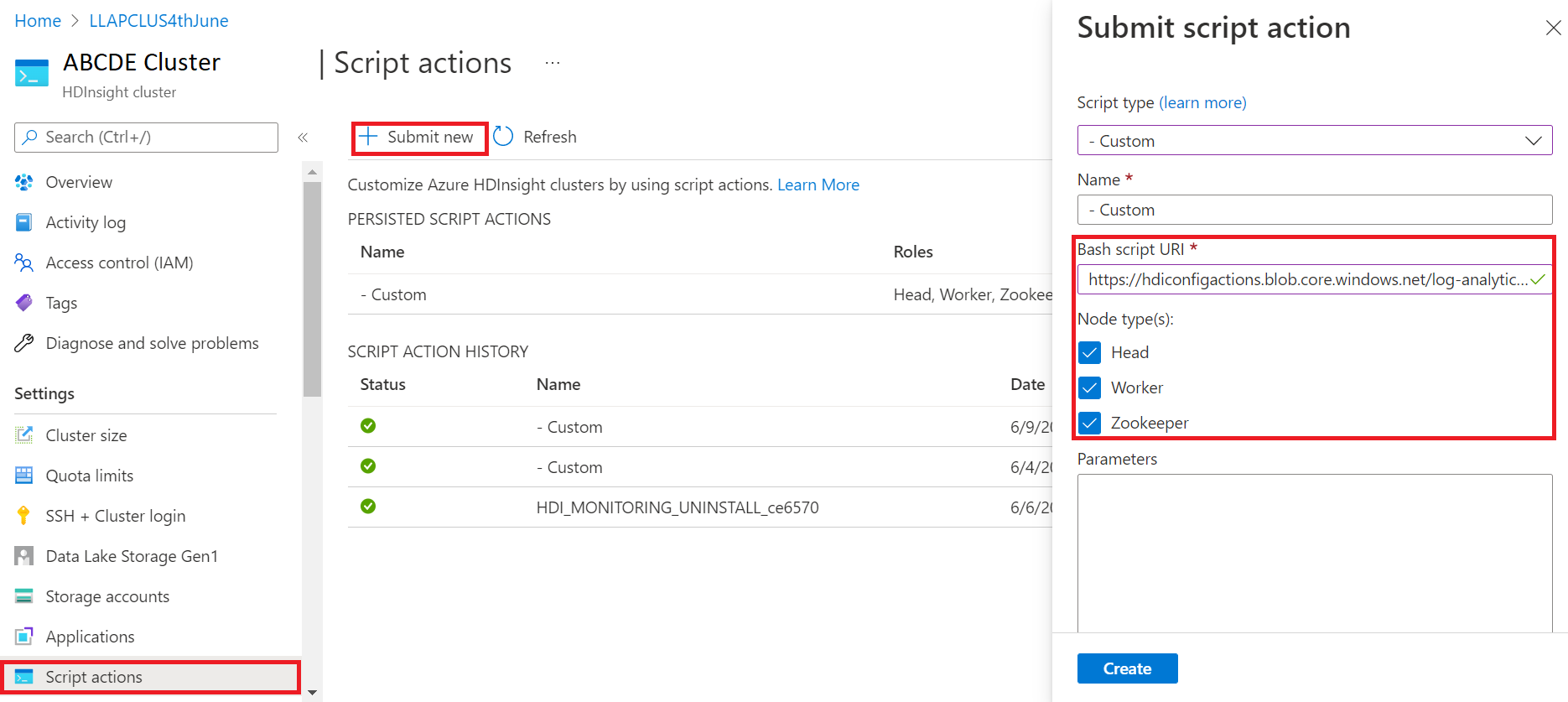

Comment mettre à niveau votre version d’OMS de 13 à 14

- Connectez-vous au portail Azure

- Dans le groupe de ressources, sélectionnez la ressource de cluster HDInsight

- Sélectionnez Actions de script

- Dans le panneau Envoyer une action de script, choisissez un Type de script personnalisé

- Collez le lien suivant dans la zone URL du script Bash https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Sélectionnez Type(s) de nœud

- Sélectionnez Créer

Vérifiez la réussite de l’installation du correctif en procédant comme suit :

Connectez-vous au cluster en utilisant SSH.

Exécutez la commande suivante dans votre client SSH.

sudo /opt/omi/bin/ominiserver/ --version

Autres correctifs de bogues

- L’interface CLI du journal Yarn ne pouvait pas récupérer les journaux si un fichier

TFileétait endommagé ou vide. - Résolution de l’erreur de détails du principal de service non valide lors de l’obtention du jeton OAuth à partir d’Azure Active Directory.

- Amélioration de la fiabilité de la création de cluster lorsque plus de 100 nœuds worker sont configurés.

Correctifs de bogues open source

Résolution des bogues TEZ

| Correctifs de bogues | Apache JIRA |

|---|---|

| Échec de build Tez : FileSaver.js introuvable | TEZ-4411 |

Exception de FS incorrecte quand l’entrepôt et scratchdir se trouvent sur des FS différentes |

TEZ-4406 |

| TezUtils.createConfFromByteString sur une configuration supérieure à 32 Mo lève l’exception com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils createByteStringFromConf devrait utiliser snappy au lieu de DeflaterOutputStream | TEZ-4113 |

| Mise à jour de la dépendance protobuf vers 3.x | TEZ-4363 |

Correctifs de bogues pour Hive

| Correctifs de bogues | Apache JIRA |

|---|---|

| Optimisations des performances de génération de fractionnement ORC | HIVE-21457 |

| Éviter de lire la table comme ACID quand son nom commence par « delta », mais que la table n’est pas transactionnelle et qu’une stratégie de fractionnement BI est utilisée | HIVE-22582 |

| Suppression d’un appel FS#exists d’AcidUtils#getLogicalLength | HIVE-23533 |

| Vectorisation d’OrcAcidRowBatchReader.computeOffset et optimisation du compartiment | HIVE-17917 |

Problèmes connus

HDInsight est compatible avec Apache HIVE 3.1.2. En raison d’un bogue dans cette version, la version de Hive affichée est 3.1.0 dans les interfaces de Hive. Toutefois, cela n’a aucun impact sur les fonctionnalités.

Date de publication : 03/06/2022

Cette version s’applique à HDInsight 4.0. La version HDInsight est mise à disposition dans toutes les régions sur plusieurs jours. La date de publication mentionnée ici indique la date de publication dans la première région. Si vous ne voyez pas les changements suivants, attendez quelques jours que la version soit active dans votre région.

Présentation de la nouvelle version

Hive Warehouse Connector (HWC) sur Spark v3.1.2

Le connecteur d’entrepôt Hive (HWC) vous permet de profiter des fonctionnalités uniques de Hive et de Spark afin de créer de puissantes applications Big Data. HWC est actuellement pris en charge pour Spark v2.4 uniquement. Cette fonctionnalité ajoute une valeur métier en autorisant les transactions ACID sur les tables Hive à l’aide de Spark. Cette fonctionnalité est utile pour les clients qui utilisent Hive et Spark dans leur patrimoine de données. Pour plus d’informations, consultez Apache Spark et Hive – Hive Warehouse Connector – Azure HDInsight | Microsoft Docs

Ambari

- Modifications apportées à la mise à l’échelle et à l’approvisionnement

- HDI Hive est désormais compatible avec OSS version 3.1.2

La version HDI Hive 3.1 est mise à niveau vers OSS Hive 3.1.2. Cette version comporte l’ensemble des correctifs et fonctionnalités disponibles dans la version open source Hive 3.1.2.

Notes

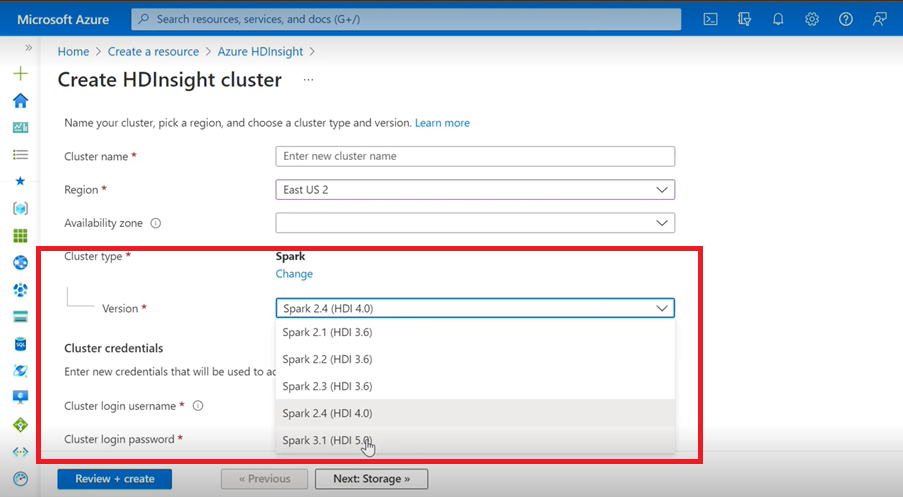

Spark

- Si vous utilisez l’interface utilisateur Azure pour créer un cluster Spark pour HDInsight, vous verrez dans la liste déroulante une autre version de Spark 3.1 (HDI 5.0) avec les versions antérieures. Cette version est une version renommée de Spark 3.1 (HDI 4.0). Il s’agit uniquement d’une modification au niveau de l’interface utilisateur, qui n’a aucun impact sur les utilisateurs existants et ceux qui utilisent déjà le modèle ARM.

Notes

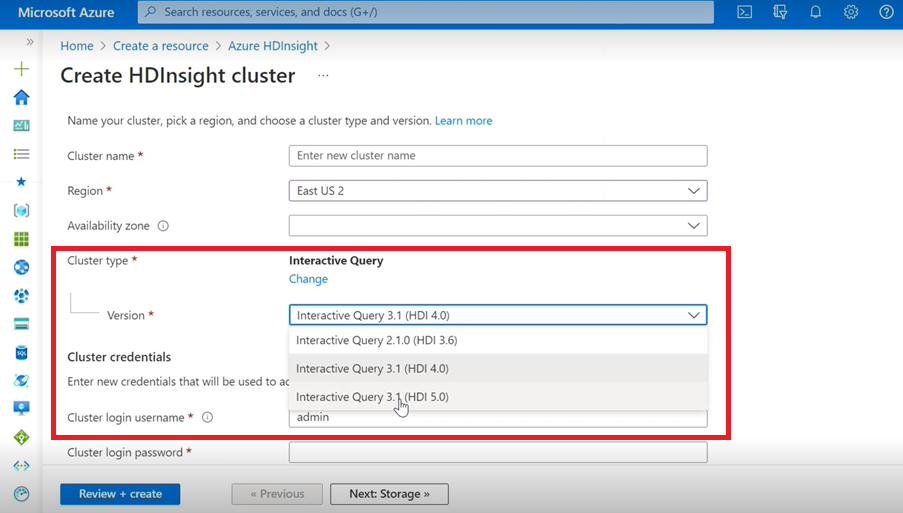

Interactive Query

- Si vous créez un cluster Interactive Query, vous verrez dans la liste déroulante une autre version, Interactive Query 3.1 (HDI 5.0).

- Si vous comptez utiliser la version Spark 3.1 avec Hive, qui nécessite la prise en charge d’ACID, vous devez sélectionner cette version, Interactive Query 3.1 (HDI 5.0).

Résolution des bogues TEZ

| Correctifs de bogues | Apache JIRA |

|---|---|

| TezUtils.createConfFromByteString sur une configuration supérieure à 32 Mo lève l’exception com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils createByteStringFromConf doit utiliser snappy au lieu de DeflaterOutputStream | TEZ-4113 |

Correctifs de bogues pour HBase

| Correctifs de bogues | Apache JIRA |

|---|---|

TableSnapshotInputFormat doit utiliser ReadType.STREAM pour analyser les fichiers HFiles |

HBASE-26273 |

| Ajout d’une option pour désactiver scanMetrics dans TableSnapshotInputFormat | HBASE-26330 |

| Correctif pour ArrayIndexOutOfBoundsException lorsque l’équilibreur est exécuté | HBASE-22739 |

Correctifs de bogues pour Hive

| Correctifs de bogues | Apache JIRA |

|---|---|

| NPE lors de l’insertion de données avec la clause ’distribute by’ avec optimisation du tri dynpart | HIVE-18284 |

| La commande MSCK REPAIR avec filtrage de partition échoue lors de la suppression de partitions | HIVE-23851 |

| Exception incorrecte levée si capacity<=0 | HIVE-25446 |

| Prise en charge de la charge parallèle pour HastTables - Interfaces | HIVE-25583 |

| Inclusion de MultiDelimitSerDe dans HiveServer2 par défaut | HIVE-20619 |

| Suppression des classes glassfish.jersey et mssql-jdbc de jdbc-standalone jar | HIVE-22134 |

| Exception de pointeur Null lors de l’exécution du compactage sur une table MM. | HIVE-21280 |

Les requêtes Hive de grande taille par le biais de knox échouent avec Canal cassé - échec de l’écriture |

HIVE-22231 |

| Ajout de la possibilité pour l’utilisateur de définir un utilisateur de liaison | HIVE-21009 |

| Implémentation d’UDF pour interpréter la date/le timestamp à l’aide de sa représentation interne et de son calendrier hybride grégorien-julien | HIVE-22241 |

| Option Beeline pour afficher/ne pas afficher le rapport d’exécution | HIVE-22204 |

| Tez : SplitGenerator tente de rechercher des fichiers de plan, qui n’existent pas pour Tez | HIVE-22169 |

Suppression de la journalisation coûteuse du cache LLAP hotpath |

HIVE-22168 |

| UDF : FunctionRegistry synchronise la classe org.apache.hadoop.hive.ql.udf.UDFType | HIVE-22161 |

| Empêchement de la création d’un ajout de routage de requête si la propriété a la valeur false | HIVE-22115 |

| Suppression de la synchronisation entre requêtes pour l’évaluation de partition | HIVE-22106 |

| Configuration du répertoire de base de Hive ignorée lors de la planification | HIVE-21182 |

| Création d’un répertoire de base pour Tez ignorée si RPC est activé | HIVE-21171 |

Basculement des UDF Hive pour utiliser le moteur regex Re2J |

HIVE-19661 |

| Les tables en cluster migrées utilisant bucketing_version 1 sur hive 3 utilisent bucketing_version 2 pour les insertions | HIVE-22429 |

| Compartimentage : la version 1 du compartimentage partitionnait incorrectement les données | HIVE-21167 |

| Ajout de l’en-tête de licence ASF au fichier nouvellement ajouté | HIVE-22498 |

| Améliorations apportées à l’outil de schéma pour prendre en charge mergeCatalog | HIVE-22498 |

| Hive avec TEZ UNION ALL et UDTF cause une perte de données | HIVE-21915 |

| Fractionner des fichiers texte même si l’en-tête/pied de page existe | HIVE-21924 |

| MultiDelimitSerDe retourne des résultats incorrects dans la dernière colonne quand le fichier chargé contient plus de colonnes que le schéma de table | HIVE-22360 |

| Client externe LLAP - Besoin de réduire l’empreinte LlapBaseInputFormat#getSplits() | HIVE-22221 |

| Le nom de colonne avec mot clé réservé n’est pas bouclé lorsque la requête incluant la jointure sur la table avec la colonne masque est réécrite (Zoltan Matyus via Zoltan Haindrich) | HIVE-22208 |

Empêchement du RuntimeException lié à l’arrêt de LLAP sur AMReporter |

HIVE-22113 |

| Le pilote du service d’état LLAP peut être bloqué avec un ID d’application Yarn incorrect | HIVE-21866 |

| OperationManager.queryIdOperation ne nettoie pas correctement plusieurs queryIds | HIVE-22275 |

| L’arrêt d’un gestionnaire de nœuds bloque le redémarrage du service LLAP | HIVE-22219 |

| Stack OverflowError lors de la suppression d’un grand nombre de partitions | HIVE-15956 |

| Échec de la vérification d’accès lorsqu’un répertoire temporaire est supprimé | HIVE-22273 |

| Correction des mauvais résultats/de l’exception ArrayOutOfBound dans les jointures de mappage externe gauche sur des conditions de limites spécifiques | HIVE-22120 |

| Suppression de la balise de gestion de distribution de pom.xml | HIVE-19667 |

| Le temps d’analyse peut être élevé s’il existe des sous-requêtes profondément imbriquées | HIVE-21980 |

Pour ALTER TABLE t SET TBLPROPERTIES (’EXTERNAL’=’TRUE’); TBL_TYPE modifications d’attribut ne se reflétant pas pour les non-majuscules |

HIVE-20057 |

JDBC : HiveConnection nuance les interfaces log4j |

HIVE-18874 |

Mise à jour des URL de référentiel dans poms - branch version 3.1 |

HIVE-21786 |

Tests DBInstall rompus sur les versions master et branch-3.1 |

HIVE-21758 |

| Le chargement des données dans une table compartimentée ignore les spécifications des partitions et charge les données dans une partition par défaut | HIVE-21564 |

| Requêtes avec condition de jointure ayant un timestamp ou un timestamp avec un littéral de fuseau horaire local lèvent une SemanticException | HIVE-21613 |

| L’analyse les statistiques de calcul pour la colonne laissent le répertoire intermédiaire sur HDFS | HIVE-21342 |

| Modification incompatible dans le calcul de compartiment Hive | HIVE-21376 |

| Fourniture d’un autoriseur de secours lorsqu’aucun autre autoriseur n’est utilisé | HIVE-20420 |

| Certains appels à alterPartitions lèvent une exception « NumberFormatException: null » | HIVE-18767 |

| HiveServer2 : Le sujet préauthentifié pour le transport http n’est pas conservé pendant toute la durée de la communication http dans certains cas | HIVE-20555 |

Date de publication : 10/03/2022

Cette version s’applique à HDInsight 4.0. La version HDInsight est mise à disposition dans toutes les régions sur plusieurs jours. La date de publication mentionnée ici indique la date de publication dans la première région. Si vous ne voyez pas les changements suivants, attendez quelques jours que la version soit active dans votre région.

Les versions de système d’exploitation pour cette mise en production sont les suivantes :

- HDInsight 4.0 : Ubuntu 18.04.5

Spark 3.1 est désormais généralement disponible

Spark 3.1 est désormais généralement disponible sur la version HDInsight 4.0. Cette version inclut

- Exécution de requête adaptative,

- Conversion de jointure par tri-fusion en jointure par hachage-diffusion,

- Optimiseur Catalyst Spark,

- Nettoyage de partition dynamique,

- Les clients seront en mesure de créer des clusters Spark 3.1, non des clusters Spark 3.0 (préversion).

Pour plus d’informations, consultez Apache Spark 3.1 est désormais généralement disponible sur HDInsight - Communauté Microsoft Tech.

Pour obtenir la liste complète des améliorations, consultez les Notes de publication d’Apache Spark 3.1.

Pour plus d’informations sur la migration, consultez le guide de migration.

Kafka 2.4 est désormais généralement disponible

Kafka 2.4.1 est désormais généralement disponible. Pour plus d’informations, consultez les Notes de publication de Kafka 2.4.1. Parmi les autres fonctionnalités, citons la disponibilité de MirrorMaker 2, une nouvelle partition de rubrique AtMinIsr de catégorie de métrique, un temps de démarrage de répartiteur amélioré par mmap différé à la demande de fichiers d’index, davantage de métriques de consommateur pour observer le comportement d’interrogation des utilisateurs.

Le type de données de mappage dans HWC est désormais pris en charge dans HDInsight 4.0

Cette version inclut la prise en charge du type de données de mappage pour HWC 1.0 (Spark 2.4) via l’application spark-Shell, et tous les autres clients Spark pris en charge par HWC. Les améliorations suivantes sont incluses comme d’autres types de données :

Un utilisateur peut

- Créer une table Hive avec une ou plusieurs colonnes contenant un type de données de mappage, insérer des données dans celle-ci et lire les résultats à partir de celle-ci.

- Créer une tramedonnées Apache Spark avec le type de mappage et effectuer des lectures et écritures de lot/flux.

Nouvelles régions

HDInsight a désormais étendu sa présence géographique à deux nouvelles régions : Chine Est 3 et Chine Nord 3.

Modifications du rétroportage OSS

Rétroportages OSS inclus dans Hive, y compris HWC 1.0 (Spark 2.4), qui prend en charge le type de données de mappage.

Voici les JIRA Apache rétroportés OSS pour cette version :

| Fonctionnalité affectée | Apache JIRA |

|---|---|

| Les requêtes SQL directes de metastore avec IN/(NOT in) doivent être fractionnées en fonction des paramètres maximaux autorisés par SQL DB | HIVE-25659 |

Mise à niveau de log4j 2.16.0 vers 2.17.0 |

HIVE-25825 |

Mise à jour de la version Flatbuffer |

HIVE-22827 |

| Prise en charge du type de données de mappage en mode natif au format Arrow | HIVE-25553 |

| Client externe LLAP - Gestion des valeurs imbriquées quand le struct parent est null | HIVE-25243 |