Protección de cumplimiento y seguridad de datos de Microsoft Purview para aplicaciones de IA generativa

Guía de licencias de Microsoft 365 para el cumplimiento de la seguridad &

Use Microsoft Purview para mitigar y administrar los riesgos asociados con el uso de inteligencia artificial e implementar los controles de protección y gobernanza correspondientes.

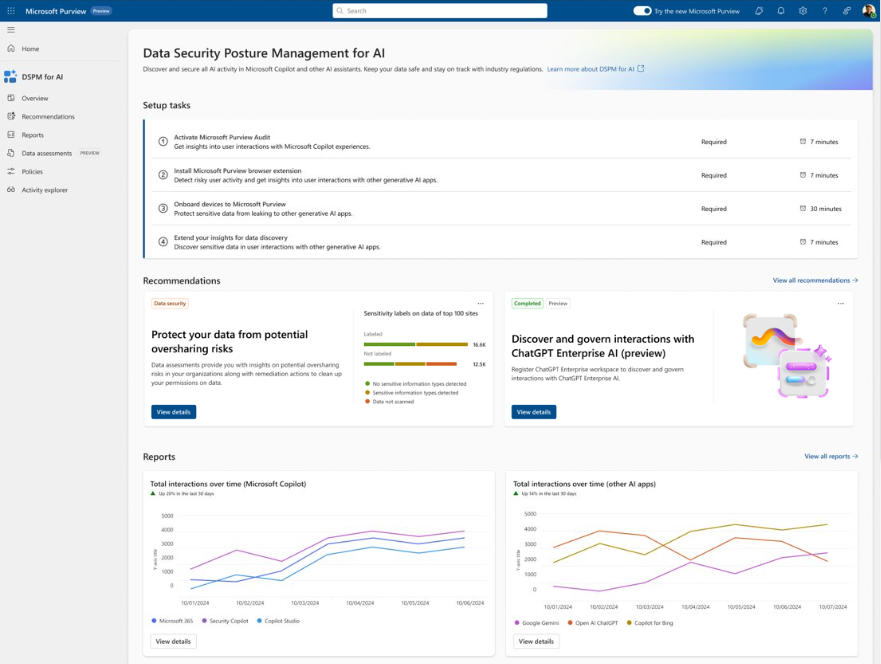

Administración de postura de seguridad de datos de Microsoft Purview (DSPM) para la inteligencia artificial proporciona herramientas gráficas e informes fáciles de usar para obtener rápidamente información sobre el uso de la inteligencia artificial dentro de su organización. Las directivas de un solo clic le ayudan a proteger los datos y a cumplir los requisitos normativos.

Use Administración de postura de seguridad de datos para IA junto con otras funcionalidades de Microsoft Purview para reforzar la seguridad y el cumplimiento de los datos para Microsoft 365 Copilot y Microsoft 365 Copilot Chat:

- Etiquetas de confidencialidad y contenido cifrados por Microsoft Purview Information Protection

- Clasificación de datos

- Clave de cliente

- Cumplimiento de las comunicaciones

- Auditoría

- Búsqueda de contenido

- Exhibición de documentos electrónicos (eDiscovery)

- Retención y eliminación

- Caja de seguridad del cliente

Nota:

Para comprobar si los planes de licencias de su organización admiten estas funcionalidades, consulte el vínculo de guía de licencias en la parte superior de la página. Para obtener información sobre las licencias de Microsoft 365 Copilot, consulte la descripción del servicio para Microsoft 365 Copilot.

Use las secciones siguientes para obtener más información sobre Administración de postura de seguridad de datos para IA y las funcionalidades de Microsoft Purview que proporcionan controles de cumplimiento y seguridad de datos adicionales para acelerar la adopción por su organización de Microsoft 365 Copilot y otras aplicaciones de IA generativas. Si no está familiarizado con Microsoft Purview, puede que también le resulte útil una introducción al producto: Obtenga información sobre Microsoft Purview.

Para obtener más información general sobre los requisitos de seguridad y cumplimiento de Microsoft 365 Copilot, consulte Datos, privacidad y seguridad para Microsoft 365 Copilot. Para obtener Microsoft 365 Copilot Chat, consulte Privacidad y protecciones de Copilot.

Administración de postura de seguridad de datos para IA proporciona información, directivas y controles para aplicaciones de inteligencia artificial

Administración de postura de seguridad de datos de Microsoft Purview (DSPM) para la inteligencia artificial desde el portal de Microsoft Purview o el portal de cumplimiento Microsoft Purview proporciona una ubicación de administración central para ayudarle a proteger rápidamente los datos de las aplicaciones de inteligencia artificial y supervisar de forma proactiva el uso de la inteligencia artificial. Estas aplicaciones incluyen Microsoft 365 Copilot, otros copilotos de Microsoft y aplicaciones de inteligencia artificial de módulos de lenguaje grande (LLM) de terceros.

Administración de postura de seguridad de datos para IA ofrece un conjunto de funcionalidades para que pueda adoptar IA de forma segura sin tener que elegir entre productividad y protección:

Conclusiones y análisis de la actividad de inteligencia artificial en su organización

Directivas listas para usarse para proteger los datos y evitar la pérdida de datos en los avisos de inteligencia artificial

Evaluaciones de datos para identificar, corregir y supervisar el posible uso compartido excesivo de datos.

Controles de cumplimiento para aplicar directivas óptimas de control y almacenamiento de datos

Para obtener una lista de sitios de inteligencia artificial de terceros compatibles, como los que se usan para Géminis y ChatGPT, consulte Sitios de IA admitidos por Microsoft Purview para protección de cumplimiento y seguridad de datos.

Uso de Administración de postura de seguridad de datos para IA

Para ayudarle a obtener información más rápida sobre el uso de la inteligencia artificial y proteger los datos, Administración de postura de seguridad de datos para IA proporciona algunas directivas preconfiguradas recomendadas que puede activar con un solo clic. Espere al menos 24 horas para que estas nuevas directivas recopilen datos con el fin de mostrar los resultados en Administración de postura de seguridad de datos para IA o reflejar los cambios que realice en la configuración predeterminada.

Sin necesidad de activación y ahora en versión preliminar, Administración de postura de seguridad de datos para IA ejecuta automáticamente una evaluación de datos semanal para todos los sitios de SharePoint que usa Copilot. Puede complementar esto con sus propias evaluaciones de datos personalizadas. Estas evaluaciones están diseñadas específicamente para ayudarle a identificar, corregir y supervisar el posible uso compartido excesivo de datos, de modo que pueda estar más seguro de su organización mediante Microsoft 365 Copilot y Microsoft 365 Copilot Chat.

Para empezar a trabajar con Administración de postura de seguridad de datos para IA, use el portal de Microsoft Purview o es posible que todavía pueda usar la portal de cumplimiento Microsoft Purview anterior. Necesita una cuenta que tenga los permisos adecuados para la administración de cumplimiento, como una cuenta que sea miembro del rol de grupo administrador de cumplimiento de Microsoft Entra.

En función del portal que use, vaya a una de las siguientes ubicaciones:

Inicio de sesión en el portal> de Microsoft PurviewSoluciones>DSPM para la inteligencia artificial.

Inicie sesión en el portal de cumplimiento Microsoft Purview>DSPM para la inteligencia artificial.

En Información general, revise la sección Introducción para obtener más información sobre Administración de postura de seguridad de datos para IA y las acciones inmediatas que puede realizar. Seleccione cada una de ellas para mostrar el panel flotante para obtener más información, realizar acciones y comprobar el estado actual.

Acción Más información Activar Auditoría de Microsoft Purview La auditoría está activada de forma predeterminada para los nuevos inquilinos, por lo que es posible que ya cumpla este requisito previo. Si lo hace y los usuarios ya tienen licencias asignadas para Copilot, comienza a ver información sobre las actividades de Copilot en la sección Informes más abajo de la página. Instalación de la extensión del explorador Microsoft Purview Requisito previo para sitios de inteligencia artificial de terceros. Incorporación de dispositivos a Microsoft Purview También es un requisito previo para sitios de inteligencia artificial de terceros. Ampliación de la información para la detección de datos Directivas de un solo clic para recopilar información sobre los usuarios que visitan sitios de inteligencia artificial generativos de terceros y les envían información confidencial. La opción es la misma que el botón Extender la información de la sección Análisis de datos de inteligencia artificial más abajo en la página. Para obtener más información sobre los requisitos previos, consulte Requisitos previos para Administración de postura de seguridad de datos para IA.

Para obtener más información sobre las directivas preconfiguradas que puede activar, consulte Directivas de un solo clic de Administración de postura de seguridad de datos para IA.

A continuación, revise la sección Recomendaciones y decida si desea implementar las opciones que sean relevantes para el inquilino. Vea cada recomendación para comprender cómo son relevantes para los datos y obtener más información.

Estas opciones incluyen la ejecución de una evaluación de datos en sitios de SharePoint, la creación de etiquetas de confidencialidad y directivas para proteger los datos y la creación de algunas directivas predeterminadas para ayudarle a detectar y proteger de inmediato los datos confidenciales enviados a sitios de IA generativos. Ejemplos de recomendaciones:

- Proteja los datos de posibles riesgos de uso compartido excesivo mediante la visualización de los resultados de la evaluación de datos predeterminada para identificar y corregir problemas que le ayudarán a implementar Microsoft 365 Copilot con mayor confianza.

- Proteja los datos confidenciales a los que se hace referencia en Microsoft 365 Copilot mediante la creación de una directiva DLP que seleccione etiquetas de confidencialidad para evitar Microsoft 365 Copilot resumir los datos etiquetados. Para obtener más información, consulte Información sobre la ubicación de la directiva de Microsoft 365 Copilot.

- Detecte interacciones de riesgo en aplicaciones de inteligencia artificial para calcular el riesgo del usuario mediante la detección de mensajes y respuestas de riesgo en Microsoft 365 Copilot y otras aplicaciones de IA generativas. Para obtener más información, consulte Uso de inteligencia artificial de riesgo (versión preliminar).

- Detecte y controle las interacciones con ChatGPT Enterprise AI mediante el registro de ChatGPT áreas de trabajo de Enterprise, para identificar posibles riesgos de exposición a los datos mediante la detección de información confidencial compartida con ChatGPT Enterprise.

- Obtenga asistencia guiada a las regulaciones de inteligencia artificial, que usa plantillas de regulación de asignación de controles del Administrador de cumplimiento.

Puede usar el vínculo Ver todas las recomendaciones o Recomendaciones en el panel de navegación para ver todas las recomendaciones disponibles para el inquilino y su estado. Cuando se completa o descarta una recomendación, ya no la verá en la página Información general .

Use la sección Informes o la página Informes del panel de navegación para ver los resultados de las directivas predeterminadas creadas. Debe esperar al menos un día para que se rellenen los informes. Seleccione las categorías de Microsoft Copilot Experiences y las aplicaciones de inteligencia artificial empresarial para ayudarle a identificar la aplicación de inteligencia artificial generativa específica.

Nota:

Las ubicaciones de aplicaciones de Teams, Copilot e IA independientes se están implementando y es posible que aún no estén visibles en el inquilino de Purview en este momento.

Use la página Directivas para supervisar el estado de las directivas de un solo clic predeterminadas creadas y las directivas relacionadas con la inteligencia artificial de otras soluciones de Microsoft Purview. Para editar las directivas, use la solución de administración correspondiente en el portal. Por ejemplo, para DSPM para IA- Comportamiento no ético en Copilot, puede revisar y corregir las coincidencias de la solución de cumplimiento de comunicaciones.

Nota:

Si tiene las directivas de retención anteriores para los chats de Teams de ubicación y las interacciones de Copilot, no se incluyen en esta página. Obtenga información sobre cómo crear directivas de retención independientes para Microsoft Copilot Experiences o Enterprise AI Apps que se incluirán en esta página directiva.

Seleccione Explorador de actividad para ver los detalles de los datos recopilados de las directivas.

Esta información más detallada incluye el tipo de actividad y el usuario, la fecha y hora, la categoría y la aplicación de la aplicación de IA, la aplicación a la que se accede, los tipos de información confidencial, los archivos a los que se hace referencia y los archivos confidenciales a los que se hace referencia.

Algunos ejemplos de actividades son la interacción con la inteligencia artificial, los tipos de información confidencial y la visita al sitio web de IA. Las indicaciones y respuestas de Copilot se incluyen en los eventos de interacción de IA cuando se tienen las permisiones adecuadas. Para obtener más información sobre los eventos, vea Eventos del Explorador de actividad.

De forma similar a las categorías de informe, las cargas de trabajo incluyen Microsoft Copilot Experiences y aplicaciones de inteligencia artificial empresarial. Entre los ejemplos de un identificador de aplicación y un host de aplicación para Microsoft Copilot Experiences se incluyen Copilots de Microsoft 365 y Copilot Studio. Las aplicaciones de inteligencia artificial empresarial incluyen ChatGPT Enterprise.

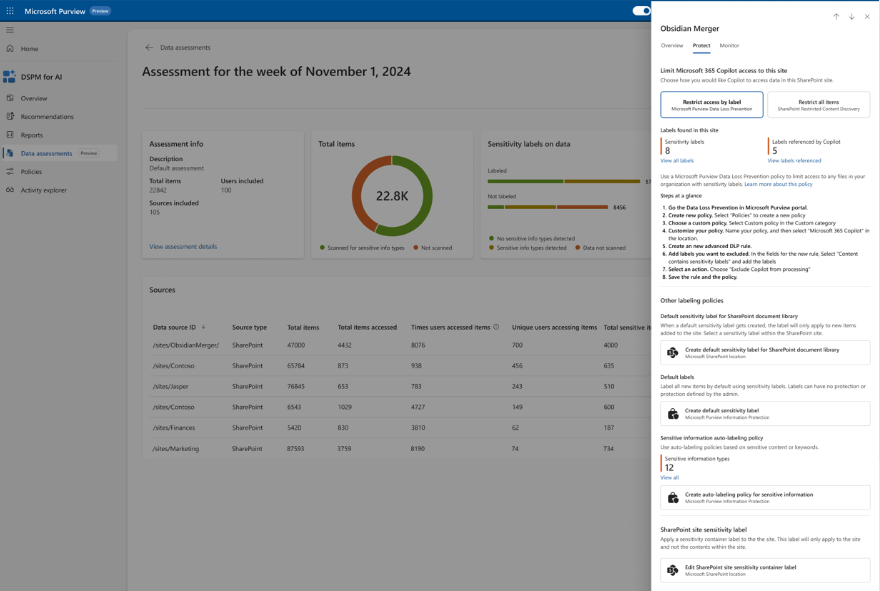

Seleccione Evaluaciones de datos (versión preliminar) para identificar y corregir posibles riesgos de uso compartido de datos en su organización. Una evaluación de datos predeterminada se ejecuta automáticamente semanalmente para todos los sitios de SharePoint usados por Copilot en su organización y es posible que ya haya ejecutado una evaluación personalizada como una de las recomendaciones. Sin embargo, vuelva periódicamente a esta opción para comprobar los resultados semanales más recientes de la evaluación predeterminada y ejecutar evaluaciones personalizadas cuando desee comprobar si hay distintos usuarios o sitios específicos. Una vez que se haya ejecutado una evaluación, espere al menos 48 horas para ver los resultados que no se actualizan de nuevo. Necesitará una nueva evaluación para ver los cambios en los resultados.

Debido a la potencia y velocidad de la inteligencia artificial puede exponer de forma proactiva contenido que podría estar obsoleto, con permisos excesivos o sin controles de gobernanza, la inteligencia artificial generativa amplifica el problema de compartir datos en exceso. Use las evaluaciones de datos para identificar y corregir problemas.

Para ver la evaluación de datos creada automáticamente para el inquilino, en la categoría Evaluaciones predeterminadas, seleccione Evaluación de uso compartido excesivo para la semana del <mes, año>, en la lista. En las columnas de cada sitio notificado, verá información como el número total de elementos encontrados, cuántos se ha accedido y con qué frecuencia, y cuántos tipos de información confidencial se encontraron y se accedió a ellos.

En la lista, seleccione cada sitio para acceder al panel flotante que tiene pestañas para Información general, Proteger y Supervisar. Use la información de cada pestaña para obtener más información y realizar las acciones recomendadas. Por ejemplo:

Use la pestaña Proteger para seleccionar opciones para corregir el uso compartido excesivo, entre las que se incluyen:

- Restringir el acceso por etiqueta: use Prevención de pérdida de datos de Microsoft Purview para crear una directiva DLP que impida que Microsoft 365 Copilot resuma los datos cuando tenga etiquetas de confidencialidad que seleccione. Para obtener más información sobre cómo funciona y los escenarios admitidos, consulte Información sobre la ubicación de la directiva de Microsoft 365 Copilot.

- Restringir todos los elementos: use La detección de contenido restringido de SharePoint para enumerar los sitios de SharePoint que se van a excluir de Microsoft 365 Copilot. Para obtener más información, vea Detección de contenido restringido para sitios de SharePoint.

- Crear una directiva de etiquetado automático: cuando se encuentra información confidencial para archivos sin etiquetar, use Microsoft Purview Information Protection para crear una directiva de etiquetado automático para aplicar automáticamente una etiqueta de confidencialidad para los datos confidenciales. Para obtener más información sobre cómo crear esta directiva, vea Configuración de directivas de etiquetado automático para SharePoint, OneDrive y Exchange.

- Crear directivas de retención: cuando no se haya accedido al contenido durante al menos 3 años, use Administración del ciclo de vida de Microsoft Purview para eliminarlo automáticamente. Para obtener más información sobre cómo crear la directiva de retención, consulte Creación y configuración de directivas de retención.

Use la pestaña Monitor para ver el número de elementos del sitio compartidos con cualquier persona, compartidos con todos los usuarios de la organización, compartidos con personas específicas y compartidos externamente. Seleccione Iniciar una revisión de acceso al sitio de SharePoint para obtener información sobre cómo usar los informes de gobernanza de acceso a datos de SharePoint.

Captura de pantalla de ejemplo, después de ejecutar una evaluación de datos, en la que se muestra la pestaña Proteger con las soluciones para los problemas encontrados:

Para crear su propia evaluación de datos personalizada, seleccione Crear evaluación para identificar posibles problemas de uso compartido excesivo para todos los usuarios o usuarios seleccionados, los orígenes de datos que se van a examinar (actualmente solo se admiten para SharePoint) y ejecute la evaluación.

Si selecciona todos los sitios, no es necesario que sea miembro de los sitios, pero debe ser miembro para seleccionar sitios específicos.

Esta evaluación de datos se crea en la categoría Evaluaciones personalizadas . Espere a que el estado de la evaluación muestre Examen completado y selecciónelo para ver los detalles. Para volver a ejecutar una evaluación de datos personalizada, use la opción duplicada para crear una nueva evaluación, empezando por las mismas selecciones.

Actualmente, las evaluaciones de datos admiten un máximo de 200 000 elementos por ubicación.

Para Microsoft 365 Copilot y Microsoft 365 Copilot Chat, use estas directivas, herramientas e información junto con protecciones y funcionalidades de cumplimiento adicionales de Microsoft Purview.

Microsoft Purview refuerza la protección de la información para Copilot

Microsoft 365 Copilot y Microsoft 365 Copilot Chat usar controles existentes para asegurarse de que los datos almacenados en el inquilino nunca se devuelven al usuario ni los usa un modelo de lenguaje grande (LLM) si el usuario no tiene acceso a esos datos. Cuando los datos tienen etiquetas de confidencialidad de su organización aplicadas al contenido, hay una capa adicional de protección:

Cuando un archivo está abierto en Word, Excel, PowerPoint o, de forma similar, un evento de correo electrónico o calendario está abierto en Outlook, la confidencialidad de los datos se muestra a los usuarios de la aplicación con el nombre de la etiqueta y las marcas de contenido (como el encabezado o el texto del pie de página) que se han configurado para la etiqueta. Loop componentes y páginas también admiten las mismas etiquetas de confidencialidad.

Cuando la etiqueta de confidencialidad aplica el cifrado, los usuarios deben tener el derecho de uso EXTRACT, así como VIEW, para que Copilot devuelva los datos.

Esta protección se extiende a los datos almacenados fuera de su inquilino de Microsoft 365 cuando está abierto en una aplicación de Office (datos en uso). Por ejemplo, almacenamiento local, recursos compartidos de red y almacenamiento en la nube.

Sugerencia

Si aún no lo ha hecho, se recomienda habilitar las etiquetas de confidencialidad para SharePoint y OneDrive y también familiarizarse con los tipos de archivo y las configuraciones de etiquetas que estos servicios pueden procesar. Cuando las etiquetas de confidencialidad no están habilitadas para estos servicios, los archivos cifrados a los que Copilot puede acceder se limitan a los datos que se usan desde aplicaciones de Office en Windows.

Para obtener instrucciones, vea Habilitar etiquetas de confidencialidad para archivos de Office en SharePoint y OneDrive.

Además, cuando se usa Microsoft 365 Copilot Chat (anteriormente conocidas como Chat empresarial, Chat basado en grafos y Microsoft 365 Chat) que pueden acceder a datos desde una amplia gama de contenido, la confidencialidad de los datos etiquetados devueltos por Copilot se hace visible para los usuarios con la etiqueta de confidencialidad mostrada para las citas y los elementos enumerados en la respuesta. Con el número de prioridad de las etiquetas de confidencialidad que se definen en el portal de Microsoft Purview o el portal de cumplimiento Microsoft Purview, la respuesta más reciente de Copilot muestra la etiqueta de confidencialidad de prioridad más alta de los datos usados para ese chat de Copilot.

Aunque los administradores de cumplimiento definen la prioridad de una etiqueta de confidencialidad, un número de prioridad más alto suele indicar una mayor confidencialidad del contenido, con permisos más restrictivos. Como resultado, las respuestas de Copilot se etiquetan con la etiqueta de confidencialidad más restrictiva.

Nota:

Si los elementos se cifran mediante Microsoft Purview Information Protection pero no tienen una etiqueta de confidencialidad, Microsoft 365 Copilot y Microsoft 365 Copilot Chat tampoco devolverán estos elementos a los usuarios si el cifrado no incluye el uso de EXTRACT o VIEW. derechos para el usuario.

Si aún no usa etiquetas de confidencialidad, consulte Introducción a las etiquetas de confidencialidad.

Aunque las directivas DLP no admiten la clasificación de datos para las interacciones de Copilot, los tipos de información confidencial y los clasificadores entrenables son compatibles con las directivas de cumplimiento de comunicaciones para identificar datos confidenciales en las solicitudes del usuario a Copilot y las respuestas.

Protección de Copilot con herencia de etiquetas de confidencialidad

Si usa Copilot para crear contenido nuevo basado en un elemento que tenga aplicada una etiqueta de confidencialidad, la etiqueta de confidencialidad del archivo de origen se hereda automáticamente, con la configuración de protección de la etiqueta.

Por ejemplo, un usuario selecciona Borrador con Copilot en Word y, a continuación, Hacer referencia a un archivo. O bien, un usuario selecciona Crear presentación a partir de un archivo en PowerPoint o Editar en páginas desde Microsoft 365 Copilot Chat. El contenido de origen tiene la etiqueta de confidencialidad Confidencial\Cualquiera (sin restricciones) aplicada y esa etiqueta está configurada para aplicar un pie de página que muestra "Confidencial". El nuevo contenido se etiqueta automáticamente Confidencial\Cualquiera (sin restricciones) con el mismo pie de página.

Para ver un ejemplo de esto en acción, watch la siguiente demostración de la sesión de Ignite 2023, "Getting your enterprise ready for Microsoft 365 Copilot". En la demostración se muestra cómo la etiqueta de confidencialidad predeterminada de General se reemplaza por una etiqueta confidencial cuando un usuario redacta con Copilot y hace referencia a un archivo etiquetado. La barra de información de la cinta de opciones informa al usuario de que el contenido creado por Copilot provocó que la nueva etiqueta se aplicara automáticamente:

Si se usan varios archivos para crear contenido nuevo, la etiqueta de confidencialidad con la prioridad más alta se usa para la herencia de etiquetas.

Al igual que con todos los escenarios de etiquetado automático, el usuario siempre puede invalidar y reemplazar una etiqueta heredada (o quitarla, si no usa el etiquetado obligatorio).

Protección de Microsoft Purview sin etiquetas de confidencialidad

Incluso si no se aplica una etiqueta de confidencialidad al contenido, los servicios y los productos podrían usar las funcionalidades de cifrado del servicio Azure Rights Management. Como resultado, Microsoft 365 Copilot y Microsoft 365 Copilot Chat todavía pueden comprobar los derechos de uso VIEW y EXTRACT antes de devolver datos y vínculos a un usuario, pero no hay herencia automática de protección para nuevos elementos.

Sugerencia

Obtendrá la mejor experiencia de usuario cuando use siempre etiquetas de confidencialidad para proteger los datos y una etiqueta aplique el cifrado.

Ejemplos de productos y servicios que pueden usar las funcionalidades de cifrado del servicio Azure Rights Management sin etiquetas de confidencialidad:

- Cifrado de mensajes de Microsoft Purview

- Microsoft Information Rights Management (IRM)

- Conector Microsoft Rights Management

- Microsoft Rights Management SDK

Para otros métodos de cifrado que no usan el servicio Azure Rights Management:

Copilot no devolverá los correos electrónicos protegidos con S/MIME y Copilot no está disponible en Outlook cuando se abre un correo electrónico protegido con S/MIME.

Copilot no puede acceder a los documentos protegidos con contraseña a menos que el usuario ya los haya abierto en la misma aplicación (datos en uso). Un elemento de destino no hereda las contraseñas.

Al igual que con otros servicios de Microsoft 365, como la exhibición de documentos electrónicos y la búsqueda, los elementos cifrados con la clave de cliente de Microsoft Purview o su propia clave raíz (BYOK) son compatibles y aptos para ser devueltos por Copilot.

Microsoft Purview admite la administración de cumplimiento para Copilot

Use las funcionalidades de cumplimiento de Microsoft Purview para admitir los requisitos de riesgo y cumplimiento de Microsoft 365 Copilot y Microsoft 365 Copilot Chat, y otras aplicaciones de IA generativas.

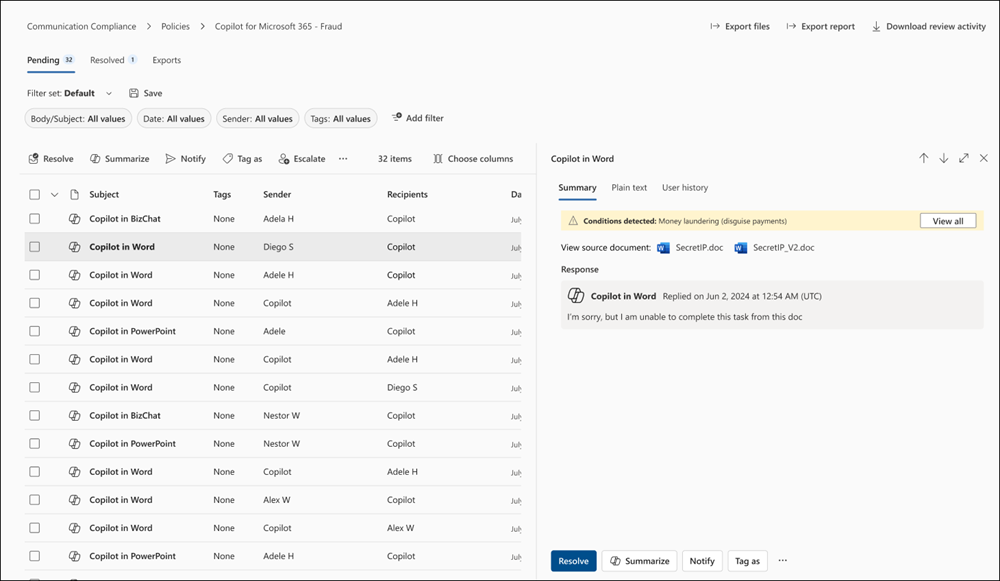

Las interacciones con Copilot se pueden supervisar para cada usuario del inquilino. Por lo tanto, puede usar la clasificación de Purview (tipos de información confidencial y clasificadores entrenables), la búsqueda de contenido, el cumplimiento de comunicaciones, la auditoría, la exhibición de documentos electrónicos y las funcionalidades de retención y eliminación automáticas mediante directivas de retención.

Para el cumplimiento de las comunicaciones, puede analizar las solicitudes del usuario y las respuestas de Copilot para detectar interacciones inapropiadas o de riesgo o el uso compartido de información confidencial. Para obtener más información, consulte Configuración de una directiva de cumplimiento de comunicaciones para detectar las interacciones de Copilot.

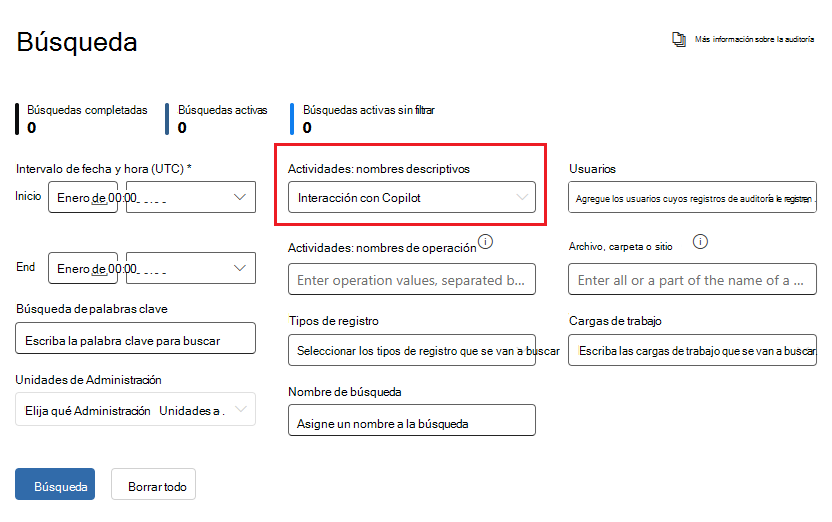

Para la auditoría, los detalles se capturan en el registro de auditoría unificado cuando los usuarios interactúan con Copilot. Los eventos incluyen cómo y cuándo interactúan los usuarios con Copilot, en el que se produjo el servicio de Microsoft 365, y las referencias a los archivos almacenados en Microsoft 365 a los que se accedió durante la interacción. Si estos archivos tienen una etiqueta de confidencialidad aplicada, también se captura. En la solución Auditar desde el portal de Microsoft Purview o el portal de cumplimiento Microsoft Purview, seleccione Actividades de Copilot e Interacted with Copilot (Interactuar con Copilot). También puede seleccionar Copilot como carga de trabajo.

Para la búsqueda de contenido, dado que el usuario solicita a Copilot y las respuestas de Copilot se almacenan en el buzón de un usuario, se pueden buscar y recuperar cuando se selecciona el buzón del usuario como origen de una consulta de búsqueda. Seleccione y recupere estos datos del buzón de origen; para ello, seleccione en el generador de consultas Agregar condición>Tipo>igual a cualquiera de> lasopciones Agregar o quitar más opciones>Interacciones de Copilot.

De forma similar para eDiscovery, se usa el mismo proceso de consulta para seleccionar buzones y recuperar las solicitudes de usuario a Copilot y las respuestas de Copilot. Una vez creada la colección y originada en la fase de revisión de eDiscovery (Premium), estos datos están disponibles para realizar todas las acciones de revisión existentes. Estas colecciones y conjuntos de revisión se pueden poner en espera o exportar. Si necesita eliminar estos datos, consulte Búsqueda y eliminación de datos para Copilot.

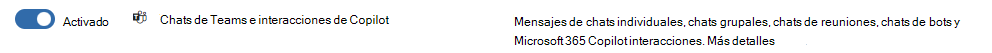

En el caso de las directivas de retención que admiten la retención y eliminación automáticas, Microsoft 365 Copilots identifica las solicitudes del usuario a Copilot y las respuestas de Copilot, incluidas en la ubicación de la directiva Microsoft Copilot Experiences. Anteriormente incluidas en una ubicación de directiva denominada Chats de Teams e interacción de Copilot, estas directivas de retención anteriores se reemplazan por ubicaciones independientes. Para obtener más información, consulte Separar una directiva existente de "Chats de Teams e interacciones de Copilot".

Para obtener información detallada sobre este trabajo de retención, consulte Información sobre la retención para las aplicaciones de Copilot & IA.

Al igual que con todas las directivas de retención y retenciones, si se aplica más de una directiva para la misma ubicación a un usuario, los principios de retención resuelven los conflictos. Por ejemplo, los datos se conservan durante el tiempo más largo de todas las directivas de retención aplicadas o las retenciones de eDiscovery.

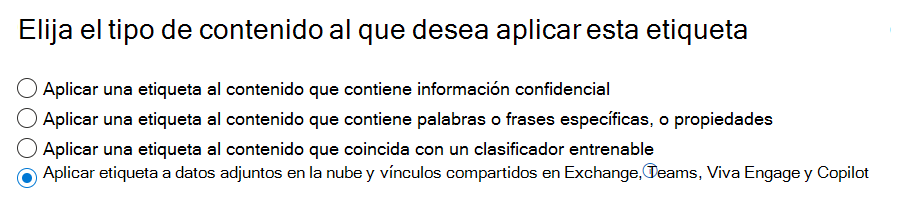

Para que las etiquetas de retención conserven automáticamente los archivos a los que se hace referencia en Copilot, seleccione la opción para los datos adjuntos en la nube con una directiva de etiqueta de retención de aplicación automática: Aplicar etiqueta a datos adjuntos en la nube y vínculos compartidos en Exchange, Teams, Viva Engage y Copilot. Al igual que con todos los datos adjuntos en la nube retenidos, se conserva la versión del archivo en el momento en que se hace referencia a él.

Para obtener información detallada sobre cómo funciona esta retención, consulte Funcionamiento de la retención con los datos adjuntos en la nube.

Para obtener instrucciones de configuración:

Para configurar las directivas de cumplimiento de comunicaciones para las interacciones de Copilot, consulte Creación y administración de directivas de cumplimiento de comunicaciones.

Para buscar interacciones de Copilot en el registro de auditoría, consulte Búsqueda en el registro de auditoría.

Para usar la búsqueda de contenido para buscar interacciones de Copilot, consulte Búsqueda de contenido.

Para usar eDiscovery para las interacciones de Copilot, consulte Microsoft Purview eDiscovery soluciones.

Para crear o cambiar una directiva de retención para las interacciones de Copilot, consulte Creación y configuración de directivas de retención.

Para crear una directiva de etiqueta de retención de aplicación automática para los archivos a los que se hace referencia en Copilot, consulte Aplicación automática de una etiqueta de retención para conservar o eliminar contenido.

Otra documentación para ayudarle a proteger y administrar aplicaciones de IA generativas

Anuncio de la entrada de blog: Aceleración de la adopción de la inteligencia artificial con funcionalidades de gobernanza y seguridad de última generación

Para obtener información más detallada, consulte Consideraciones sobre Administración de postura de seguridad de datos de Microsoft Purview para IA y protección de cumplimiento y seguridad de datos para Copilot.

Microsoft 365 Copilot:

- Documentación de Microsoft 365 Copilot

- Aplicación de principios de Confianza cero a Microsoft 365 Copilot

Recursos relacionados: