Flujos de eventos de Microsoft Fabric: información general

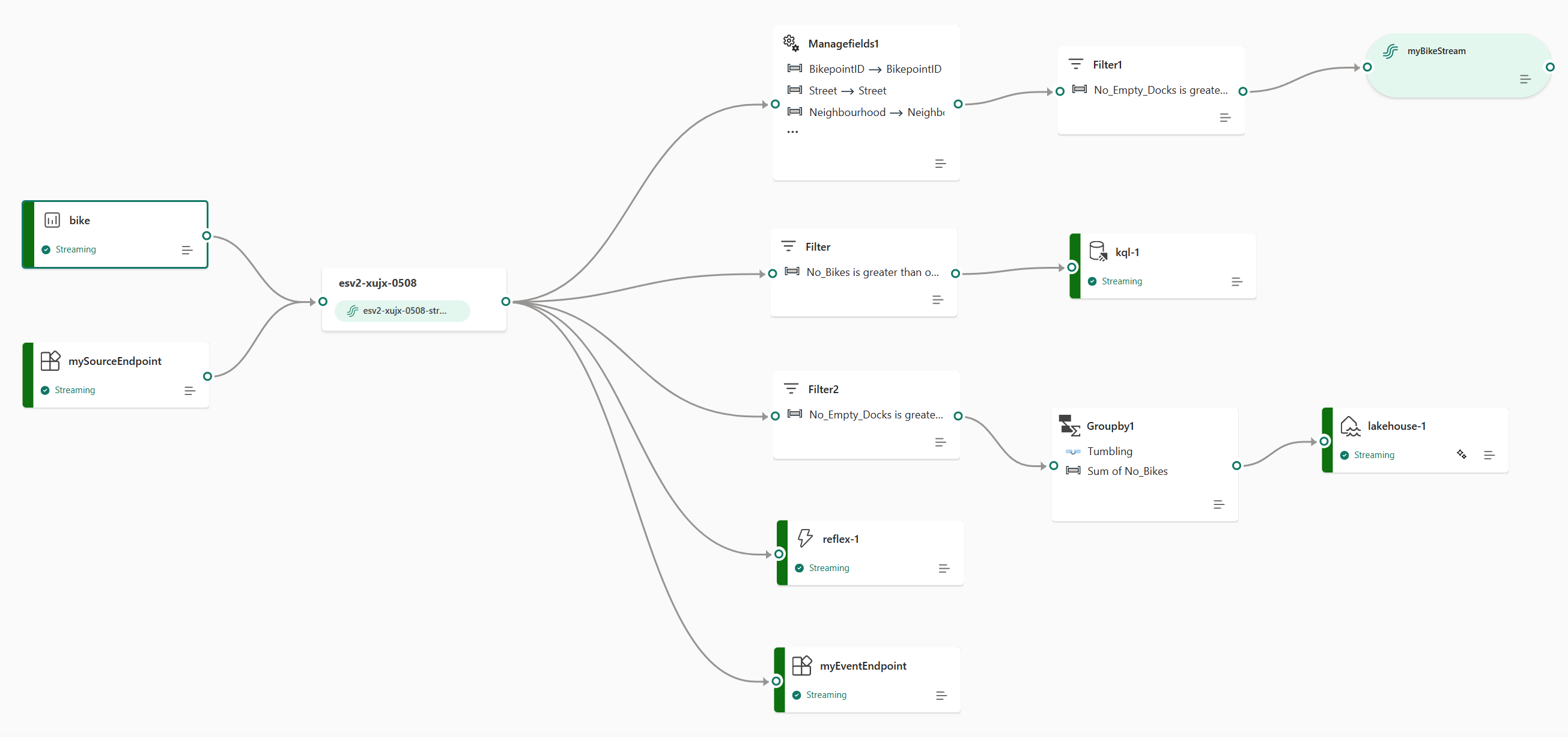

La característica de flujos de eventos de la experiencia de Inteligencia en tiempo real de Microsoft Fabric le permite incorporar eventos en tiempo real a Fabric, transformarlos y enrutarlos a varios destinos sin escribir código (sin código). Puede crear una secuencia de eventos, que es una instancia del elemento Eventstream en Fabric, agregar orígenes de datos de eventos a la secuencia, opcionalmente agregar transformaciones para transformar los datos del evento y, a continuación, enrutar los datos a destinos admitidos. Además, con los puntos de conexión de Apache Kafka disponibles en el elemento Eventstream, puede enviar o consumir eventos en tiempo real mediante el protocolo Kafka.

Incorporación de eventos a Fabric

La característica eventstreams proporciona varios conectores de origen para capturar datos de eventos de los distintos orígenes. Hay más orígenes disponibles al habilitar funcionalidades mejoradas en el momento de crear una secuencia de eventos.

| Orígenes | Descripción |

|---|---|

| Azure Event Hubs | Si tiene un centro de eventos de Azure, puede ingerir datos del centro de eventos en Microsoft Fabric mediante Eventstream. |

| Azure IoT Hub | Si tiene un centro de IoT de Azure, puede ingerir datos de IoT en Microsoft Fabric mediante Eventstream. |

| Captura de datos modificados de la base de datos Azure SQL | El conector de origen de CDC de Azure SQL Database permite capturar una instantánea de los datos actuales en una base de datos de Azure SQL. A continuación, el conector supervisa y registra los cambios futuros a nivel de fila en estos datos. |

| CDC de base de datos de PostgreSQL | El conector de origen de captura de datos modificados (CDC) de la base de datos de PostgreSQL permite capturar una instantánea de los datos actuales en una base de datos de PostgreSQL. A continuación, el conector supervisa y registra los cambios futuros a nivel de fila en estos datos. |

| CDC de base de datos de MySQL | El conector de origen de captura de datos modificados (CDC) de Azure MySQL Database permite capturar una instantánea de los datos actuales en una base de datos de Azure Database for MySQL. Puede especificar las tablas que se van a supervisar y Eventstream registra los cambios futuros de nivel de fila en las tablas. |

| CDC de Azure Cosmos DB | El conector de origen de captura de datos modificados (CDC) de Azure Cosmos DB para flujos de eventos de Microsoft Fabric permite capturar una instantánea de los datos actuales en una base de datos de Azure Cosmos DB. A continuación, el conector supervisa y registra los cambios futuros a nivel de fila en estos datos. |

| SQL Server en CDC de base de datos (DB) de máquina virtual (VM) | El conector de origen de la base de datos de SQL Server en la máquina virtual (CDC) para flujos de eventos de Fabric permite capturar una instantánea de los datos actuales de una base de datos de SQL Server en la máquina virtual. A continuación, el conector supervisa y registra los cambios futuros a nivel de fila en estos datos. |

| Azure SQL Managed Instance CDC | El conector de origen de Azure SQL Managed Instance CDC para flujos de eventos de Microsoft Fabric permite capturar una instantánea de los datos actuales en una base de datos de SQL Managed Instance. A continuación, el conector supervisa y registra los cambios futuros a nivel de fila en estos datos. |

| Google Cloud Pub/Sub | Google Pub/Sub es un servicio de mensajería que permite publicar y suscribirse a secuencias de eventos. Puede agregar Google Pub/Sub como origen a su secuencia de eventos para capturar, transformar y enrutar eventos en tiempo real a varios destinos de Fabric. |

| Flujos de datos de Amazon Kinesis | Amazon Kinesis Data Streams es un servicio de procesamiento y ingesta de datos muy duradero y escalable de forma masiva optimizado para datos de streaming. Al integrar Amazon Kinesis Data Streams como origen dentro de la secuencia de eventos, puede procesar sin problemas flujos de datos en tiempo real antes de enrutarlos a varios destinos dentro de Fabric. |

| Confluent Cloud Kafka | Confluent Cloud Kafka es una plataforma de streaming que ofrece eficaces funcionalidades de procesamiento y streaming de datos mediante Apache Kafka. Al integrar Confluent Cloud Kafka como origen dentro de la secuencia de eventos, puede procesar sin problemas flujos de datos en tiempo real antes de enrutarlos a varios destinos dentro de Fabric. |

| Amazon MSK Kafka | Amazon MSK Kafka es un servicio Kafka totalmente administrado que simplifica la configuración, el escalado y la administración. Al integrar Amazon MSK Kafka como origen dentro del flujo de eventos, puede traer sin problemas los eventos en tiempo real de su MSK Kafka y procesarlos antes de enrutarlos a varios destinos dentro de Fabric. |

| Datos de ejemplo | Puede elegir Bicicletas, Taxi amarillo, o Eventos de mercado de valores como un origen de datos de ejemplo para probar la ingesta de datos al configurar un eventstream. |

| Punto de conexión personalizado (es decir, aplicación personalizada en la funcionalidad estándar) | La característica de punto de conexión personalizado permite que las aplicaciones o los clientes de Kafka se conecten a Eventstream mediante una cadena de conexión, lo que permite la ingesta fluida de datos de streaming en Eventstream. |

| Azure Service Bus (versión preliminar) | Puede ingerir datos de una cola de Azure Service Bus o la suscripción de un tema a Microsoft Fabric mediante Eventstream. |

| Apache Kafka (versión preliminar) | Apache Kafka es una plataforma distribuida de código abierto para crear sistemas de datos escalables y en tiempo real. Al integrar Apache Kafka como origen dentro del flujo de eventos, puede traer sin problemas eventos en tiempo real de Apache Kafka y procesarlos antes de enrutarlos a varios destinos dentro de Fabric. |

| Eventos de Azure Blob Storage (versión preliminar) | Los eventos de Azure Blob Storage se desencadenan cuando un cliente crea, reemplaza o elimina un blob. El conector permite vincular eventos de Blob Storage a eventos de Fabric en el centro en tiempo real. Puede convertir estos eventos en flujos de datos continuos y transformarlos antes de enrutarlos a varios destinos de Fabric. |

| Eventos de elementos del área de trabajo de Fabric (versión preliminar) | Los eventos de elementos del área de trabajo de Fabric son eventos discretos de Fabric que se producen cuando se realizan cambios en el área de trabajo de Fabric. Estos cambios incluyen la creación, actualización o eliminación de un elemento de Fabric. Con flujos de eventos de Fabric, puede capturar estos eventos del área de trabajo de Fabric, transformarlos y enrutarlos a varios destinos de Fabric para su posterior análisis. |

Procesamiento de eventos mediante la experiencia sin código

La experiencia de arrastrar y colocar proporciona una manera intuitiva y sencilla de crear la lógica de enrutamiento, transformación y procesamiento de datos de eventos sin necesidad de escribir código. Un diagrama de flujo de datos de un extremo a otro en una secuencia de eventos puede proporcionarle una comprensión completa del flujo de datos y de la organización. El editor del procesador de eventos es una experiencia sin código que le permite arrastrar y colocar para diseñar la lógica de procesamiento de datos de eventos.

| Transformación | Descripción |

|---|---|

| Filtro | Use la transformación Filtro para filtrar eventos en función del valor de un campo de la entrada. En función del tipo de datos (número o texto), la transformación mantiene los valores que coincidan con la condición seleccionada, como is null o is not null. |

| Administrar campos | La transformación Administrar campos permite agregar, quitar o cambiar el tipo de datos, o el nombre de los campos procedentes de una entrada u otra transformación. |

| Agregado | Use la transformación Agregado para calcular una agregación (Suma, Mínimo, Máximo o Promedio) cada vez que se produzca un nuevo evento durante un período de tiempo. Esta operación también permite cambiar el nombre de estas columnas calculadas, y filtrar o segmentar la agregación en función de otras dimensiones de los datos. Puede tener una o varias agregaciones en la misma transformación. |

| Agrupar por | Use la transformación Agrupar por para calcular agregaciones en todos los eventos dentro de un período de tiempo determinado. Puede agrupar por los valores en uno o varios campos. Es como la transformación Agregado que permite cambiar el nombre de las columnas, pero proporciona más opciones para la agregación e incluye opciones más complejas para las ventanas de tiempo. Al igual que Agregado, puede incluir más de una agregación por transformación. |

| Unión | Use la transformación Unión para conectar dos o más nodos y agregar eventos con campos compartidos (con el mismo nombre y tipo de datos) en una tabla. Los campos que no coincidan se descartan y no se incluyen en la salida. |

| Expandir | Utilice la transformación Expandir matriz para crear una nueva fila por cada valor dentro de una matriz. |

| Join | Use la transformación Combinación para combinar datos de dos flujos en función de una condición coincidente entre ellas. |

Si ha habilitado Funcionalidades mejoradas al crear un flujo de eventos, se admiten las operaciones de transformación para todos los destinos (con flujo derivado que actúa como puente intermedio para algunos destinos, como punto de conexión personalizado, Fabric Activator). Si no lo ha hecho, las operaciones de transformación solo están disponibles para los destinos de almacén de lago y Eventhouse (procesamiento de eventos antes de la ingesta).

Redirigir eventos a destinos

La característica Flujos de eventos de Fabric admite el envío de datos a los siguientes destinos admitidos.

| Destino | Descripción |

|---|---|

| Punto de conexión personalizado (es decir, aplicación personalizada en la funcionalidad estándar) | Con este destino, puede enrutar fácilmente los eventos en tiempo real a un punto de conexión personalizado. Puede conectar sus propias aplicaciones a eventstream y consumir los datos del evento en tiempo real. Este destino es útil cuando quiere enviar datos en tiempo real a un sistema externo fuera de Microsoft Fabric. |

| Eventhouse | Este destino le permite ingerir los datos de eventos en tiempo real en un Eventhouse, donde puede usar el eficaz lenguaje de consulta Kusto (KQL) para consultar y analizar los datos. Con los datos del Eventhouse, puede obtener información más detallada sobre los datos del evento y crear informes y paneles completos. Puede elegir entre dos modos de ingesta: Ingesta directa y Procesamiento de eventos antes de la ingesta. |

| Lakehouse | Este destino le proporciona la capacidad de transformar los eventos en tiempo real antes de la ingesta en el almacén de lago. Los eventos en tiempo real se convierten en formato Delta Lake y, a continuación, se almacenan en las tablas del almacén de lago designadas. Este destino admite escenarios de almacenamiento de datos. |

| Secuencia derivada | La secuencia derivada es un tipo especializado de destino que puede crear después de agregar operaciones de flujo, como Filtrar o Administrar campos, a una secuencia de eventos. La secuencia derivada representa la secuencia predeterminada transformada después del procesamiento del flujo. Puede enrutar la secuencia derivada a varios destinos en Fabric y ver la secuencia derivada en el centro en tiempo real. |

| Fabric Activator (versión preliminar) | Este destino te permite conectar directamente tus datos de eventos en tiempo real a una instancia de Fabric Activator. Activator es un tipo de agente inteligente que contiene toda la información necesaria para conectarse a los datos, vigilar las condiciones y actuar. Cuando los datos alcanzan determinados umbrales o coinciden con otros patrones, Activator adopta automáticamente las medidas oportunas, como alertar a los usuarios o poner en marcha los flujos de trabajo de Power Automate. |

Puede adjuntar varios destinos en una secuencia de eventos para recibir simultáneamente datos de las secuencias de eventos sin interferir entre sí.

Nota:

Se recomienda usar la característica de flujos de eventos Microsoft Fabric con al menos 4 unidades de capacidad (SKU: F4)

Apache Kafka en flujos de eventos de Fabric

La característica de flujos de eventos de Fabric ofrece un punto de conexión de Apache Kafka en el elemento Eventstream, lo que permite a los usuarios conectarse y consumir eventos de streaming a través del protocolo Kafka. Si ya tiene una aplicación que usa el protocolo Apache Kafka para enviar o consumir eventos de streaming con temas de Kafka específicos, puede adaptar sin esfuerzo la misma aplicación para enviar o consumir los eventos de streaming dentro del flujo de eventos simplemente actualizando la configuración de conexión para que apunte al punto de conexión de Kafka proporcionado en el flujo de eventos.

La característica de flujos de eventos de Fabric cuenta con tecnología de Azure Event Hubs, un servicio nativo de nube totalmente administrado. Cuando se crea un flujo de eventos, se aprovisiona automáticamente un espacio de nombres del centro de eventos y se asigna un centro de eventos al flujo predeterminado sin necesidad de configuraciones de aprovisionamiento. Para obtener más información sobre las características compatibles con Kafka en el servicio Azure Event Hubs, consulte Azure Event Hubs para Apache Kafka.

Para obtener más información sobre cómo obtener los detalles del punto de conexión de Kafka para enviar eventos a un flujo de eventos, consulte Adición de un origen de punto de conexión personalizado a un flujo de eventos; y para consumir eventos de un flujo de datos, consulte Adición de un destino de punto de conexión personalizado a un flujo de eventos.

Funcionalidades mejoradas

Hay más características, orígenes y destinos disponibles al habilitar la opción Funcionalidades mejoradas al crear un flujo de eventos. Use las pestañas Funcionalidades mejoradas y Funcionalidades estándar para obtener información sobre orígenes y destinos adicionales compatibles con las funcionalidades mejoradas.

Estas son algunas otras características significativas de Funcionalidades mejoradas:

- Modo de edición y Vista en vivo. Explore dos modos distintos para visualizar y diseñar el procesamiento de flujos.

- Secuencias predeterminadas y derivadas. Cree un flujo continuo de secuencias con el formato que diseñe, con un procesador de eventos que se puede consumir más adelante en el centro en tiempo real.

- Enrutamiento del flujo de datos en función del contenido. Transforme y enrute los flujos de datos en cualquier parte de Fabric en función del contenido del flujo de datos que diseñó con el procesador de eventos.