針對 Azure Data Factory 和 Synapse 管線進行疑難排解

適用於: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

提示

試用 Microsoft Fabric 中的 Data Factory,這是適用於企業的全方位分析解決方案。 Microsoft Fabric 涵蓋從資料移動到資料科學、即時分析、商業智慧和報告的所有項目。 了解如何免費啟動新的試用版!

本文將探討 Azure Data Factory 和 Synapse 管線中外部控制活動的常見疑難排解方法。

連接器和複製活動

針對連接器問題 (例如使用複製活動時發生錯誤),請參閱針對連接器進行疑難排解一文。

Azure Databricks

錯誤碼:3200

訊息:錯誤 403。

原因:

The Databricks access token has expired.建議:根據預設,Azure Databricks 存取權杖的有效期限為 90天。 請建立新的權杖,並更新連結的服務。

錯誤碼:3201

訊息:

Missing required field: settings.task.notebook_task.notebook_path.原因:

Bad authoring: Notebook path not specified correctly.建議:在 Databricks 活動中指定筆記本路徑。

訊息:

Cluster... does not exist.原因:

Authoring error: Databricks cluster does not exist or has been deleted.建議:確認 Databricks 叢集存在。

訊息:

Invalid Python file URI... Please visit Databricks user guide for supported URI schemes.原因:

Bad authoring.建議:針對工作區定址配置指定絕對路徑,或針對 Databricks 檔案系統 (DFS) 中所儲存的檔案指定

dbfs:/folder/subfolder/foo.py。

訊息:

{0} LinkedService should have domain and accessToken as required properties.原因:

Bad authoring.建議:確認連結服務定義。

訊息:

{0} LinkedService should specify either existing cluster ID or new cluster information for creation.原因:

Bad authoring.建議:確認連結服務定義。

訊息:

Node type Standard_D16S_v3 is not supported. Supported node types: Standard_DS3_v2, Standard_DS4_v2, Standard_DS5_v2, Standard_D8s_v3, Standard_D16s_v3, Standard_D32s_v3, Standard_D64s_v3, Standard_D3_v2, Standard_D8_v3, Standard_D16_v3, Standard_D32_v3, Standard_D64_v3, Standard_D12_v2, Standard_D13_v2, Standard_D14_v2, Standard_D15_v2, Standard_DS12_v2, Standard_DS13_v2, Standard_DS14_v2, Standard_DS15_v2, Standard_E8s_v3, Standard_E16s_v3, Standard_E32s_v3, Standard_E64s_v3, Standard_L4s, Standard_L8s, Standard_L16s, Standard_L32s, Standard_F4s, Standard_F8s, Standard_F16s, Standard_H16, Standard_F4s_v2, Standard_F8s_v2, Standard_F16s_v2, Standard_F32s_v2, Standard_F64s_v2, Standard_F72s_v2, Standard_NC12, Standard_NC24, Standard_NC6s_v3, Standard_NC12s_v3, Standard_NC24s_v3, Standard_L8s_v2, Standard_L16s_v2, Standard_L32s_v2, Standard_L64s_v2, Standard_L80s_v2.原因:

Bad authoring.建議:請參閱錯誤訊息。

錯誤碼:3202

訊息:

There were already 1000 jobs created in past 3600 seconds, exceeding rate limit: 1000 job creations per 3600 seconds.原因:

Too many Databricks runs in an hour.建議:檢查使用此 Databricks 工作區的所有管線,以了解其作業建立比率。 如果管線啟動的 Databricks 執行總數太多,請將一些管線遷移至新的工作區。

訊息:

Could not parse request object: Expected 'key' and 'value' to be set for JSON map field base_parameters, got 'key: "..."' instead.原因:

Authoring error: No value provided for the parameter.建議:檢查管線 JSON,並確保 baseParameters 筆記本中的所有參數都指定非空白值。

訊息:

User: 'SimpleUserContext{userId=..., name=user@company.com, orgId=...}' is not authorized to access cluster.原因:產生存取權杖的使用者不允許存取連結服務中指定的 Databricks 叢集。

建議:請確定使用者具有工作區中的必要權限。

訊息:

Job is not fully initialized yet. Please retry later.原因:作業尚未初始化。

建議:請稍候,稍後再試一次。

錯誤碼:3203

訊息:

The cluster is in Terminated state, not available to receive jobs. Please fix the cluster or retry later.原因:叢集已終止。 若為互動式叢集,此問題可能是因為競爭條件。

建議:若要避免此錯誤,請使用作業叢集。

錯誤碼:3204

訊息:

Job execution failed.原因︰錯誤訊息指出各種問題,例如未預期的叢集狀態或特定活動。 通常不會出現任何錯誤訊息。

建議:N/A

錯誤碼:3208

訊息:

An error occurred while sending the request.原因:Databricks 服務的網路連線已中斷。

建議:如果您使用自我裝載整合執行階段,則請確定來自整合執行階段節點的網路連線可靠。 如果您使用 Azure 整合執行階段,則重試通常會運作。

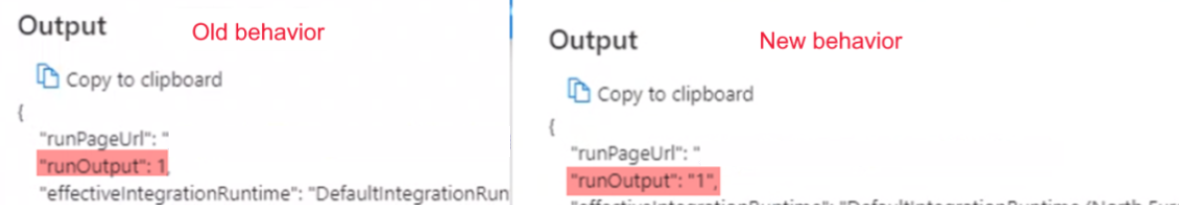

布林值執行輸出會以字串的形式開始,而不是預期的 int

徵狀:您的布林值執行輸出會以字串的形式開始 (例如,

"0"或"1"),而不是預期的 int (例如,0or1)。

當您依賴此起始輸出的管線失敗時,您在 2021 年 9 月 28 日上午 9 點 IST 注意到這項變更。 管線上未進行任何變更,而且布林值輸出資料已如預期在失敗之前到達。

原因:此問題是由最近的變更所造成,這是設計方式所致。 變更之後,如果結果是以零開頭的數字,Azure Data Factory 會將數字轉換成八進位值,這是錯誤。 此數字一律為 0 或 1,永遠不會在變更之前造成問題。 因此,若要修正八進位轉換,字串輸出會以原狀從 Notebook 執行傳遞。

建議:將 if 條件變更為如

if(value=="0")的項目。

Azure Data Lake Analytics

下表適用於 U-SQL。

錯誤碼:2709

訊息:

The access token is from the wrong tenant.原因:Microsoft Entra 租用戶不正確。

建議:Microsoft Entra 租用戶不正確。

訊息:

We cannot accept your job at this moment. The maximum number of queued jobs for your account is 200.原因:此錯誤是 Data Lake Analytics 上的節流所造成。

建議:減少提交至 Data Lake Analytics 的作業數目。 請變更活動上的觸發程序和並行設定,或放寬 Data Lake Analytics 的限制。

訊息:

This job was rejected because it requires 24 AUs. This account's administrator-defined policy prevents a job from using more than 5 AUs.原因:此錯誤是 Data Lake Analytics 上的節流所造成。

建議:減少提交至 Data Lake Analytics 的作業數目。 請變更活動上的觸發程序和並行設定,或放寬 Data Lake Analytics 的限制。

錯誤碼:2705

訊息:

Forbidden. ACL verification failed. Either the resource does not exist or the user is not authorized to perform the requested operation.<br/> <br/> User is not able to access Data Lake Store. <br/> <br/> User is not authorized to use Data Lake Analytics.原因:服務主體或憑證無法存取儲存體中的檔案。

建議:確認使用者針對 Data Lake Analytics 作業所提供的服務主體或憑證可以存取 Data Lake Analytics 帳戶,以及根資料夾中的預設 Data Lake Storage 執行個體。

錯誤碼:2711

訊息:

Forbidden. ACL verification failed. Either the resource does not exist or the user is not authorized to perform the requested operation.<br/> <br/> User is not able to access Data Lake Store. <br/> <br/> User is not authorized to use Data Lake Analytics.原因:服務主體或憑證無法存取儲存體中的檔案。

建議:確認使用者針對 Data Lake Analytics 作業所提供的服務主體或憑證可以存取 Data Lake Analytics 帳戶,以及根資料夾中的預設 Data Lake Storage 執行個體。

訊息:

Cannot find the 'Azure Data Lake Store' file or folder.原因:U-SQL 檔案的路徑錯誤,或連結的服務認證沒有存取權。

建議:請確認連結服務中提供的路徑和認證。

錯誤碼:2704

訊息:

Forbidden. ACL verification failed. Either the resource does not exist or the user is not authorized to perform the requested operation.<br/> <br/> User is not able to access Data Lake Store. <br/> <br/> User is not authorized to use Data Lake Analytics.原因:服務主體或憑證無法存取儲存體中的檔案。

建議:確認使用者針對 Data Lake Analytics 作業所提供的服務主體或憑證可以存取 Data Lake Analytics 帳戶,以及根資料夾中的預設 Data Lake Storage 執行個體。

錯誤碼:2707

訊息:

Cannot resolve the account of AzureDataLakeAnalytics. Please check 'AccountName' and 'DataLakeAnalyticsUri'.原因:連結服務中的 Data Lake Analytics 帳戶錯誤。

建議:確認已提供正確的帳戶。

錯誤碼:2703

訊息:

Error Id: E_CQO_SYSTEM_INTERNAL_ERROR (or any error that starts with "Error Id:").原因:錯誤來自 Data Lake Analytics。

建議:已提交給 Data Lake Analytics 的作業和其中的指令碼都失敗。 在 Data Lake Analytics 中進行調查。 在入口網站中,移至 Data Lake Analytics 帳戶,然後使用 Data Factory 活動執行識別碼來尋找作業 (請勿使用管線執行識別碼)。 這些作業會提供有關錯誤的詳細資訊,並協助您進行疑難排解。

如果解決方法不清楚,請洽詢 Data Lake Analytics 支援小組,並提供作業統一資源定位器 (URL),其中包含您的帳戶名稱和作業識別碼。

Azure Functions

錯誤碼:3602

訊息:

Invalid HttpMethod: '%method;'.原因:Azure Function 活動不支援活動承載中指定的 Httpmethod。

建議:支援的 Httpmethod 是:PUT、POST、GET、DELETE、OPTIONS、HEAD 和 TRACE。

錯誤碼:3603

訊息:

Response Content is not a valid JObject.原因:呼叫的 Azure 函式未在回應中傳回 JSON 承載。 Azure Data Factory 和 Synapse 管線 Azure 函式活動僅支援 JSON 回應內容。

建議:更新 Azure 函數以傳回有效的 JSON 承載,例如 C# 函數可能會傳回

(ActionResult)new OkObjectResult("{\"Id\":\"123\"}");

錯誤碼:3606

訊息:Azure 函數活動遺漏函數金鑰。

原因:Azure 函數活動定義不完整。

建議:檢查輸入 Azure 函數活動 JSON 定義是否具有名為

functionKey的屬性。

錯誤碼:3607

訊息:

Azure function activity missing function name.原因:Azure 函數活動定義不完整。

建議:檢查輸入 Azure 函數活動 JSON 定義是否具有名為

functionName的屬性。

錯誤碼:3608

訊息:

Call to provided Azure function '%FunctionName;' failed with status-'%statusCode;' and message - '%message;'.原因:活動定義中的 Azure 函數詳細資料可能不正確。

建議:請修正 Azure 函數的詳細資料,然後再試一次。

錯誤碼:3609

訊息:

Azure function activity missing functionAppUrl.原因:Azure 函數活動定義不完整。

建議:檢查輸入 Azure 函數活動 JSON 定義是否具有名為

functionAppUrl的屬性。

錯誤碼:3610

訊息:

There was an error while calling endpoint.原因:函數 URL 可能不正確。

建議:請確認活動 JSON 中的

functionAppUrl值正確無誤,然後再試一次。

錯誤碼:3611

訊息:

Azure function activity missing Method in JSON.原因:Azure 函數活動定義不完整。

建議:檢查輸入 Azure 函數活動 JSON 定義是否具有名為

method的屬性。

錯誤碼:3612

訊息:

Azure function activity missing LinkedService definition in JSON.原因:Azure 函數活動定義不完整。

建議:檢查輸入 Azure 函數活動的 JSON 定義是否有連結服務的詳細資料。

Azure Machine Learning

錯誤碼:4101

訊息:

AzureMLExecutePipeline activity '%activityName;' has invalid value for property '%propertyName;'.原因:

%propertyName;屬性的定義未使用正確格式或遺失。建議:檢查

%activityName;活動的%propertyName;屬性是否已使用正確資料加以定義。

錯誤碼:4110

訊息:

AzureMLExecutePipeline activity missing LinkedService definition in JSON.原因:AzureMLExecutePipeline 活動定義不完整。

建議:檢查輸入 AzureMLExecutePipeline 活動的 JSON 定義是否已正確連結服務詳細資料。

錯誤碼:4111

訊息:

AzureMLExecutePipeline activity has wrong LinkedService type in JSON. Expected LinkedService type: '%expectedLinkedServiceType;', current LinkedService type: Expected LinkedService type: '%currentLinkedServiceType;'.原因:活動定義不正確。

建議:檢查輸入 AzureMLExecutePipeline 活動的 JSON 定義是否已正確連結服務詳細資料。

錯誤碼:4112

訊息:

AzureMLService linked service has invalid value for property '%propertyName;'.原因:'%propertyName;' 屬性的定義未使用正確格式或遺失。

建議:檢查連結服務的

%propertyName;屬性是否已使用正確資料加以定義。

錯誤碼:4121

訊息:

Request sent to Azure Machine Learning for operation '%operation;' failed with http status code '%statusCode;'. Error message from Azure Machine Learning: '%externalMessage;'.原因:用來存取 Azure Machine Learning 的認證已過期。

建議:請確認認證有效,然後再試一次。

錯誤碼:4122

訊息:

Request sent to Azure Machine Learning for operation '%operation;' failed with http status code '%statusCode;'. Error message from Azure Machine Learning: '%externalMessage;'.原因:Azure Machine Learning 連結服務中提供的認證無效,或沒有執行該作業的權限。

建議:請確認連結服務中的認證有效,而且具有存取 Azure Machine Learning 的權限。

錯誤碼:4123

訊息:

Request sent to Azure Machine Learning for operation '%operation;' failed with http status code '%statusCode;'. Error message from Azure Machine Learning: '%externalMessage;'.原因:

pipelineParameters這類活動屬性不適用於 Azure Machine Learning (ML) 管線。建議:檢查活動屬性值是否符合預期的承載 (連結服務中指定且已發佈的 Azure Machine Learning 管線承載)。

錯誤碼:4124

訊息:

Request sent to Azure Machine Learning for operation '%operation;' failed with http status code '%statusCode;'. Error message from Azure Machine Learning: '%externalMessage;'.原因:已發佈的 Azure Machine Learning 管線端點不存在。

建議:確認連結服務中指定且已發佈的 Azure Machine Learning 管線端點存在於 Azure Machine Learning 中。

錯誤碼:4125

訊息:

Request sent to Azure Machine Learning for operation '%operation;' failed with http status code '%statusCode;'. Error message from Azure Machine Learning: '%externalMessage;'.原因:Azure Machine Learning 上發生伺服器錯誤。

建議:稍後重試。 如果問題持續發生,請洽詢 Azure Machine Learning 小組以取得協助。

錯誤碼:4126

訊息:

Azure ML pipeline run failed with status: '%amlPipelineRunStatus;'. Azure ML pipeline run Id: '%amlPipelineRunId;'. Please check in Azure Machine Learning for more error logs.原因:Azure Machine Learning 管線執行失敗。

建議:檢查 Azure Machine Learning 以取得更多錯誤記錄,然後修正 ML 管線。

Azure Synapse Analytics

錯誤碼:3250

訊息:

There are not enough resources available in the workspace, details: '%errorMessage;'原因:資源不足

建議:請嘗試在工作區中結束執行中作業、減少要求的虛擬核心數目、增加工作區配額或使用另一個工作區。

錯誤碼:3251

訊息:

There are not enough resources available in the pool, details: '%errorMessage;'原因:資源不足

建議:請嘗試在集區中結束執行中作業、減少要求的虛擬核心數目、增加集區大小上限或使用另一個集區。

錯誤碼:3252

訊息:

There are not enough vcores available for your spark job, details: '%errorMessage;'原因:虛擬核心不足

建議:請嘗試減少要求的虛擬核心數目,或增加您的虛擬核心配額。 如需詳細資訊,請參閱 Apache Spark 核心概念。

錯誤碼:3253

訊息:

There are substantial concurrent MappingDataflow executions which is causing failures due to throttling under the Integration Runtime used for ActivityId: '%activityId;'.原因:已達到節流閾值。

建議:在等候期間結束後重試要求。

錯誤碼:3254

訊息:

AzureSynapseArtifacts linked service has invalid value for property '%propertyName;'.原因:'%propertyName;' 屬性的定義未使用正確格式或遺失。

建議:檢查連結服務的 [%propertyName] 屬性是否已使用正確資料加以定義。

常見

錯誤碼:2103

訊息:

Please provide value for the required property '%propertyName;'.原因:未提供屬性所需的值。

建議:提供訊息中的值,然後再試一次。

錯誤碼:2104

訊息:

The type of the property '%propertyName;' is incorrect.原因:提供的屬性類型不正確。

建議:請修正屬性的類型,然後再試一次。

錯誤碼:2105

訊息:

An invalid json is provided for property '%propertyName;'. Encountered an error while trying to parse: '%message;'.原因:屬性的值無效,或不是預期的格式。

建議:請參閱屬性的文件,並確認提供的值包含正確的格式和類型。

錯誤碼:2106

訊息:

The storage connection string is invalid. %errorMessage;原因:儲存體的連接字串無效或格式不正確。

建議:請移至 Azure 入口網站並尋找您的儲存體,然後將連接字串複製並貼到您的連結服務中,然後再試一次。

錯誤碼:2110

訊息:

The linked service type '%linkedServiceType;' is not supported for '%executorType;' activities.原因:活動中指定的連結服務不正確。

建議:確認連結服務類型是活動支援的其中一個類型。 例如,HDI 活動的連結服務類型可以是 HDInsight 或 HDInsightOnDemand。

錯誤碼:2111

訊息:

The type of the property '%propertyName;' is incorrect. The expected type is %expectedType;.原因:提供的屬性類型不正確。

建議:請修正屬性類型,然後再試一次。

錯誤碼:2112

訊息:

The cloud type is unsupported or could not be determined for storage from the EndpointSuffix '%endpointSuffix;'.原因:EndpointSuffix 中儲存體的雲端類型不受支援或無法判斷。

建議:請使用另一個雲端中的儲存體,然後再試一次。

自訂

下表適用於 Azure Batch。

錯誤碼:2500

訊息:

Hit unexpected exception and execution failed.原因:

Can't launch command, or the program returned an error code.建議:請確認可執行檔存在。 如果程式已啟動,請確認 stdout.txt 和 stderr.txt 已上傳至儲存體帳戶。 在您程式碼中包含記錄是利於偵錯的好方法。

錯誤碼:2501

訊息:

Cannot access user batch account; please check batch account settings.原因:不正確的 Batch 存取金鑰或集區名稱。

建議:請確認連結服務中的集區名稱和 Batch 存取金鑰。

錯誤碼:2502

訊息:

Cannot access user storage account; please check storage account settings.原因:儲存體帳戶名稱或存取金鑰不正確。

建議:請確認連結服務中的儲存體帳戶名稱和存取金鑰。

錯誤碼:2504

訊息:

Operation returned an invalid status code 'BadRequest'.原因:自訂活動的

folderPath中有太多檔案。resourceFiles的大小總計不能超過 32,768 個字元。建議:移除不必要的檔案或將其壓縮,並新增 unzip 命令來將其解壓縮。

例如,使用

powershell.exe -nologo -noprofile -command "& { Add-Type -A 'System.IO.Compression.FileSystem'; [IO.Compression.ZipFile]::ExtractToDirectory($zipFile, $folder); }" ; $folder\yourProgram.exe

錯誤碼:2505

訊息:

Cannot create Shared Access Signature unless Account Key credentials are used.原因:自訂活動僅支援使用存取金鑰的儲存體帳戶。

建議:請參閱錯誤描述。

錯誤碼:2507

訊息:

The folder path does not exist or is empty: ...原因:位於指定路徑的儲存體帳戶中沒有任何檔案。

建議:資料夾路徑必須包含您想要執行的可執行檔。

錯誤碼:2508

訊息:

There are duplicate files in the resource folder.原因:資料夾路徑的不同子資料夾中有多個名稱相同的檔案。

建議:自訂活動會將 folderPath 下的資料夾結構壓平合併。 如果您需要保留資料夾結構,請壓縮檔案,並使用解壓縮命令在 Azure Batch 中將檔案解壓縮。

例如,使用

powershell.exe -nologo -noprofile -command "& { Add-Type -A 'System.IO.Compression.FileSystem'; [IO.Compression.ZipFile]::ExtractToDirectory($zipFile, $folder); }" ; $folder\yourProgram.exe

錯誤碼:2509

訊息:

Batch url ... is invalid; it must be in Uri format.原因:Batch URL 必須類似於

https://mybatchaccount.eastus.batch.azure.com建議:請參閱錯誤描述。

錯誤碼:2510

訊息:

An error occurred while sending the request.原因:Batch URL 無效。

建議:確認 Batch URL。

HDInsight

錯誤碼:206

訊息:

The batch ID for Spark job is invalid. Please retry your job.原因:造成此錯誤的服務發生內部問題。

建議:此問題可能是暫時性的。 稍後再重試您的作業。

錯誤碼:207

訊息:

Could not determine the region from the provided storage account. Please try using another primary storage account for the on demand HDI.原因:嘗試從主要儲存體帳戶判斷區域時發生內部錯誤。

建議:請嘗試另一個儲存體。

錯誤碼:208

訊息:

Service Principal or the MSI authenticator are not instantiated. Please consider providing a Service Principal in the HDI on demand linked service which has permissions to create an HDInsight cluster in the provided subscription and try again.原因:嘗試讀取服務主體或具現化 MSI 驗證時發生內部錯誤。

建議:請考慮提供有權在所提供訂用帳戶中建立 HDInsight 叢集的服務主體,然後再試一次。 確認已正確設定「管理身分識別」。

錯誤碼:2300

訊息:

Failed to submit the job '%jobId;' to the cluster '%cluster;'. Error: %errorMessage;.原因:錯誤訊息包含類似於

The remote name could not be resolved.的訊息。 提供的叢集 URI 可能無效。建議:請確認叢集尚未刪除,而且提供的 URI 正確。 當您在瀏覽器中開啟 URI 時,您應該會看到 Ambari UI。 如果叢集位於虛擬網路中,則 URI 應該是私人 URI。 若要將其開啟,請使用屬於相同虛擬網路的虛擬機器 (VM)。

如需詳細資訊,請參閱直接連線到 Apache Hadoop 服務。

原因:如果錯誤訊息包含類似於

A task was canceled.的訊息,表示作業提交逾時。建議:此問題可能源自一般 HDInsight 連線能力或網路連線能力。 請先確認您可以從任何瀏覽器連線到 HDInsight Ambari UI。 然後檢查您的認證是否仍然有效。

如果您使用自我裝載整合執行階段 (IR),請從已安裝自我裝載 IR 的 VM 或機器中執行此步驟。 然後再次嘗試提交作業。

如需詳細資訊,請參閱 Ambari Web UI。

原因:如果錯誤訊息包含類似於

User admin is locked out in Ambari或Unauthorized: Ambari user name or password is incorrect的訊息時,表示 HDInsight 的認證不正確或已過期。建議:請更正認證並重新部署連結服務。 首先,請在任何瀏覽器上開啟叢集 URI 並嘗試登入,以確認認證可在 HDInsight 上使用。 如果認證無法使用,您可以從 Azure 入口網站中進行重設。

針對 ESP 叢集,請透過自助式密碼重設來重設密碼。

原因:如果錯誤訊息包含類似於

502 - Web server received an invalid response while acting as a gateway or proxy server的訊息,表示此錯誤是由 HDInsight 服務傳回。建議:502 錯誤通常會發生在 Ambari 伺服器程序關閉時。 您可以藉由重新啟動前端節點來重新啟動 Ambari 服務。

使用 SSH 連線到 HDInsight 上的其中一個節點。

執行

ping headnodehost來識別使用中的前端節點主機。使用 SSH 連線到作用中的前端節點,因為 Ambari 伺服器位於作用中的前端節點上。

重新啟動使用中的前端節點。

如需詳細資訊,請參閱 Azure HDInsight 疑難排解文件。 例如:

原因:當錯誤訊息包含類似

Unable to service the submit job request as templeton service is busy with too many submit job requests或Queue root.joblauncher already has 500 applications, cannot accept submission of application的訊息時,表示有太多作業同時提交到 HDInsight。建議:限制提交到 HDInsight 的並行作業數目。 如果作業是由相同活動所提交,請參閱活動的並行資訊。 變更觸發程序,讓並行的管線執行數目分散在一段時間內。

請參閱 HDInsight 文件,依據錯誤中的建議調整

templeton.parallellism.job.submit。

錯誤碼:2301

訊息:

Could not get the status of the application '%physicalJobId;' from the HDInsight service. Received the following error: %message;. Please refer to HDInsight troubleshooting documentation or contact their support for further assistance.原因:HDInsight 叢集或服務有問題。

建議:如果服務嘗試要求執行中作業的狀態,卻未收到來自 HDInsight 叢集的回應,就會發生此錯誤。 此問題可能源自叢集本身,或 HDInsight 服務可能發生中斷。

請參閱 HDInsight 疑難排解文件,或連絡 Microsoft 支援服務以取得進一步的協助。

錯誤碼:2302

訊息:

Hadoop job failed with exit code '%exitCode;'. See '%logPath;/stderr' for more details. Alternatively, open the Ambari UI on the HDI cluster and find the logs for the job '%jobId;'. Contact HDInsight team for further support.原因:已將作業提交至 HDI 叢集,但卻失敗。

建議:

- 檢查 Ambari UI:

- 確定所有服務仍在執行中。

- 從 Ambari UI 中,檢查儀表板中的 [警示] 區段。

- 如需有關警示和警示解決方式的詳細資訊,請參閱管理和監視叢集。

- 檢閱您的 YARN 記憶體。 如果您的 YARN 記憶體偏高,處理作業的速度可能會有所延遲。 如果您的資源不足以容納 Spark 應用程式/作業,請擴大叢集,確保叢集具有足夠的記憶體和核心。

- 執行測試作業範例。

- 如果您在 HDInsight 後端上執行相同的作業,請確認其是否已成功。 如需執行範例的例子,請參閱執行包含在 HDInsight 中的 MapReduce 範例

- 如果 HDInsight 上的作業仍然失敗,請檢查應用程式記錄檔和資訊,這些資訊可協助您:

- 檢查是否已將作業提交至 YARN。 如果作業未提交至 YARN,請使用

--master yarn。 - 如果應用程式已完成執行,請收集 YARN 應用程式的開始時間和結束時間。 如果應用程式未完成執行,請收集開始時間/啟動時間。

- 使用

yarn logs -applicationId <Insert_Your_Application_ID>檢查並收集應用程式記錄檔。 - 檢查並收集

/var/log/hadoop-yarn/yarn目錄下的 YARN Resource Manager 記錄檔。 - 如果這些步驟不足以解決問題,請連絡 Azure HDInsight 小組以取得支援,並提供上述記錄和時間戳記。

- 檢查是否已將作業提交至 YARN。 如果作業未提交至 YARN,請使用

錯誤碼:2303

訊息:

Hadoop job failed with transient exit code '%exitCode;'. See '%logPath;/stderr' for more details. Alternatively, open the Ambari UI on the HDI cluster and find the logs for the job '%jobId;'. Try again or contact HDInsight team for further support.原因:已將作業提交至 HDI 叢集,但卻失敗。

建議:

- 檢查 Ambari UI:

- 確定所有服務仍在執行中。

- 從 Ambari UI 中,檢查儀表板中的 [警示] 區段。

- 如需有關警示和警示解決方式的詳細資訊,請參閱管理和監視叢集。

- 檢閱您的 YARN 記憶體。 如果您的 YARN 記憶體偏高,處理作業的速度可能會有所延遲。 如果您的資源不足以容納 Spark 應用程式/作業,請擴大叢集,確保叢集具有足夠的記憶體和核心。

- 執行測試作業範例。

- 如果您在 HDInsight 後端上執行相同的作業,請確認其是否已成功。 如需執行範例的例子,請參閱執行包含在 HDInsight 中的 MapReduce 範例

- 如果 HDInsight 上的作業仍然失敗,請檢查應用程式記錄檔和資訊,這些資訊可協助您:

- 檢查是否已將作業提交至 YARN。 如果作業未提交至 YARN,請使用

--master yarn。 - 如果應用程式已完成執行,請收集 YARN 應用程式的開始時間和結束時間。 如果應用程式未完成執行,請收集開始時間/啟動時間。

- 使用

yarn logs -applicationId <Insert_Your_Application_ID>檢查並收集應用程式記錄檔。 - 檢查並收集

/var/log/hadoop-yarn/yarn目錄下的 YARN Resource Manager 記錄檔。 - 如果這些步驟不足以解決問題,請連絡 Azure HDInsight 小組以取得支援,並提供上述記錄和時間戳記。

- 檢查是否已將作業提交至 YARN。 如果作業未提交至 YARN,請使用

錯誤碼:2304

訊息:

MSI authentication is not supported on storages for HDI activities.原因:HDInsight (HDI) 連結服務或 HDI 活動中所用的儲存體連結服務上設定了不受支援的 MSI 驗證。

建議:針對 HDI 連結服務或 HDI 活動中所使用的儲存體帳戶,提供完整連接字串。

錯誤碼:2305

訊息:

Failed to initialize the HDInsight client for the cluster '%cluster;'. Error: '%message;'原因︰HDI 叢集的連線資訊不正確、提供的使用者沒有執行必要動作的權限,或 HDInsight 服務在回應服務的要求時發生問題。

建議:請確認使用者資訊是否正確,以及 HDI 叢集的 Ambari UI 是否可以使用瀏覽器從已安裝 IR 的 VM 中開啟 (適用於自我裝載 IR),或是否可以從任何機器開啟 (適用於 Azure IR)。

錯誤碼:2306

訊息:

An invalid json is provided for script action '%scriptActionName;'. Error: '%message;'原因:為指令碼動作提供的 JSON 無效。

建議:錯誤訊息應有助於找出問題。 請修正 JSON 設定,然後再試一次。

如需詳細資訊,請參閱 Azure HDInsight 隨選連結服務。

錯誤碼:2310

訊息:

Failed to submit Spark job. Error: '%message;'原因:服務嘗試使用 Livy API (livy/batch) 在 Spark 叢集上建立批次,但收到錯誤。

建議:請遵循錯誤訊息來修正問題。 如果沒有足夠的資訊可解決此問題,則請連絡 HDI 小組,並將批次識別碼和作業識別碼提供給他們,而您可以在 [服務監視] 頁面的活動執行輸出中找到這些資訊。 若要進一步進行疑難排解,請收集批次工作的完整記錄檔。

如需如何收集完整記錄檔的詳細資訊,請參閱取得批次工作的完整記錄。

錯誤碼:2312

訊息:

Spark job failed, batch id:%batchId;. Please follow the links in the activity run Output from the service Monitoring page to troubleshoot the run on HDInsight Spark cluster. Please contact HDInsight support team for further assistance.原因:HDInsight Spark 叢集上的作業失敗。

建議:遵循 [服務監視] 頁面中活動執行輸出內的連結,針對 HDInsight Spark 叢集上的執行進行疑難排解。 請連絡 HDInsight 支援小組以取得進一步的協助。

如需如何收集完整記錄檔的詳細資訊,請參閱取得批次工作的完整記錄。

錯誤碼:2313

訊息:

The batch with ID '%batchId;' was not found on Spark cluster. Open the Spark History UI and try to find it there. Contact HDInsight support for further assistance.原因:已刪除 HDInsight Spark 叢集上的批次。

建議:針對 HDInsight Spark 叢集上的批次進行疑難排解。 請連絡 HDInsight 支援服務以取得進一步的協助。

如需如何收集完整記錄的詳細資訊,請參閱取得批次作業的完整記錄,並與 HDInsight 支援服務分享完整記錄,以取得進一步的協助。

錯誤碼:2328

訊息:

Failed to create the on demand HDI cluster. Cluster or linked service name: '%clusterName;', error: '%message;'原因:錯誤訊息應該會顯示錯誤的詳細資料。

建議:錯誤訊息應有助於問題的疑難排解。

錯誤碼:2329

訊息:

Failed to delete the on demand HDI cluster. Cluster or linked service name: '%clusterName;', error: '%message;'原因:錯誤訊息應該會顯示錯誤的詳細資料。

建議:錯誤訊息應有助於問題的疑難排解。

錯誤碼:2331

訊息:

The file path should not be null or empty.原因:提供的檔案路徑是空的。

建議:請提供現有檔案的路徑。

錯誤碼:2340

訊息:

HDInsightOnDemand linked service does not support execution via SelfHosted IR. Your IR name is '%IRName;'. Please select an Azure IR instead.原因:HDInsightOnDemand 連結服務不支援透過 SelfHosted IR 執行。

建議:請選取 Azure IR,然後再試一次。

錯誤碼:2341

訊息:

HDInsight cluster URL '%clusterUrl;' is incorrect, it must be in URI format and the scheme must be 'https'.原因:提供的 URL 格式不正確。

建議:請修正叢集 URL,然後再試一次。

錯誤碼:2342

訊息:

Failed to connect to HDInsight cluster: '%errorMessage;'.原因:為叢集提供的認證錯誤,或發生網路設定或連線問題,或 IR 連線到叢集時發生問題。

建議:

在瀏覽器中開啟 HDInsight 叢集的 Ambari UI,以確認認證是否正確。

如果叢集位於虛擬網路 (VNet) 中,而且正在使用自我裝載 IR,則 HDI URL 必須是 Vnet 中的私人 URL,且在叢集名稱後面應該列出

-int。例如,將

https://mycluster.azurehdinsight.net/變更為https://mycluster-int.azurehdinsight.net/。 請注意,-int應位於mycluster之後,但在.azurehdinsight.net之前如果叢集在 VNet 中,且使用自我裝載 IR,也使用了私人 URL,但連線仍然失敗,則表示安裝 IR 的 VM 連線到 HDI 時出現問題。

連線到已安裝 IR 的 VM,並在瀏覽器中開啟 Ambari UI。 使用叢集的私人 URL。 此連線應該可從瀏覽器執行。 如果不行,請連絡 HDInsight 支援小組以取得進一步的協助。

如果未使用自我裝載 IR,則 HDI 叢集應可公開存取。 在瀏覽器中開啟 Ambari UI,並檢查其是否已開啟。 如果叢集或其中的服務有任何問題,請連絡 HDInsight 支援小組以取得協助。

IR (自我裝載或 Azure) 必須能夠存取連結服務中所使用的 HDI 叢集 URL,才能讓測試連線通過,並讓執行作業正常運作。 您可以從 VM 或任何公用機器的瀏覽器開啟 URL,以驗證此狀態。

錯誤碼:2343

訊息:

User name and password cannot be null or empty to connect to the HDInsight cluster.原因:使用者名稱或密碼是空白的。

建議:請提供正確的認證以連線到 HDI,然後再試一次。

錯誤碼:2345

訊息:

Failed to read the content of the hive script. Error: '%message;'原因:指令檔不存在,或服務無法連線到指令碼的位置。

建議:請確認指令碼存在,而且相關聯的連結服務具有適當的認證可進行連線。

錯誤碼:2346

訊息:

Failed to create ODBC connection to the HDI cluster with error message '%message;'.原因:服務嘗試對 HDI 叢集建立開放式資料庫連接 (ODBC) 的連線,但發生錯誤而失敗。

建議:

- 請確認您已正確設定 ODBC/Java 資料庫連線 (JDBC) 來進行連線。

- 針對 JDBC,如果您使用相同的虛擬網路,您可以從下列網站取得此連線:

Hive -> Summary -> HIVESERVER2 JDBC URL - 若要確定您已設定正確的 JDBC,請參閱透過 HDInsight 中的 JDBC 驅動程式查詢 Apache Hive。

- 針對 Open Database (ODB),請參閱教學課程:使用 ODBC 和 PowerShell 查詢 Apache Hive,以確保您擁有正確的設定。

- 針對 JDBC,如果您使用相同的虛擬網路,您可以從下列網站取得此連線:

- 確認 Hiveserver2、Hive 中繼存放區和 Hiveserver2 Interactive 正在作用中且正常運作。

- 檢查 Ambari 使用者介面 (UI):

- 確定所有服務仍在執行中。

- 從 Ambari UI 中,檢查儀表板中的警示區段。

- 如需有關警示和警示解決方式的詳細資訊,請參閱管理和監視叢集。

- 如果這些步驟不足以解決問題,請連絡 Azure HDInsight 小組。

- 請確認您已正確設定 ODBC/Java 資料庫連線 (JDBC) 來進行連線。

錯誤碼:2347

訊息:

Hive execution through ODBC failed with error message '%message;'.原因:服務已透過 ODBC 連線提交用於執行的 Hive 指令碼給 HDI 叢集,但指令碼在 HDI 上失敗。

建議:

- 請確認您已正確設定 ODBC/Java 資料庫連線 (JDBC) 來進行連線。

- 針對 JDBC,如果您使用相同的虛擬網路,您可以從下列網站取得此連線:

Hive -> Summary -> HIVESERVER2 JDBC URL - 若要確定您已設定正確的 JDBC,請參閱透過 HDInsight 中的 JDBC 驅動程式查詢 Apache Hive。

- 針對 Open Database (ODB),請參閱教學課程:使用 ODBC 和 PowerShell 查詢 Apache Hive,以確保您擁有正確的設定。

- 針對 JDBC,如果您使用相同的虛擬網路,您可以從下列網站取得此連線:

- 確認 Hiveserver2、Hive 中繼存放區和 Hiveserver2 Interactive 正在作用中且正常運作。

- 檢查 Ambari 使用者介面 (UI):

- 確定所有服務仍在執行中。

- 從 Ambari UI 中,檢查儀表板中的警示區段。

- 如需有關警示和警示解決方式的詳細資訊,請參閱管理和監視叢集。

- 如果這些步驟不足以解決問題,請連絡 Azure HDInsight 小組。

- 請確認您已正確設定 ODBC/Java 資料庫連線 (JDBC) 來進行連線。

錯誤碼:2348

訊息:

The main storage has not been initialized. Please check the properties of the storage linked service in the HDI linked service.原因:儲存體連結服務屬性未正確設定。

建議:在 HDI 活動的主要儲存體連結服務中,僅支援完整的連接字串。 確認您未使用 MSI 授權或應用程式。

錯誤碼:2350

訊息:

Failed to prepare the files for the run '%jobId;'. HDI cluster: '%cluster;', Error: '%errorMessage;'原因:用來連線至檔案所在儲存體的認證不正確,或檔案不存在於該處。

建議:此錯誤發生在服務準備 HDI 活動,並嘗試在將作業提交至 HDI 之前,先將檔案複製到主要儲存體時。 請檢查檔案是否存在於提供的位置,以及儲存體連線是否正確。 由於 HDI 活動不支援在與 HDI 活動相關的儲存體帳戶上進行 MSI 驗證,因此請確認那些連結服務是否具有完整金鑰,或使用 Azure Key Vault。

錯誤碼:2351

訊息:

Could not open the file '%filePath;' in container/fileSystem '%container;'.原因:檔案不存在於指定路徑。

建議:請檢查檔案是否確實存在,以及指向此檔案且具有連線資訊的連結服務是否有正確的認證。

錯誤碼:2352

訊息:

The file storage has not been initialized. Please check the properties of the file storage linked service in the HDI activity.原因:檔案儲存體連結服務屬性未正確設定。

建議:確認已正確設定檔案儲存體連結服務的屬性。

錯誤碼:2353

訊息:

The script storage has not been initialized. Please check the properties of the script storage linked service in the HDI activity.原因:未正確設定指令碼儲存體連結服務屬性。

建議:確認已正確設定指令碼儲存體連結服務的屬性。

錯誤碼:2354

訊息:

The storage linked service type '%linkedServiceType;' is not supported for '%executorType;' activities for property '%linkedServicePropertyName;'.原因:活動不支援儲存體連結服務類型。

建議:確認所選取的連結服務有其中一個支援的活動類型。 HDI 活動支援 AzureBlobStorage 和 AzureBlobFSStorage 連結服務。

如需詳細資訊,請參閱比較與 Azure HDInsight 叢集搭配使用的儲存體選項

錯誤碼:2355

訊息:

The '%value' provided for commandEnvironment is incorrect. The expected value should be an array of strings where each string has the format CmdEnvVarName=CmdEnvVarValue.原因:為

commandEnvironment提供的值不正確。建議:確認提供的值類似於:

\"variableName=variableValue\" ]也請確認每個變數只會在清單中出現一次。

錯誤碼:2356

訊息:

The commandEnvironment already contains a variable named '%variableName;'.原因:為

commandEnvironment提供的值不正確。建議:確認提供的值類似於:

\"variableName=variableValue\" ]也請確認每個變數只會在清單中出現一次。

錯誤碼:2357

訊息:

The certificate or password is wrong for ADLS Gen 1 storage.原因:提供的認證不正確。

建議:確認 ADLS Gen 1 中的連線資訊已連結至服務,並確認測試連線是否已成功。

錯誤碼:2358

訊息:

The value '%value;' for the required property 'TimeToLive' in the on demand HDInsight linked service '%linkedServiceName;' has invalid format. It should be a timespan between '00:05:00' and '24:00:00'.原因:為必要屬性

TimeToLive所提供的值具有無效格式。建議:將值更新為建議的範圍,然後再試一次。

錯誤碼:2359

訊息:

The value '%value;' for the property 'roles' is invalid. Expected types are 'zookeeper', 'headnode', and 'workernode'.原因:為屬性

roles提供的值無效。建議:將值更新為其中一個建議,然後再試一次。

錯誤碼:2360

訊息:

The connection string in HCatalogLinkedService is invalid. Encountered an error while trying to parse: '%message;'.原因:為

HCatalogLinkedService提供的連接字串無效。建議:請將值更新為正確的 Azure SQL 連接字串,然後再試一次。

錯誤碼:2361

訊息:

Failed to create on demand HDI cluster. Cluster name is '%clusterName;'.原因:叢集建立失敗,且服務未從 HDInsight 服務取得錯誤。

建議:開啟 Azure 入口網站,並嘗試尋找具有所提供名稱的 HDI 資源,然後檢查佈建狀態。 請連絡 HDInsight 支援小組以取得進一步的協助。

錯誤碼:2362

訊息:

Only Azure Blob storage accounts are supported as additional storages for HDInsight on demand linked service.原因:提供的額外儲存體不是 Azure Blob 儲存體。

建議:提供 Azure Blob 儲存體帳戶作為 HDInsight 隨選連結服務的額外儲存體。

使用 HDInsight ESP 叢集的連結服務時發生 SSL 錯誤

訊息:

Failed to connect to HDInsight cluster: 'ERROR [HY000] [Microsoft][DriverSupport] (1100) SSL certificate verification failed because the certificate is missing or incorrect.'原因:問題最有可能與系統信任存放區相關。

解決方案:您可以瀏覽至路徑 Microsoft Integration Runtime\4.0\Shared\ODBC Drivers\Microsoft Hive ODBC Driver\lib,並且開啟 DriverConfiguration64.exe 以變更設定。

![取消選取 [使用系統信任存放區]](media/connector-troubleshoot-guide/system-trust-store-setting.png)

HDI 活動停滯在準備叢集

如果 HDI 活動停滯在準備叢集,請遵循下列指導方針:

請確定逾時大於以下所述的值,並等候執行完成或直到逾時為止,然後等待存留時間 (TTL) 的時間,再提交新作業。

啟動叢集所需的預設時間上限為 2 小時,如果您有任何 init 指令碼,則會再增加,最多另外還要 2 小時。

請確定在相同區域中佈建儲存體和 HDI。

請確定用來存取 HDI 叢集的服務主體有效。

如果問題仍然持續發生,作為因應措施,請刪除 HDI 連結服務,並使用新的名稱重新建立。

Web 活動

錯誤碼:2001

訊息:

The length of execution output is over limit (around 4MB currently).原因:執行輸出的大小大於 4 MB,但支援的輸出回應承載大小上限為 4 MB。

建議:確定執行輸出大小未超過 4 MB。 如需詳細資訊,請參閱如何為使用 Azure Data Factory 移動的資料擴增大小。

錯誤碼:2002

訊息:

The payload including configurations on activity/dataSet/linked service is too large. Please check if you have settings with very large value and try to reduce its size.原因:您嘗試傳送的承載太大。

建議:請參閱承載太大。

錯誤碼:2003

訊息:

There are substantial concurrent external activity executions which is causing failures due to throttling under subscription <subscription id>, region <region code> and limitation <current limit>. Please reduce the concurrent executions. For limits, refer https://aka.ms/adflimits.原因:同時執行太多活動。 同時觸發太多管線時,就會發生此狀況。

建議:減少管線並行。 您可能需要分散管線的觸發時間。

錯誤碼:2010

訊息:

The Self-hosted Integration Runtime ‘<SHIR name>’ is offline原因:自我裝載整合執行階段離線,或 Azure 整合執行階段已過期或未註冊。

建議:確定自我裝載整合執行階段已啟動並執行中。 如需詳細資訊,請參閱對自我裝載整合執行階段進行疑難排解。

錯誤碼:2105

訊息:

The value type '<provided data type>', in key '<key name>' is not expected type '<expected data type>'原因:在動態內容運算式中產生的資料與索引鍵不符,並且導致 JSON 剖析失敗。

建議:查看索引鍵欄位,並修正動態內容定義。

錯誤碼:2108

訊息:

Error calling the endpoint '<URL>'. Response status code: 'NA - Unknown'. More details: Exception message: 'NA - Unknown [ClientSideException] Invalid Url: <URL>. Please verify Url or integration runtime is valid and retry. Localhost URLs are allowed only with SelfHosted Integration Runtime'原因:無法連線到提供的 URL。 可能的原因包括網路連線有問題、URL 無法解析,或在 Azure 整合執行階段上使用了 localhost URL。

建議:確認提供的 URL 可供存取。

訊息:

Error calling the endpoint '%url;'. Response status code: '%code;'原因:要求因為基本問題而失敗,例如網路連線、DNS 失敗、伺服器憑證驗證或逾時。

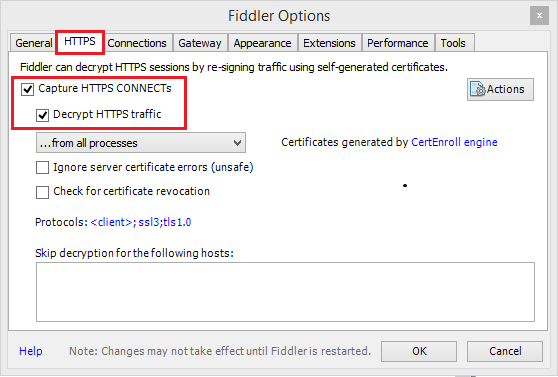

建議:使用 Fiddler/Netmon/Wireshark 來驗證要求。

使用 Fiddler

若要使用 Fiddler 來為受監視的 Web 應用程式建立 HTTP 工作階段:

下載、安裝和開啟 Fiddler。

如果您的 Web 應用程式使用 HTTPS,請移至 [工具]>[Fiddler 選項]>[HTTPS]。

在 [HTTPS] 索引標籤中,選取 [取得 HTTPS 連線] 和 [將 HTTPS 流量解密]。

如果您的應用程式使用 TLS/SSL 憑證,請將 Fiddler 憑證新增至您的裝置。

移至:[工具] > [Fiddler 選項] > [HTTPS] > [動作] > [將根憑證匯出到桌面]。

藉由前往 [檔案]>[擷取流量] 來關閉擷取作業。 或是按下 F12。

清除瀏覽器的快取後,所有快取的項目都會移除,因此必須重新下載。

建立要求:

選取 [編輯器] 索引標籤。

設定 HTTP 方法和 URL。

如有需要,請新增標頭和要求本文。

選取 [執行]。

再次開啟流量擷取,並在您的頁面上完成有問題的交易。

移至:[檔案] > [儲存] > [所有工作階段]。

如需詳細資訊,請參閱開始使用 Azure Fiddler

錯誤碼:2113

訊息:

ExtractAuthorizationCertificate: Unable to generate a certificate from a Base64 string/password combination原因:無法從 Base64 字串/密碼組合產生憑證。

建議:確認已正確輸入您所使用的 Base64 編碼 PFX 憑證和密碼組合。

錯誤碼:2403

訊息:

Get access token from MSI failed for Datafactory <DF name>, region <region code>. Please verify resource url is valid and retry.原因:無法從提供的資源 URL 取得存取權杖。

建議:確認您已為受控識別提供正確的資源 URL。

一般

REST 接續權杖 Null 錯誤

錯誤訊息: {"token":null,"range":{"min":..}

原因:跨多個分割區/頁面查詢時,後端服務會傳回 JObject 格式的接續權杖,具有 3 個屬性:權杖、最小和最大索引鍵範圍,例如,{"token":null,"range":{"min":"05C1E9AB0DAD76","max":"05C1E9CD673398"}})。 視來源資料而定,查詢可能會產生 0,表示遺漏權杖,但還有更多資料要擷取。

建議:當 continuationToken 非 Null 時,字串為 {"token":null,"range":{"min":"05C1E9AB0DAD76","max":"05C1E9CD673398"}},需要使用先前回應的接續權杖,再次呼叫 queryActivityRuns API。 您必須再次傳遞查詢 API 的完整字串。 活動將會在查詢結果的後續頁面中傳回。 您應該忽略此頁面中有空陣列,只要完整 continuationToken 值 != null,您就需要繼續查詢。 如需詳細資訊,請參閱用於管線執行查詢的 REST API。

活動停滯問題

當您觀察到活動執行的時間比正常執行還久,但幾乎沒有進度時,可能是停滯。 您可以嘗試取消然後重試,看看是否有幫助。 如果是複製活動,您可以從針對複製活動效能進行疑難排解了解效能監視和疑難排解;如果是資料流程,請從對應資料流程效能和微調指南中了解。

承載過大

錯誤訊息: The payload including configurations on activity/dataSet/linked service is too large. Please check if you have settings with very large value and try to reduce its size.

原因:每個活動執行的承載包含活動設定、相關聯的資料集和已連結的服務設定 (如果有的話),以及每個活動類型所產生的一小部分系統屬性。 此類承載大小的限制是 896 KB,如同 Data Factory 和 Azure Synapse Analytics 的 Azure 限制文件中所述。

建議:您可能會因為從上游活動輸出或外部傳入一或多個大型參數值而達到此限制,特別是當您在控制流程中跨活動傳遞實際資料時。 檢查您是否可以減少大型參數值的大小,或調整管線邏輯,以避免跨活動傳遞這類值,並改為在活動內處理。

不支援的壓縮導致檔案損壞

徵狀:您嘗試解壓縮儲存在 Blob 容器中的檔案。 管線中單一複製活動的來源,其壓縮類型設定為「deflate64」(或任何不支援的類型)。 此活動會順利執行,並產生以 zip 檔案包含的文字檔。 不過,檔案中的文字有問題,而且此檔案似乎已損毀。 在本機解壓縮此檔案時,沒有問題。

原因:您的 zip 檔案是由 「deflate64」的演算法壓縮,而 Azure Data Factory 的內部 zip 程式庫僅支援「deflate」。 如果 zip 檔案是由 Windows 系統壓縮,而整體檔案大小超過特定數目,Windows 預設會使用「deflate64」,Azure Data Factory 不支援。 另一方面,如果檔案大小較小,或使用支援指定壓縮演算法的某些第三方 zip 工具,則 Windows 預設會使用「deflate」。

提示

實際上,Azure Data Factory 和 Synapse Analytics 中的二進位格式和 Azure Data Factory 和 Azure Synapse Analytics 中分隔的文字格式,都清楚指出 Azure Data Factory 中不支援「deflate64」格式。

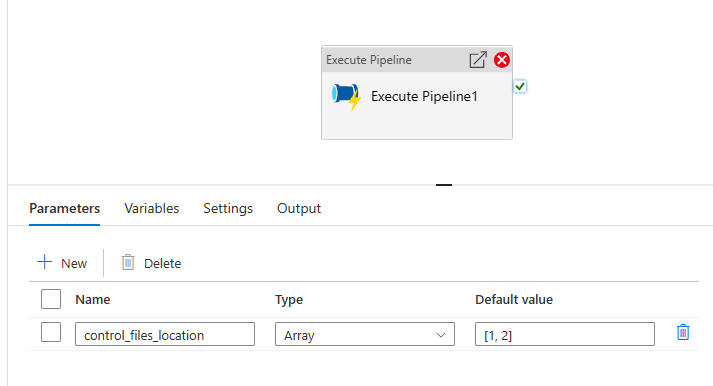

執行管線會以字串形式將陣列參數傳遞至子管線

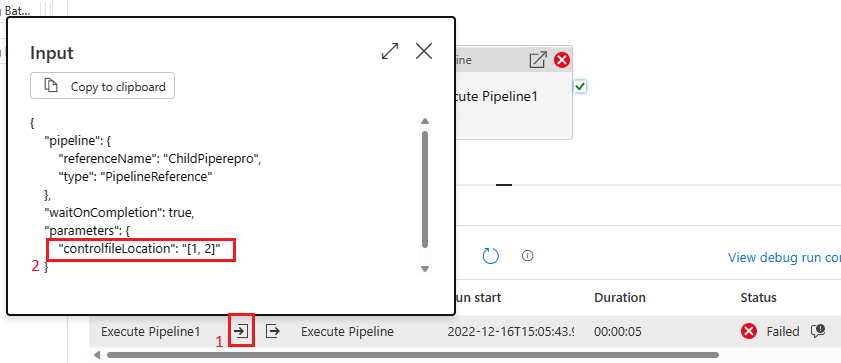

錯誤訊息: Operation on target ForEach1 failed: The execution of template action 'MainForEach1' failed: the result of the evaluation of 'foreach' expression '@pipeline().parameters.<parameterName>' is of type 'String'. The result must be a valid array.

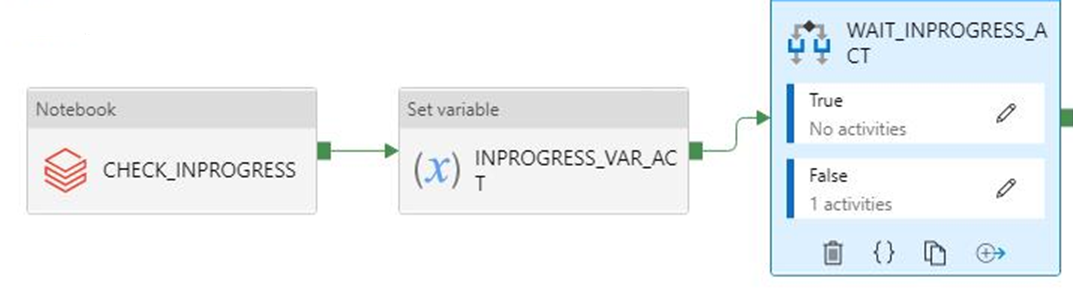

原因:即使您在執行管線中建立陣列類型的參數 (如下圖所示),管線還是會失敗。

原因是會以字串形式將承載從父管線傳遞至子管線的事實。 當我們檢查傳遞至子管線的輸入時,就會看到它。

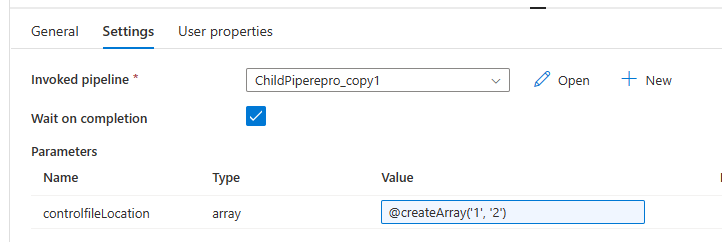

建議:若要解決此問題,我們可以利用 create array 函數,如下圖所示。

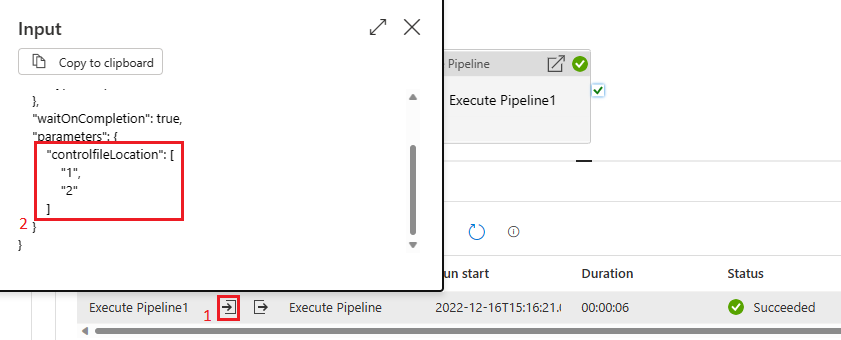

然後,我們的管線將會成功。 我們可以在輸入方塊中看到傳遞的參數是陣列。

相關內容

如需更多疑難排解的協助,請嘗試下列資源: