排除 Microsoft Fabric 中的医疗保健数据解决方案故障

本文提供有关使用 Microsoft Fabric 中的医疗保健数据解决方案时可能遇到的一些问题或错误以及如何解决它们的信息。 本文还包括一些应用程序监视指南。

如果按照本文中的指南操作后问题仍然存在,请为支持团队创建事件工单。

解决部署问题

有时,在将医疗保健数据解决方案部署到 Fabric 工作区时,可能会遇到间歇性问题。 下面是一些常见问题和解决方法:

解决方案创建失败或花费时间过长。

错误:医疗保健解决方案的创建过程超过 5 分钟,和/或失败。

原因:如果存在另一个同名或最近删除的医疗保健解决方案,则会发生此错误。

解决方法:如果最近删除了解决方案,请等待 30 到 60 分钟,然后再尝试其他部署。

功能部署失败。

错误:医疗保健数据解决方案中的功能无法部署。

解决方法:验证该功能是否在管理已部署的功能部分下列出。

- 如果表中未列出该功能,请尝试再次部署它。 选择功能磁贴,然后选择部署到工作区按钮。

- 如果该功能在表中列出并且状态值为部署失败,请重新部署该功能。 或者,您可以创建新的医疗保健数据解决方案环境,并在其中重新部署该功能。

排除未识别表故障

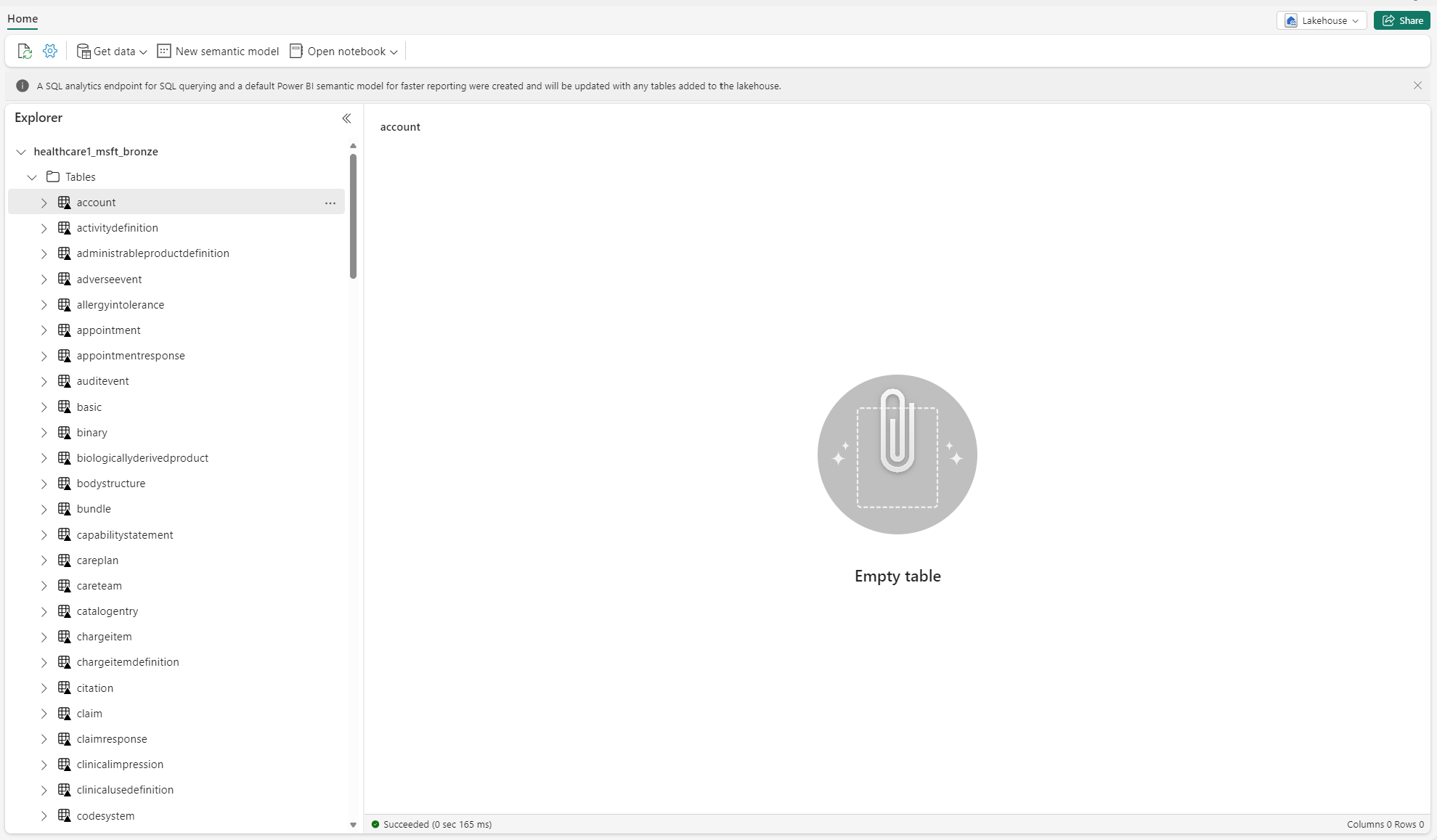

首次在湖屋中创建增量表时,它们在湖屋资源管理器视图中可能暂时显示为“未识别”或为空。 但是,几分钟后,它们应该会正确显示在表文件夹下。

重新运行数据管道

若要端到端重新运行示例数据,请按照以下步骤操作:

从笔记本运行 Spark SQL 语句,以删除湖屋中的所有表。 下面是一个示例:

lakehouse_name = "<lakehouse_name>" tables = spark.sql(f"SHOW TABLES IN {lakehouse_name}") for row in tables.collect(): spark.sql(f"DROP TABLE {lakehouse_name}.{row[1]}")使用 OneLake 文件资源管理器连接到 Windows 文件资源管理器中的 OneLake。

导航到 Windows 文件资源管理器中的工作区文件夹。 在

<solution_name>.HealthDataManager\DMHCheckpoint下,删除<lakehouse_id>/<table_name>中的所有相应文件夹。 或者,也可以使用适用于 Fabric 的 Microsoft Spark Utilities (MSSparkUtils) 删除文件夹。重新运行数据管道,从铜牌湖屋中的临床数据引入开始。

使用 Azure Log Analytics 监视 Apache Spark 应用程序

Apache Spark 应用程序日志将发送到您可以查询的 Azure Log Analytics 工作区实例。 使用此示例 Kusto 查询筛选特定于医疗保健数据解决方案的日志:

AppTraces

| where Properties['LoggerName'] contains "Healthcaredatasolutions"

or Properties['LoggerName'] contains "DMF"

or Properties['LoggerName'] contains "RMT"

| limit 1000

每次执行时,笔记本的控制台日志也会记录 RunId。 可以使用此值检索特定运行的日志,如以下示例查询所示:

AppTraces

| where Properties['RunId'] == "<RunId>"

有关常规监视信息,请参阅使用 Fabric 监视中心。

使用 OneLake 文件资源管理器

OneLake 文件资源管理器应用程序将 OneLake 与 Windows 文件资源管理器无缝集成。 您可以使用 OneLake 文件资源管理器查看在 Fabric 工作区中部署的任何文件夹或文件。 您还可以查看示例数据、OneLake 文件和文件夹以及检查点文件。

使用 Azure 存储资源管理器

还可以使用 Azure 存储资源管理器执行以下操作:

在 Fabric 工作区中重置 Spark 运行时版本

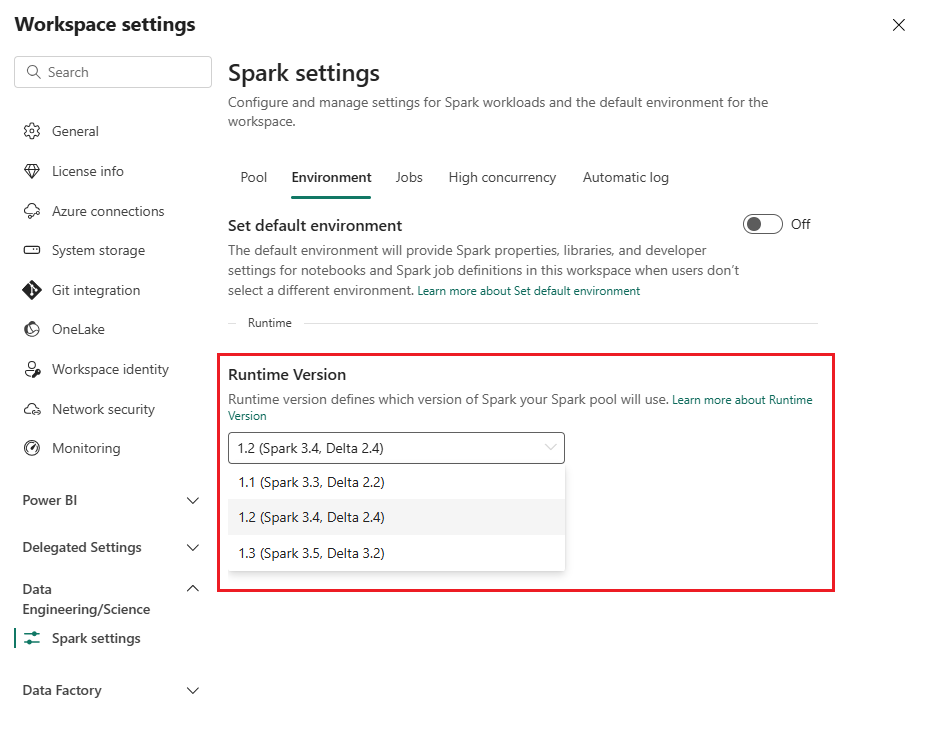

默认情况下,所有新的 Fabric 工作区都使用最新的 Fabric 运行时版本,当前版本为运行时 1.3。 但是,医疗保健数据解决方案仅支持运行时 1.2。

因此,在将医疗保健数据解决方案部署到工作区后,请确保将默认 Fabric 运行时版本设置为运行时 1.2(Apache Spark 3.4 和 Delta Lake 2.4)。 否则,数据管道和笔记本执行可能会失败。 有关详细信息,请参阅 Fabric 中的多个运行时支持。

按照以下步骤查看/更新 Fabric 运行时版本:

转到医疗保健数据解决方案工作区,然后选择工作区设置。

在“工作区设置”页面上,展开数据工程/科学下拉框,然后选择 Spark 设置。

在环境选项卡上,将运行时版本值更新为 1.2(Spark 3.4、Delta 2.4)并保存更改。

刷新 Fabric UI 和 OneLake 文件资源管理器

有时,您可能会注意到 Fabric UI 或 OneLake 文件资源管理器并不总是在每次执行笔记本后刷新内容。 如果在运行任何执行步骤(例如创建新文件夹或湖屋,或者将新数据引入到表中)后在 UI 中看不到预期结果,请尝试刷新项目(表、湖屋、文件夹)。 在探索其他选项或进一步调查之前,此刷新通常可以解决差异。