Anteckning

Åtkomst till den här sidan kräver auktorisering. Du kan prova att logga in eller ändra kataloger.

Åtkomst till den här sidan kräver auktorisering. Du kan prova att ändra kataloger.

Övervakningsmodeller i produktion är en viktig del av AI-livscykeln. Ändringar i data och konsumentbeteenden kan påverka ditt generativa AI-program över tid, vilket resulterar i inaktuella system som negativt påverkar affärsresultat och utsätter organisationer för efterlevnadsrisker, ekonomiska risker och ryktesrisker.

Viktigt!

Modellövervakning för generativa AI-program finns för närvarande i offentlig förhandsversion. Dessa förhandsversioner tillhandahålls utan ett serviceavtal och rekommenderas inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade. Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

Azure Machine Learning-modellövervakning för generativa AI-program gör det enklare för dig att övervaka dina LLM-program i produktion för säkerhet och kvalitet på en takt för att säkerställa att det ger maximal inverkan på verksamheten. Övervakning hjälper slutligen till att upprätthålla kvaliteten och säkerheten för dina generativa AI-program. Funktioner och integreringar omfattar:

- Samla in produktionsdata med hjälp av modelldatainsamlare.

- Ansvarsfulla AI-utvärderingsmått som grund, konsekvens, flyt, relevans och likhet, som är kompatibla med azure Machine Learning-mått för snabbflödesutvärdering.

- Möjlighet att konfigurera aviseringar för överträdelser baserat på organisationens mål och köra övervakning regelbundet

- Använd resultat i en omfattande instrumentpanel på en arbetsyta i Azure Machine Learning-studio.

- Integrering med mått för snabbflödesutvärdering i Azure Machine Learning, analys av insamlade produktionsdata för att tillhandahålla aviseringar i tid och visualisering av måtten över tid.

Grundläggande begrepp för modellövervakning finns i Modellövervakning med Azure Machine Learning (förhandsversion). I den här artikeln får du lära dig hur du övervakar ett generativt AI-program som backas upp av en hanterad onlineslutpunkt. De steg du utför är:

- Konfigurera förutsättningar

- Skapa din övervakare

- Bekräfta övervakningsstatus

- Använda övervakningsresultat

Utvärderingsmått

Mått genereras av följande toppmoderna GPT-språkmodeller som konfigurerats med specifika utvärderingsinstruktioner (promptmallar) som fungerar som utvärderarmodeller för sekvens-till-sekvens-uppgifter. Den här tekniken har visat starka empiriska resultat och hög korrelation med mänskligt omdöme jämfört med standardmått för generativ AI-utvärdering. Formulär mer information om utvärdering av promptflöde finns i Skicka masstest och utvärdera ett flöde (förhandsversion) för mer information om utvärdering av promptflöde.

Dessa GPT-modeller stöds och konfigureras som din Azure OpenAI-resurs:

- GPT-3.5 Turbo

- GPT-4

- GPT-4-32k

Följande mått stöds. Mer detaljerad information om varje mått finns i Övervaka beskrivningar av utvärderingsmått och användningsfall

- Grundvärde: utvärderar hur väl modellens genererade svar överensstämmer med information från indatakällan.

- Relevans: utvärderar i vilken utsträckning modellens genererade svar är relevanta och direkt relaterade till de aktuella frågorna.

- Enhetlighet: utvärderar hur väl språkmodellen kan skapa utdataflöden smidigt, läser naturligt och liknar mänskligt språk.

- Fluency: utvärderar språkkunskaperna i en generativ AI:s förutsagda svar. Den utvärderar hur väl den genererade texten följer grammatiska regler, syntaktiska strukturer och lämplig användning av vokabulär, vilket resulterar i språkligt korrekta och naturligt klingande svar.

- Likhet: utvärderar likheten mellan en grundläggande sannings mening (eller dokument) och förutsägelsedomen som genereras av en AI-modell.

Krav för måttkonfiguration

Följande indata (namn på datakolumner) krävs för att mäta genereringens säkerhet och kvalitet:

- prompt text – den ursprungliga prompten (kallas även "indata" eller "fråga")

- slutförandetext – det slutliga slutförandet från API-anropet som returneras (kallas även "utdata" eller "svar")

- kontexttext – alla kontextdata som skickas till API-anropet, tillsammans med den ursprungliga prompten. Om du till exempel bara vill hämta sökresultat från vissa certifierade informationskällor/webbplatser kan du definiera i utvärderingsstegen. Det här är ett valfritt steg som kan konfigureras via promptflöde.

- grundsanningstext – den användardefinierade texten som "sanningens källa" (valfritt)

Vilka parametrar som konfigureras i datatillgången avgör vilka mått du kan producera, enligt den här tabellen:

| Mått | Prompt | Fullbordande | Kontext | Grund sanning |

|---|---|---|---|---|

| Koherens | Obligatoriskt | Obligatoriskt | - | - |

| Flyt | Obligatoriskt | Obligatoriskt | - | - |

| Grundstötning | Obligatoriskt | Obligatoriskt | Obligatoriskt | - |

| Relevans | Obligatoriskt | Obligatoriskt | Obligatoriskt | - |

| Likhet | Obligatoriskt | Obligatoriskt | - | Obligatoriskt |

Förutsättningar

- Azure OpenAI-resurs: Du måste ha en Azure OpenAI-resurs skapad med tillräcklig kvot. Den här resursen används som utvärderingsslutpunkt.

- Hanterad identitet: Skapa en användartilldelad hanterad identitet (UAI) och bifoga den till din arbetsyta med hjälp av vägledningen i Bifoga användartilldelad hanterad identitet med hjälp av CLI v2med tillräcklig rollåtkomst, enligt definitionen i nästa steg.

- Rollåtkomst Om du vill tilldela en roll med nödvändiga behörigheter måste du ha behörigheten ägare eller Microsoft.Authorization/roleAssignments/write på resursen. Det kan ta flera minuter att uppdatera anslutningar och behörigheter. Dessa ytterligare roller måste tilldelas till din UAI:

- Resurs: Arbetsyta

- Roll: Azure Machine Learning-Dataforskare

- Anslutning till arbetsyta: Enligt den här vägledningen använder du en hanterad identitet som representerar autentiseringsuppgifterna för Azure OpenAI-slutpunkten som används för att beräkna övervakningsmåtten. Ta INTE bort anslutningen när den används i flödet.

- API-version: 2023-03-15-preview

- Distribution av promptflöde: Skapa en körning av promptflöde enligt den här vägledningen, kör ditt flöde och se till att distributionen har konfigurerats med hjälp av den här artikeln som en guide

- Flödesindata och utdata: Du måste namnge dina flödesutdata på rätt sätt och komma ihåg dessa kolumnnamn när du skapar övervakaren. I den här artikeln använder vi följande:

- Indata (krävs): "prompt"

- Utdata (krävs): "slutförande"

- Utdata (valfritt): "kontext" | "grund sanning"

- Datainsamling: i "Distribution" (steg 2 i guiden för distribution av promptflöde)måste växlingsknappen "slutsatsdragningsdatainsamling" aktiveras med hjälp av modelldatainsamlaren

- Utdata: I utdata (steg 3 i guiden för distribution av promptflöde) bekräftar du att du har valt de nödvändiga utdata som anges ovan (till exempel slutförande | kontext | ground_truth) som uppfyller dina krav för måttkonfiguration

- Flödesindata och utdata: Du måste namnge dina flödesutdata på rätt sätt och komma ihåg dessa kolumnnamn när du skapar övervakaren. I den här artikeln använder vi följande:

Kommentar

Om beräkningsinstansen ligger bakom ett virtuellt nätverk läser du Nätverksisolering i promptflöde.

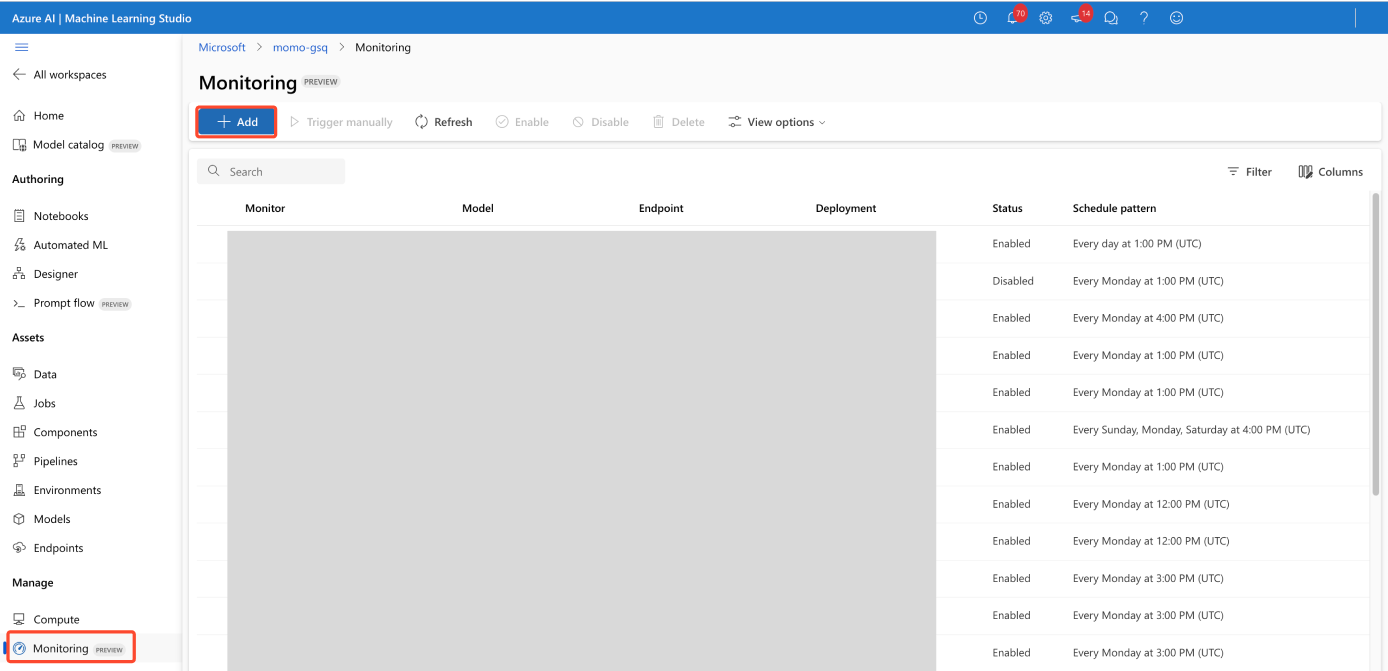

Skapa din övervakare

Skapa din övervakare på översiktssidan Övervakning

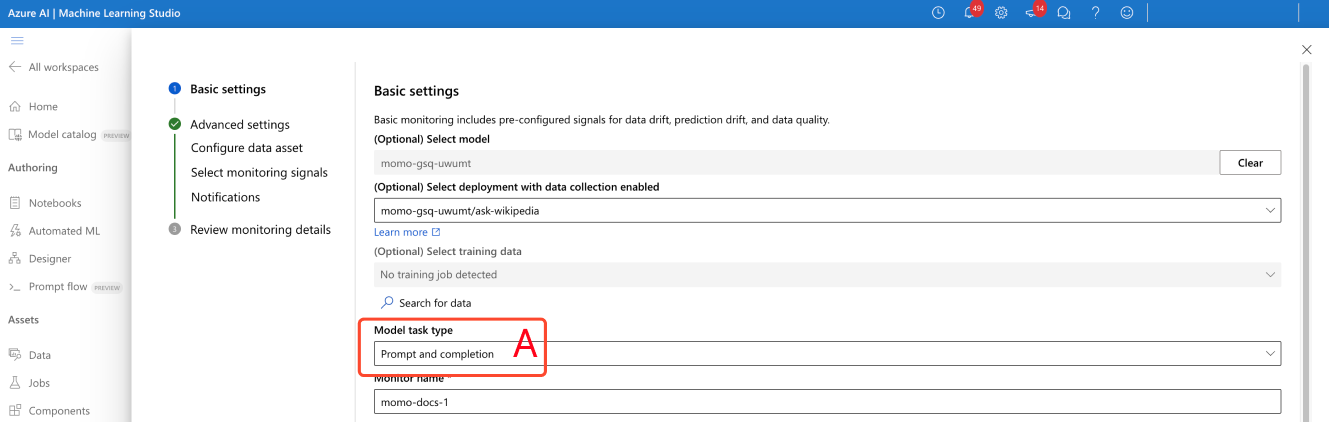

Konfigurera grundläggande övervakningsinställningar

I guiden för att skapa övervakning ändrar du modellaktivitetstypen till fråga och slutför, enligt (A) i skärmbilden.

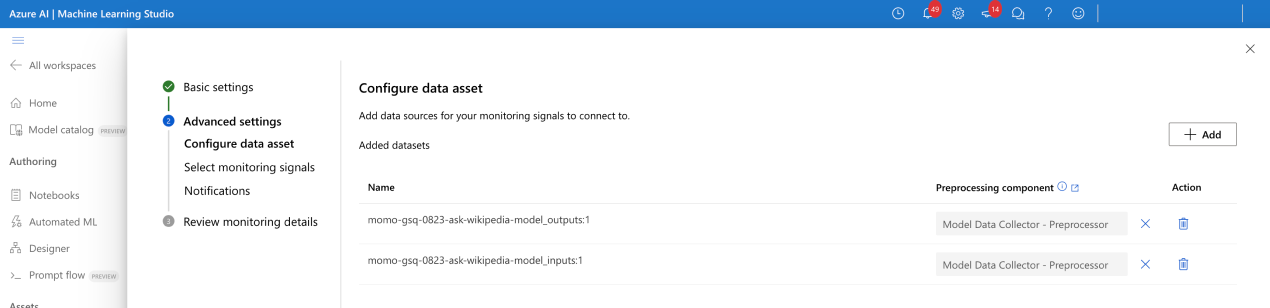

Konfigurera datatillgång

Om du har använt Model Data Collector väljer du dina två datatillgångar (indata och utdata).

Välj övervakningssignaler

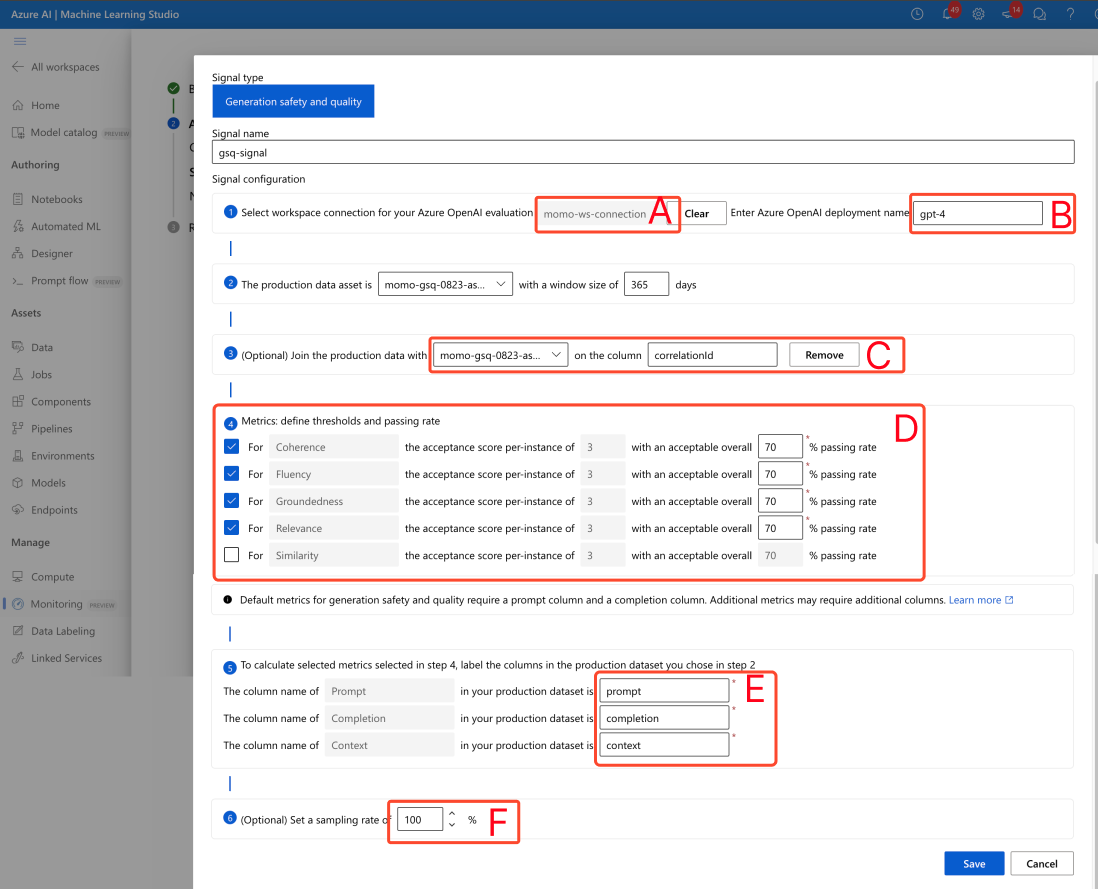

- Konfigurera anslutning till arbetsyta (A) på skärmbilden.

- Ange azure OpenAI-utvärderarens distributionsnamn (B)..

- (Valfritt) Anslut dina produktionsdataindata och utdata: dina indata och utdata för produktionsmodellen kopplas automatiskt av övervakningstjänsten (C).. Du kan anpassa detta om det behövs, men ingen åtgärd krävs. Som standard är kopplingskolumnen correlationid.

- (Valfritt) Konfigurera måtttrösklar: En acceptabel poäng per instans fastställs till 3/5. Du kan justera din acceptabla totala % överföringshastighet mellan intervallet [1,99] %

Ange kolumnnamn manuellt från ditt promptflöde (E). Standardnamn är ("prompt" | "slutförande" | "context" | "ground_truth") men du kan konfigurera den enligt din datatillgång.

(valfritt) Ange samplingsfrekvens (F)

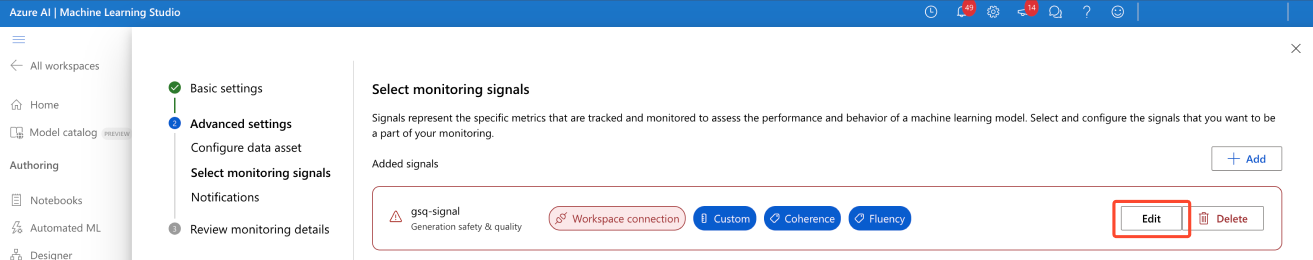

När signalen har konfigurerats visas inte längre en varning.

Konfigurera meddelanden

Ingen åtgärd krävs. Du kan konfigurera fler mottagare om det behövs.

Bekräfta konfiguration av övervakningssignaler

När den har konfigurerats bör övervakaren se ut så här:

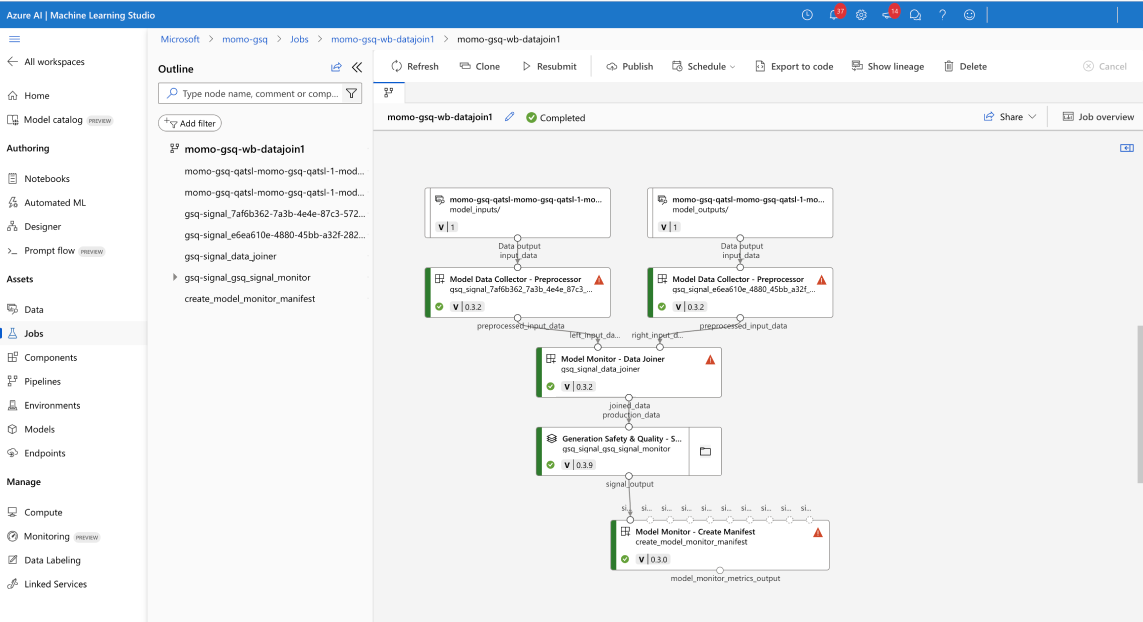

Bekräfta övervakningsstatus

Om det har konfigurerats visar ditt pipelinejobb för övervakning följande:

Använda resultat

Översiktssida för övervakning

Övervakningsöversikten ger en översikt över din signalprestanda. Du kan ange din signalinformationssida för mer information.

Signalinformationssida

På sidan med signalinformation kan du visa mått över tid (A) och visa histogram för distribution (B).

Lösa aviseringar

Det går bara att justera signaltrösklar. Den godtagbara poängen är fast vid 3/5 och det är bara möjligt att justera fältet "acceptabel övergripande % överföringshastighet".