Notas de versão arquivadas

Resumo

O Azure HDInsight é um dos serviços mais populares entre os clientes empresariais para análises de código aberto no Azure. Assine as Notas de versão do HDInsight para obter informações atualizadas sobre o HDInsight e todas as versões do HDInsight.

Para se inscrever, clique no botão "assistir" no banner e fique atento às versões do HDInsight.

Informações de lançamento

Data de lançamento: 22 Oct 2024

Nota

Esta é uma versão de hotfix/manutenção para o provedor de recursos. Para obter mais informações, consulte Provedor de recursos.

O Azure HDInsight lança periodicamente atualizações de manutenção para fornecer correções de bugs, aprimoramentos de desempenho e patches de segurança, garantindo que você se mantenha atualizado com essas atualizações, garantindo desempenho e confiabilidade ideais.

Esta nota de versão aplica-se a:

Versão do HDInsight 5.1.

Versão do HDInsight 5.0.

Versão do HDInsight 4.0.

A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta nota de versão é aplicável ao número 2409240625 imagem. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

O Ubuntu 18.04 é suportado em Manutenção de Segurança Estendida (ESM) pela equipe do Azure Linux para o Azure HDInsight de julho de 2023, lançamento em diante.

Para versões específicas da carga de trabalho, consulte Versões de componentes do HDInsight 5.x.

Atualizado

Suporte à autenticação baseada em MSI disponível para o armazenamento de blobs do Azure.

- O Azure HDInsight agora dá suporte à autenticação baseada em OAuth para acessar o armazenamento de Blob do Azure aproveitando o Azure Ative Directory (AAD) e as identidades gerenciadas (MSI). Com esse aprimoramento, o HDInsight usa identidades gerenciadas atribuídas pelo usuário para acessar o armazenamento de blob do Azure. Para obter mais informações, consulte Identidades gerenciadas para recursos do Azure.

O serviço HDInsight fez a transição para usar balanceadores de carga padrão para todas as suas configurações de cluster devido ao anúncio de substituição do balanceador de carga básico do Azure.

Nota

Esta alteração está disponível em todas as regiões. Recrie o cluster para consumir essa alteração. Para obter assistência, entre em contato com o suporte.

Importante

Ao usar sua própria Rede Virtual (VNet personalizada) durante a criação do cluster, esteja ciente de que a criação do cluster não terá êxito quando essa alteração for habilitada. Recomendamos consultar o guia de migração para recriar o cluster. Para obter assistência, entre em contato com o suporte.

Brevemente

Brevemente

Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Básica e Padrão. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs).

- Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

Notificações de desativação para HDInsight 4.0 e HDInsight 5.0.

Se tiver mais alguma dúvida, contacte o Suporte do Azure.

Você sempre pode nos perguntar sobre o HDInsight no Azure HDInsight - Perguntas e respostas da Microsoft.

Estamos ouvindo: Você pode adicionar mais ideias e outros tópicos aqui e votar neles - Ideias do HDInsight e siga-nos para obter mais atualizações na Comunidade AzureHDInsight.

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Práticas recomendadas.

Data de lançamento: 30 Aug 2024

Nota

Esta é uma versão de hotfix/manutenção para o provedor de recursos. Para obter mais informações, consulte Provedor de recursos.

O Azure HDInsight lança periodicamente atualizações de manutenção para fornecer correções de bugs, aprimoramentos de desempenho e patches de segurança, garantindo que você se mantenha atualizado com essas atualizações, garantindo desempenho e confiabilidade ideais.

Esta nota de versão aplica-se a:

Versão do HDInsight 5.1.

Versão do HDInsight 5.0.

Versão do HDInsight 4.0.

A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta nota de versão é aplicável para o número 2407260448 de imagem. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

O Ubuntu 18.04 é suportado em Manutenção de Segurança Estendida (ESM) pela equipe do Azure Linux para o Azure HDInsight de julho de 2023, lançamento em diante.

Para versões específicas da carga de trabalho, consulte Versões de componentes do HDInsight 5.x.

Problema corrigido

- Correção de bug de banco de dados padrão.

Brevemente

-

Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Básica e Padrão. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs).

- Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

- Notificações de desativação para HDInsight 4.0 e HDInsight 5.0.

Se tiver mais alguma dúvida, contacte o Suporte do Azure.

Você sempre pode nos perguntar sobre o HDInsight no Azure HDInsight - Perguntas e respostas da Microsoft.

Estamos ouvindo: Você pode adicionar mais ideias e outros tópicos aqui e votar neles - Ideias do HDInsight e siga-nos para obter mais atualizações na Comunidade AzureHDInsight.

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Melhores práticas.

Data de lançamento: Aug 09, 2024

Esta nota de versão aplica-se a:

Versão do HDInsight 5.1.

Versão do HDInsight 5.0.

Versão do HDInsight 4.0.

A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta nota de versão é aplicável para o número 2407260448 de imagem. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

O Ubuntu 18.04 é suportado em Manutenção de Segurança Estendida (ESM) pela equipe do Azure Linux para o Azure HDInsight de julho de 2023, lançamento em diante.

Para versões específicas da carga de trabalho, consulte Versões de componentes do HDInsight 5.x.

Atualizações

Adição do Azure Monitor Agent for Log Analytics no HDInsight

Adição e DCR automatizado para análise de SystemMSI log, dada a preterição da experiência do Novo Azure Monitor (visualização).

Nota

Número de imagem efetivo 2407260448, os clientes que usam o portal para análise de log terão experiência padrão do Azure Monitor Agent . Caso deseje mudar para a experiência do Azure Monitor (visualização), você pode fixar seus clusters em imagens antigas criando uma solicitação de suporte.

Data de lançamento: 05 jul 2024

Nota

Esta é uma versão de hotfix/manutenção para o provedor de recursos. Para obter mais informações, consulte Provedor de Recursos

Problemas corrigidos

As tags HOBO substituem as tags de usuário.

- As tags HOBO substituem as tags de usuário em subrecursos na criação de cluster HDInsight.

Data de lançamento: 19 jun 2024

Esta nota de versão aplica-se a:

Versão do HDInsight 5.1.

Versão do HDInsight 5.0.

Versão do HDInsight 4.0.

A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta nota de versão é aplicável para o número de imagem 2406180258. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

O Ubuntu 18.04 é suportado em Manutenção de Segurança Estendida (ESM) pela equipe do Azure Linux para o Azure HDInsight de julho de 2023, lançamento em diante.

Para versões específicas da carga de trabalho, consulte Versões de componentes do HDInsight 5.x.

Problemas corrigidos

Melhorias de segurança

- Melhorias no uso de tags para clusters de acordo com os requisitos SFI .

- Melhorias nos scripts de testes de acordo com os requisitos SFI .

Melhorias na Análise de Log do HDInsight com suporte de Identidade Gerenciada pelo Sistema para o Provedor de Recursos do HDInsight.

Adição de nova atividade para atualizar a versão do agente para imagem

mdsdantiga (criada antes de 2024).Habilitando o MISE no gateway como parte das melhorias contínuas para a migração MSAL.

Incorpore o Spark Thrift Server

Httpheader hiveConfao Jetty HTTP ConnectionFactory.Reverta RANGER-3753 e RANGER-3593.

A

setOwnerUserimplementação dada na versão Ranger 2.3.0 tem um problema de regressão crítica ao ser usada pelo Hive. No Ranger 2.3.0, quando o HiveServer2 tenta avaliar as políticas, o Ranger Client tenta obter o proprietário da tabela hive chamando o Metastore na função setOwnerUser que essencialmente faz chamada para o armazenamento para verificar o acesso a essa tabela. Esse problema faz com que as consultas sejam executadas lentamente quando o Hive é executado no Ranger 2.3.0.

Novas regiões adicionadas

- Norte da Itália

- Israel Central

- Espanha Central

- México Central

- Jio Índia Central

Adicionar às Notas do Arquivo de junho de 2024

Brevemente

-

Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Básica e Padrão. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs).

- Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

- Notificações de desativação para HDInsight 4.0 e HDInsight 5.0.

Se tiver mais alguma dúvida, contacte o Suporte do Azure.

Você sempre pode nos perguntar sobre o HDInsight no Azure HDInsight - Perguntas e respostas da Microsoft.

Estamos ouvindo: Você pode adicionar mais ideias e outros tópicos aqui e votar neles - Ideias do HDInsight e siga-nos para obter mais atualizações na Comunidade AzureHDInsight.

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Melhores práticas.

Data de lançamento: 16 de maio de 2024

Esta nota de versão aplica-se a:

Versão do HDInsight 5.0.

Versão do HDInsight 4.0.

A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta nota de versão é aplicável ao número 2405081840 imagem. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

O Ubuntu 18.04 é suportado em Manutenção de Segurança Estendida (ESM) pela equipe do Azure Linux para o Azure HDInsight de julho de 2023, lançamento em diante.

Para versões específicas da carga de trabalho, consulte Versões de componentes do HDInsight 5.x.

Problemas corrigidos

- API adicionada no gateway para obter token para Keyvault, como parte da iniciativa SFI.

- Na nova tabela Monitor de log

HDInsightSparkLogs, para o tipoSparkDriverLogde log, alguns dos campos estavam faltando. Por exemplo,LogLevel & Message. Esta versão adiciona os campos ausentes aos esquemas e a formatação fixa paraSparkDriverLogo . - Os logs do Livy não estão disponíveis na tabela de monitoramento do

SparkDriverLogLog Analytics, que foi devido a um problema com o caminho de origem do log do Livy e o regex de análise de log nasSparkLivyLogconfigurações. - Qualquer cluster HDInsight, usando o ADLS Gen2 como uma conta de armazenamento principal, pode aproveitar o acesso baseado em MSI a qualquer um dos recursos do Azure (por exemplo, SQL, Keyvaults) que é usado no código do aplicativo.

Brevemente

-

Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Básica e Padrão. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs).

- Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

- Notificações de desativação para HDInsight 4.0 e HDInsight 5.0.

Se tiver mais alguma dúvida, contacte o Suporte do Azure.

Você sempre pode nos perguntar sobre o HDInsight no Azure HDInsight - Perguntas e respostas da Microsoft.

Estamos ouvindo: Você pode adicionar mais ideias e outros tópicos aqui e votar neles - Ideias do HDInsight e siga-nos para obter mais atualizações na Comunidade AzureHDInsight.

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Melhores práticas.

Data de lançamento: 15 de abril de 2024

Esta nota de versão aplica-se à versão 5.1 do HDInsight.

A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta nota de versão é aplicável para o número 2403290825 de imagem. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

O Ubuntu 18.04 é suportado em Manutenção de Segurança Estendida (ESM) pela equipe do Azure Linux para o Azure HDInsight de julho de 2023, lançamento em diante.

Para versões específicas da carga de trabalho, consulte Versões de componentes do HDInsight 5.x.

Problemas corrigidos

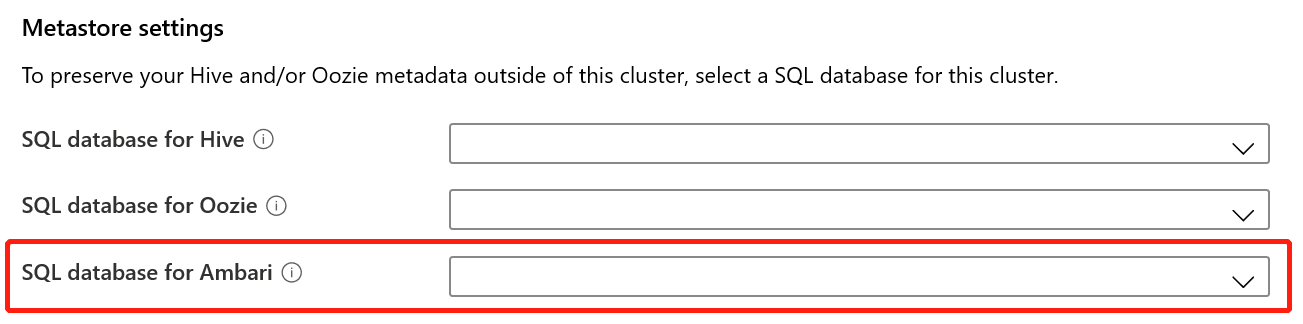

- Correções de bugs para Ambari DB, Hive Warehouse Controller (HWC), Spark, HDFS

- Correções de bugs para o módulo de análise de log para HDInsightSparkLogs

- Correções CVE para o Provedor de Recursos do HDInsight.

Brevemente

-

Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Básica e Padrão. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs).

- Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

- Notificações de desativação para HDInsight 4.0 e HDInsight 5.0.

Se tiver mais alguma dúvida, contacte o Suporte do Azure.

Você sempre pode nos perguntar sobre o HDInsight no Azure HDInsight - Perguntas e respostas da Microsoft.

Estamos ouvindo: Você pode adicionar mais ideias e outros tópicos aqui e votar neles - Ideias do HDInsight e siga-nos para obter mais atualizações na Comunidade AzureHDInsight.

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Melhores práticas.

Data de lançamento: 15 de fevereiro de 2024

Esta versão aplica-se às versões 4.x e 5.x do HDInsight. A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta versão é aplicável para o número de imagem 2401250802. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

O Ubuntu 18.04 é suportado em Manutenção de Segurança Estendida (ESM) pela equipe do Azure Linux para o Azure HDInsight de julho de 2023, lançamento em diante.

Para versões específicas da carga de trabalho, consulte

Novas funcionalidades

- Suporte do Apache Ranger para Spark SQL no Spark 3.3.0 (HDInsight versão 5.1) com pacote de segurança Enterprise. Saiba mais sobre o assunto aqui.

Problemas corrigidos

- Correções de segurança dos componentes Ambari e Oozie

Brevemente

Brevemente

- Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Básica e Padrão. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs).

- Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

Se tiver mais alguma dúvida, contacte o Suporte do Azure.

Você sempre pode nos perguntar sobre o HDInsight no Azure HDInsight - Perguntas e respostas da Microsoft

Estamos ouvindo: Você pode adicionar mais ideias e outros tópicos aqui e votar neles - Ideias do HDInsight e siga-nos para obter mais atualizações na Comunidade AzureHDInsight

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Melhores práticas.

Próximos passos

- Azure HDInsight: Frequently asked questions (Autenticação Pass-through: Perguntas mais frequentes)

- Configurar o agendamento da aplicação de patches do SO para clusters do HDInsight baseados em Linux

- Nota de lançamento anterior

O Azure HDInsight é um dos serviços mais populares entre os clientes empresariais para análises de código aberto no Azure. Se você gostaria de se inscrever em notas de versão, assista aos lançamentos neste repositório GitHub.

Data de lançamento: 10 de janeiro de 2024

Esta versão de hotfix se aplica às versões do HDInsight 4.x e 5.x. A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta versão é aplicável para o número de imagem 2401030422. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Nota

O Ubuntu 18.04 é suportado em Manutenção de Segurança Estendida (ESM) pela equipe do Azure Linux para o Azure HDInsight de julho de 2023, lançamento em diante.

Para versões específicas da carga de trabalho, consulte

Problemas corrigidos

- Correções de segurança dos componentes Ambari e Oozie

Brevemente

Brevemente

- Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Básica e Padrão. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs).

- Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

Se tiver mais alguma dúvida, contacte o Suporte do Azure.

Você sempre pode nos perguntar sobre o HDInsight no Azure HDInsight - Perguntas e respostas da Microsoft

Estamos ouvindo: Você pode adicionar mais ideias e outros tópicos aqui e votar neles - Ideias do HDInsight e siga-nos para obter mais atualizações na Comunidade AzureHDInsight

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Melhores práticas.

Data de lançamento: 26 de outubro de 2023

Esta versão aplica-se ao HDInsight 4.x e 5.x A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta versão é aplicável para o número de imagem 2310140056. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Para versões específicas da carga de trabalho, consulte

Novidades

O HDInsight anuncia a disponibilidade geral do HDInsight 5.1 a partir de 1º de novembro de 2023. Esta versão traz uma atualização de pilha completa para os componentes de código aberto e as integrações da Microsoft.

- Últimas versões de código aberto – O HDInsight 5.1 vem com a última versão estável de código aberto disponível. Os clientes podem se beneficiar de todos os recursos de código aberto mais recentes, melhorias de desempenho da Microsoft e correções de bugs.

- Seguro – As versões mais recentes vêm com as correções de segurança mais recentes, correções de segurança de código aberto e melhorias de segurança da Microsoft.

- TCO mais baixo – Com melhorias de desempenho, os clientes podem reduzir o custo operacional, juntamente com o dimensionamento automático aprimorado.

Permissões de cluster para armazenamento seguro

- Os clientes podem especificar (durante a criação do cluster) se um canal seguro deve ser usado para que os nós do cluster HDInsight conectem a conta de armazenamento.

Criação de cluster HDInsight com redes virtuais personalizadas.

- Para melhorar a postura geral de segurança dos clusters HDInsight, os clusters HDInsight que usam VNETs personalizadas precisam garantir que o usuário precise ter permissão para

Microsoft Network/virtualNetworks/subnets/join/actionexecutar operações de criação. O cliente pode enfrentar falhas de criação se essa verificação não estiver habilitada.

- Para melhorar a postura geral de segurança dos clusters HDInsight, os clusters HDInsight que usam VNETs personalizadas precisam garantir que o usuário precise ter permissão para

Clusters do ABFS não ESP [Permissões de Cluster para Word Readable]

- Os clusters ABFS não-ESP restringem os usuários do grupo não-Hadoop de executar comandos Hadoop para operações de armazenamento. Essa alteração melhora a postura de segurança do cluster.

Atualização de cota in-line.

- Agora você pode solicitar o aumento da cota diretamente da página Minha cota, com a chamada direta da API é muito mais rápido. Caso a chamada de API falhe, você pode criar uma nova solicitação de suporte para aumento de cota.

Brevemente

Brevemente

O comprimento máximo do nome do cluster será alterado de 59 para 49 carateres, para melhorar a postura de segurança dos clusters. Esta alteração será implementada em todas as regiões a partir da próxima versão.

Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Básica e Padrão. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs).

- Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

Se tiver mais alguma dúvida, contacte o Suporte do Azure.

Você sempre pode nos perguntar sobre o HDInsight no Azure HDInsight - Perguntas e respostas da Microsoft

Estamos ouvindo: Você pode adicionar mais ideias e outros tópicos aqui e votar neles - Ideias do HDInsight e siga-nos para obter mais atualizações na Comunidade AzureHDInsight

Nota

Esta versão aborda os seguintes CVEs lançados pelo MSRC em 12 de setembro de 2023. A ação é atualizar para a imagem mais recente 2308221128 ou 2310140056. Os clientes são aconselhados a planear em conformidade.

| CVE | Gravidade | Título da CVE | Observação |

|---|---|---|---|

| CVE-2023-38156 | Importante | Vulnerabilidade de Elevação de Privilégio do Azure HDInsight Apache Ambari | Incluído na imagem 2308221128 ou 2310140056 |

| CVE-2023-36419 | Importante | Vulnerabilidade de Elevação de Privilégio do Scheduler de Fluxo de Trabalho Apache Oozie do Azure HDInsight | Aplique uma ação de script nos seus clusters ou atualize para a imagem 2310140056 |

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Melhores práticas.

Data de lançamento: 7 de setembro de 2023

Esta versão aplica-se ao HDInsight 4.x e 5.x A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta versão é aplicável para o número de imagem 2308221128. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Para versões específicas da carga de trabalho, consulte

Importante

Esta versão aborda os seguintes CVEs lançados pelo MSRC em 12 de setembro de 2023. A ação é atualizar para a imagem mais recente 2308221128. Os clientes são aconselhados a planear em conformidade.

| CVE | Gravidade | Título da CVE | Observação |

|---|---|---|---|

| CVE-2023-38156 | Importante | Vulnerabilidade de Elevação de Privilégio do Azure HDInsight Apache Ambari | Incluído na imagem 2308221128 |

| CVE-2023-36419 | Importante | Vulnerabilidade de Elevação de Privilégio do Scheduler de Fluxo de Trabalho Apache Oozie do Azure HDInsight | Aplicar ação de Script em seus clusters |

Brevemente

- O comprimento máximo do nome do cluster será alterado de 59 para 49 carateres, para melhorar a postura de segurança dos clusters. Esta alteração será implementada até 30 de setembro de 2023.

- Permissões de cluster para armazenamento seguro

- Os clientes podem especificar (durante a criação do cluster) se um canal seguro deve ser usado para que os nós do cluster HDInsight entrem em contato com a conta de armazenamento.

- Atualização de cota in-line.

- As cotas de solicitação aumentam diretamente da página Minha Cota, que será uma chamada direta de API, que é mais rápida. Se a chamada APdI falhar, os clientes precisarão criar uma nova solicitação de suporte para aumento de cota.

- Criação de cluster HDInsight com redes virtuais personalizadas.

- Para melhorar a postura geral de segurança dos clusters HDInsight, os clusters HDInsight que usam VNETs personalizadas precisam garantir que o usuário precise ter permissão para

Microsoft Network/virtualNetworks/subnets/join/actionexecutar operações de criação. Os clientes precisariam planejar de acordo, pois essa mudança seria uma verificação obrigatória para evitar falhas de criação de cluster antes de 30 de setembro de 2023.

- Para melhorar a postura geral de segurança dos clusters HDInsight, os clusters HDInsight que usam VNETs personalizadas precisam garantir que o usuário precise ter permissão para

- Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Básica e Padrão. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs). Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

- Clusters ABFS não ESP [Permissões de cluster para Word legível]

- Planeje introduzir uma alteração nos clusters ABFS não ESP, que restringe os usuários que não são do grupo Hadoop de executar comandos Hadoop para operações de armazenamento. Essa alteração para melhorar a postura de segurança do cluster. Os clientes têm de planear as atualizações antes de 30 de setembro de 2023.

Se tiver mais alguma dúvida, contacte o Suporte do Azure.

Você sempre pode nos perguntar sobre o HDInsight no Azure HDInsight - Perguntas e respostas da Microsoft

Você está convidado a adicionar mais propostas e ideias e outros tópicos aqui e votar neles - Comunidade HDInsight (azure.com).

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Melhores práticas.

Data de lançamento: 25 de julho de 2023

Esta versão aplica-se ao HDInsight 4.x e 5.x A versão do HDInsight estará disponível para todas as regiões durante vários dias. Esta versão é aplicável para o número de imagem 2307201242. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Para versões específicas da carga de trabalho, consulte

O que há de novo

O que há de novo

- O HDInsight 5.1 agora é compatível com o cluster ESP.

- As versões atualizadas do Ranger 2.3.0 e do Oozie 5.2.1 agora fazem parte do HDInsight 5.1

- O cluster Spark 3.3.1 (HDInsight 5.1) vem com o Hive Warehouse Connector (HWC) 2.1, que funciona em conjunto com o cluster de Consulta Interativa (HDInsight 5.1).

- O Ubuntu 18.04 é suportado no ESM (Extended Security Maintenance) pela equipe do Azure Linux para o Azure HDInsight de julho de 2023, lançamento em diante.

Importante

Esta versão aborda os seguintes CVEs lançados pelo MSRC em 8 de agosto de 2023. A ação é atualizar para a imagem mais recente 2307201242. Os clientes são aconselhados a planear em conformidade.

| CVE | Gravidade | Título da CVE |

|---|---|---|

| CVE-2023-35393 | Importante | Vulnerabilidade de falsificação do Azure Apache Hive |

| CVE-2023-35394 | Importante | Vulnerabilidade de falsificação do Notebook do Azure HDInsight Jupyter |

| CVE-2023-36877 | Importante | Vulnerabilidade de falsificação do Azure Apache Oozie |

| CVE-2023-36881 | Importante | Vulnerabilidade de falsificação do Azure Apache Ambari |

| CVE-2023-38188 | Importante | Vulnerabilidade de falsificação do Azure Apache Hadoop |

Brevemente

Brevemente

- O comprimento máximo do nome do cluster será alterado de 59 para 49 carateres, para melhorar a postura de segurança dos clusters. Os clientes precisam planejar as atualizações antes de 30 de setembro de 2023.

- Permissões de cluster para armazenamento seguro

- Os clientes podem especificar (durante a criação do cluster) se um canal seguro deve ser usado para que os nós do cluster HDInsight entrem em contato com a conta de armazenamento.

- Atualização de cota in-line.

- As cotas de solicitação aumentam diretamente da página Minha Cota, que será uma chamada direta de API, que é mais rápida. Se a chamada de API falhar, os clientes precisarão criar uma nova solicitação de suporte para aumento de cota.

- Criação de cluster HDInsight com redes virtuais personalizadas.

- Para melhorar a postura geral de segurança dos clusters HDInsight, os clusters HDInsight que usam VNETs personalizadas precisam garantir que o usuário precise ter permissão para

Microsoft Network/virtualNetworks/subnets/join/actionexecutar operações de criação. Os clientes precisariam planejar de acordo, pois essa mudança seria uma verificação obrigatória para evitar falhas na criação de clusters antes de 30 de setembro de 2023.

- Para melhorar a postura geral de segurança dos clusters HDInsight, os clusters HDInsight que usam VNETs personalizadas precisam garantir que o usuário precise ter permissão para

- Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Basic e Standard. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs). Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

- Clusters ABFS não ESP [Permissões de cluster para Word legível]

- Planeje introduzir uma alteração nos clusters ABFS não ESP, que restringe os usuários que não são do grupo Hadoop de executar comandos Hadoop para operações de armazenamento. Essa alteração para melhorar a postura de segurança do cluster. Os clientes precisam planejar as atualizações antes de 30 de setembro de 2023.

Se tiver mais alguma dúvida, contacte o Suporte do Azure.

Você sempre pode nos perguntar sobre o HDInsight no Azure HDInsight - Perguntas e respostas da Microsoft

Você está convidado a adicionar mais propostas e ideias e outros tópicos aqui e votar neles - Comunidade HDInsight (azure.com) e siga-nos para mais atualizações sobre o X

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Melhores práticas.

Data de lançamento: 08 de maio de 2023

Esta versão aplica-se ao HDInsight 4.x e 5.x A versão do HDInsight está disponível para todas as regiões durante vários dias. Esta versão é aplicável para o número de imagem 2304280205. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Para versões específicas da carga de trabalho, consulte

![]()

Azure HDInsight 5.1 atualizado com

- Apache HBase 2.4.11

- Apache Phoenix 5.1.2

- Apache Hive 3.1.2

- Apache Spark 3.3.1

- Apache Tez 0.9.1

- Apache Zeppelin 0.10.1

- Apache Livy 0,5

- Apache Kafka 3.2.0

Nota

- Todos os componentes são integrados com Hadoop 3.3.4 & ZK 3.6.3

- Todos os componentes atualizados acima estão agora disponíveis em clusters não-ESP para visualização pública.

![]()

Dimensionamento automático aprimorado para HDInsight

O Azure HDInsight fez melhorias notáveis na estabilidade e latência no Autoscale, As alterações essenciais incluem loop de feedback aprimorado para decisões de escala, melhoria significativa na latência para dimensionamento e suporte para recomissionamento dos nós desativados, Saiba mais sobre os aprimoramentos, como configurar e migrar seu cluster para dimensionamento automático aprimorado. A capacidade de dimensionamento automático aprimorada está disponível a partir de 17 de maio de 2023 em todas as regiões suportadas.

O Azure HDInsight ESP para Apache Kafka 2.4.1 agora está disponível ao público em geral.

O Azure HDInsight ESP para Apache Kafka 2.4.1 está em pré-visualização pública desde abril de 2022. Após melhorias notáveis nas correções de CVE e estabilidade, o Azure HDInsight ESP Kafka 2.4.1 agora se torna geralmente disponível e pronto para cargas de trabalho de produção, saiba os detalhes sobre como configurar e migrar.

Gerenciamento de cotas para o HDInsight

Atualmente, o HDInsight aloca cotas para assinaturas de clientes em nível regional. Os núcleos atribuídos aos clientes são genéricos e não são classificados ao nível da família VM (por exemplo,

Dv2, ,Ev3Eav4, etc.).O HDInsight introduziu uma exibição aprimorada, que fornece detalhes e classificação de cotas para VMs de nível familiar, esse recurso permite que os clientes visualizem as cotas atuais e restantes para uma região no nível da família de VMs. Com a visão aprimorada, os clientes têm visibilidade mais rica, para planejar cotas e uma melhor experiência do usuário. Esse recurso está atualmente disponível no HDInsight 4.x e 5.x para a região EUAP Leste dos EUA. Outras regiões a seguir mais tarde.

Para obter mais informações, consulte Planejamento de capacidade de cluster no Azure HDInsight | Microsoft Learn

![]()

- Polónia Central

- O comprimento máximo do nome do cluster muda de 59 caracteres para 45, para melhorar a postura de segurança dos clusters.

- Permissões de cluster para armazenamento seguro

- Os clientes podem especificar (durante a criação do cluster) se um canal seguro deve ser usado para que os nós do cluster HDInsight entrem em contato com a conta de armazenamento.

- Atualização de cota in-line.

- As cotas de solicitação aumentam diretamente da página Minha cota, que é uma chamada direta de API, que é mais rápida. Se a chamada de API falhar, os clientes precisarão criar uma nova solicitação de suporte para aumento de cota.

- Criação de cluster HDInsight com redes virtuais personalizadas.

- Para melhorar a postura geral de segurança dos clusters HDInsight, os clusters HDInsight que usam VNETs personalizadas precisam garantir que o usuário precise ter permissão para

Microsoft Network/virtualNetworks/subnets/join/actionexecutar operações de criação. Os clientes precisariam planejar de acordo, pois essa seria uma verificação obrigatória para evitar falhas na criação de clusters.

- Para melhorar a postura geral de segurança dos clusters HDInsight, os clusters HDInsight que usam VNETs personalizadas precisam garantir que o usuário precise ter permissão para

- Aposentadoria de VMs básicas e padrão da série A.

- Em 31 de agosto de 2024, aposentaremos as VMs das séries A Basic e Standard. Antes dessa data, você precisa migrar suas cargas de trabalho para VMs da série Av2, que fornecem mais memória por vCPU e armazenamento mais rápido em unidades de estado sólido (SSDs). Para evitar interrupções de serviço, migre suas cargas de trabalho de VMs das séries A Básica e Standard para VMs da série Av2 antes de 31 de agosto de 2024.

- Clusters ABFS não-ESP [Permissões de cluster para leitura mundial]

- Planeje introduzir uma alteração nos clusters ABFS não ESP, que restringe os usuários que não são do grupo Hadoop de executar comandos Hadoop para operações de armazenamento. Essa alteração para melhorar a postura de segurança do cluster. Os clientes precisam planejar as atualizações.

Data de lançamento: 28 de fevereiro de 2023

Esta versão aplica-se ao HDInsight 4.0. e 5.0, 5.1. A versão do HDInsight está disponível para todas as regiões durante vários dias. Esta versão é aplicável para o número de imagem 2302250400. Como verificar o número da imagem?

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Para versões específicas da carga de trabalho, consulte

Importante

A Microsoft emitiu o CVE-2023-23408, que é corrigido na versão atual e os clientes são aconselhados a atualizar seus clusters para a imagem mais recente.

![]()

HDInsight 5.1

Começamos a lançar uma nova versão do HDInsight 5.1. Todas as novas versões de código aberto adicionadas como versões incrementais no HDInsight 5.1.

Para obter mais informações, consulte HDInsight versão 5.1.0

![]()

Atualização do Kafka 3.2.0 (Visualização)

- Kafka 3.2.0 inclui vários novos recursos significativos / melhorias.

- Zookeeper atualizado para 3.6.3

- Suporte Kafka Streams

- Garantias de entrega mais fortes para o produtor de Kafka habilitadas por defeito.

-

log4j1.x substituído porreload4j. - Envie uma dica para o líder da partição para recuperar a partição.

-

JoinGroupRequesteLeaveGroupRequestter um motivo anexado. - Adicionadas métricas de contagem de corretores8.

- Melhorias no espelho

Maker2.

Atualização do HBase 2.4.11 (Visualização)

- Esta versão tem novos recursos, como a adição de novos tipos de mecanismo de cache para cache de bloco, a capacidade de alterar

hbase:meta tablee visualizar ahbase:metatabela a partir da interface do usuário WEB do HBase.

Atualização Phoenix 5.1.2 (Pré-visualização)

- Versão Phoenix atualizada para 5.1.2 nesta versão. Esta atualização inclui o Phoenix Query Server. O Phoenix Query Server faz o proxy do driver JDBC Phoenix padrão e fornece um protocolo de conexão compatível com versões anteriores para invocar esse driver JDBC.

Ambari CVEs

- Vários CVEs Ambari são corrigidos.

Nota

O ESP não é suportado para Kafka e HBase nesta versão.

![]()

O que se segue

- Dimensionamento automático

- Dimensionamento automático com latência melhorada e várias melhorias

- Limitação de alteração de nome de cluster

- O comprimento máximo do nome do cluster muda de 59 para 45 em Público, Azure China e Azure Government.

- Permissões de cluster para armazenamento seguro

- Os clientes podem especificar (durante a criação do cluster) se um canal seguro deve ser usado para que os nós do cluster HDInsight entrem em contato com a conta de armazenamento.

- Clusters ABFS não-ESP [Permissões de cluster para leitura mundial]

- Planeje introduzir uma alteração nos clusters ABFS não ESP, que restringe os usuários que não são do grupo Hadoop de executar comandos Hadoop para operações de armazenamento. Essa alteração para melhorar a postura de segurança do cluster. Os clientes precisam planejar as atualizações.

- Atualizações de código aberto

- O Apache Spark 3.3.0 e o Hadoop 3.3.4 estão em desenvolvimento no HDInsight 5.1 e incluem vários novos recursos significativos, desempenho e outras melhorias.

Nota

Aconselhamos os clientes a usar as versões mais recentes do HDInsight Images , pois elas trazem o melhor das atualizações de código aberto, atualizações do Azure e correções de segurança. Para obter mais informações, consulte Melhores práticas.

Data de lançamento: 12 de dezembro de 2022

Esta versão aplica-se ao HDInsight 4.0. e a versão 5.0 do HDInsight é disponibilizada para todas as regiões durante vários dias.

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

Versões do SO

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

![]()

- Log Analytics - Os clientes podem habilitar o monitoramento clássico para obter a versão 14.19 mais recente do OMS. Para remover versões antigas, desative e habilite o monitoramento clássico.

- Sair automaticamente da interface do usuário do Ambari devido à inatividade. Para mais informações, consulte aqui

- Spark - Uma versão nova e otimizada do Spark 3.1.3 está incluída nesta versão. Testamos o Apache Spark 3.1.2 (versão anterior) e o Apache Spark 3.1.3 (versão atual) usando o benchmark TPC-DS. O teste foi realizado usando E8 V3 SKU, para Apache Spark em carga de trabalho de 1 TB. O Apache Spark 3.1.3 (versão atual) superou o Apache Spark 3.1.2 (versão anterior) em mais de 40% no tempo total de execução de consultas para consultas TPC-DS usando as mesmas especificações de hardware. A equipe do Microsoft Spark adicionou otimizações disponíveis no Azure Synapse com o Azure HDInsight. Para obter mais informações, consulte Acelerar suas cargas de trabalho de dados com atualizações de desempenho para o Apache Spark 3.1.2 no Azure Synapse

![]()

- Catar Central

- Norte da Alemanha

![]()

O HDInsight se afastou do Azul Zulu Java JDK 8 para

Adoptium Temurin JDK 8o , que suporta tempos de execução certificados TCK de alta qualidade e tecnologia associada para uso em todo o ecossistema Java.O HDInsight migrou para o

reload4j. Aslog4jalterações aplicam-se a:- Apache Hadoop

- Apache Zookeeper

- Apache Oozie

- Apache Ranger

- Apache Sqoop

- Apache Pig

- Apache Ambari

- Apache Kafka

- Apache Spark

- Apache Zeppelin

- Apache Lívio

- Apache Rubix

- Apache Hive

- Apache Tez

- Apache HBase

- OMI

- Apache Pheonix

![]()

O HDInsight para implementar o TLS1.2 no futuro, e as versões anteriores são atualizadas na plataforma. Se você estiver executando aplicativos sobre o HDInsight e eles usarem TLS 1.0 e 1.1, atualize para o TLS 1.2 para evitar qualquer interrupção nos serviços.

Para obter mais informações, consulte Como habilitar o Transport Layer Security (TLS)

![]()

Fim do suporte para clusters do Azure HDInsight no Ubuntu 16.04 LTS a partir de 30 de novembro de 2022. HDInsight começa a liberação de imagens de cluster usando o Ubuntu 18.04 a partir de 27 de junho de 2021. Recomendamos que nossos clientes que estão executando clusters usando o Ubuntu 16.04 reconstruam seus clusters com as imagens HDInsight mais recentes até 30 de novembro de 2022.

Para obter mais informações sobre como verificar a versão Ubuntu do cluster, veja aqui

Execute o comando "lsb_release -a" no terminal.

Se o valor da propriedade "Description" na saída for "Ubuntu 16.04 LTS", então esta atualização é aplicável ao cluster.

![]()

- Suporte para seleção de zonas de disponibilidade para clusters Kafka e HBase (acesso de gravação).

Correções de bugs de código aberto

Correções de bugs do Hive

| Correções de Erros | Apache JIRA |

|---|---|

| VIH-26127 | Erro INSERT OVERWRITE - Arquivo não encontrado |

| VIH-24957 | Resultados errados quando a subconsulta tem COALESCE no predicado de correlação |

| VIH-24999 | HiveSubQueryRemoveRule gera um plano inválido para a subconsulta IN com várias correlações |

| VIH-24322 | Se houver inserção direta, o ID da tentativa deve ser verificado quando a leitura do manifesto falhar |

| VIH-23363 | Atualize a dependência do DataNucleus para 5.2 |

| VIH-26412 | Criar interface para buscar slots disponíveis e adicionar o padrão |

| VIH-26173 | Upgrade derby para 10.14.2.0 |

| VIH-25920 | Colisão Xerce2 com o ponto 2.12.2. |

| VIH-26300 | Atualize a versão de associação de dados Jackson para 2.12.6.1+ para evitar CVE-2020-36518 |

Data de lançamento: 08/10/2022

Esta versão aplica-se ao HDInsight 4.0. A versão do HDInsight é disponibilizada para todas as regiões durante vários dias.

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

![]()

Novos Recursos

1. Anexe discos externos em clusters HDI Hadoop/Spark

O cluster HDInsight vem com espaço em disco predefinido com base na SKU. Esse espaço pode não ser suficiente em cenários de trabalho grandes.

Esse novo recurso permite que você adicione mais discos no cluster, que usado como diretório local do gerenciador de nós. Adicione o número de discos aos nós de trabalho durante a criação do cluster HIVE e do Spark, enquanto os discos selecionados fazem parte dos diretórios locais do gerenciador de nós.

Nota

Os discos adicionados são configurados apenas para diretórios locais do gerenciador de nós.

Para mais informações, consulte aqui

2. Análise seletiva de registo

A análise de log seletivo agora está disponível em todas as regiões para visualização pública. Você pode conectar seu cluster a um espaço de trabalho de análise de log. Uma vez ativado, você pode ver os logs e métricas como Logs de Segurança do HDInsight, Gerenciador de Recursos do Yarn, Métricas do Sistema, etc. Você pode monitorar cargas de trabalho e ver como elas estão afetando a estabilidade do cluster. O log seletivo permite habilitar/desabilitar todas as tabelas ou habilitar tabelas seletivas no espaço de trabalho de análise de log. Você pode ajustar o tipo de fonte para cada tabela, já que na nova versão do monitoramento de Genebra uma tabela tem várias fontes.

- O sistema de monitoramento de Genebra usa mdsd (MDS daemon), que é um agente de monitoramento e fluente para coletar logs usando a camada de log unificada.

- O Log Seletivo usa a ação de script para desabilitar/habilitar tabelas e seus tipos de log. Como ele não abre novas portas nem altera nenhuma configuração de segurança existente, portanto, não há alterações de segurança.

- A Ação de Script é executada em paralelo em todos os nós especificados e altera os arquivos de configuração para desabilitar/habilitar tabelas e seus tipos de log.

Para mais informações, consulte aqui

![]()

Fixo

Análise de logs

O Log Analytics integrado ao Azure HDInsight que executa o OMS versão 13 requer uma atualização para o OMS versão 14 para aplicar as atualizações de segurança mais recentes. Os clientes que usam a versão mais antiga do cluster com o OMS versão 13 precisam instalar o OMS versão 14 para atender aos requisitos de segurança. (Como verificar a versão atual & Instalar 14)

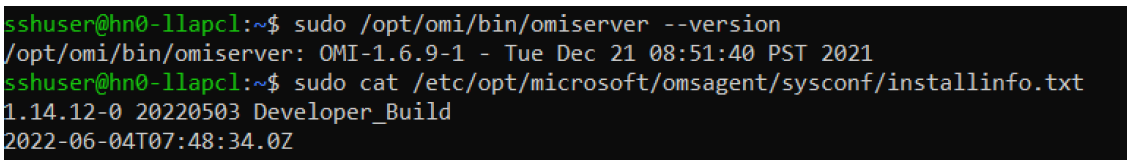

Como verificar sua versão atual do OMS

- Entre no cluster usando SSH.

- Execute o seguinte comando no seu cliente SSH.

sudo /opt/omi/bin/ominiserver/ --version

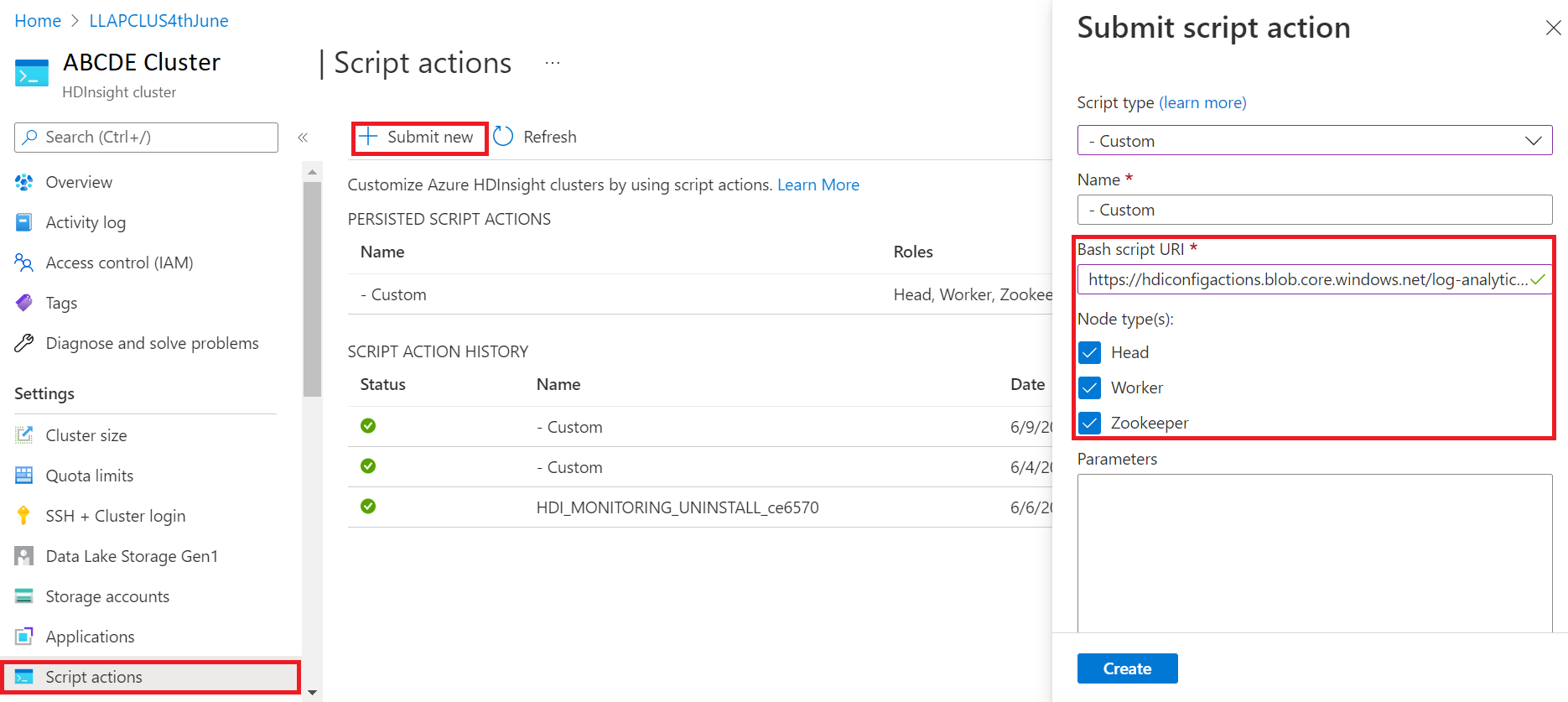

Como atualizar sua versão do OMS de 13 para 14

- Inicie sessão no portal do Azure

- No grupo de recursos, selecione o recurso de cluster HDInsight

- Selecionar ações de script

- No painel de ação Enviar script, escolha Tipo de script como personalizado

- Cole o seguinte link na caixa URL do script Bash: https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Selecionar tipo(s) de nó

- Selecione Criar

Verifique se a instalação do patch foi bem-sucedida usando as seguintes etapas:

Entre no cluster usando SSH.

Execute o seguinte comando no seu cliente SSH.

sudo /opt/omi/bin/ominiserver/ --version

Outras correções de bugs

- A CLI do log do Yarn não conseguiu recuperar os logs se algum

TFileestiver corrompido ou vazio. - Resolvido erro de detalhes da entidade de serviço inválida ao obter o token OAuth do Azure Ative Directory.

- Maior confiabilidade de criação de cluster quando 100+ nós trabalhados são configurados.

Correções de bugs de código aberto

Correções de bugs TEZ

| Correções de Erros | Apache JIRA |

|---|---|

| Tez Build Failure: FileSaver.js não encontrado | TEZ-4411 |

Exceção FS errada quando armazém e scratchdir estão em FS diferentes |

TEZ-4406 |

| TezUtils.createConfFromByteString em Configuração maior que 32 MB lança exceção com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils::createByteStringFromConf deve usar snappy em vez de DeflaterOutputStream | TEZ-4113 |

| Atualize a dependência do protobuf para 3.x | TEZ-4363 |

Correções de bugs do Hive

| Correções de Erros | Apache JIRA |

|---|---|

| Otimizações de Perf na geração dividida de ORC | VIH-21457 |

| Evite ler tabela como ACID quando o nome da tabela estiver começando com "delta", mas a tabela não for transacional e a estratégia de divisão de BI for usada | VIH-22582 |

| Remover uma chamada FS#exists de AcidUtils#getLogicalLength | VIH-23533 |

| Otimização vetorizada OrcAcidRowBatchReader.computeOffset e bucket | VIH-17917 |

Problemas conhecidos

O HDInsight é compatível com o Apache HIVE 3.1.2. Devido a um bug nesta versão, a versão do Hive é mostrada como 3.1.0 em interfaces hive. No entanto, não há impacto na funcionalidade.

Data de lançamento: 08/10/2022

Esta versão aplica-se ao HDInsight 4.0. A versão do HDInsight é disponibilizada para todas as regiões durante vários dias.

O HDInsight usa práticas de implantação seguras, que envolvem a implantação gradual da região. Pode levar até 10 dias úteis para que uma nova versão ou uma nova versão esteja disponível em todas as regiões.

![]()

Novos Recursos

1. Anexe discos externos em clusters HDI Hadoop/Spark

O cluster HDInsight vem com espaço em disco predefinido com base na SKU. Esse espaço pode não ser suficiente em cenários de trabalho grandes.

Esse novo recurso permite que você adicione mais discos no cluster, que serão usados como diretório local do gerenciador de nós. Adicione o número de discos aos nós de trabalho durante a criação do cluster HIVE e do Spark, enquanto os discos selecionados fazem parte dos diretórios locais do gerenciador de nós.

Nota

Os discos adicionados são configurados apenas para diretórios locais do gerenciador de nós.

Para mais informações, consulte aqui

2. Análise seletiva de registo

A análise de log seletivo agora está disponível em todas as regiões para visualização pública. Você pode conectar seu cluster a um espaço de trabalho de análise de log. Uma vez ativado, você pode ver os logs e métricas como Logs de Segurança do HDInsight, Gerenciador de Recursos do Yarn, Métricas do Sistema, etc. Você pode monitorar cargas de trabalho e ver como elas estão afetando a estabilidade do cluster. O log seletivo permite habilitar/desabilitar todas as tabelas ou habilitar tabelas seletivas no espaço de trabalho de análise de log. Você pode ajustar o tipo de fonte para cada tabela, já que na nova versão do monitoramento de Genebra uma tabela tem várias fontes.

- O sistema de monitoramento de Genebra usa mdsd (MDS daemon), que é um agente de monitoramento e fluente para coletar logs usando a camada de log unificada.

- O Log Seletivo usa a ação de script para desabilitar/habilitar tabelas e seus tipos de log. Como ele não abre novas portas nem altera nenhuma configuração de segurança existente, portanto, não há alterações de segurança.

- A Ação de Script é executada em paralelo em todos os nós especificados e altera os arquivos de configuração para desabilitar/habilitar tabelas e seus tipos de log.

Para mais informações, consulte aqui

![]()

Fixo

Análise de logs

O Log Analytics integrado ao Azure HDInsight que executa o OMS versão 13 requer uma atualização para o OMS versão 14 para aplicar as atualizações de segurança mais recentes. Os clientes que usam a versão mais antiga do cluster com o OMS versão 13 precisam instalar o OMS versão 14 para atender aos requisitos de segurança. (Como verificar a versão atual & Instalar 14)

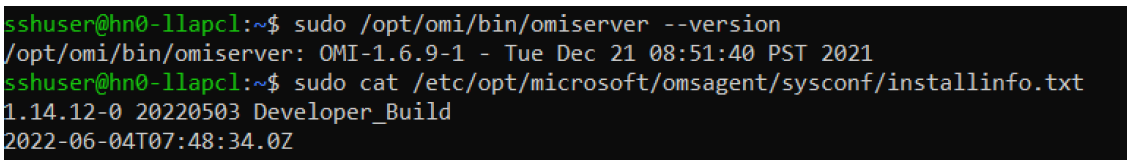

Como verificar sua versão atual do OMS

- Faça login no cluster usando SSH.

- Execute o seguinte comando no seu cliente SSH.

sudo /opt/omi/bin/ominiserver/ --version

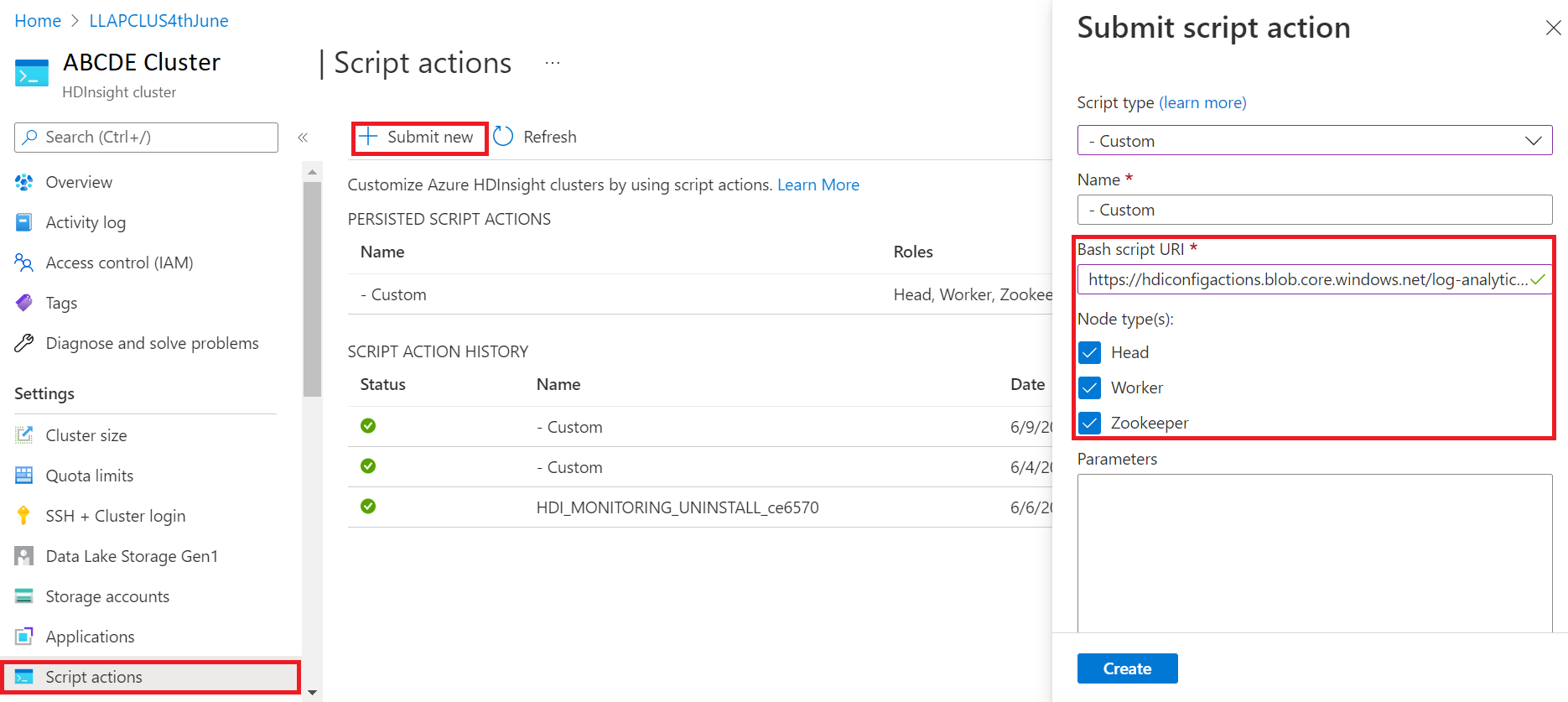

Como atualizar sua versão do OMS de 13 para 14

- Inicie sessão no portal do Azure

- No grupo de recursos, selecione o recurso de cluster HDInsight

- Selecionar ações de script

- No painel de ação Enviar script, escolha Tipo de script como personalizado

- Cole o seguinte link na caixa URL do script Bash: https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Selecionar tipo(s) de nó

- Selecione Criar

Verifique se a instalação do patch foi bem-sucedida usando as seguintes etapas:

Entre no cluster usando SSH.

Execute o seguinte comando no seu cliente SSH.

sudo /opt/omi/bin/ominiserver/ --version

Outras correções de bugs

- A CLI do log do Yarn não conseguiu recuperar os logs se algum

TFileestiver corrompido ou vazio. - Resolvido erro de detalhes da entidade de serviço inválida ao obter o token OAuth do Azure Ative Directory.

- Maior confiabilidade de criação de cluster quando 100+ nós trabalhados são configurados.

Correções de bugs de código aberto

Correções de bugs TEZ

| Correções de Erros | Apache JIRA |

|---|---|

| Tez Build Failure: FileSaver.js não encontrado | TEZ-4411 |

Exceção FS errada quando armazém e scratchdir estão em FS diferentes |

TEZ-4406 |

| TezUtils.createConfFromByteString em Configuração maior que 32 MB lança exceção com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils::createByteStringFromConf deve usar snappy em vez de DeflaterOutputStream | TEZ-4113 |

| Atualize a dependência do protobuf para 3.x | TEZ-4363 |

Correções de bugs do Hive

| Correções de Erros | Apache JIRA |

|---|---|

| Otimizações de Perf na geração dividida de ORC | VIH-21457 |

| Evite ler tabela como ACID quando o nome da tabela estiver começando com "delta", mas a tabela não for transacional e a estratégia de divisão de BI for usada | VIH-22582 |

| Remover uma chamada FS#exists de AcidUtils#getLogicalLength | VIH-23533 |

| Otimização vetorizada OrcAcidRowBatchReader.computeOffset e bucket | VIH-17917 |

Problemas conhecidos

O HDInsight é compatível com o Apache HIVE 3.1.2. Devido a um bug nesta versão, a versão do Hive é mostrada como 3.1.0 em interfaces hive. No entanto, não há impacto na funcionalidade.

Data de lançamento: 06/03/2022

Esta versão aplica-se ao HDInsight 4.0. A versão do HDInsight é disponibilizada para todas as regiões durante vários dias. A data de lançamento aqui indica a data de lançamento da primeira região. Se você não vir as seguintes alterações, aguarde o lançamento estar ativo em sua região por vários dias.

Destaques da versão

O conector de armazém do Hive (HWC) no Spark v3.1.2

O Hive Warehouse Connector (HWC) permite que você aproveite os recursos exclusivos do Hive e do Spark para criar aplicativos poderosos de big data. Atualmente, o HWC é suportado apenas para o Spark v2.4. Esse recurso agrega valor comercial ao permitir transações ACID em tabelas Hive usando o Spark. Esse recurso é útil para clientes que usam o Hive e o Spark em seu conjunto de dados. Para obter mais informações, consulte Apache Spark & Hive - Hive Warehouse Connector - Azure HDInsight | Documentos Microsoft

Ambari

- Alterações de melhoria de dimensionamento e provisionamento

- HDI hive agora é compatível com OSS versão 3.1.2

A versão do HDI Hive 3.1 é atualizada para o OSS Hive 3.1.2. Esta versão tem todas as correções e recursos disponíveis na versão de código aberto Hive 3.1.2.

Nota

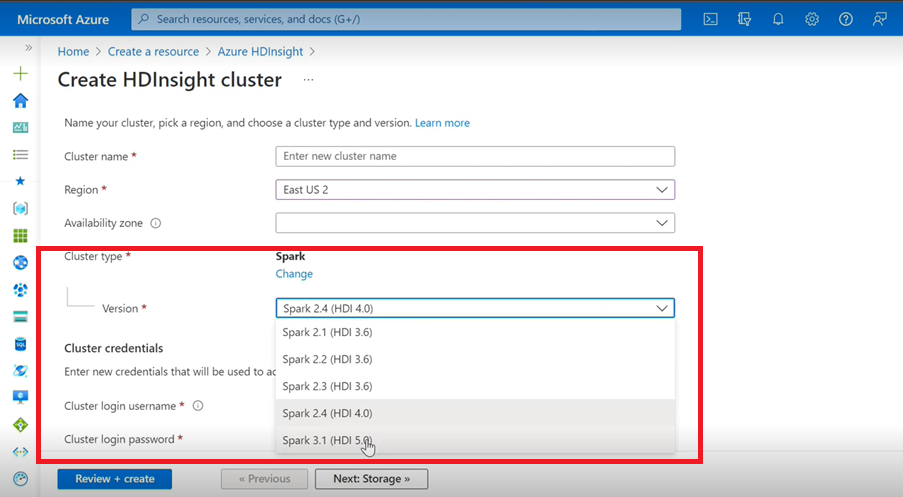

Spark

- Se você estiver usando a Interface do Usuário do Azure para criar o Cluster Spark para HDInsight, verá na lista suspensa uma outra versão do Spark 3.1. (HDI 5.0) juntamente com as versões mais antigas. Esta versão é uma versão renomeada do Spark 3.1. (IDH 4.0). Essa é apenas uma alteração no nível da interface do usuário, que não afeta nada para os usuários existentes e os usuários que já estão usando o modelo ARM.

Nota

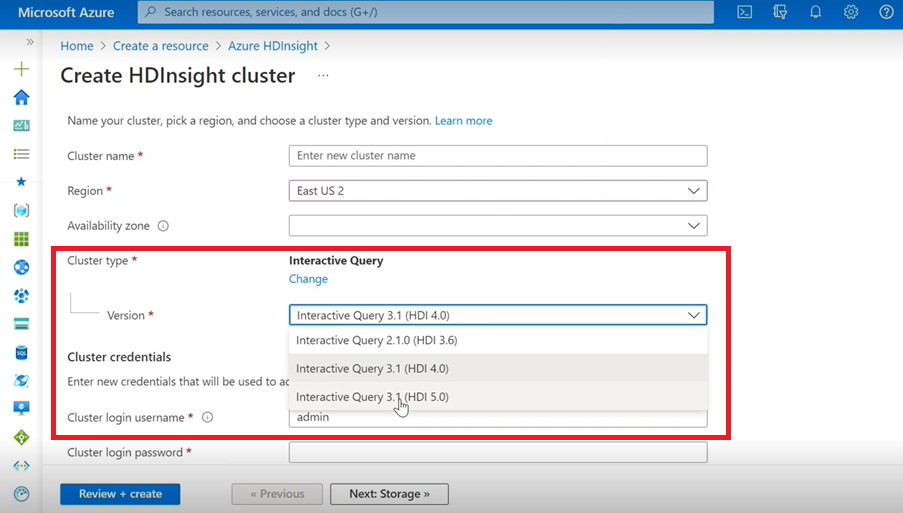

Consulta Interativa

- Se você estiver criando um Cluster de Consulta Interativa, verá na lista suspensa uma outra versão como Consulta Interativa 3.1 (HDI 5.0).

- Se você vai usar a versão Spark 3.1 junto com o Hive que exigem suporte ACID, você precisa selecionar esta versão Interactive Query 3.1 (HDI 5.0).

Correções de bugs TEZ

| Correções de Erros | Apache JIRA |

|---|---|

| TezUtils.createConfFromByteString em Configuração maior que 32 MB lança exceção com.google.protobuf.CodedInputStream | TEZ-4142 |

| TezUtils createByteStringFromConf deve usar snappy em vez de DeflaterOutputStream | TEZ-4113 |

Correções de bugs do HBase

| Correções de Erros | Apache JIRA |

|---|---|

TableSnapshotInputFormat deve usar ReadType.STREAM para verificação HFiles |

HBASE-26273 |

| Adicionar opção para desativar scanMetrics em TableSnapshotInputFormat | HBASE-26330 |

| Correção para ArrayIndexOutOfBoundsException quando o balanceador é executado | HBASE-22739 |

Correções de bugs do Hive

| Correções de Erros | Apache JIRA |

|---|---|

| NPE ao inserir dados com a cláusula 'distribute by' com otimização de classificação dynpart | VIH-18284 |

| Comando MSCK REPAIR com filtragem de partição falha ao soltar partições | VIH-23851 |

| Exceção errada lançada se capacity<=0 | VIH-25446 |

| Suporte a carga paralela para HastTables - Interfaces | VIH-25583 |

| Incluir MultiDelimitSerDe no HiveServer2 por padrão | VIH-20619 |

| Remova as classes glassfish.jersey e mssql-jdbc do jar jdbc-standalone | VIH-22134 |

| Exceção de ponteiro nulo ao executar compactação em uma tabela MM. | VIH-21280 |

Consulta do Hive com tamanho grande via knox falha com falha na gravação de tubo quebrado |

VIH-22231 |

| Adicionando capacidade para o usuário definir vincular usuário | VIH-21009 |

| Implementar UDF para interpretar o carimbo de data/hora usando sua representação interna e calendário híbrido gregoriano-juliano | VIH-22241 |

| Opção Beeline para mostrar/não mostrar relatório de execução | VIH-22204 |

| Tez: SplitGenerator tenta procurar arquivos de plano, o que não existe para Tez | VIH-22169 |

Remova o registro caro do cache LLAP hotpath |

VIH-22168 |

| UDF: FunctionRegistry sincroniza na classe org.apache.hadoop.hive.ql.udf.UDFType | VIH-22161 |

| Impedir a criação do apêndice de roteamento de consulta se a propriedade estiver definida como false | VIH-22115 |

| Remover a sincronização de consultas cruzadas para o partition-eval | VIH-22106 |

| Pule a configuração do dir de arranhão da colmeia durante o planejamento | VIH-21182 |

| Ignore a criação de dirs de rascunho para tez se o RPC estiver ativado | VIH-21171 |

switch Hive UDFs para usar Re2J o mecanismo regex |

VIH-19661 |

| Tabelas clusterizadas migradas usando o bucketing_version 1 no hive 3 usa o bucketing_version 2 para inserções | VIH-22429 |

| Bucketing: O bucketing versão 1 está particionando dados incorretamente | VIH-21167 |

| Adicionando cabeçalho de licença ASF ao arquivo recém-adicionado | VIH-22498 |

| Aprimoramentos da ferramenta de esquema para dar suporte a mergeCatalog | VIH-22498 |

| Hive com TEZ UNION ALL e UDTF resulta em perda de dados | VIH-21915 |

| Dividir ficheiros de texto mesmo que exista cabeçalho/rodapé | VIH-21924 |

| MultiDelimitSerDe retorna resultados errados na última coluna quando o arquivo carregado tem mais colunas do que o que está presente no esquema da tabela | VIH-22360 |

| Cliente externo LLAP - Necessidade de reduzir a pegada LlapBaseInputFormat#getSplits() | VIH-22221 |

| O nome da coluna com palavra-chave reservada não escapa quando a consulta, incluindo a junção na tabela com coluna de máscara, é reescrita (Zoltan Matyus via Zoltan Haindrich) | VIH-22208 |

Impedir o desligamento do LLAP em AMReporter RuntimeException relacionado |

VIH-22113 |

| O driver de serviço de status LLAP pode ficar preso com o ID errado do aplicativo Yarn | VIH-21866 |

| OperationManager.queryIdOperation não limpa corretamente vários queryIds | VIH-22275 |

| Derrubar um gerenciador de nó bloqueia a reinicialização do serviço LLAP | VIH-22219 |

| Stack OverflowError quando soltar muitas partições | VIH-15956 |

| A verificação de acesso falha quando um diretório temporário é removido | VIH-22273 |

| Corrigir resultados errados/exceção ArrayOutOfBound em junções de mapa externo à esquerda em condições de limite específicas | VIH-22120 |

| Remover tag de gerenciamento de distribuição do pom.xml | VIH-19667 |

| O tempo de análise pode ser alto se houver subconsultas profundamente aninhadas | VIH-21980 |

Para ALTER TABLE t SET TBLPROPERTIES ('EXTERNAL'='TRUE'); TBL_TYPE alterações de atributos não refletidas para não-CAPS |

VIH-20057 |

JDBC: Interfaces de sombreamento do log4j HiveConnection |

VIH-18874 |

Atualizar URLs de repositório em poms - versão branch 3.1 |

VIH-21786 |

DBInstall Testes quebrados no Master e no Branch-3.1 |

VIH-21758 |

| Carregar dados em uma tabela em bucket é ignorar partições, especificações e carrega dados na partição padrão | VIH-21564 |

| Consultas com condição de junção com carimbo de data/hora ou carimbo de data/hora com lançamento literal de fuso horário local SemanticException | VIH-21613 |

| Analise estatísticas de computação para dir de preparo de folhas de coluna no HDFS | VIH-21342 |

| Alteração incompatível no cálculo do bucket do Hive | VIH-21376 |

| Fornecer um autorizador de fallback quando nenhum outro autorizador estiver em uso | VIH-20420 |

| Algumas invocações alterPartitions lançam 'NumberFormatException: null' | VIH-18767 |

| HiveServer2: O assunto pré-autenticado para transporte http não é retido durante toda a duração da comunicação http em alguns casos | VIH-20555 |

Data de lançamento: 03/10/2022

Esta versão aplica-se ao HDInsight 4.0. A versão do HDInsight é disponibilizada para todas as regiões durante vários dias. A data de lançamento aqui indica a data de lançamento da primeira região. Se você não vir as seguintes alterações, aguarde o lançamento estar ativo em sua região por vários dias.

As versões do SO para esta versão são:

- HDInsight 4.0: Ubuntu 18.04.5

O Spark 3.1 já está disponível para o público em geral

O Spark 3.1 agora está disponível para o público em geral na versão 4.0 do HDInsight. Esta versão inclui

- Execução de consulta adaptável,

- Converter Sort Merge Join para Broadcast Hash Join,

- Otimizador de catalisador de faísca,

- Poda de partição dinâmica,

- Os clientes poderão criar novos clusters do Spark 3.1 e não clusters do Spark 3.0 (visualização).

Para obter mais informações, consulte Apache Spark 3.1 agora está disponível em geral no HDInsight - Microsoft Tech Community.

Para obter uma lista completa de melhorias, consulte as notas de versão do Apache Spark 3.1.

Para obter mais informações sobre migração, consulte o guia de migração.

Kafka 2.4 está agora disponível para o público em geral

Kafka 2.4.1 está agora disponível para o público em geral. Para obter mais informações, consulte as Notas de versão do Kafka 2.4.1. Outros recursos incluem disponibilidade do MirrorMaker 2, nova partição de tópico AtMinIsr de categoria métrica, tempo de inicialização do corretor aprimorado por preguiça na demanda mmap de arquivos de índice, mais métricas do consumidor para observar o comportamento da pesquisa do usuário.

O tipo de dados de mapa no HWC agora é suportado no HDInsight 4.0

Esta versão inclui o suporte a tipos de dados de mapa para HWC 1.0 (Spark 2.4) por meio do aplicativo spark-shell e todos os outros clientes spark suportados pelo HWC. As seguintes melhorias estão incluídas como qualquer outro tipo de dados:

Um utilizador pode:

- Crie uma tabela do Hive com qualquer coluna que contenha o tipo de dados Mapa, insira dados nela e leia os resultados dela.

- Crie um dataframe do Apache Spark com Map Type e faça leituras e gravações em lote/stream.

Novas regiões

A HDInsight expandiu agora a sua presença geográfica para duas novas regiões: China East 3 e China North 3.

Alterações no backport OSS

Backports OSS incluídos no Hive, incluindo HWC 1.0 (Spark 2.4), que suporta o tipo de dados Map.

Aqui estão os JIRAs Apache backported OSS para esta versão:

| Recurso afetado | Apache JIRA |

|---|---|

| As consultas SQL diretas do Metastore com IN/(NOT IN) devem ser divididas com base nos parâmetros máximos permitidos pelo SQL DB | VIH-25659 |

Atualizar log4j 2.16.0 para 2.17.0 |

VIH-25825 |

Versão de atualização Flatbuffer |

VIH-22827 |

| Suporte ao tipo de dados de mapa nativamente no formato de seta | VIH-25553 |

| Cliente externo LLAP - Manipula valores aninhados quando a estrutura pai é nula | VIH-25243 |

| Atualize a versão da seta para 0.11.0 | VIH-23987 |

Avisos de preterição

Conjuntos de Dimensionamento de Máquina Virtual do Azure no HDInsight

O HDInsight não usará mais os Conjuntos de Escala de Máquina Virtual do Azure para provisionar os clusters, nenhuma alteração significativa é esperada. Os clusters HDInsight existentes em conjuntos de dimensionamento de máquinas virtuais não têm impacto, quaisquer novos clusters nas imagens mais recentes deixarão de utilizar Conjuntos de Dimensionamento de Máquinas Virtuais.

O dimensionamento de cargas de trabalho do HBase do Azure HDInsight agora terá suporte apenas usando a escala manual

A partir de 01 de março de 2022, o HDInsight suportará apenas a escala manual para HBase, não havendo impacto na execução de clusters. Os novos clusters HBase não poderão habilitar o Autoscaling baseado em agendamento. Para obter mais informações sobre como dimensionar manualmente seu cluster HBase, consulte nossa documentação sobre Dimensionamento manual de clusters do Azure HDInsight

Data de lançamento: 27/12/2021

Esta versão aplica-se ao HDInsight 4.0. A versão do HDInsight é disponibilizada para todas as regiões durante vários dias. A data de lançamento aqui indica a data de lançamento da primeira região. Se você não vir as seguintes alterações, aguarde o lançamento estar ativo em sua região por vários dias.

As versões do SO para esta versão são:

- HDInsight 4.0: Ubuntu 18.04.5 LTS

A imagem do HDInsight 4.0 foi atualizada para atenuar Log4j a vulnerabilidade, conforme descrito na Resposta da Microsoft ao CVE-2021-44228 Apache Log4j 2.

Nota

- Todos os clusters HDI 4.0 criados após 27 de dezembro de 2021 00:00 UTC são criados com uma versão atualizada da imagem que mitiga as

log4jvulnerabilidades. Portanto, os clientes não precisam corrigir/reinicializar esses clusters. - Para novos clusters HDInsight 4.0 criados entre 16 de dezembro de 2021 às 01:15 UTC e 27 de dezembro de 2021 00:00 UTC, HDInsight 3.6 ou em assinaturas fixadas após 16 de dezembro de 2021, o patch é aplicado automaticamente dentro da hora em que o cluster é criado, no entanto, os clientes devem reinicializar seus nós para que o patch seja concluído (exceto para nós de gerenciamento Kafka, que são reinicializados automaticamente).

Data de lançamento: 27/07/2021

Esta versão aplica-se ao HDInsight 3.6 e ao HDInsight 4.0. A versão do HDInsight é disponibilizada para todas as regiões durante vários dias. A data de lançamento aqui indica a data de lançamento da primeira região. Se você não vir as seguintes alterações, aguarde o lançamento estar ativo em sua região em vários dias.

As versões do SO para esta versão são:

- HDInsight 3.6: Ubuntu 16.04.7 LTS

- HDInsight 4.0: Ubuntu 18.04.5 LTS

Novas funcionalidades

O suporte do Azure HDInsight para Conectividade Pública Restrita está disponível em geral em 15 de outubro de 2021

O Azure HDInsight agora oferece suporte à conectividade pública restrita em todas as regiões. Abaixo estão alguns dos principais destaques desse recurso:

- Capacidade de reverter a comunicação do provedor de recursos para o cluster de forma que ele seja de saída do cluster para o provedor de recursos

- Suporte para trazer seus próprios recursos habilitados para Link privado (por exemplo, armazenamento, SQL, cofre de chaves) para cluster HDInsight acessar os recursos somente pela rede privada

- Nenhum endereço IP público é provisionado por recursos

Usando esse novo recurso, você também pode ignorar as regras de marca de serviço NSG (grupo de segurança de rede) de entrada para IPs de gerenciamento do HDInsight. Saiba mais sobre como restringir a conectividade pública

O suporte do Azure HDInsight para o Azure Private Link está disponível em geral em 15 de outubro de 2021

Agora você pode usar pontos de extremidade privados para se conectar aos clusters HDInsight por meio de link privado. O link privado pode ser usado em cenários de VNET cruzada onde o emparelhamento VNET não está disponível ou habilitado.

O Azure Private Link permite que você acesse os Serviços PaaS do Azure (por exemplo, Armazenamento do Azure e Banco de Dados SQL) e os serviços hospedados pelo Azure de propriedade do cliente/parceiro em um ponto de extremidade privado em sua rede virtual.

O tráfego entre a sua rede virtual e o serviço percorre a rede de backbone da Microsoft. Expor o seu serviço à Internet pública já não é necessário.

Deixe mais em ativar link privado.

Nova experiência de integração do Azure Monitor (Pré-visualização)

A nova experiência de integração do monitor do Azure será Pré-visualizada no Leste dos EUA e na Europa Ocidental com esta versão. Saiba mais detalhes sobre a nova experiência de monitor do Azure aqui.

Preterição

A versão do HDInsight 3.6 foi preterida a partir de 01 de outubro de 2022.

Alterações de comportamento

O HDInsight Interactive Query suporta apenas o dimensionamento automático baseado em agendamento

À medida que os cenários dos clientes se tornam mais maduros e diversificados, identificamos algumas limitações com o Autoscale baseado em carga do LLAP (Interactive Query). Essas limitações são causadas pela natureza da dinâmica da consulta LLAP, problemas futuros de precisão de previsão de carga e problemas na redistribuição de tarefas do agendador LLAP. Devido a essas limitações, os usuários podem ver suas consultas serem executadas mais lentamente em clusters LLAP quando o Autoscale estiver habilitado. O efeito no desempenho pode superar os benefícios de custo do Autoscale.

A partir de julho de 2021, a carga de trabalho de Consulta Interativa no HDInsight suporta apenas o dimensionamento automático baseado em agendamento. Não é mais possível habilitar o dimensionamento automático baseado em carga em novos clusters de Consulta Interativa. Os clusters em execução existentes podem continuar a ser executados com as limitações conhecidas descritas acima.

A Microsoft recomenda que você mude para um Autoscale baseado em programação para LLAP. Você pode analisar o padrão de uso atual do cluster por meio do painel do Grafana Hive. Para obter mais informações, consulte Dimensionar automaticamente clusters do Azure HDInsight.

Próximas alterações

As seguintes alterações acontecem nas próximas versões.

O componente LLAP integrado no cluster ESP Spark será removido

O cluster ESP Spark do HDInsight 4.0 tem componentes LLAP integrados executados em ambos os nós principais. Os componentes LLAP no cluster ESP Spark foram originalmente adicionados para o HDInsight 3.6 ESP Spark, mas não tem nenhum caso de usuário real para o HDInsight 4.0 ESP Spark. Na próxima versão agendada para setembro de 2021, o HDInsight removerá o componente LLAP integrado do cluster HDInsight 4.0 ESP Spark. Essa alteração ajuda a descarregar a carga de trabalho do nó principal e evitar confusão entre o ESP Spark e o tipo de cluster ESP Interactive Hive.

Nova região

- EUA Oeste 3

-

JioÍndia Ocidental - Austrália Central

Alteração de versão do componente

A seguinte versão do componente foi alterada com esta versão:

- Versão ORC de 1.5.1 a 1.5.9