Avaliação de aplicativos de IA gerativa

Importante

Os itens marcados (versão prévia) neste artigo estão atualmente em versão prévia pública. Essa versão prévia é fornecida sem um contrato de nível de serviço e não recomendamos isso para cargas de trabalho de produção. Alguns recursos podem não ter suporte ou podem ter restrição de recursos. Para obter mais informações, consulte Termos de Uso Complementares de Versões Prévias do Microsoft Azure.

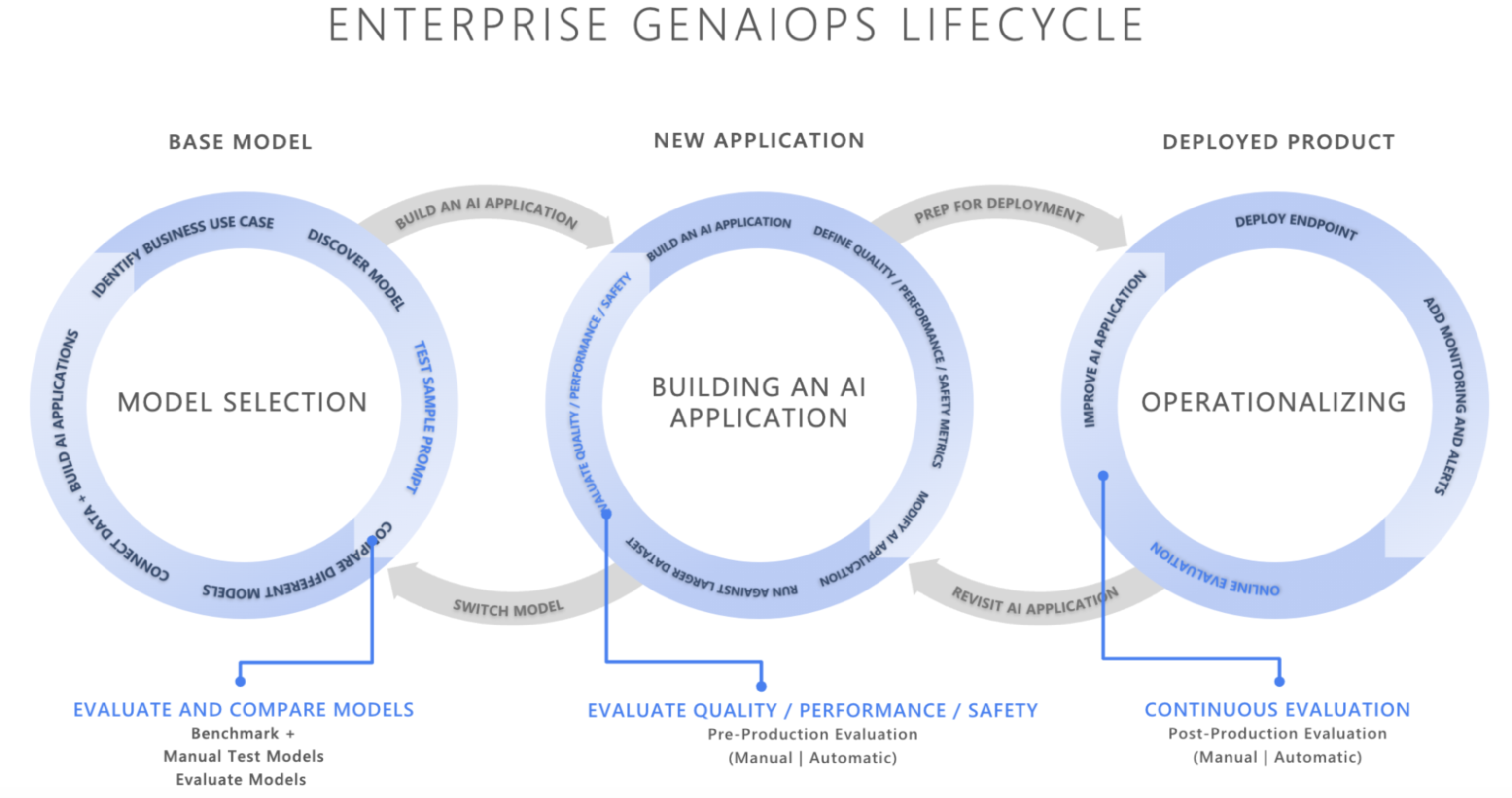

No cenário de rápida evolução da inteligência artificial, a integração do GenAIOps (Generative AI Operations) está transformando como as organizações desenvolvem e implantam aplicativos de IA. À medida que as empresas dependem cada vez mais da IA para aprimorar a tomada de decisões, melhorar as experiências dos clientes e impulsionar a inovação, a importância de uma estrutura de avaliação robusta não pode ser superestimada. A avaliação é um componente essencial do ciclo de vida de IA generativa para criar confiança nos aplicativos centrados em IA. Se não forem projetados com cuidado, esses aplicativos poderão produzir saídas fabricadas e não baseadas no contexto, irrelevantes ou incoerentes, resultando em experiências ruins do cliente ou pior, perpetuar estereótipos sociais, promover desinformação, expor organizações a ataques mal-intencionados ou uma ampla gama de outros impactos negativos.

Os avaliadores são ferramentas úteis para avaliar a frequência e a gravidade dos riscos de conteúdo ou o comportamento indesejável em respostas de IA. A execução de avaliações iterativas e sistemáticas com os avaliadores certos pode ajudar as equipes a medir e abordar possíveis problemas de qualidade ou segurança de resposta em todo o ciclo de vida de desenvolvimento de IA, desde a seleção inicial do modelo até o monitoramento pós-produção. Avaliação dentro da produção do Ciclo de Vida do GenAIOps.

Ao entender e implementar estratégias de avaliação eficazes em cada estágio, as organizações podem garantir que suas soluções de IA não apenas atendam às expectativas iniciais, mas também se adaptem e prosperem em ambientes do mundo real. Vamos nos aprofundar em como a avaliação se encaixa nos três estágios críticos do ciclo de vida da IA

Seleção de modelo base

O primeiro estágio do ciclo de vida de IA envolve a seleção de um modelo base apropriado. Os modelos de IA generativa variam amplamente em termos de funcionalidades, pontos fortes e limitações, portanto, é essencial identificar qual modelo melhor se adapta ao seu caso de uso específico. Durante a avaliação do modelo base, você "dá uma olhada" para comparar modelos diferentes testando suas saídas em relação a um conjunto de critérios relevantes para seu aplicativo.

As principais considerações neste estágio podem incluir:

- Precisão/qualidade: quão bem o modelo gera respostas relevantes e coerentes?

- Desempenho em tarefas específicas: o modelo pode lidar com o tipo de prompts e conteúdo necessários para seu caso de uso? Como é sua latência e custo?

- Considerações tendenciosas e éticas: o modelo produz alguma saída que possa perpetuar ou promover estereótipos prejudiciais?

- Risco e segurança: há algum risco de o modelo gerar conteúdo não seguro ou mal-intencionado?

Você pode explorar os parâmetros de comparação do Azure AI Foundry para avaliar e comparar modelos em conjuntos de dados disponíveis publicamente, além de regenerar resultados de parâmetro de comparação em seus próprios dados. Como alternativa, você pode avaliar um dos muitos modelos base de IA generativa por meio do SDK de Avaliação de IA do Azure, conforme demonstrado, consulte Avaliar modelo de ponto de extremidade.

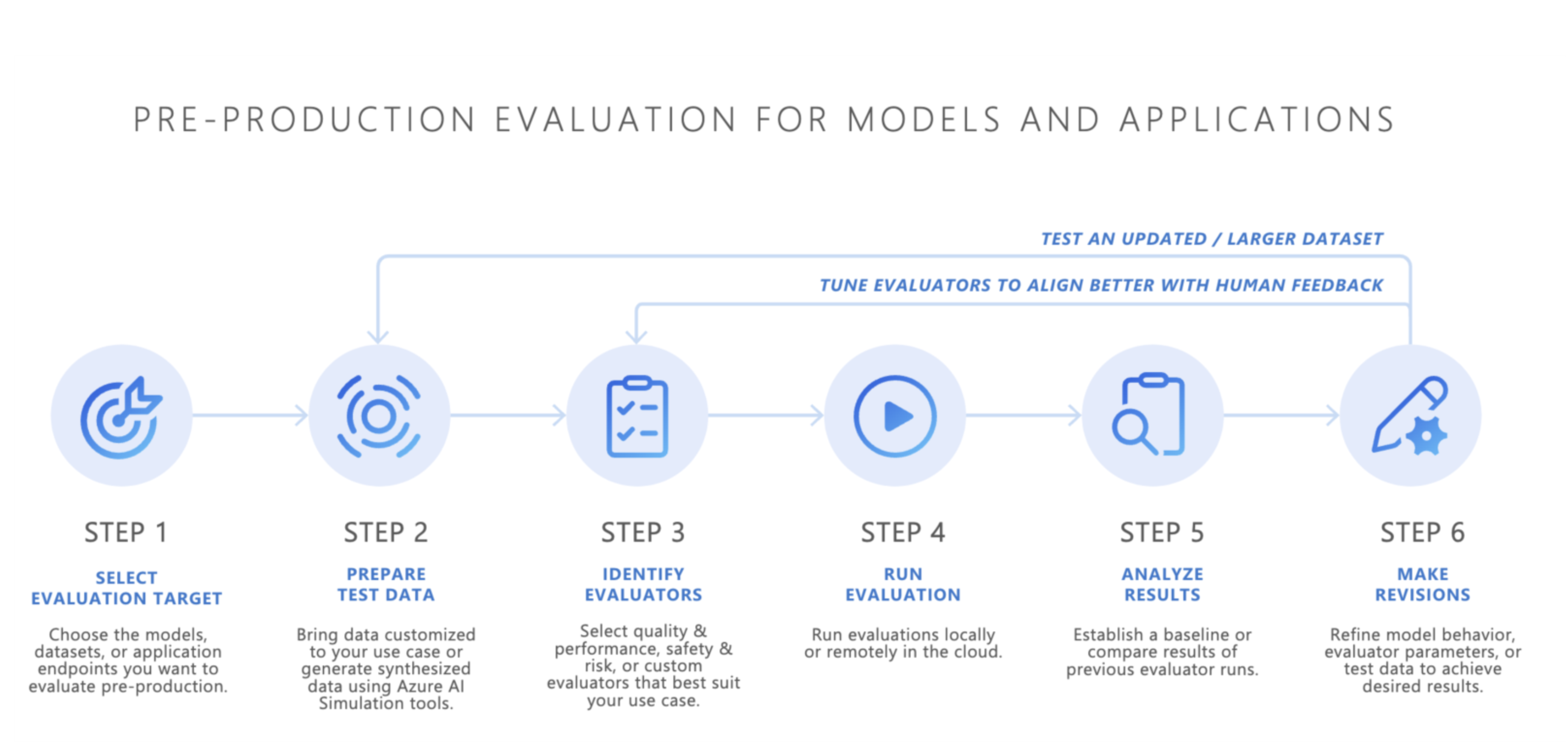

Avaliação de pré-produção

Depois de selecionar um modelo base, a próxima etapa é desenvolver um aplicativo de IA, como um chatbot alimentado por IA, um aplicativo RAG (geração aumentada por recuperação), um aplicativo de IA agente ou qualquer outra ferramenta de IA generativa. Após o desenvolvimento, a avaliação de pré-produção começa. Antes de implantar o aplicativo em um ambiente de produção, testes rigorosos são essenciais para garantir que o modelo esteja realmente pronto para uso real.

A avaliação de pré-produção envolve:

- Teste com conjuntos de dados de avaliação: esses conjuntos de dados simulam interações realistas do usuário para garantir que o aplicativo de IA seja executado conforme o esperado.

- Identificando casos de borda: encontrar cenários em que a qualidade de resposta do aplicativo de IA pode diminuir ou produzir respostas indesejáveis.

- Avaliando a robustez: garantir que o modelo possa lidar com muitas variações de entrada sem quedas significativas na qualidade ou segurança.

- Medindo as principais métricas: métricas como aterramento de resposta, relevância e segurança são avaliadas para confirmar a preparação para a produção.

O estágio de pré-produção atua como uma verificação de qualidade final, reduzindo o risco de implantar um aplicativo de IA que não atenda aos padrões de segurança ou desempenho desejados.

- Traga seus próprios dados: você pode avaliar seus aplicativos de IA em pré-produção usando seus próprios dados de avaliação com o Azure AI Foundry ou os avaliadores compatíveis do SDK de Avaliação de IA do Azure, incluindo qualidade de geração, segurança ou avaliadores personalizadose exibir resultados por meio do portal do Azure AI Foundry.

- Simuladores: se você não tiver dados de avaliação (dados de teste), os simuladores do SDK de Avaliação de IA do Azure poderão ajudar gerando consultas relacionadas a tópicos ou consultas adversariais. Esses simuladores testam a resposta do modelo a consultas semelhantes a situações ou ataques (casos de borda).

- O simulador adversarial injeta consultas que imitam possíveis ameaças à segurança ou tentam jailbreaks, ajudando a identificar limitações e preparando o modelo para condições inesperadas.

- Simuladores apropriados para contexto geram conversas típicas e relevantes que você esperaria dos usuários para testar a qualidade das respostas.

Como alternativa, você também pode usar o widget de avaliação do Azure AI Foundry para testar seus aplicativos de IA generativa.

Depois que resultados satisfatórios forem alcançados, o aplicativo de IA poderá ser implantado na produção.

Monitoramento pós-produção

Após a implantação, o aplicativo de IA entra na fase de avaliação de pós-produção, também conhecida como avaliação online ou monitoramento. Neste estágio, o modelo é inserido em um produto do mundo real e responde a consultas de usuário reais. O monitoramento garante que o modelo continue se comportando conforme o esperado e se adapte a quaisquer alterações no comportamento ou no conteúdo do usuário.

- Acompanhamento de desempenho contínuo: medição regular da resposta do aplicativo de IA usando as principais métricas para garantir uma qualidade de saída consistente.

- Resposta a incidentes: respostas rápidas a quaisquer saídas prejudiciais, injustas ou inadequadas que possam surgir durante o uso no mundo real.

Monitorando continuamente o comportamento do aplicativo de IA em produção, você pode manter experiências de usuário de alta qualidade e resolver rapidamente todos os problemas que surgirem.

Conclusão

O GenAIOps estabelece um processo confiável e repetível para gerenciar aplicativos de IA generativa em seu ciclo de vida. A avaliação desempenha um papel vital em cada estágio, desde a seleção do modelo base, até o teste de pré-produção e o monitoramento pós-produção contínuo. Medindo e abordando sistematicamente os riscos e refinando sistemas de IA em cada etapa, as equipes podem criar soluções de IA generativa que não são apenas poderosas, mas também confiáveis e seguras para uso no mundo real.

Folha de referências:

| Finalidade | Processo | Parâmetros |

|---|---|---|

| O que você está avaliando? | Identificar ou criar avaliadores relevantes | - Qualidade e desempenho ( Notebook de exemplo de desempenho e qualidade) - Segurança e Proteção (Notebook de exemplo de Segurança e Proteção) - Personalizado (Notebook de exemplo personalizado) |

| Quais dados você deve usar? | Carregar ou gerar conjunto de dados relevante | Simulador genérico para medir Qualidade e Desempenho (Notebook de exemplo de simulador genérico) - Simulador de adversário para medir Segurança e Proteção (notebook de exemplo do simulador de adversário) |

| Quais recursos devem realizar a avaliação? | Executar avaliação | - Execução local - Execução de nuvem remota |

| Como meu modelo/aplicativo foi executado? | Analisar resultados | Exibir pontuações agregadas, exibir detalhes, detalhes da pontuação, comparar execuções de avaliação |

| Como posso melhorar? | Fazer alterações no modelo, aplicativo ou avaliadores | - Se os resultados da avaliação não se alinharem aos comentários humanos, ajuste o avaliador. - Se os resultados da avaliação se alinharem aos comentários humanos, mas não atenderem aos limites de qualidade/segurança, aplique mitigações direcionadas. |