Parâmetros de comparação de modelo no Estúdio de IA do Azure

Importante

Os itens marcados (versão prévia) neste artigo estão atualmente em versão prévia pública. Essa versão prévia é fornecida sem um contrato de nível de serviço e não recomendamos isso para cargas de trabalho de produção. Alguns recursos podem não ter suporte ou podem ter restrição de recursos. Para obter mais informações, consulte Termos de Uso Complementares de Versões Prévias do Microsoft Azure.

No Estúdio de IA do Azure, você pode comparar parâmetros de comparação entre modelos e conjuntos de dados disponíveis no setor para decidir qual deles atende ao seu cenário de negócios. Você pode acessar diretamente os resultados detalhados dos dados comparativos no catálogo de modelos. Se você já tem modelos em mente ou está explorando modelos, os dados comparativos na IA do Azure permitem que você tome decisões informadas de forma rápida e eficiente.

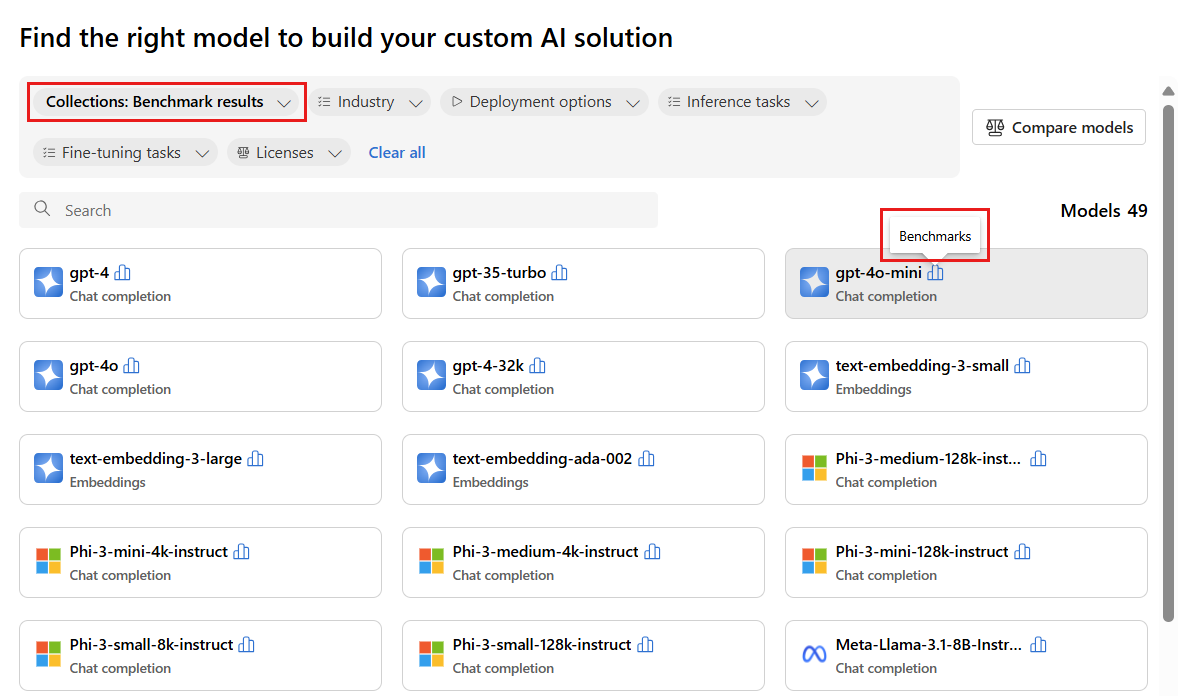

A IA do Azure dá suporte aos dados comparativos de modelo para modelos selecionados que são populares e usados com mais frequência. Os modelos com suporte têm um ícone de parâmetros de comparação que se parece com um histograma. Você pode encontrar esses modelos no catálogo de modelos usando o filtro Coleções e selecionando Resultados do parâmetro de comparação. Em seguida, você pode usar a funcionalidade de pesquisa para encontrar modelos específicos.

Os parâmetros de comparação de modelo ajudam você a tomar decisões informadas sobre a sustentabilidade de modelos e conjuntos de dados antes de iniciar qualquer trabalho. Os parâmetros de comparação são uma lista com curadoria dos modelos de melhor desempenho para uma tarefa, com base em uma comparação abrangente das métricas de benchmarking. O Estúdio de IA do Azure fornece os seguintes parâmetros de comparação para modelos baseados em coleções de catálogos de modelos:

- Parâmetros de comparação entre LLMs (modelos de linguagem grande) e modelos de linguagem pequenos (SLMs)

- Parâmetros de comparação entre modelos inseridos

Parâmetro de comparação de LLMs e SLMs

Os parâmetros de comparação de modelo avaliam LLMs e SLMs nas seguintes categorias: qualidade, desempenho e custo. Os parâmetros de comparação são atualizados regularmente à medida que novas métricas e conjuntos de dados são adicionados aos modelos existentes e à medida que novos modelos são adicionados ao catálogo de modelos.

Quality

A IA do Azure avalia a qualidade de LLMs e SLMs em várias métricas agrupadas em duas categorias principais: precisão e métricas assistidas por prompt:

Para a métrica de precisão:

| Métrica | Descrição |

|---|---|

| Precisão | As pontuações de precisão estão disponíveis no conjunto de dados e nos níveis de modelo. No nível do conjunto de dados, a pontuação é o valor médio de uma métrica de precisão computada em todos os exemplos no conjunto de dados. A métrica de precisão usada é exact-match em todos os casos, exceto no conjunto de dados HumanEval que usa uma métrica de pass@1. A correspondência exata compara o texto gerado pelo modelo com a resposta correta de acordo com o conjunto de dados, relatando um se o texto gerado corresponder exatamente à resposta e, caso contrário, zero. A métrica pass@1 mede a proporção de soluções de modelo que passam por um conjunto de testes de unidade em uma tarefa de geração de código. No nível do modelo, a pontuação de precisão é a média das precisões no nível do conjunto de dados para cada modelo. |

Para métricas assistidas por prompt:

| Métrica | Descrição |

|---|---|

| Coerência | A coerência avalia o quão bem o modelo de linguagem pode produzir resultados que fluem facilmente, são lidos naturalmente e se assemelham à linguagem humana. |

| Fluência | A fluência avalia a proficiência linguística da resposta prevista de uma IA generativa. Ela avalia a adequação do texto gerado às regras gramaticais, às estruturas sintáticas e ao uso adequado do vocabulário, resultando em respostas linguisticamente corretas e naturais. |

| Similaridade com GPT | O GPTSimilarity é uma medida que quantifica a similaridade entre uma frase real (ou documento) e a frase de previsão gerada por um modelo de IA. A métrica é calculada pela primeira vez computando inserções no nível da frase usando a API de inserções para a realidade e a previsão do modelo. Essas incorporações são representações vetoriais de alta dimensão das frases, capturando seu significado semântico e contexto. |

| Fundamentação | A aterramento mede o quão bem as respostas geradas do modelo de idioma se alinham com as informações da fonte de entrada. |

| Relevância | A relevância mede até que ponto as respostas geradas pelo modelo de linguagem são pertinentes e diretamente relacionadas às perguntas fornecidas. |

A IA do Azure também exibe o índice de qualidade da seguinte maneira:

| Índice | Descrição |

|---|---|

| Índice de qualidade | O índice de qualidade é calculado pela redução da GPTSimilarity entre zero e um, seguido pela média com métricas de precisão. Valores mais altos de índice de qualidade são melhores. |

O índice de qualidade representa a pontuação média da métrica primária aplicável (precisão, GPTSimilarity redimensionada) em 15 conjuntos de dados padrão e é fornecido em uma escala de zero a um.

O índice de qualidade constitui duas categorias de métricas:

- Precisão (por exemplo, correspondência exata ou

pass@k). Varia de zero a um. - Métricas baseadas em prompt (por exemplo, GPTSimilarity, aterramento, coerência, fluência e relevância). Varia de um a cinco.

A estabilidade do valor do índice de qualidade fornece um indicador da qualidade geral do modelo.

Desempenho

As métricas de desempenho são calculadas como uma agregação ao longo de 14 dias, com base em 24 trilhas (duas solicitações por trilha) enviadas diariamente com um intervalo de uma hora entre cada trilha. Os seguintes parâmetros padrão são usados para cada solicitação para o ponto de extremidade do modelo:

| Parâmetro | Valor | Aplicável para |

|---|---|---|

| Region | Leste dos EUA/Leste dos EUA 2 | APIs sem servidor e OpenAI do Azure |

| Limite de taxa de tokens por minuto (TPM) | 30k (180 RPM com base no OpenAI do Azure) N/A (APIs sem servidor) |

Para modelos do OpenAI do Azure, a seleção está disponível para usuários com intervalos de limite de taxa com base no tipo de implantação (padrão, global, padrão global e assim por diante). Para APIs sem servidor, essa configuração é abstraída. |

| Número de solicitações | Duas solicitações em uma trilha para cada hora (24 trilhas por dia) | APIs sem servidor, OpenAI do Azure |

| Número de trilhas/execuções | 14 dias com 24 trilhas por dia para 336 corridas | APIs sem servidor, OpenAI do Azure |

| Comprimento do prompt/contexto | Comprimento moderado | APIs sem servidor, OpenAI do Azure |

| Número de tokens processados (moderado) | Taxa de 80:20 para tokens de entrada para saída, ou seja, 800 tokens de entrada para 200 tokens de saída. | APIs sem servidor, OpenAI do Azure |

| Número de solicitações simultâneas | Único (as solicitações são enviadas sequencialmente uma após a outra) | APIs sem servidor, OpenAI do Azure |

| Dados | Sintético (prompts de entrada preparados a partir de texto estático) | APIs sem servidor, OpenAI do Azure |

| Region | Leste dos EUA/Leste dos EUA 2 | APIs sem servidor e OpenAI do Azure |

| Tipo de implantação | Standard | Aplicável somente para o OpenAI do Azure |

| Streaming | Verdadeiro | Aplica-se às APIs sem servidor e ao OpenAI do Azure. Para modelos implantados por meio da computação gerenciada, defina max_token = 1 para replicar o cenário de streaming. Isso permite calcular métricas como o tempo total para o primeiro token (TTFT) para computação gerenciada. |

| Tokenizer | Pacote Tiktoken (OpenAI do Azure) ID do modelo de detecção facial (APIs sem servidor) |

ID do modelo de detecção facial (APIs sem servidor do Azure) |

O desempenho de LLMs e SLMs é avaliado nas seguintes métricas:

| Métrica | Descrição |

|---|---|

| Média de latência | Tempo médio em segundos necessário para processar uma solicitação, computada em várias solicitações. Para calcular essa métrica, enviamos uma solicitação para o ponto de extremidade a cada hora, por duas semanas e calculamos a média. |

| Latência P50 | 50º valor de percentil (a mediana) de latência (o tempo gasto entre a solicitação e quando recebemos toda a resposta com um código bem-sucedido). Por exemplo, quando enviamos uma solicitação para o ponto de extremidade, 50% das solicitações são concluídas em 'x' segundos, com 'x' sendo a medida de latência. |

| Latência P90 | 90º valor de percentil de latência (o tempo gasto entre a solicitação e quando recebemos toda a resposta com um código bem-sucedido). Por exemplo, quando enviamos uma solicitação para o ponto de extremidade, 90% das solicitações são concluídas em 'x' segundos, com 'x' sendo a medida de latência. |

| Latência P95 | 95º valor de percentil de latência (o tempo gasto entre a solicitação e quando recebemos toda a resposta com um código bem-sucedido). Por exemplo, quando enviamos uma solicitação para o ponto de extremidade, 95% das solicitações são concluídas em 'x' segundos, com 'x' sendo a medida de latência. |

| Latência P99 | 99º valor de percentil de latência (o tempo gasto entre a solicitação e quando recebemos toda a resposta com um código bem-sucedido). Por exemplo, quando enviamos uma solicitação para o ponto de extremidade, 99% das solicitações são concluídas em "x" segundos, com 'x' sendo a medida de latência. |

| Taxa de transferência GTPS | Os tokens gerados por segundo (GTPS) é o número de tokens de saída que estão sendo gerados por segundo a partir do momento em que a solicitação é enviada para o ponto de extremidade. |

| TTPS de taxa de transferência | O total de tokens por segundo (TTPS) é o número total de tokens processados por segundo, incluindo tanto os tokens do prompt de entrada quanto os de saída gerados. |

| TTFT de latência | O tempo total para o primeiro token (TTFT) é o tempo necessário para que o primeiro token na resposta seja retornado do ponto de extremidade quando o streaming estiver habilitado. |

| Tempo entre tokens | Essa métrica é o tempo entre os tokens recebidos. |

A IA do Azure também exibe índices de desempenho para latência e taxa de transferência da seguinte maneira:

| Índice | Descrição |

|---|---|

| Índice de latência | Tempo médio para o primeiro token. Valores menores são melhores. |

| Índice de taxa de transferência | Tokens gerados médios por segundo. Valores mais altos são melhores. |

Para métricas de desempenho, como latência ou taxa de transferência, o tempo para o primeiro token e os tokens gerados por segundo dão uma melhor noção geral do desempenho e comportamento típicos do modelo. Atualizamos nossos números de desempenho em cadência regular.

Custo

Cálculos de custo são estimativas para usar um ponto de extremidade de modelo LLM ou SLM hospedado na plataforma de IA do Azure. A IA do Azure dá suporte à exibição do custo de APIs sem servidor e modelos do OpenAI do Azure. Como esses custos estão sujeitos a alterações, atualizamos nossos cálculos de custo em uma cadência regular.

O custo de LLMs e SLMs é avaliado nas seguintes métricas:

| Métrica | Descrição |

|---|---|

| Custo por tokens de entrada | Custo para implantação de API sem servidor para 1 milhão de tokens de entrada |

| Custo por tokens de saída | Custo para implantação de API sem servidor para 1 milhão de tokens de saída |

| Custo estimado | Custo para a soma do custo por tokens de entrada e custo por tokens de saída, com uma taxa de 3:1. |

A IA do Azure também exibe o índice de custo da seguinte maneira:

| Índice | Descrição |

|---|---|

| Índice de custo | Custo estimado. Valores menores são melhores. |

Parâmetro de comparação de modelos de inserção

Os parâmetros de comparação de modelo avaliam os modelos de inserção com base na qualidade.

Quality

A qualidade dos modelos de inserção é avaliada nas seguintes métricas:

| Métrica | Descrição |

|---|---|

| Precisão | A precisão é a proporção de previsões corretas entre o número total de previsões processadas. |

| Medida F1 | Pontuação F1 é a média ponderada da precisão e recall, onde o melhor valor é um (precisão perfeita e recall), e pior é zero. |

| Média de precisão (MAP) | A MAP avalia a qualidade dos sistemas de classificação e de recomendação. Ele mede tanto a relevância dos itens sugeridos quanto o quão bom o sistema é em colocar itens mais relevantes na parte superior. Os valores podem variar de zero a um e, quanto maior a MAP, melhor o sistema pode colocar itens relevantes no alto da lista. |

| Ganho cumulativo com desconto normalizado (NDCG) | O NDCG avalia a capacidade de um algoritmo de machine learning de classificar itens com base na relevância. Ele compara classificações a uma ordem ideal em que todos os itens relevantes estão no topo da lista, onde k é o comprimento da lista ao avaliar a qualidade da classificação. Em nossos parâmetros de comparação, k=10, indicado por uma métrica de ndcg_at_10, o que significa que examinamos os 10 principais itens. |

| Precision | A precisão mede a capacidade do modelo de identificar instâncias de uma determinada classe corretamente. A precisão mostra a frequência com que um modelo de machine learning está correto ao prever a classe de destino. |

| Correlação de Spearman | A correlação de Spearman com base na similaridade de cosseno é calculada pela primeira vez calculando a semelhança de cosseno entre variáveis e, em seguida, classificando essas pontuações e usando as classificações para calcular a correlação de Spearman. |

| V measure | A V measure é uma métrica usada para avaliar a qualidade do clustering. Ela é calculada como uma média harmônica de homogênea e integridade, garantindo um equilíbrio entre os dois para uma pontuação significativa. As pontuações possíveis estão entre zero e uma, com uma rotulagem perfeitamente completa. |

Cálculo de pontuações

Pontuações individuais

Os resultados do parâmetro de comparação são provenientes de conjuntos de dados públicos que geralmente são usados para avaliação do modelo de linguagem. Na maioria dos casos, os dados são hospedados em repositórios do GitHub mantidos pelos criadores ou curadores dos dados. Os pipelines de avaliação de IA do Azure baixam dados das respectivas fontes originais, extraem prompts de cada linha de exemplo, geram respostas de modelo e computam métricas de precisão relevantes.

A construção de prompt segue as práticas recomendadas para cada conjunto de dados, especificadas pelo documento que apresenta o conjunto de dados e o padrão do setor. Na maioria dos casos, cada prompt contém vários shots, ou seja, vários exemplos de perguntas e respostas completas para aprimorar o modelo para a tarefa. Os pipelines de avaliação criam capturas por meio de perguntas de amostragem e respostas de uma parte dos dados que são mantidos fora da avaliação.