Problemen met oplossingen voor gezondheidszorggegevens oplossen in Microsoft Fabric

Dit artikel bevat informatie over enkele problemen of fouten die u mogelijk tegenkomt bij het gebruik van oplossingen voor gezondheidszorggegevens in Microsoft Fabric en hoe u deze kunt oplossen. Het artikel bevat ook enkele richtlijnen voor het controleren van toepassingen.

Als het probleem zich blijft voordoen nadat u de instructies in dit artikel hebt gevolgd, kunt u een incidentticket maken voor het ondersteuningsteam.

Implementatieproblemen oplossen

Soms kunt u problemen ondervinden wanneer u oplossingen voor gezondheidszorggegevens implementeert in de Fabric-werkruimte. Hier worden enkele veelvoorkomende problemen beschreven en wordt aangegeven hoe u deze kunt oplossen:

Het maken van een oplossing mislukt of duurt te lang.

Fout: Het maken van de gezondheidszorgoplossing duurt langer dan 5 minuten en/of mislukt.

Oorzaak: Deze fout treedt op als er een andere zorgoplossing met dezelfde naam is of als deze onlangs is verwijderd.

Oplossing: Als u onlangs een oplossing hebt verwijderd, moet u 30 tot 60 minuten wachten voordat u een nieuwe implementatie uitvoert.

Implementatie van mogelijkheid mislukt.

Fout: Mogelijkheden in oplossingen voor gezondheidszorggegevens kunnen niet worden geïmplementeerd.

Oplossing: Controleer of de mogelijkheid onder de sectie Geïmplementeerde mogelijkheden beheren wordt vermeld.

- Als de mogelijkheid niet in de tabel staat, probeert u deze opnieuw te implementeren. Selecteer de mogelijkheidstegel en selecteer vervolgens de knop Implementeren naar werkruimte.

- Als de mogelijkheid in de tabel wordt vermeld met de statuswaarde Implementatie mislukt, implementeert u de mogelijkheid opnieuw. U kunt ook voor een nieuwe omgeving voor oplossingen voor gezondheidszorggegevens maken en de functionaliteit daar opnieuw implementeren.

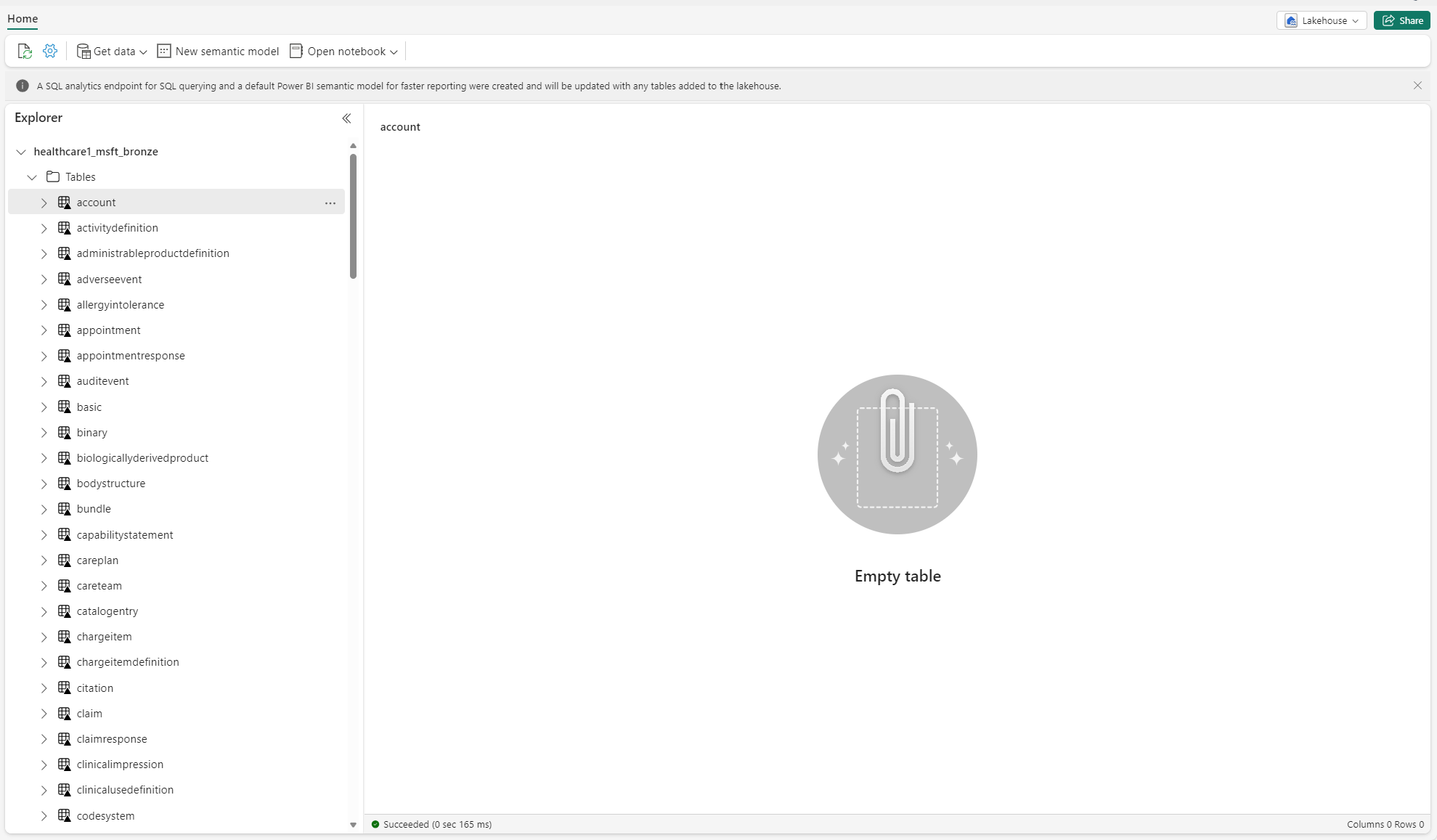

Problemen met niet-geïdentificeerde tabellen oplossen

Wanneer deltatabellen voor de eerste keer in het lakehouse worden gemaakt, worden ze mogelijk tijdelijk weergegeven als niet-geïdentificeerd of leeg in de weergave van de lakehouse-verkenner. Na een paar minuten zouden ze echter correct in de tabellenmap moeten verschijnen.

Gegevenspijplijn opnieuw uitvoeren

Volg deze stappen om de voorbeeldgegevens van begin tot eind opnieuw uit te voeren:

Voer een Spark SQL-instructie uit vanuit een notebook om alle tabellen uit een lakehouse te verwijderen. Hier volgt een voorbeeld:

lakehouse_name = "<lakehouse_name>" tables = spark.sql(f"SHOW TABLES IN {lakehouse_name}") for row in tables.collect(): spark.sql(f"DROP TABLE {lakehouse_name}.{row[1]}")Gebruik de OneLake-bestandsverkenner om verbinding te maken met OneLake in Windows Verkenner.

Navigeer naar uw werkruimtemap in Windows Verkenner. Verwijder onder

<solution_name>.HealthDataManager\DMHCheckpointalle bijbehorende mappen<lakehouse_id>/<table_name>. U kunt ook Microsoft Spark Utilities (MSSparkUtils) for Fabric gebruiken om de map te verwijderen.Voer de gegevenspijplijnen opnieuw uit, te beginnen met de opname van klinische gegevens in het bronzen lakehouse.

Apache Spark-toepassingen controleren met Azure Log Analytics

De Apache Spark-toepassingslogboeken worden verzonden naar een instantie van Azure Log Analytics-werkruimte waarop u query's kunt uitvoeren. Gebruik dit voorbeeld van een Kusto-query om de specifieke logboeken voor oplossingen voor gezondheidszorggegevens te filteren:

AppTraces

| where Properties['LoggerName'] contains "Healthcaredatasolutions"

or Properties['LoggerName'] contains "DMF"

or Properties['LoggerName'] contains "RMT"

| limit 1000

De consolelogboeken van de notebook registreren ook de RunId voor elke uitvoering. U kunt deze waarde gebruiken om logboeken voor een specifieke uitvoering op te halen, zoals weergegeven in de volgende voorbeeldquery:

AppTraces

| where Properties['RunId'] == "<RunId>"

Zie Fabric Monitoring Hub gebruiken voor algemene informatie over bewaking.

OneLake-bestandsverkenner gebruiken

De OneLake-bestandsverkenner integreert OneLake naadloos met Windows Verkenner. Met de bestandsverkenner van OneLake kunt u alle mappen en bestanden bekijken die in uw Fabric-werkruimte zijn geïmplementeerd. U kunt ook de voorbeeldgegevens, OneLake-bestanden en -mappen en de controlepuntbestanden bekijken.

Azure Storage Explorer gebruiken

U kunt Azure Storage Explorer ook gebruiken voor het volgende:

- Toegang krijgen tot de OneLake-bestanden in uw Fabric-lakehouses

- Verbinding maken met het bestandspad naar uw uw OneLake-URL

Spark-runtimeversie opnieuw instellen in de Fabric-werkruimte

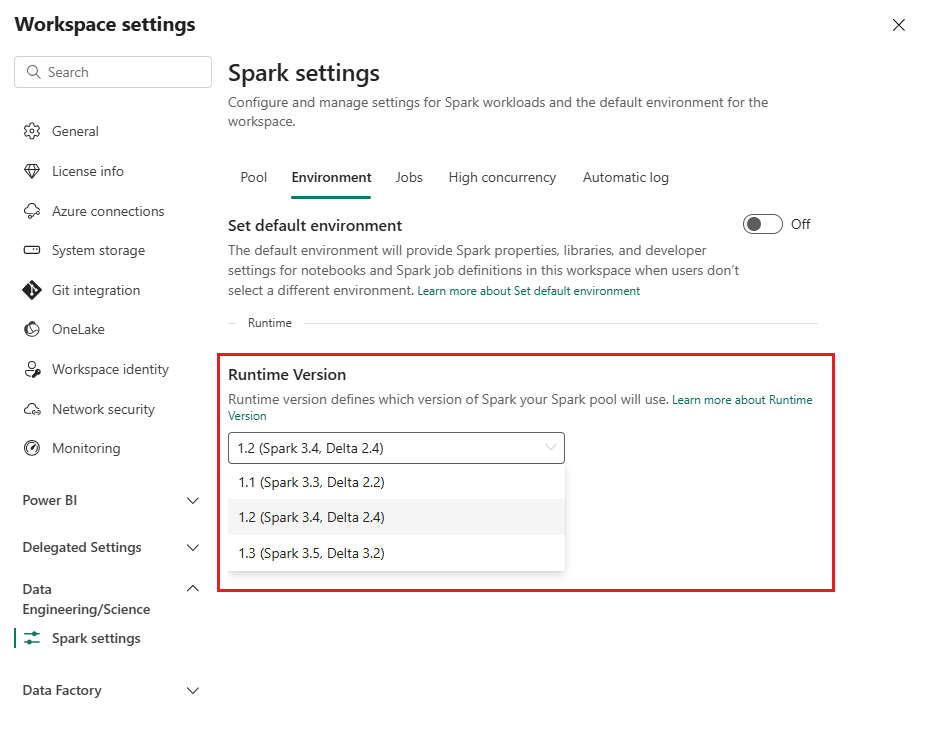

Standaard gebruiken alle nieuwe Fabric-werkruimten de nieuwste Fabric-runtimeversie. Momenteel is dit Runtime 1.3. Oplossingen voor gezondheidszorggegevens ondersteunen echter alleen Runtime 1.2.

Nadat u oplossingen voor gezondheidszorggegevens in uw werkruimte hebt geïmplementeerd, moet u ervoor zorgen dat de standaard Fabric-runtimeversie is ingesteld op Runtime 1.2 (Apache Spark 3.4 en Delta Lake 2.4). Als u dat niet doet, kunnen de uitvoeringen van uw gegevenspijplijn en notebook mislukken. Zie Ondersteuning voor meerdere runtimes in Fabric voor meer informatie.

Volg deze stappen om de Fabric-runtimeversie te controleren/bij te werken:

Ga naar uw werkruimte voor oplossingen voor gezondheidszorggegevens en selecteer Werkruimte-instellingen.

Vouw op de pagina met werkruimte-instellingen de vervolgkeuzelijst Data engineering/wetenschap uit en selecteer Spark-instellingen.

Werk op het tabblad Omgeving de waarde voor Runtimeversie bij naar 1.2 (Spark 3.4, Delta 2.4) en sla de wijzigingen op.

Fabric-gebruikersinterface en OneLake-bestandsverkenner vernieuwen

Soms merkt u wellicht dat in de Fabric-gebruikersinterface of OneLake-bestandsverkenner de inhoud niet altijd wordt vernieuwd na elke uitvoering van het notebook. Als u niet het verwachte resultaat in de gebruikersinterface ziet nadat u een uitvoeringsstap hebt uitgevoerd (bijvoorbeeld als u een nieuwe map of een nieuw lakehouse hebt gemaakt of nieuwe gegevens hebt opgenomen in een tabel), kunt u proberen het artefact (tabel, lakehouse, map) te vernieuwen. Met deze vernieuwing kunt u vaak verschillen oplossen voordat u andere opties gaat onderzoeken of verder onderzoek gaat doen.