Fabric Eventstream - overzicht

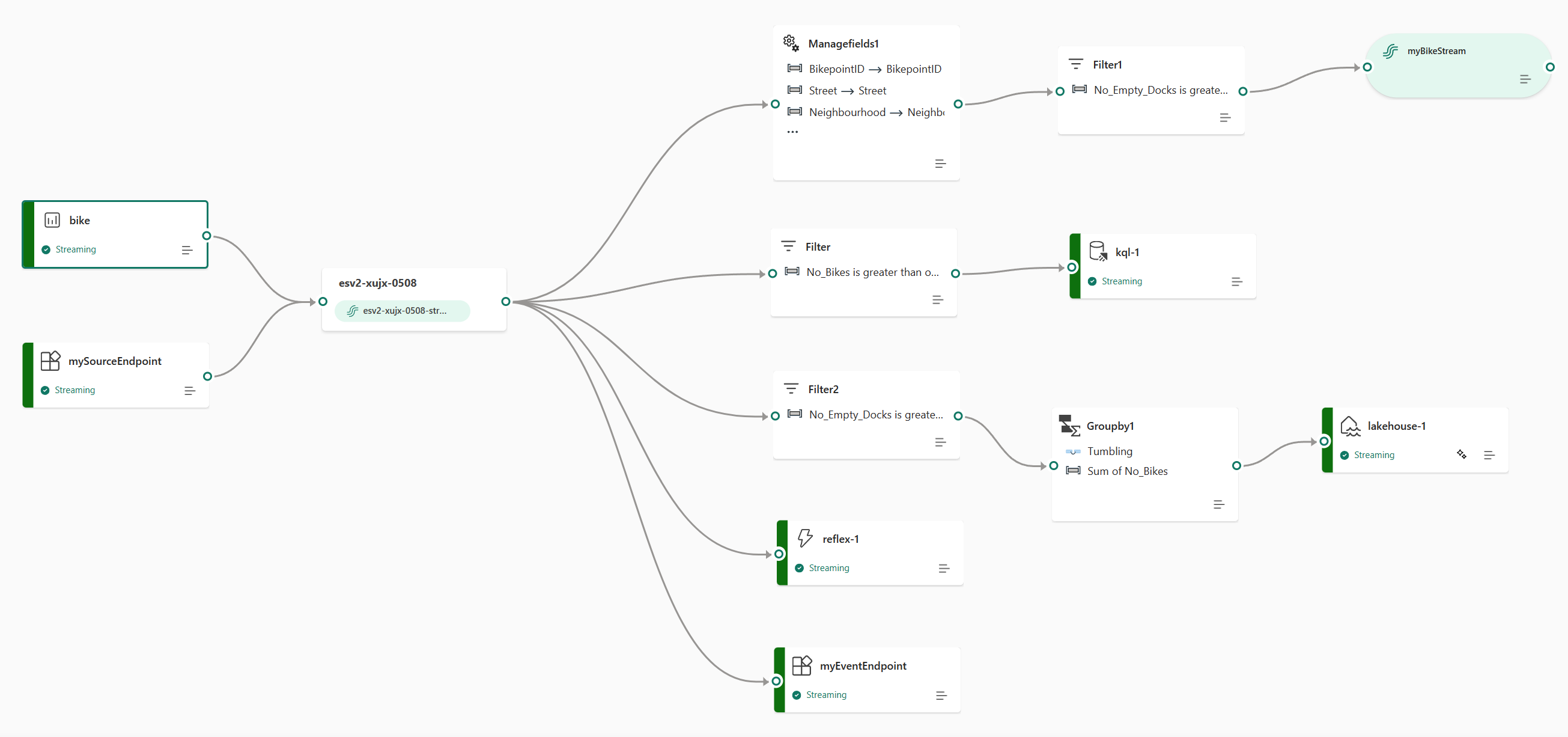

Met de functie eventstreams in de Realtime intelligence-ervaring van Microsoft Fabric kunt u realtime gebeurtenissen in Fabric opnemen, transformeren en ze vervolgens routeren naar verschillende bestemmingen zonder code te schrijven (geen code). U maakt een eventstream, een exemplaar van het Eventstream-item in Fabric, voegt gebeurtenisgegevensbronnen toe aan de stream, voegt eventueel transformaties toe om de gebeurtenisgegevens te transformeren en routeer vervolgens de gegevens naar ondersteunde bestemmingen. Daarnaast kunt u, met Apache Kafka-eindpunten die beschikbaar zijn op het Eventstream-item, realtime gebeurtenissen verzenden of gebruiken met behulp van het Kafka-protocol.

Gebeurtenissen in Fabric brengen

De functie eventstreams biedt u verschillende bronconnectors voor het ophalen van gebeurtenisgegevens uit de verschillende bronnen. Er zijn meer bronnen beschikbaar wanneer u verbeterde mogelijkheden inschakelt op het moment dat u een eventstream maakt.

| Bronnen | Beschrijving |

|---|---|

| Azure Event Hubs | Als u een Azure Event Hub hebt, kunt u event hub-gegevens opnemen in Microsoft Fabric met behulp van Eventstream. |

| Azure IoT Hub | Als u een Azure IoT-hub hebt, kunt u IoT-gegevens opnemen in Microsoft Fabric met behulp van Eventstream. |

| Azure SQL Database Change Data Capture (CDC) | Met de Azure SQL Database CDC-bronconnector kunt u een momentopname van de huidige gegevens in een Azure SQL-database vastleggen. De connector bewaakt en registreert toekomstige wijzigingen op rijniveau in deze gegevens. |

| PostgreSQL-database-CDC | Met de Bronconnector PostgreSQL Database Change Data Capture (CDC) kunt u een momentopname van de huidige gegevens in een PostgreSQL-database vastleggen. De connector bewaakt en registreert toekomstige wijzigingen op rijniveau in deze gegevens. |

| MySQL-database-CDC | Met de Bronconnector azure MySQL Database Change Data Capture (CDC) kunt u een momentopname van de huidige gegevens in een Azure Database for MySQL-database vastleggen. U kunt de tabellen opgeven die moeten worden bewaakt en de eventstream registreert toekomstige wijzigingen op rijniveau in de tabellen. |

| Azure Cosmos DB CDC | Met de Azure Cosmos DB Change Data Capture-bronconnector (CDC) voor Microsoft Fabric-gebeurtenisstromen kunt u een momentopname van de huidige gegevens in een Azure Cosmos DB-database vastleggen. De connector bewaakt en registreert toekomstige wijzigingen op rijniveau in deze gegevens. |

| SQL Server op virtuele machine (VM) Database (DB) CDC | Met de SQL Server op DE CDC-bronconnector (VM DB) voor Fabric-gebeurtenisstromen kunt u een momentopname van de huidige gegevens in een SQL Server-database op de VM vastleggen. De connector bewaakt en registreert toekomstige wijzigingen op rijniveau in de gegevens. |

| Azure SQL Managed Instance CDC | Met de CDC-bronconnector van Azure SQL Managed Instance voor Microsoft Fabric-gebeurtenisstromen kunt u een momentopname van de huidige gegevens in een SQL Managed Instance-database vastleggen. De connector bewaakt en registreert toekomstige wijzigingen op rijniveau in deze gegevens. |

| Google Cloud Pub/Sub | Google Pub/Sub is een berichtenservice waarmee u streams van gebeurtenissen kunt publiceren en abonneren. U kunt Google Pub/Sub als bron toevoegen aan uw eventstream om realtime gebeurtenissen vast te leggen, te transformeren en te routeren naar verschillende bestemmingen in Fabric. |

| Amazon Kinesis-gegevensstromen | Amazon Kinesis-gegevensstromen is een zeer schaalbare, zeer duurzame gegevensopname en verwerkingsservice die is geoptimaliseerd voor streaminggegevens. Door Amazon Kinesis-gegevensstromen te integreren als bron in uw eventstream, kunt u realtime gegevensstromen naadloos verwerken voordat u ze doorsturen naar meerdere bestemmingen in Fabric. |

| Confluent Cloud Kafka | Confluent Cloud Kafka is een streamingplatform dat krachtige functies voor gegevensstreaming en -verwerking biedt met behulp van Apache Kafka. Door Confluent Cloud Kafka te integreren als bron in uw eventstream, kunt u realtime gegevensstromen naadloos verwerken voordat u ze doorsturen naar meerdere bestemmingen in Fabric. |

| Amazon MSK Kafka | Amazon MSK Kafka is een volledig beheerde Kafka-service die het instellen, schalen en beheren vereenvoudigt. Door Amazon MSK Kafka te integreren als bron in uw eventstream, kunt u de realtime gebeurtenissen naadloos vanuit uw MSK Kafka overbrengen en verwerken voordat u ze doorsturen naar meerdere bestemmingen in Fabric. |

| Voorbeeldgegevens | U kunt fietsen, yellow taxi- of aandelenmarktgebeurtenissen kiezen als voorbeeldgegevensbron om de gegevensopname te testen tijdens het instellen van een eventstream. |

| Aangepast eindpunt (dat wil gezegd, aangepaste app in standaardmogelijkheid) | Met de aangepaste eindpuntfunctie kunnen uw toepassingen of Kafka-clients verbinding maken met Eventstream met behulp van een verbindingsreeks, waardoor de soepele opname van streaminggegevens naar Eventstream mogelijk wordt. |

| Azure Service Bus (preview) | U kunt gegevens opnemen uit een Azure Service Bus-wachtrij of het abonnement van een onderwerp in Microsoft Fabric met behulp van Eventstream. |

| Apache Kafka (preview) | Apache Kafka is een opensource, gedistribueerd platform voor het bouwen van schaalbare, realtime gegevenssystemen. Door Apache Kafka te integreren als bron in uw eventstream, kunt u naadloos realtime gebeurtenissen uit uw Apache Kafka overbrengen en verwerken voordat u ze doorsturen naar meerdere bestemmingen in Fabric. |

| Azure Blob Storage-gebeurtenissen (preview) | Azure Blob Storage-gebeurtenissen worden geactiveerd wanneer een client een blob maakt, vervangt of verwijdert. Met de connector kunt u Blob Storage-gebeurtenissen koppelen aan Fabric-gebeurtenissen in realtime hub. U kunt deze gebeurtenissen converteren naar continue gegevensstromen en deze transformeren voordat u ze doorsturen naar verschillende bestemmingen in Fabric. |

| Item-gebeurtenissen voor infrastructuurwerkruimten (preview) | Items in de infrastructuurwerkruimte zijn afzonderlijke Fabric-gebeurtenissen die optreden wanneer wijzigingen worden aangebracht in uw infrastructuurwerkruimte. Deze wijzigingen omvatten het maken, bijwerken of verwijderen van een Fabric-item. Met Fabric-gebeurtenisstromen kunt u deze Fabric-werkruimtegebeurtenissen vastleggen, transformeren en routeren naar verschillende bestemmingen in Fabric voor verdere analyse. |

| Fabric OneLake-gebeurtenissen (voorbeeldweergave) | Met OneLake-gebeurtenissen kunt u zich abonneren op wijzigingen in bestanden en mappen in OneLake en vervolgens in realtime reageren op deze wijzigingen. Met Fabric-gebeurtenisstromen kunt u deze OneLake-gebeurtenissen vastleggen, transformeren en routeren naar verschillende bestemmingen in Fabric voor verdere analyse. Deze naadloze integratie van OneLake-gebeurtenissen in Fabric-gebeurtenisstromen biedt u meer flexibiliteit voor het bewaken en analyseren van activiteiten in uw OneLake. |

| Fabric-taakgebeurtenissen (preview) | Met taakevenementen kunt u zich abonneren op wijzigingen die worden geproduceerd wanneer Fabric een taak uitvoert. U kunt bijvoorbeeld reageren op wijzigingen wanneer u een semantisch model vernieuwt, een geplande pijplijn uitvoert of een notebook uitvoert. Elk van deze activiteiten kan een bijbehorende taak genereren, die op zijn beurt een set bijbehorende taakevenementen genereert. Met Fabric-gebeurtenisstromen kunt u deze taakgebeurtenissen vastleggen, transformeren en doorsturen naar verschillende bestemmingen in Fabric voor verdere analyse. Dankzij deze naadloze integratie van taakevenementen in Fabric-gebeurtenisstromen hebt u meer flexibiliteit voor het bewaken en analyseren van activiteiten in uw taak. |

Gebeurtenissen verwerken met behulp van no-code-ervaring

De ervaring voor slepen en neerzetten biedt u een intuïtieve en eenvoudige manier om uw gebeurtenisgegevensverwerking, transformatie en routeringslogica te maken zonder code te schrijven. Een end-to-end gegevensstroomdiagram in een eventstream biedt u een uitgebreid inzicht in de gegevensstroom en organisatie. De gebeurtenisprocessoreditor is een ervaring zonder code waarmee u de logica voor gebeurtenisgegevensverwerking kunt slepen en neerzetten.

| Transformatie | Beschrijving |

|---|---|

| Filter | Gebruik de filtertransformatie om gebeurtenissen te filteren op basis van de waarde van een veld in de invoer. Afhankelijk van het gegevenstype (getal of tekst) behoudt de transformatie de waarden die overeenkomen met de geselecteerde voorwaarde, zoals is null of is not null. |

| Velden beheren | Met de transformatie Velden beheren kunt u velden toevoegen, verwijderen, wijzigen of de naam van velden wijzigen die afkomstig zijn van een invoer of een andere transformatie. |

| Samenvoegen | Gebruik de aggregatietransformatie om telkens wanneer een nieuwe gebeurtenis plaatsvindt in een bepaalde periode een aggregatie (Som, Minimum, Maximum of Gemiddelde) te berekenen. Met deze bewerking kunt u ook de naam van deze berekende kolommen wijzigen en de aggregatie filteren of segmenteren op basis van andere dimensies in uw gegevens. U kunt een of meer aggregaties in dezelfde transformatie hebben. |

| Groeperen op | Gebruik de transformatie Groeperen op om aggregaties te berekenen voor alle gebeurtenissen binnen een bepaald tijdvenster. U kunt groeperen op de waarden in een of meer velden. Het is net zoals de aggregatietransformatie de naam van kolommen kan wijzigen, maar biedt meer opties voor aggregatie en bevat complexere opties voor tijdvensters. Net als Aggregatie kunt u meer dan één aggregatie per transformatie toevoegen. |

| Vakbond | Gebruik de samenvoegingstransformatie om twee of meer knooppunten te verbinden en gebeurtenissen toe te voegen met gedeelde velden (met dezelfde naam en hetzelfde gegevenstype) in één tabel. Velden die niet overeenkomen, worden verwijderd en niet opgenomen in de uitvoer. |

| Uitvouwen | Gebruik de matrixtransformatie Uitvouwen om een nieuwe rij te maken voor elke waarde in een matrix. |

| Deelnemen | Gebruik de jointransformatie om gegevens uit twee streams te combineren op basis van een overeenkomende voorwaarde tussen deze stromen. |

Als u verbeterde mogelijkheden hebt ingeschakeld tijdens het maken van een eventstream, worden de transformatiebewerkingen ondersteund voor alle bestemmingen (waarbij afgeleide stream fungeert als een tussenliggende brug voor sommige bestemmingen, zoals aangepast eindpunt, Fabric Activator). Als u dit niet hebt gedaan, zijn de transformatiebewerkingen alleen beschikbaar voor de Bestemmingen Lakehouse en Eventhouse (gebeurtenisverwerking vóór opname).

Gebeurtenissen routeren naar bestemmingen

De functie Fabric-gebeurtenisstromen ondersteunt het verzenden van gegevens naar de volgende ondersteunde bestemmingen.

| Bestemming | Beschrijving |

|---|---|

| Aangepast eindpunt (d.w.w.v. aangepaste app in standaardmogelijkheid) | Met deze bestemming kunt u uw realtime gebeurtenissen eenvoudig doorsturen naar een aangepast eindpunt. U kunt uw eigen toepassingen verbinden met de eventstream en de gebeurtenisgegevens in realtime gebruiken. Deze bestemming is handig als u realtime gegevens wilt uitgaan naar een extern systeem buiten Microsoft Fabric. |

| Eventhouse | Met deze bestemming kunt u uw realtime gebeurtenisgegevens opnemen in een Eventhouse, waar u de krachtige Kusto-querytaal (KQL) kunt gebruiken om query's uit te voeren en de gegevens te analyseren. Met de gegevens in Eventhouse krijgt u meer inzicht in uw gebeurtenisgegevens en kunt u uitgebreide rapporten en dashboards maken. U kunt kiezen tussen twee opnamemodi: Directe opname en gebeurtenisverwerking vóór opname. |

| Lakehouse | Deze bestemming biedt u de mogelijkheid om uw realtime gebeurtenissen te transformeren voordat u ze in uw lakehouse opneemt. Realtime gebeurtenissen worden omgezet in Delta Lake-indeling en worden vervolgens opgeslagen in de aangewezen lakehouse-tabellen. Deze bestemming ondersteunt scenario's voor datawarehousing. |

| Afgeleide stroom | Afgeleide stream is een speciaal type bestemming dat u kunt maken nadat u stroombewerkingen, zoals Filter of Manage Fields, hebt toegevoegd aan een eventstream. De afgeleide stream vertegenwoordigt de getransformeerde standaardstroom na stroomverwerking. U kunt de afgeleide stream routeren naar meerdere bestemmingen in Fabric en de afgeleide stream bekijken in de realtime-hub. |

| Fabric Activator (preview) | Met deze bestemming kunt u uw realtime gebeurtenisgegevens rechtstreeks verbinden met een Fabric Activator. Activator is een type intelligente agent die alle informatie bevat die nodig is om verbinding te maken met gegevens, te controleren op omstandigheden en actie te ondernemen. Wanneer de gegevens bepaalde drempelwaarden bereiken of overeenkomen met andere patronen, neemt Activator automatisch de juiste actie, zoals het waarschuwen van gebruikers of het starten van Power Automate-werkstromen. |

U kunt meerdere bestemmingen in een eventstream koppelen om tegelijkertijd gegevens van uw eventstreams te ontvangen zonder dat ze elkaar verstoren.

Notitie

We raden aan dat u de functie gebeurtenisstreams van Microsoft Fabric gebruikt met ten minste vier capaciteitsunits (SKU: F4)

Gebeurtenisstromen van Apache Kafka in Fabric

De functie Fabric-gebeurtenisstromen biedt een Apache Kafka-eindpunt op het Eventstream-item, zodat gebruikers via het Kafka-protocol streaminggebeurtenissen kunnen verbinden en gebruiken. Als uw toepassing al gebruikmaakt van het Apache Kafka-protocol voor het verzenden of ontvangen van streaminggebeurtenissen met specifieke onderwerpen, kunt u het eenvoudig verbinden met uw Eventstream. Werk de verbindingsinstellingen bij om het Kafka-eindpunt in uw Eventstream te gebruiken.

De functie Fabric-gebeurtenisstromen wordt mogelijk gemaakt door Azure Event Hubs, een volledig beheerde cloudeigen service. Wanneer een eventstream wordt gemaakt, wordt automatisch een Event Hub-naamruimte ingericht en wordt een Event Hub toegewezen aan de standaardstream zonder dat hiervoor inrichtingsconfiguraties nodig zijn. Zie Azure Event Hubs voor Apache Kafka voor meer informatie over de kafka-compatibele functies in de Azure Event Hubs-service.

Zie Aangepaste eindpuntbron toevoegen aan een eventstream voor meer informatie over het verkrijgen van de details van het Kafka-eindpunt voor het verzenden van gebeurtenissen naar eventstream. Zie Een aangepast eindpuntdoel toevoegen aan een eventstream voor meer informatie over het verkrijgen van de details van het Kafka-eindpunt.

Beperkingen

Fabric Eventstream heeft de volgende algemene beperkingen. Voordat u met Eventstream werkt, bekijkt u deze beperkingen om ervoor te zorgen dat deze overeenkomen met uw vereisten.

| Grens | Grootte |

|---|---|

| Maximale berichtgrootte | 1 MB |

| Maximale bewaartermijn van gebeurtenisgegevens | 90 dagen |