Confluent Kafka-bron toevoegen aan een eventstream

In dit artikel leest u hoe u confluent Kafka-bron toevoegt aan een eventstream.

Confluent Cloud Kafka is een streamingplatform dat krachtige functies voor gegevensstreaming en -verwerking biedt met behulp van Apache Kafka. Door Confluent Cloud Kafka te integreren als bron in uw eventstream, kunt u realtime gegevensstromen naadloos verwerken voordat u ze doorsturen naar meerdere bestemmingen in Fabric.

Notitie

Deze bron wordt niet ondersteund in de volgende regio's van uw werkruimtecapaciteit: VS - west 3, Zwitserland - west.

Vereisten

- Toegang tot een werkruimte in de licentiemodus voor infrastructuurcapaciteit (of) de modus Voor proeflicenties met inzender- of hogere machtigingen.

- Een Confluent Cloud Kafka-cluster en een API-sleutel.

- Uw Confluent Cloud Kafka-cluster moet openbaar toegankelijk zijn en zich niet achter een firewall bevinden of zijn beveiligd in een virtueel netwerk.

- Als u geen eventstream hebt, maakt u een eventstream.

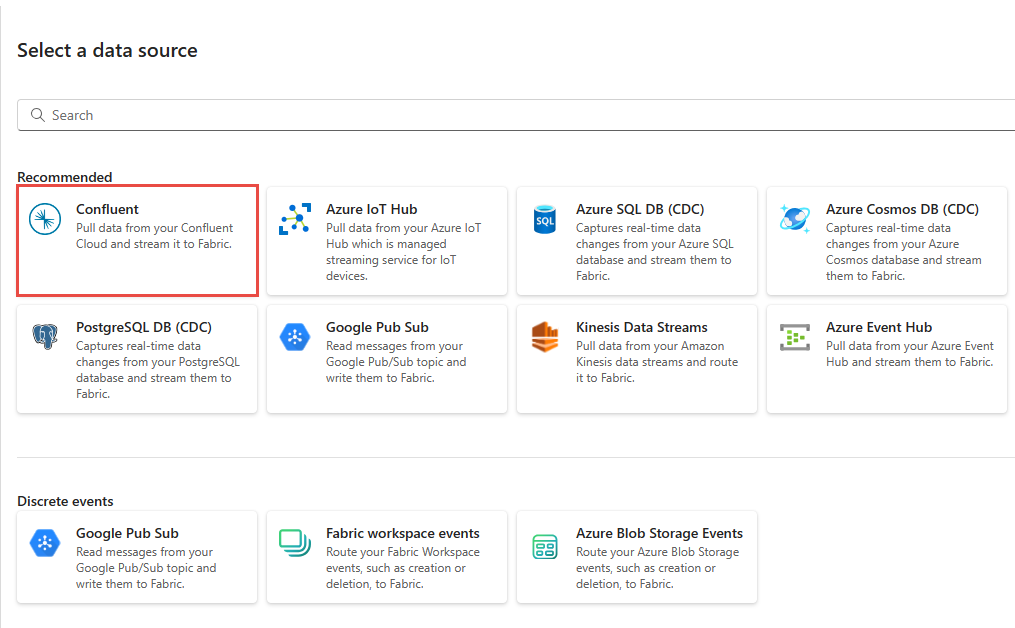

De wizard Een gegevensbron selecteren starten

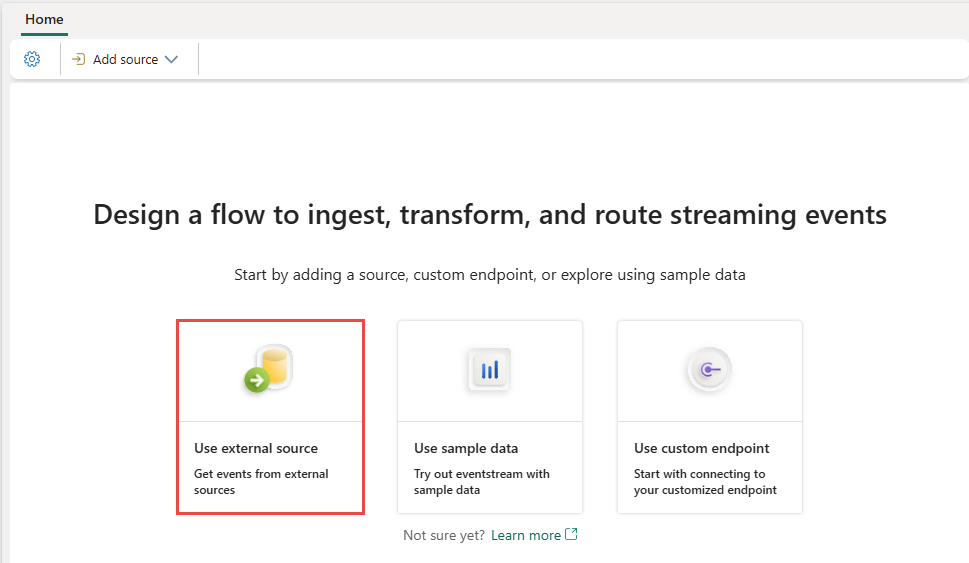

Als u nog geen bron aan uw eventstream hebt toegevoegd, selecteert u De tegel Externe bron gebruiken.

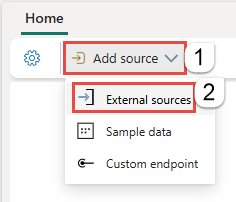

Als u de bron toevoegt aan een al gepubliceerde gebeurtenisstroom, schakelt u over naar de bewerkingsmodus, selecteert u Bron toevoegen op het lint en selecteert u Vervolgens Externe bronnen.

Confluent Kafka configureren en er verbinding mee maken

Selecteer Confluent op de pagina Een gegevensbron selecteren.

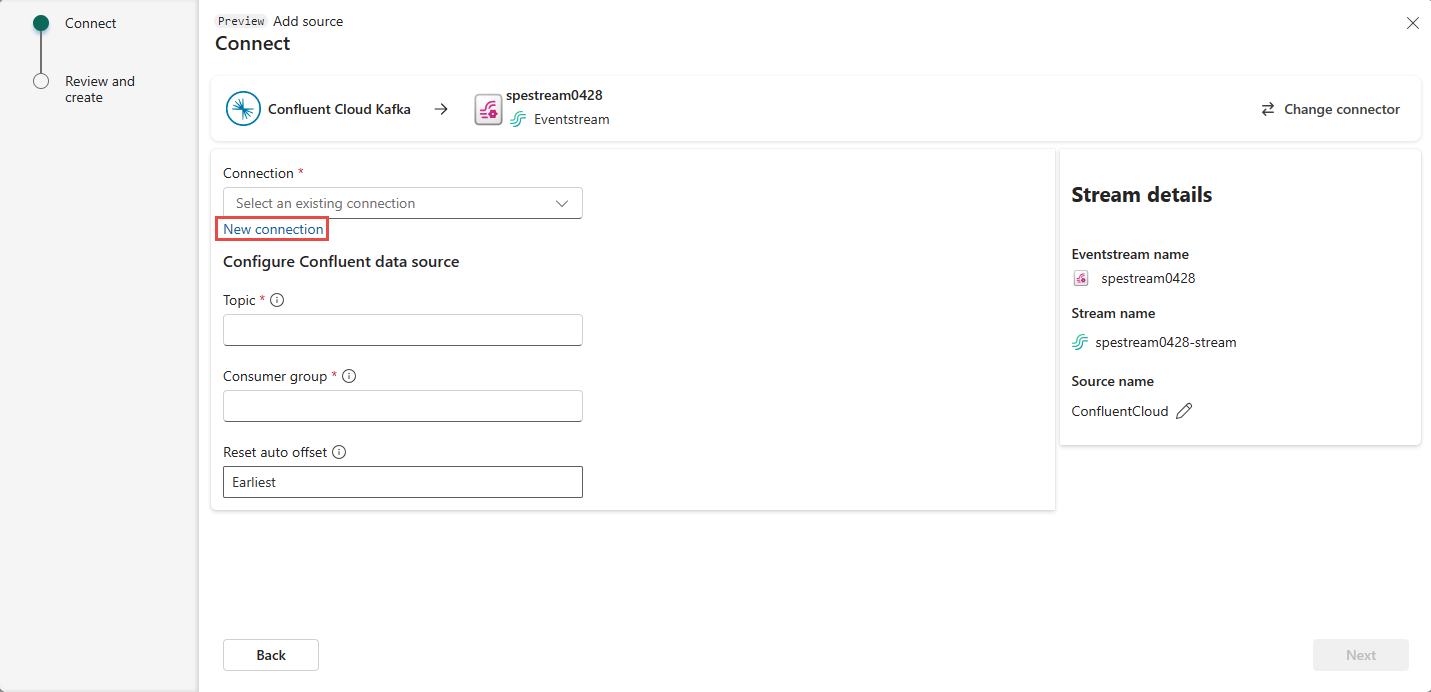

Als u een verbinding wilt maken met de Confluent Cloud Kafka-bron, selecteert u Nieuwe verbinding.

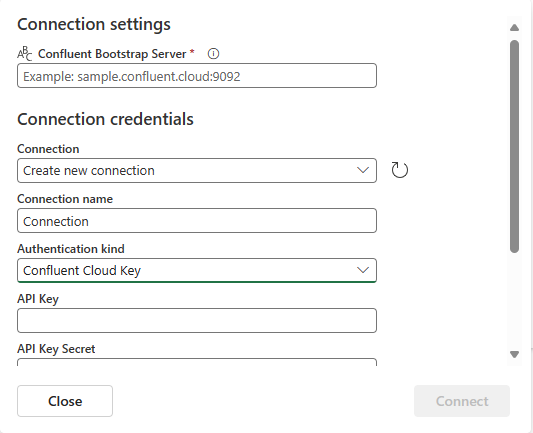

Voer in de sectie Verbindingsinstellingen Confluent Bootstrap-server in. Navigeer naar de startpagina van Confluent Cloud, selecteer Clusterinstellingen en kopieer het adres naar uw Bootstrap-server.

Als u een bestaande verbinding met het Confluent-cluster hebt in de sectie Verbindingsreferenties , selecteert u deze in de vervolgkeuzelijst voor Verbinding. Voer anders de volgende stappen uit:

- Voer voor de verbindingsnaam een naam in voor de verbinding.

- Controleer voor verificatietype of Confluent Cloud Key is geselecteerd.

- Voor API-sleutel en API-sleutelgeheim:

Navigeer naar uw Confluent Cloud.

Selecteer API-sleutels in het zijmenu.

Selecteer de knop Sleutel toevoegen om een nieuwe API-sleutel te maken.

Kopieer de API-sleutel en het geheim.

Plak deze waarden in de velden API-sleutel en API-sleutelgeheim .

Selecteer Verbinden

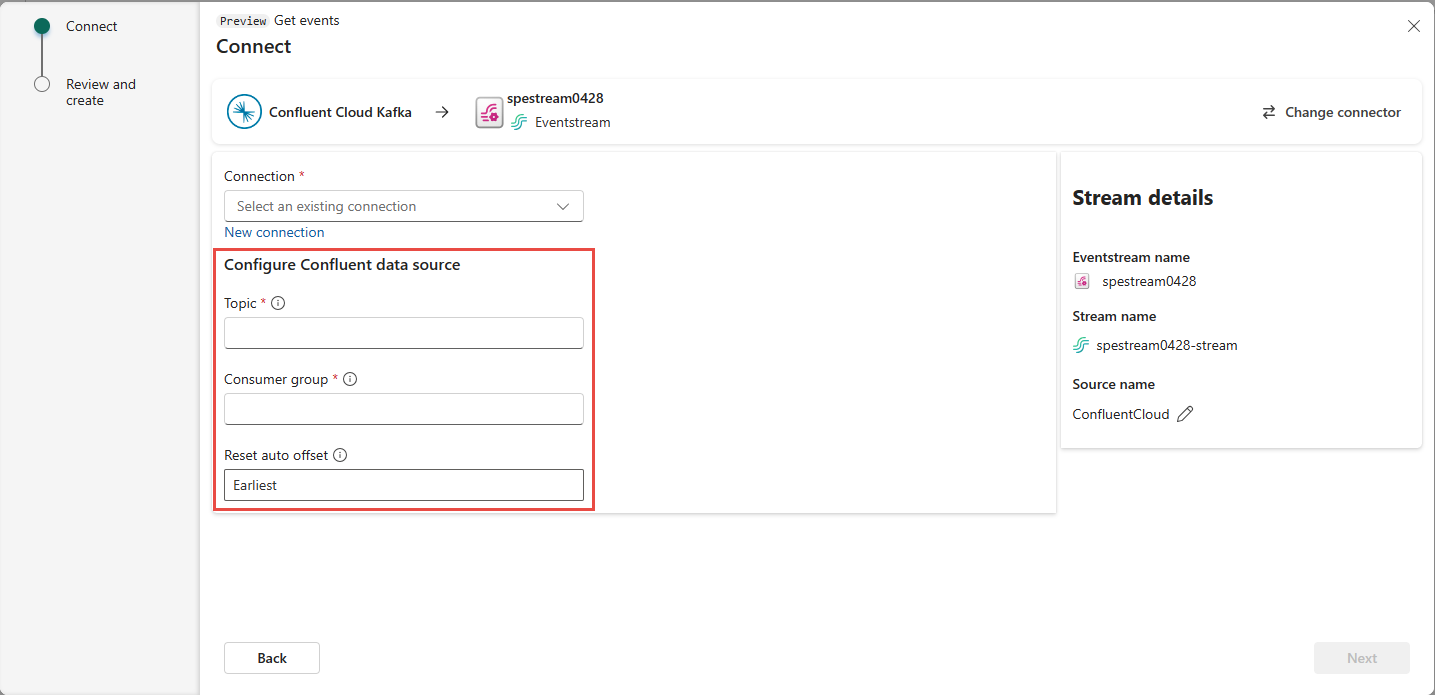

Schuif naar de sectie Confluent-gegevensbron configureren op de pagina. Voer de informatie in om de configuratie van de Confluent-gegevensbron te voltooien.

- Voer voor Onderwerp een onderwerpnaam in vanuit uw Confluent Cloud. U kunt uw onderwerp maken of beheren in de Confluent Cloud Console.

- Voer voor consumentengroep een consumentengroep van uw Confluent Cloud in. Het biedt u de toegewezen consumentengroep voor het ophalen van de gebeurtenissen uit het Confluent Cloud-cluster.

- Selecteer een van de volgende waarden voor de instelling Automatische offset opnieuw instellen:

Vroegste: de vroegste gegevens die beschikbaar zijn vanuit uw Confluent-cluster

Nieuwste : de meest recente beschikbare gegevens

Geen : stel de offset niet automatisch in.

Selecteer Volgende. Controleer in het scherm Controleren en maken de samenvatting en selecteer vervolgens Toevoegen.

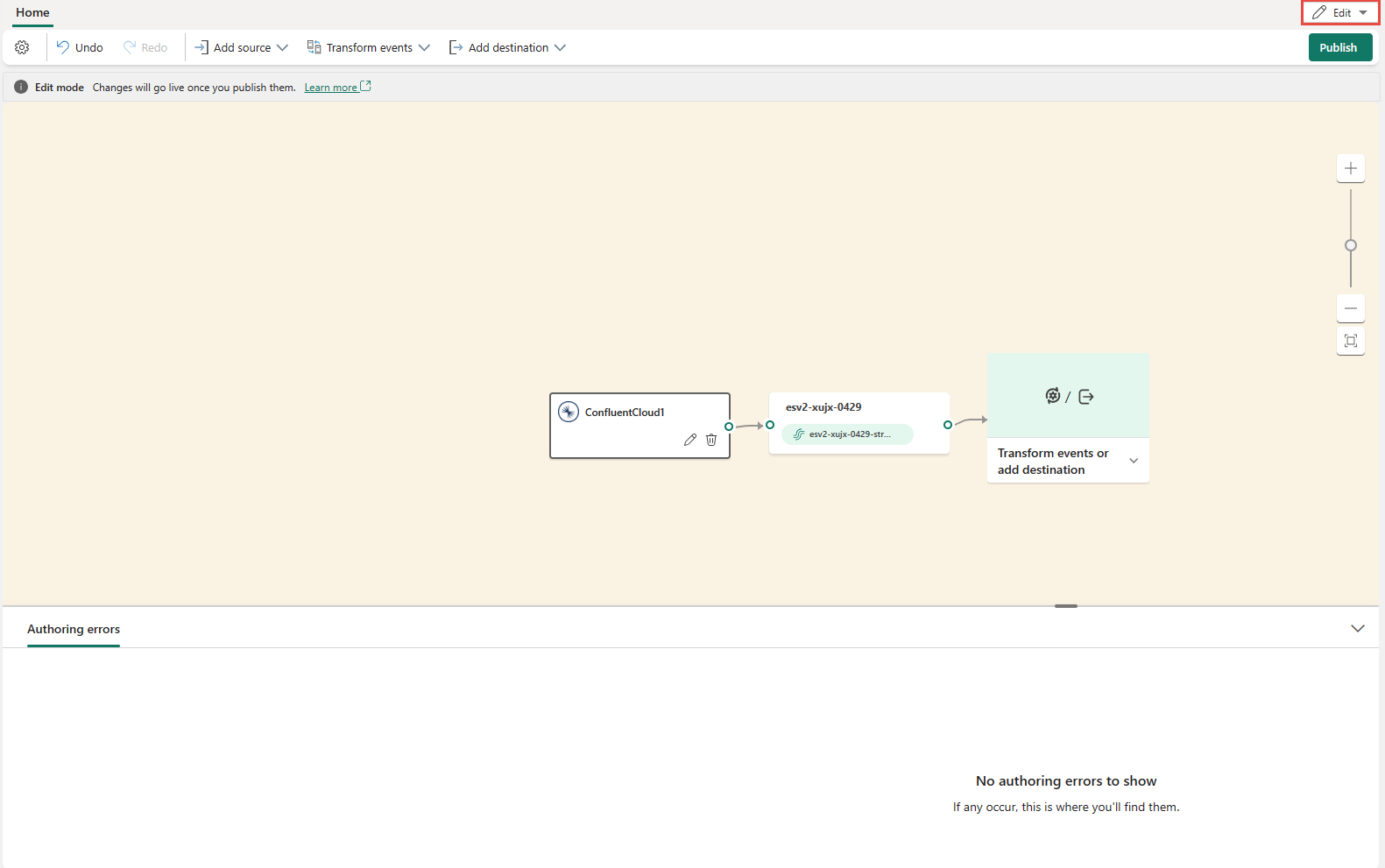

U ziet dat de Confluent Cloud Kafka-bron wordt toegevoegd aan uw eventstream op het canvas in de bewerkingsmodus. Als u deze zojuist toegevoegde Confluent Cloud Kafka-bron wilt implementeren, selecteert u Publiceren op het lint.

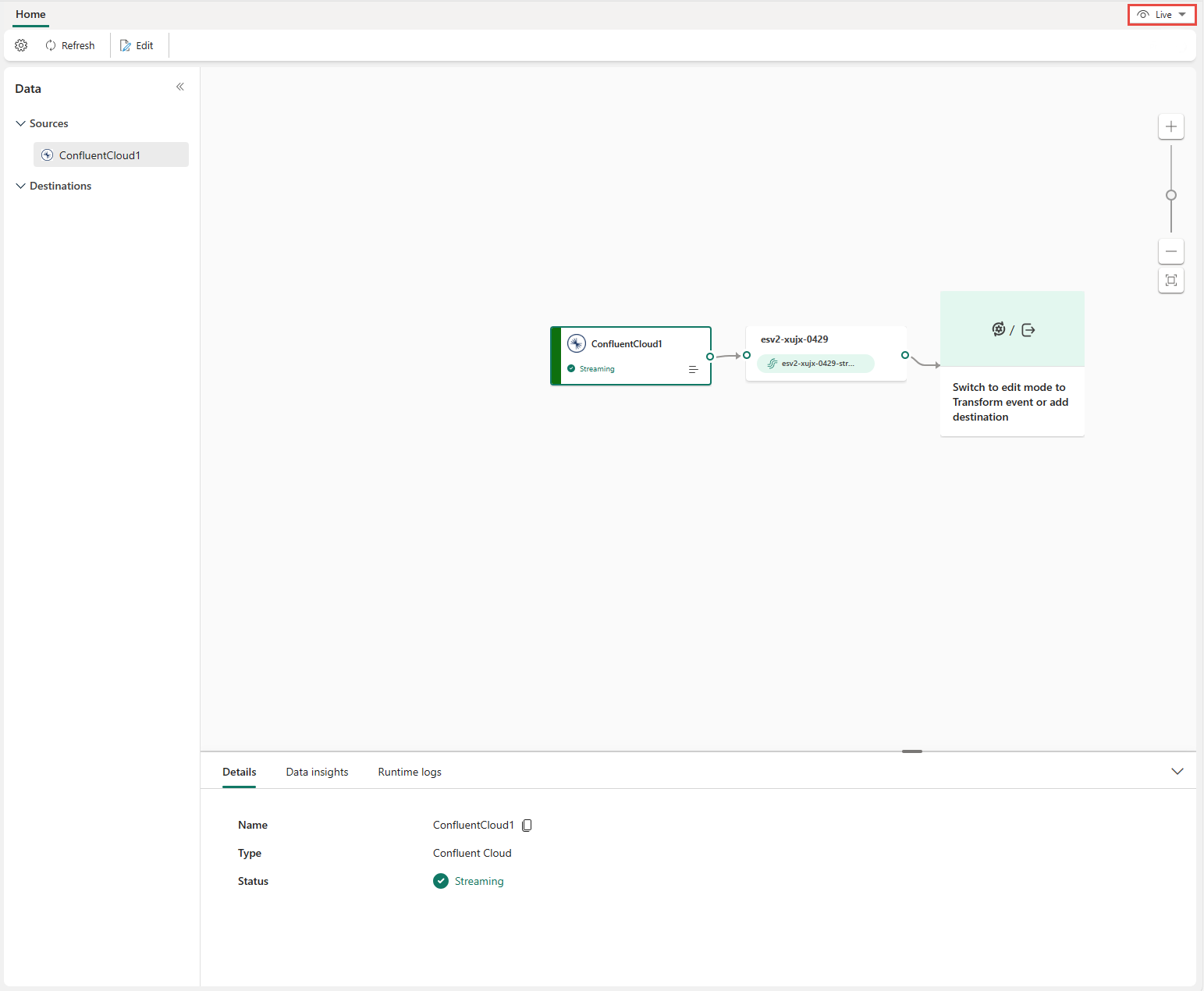

Nadat u deze stappen hebt voltooid, is de Confluent Cloud Kafka-bron beschikbaar voor visualisatie in de liveweergave.

Beperkingen

- Confluent Kafka met JSON- en Avro-indelingen, met behulp van schemaregister, wordt momenteel niet ondersteund.

- Het decoderen van gegevens uit Confluent Kafka met behulp van het Confluent-schemaregister wordt momenteel niet ondersteund.

Notitie

Het maximum aantal bronnen en bestemmingen voor één eventstream is 11.

Gerelateerde inhoud

Andere connectors: