Opties voor het ophalen van gegevens in Fabric Lakehouse

De ervaring voor het ophalen van gegevens omvat alle gebruikersscenario's voor het binnenbrengen van gegevens in lakehouse, zoals:

- Verbinding maken met bestaande SQL Server en gegevens kopiëren naar deltatabel op het lakehouse.

- Bestanden uploaden vanaf uw computer.

- Meerdere tabellen uit andere lakehouses kopiëren en samenvoegen in een nieuwe Delta-tabel.

- Verbinding maken met een streamingbron om gegevens te landen in een lakehouse.

- Verwijzen naar gegevens zonder deze te kopiëren uit andere interne lakehouses of externe bronnen.

Verschillende manieren om gegevens in een lakehouse te laden

In Microsoft Fabric zijn er een aantal manieren waarop u gegevens in een lakehouse kunt ophalen:

- Bestand uploaden vanaf lokale computer

- Een hulpprogramma voor kopiëren uitvoeren in pijplijnen

- Een gegevensstroom instellen

- Apache Spark-bibliotheken in notebookcode

- Realtimegebeurtenissen streamen met Eventstream

- Gegevens ophalen uit Eventhouse

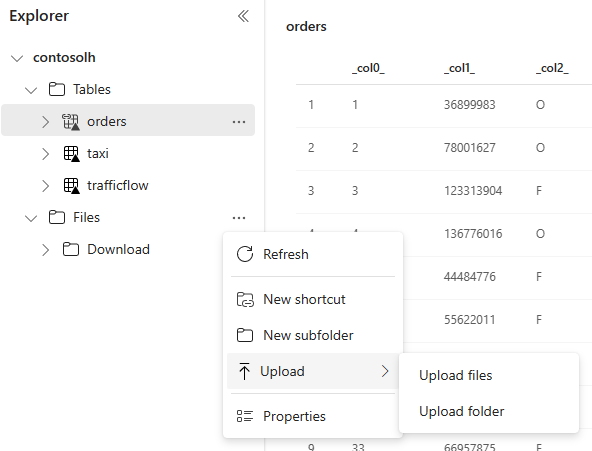

Lokaal bestand uploaden

U kunt ook gegevens uploaden die zijn opgeslagen op uw lokale computer. U kunt dit rechtstreeks doen in de Lakehouse-verkenner.

Hulpprogramma kopiëren in pijplijnen

Het hulpprogramma Kopiëren is een zeer schaalbare Data-Integratie oplossing waarmee u verbinding kunt maken met verschillende gegevensbronnen en de gegevens in de oorspronkelijke indeling kunt laden of naar een Delta-tabel kunt converteren. Het hulpprogramma Kopiëren maakt deel uit van pijplijnactiviteiten die u op meerdere manieren kunt wijzigen, zoals plannen of activeren op basis van een gebeurtenis. Zie Gegevens kopiëren met behulp van kopieeractiviteit voor meer informatie.

Gegevensstromen

Voor gebruikers die bekend zijn met Power BI-gegevensstromen, is hetzelfde hulpprogramma beschikbaar om gegevens in uw Lakehouse te laden. U kunt deze snel openen via de optie 'Gegevens ophalen' van Lakehouse Explorer en gegevens laden van meer dan 200 connectors. Zie Quickstart voor meer informatie: Uw eerste gegevensstroom maken om gegevens op te halen en te transformeren.

Notebookcode

U kunt beschikbare Spark-bibliotheken gebruiken om rechtstreeks verbinding te maken met een gegevensbron, gegevens te laden in een gegevensframe en deze vervolgens op te slaan in een lakehouse. Deze methode is de meest open manier om gegevens in lakehouse te laden die volledig worden beheerd door gebruikerscode.

Notitie

Externe Delta-tabellen die zijn gemaakt met Spark-code, zijn niet zichtbaar voor een SQL-analyse-eindpunt. Gebruik snelkoppelingen in de tabelruimte om externe Delta-tabellen zichtbaar te maken voor een SQL-analyse-eindpunt. Zie Een snelkoppeling maken naar bestanden of tabellenvoor meer informatie over het maken van een snelkoppeling.

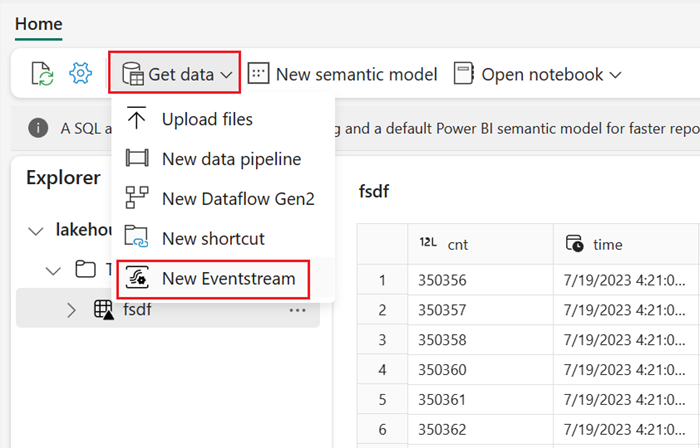

Realtimegebeurtenissen streamen met Eventstream

Met Eventstream kunt u realtime gebeurtenissen ophalen, verwerken en routeren vanuit een groot aantal bronnen.

Zie Gegevens ophalen uit Eventstream in een lakehouse om te zien hoe u Lakehouse toevoegt als bestemming voor Eventstream.

Voor optimale streamingprestaties kunt u gegevens van Eventstream streamen naar een Eventhouse en vervolgens De beschikbaarheid van OneLake inschakelen.

Gegevens ophalen uit Eventhouse

Wanneer u OneLake-beschikbaarheid inschakelt voor gegevens in een Eventhouse, wordt er een Delta-tabel gemaakt in OneLake. Deze Delta-tabel kan worden geopend door een lakehouse met behulp van een snelkoppeling. Zie OneLake-snelkoppelingen voor meer informatie. Zie Eventhouse OneLake-beschikbaarheid voor meer informatie.

Overwegingen bij het kiezen van een benadering voor het laden van gegevens

| Gebruiksscenario | Aanbeveling |

|---|---|

| Kleine bestanden uploaden vanaf lokale computer | Lokaal bestand uploaden gebruiken |

| Kleine gegevens of specifieke connector | Gegevensstromen gebruiken |

| Grote gegevensbron | Hulpprogramma Kopiëren gebruiken in pijplijnen |

| Complexe gegevenstransformaties | Notebook-code gebruiken |

| Streaminggegevens | Eventstream gebruiken om gegevens te streamen naar Eventhouse; OneLake-beschikbaarheid inschakelen en een snelkoppeling maken vanuit Lakehouse |

| Tijdreeksgegevens | Gegevens ophalen uit Eventhouse |

Gerelateerde inhoud

- De gegevens in uw lakehouse verkennen met een notebook

- Quickstart: Uw eerste pijplijn maken om gegevens te kopiëren

- Gegevens kopiëren met behulp van kopieeractiviteit

- Gegevens verplaatsen van Azure SQL DB naar Lakehouse via kopieerassistent

- Een lakehouse-bestemming toevoegen aan een eventstream

- Beschikbaarheid van Eventhouse OneLake