Evaluatie van generatieve AI-toepassingen

Belangrijk

Items die in dit artikel zijn gemarkeerd (preview) zijn momenteel beschikbaar als openbare preview. Deze preview wordt aangeboden zonder een service level agreement en we raden deze niet aan voor productieworkloads. Misschien worden bepaalde functies niet ondersteund of zijn de mogelijkheden ervan beperkt. Zie Aanvullende gebruiksvoorwaarden voor Microsoft Azure-previews voor meer informatie.

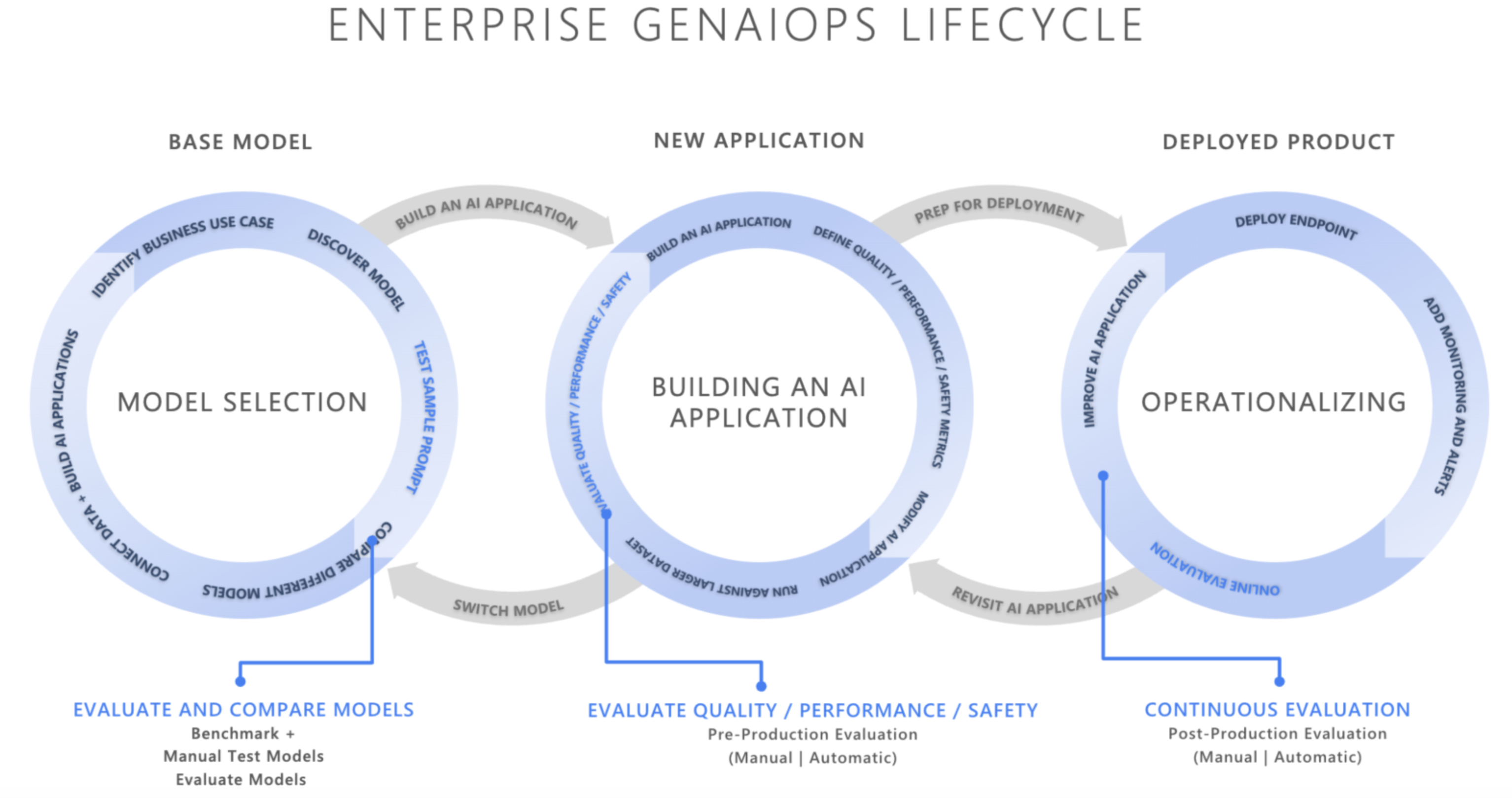

In het snel veranderende landschap van kunstmatige intelligentie transformeert de integratie van GenAIOps (Ative AI Operations) hoe organisaties AI-toepassingen ontwikkelen en implementeren. Omdat bedrijven steeds vaker vertrouwen op AI om besluitvorming te verbeteren, klantervaringen te verbeteren en innovatie te stimuleren, kan het belang van een robuust evaluatieframework niet worden overdreven. Evaluatie is een essentieel onderdeel van de generatieve AI-levenscyclus om vertrouwen en vertrouwen in AI-gerichte toepassingen te bouwen. Als deze toepassingen niet zorgvuldig zijn ontworpen, kunnen deze toepassingen uitvoer produceren die zijn gemaakt en niet-geaard in context, irrelevant of incoherent, wat resulteert in slechte klantervaringen, of erger, maatschappelijke stereotypen bevorderen, onjuiste informatie bevorderen, organisaties blootstellen aan schadelijke aanvallen of een breed scala aan andere negatieve effecten.

Evaluators zijn nuttige hulpmiddelen om de frequentie en ernst van inhoudsrisico's of ongewenst gedrag in AI-antwoorden te beoordelen. Het uitvoeren van iteratieve, systematische evaluaties met de juiste evaluators kan teams helpen bij het meten en aanpakken van mogelijke responskwaliteit, veiligheid of beveiligingsproblemen gedurende de levenscyclus van AI-ontwikkeling, van de eerste modelselectie tot na productiebewaking. Evaluatie binnen de productie van de levenscyclus van GenAI Ops.

Door in elke fase effectieve evaluatiestrategieën te begrijpen en te implementeren, kunnen organisaties ervoor zorgen dat hun AI-oplossingen niet alleen voldoen aan de initiële verwachtingen, maar zich ook aanpassen en bloeien in echte omgevingen. Laten we eens bekijken hoe evaluatie past in de drie kritieke fasen van de AI-levenscyclus

Selectie van basismodel

De eerste fase van de AI-levenscyclus omvat het selecteren van een geschikt basismodel. Generatieve AI-modellen variëren sterk in termen van mogelijkheden, sterke punten en beperkingen, dus het is essentieel om te bepalen welk model het beste past bij uw specifieke use-case. Tijdens de evaluatie van het basismodel kunt u verschillende modellen vergelijken door de uitvoer te testen op basis van een reeks criteria die relevant zijn voor uw toepassing.

Belangrijke overwegingen in deze fase kunnen zijn:

- Nauwkeurigheid/kwaliteit: Hoe goed genereert het model relevante en coherente reacties?

- Prestaties voor specifieke taken: Kan het model het type prompts en inhoud verwerken dat nodig is voor uw use-case? Hoe zijn de latentie en kosten?

- Bias en ethische overwegingen: Produceert het model uitvoer die schadelijke stereotypen kan bestendigen of bevorderen?

- Risico's en veiligheid: Zijn er risico's van het model dat onveilige of schadelijke inhoud genereert?

U kunt Azure AI Foundry-benchmarksverkennen om modellen te evalueren en vergelijken op openbaar beschikbare gegevenssets, terwijl u ook benchmarkresultaten op uw eigen gegevens opnieuw kunt genereren. U kunt ook een van de vele basisgeneratieve AI-modellen evalueren via de Azure AI Evaluation SDK, zoals gedemonstreerd. Zie het voorbeeld van modeleindpunten evalueren.

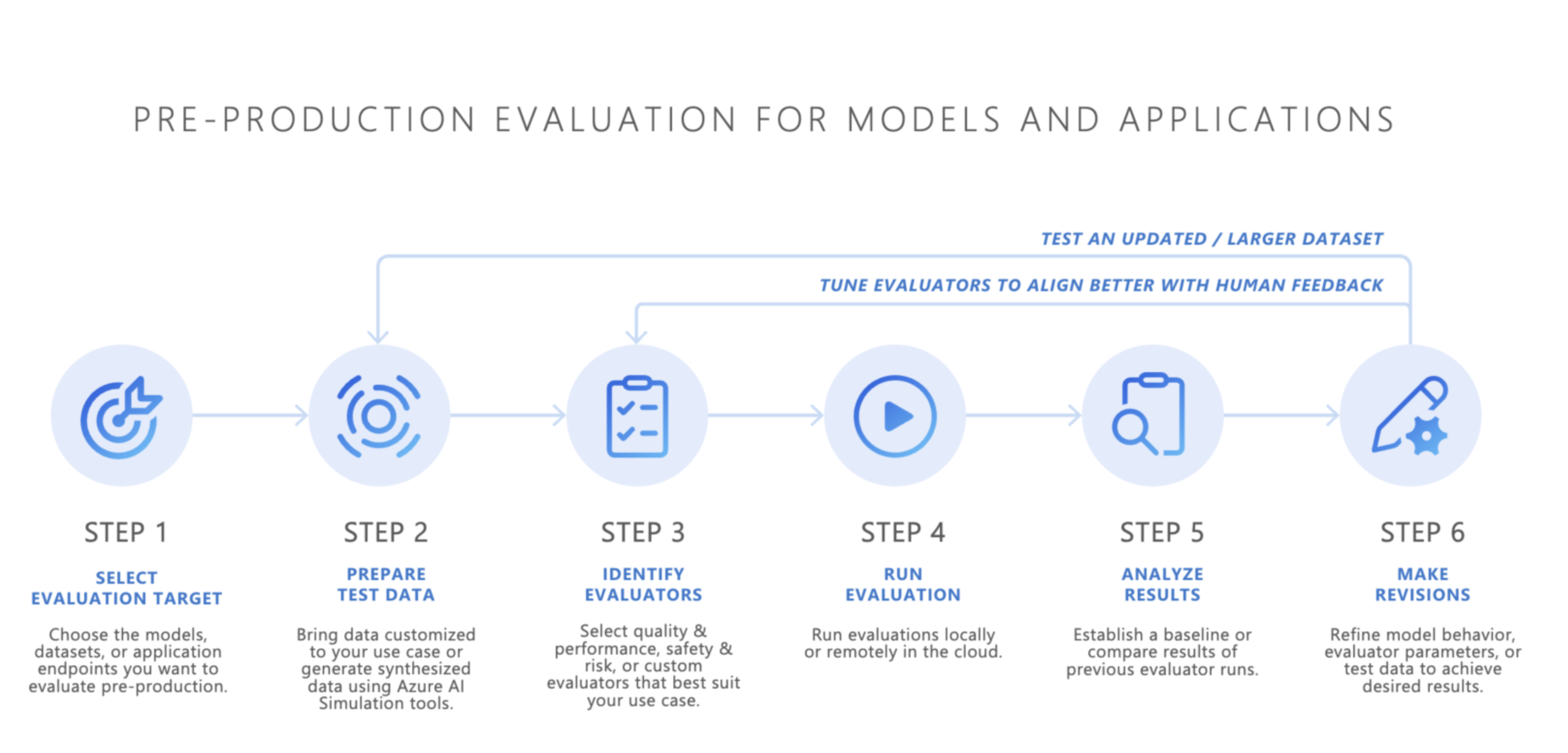

Evaluatie van preproductie

Nadat u een basismodel hebt geselecteerd, is de volgende stap het ontwikkelen van een AI-toepassing, zoals een AI-chatbot, een rag-toepassing (retrieval-augmented generation), een agentische AI-toepassing of een ander generatief AI-hulpprogramma. Na de ontwikkeling begint de evaluatie van de preproductie. Voordat u de toepassing in een productieomgeving implementeert, is strenge tests essentieel om ervoor te zorgen dat het model echt gereed is voor gebruik in de echte wereld.

Evaluatie van preproductie omvat:

- Testen met evaluatiegegevenssets: deze gegevenssets simuleren realistische gebruikersinteracties om ervoor te zorgen dat de AI-toepassing naar verwachting presteert.

- Edge-gevallen identificeren: scenario's zoeken waarbij de responskwaliteit van de AI-toepassing kan afnemen of ongewenste uitvoer kan produceren.

- Robuustheid beoordelen: Ervoor zorgen dat het model een reeks invoervariaties kan verwerken zonder dat er aanzienlijke dalingen in kwaliteit of veiligheid zijn.

- Belangrijke metrische gegevens meten: metrische gegevens, zoals geaardheid van reacties, relevantie en veiligheid, worden geëvalueerd om de gereedheid voor productie te bevestigen.

De preproductiefase fungeert als een definitieve kwaliteitscontrole, waardoor het risico wordt beperkt dat een AI-toepassing wordt geïmplementeerd die niet voldoet aan de gewenste prestatie- of veiligheidsnormen.

- Bring Your Own Data: U kunt uw AI-toepassingen evalueren in preproductie met behulp van uw eigen evaluatiegegevens met azure AI Foundry of de ondersteunde evaluators van Azure AI Evaluation SDK , waaronder generatiekwaliteit, veiligheid of aangepaste evaluators, en resultaten weergeven via de Azure AI Foundry-portal.

- Simulators: Als u geen evaluatiegegevens (testgegevens) hebt, kunnen de simulators van de Azure AI Evaluation SDK u helpen door onderwerpgerelateerde of adversariele query's te genereren. Deze simulatoren testen de reactie van het model op situatiespecifieke of aanvalsachtige query's (edge-cases).

- De adversarial simulator injecteert query's die mogelijke beveiligingsrisico's nabootsen of jailbreaks proberen, om beperkingen te identificeren en het model voor te bereiden op onverwachte omstandigheden.

- Context geschikte simulators genereren typische, relevante gesprekken die u van gebruikers verwacht om de kwaliteit van reacties te testen.

U kunt ook de evaluatiewidget van Azure AI Foundry gebruiken om uw generatieve AI-toepassingen te testen.

Zodra bevredigende resultaten zijn bereikt, kan de AI-toepassing worden geïmplementeerd in productie.

Bewaking na productie

Na de implementatie voert de AI-toepassing de fase na productieevaluatie in, ook wel online evaluatie of bewaking genoemd. In deze fase wordt het model ingesloten in een echt product en reageert op werkelijke gebruikersquery's. Bewaking zorgt ervoor dat het model zich blijft gedragen zoals verwacht en zich aanpast aan eventuele wijzigingen in gebruikersgedrag of -inhoud.

- Doorlopend bijhouden van prestaties: meet regelmatig de reactie van de AI-toepassing met behulp van belangrijke metrische gegevens om een consistente uitvoerkwaliteit te garanderen.

- Incidentrespons: Reageer snel op schadelijke, oneerlijke of ongepaste uitvoer die zich kan voordoen tijdens het gebruik in de praktijk.

Door continu het gedrag van de AI-toepassing in productie te bewaken, kunt u gebruikerservaringen van hoge kwaliteit onderhouden en snel eventuele problemen oplossen die zich voordoen.

Conclusie

GenAIOps gaat allemaal over het opzetten van een betrouwbaar en herhaalbaar proces voor het beheren van generatieve AI-toepassingen gedurende hun levenscyclus. Evaluatie speelt in elke fase een belangrijke rol, van basismodelselectie tot doorlopende postproductiebewaking. Door risico's systematisch te meten en aan te pakken en AI-systemen bij elke stap te verfijnen, kunnen teams generatieve AI-oplossingen bouwen die niet alleen krachtig, maar ook betrouwbaar en veilig zijn voor gebruik in de praktijk.

Cheatsheet:

| Doel | Proces | Parameters |

|---|---|---|

| Waarvoor evalueert u? | Relevante evaluators identificeren of bouwen |

-

Kwaliteit en prestaties ( notebook met kwaliteits- en prestatievoorbeelden) - Veiligheids- en beveiligingsnotitieblok (voorbeeldnotitieblok voor veiligheid en beveiliging) - Aangepast (aangepast voorbeeldnotebook) |

| Welke gegevens moet u gebruiken? | Relevante gegevensset uploaden of genereren |

Algemene simulator voor het meten van kwaliteit en prestaties (generic simulator sample notebook) - Adversarial simulator voor het meten van veiligheid en beveiliging (adversarial simulator sample notebook) |

| Welke resources moeten de evaluatie uitvoeren? | Evaluatie uitvoeren | - Lokale uitvoering - Externe clouduitvoering |

| Hoe heeft mijn model/app uitgevoerd? | Resultaten analyseren | Geaggregeerde scores weergeven, details weergeven, scoredetails, evaluatieuitvoeringen vergelijken |

| Hoe kan ik verbeteren? | Wijzigingen aanbrengen in model-, app- of evaluators | - Als de evaluatieresultaten niet zijn afgestemd op menselijke feedback, past u uw evaluator aan. - Als de evaluatieresultaten zijn afgestemd op menselijke feedback, maar niet voldoen aan de drempelwaarden voor kwaliteit/veiligheid, past u gerichte oplossingen toe. |