Modelbenchmarks in de Azure AI Foundry-portal

Belangrijk

Items die in dit artikel zijn gemarkeerd (preview) zijn momenteel beschikbaar als openbare preview. Deze preview wordt aangeboden zonder een service level agreement en we raden deze niet aan voor productieworkloads. Misschien worden bepaalde functies niet ondersteund of zijn de mogelijkheden ervan beperkt. Zie Aanvullende gebruiksvoorwaarden voor Microsoft Azure-previews voor meer informatie.

In de Azure AI Foundry-portal kunt u benchmarks vergelijken tussen modellen en gegevenssets die beschikbaar zijn in de branche om te bepalen welke voldoet aan uw bedrijfsscenario. U hebt rechtstreeks toegang tot gedetailleerde benchmarkresultaten in de modelcatalogus. Of u nu al modellen in gedachten hebt of modellen verkent, met de benchmarkinggegevens in Azure AI kunt u snel en efficiënt weloverwogen beslissingen nemen.

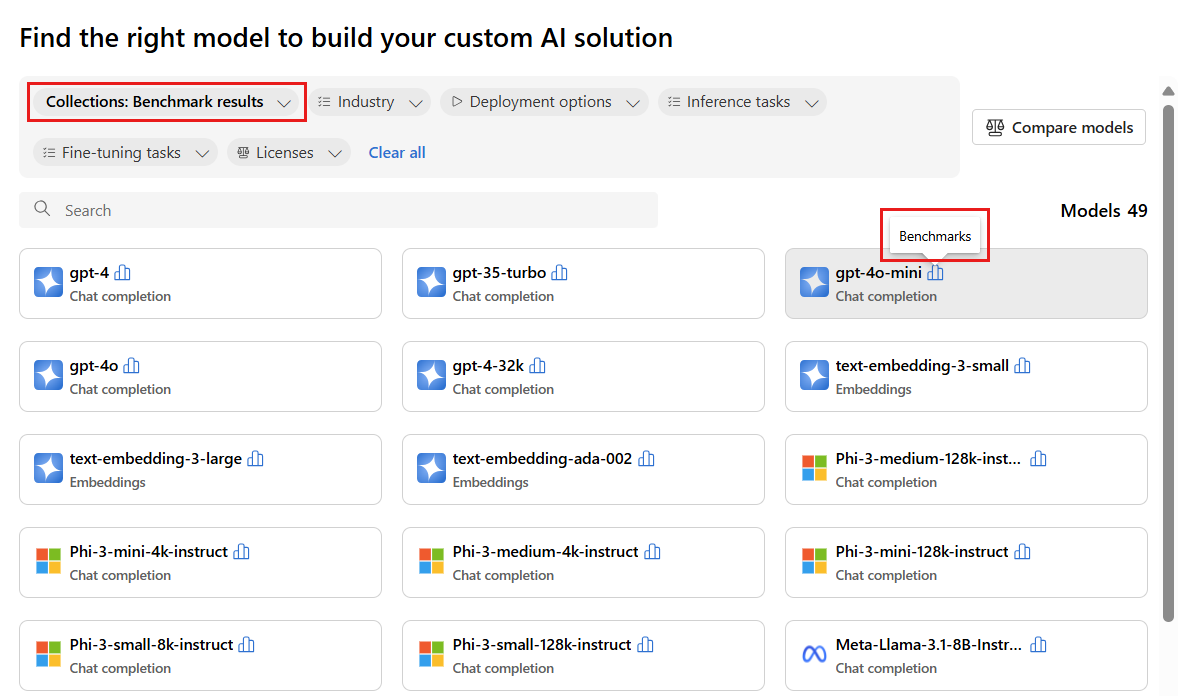

Azure AI biedt ondersteuning voor modelbenchmarking voor bepaalde modellen die populair en het meest worden gebruikt. Ondersteunde modellen hebben een benchmarkspictogram dat eruitziet als een histogram. U vindt deze modellen in de modelcatalogus met behulp van het filter Verzamelingen en het selecteren van benchmarkresultaten. Vervolgens kunt u de zoekfunctionaliteit gebruiken om specifieke modellen te vinden.

Met modelbenchmarks kunt u weloverwogen beslissingen nemen over de duurzaamheid van modellen en gegevenssets voordat u een taak start. De benchmarks zijn een gecureerde lijst met de best presterende modellen voor een taak, op basis van een uitgebreide vergelijking van metrische benchmarkgegevens. Azure AI Foundry biedt de volgende benchmarks voor modellen, op basis van modelcatalogusverzamelingen:

- Benchmarks voor grote taalmodellen (LLM's) en kleine taalmodellen (SLM's)

- Benchmarks voor insluitingsmodellen

Benchmarking van LLM's en SLM's

Modelbenchmarks beoordelen LLM's en SLM's in de volgende categorieën: kwaliteit, prestaties en kosten. De benchmarks worden regelmatig bijgewerkt naarmate nieuwe metrische gegevens en gegevenssets worden toegevoegd aan bestaande modellen en wanneer er nieuwe modellen worden toegevoegd aan de modelcatalogus.

kwaliteit

Azure AI beoordeelt de kwaliteit van LLM's en SLM's in verschillende metrische gegevens die zijn gegroepeerd in twee hoofdcategorieën: nauwkeurigheid en met prompt ondersteunde metrische gegevens:

Voor metrische gegevens voor nauwkeurigheid:

| Metrisch | Beschrijving |

|---|---|

| Nauwkeurigheid | Nauwkeurigheidsscores zijn beschikbaar op de gegevensset en de modelniveaus. Op gegevenssetniveau is de score de gemiddelde waarde van een metrische nauwkeurigheid die wordt berekend over alle voorbeelden in de gegevensset. De gebruikte metrische nauwkeurigheidsgegevens zijn exact-match in alle gevallen, met uitzondering van de HumanEval-gegevensset die gebruikmaakt van een pass@1 metrische waarde. Exacte overeenkomst vergelijkt model gegenereerde tekst met het juiste antwoord volgens de gegevensset, waarbij één wordt gerapporteerd als de gegenereerde tekst exact overeenkomt met het antwoord en anders nul. De pass@1 metrische waarde meet het aandeel van modeloplossingen die een set eenheidstests doorgeven in een taak voor het genereren van code. Op modelniveau is de nauwkeurigheidsscore het gemiddelde van de nauwkeurigheid op gegevenssetniveau voor elk model. |

Voor prompt-ondersteunde metrische gegevens:

| Metrisch | Beschrijving |

|---|---|

| Samenhang | Coherentie evalueert hoe goed het taalmodel uitvoer kan produceren die soepel stroomt, natuurlijk leest en lijkt op menselijke taal. |

| Vlotheid | Fluency evalueert de taalvaardigheid van het voorspelde antwoord van ai. Het beoordeelt hoe goed de gegenereerde tekst voldoet aan grammaticale regels, syntactische structuren en het juiste gebruik van vocabulaire, wat resulteert in taalkundige correcte en natuurlijke reacties. |

| GPTSimilariteit | GPTSimilariteit is een meting die de overeenkomst kwantificeert tussen een grondwaarzin (of document) en de voorspellingszin die door een AI-model wordt gegenereerd. De metrische waarde wordt berekend door eerst insluitingen op zinsniveau te berekenen, met behulp van de API voor insluitingen voor zowel de grondwaar als de voorspelling van het model. Deze insluitingen vertegenwoordigen hoogdimensionale vectorweergaven van de zinnen, waarbij hun semantische betekenis en context worden vastgelegd. |

| Grondgebondenheid | Grondheid meet hoe goed de gegenereerde antwoorden van het taalmodel overeenkomen met informatie uit de invoerbron. |

| Relevantie | Relevantie meet de mate waarin de gegenereerde antwoorden van het taalmodel relevant zijn en rechtstreeks gerelateerd zijn aan de gegeven vragen. |

Azure AI geeft ook de kwaliteitsindex als volgt weer:

| Index | Beschrijving |

|---|---|

| Kwaliteitsindex | De kwaliteitsindex wordt berekend door GPTSimilariteit omlaag te schalen tussen nul en één, gevolgd door gemiddelde metrische gegevens voor nauwkeurigheid. Hogere waarden van de kwaliteitsindex zijn beter. |

De kwaliteitsindex vertegenwoordigt de gemiddelde score van de toepasselijke primaire metrische gegevens (nauwkeurigheid, aangepaste GPTSimilariteit) meer dan 15 standaardgegevenssets en wordt geleverd op een schaal van nul tot één.

De kwaliteitsindex bestaat uit twee categorieën metrische gegevens:

- Nauwkeurigheid (bijvoorbeeld exacte overeenkomst of

pass@k). Varieert van nul tot één. - Op prompt gebaseerde metrische gegevens (bijvoorbeeld GPTSimilariteit, aarding, samenhang, vloeiendheid en relevantie). Varieert van één tot vijf.

De stabiliteit van de kwaliteitsindexwaarde geeft een indicator van de algehele kwaliteit van het model.

Prestaties

Metrische prestatiegegevens worden berekend als een aggregaties van meer dan 14 dagen, op basis van 24 paden (twee aanvragen per trail) die dagelijks worden verzonden met een interval van één uur tussen elke trail. De volgende standaardparameters worden gebruikt voor elke aanvraag voor het modeleindpunt:

| Parameter | Weergegeven als | Van toepassing op |

|---|---|---|

| Regio | VS - oost/VS - oost2 | Serverloze API's en Azure OpenAI |

| Snelheidslimiet voor tokens per minuut (TPM) | 30k (180 RPM op basis van Azure OpenAI) N.v.v. (serverloze API's) |

Voor Azure OpenAI-modellen is selectie beschikbaar voor gebruikers met frequentielimietbereiken op basis van het implementatietype (standaard, globaal, globaal, globaal, enzovoort).) Voor serverloze API's wordt deze instelling geabstraheerd. |

| Aantal aanvragen | Twee aanvragen in een trail voor elk uur (24 paden per dag) | Serverloze API's, Azure OpenAI |

| Aantal paden/runs | 14 dagen met 24 paden per dag voor 336 runs | Serverloze API's, Azure OpenAI |

| Lengte van prompt/context | Gemiddelde lengte | Serverloze API's, Azure OpenAI |

| Aantal verwerkte tokens (gemiddeld) | Verhouding van 80:20 voor invoer-naar-uitvoertokens, dat wil gezegd 800 invoertokens tot 200 uitvoertokens. | Serverloze API's, Azure OpenAI |

| Aantal gelijktijdige aanvragen | Een (aanvragen worden opeenvolgend verzonden) | Serverloze API's, Azure OpenAI |

| Gegevens | Synthetische (invoerprompts voorbereid op statische tekst) | Serverloze API's, Azure OpenAI |

| Regio | VS - oost/VS - oost2 | Serverloze API's en Azure OpenAI |

| Implementatietype | Standaard | Alleen van toepassing op Azure OpenAI |

| Streaming | Waar | Van toepassing op serverloze API's en Azure OpenAI. Voor modellen die zijn geïmplementeerd via beheerde berekeningen, stelt u max_token = 1 in voor het repliceren van streamingscenario's, waarmee metrische gegevens, zoals de totale tijd tot het eerste token (TTFT) voor beheerde berekeningen, kunnen worden berekend. |

| Tokenizer | Tiktoken-pakket (Azure OpenAI) Face-model-id (serverloze API's) knuffelen |

Face-model-id (serverloze Azure-API's) |

De prestaties van LLM's en SLM's worden beoordeeld op de volgende metrische gegevens:

| Metrisch | Beschrijving |

|---|---|

| Gemiddelde latentie | De gemiddelde tijd in seconden die nodig is voor het verwerken van een aanvraag, berekend over meerdere aanvragen. Om deze metrische gegevens te berekenen, verzenden we elk uur een aanvraag naar het eindpunt, twee weken en berekenen we het gemiddelde. |

| Latentie P50 | 50e percentielwaarde (de mediaan) van latentie (de tijd tussen de aanvraag en wanneer we het volledige antwoord ontvangen met een geslaagde code). Wanneer we bijvoorbeeld een aanvraag naar het eindpunt verzenden, worden 50% van de aanvragen in 'x' seconden voltooid, waarbij 'x' de latentiemeting is. |

| Latentie P90 | 90e percentielwaarde van latentie (de tijd tussen de aanvraag en wanneer we het volledige antwoord ontvangen met een geslaagde code). Wanneer we bijvoorbeeld een aanvraag naar het eindpunt verzenden, worden 90% van de aanvragen in 'x' seconden voltooid, waarbij 'x' de latentiemeting is. |

| Latentie P95 | 95e percentielwaarde van latentie (de tijd tussen de aanvraag en wanneer we het volledige antwoord ontvangen met een geslaagde code). Wanneer we bijvoorbeeld een aanvraag naar het eindpunt verzenden, zijn 95% van de aanvragen in 'x' seconden voltooid, waarbij 'x' de latentiemeting is. |

| Latentie P99 | 99e percentielwaarde van latentie (de tijd tussen de aanvraag en wanneer we het volledige antwoord ontvangen met een geslaagde code). Wanneer we bijvoorbeeld een aanvraag naar het eindpunt verzenden, zijn 99% van de aanvragen in 'x' seconden voltooid, waarbij 'x' de latentiemeting is. |

| Doorvoer GTPS | Gegenereerde tokens per seconde (GTPS) is het aantal uitvoertokens dat per seconde wordt gegenereerd vanaf het moment dat de aanvraag naar het eindpunt wordt verzonden. |

| Doorvoer TTPS | Het totale aantal tokens per seconde (TTPS) is het aantal totale tokens dat per seconde wordt verwerkt, inclusief zowel van de invoerprompt als gegenereerde uitvoertokens. |

| Latentie TTFT | De totale tijd tot het eerste token (TTFT) is de tijd die nodig is voor het eerste token in het antwoord dat moet worden geretourneerd vanaf het eindpunt wanneer streaming is ingeschakeld. |

| Tijd tussen tokens | Deze metrische waarde is de tijd tussen tokens die zijn ontvangen. |

Azure AI geeft als volgt prestatieindexen weer voor latentie en doorvoer:

| Index | Beschrijving |

|---|---|

| Latentieindex | Gemiddelde tijd tot eerste token. Lagere waarden zijn beter. |

| Doorvoerindex | Gemiddelde gegenereerde tokens per seconde. Hogere waarden zijn beter. |

Voor metrische prestatiegegevens, zoals latentie of doorvoer, geven de tijd tot het eerste token en de gegenereerde tokens per seconde een beter beeld van de typische prestaties en het gedrag van het model. We vernieuwen onze prestatienummers op regelmatige frequentie.

Kosten

Kostenberekeningen zijn schattingen voor het gebruik van een LLM- of SLM-modeleindpunt dat wordt gehost op het Azure AI-platform. Azure AI biedt ondersteuning voor het weergeven van de kosten van serverloze API's en Azure OpenAI-modellen. Omdat deze kosten onderhevig zijn aan wijzigingen, vernieuwen we onze kostenberekeningen regelmatig.

De kosten van LLM's en SLM's worden beoordeeld op basis van de volgende metrische gegevens:

| Metrisch | Beschrijving |

|---|---|

| Kosten per invoertokens | Kosten voor serverloze API-implementatie voor 1 miljoen invoertokens |

| Kosten per uitvoertokens | Kosten voor serverloze API-implementatie voor 1 miljoen uitvoertokens |

| Geschatte kosten | Kosten voor de som van de kosten per invoertokens en kosten per uitvoertokens, met een verhouding van 3:1. |

Azure AI geeft ook de kostenindex als volgt weer:

| Index | Beschrijving |

|---|---|

| Kostenindex | Geschatte kosten. Lagere waarden zijn beter. |

Benchmarking van insluitmodellen

Modelbenchmarks beoordelen het insluiten van modellen op basis van kwaliteit.

kwaliteit

De kwaliteit van het insluiten van modellen wordt beoordeeld op de volgende metrische gegevens:

| Metrisch | Beschrijving |

|---|---|

| Nauwkeurigheid | Nauwkeurigheid is het aandeel van de juiste voorspellingen onder het totale aantal verwerkte voorspellingen. |

| F1-score | F1 Score is het gewogen gemiddelde van de precisie en relevante overeenkomsten, waarbij de beste waarde één is (perfecte precisie en relevante overeenkomsten), en het slechtste is nul. |

| Gemiddelde gemiddelde precisie (MAP) | MAP evalueert de kwaliteit van classificatie- en aanbevelingssystemen. Het meet zowel de relevantie van voorgestelde items als hoe goed het systeem is bij het plaatsen van relevantere items bovenaan. Waarden kunnen variëren van nul tot één, en hoe hoger de MAP, hoe beter het systeem relevante items hoog in de lijst kan plaatsen. |

| Genormaliseerde cumulatieve winst (NDCG) | NDCG evalueert de mogelijkheid van een machine learning-algoritme om items te sorteren op basis van relevantie. Het vergelijkt classificaties met een ideale volgorde waarbij alle relevante items zich boven aan de lijst bevinden, waarbij k de lijstlengte is tijdens het evalueren van de classificatiekwaliteit. In onze benchmarks, k=10, aangegeven met een metrische waarde ndcg_at_10, wat betekent dat we naar de top 10 items kijken. |

| Precisie | Precisie meet de mogelijkheid van het model om exemplaren van een bepaalde klasse correct te identificeren. Precisie laat zien hoe vaak een machine learning-model juist is bij het voorspellen van de doelklasse. |

| Spearman-correlatie | Spearman-correlatie op basis van cosinus-gelijkenis wordt berekend door eerst de cosinus-gelijkenis tussen variabelen te berekenen, vervolgens deze scores te rangschikken en de rangschikkingen te gebruiken om de Spearman-correlatie te berekenen. |

| V-meting | V-meting is een metrische waarde die wordt gebruikt om de kwaliteit van clustering te evalueren. V-meting wordt berekend als een harmonisch gemiddelde van homogeniteit en volledigheid, waardoor een balans tussen de twee wordt gewaarborgd voor een zinvolle score. Mogelijke scores liggen tussen nul en één, waarbij één perfect compleet labelen is. |

Berekening van scores

Afzonderlijke scores

Benchmarkresultaten zijn afkomstig van openbare gegevenssets die vaak worden gebruikt voor de evaluatie van taalmodellen. In de meeste gevallen worden de gegevens gehost in GitHub-opslagplaatsen die worden onderhouden door de makers of curatoren van de gegevens. Azure AI-evaluatiepijplijnen downloaden gegevens uit hun oorspronkelijke bronnen, extraheer prompts uit elke voorbeeldrij, genereer modelantwoorden en bereken vervolgens relevante nauwkeurigheidsgegevens.

Prompt construction volgt aanbevolen procedures voor elke gegevensset, zoals is opgegeven in het document waarin de standaarden voor gegevenssets en industrie worden ingevoerd. In de meeste gevallen bevat elke prompt verschillende shots, dat wil gezegd, verschillende voorbeelden van volledige vragen en antwoorden om het model voor de taak te primen. Met de evaluatiepijplijnen worden schermafbeeldingen gemaakt door vragen en antwoorden te nemen op basis van een deel van de gegevens die uit de evaluatie zijn opgeslagen.