Modellen toevoegen en configureren aan deductie van Azure AI-modellen

Belangrijk

Items die in dit artikel zijn gemarkeerd (preview) zijn momenteel beschikbaar als openbare preview. Deze preview wordt aangeboden zonder een service level agreement en we raden deze niet aan voor productieworkloads. Misschien worden bepaalde functies niet ondersteund of zijn de mogelijkheden ervan beperkt. Zie Aanvullende gebruiksvoorwaarden voor Microsoft Azure-previews voor meer informatie.

U kunt bepalen en configureren welke modellen beschikbaar zijn voor deductie in het deductie-eindpunt. Wanneer een bepaald model is geconfigureerd, kunt u er vervolgens voorspellingen van genereren door de modelnaam of implementatienaam voor uw aanvragen aan te geven. Er zijn geen verdere wijzigingen vereist in uw code om deze te gebruiken.

In dit artikel leert u hoe u een nieuw model toevoegt aan Azure AI-modeldeductie in Azure AI Foundry.

Vereisten

U hebt het volgende nodig om dit artikel te voltooien:

Een Azure-abonnement. Als u GitHub-modellen gebruikt, kunt u uw ervaring upgraden en een Azure-abonnement maken in het proces. Lees Upgrade van GitHub-modellen naar Azure AI-modeldeductie als dat uw geval is.

Een Azure AI-servicesresource.

Een AI-project dat is verbonden met uw Azure AI Services-resource met de functie Modellen implementeren in deductieservice van Azure AI-modellen.

- U kunt de stappen volgen bij Deductieservice voor Azure AI-modellen configureren in mijn project in Azure AI Foundry.

Een model toevoegen

U kunt modellen toevoegen aan het deductie-eindpunt van het Azure AI-model met behulp van de volgende stappen:

Ga naar de sectie Modelcatalogus in de Azure AI Foundry-portal.

Schuif naar het model waarin u geïnteresseerd bent en selecteer het.

U kunt de details van het model bekijken in de modelkaart.

Selecteer Implementeren.

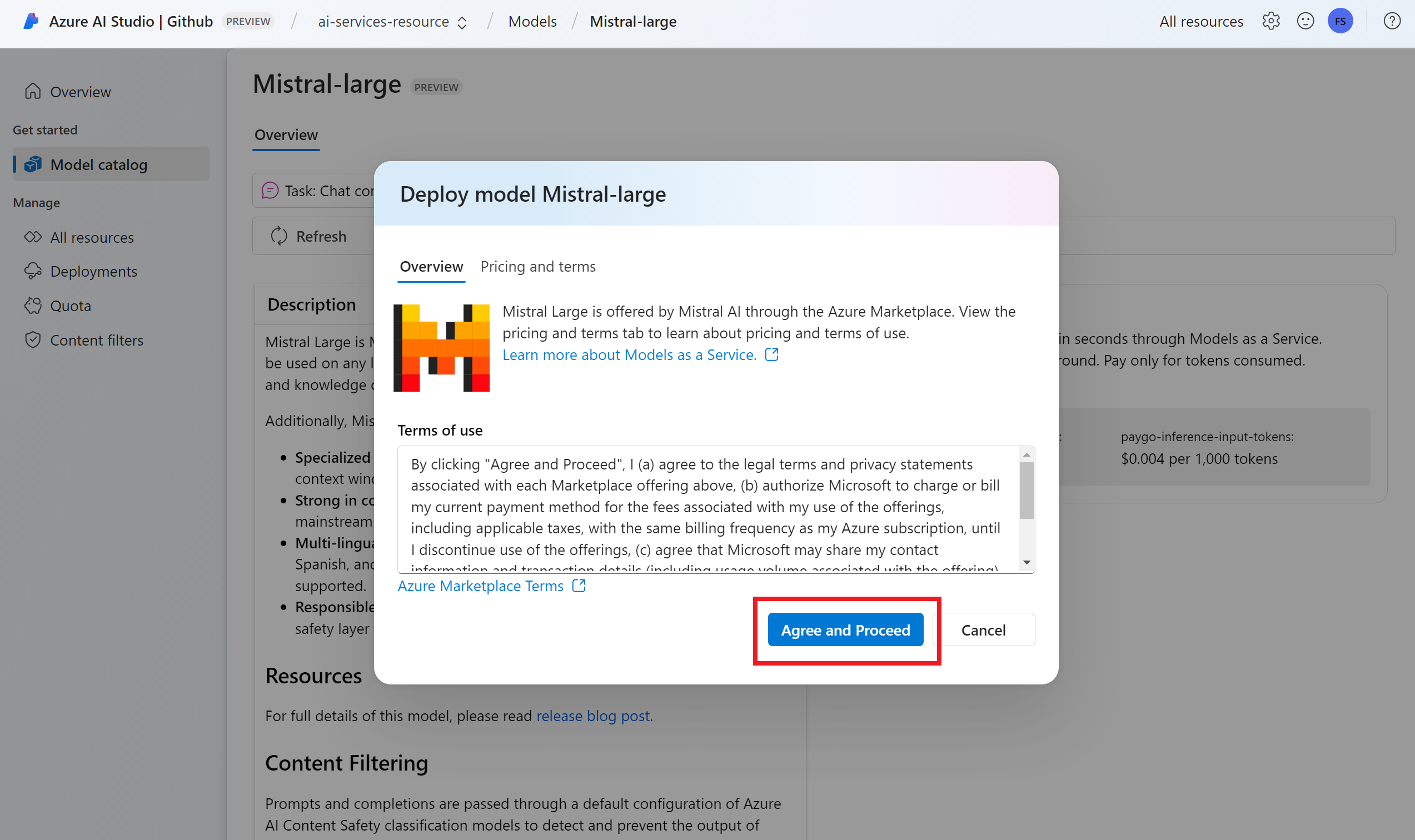

Voor modelproviders waarvoor meer contractvoorwaarden zijn vereist, wordt u gevraagd deze voorwaarden te accepteren. Dit is bijvoorbeeld het geval voor Mistral-modellen. Accepteer de voorwaarden voor deze gevallen door Abonneren en implementeren te selecteren.

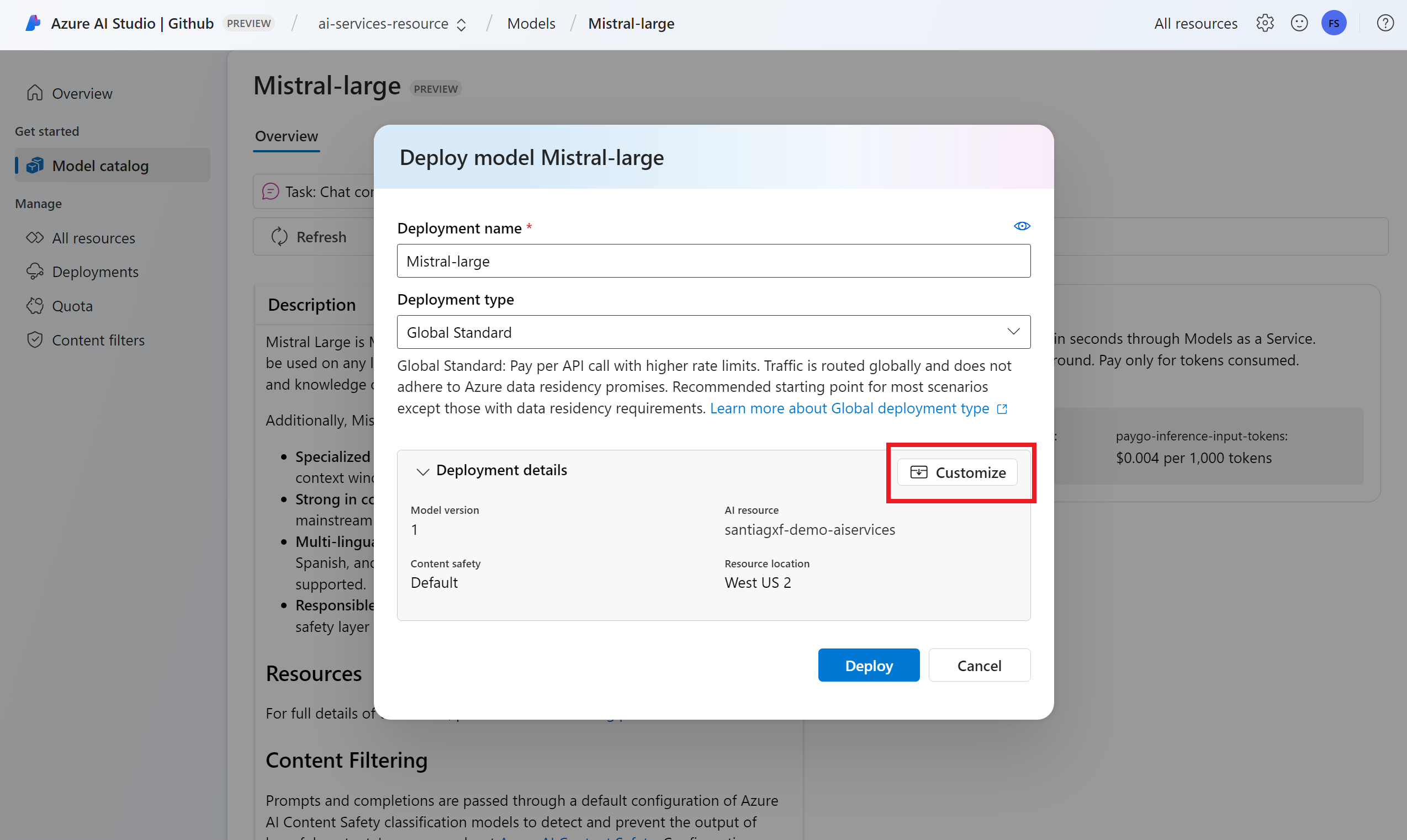

U kunt de implementatie-instellingen op dit moment configureren. Standaard ontvangt de implementatie de naam van het model dat u implementeert. De implementatienaam wordt gebruikt in de

modelparameter voor aanvraag om naar deze specifieke modelimplementatie te routeren. Hiermee kunt u ook specifieke namen voor uw modellen configureren wanneer u specifieke configuraties koppelt. Bijvoorbeeldo1-preview-safevoor een model met een strikt inhoudsbeveiligingsfilter.Tip

Elk model kan verschillende implementatietypen ondersteunen, wat verschillende gegevenslocatie- of doorvoergaranties biedt. Zie implementatietypen voor meer informatie.

We selecteren automatisch een Azure AI Services-verbinding, afhankelijk van uw project. Gebruik de optie Aanpassen om de verbinding te wijzigen op basis van uw behoeften. Als u implementeert onder het standaardimplementatietype , moeten de modellen beschikbaar zijn in de regio van de Azure AI Services-resource.

Tip

Als de gewenste resource niet wordt vermeld, moet u er mogelijk een verbinding mee maken. Zie Deductieservice voor Azure AI-modellen configureren in mijn project in de Azure AI Foundry-portal.

Selecteer Implementeren.

Zodra de implementatie is voltooid, wordt het nieuwe model weergegeven op de pagina en kan het worden gebruikt.

Modellen beheren

U kunt de bestaande modelimplementaties in de resource beheren met behulp van de Azure AI Foundry-portal.

Ga naar de sectie Modellen en eindpunten in de Azure AI Foundry-portal.

Schuif naar de verbinding met uw Azure AI Services-resource. Modelimplementaties worden gegroepeerd en per verbinding weergegeven.

U ziet een lijst met modellen die beschikbaar zijn onder elke verbinding. Selecteer de modelimplementatie waarin u geïnteresseerd bent.

Bewerk of verwijder de implementatie indien nodig.

De implementatie testen in de speeltuin

U kunt communiceren met het nieuwe model in de Azure AI Foundry-portal met behulp van de speeltuin:

Notitie

Playground is alleen beschikbaar wanneer u werkt met AI-projecten in Azure AI Foundry. Maak een AI-project om volledige toegang te krijgen tot alle mogelijkheden in Azure AI Foundry.

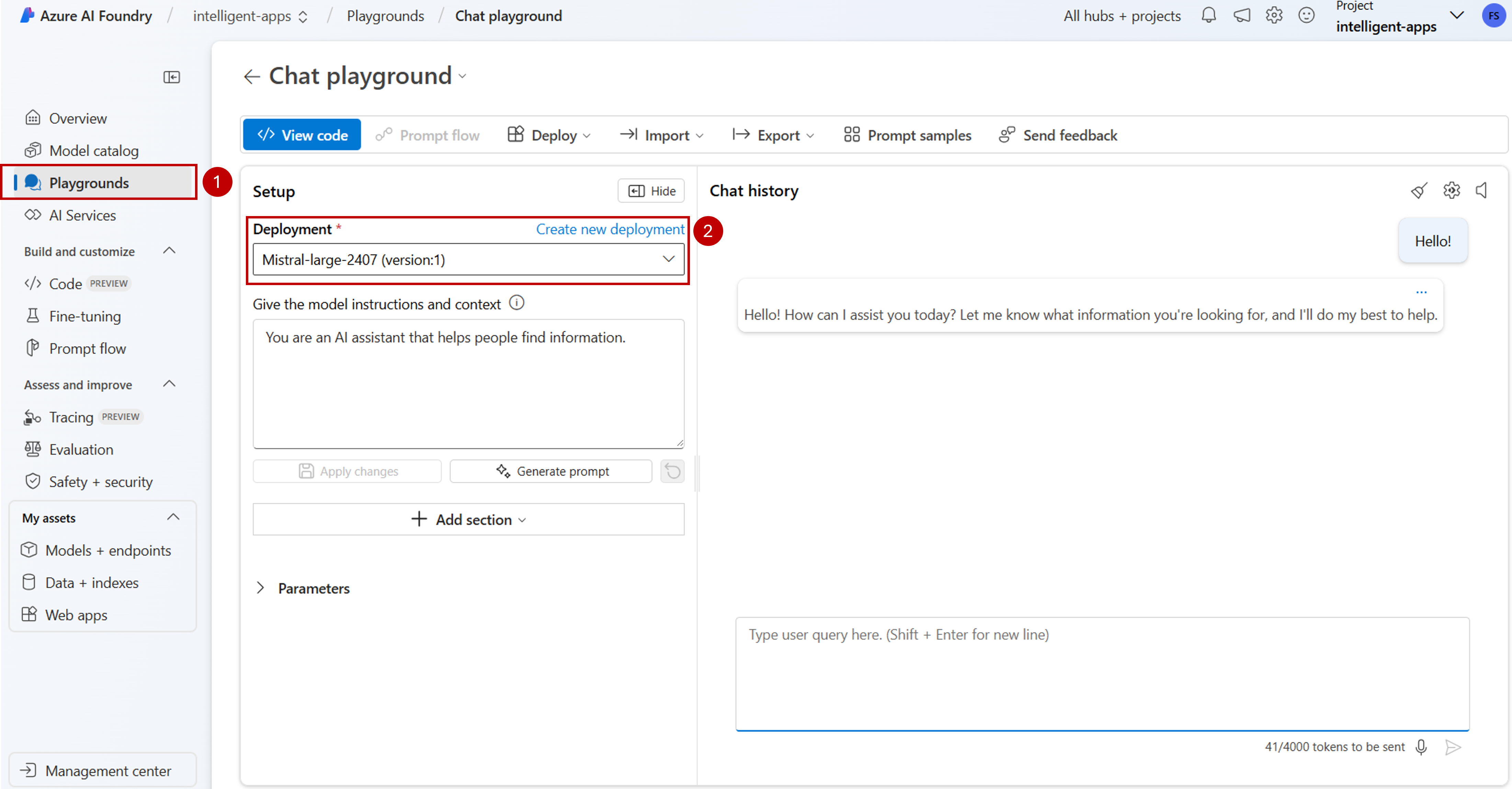

Ga naar de sectie Playgrounds in azure AI Foundry Portal.

Afhankelijk van het type model dat u hebt geïmplementeerd, selecteert u de benodigde speeltuin. In dit geval selecteren we Chatspeeltuin.

Selecteer in de vervolgkeuzelijst Implementatie onder Setup de naam van de modelimplementatie die u hebt gemaakt.

Typ uw prompt en bekijk de uitvoer.

Daarnaast kunt u Code weergeven gebruiken om details te bekijken over hoe u programmatisch toegang krijgt tot de modelimplementatie.

Belangrijk

Items die in dit artikel zijn gemarkeerd (preview) zijn momenteel beschikbaar als openbare preview. Deze preview wordt aangeboden zonder een service level agreement en we raden deze niet aan voor productieworkloads. Misschien worden bepaalde functies niet ondersteund of zijn de mogelijkheden ervan beperkt. Zie Aanvullende gebruiksvoorwaarden voor Microsoft Azure-previews voor meer informatie.

U kunt bepalen en configureren welke modellen beschikbaar zijn voor deductie in het deductie-eindpunt. Wanneer een bepaald model is geconfigureerd, kunt u er vervolgens voorspellingen van genereren door de modelnaam of implementatienaam voor uw aanvragen aan te geven. Er zijn geen verdere wijzigingen vereist in uw code om deze te gebruiken.

In dit artikel leert u hoe u een nieuw model toevoegt aan Azure AI-modeldeductie in Azure AI Foundry.

Vereisten

U hebt het volgende nodig om dit artikel te voltooien:

Een Azure-abonnement. Als u GitHub-modellen gebruikt, kunt u uw ervaring upgraden en een Azure-abonnement maken in het proces. Lees Upgrade van GitHub-modellen naar Azure AI-modeldeductie als dat uw geval is.

Een Azure AI-servicesresource.

Installeer de Azure CLI en de

cognitiveservicesextensie voor Azure AI Services:az extension add -n cognitiveservicesSommige opdrachten in deze zelfstudie gebruiken het

jqhulpprogramma, dat mogelijk niet in uw systeem is geïnstalleerd. Zie Downloadenjqvoor installatie-instructies.Identificeer de volgende informatie:

Uw Azure-abonnements-id.

De resourcenaam van uw Azure AI Services.

De resourcegroep waarin de Azure AI Services-resource wordt geïmplementeerd.

Modellen toevoegen

Als u een model wilt toevoegen, moet u eerst het model identificeren dat u wilt implementeren. U kunt als volgt een query uitvoeren op de beschikbare modellen:

Meld u aan bij uw Azure-abonnement:

az loginAls u meer dan 1 abonnement hebt, selecteert u het abonnement waarin uw resource zich bevindt:

az account set --subscription $subscriptionId>Stel de volgende omgevingsvariabelen in met de naam van de Azure AI Services-resource die u wilt gebruiken en resourcegroep.

accountName="<ai-services-resource-name>" resourceGroupName="<resource-group>"Als u nog geen Azure AI Services-account hebt gemaakt, kunt u er als volgt een maken:

az cognitiveservices account create -n $accountName -g $resourceGroupNameLaten we eerst kijken welke modellen beschikbaar zijn voor u en onder welke SKU. Met de volgende opdracht worden alle beschikbare modeldefinities weergegeven:

az cognitiveservices account list-models \ -n $accountName \ -g $resourceGroupName \ | jq '.[] | { name: .name, format: .format, version: .version, sku: .skus[0].name, capacity: .skus[0].capacity.default }'Uitvoer ziet er als volgt uit:

{ "name": "Phi-3.5-vision-instruct", "format": "Microsoft", "version": "2", "sku": "GlobalStandard", "capacity": 1 }Identificeer het model dat u wilt implementeren. U hebt de eigenschappen

name,format, enversionsku. Capaciteit kan ook nodig zijn, afhankelijk van het type implementatie.Tip

U ziet dat niet alle modellen beschikbaar zijn in alle SKU's.

Voeg de modelimplementatie toe aan de resource. In het volgende voorbeeld wordt het volgende toegevoegd

Phi-3.5-vision-instruct:az cognitiveservices account deployment create \ -n $accountName \ -g $resourceGroupName \ --deployment-name Phi-3.5-vision-instruct \ --model-name Phi-3.5-vision-instruct \ --model-version 2 \ --model-format Microsoft \ --sku-capacity 1 \ --sku-name GlobalStandardHet model is klaar om te worden gebruikt.

U kunt hetzelfde model meerdere keren implementeren als dat nodig is zolang het zich onder een andere implementatienaam bevindt. Deze mogelijkheid kan nuttig zijn voor het geval u verschillende configuraties voor een bepaald model wilt testen, inclusief de veiligheid van inhoud.

Implementaties beheren

U kunt alle beschikbare implementaties bekijken met behulp van de CLI:

Voer de volgende opdracht uit om alle actieve implementaties weer te geven:

az cognitiveservices account deployment list -n $accountName -g $resourceGroupNameU kunt de details van een bepaalde implementatie bekijken:

az cognitiveservices account deployment show \ --deployment-name "Phi-3.5-vision-instruct" \ -n $accountName \ -g $resourceGroupNameU kunt een bepaalde implementatie als volgt verwijderen:

az cognitiveservices account deployment delete \ --deployment-name "Phi-3.5-vision-instruct" \ -n $accountName \ -g $resourceGroupName

Het model gebruiken

Geïmplementeerde modellen in Azure AI-modeldeductie kunnen worden gebruikt met behulp van het deductie-eindpunt van het Azure AI-model voor de resource. Wanneer u uw aanvraag maakt, geeft u de parameter model aan en voegt u de naam van de modelimplementatie in die u hebt gemaakt. U kunt de URI voor het deductie-eindpunt programmatisch ophalen met behulp van de volgende code:

Deductie-eindpunt

az cognitiveservices account show -n $accountName -g $resourceGroupName | jq '.properties.endpoints["Azure AI Model Inference API"]'

Als u aanvragen wilt indienen bij het deductie-eindpunt van het Azure AI-model, voegt u bijvoorbeeld https://<resource>.services.ai.azure.com/modelsde route modelstoe. U kunt de API-verwijzing voor het eindpunt bekijken op de referentiepagina van de Deductie-API voor Azure AI-modellen.

Deductiesleutels

az cognitiveservices account keys list -n $accountName -g $resourceGroupName

Belangrijk

Items die in dit artikel zijn gemarkeerd (preview) zijn momenteel beschikbaar als openbare preview. Deze preview wordt aangeboden zonder een service level agreement en we raden deze niet aan voor productieworkloads. Misschien worden bepaalde functies niet ondersteund of zijn de mogelijkheden ervan beperkt. Zie Aanvullende gebruiksvoorwaarden voor Microsoft Azure-previews voor meer informatie.

U kunt bepalen en configureren welke modellen beschikbaar zijn voor deductie in het deductie-eindpunt. Wanneer een bepaald model is geconfigureerd, kunt u er vervolgens voorspellingen van genereren door de modelnaam of implementatienaam voor uw aanvragen aan te geven. Er zijn geen verdere wijzigingen vereist in uw code om deze te gebruiken.

In dit artikel leert u hoe u een nieuw model toevoegt aan Azure AI-modeldeductie in Azure AI Foundry.

Vereisten

U hebt het volgende nodig om dit artikel te voltooien:

Een Azure-abonnement. Als u GitHub-modellen gebruikt, kunt u uw ervaring upgraden en een Azure-abonnement maken in het proces. Lees Upgrade van GitHub-modellen naar Azure AI-modeldeductie als dat uw geval is.

Een Azure AI-servicesresource.

Installeer de Azure CLI.

Identificeer de volgende informatie:

Uw Azure-abonnements-id.

De resourcenaam van uw Azure AI Services.

De resourcegroep waarin de Azure AI Services-resource wordt geïmplementeerd.

De modelnaam, provider, versie en SKU die u wilt implementeren. U kunt de Azure AI Foundry-portal of de Azure CLI gebruiken om deze te identificeren. In dit voorbeeld implementeren we het volgende model:

-

Modelnaam::

Phi-3.5-vision-instruct -

Provider:

Microsoft -

Versie:

2 - Implementatietype: Algemene standaard

-

Modelnaam::

Het model toevoegen

Gebruik de sjabloon

ai-services-deployment-template.bicepom modelimplementaties te beschrijven:ai-services-deployment-template.bicep

@description('Name of the Azure AI services account') param accountName string @description('Name of the model to deploy') param modelName string @description('Version of the model to deploy') param modelVersion string @allowed([ 'AI21 Labs' 'Cohere' 'Core42' 'DeepSeek' 'Meta' 'Microsoft' 'Mistral AI' 'OpenAI' ]) @description('Model provider') param modelPublisherFormat string @allowed([ 'GlobalStandard' 'Standard' 'GlobalProvisioned' 'Provisioned' ]) @description('Model deployment SKU name') param skuName string = 'GlobalStandard' @description('Content filter policy name') param contentFilterPolicyName string = 'Microsoft.DefaultV2' @description('Model deployment capacity') param capacity int = 1 resource modelDeployment 'Microsoft.CognitiveServices/accounts/deployments@2024-04-01-preview' = { name: '${accountName}/${modelName}' sku: { name: skuName capacity: capacity } properties: { model: { format: modelPublisherFormat name: modelName version: modelVersion } raiPolicyName: contentFilterPolicyName == null ? 'Microsoft.Nill' : contentFilterPolicyName } }Voer de implementatie uit:

RESOURCE_GROUP="<resource-group-name>" ACCOUNT_NAME="<azure-ai-model-inference-name>" MODEL_NAME="Phi-3.5-vision-instruct" PROVIDER="Microsoft" VERSION=2 az deployment group create \ --resource-group $RESOURCE_GROUP \ --template-file ai-services-deployment-template.bicep \ --parameters accountName=$ACCOUNT_NAME modelName=$MODEL_NAME modelVersion=$VERSION modelPublisherFormat=$PROVIDER

Het model gebruiken

Geïmplementeerde modellen in Azure AI-modeldeductie kunnen worden gebruikt met behulp van het deductie-eindpunt van het Azure AI-model voor de resource. Wanneer u uw aanvraag maakt, geeft u de parameter model aan en voegt u de naam van de modelimplementatie in die u hebt gemaakt.