Eindpunt voor modeldeductie in Azure AI Services

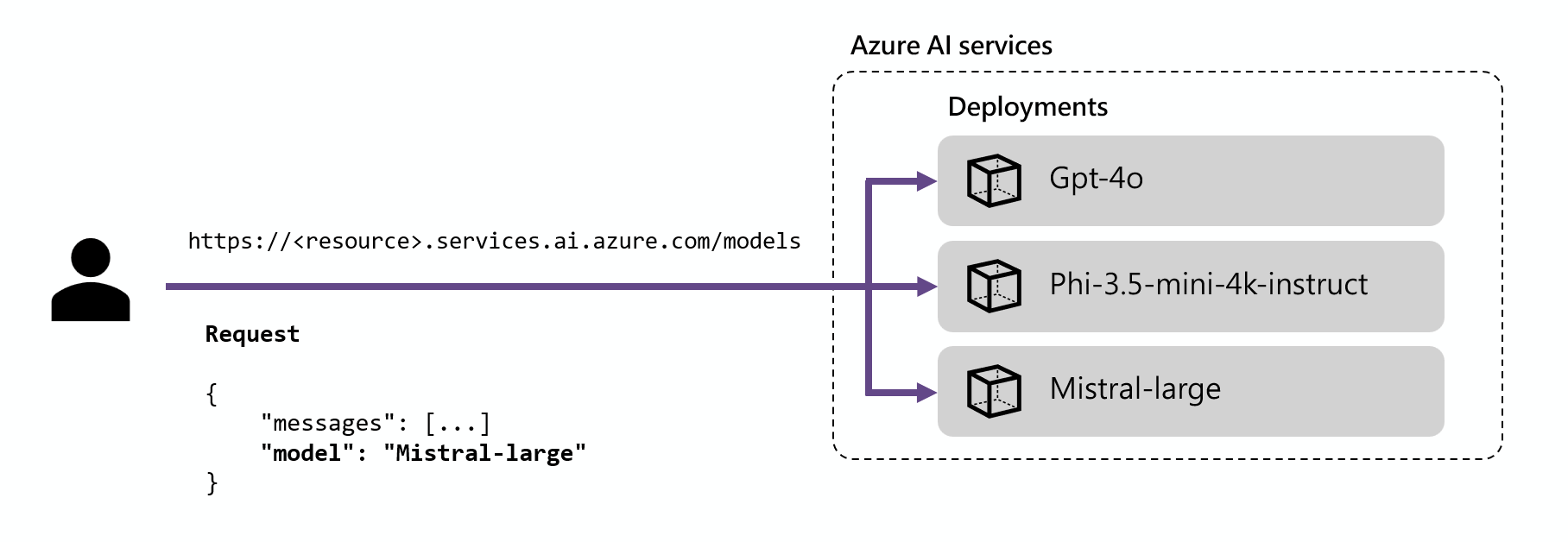

Met Azure AI-modeldeductie in Azure AI-services kunnen klanten de krachtigste modellen van vlaggenschipmodelproviders gebruiken met behulp van één eindpunt en referenties. Dit betekent dat u tussen modellen kunt schakelen en deze kunt gebruiken vanuit uw toepassing zonder dat u één regel code hoeft te wijzigen.

In het artikel wordt uitgelegd hoe modellen zijn ingedeeld in de service en hoe u het deductie-eindpunt gebruikt om ze aan te roepen.

Installaties

Azure AI-modeldeductie maakt modellen beschikbaar met behulp van het implementatieconcept . Implementaties zijn een manier om een model een naam te geven onder bepaalde configuraties. Vervolgens kunt u een dergelijke modelconfiguratie aanroepen door de naam ervan voor uw aanvragen aan te geven.

Implementaties vastleggen:

- Een modelnaam

- Een modelversie

- Een inrichting/capaciteitstype1

- Een configuratievoor inhoudsfilters 1

- Een snelheidsbeperkingsconfiguratie1

1 Configuraties kunnen variëren, afhankelijk van het geselecteerde model.

Een Azure AI-servicesresource kan zoveel modelimplementaties hebben als nodig is en er worden geen kosten in rekening gebracht, tenzij deductie wordt uitgevoerd voor deze modellen. Implementaties zijn Azure-resources en daarom zijn ze onderhevig aan Azure-beleid.

Zie Modelimplementaties toevoegen en configureren voor meer informatie over het maken van implementaties.

Azure AI-deductie-eindpunt

Met het Azure AI-deductie-eindpunt kunnen klanten één eindpunt met dezelfde verificatie en hetzelfde schema gebruiken om deductie te genereren voor de geïmplementeerde modellen in de resource. Dit eindpunt volgt de Azure AI-modeldeductie-API die alle modellen in Azure AI-modeldeductie ondersteunen. Het biedt ondersteuning voor de volgende modaliteit:

- Tekst insluitingen

- Afbeeldingen insluiten

- Chatvoltooiingen

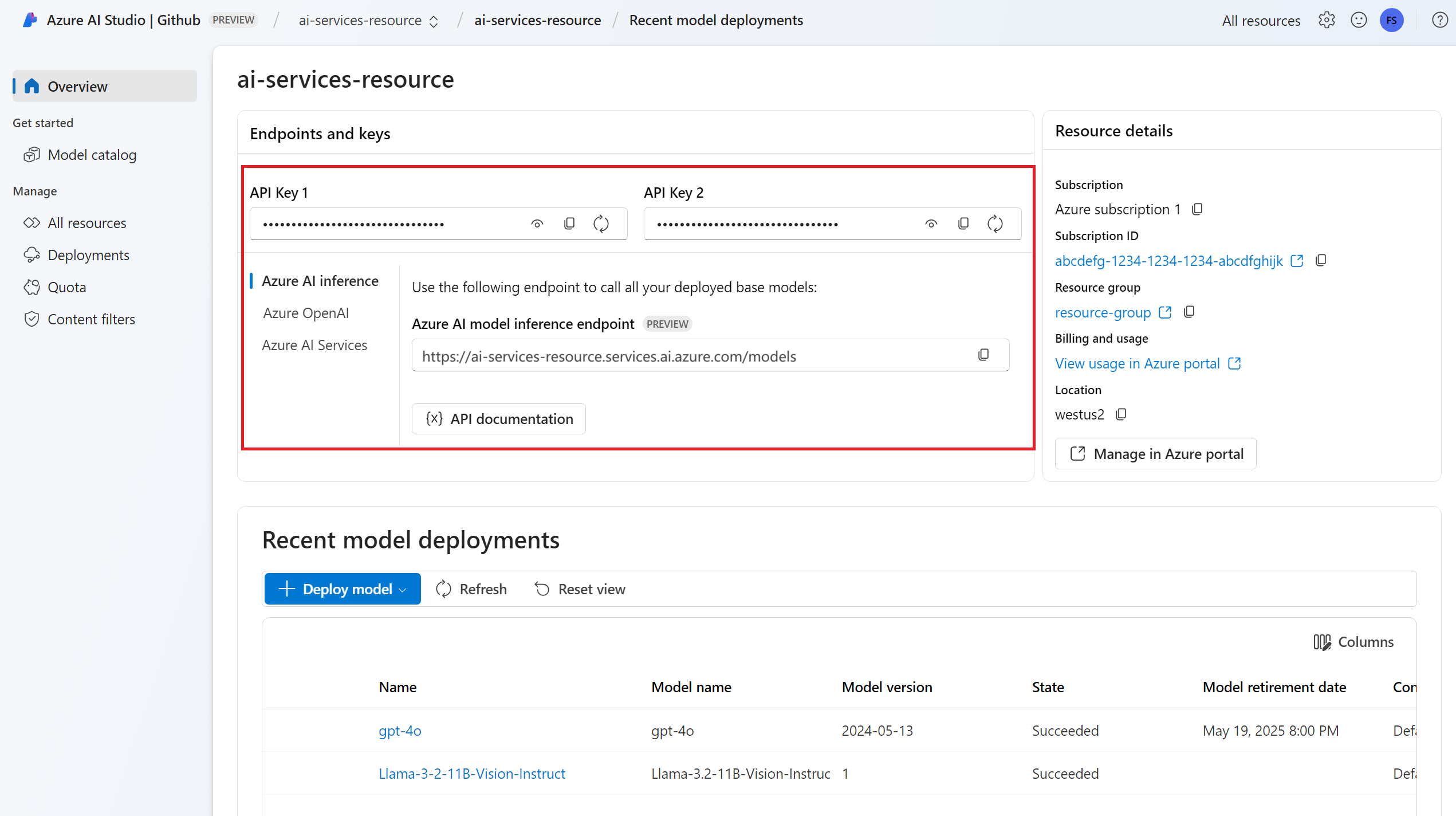

U ziet de eindpunt-URL en referenties in de sectie Overzicht :

Routering

Het deductie-eindpunt stuurt aanvragen naar een bepaalde implementatie door de parameter name in de aanvraag te koppelen aan de naam van de implementatie. Dit betekent dat implementaties werken als een alias van een bepaald model onder bepaalde configuraties. Met deze flexibiliteit kunt u een bepaald model meerdere keren in de service implementeren, maar indien nodig onder verschillende configuraties.

Als u bijvoorbeeld een implementatie met de naam Mistral-largemaakt, kan deze implementatie worden aangeroepen als:

Installeer het pakket azure-ai-inference met behulp van uw pakketbeheer, zoals pip:

pip install azure-ai-inference>=1.0.0b5

Waarschuwing

Voor de Azure AI Services-resource is de versie azure-ai-inference>=1.0.0b5 voor Python vereist.

Vervolgens kunt u het pakket gebruiken om het model te gebruiken. In het volgende voorbeeld ziet u hoe u een client maakt om chatvoltooiingen te gebruiken:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

model = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

Bekijk onze voorbeelden en lees de API-referentiedocumentatie om aan de slag te gaan.

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Tip

Implementatieroutering is niet hoofdlettergevoelig.

SDK's

Het azure AI-modeldeductie-eindpunt wordt ondersteund door meerdere SDK's, waaronder de Azure AI-deductie-SDK, de Azure AI Foundry SDK en de Azure OpenAI SDK, die beschikbaar zijn in meerdere talen. Meerdere integraties worden ook ondersteund in populaire frameworks zoals LangChain, LangGraph, Llama-Index, Semantic Kernel en AG2. Zie ondersteunde programmeertalen en SDK's voor meer informatie.

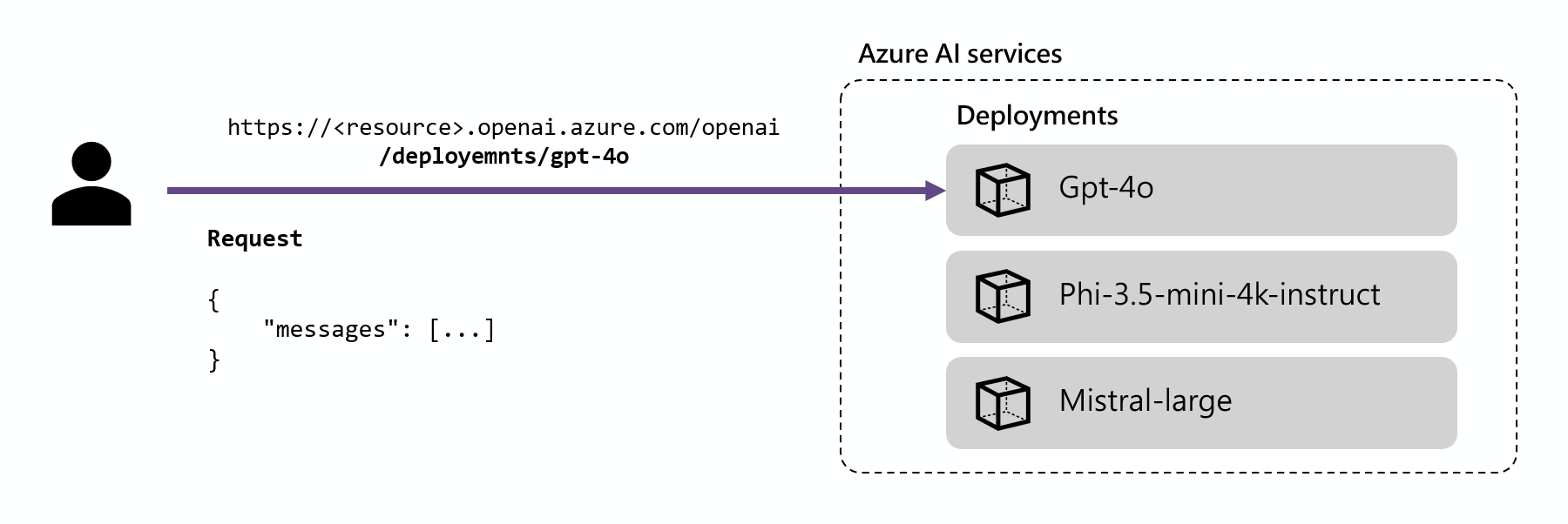

Azure OpenAI-deductie-eindpunt

Azure OpenAI-modellen die zijn geïmplementeerd in AI-services ondersteunen ook de Azure OpenAI-API. Deze API biedt de volledige mogelijkheden van OpenAI-modellen en biedt ondersteuning voor aanvullende functies, zoals assistenten, threads, bestanden en batchdeductie.

Azure OpenAI-deductie-eindpunten werken op implementatieniveau en ze hebben hun eigen URL die aan elk van deze eindpunten is gekoppeld. Hetzelfde verificatiemechanisme kan echter worden gebruikt om ze te gebruiken. Meer informatie vindt u op de referentiepagina voor De Azure OpenAI-API

Elke implementatie heeft een URL die de samenvoegingen van de Basis-URL van Azure OpenAI en de route /deployments/<model-deployment-name>is.

Belangrijk

Er is geen routeringsmechanisme voor het Azure OpenAI-eindpunt, omdat elke URL exclusief is voor elke modelimplementatie.

SDK's

Het Azure OpenAI-eindpunt wordt ondersteund door de OpenAI SDK (AzureOpenAI klasse) en Azure OpenAI SDK's, die beschikbaar zijn in meerdere talen. Zie ondersteunde talen voor meer informatie.