Uw AI-project configureren voor het gebruik van azure AI-modeldeductie

Als u al een AI-project in Azure AI Foundry hebt, implementeert de modelcatalogus standaard modellen van externe modelproviders als zelfstandige eindpunten in uw project. Elke modelimplementatie heeft een eigen set URI's en referenties voor toegang. Aan de andere kant worden Azure OpenAI-modellen geïmplementeerd in Azure AI Services-resource of in de Azure OpenAI Service-resource.

U kunt dit gedrag wijzigen en beide typen modellen implementeren in Azure AI Services-resources met behulp van Azure AI-modeldeductie. Zodra deze zijn geconfigureerd, worden implementaties van Models as a Service-modellen die betalen per gebruik-facturering ondersteunen, uitgevoerd met de verbonden Azure AI Services-resource in plaats daarvan met het project zelf, zodat u één set eindpunten en referenties krijgt voor toegang tot alle modellen die zijn geïmplementeerd in Azure AI Foundry. U kunt azure OpenAI- en modelproviders van derden op dezelfde manier beheren.

Daarnaast biedt het implementeren van modellen naar Azure AI-modeldeductie de extra voordelen van:

- Routeringsmogelijkheid.

- Aangepaste inhoudsfilters.

- Implementatietype globale capaciteit.

- Sleutelloze verificatie met op rollen gebaseerd toegangsbeheer.

In dit artikel leert u hoe u uw project configureert voor het gebruik van modellen die zijn geïmplementeerd in Azure AI-modeldeductie in Azure AI-services.

Vereisten

U hebt het volgende nodig om deze zelfstudie te voltooien:

Een Azure-abonnement. Als u GitHub-modellen gebruikt, kunt u uw ervaring upgraden en een Azure-abonnement maken in het proces. Lees Upgrade van GitHub-modellen naar Azure AI-modeldeductie als dit uw geval is.

Een Azure AI-servicesresource. Zie Een Azure AI Services-resource maken voor meer informatie.

Een Azure AI-project en Azure AI Hub.

Tip

Wanneer uw AI-hub is ingericht, wordt er een Azure AI-servicesresource gemaakt en worden de twee verbonden resources gemaakt. Als u wilt zien welke Azure AI-servicesresource is verbonden met uw project, gaat u naar de verbonden resources van azure AI Foundry Portal>>en zoekt u de verbindingen van het type AI Services.

Het project configureren voor het gebruik van azure AI-modeldeductie

Voer de volgende stappen uit om het project te configureren voor het gebruik van de deductiemogelijkheid van het Azure AI-model in Azure AI Services:

Ga naar de Azure AI Foundry-portal.

Selecteer in de bovenste navigatiebalk, rechtsboven, het pictogram Voorbeeldfuncties . Rechts van het scherm wordt een contextuele blade weergegeven.

Schakel de functie Modellen implementeren in azure AI-modeldeductieservice in.

Sluit het paneel.

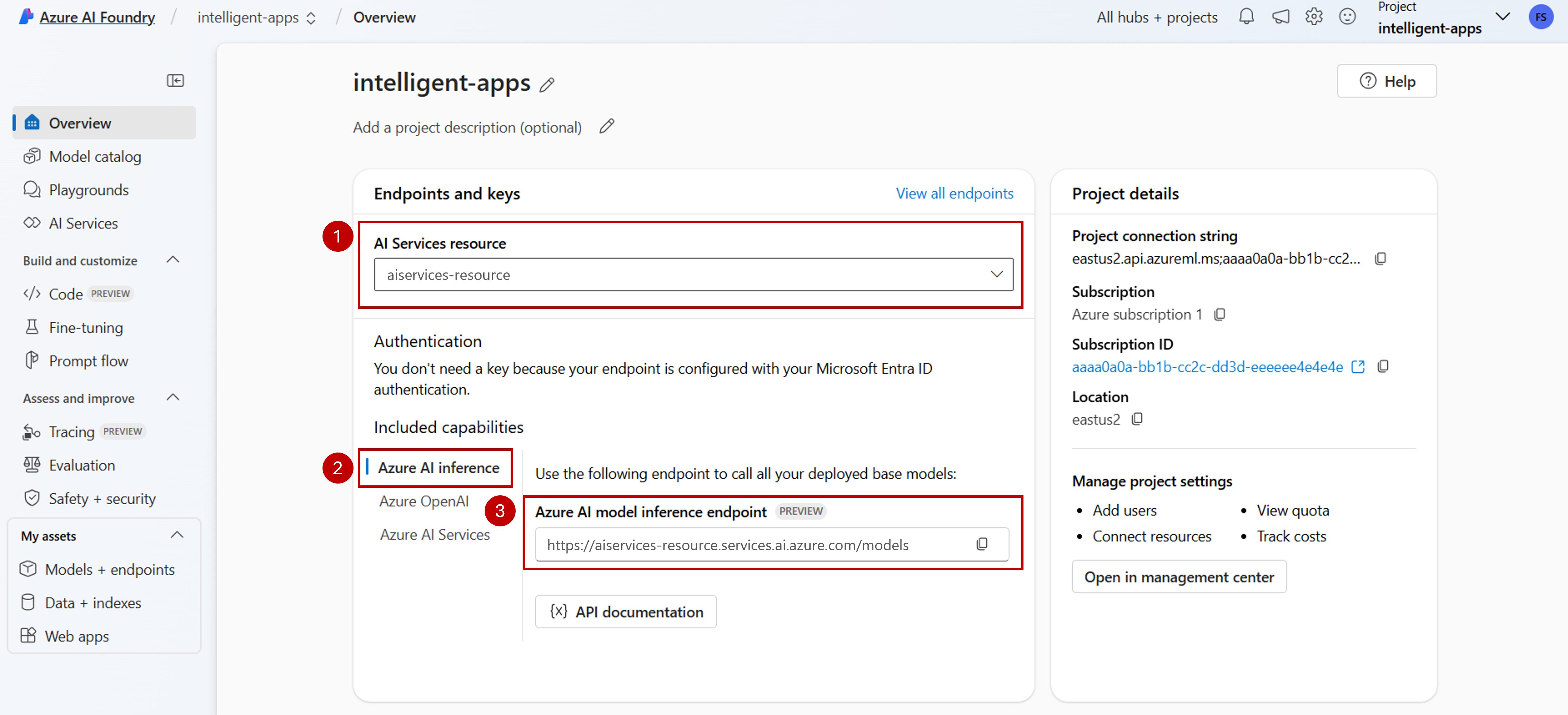

Identificeer op de landingspagina van uw project de Azure AI Services-resource die is verbonden met uw project. Gebruik de vervolgkeuzelijst om de resource te wijzigen die u hebt verbonden als dat nodig is.

Als er geen resource wordt vermeld in de vervolgkeuzelijst, is er geen Azure AI Services-resource aan uw AI Hub gekoppeld. Maak een nieuwe verbinding door:

Selecteer beheercentrum in de linkerbenedenhoek van het scherm.

Selecteer nieuwe verbinding in de sectie Verbindingen.

Selecteer Azure AI-services.

Zoek in de browser naar een bestaande Azure AI Services-resource in uw abonnement.

Selecteer Verbinding toevoegen.

De nieuwe verbinding wordt toegevoegd aan uw hub.

Ga terug naar de landingspagina van het project om door te gaan en selecteer nu de nieuwe gemaakte verbinding. Vernieuw de pagina als deze niet onmiddellijk wordt weergegeven.

Zorg ervoor dat u onder Opgenomen mogelijkheden Azure AI-deductie selecteert. De eindpunt-URI van het Azure AI-modeldeductie wordt samen met de referenties weergegeven om er toegang toe te krijgen.

Tip

Elke Azure AI-servicesresource heeft één Azure AI-modeldeductie-eindpunt dat kan worden gebruikt voor toegang tot elke modelimplementatie. Hetzelfde eindpunt dient meerdere modellen, afhankelijk van de modellen die zijn geconfigureerd. Meer informatie over hoe het eindpunt werkt.

Noteer de eindpunt-URL en referenties.

De modelimplementatie maken in azure AI-modeldeductie

Voer de volgende stappen uit voor elk model dat u wilt implementeren onder Azure AI-modeldeductie:

Ga naar de sectie Modelcatalogus in de Azure AI Foundry-portal.

Schuif naar het model waarin u geïnteresseerd bent en selecteer het.

U kunt de details van het model bekijken in de modelkaart.

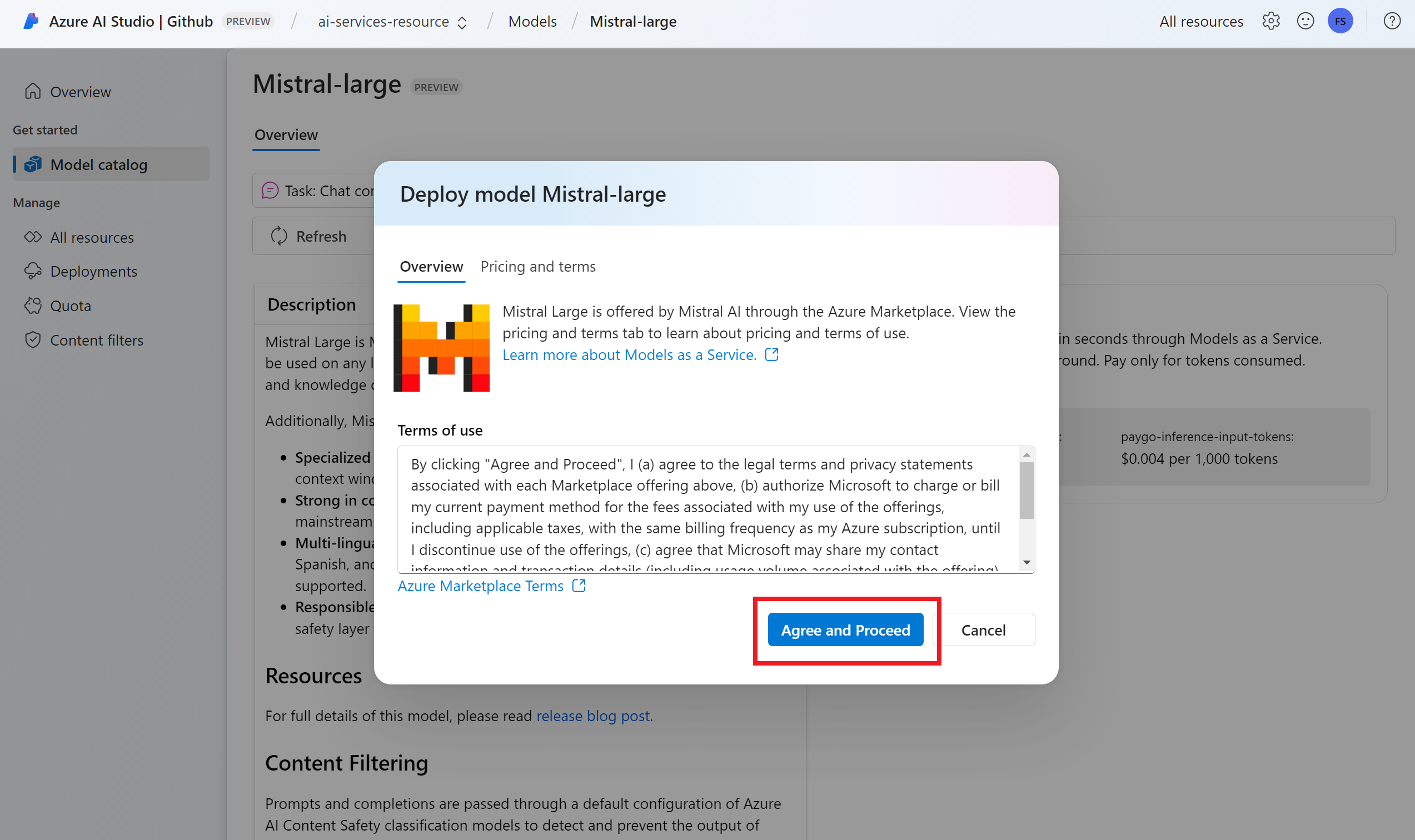

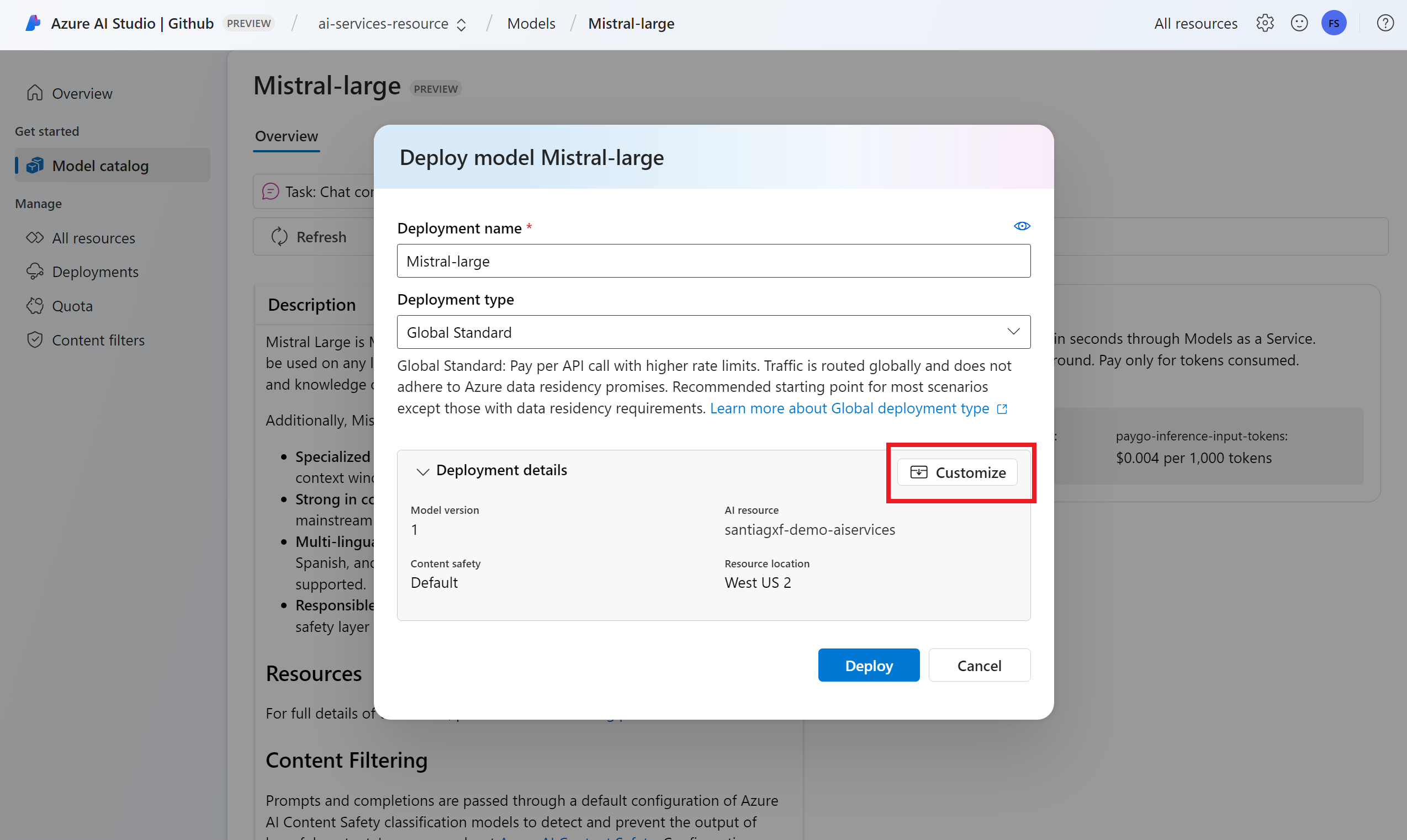

Selecteer Implementeren.

Voor modellenproviders waarvoor meer contractvoorwaarden zijn vereist, wordt u gevraagd deze voorwaarden te accepteren. Accepteer de voorwaarden voor deze gevallen door Abonneren en implementeren te selecteren.

U kunt de implementatie-instellingen op dit moment configureren. Standaard ontvangt de implementatie de naam van het model dat u implementeert. De implementatienaam wordt gebruikt in de

modelparameter voor aanvraag om naar deze specifieke modelimplementatie te routeren. Hiermee kunt u specifieke namen voor uw modellen configureren wanneer u specifieke configuraties koppelt. Bijvoorbeeldo1-preview-safevoor een model met een strikt inhoudsbeveiligingsfilter.We selecteren automatisch een Azure AI Services-verbinding, afhankelijk van uw project, omdat u de functie Modellen implementeren hebt ingeschakeld in de deductieservice van Azure AI-modellen. Gebruik de optie Aanpassen om de verbinding te wijzigen op basis van uw behoeften. Als u implementeert onder het standaardimplementatietype , moeten de modellen beschikbaar zijn in de regio van de Azure AI Services-resource.

Selecteer Implementeren.

Zodra de implementatie is voltooid, ziet u de eindpunt-URL en referenties om toegang te krijgen tot het model. U ziet dat de opgegeven URL en referenties nu hetzelfde zijn als die worden weergegeven op de landingspagina van het project voor het eindpunt voor deductie van het Azure AI-model.

U kunt alle modellen bekijken die beschikbaar zijn onder de resource door naar de sectie Modellen en eindpunten te gaan en de groep te zoeken voor de verbinding met uw AI Services-resource:

Uw code upgraden met het nieuwe eindpunt

Zodra uw Azure AI Services-resource is geconfigureerd, kunt u deze gaan gebruiken vanuit uw code. U hebt de eindpunt-URL en -sleutel nodig, die u kunt vinden in de sectie Overzicht :

U kunt een van de ondersteunde SDK's gebruiken om voorspellingen op te halen uit het eindpunt. De volgende SDK's worden officieel ondersteund:

- OpenAI SDK

- Azure OpenAI SDK

- Azure AI-deductiepakket

- Azure AI Projects-pakket

Zie de sectie ondersteunde talen en SDK's voor meer informatie en voorbeelden. In het volgende voorbeeld ziet u hoe u het Azure AI-deductiepakket gebruikt met het zojuist geïmplementeerde model:

Installeer het pakket azure-ai-inference met behulp van uw pakketbeheer, zoals pip:

pip install azure-ai-inference

Vervolgens kunt u het pakket gebruiken om het model te gebruiken. In het volgende voorbeeld ziet u hoe u een client maakt om chatvoltooiingen te gebruiken:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

client = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZURE_INFERENCE_CREDENTIAL"]),

)

Bekijk onze voorbeelden en lees de API-referentiedocumentatie om aan de slag te gaan.

Uw eerste chatvoltooiing genereren:

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Gebruik de parameter model="<deployment-name> om uw aanvraag naar deze implementatie te routeren.

Implementaties werken als alias van een bepaald model onder bepaalde configuraties. Zie de conceptpagina Routering voor meer informatie over de route-implementaties van Azure AI Services.

Overstappen van serverloze API-eindpunten naar azure AI-modeldeductie

Hoewel u het project hebt geconfigureerd voor het gebruik van de deductie van het Azure AI-model, blijven bestaande modelimplementaties in het project bestaan als serverloze API-eindpunten. Deze implementaties worden niet voor u verplaatst. Daarom kunt u elke bestaande code die verwijst naar eerdere modelimplementaties geleidelijk bijwerken. Als u wilt beginnen met het verplaatsen van de modelimplementaties, raden we de volgende werkstroom aan:

Maak de modelimplementatie opnieuw in azure AI-modeldeductie. Deze modelimplementatie is toegankelijk onder het deductie-eindpunt van het Azure AI-model.

Werk uw code bij om het nieuwe eindpunt te gebruiken.

Schoon het project op door het serverloze API-eindpunt te verwijderen.

Uw code upgraden met het nieuwe eindpunt

Zodra de modellen zijn geïmplementeerd onder Azure AI Services, kunt u uw code upgraden om het eindpunt voor deductie van het Azure AI-model te gebruiken. Het belangrijkste verschil tussen hoe serverloze API-eindpunten en azure AI-modeldeductie werkt, bevinden zich in de eindpunt-URL en modelparameter. Hoewel serverloze API-eindpunten een set URI's en sleutels per modelimplementatie hebben, heeft Azure AI-modeldeductie er slechts één voor alle.

De volgende tabel bevat een overzicht van de wijzigingen die u moet introduceren:

| Eigenschappen | Serverloze API-eindpunten | Azure AI-modeldeductie |

|---|---|---|

| Eindpunt | https://<endpoint-name>.<region>.inference.ai.azure.com |

https://<ai-resource>.services.ai.azure.com/models |

| Referentie | Eén per model/eindpunt. | Eén per Azure AI Services-resource. U kunt ook Microsoft Entra-id gebruiken. |

| Modelparameter | Geen. | Vereist. Gebruik de naam van de modelimplementatie. |

Bestaande serverloze API-eindpunten van uw project opschonen

Nadat u de code hebt geherstructureerd, wilt u mogelijk de bestaande serverloze API-eindpunten in het project verwijderen (indien van toepassing).

Voer de volgende stappen uit voor elk model dat als serverloze API-eindpunten is geïmplementeerd:

Ga naar de Azure AI Foundry-portal.

Selecteer Modellen en eindpunten.

Identificeer de eindpunten van het type Serverloos en selecteer het eindpunt dat u wilt verwijderen.

Selecteer de optie Verwijderen.

Waarschuwing

Deze bewerking kan niet worden teruggezet. Zorg ervoor dat het eindpunt momenteel niet wordt gebruikt door een andere gebruiker of stukje code.

Bevestig de bewerking door Verwijderen te selecteren.

Als u een serverloze API-verbinding met dit eindpunt hebt gemaakt vanuit andere projecten, worden dergelijke verbindingen niet verwijderd en blijven ze verwijzen naar het niet-bestaande eindpunt. Verwijder een van deze verbindingen om fouten te voorkomen.

Beperkingen

Houd rekening met de volgende beperkingen bij het configureren van uw project voor het gebruik van Azure AI-modeldeductie:

- Alleen modellen die facturering per gebruik ondersteunen (Models as a Service) zijn beschikbaar voor implementatie naar Azure AI-modeldeductie. Modellen waarvoor rekenquotum van uw abonnement is vereist (Managed Compute), inclusief aangepaste modellen, kunnen alleen worden geïmplementeerd binnen een bepaald project als Beheerde online-eindpunten en blijven toegankelijk met behulp van hun eigen set eindpunt-URI's en referenties.

- Modellen die beschikbaar zijn als facturering per gebruik en beheerde compute-aanbiedingen, worden standaard geïmplementeerd in Azure AI-modeldeductie in Azure AI-servicesresources. Azure AI Foundry Portal biedt geen manier om ze te implementeren op beheerde online-eindpunten. U moet de functie uitschakelen die wordt vermeld bij Het project configureren om azure AI-modeldeductie te gebruiken of de Azure CLI/Azure ML SDK/ARM-sjablonen gebruiken om de implementatie uit te voeren.

Volgende stappen

- Voeg meer modellen toe aan uw eindpunt.