Azure Synapse Analytics에서 Fabric으로 Spark 풀 마이그레이션

Azure Synapse는 Spark 풀을 제공하지만 Fabric은 스타터 풀 및 사용자 지정 풀을 제공합니다. Azure Synapse에 사용자 지정 구성 또는 라이브러리가 없는 단일 풀이 있고 중간 크기 노드가 요구 사항을 충족하는 경우 스타터 풀을 선택하는 것이 좋습니다. 그러나 Spark 풀 구성에서 더 많은 유연성을 추구하는 경우 사용자 지정 풀을 사용하는 것이 좋습니다. 여기 두 옵션이 있습니다.

- 옵션 1: Spark 풀을 작업 영역의 기본 풀로 이동합니다.

- 옵션 2: Fabric에서 Spark 풀을 사용자 지정 환경으로 이동합니다.

둘 이상의 Spark 풀이 있고 동일한 Fabric 작업 영역으로 이동하려는 경우 옵션 2를 사용하여 여러 사용자 지정 환경 및 풀을 만드는 것이 좋습니다.

Spark 풀 고려 사항은 Azure Synapse Spark와 Fabric 간의 차이점을 참조 하세요.

필수 조건

아직 없는 경우 테넌트에 Fabric 작업 영역을 만듭니다.

옵션 1: Spark 풀에서 작업 영역의 기본 풀로

Fabric 작업 영역에서 사용자 지정 Spark 풀을 만들고 작업 영역에서 기본 풀로 사용할 수 있습니다. 기본 풀은 동일한 작업 영역의 모든 Notebook 및 Spark 작업 정의에서 사용됩니다.

기존 Spark 풀에서 Azure Synapse에서 작업 영역 기본 풀로 이동하려면 다음을 수행합니다.

- Azure Synapse 작업 영역에 액세스: Azure에 로그인합니다. Azure Synapse 작업 영역으로 이동하고, 분석 풀로 이동하고, Apache Spark 풀을 선택합니다.

- Spark 풀 찾기: Apache Spark 풀에서 Fabric으로 이동할 Spark 풀을 찾아 풀 속성을 확인합니다.

- 속성 가져오기: Apache Spark 버전, 노드 크기 패밀리, 노드 크기 또는 자동 크기 조정과 같은 Spark 풀 속성을 가져옵니다. 차이점을 보려면 Spark 풀 고려 사항을 참조하세요.

-

Fabric에서 사용자 지정 Spark 풀을 만듭니다.

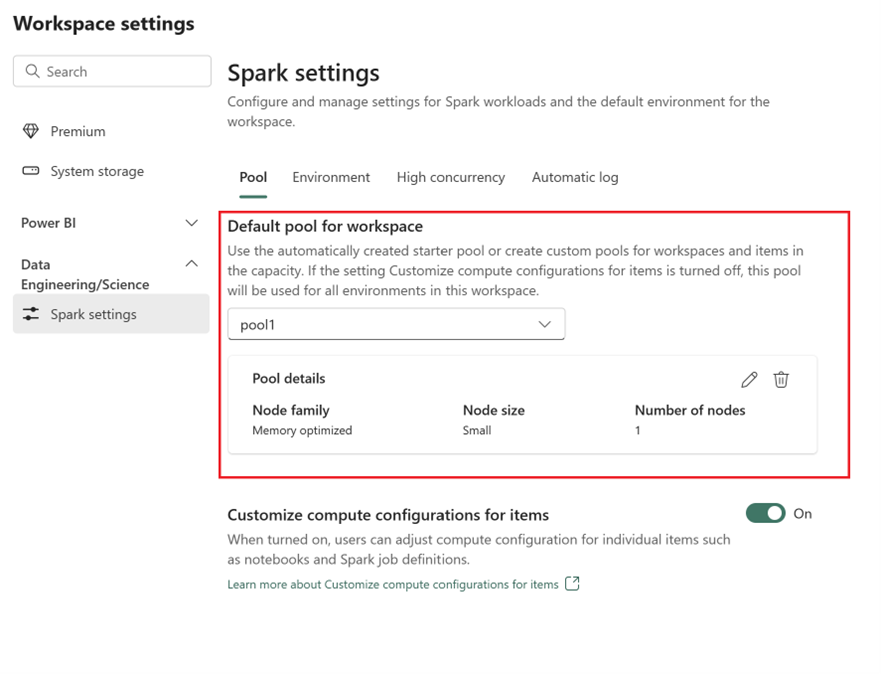

- Fabric 작업 영역으로 이동하여 작업 영역 설정을 선택합니다.

- 데이터 엔지니어/과학으로 이동하여 Spark 설정을 선택합니다.

- 풀 탭 및 작업 영역의 기본 풀 섹션에서 드롭다운 메뉴를 확장하고 새 풀 만들기를 선택합니다.

- 해당 대상 값을 사용하여 사용자 지정 풀을 만듭니다. 이름, 노드 패밀리, 노드 크기, 자동 크기 조정 및 동적 실행기 할당 옵션을 채웁니다.

-

런타임 버전 선택:

- 환경 탭으로 이동하여 필요한 런타임 버전을 선택합니다. 여기에서 사용 가능한 런타임을 참조하세요.

- 기본 환경 설정 옵션을 사용하지 않도록 설정합니다.

참고 항목

이 옵션에서는 풀 수준 라이브러리 또는 구성이 지원되지 않습니다. 그러나 Notebook 및 Spark 작업 정의와 같은 개별 항목에 대한 컴퓨팅 구성을 조정하고 인라인 라이브러리를 추가할 수 있습니다. 사용자 지정 라이브러리 및 구성을 환경에 추가해야 하는 경우 사용자 지정 환경을 고려합니다.

옵션 2: Spark 풀에서 사용자 지정 환경으로

사용자 지정 환경을 사용하면 사용자 지정 Spark 속성 및 라이브러리를 설정할 수 있습니다. 사용자 지정 환경을 만듭니다.

- Azure Synapse 작업 영역에 액세스: Azure에 로그인합니다. Azure Synapse 작업 영역으로 이동하고, 분석 풀로 이동하고, Apache Spark 풀을 선택합니다.

- Spark 풀 찾기: Apache Spark 풀에서 Fabric으로 이동할 Spark 풀을 찾아 풀 속성을 확인합니다.

- 속성 가져오기: Apache Spark 버전, 노드 크기 패밀리, 노드 크기 또는 자동 크기 조정과 같은 Spark 풀 속성을 가져옵니다. 차이점을 보려면 Spark 풀 고려 사항을 참조하세요.

-

사용자 지정 Spark 풀을 만듭니다.

- Fabric 작업 영역으로 이동하여 작업 영역 설정을 선택합니다.

- 데이터 엔지니어/과학으로 이동하여 Spark 설정을 선택합니다.

- 풀 탭 및 작업 영역의 기본 풀 섹션에서 드롭다운 메뉴를 확장하고 새 풀 만들기를 선택합니다.

- 해당 대상 값을 사용하여 사용자 지정 풀을 만듭니다. 이름, 노드 패밀리, 노드 크기, 자동 크기 조정 및 동적 실행기 할당 옵션을 채웁니다.

- 환경 항목이 없으면 환경 항목을 만듭니다.

-

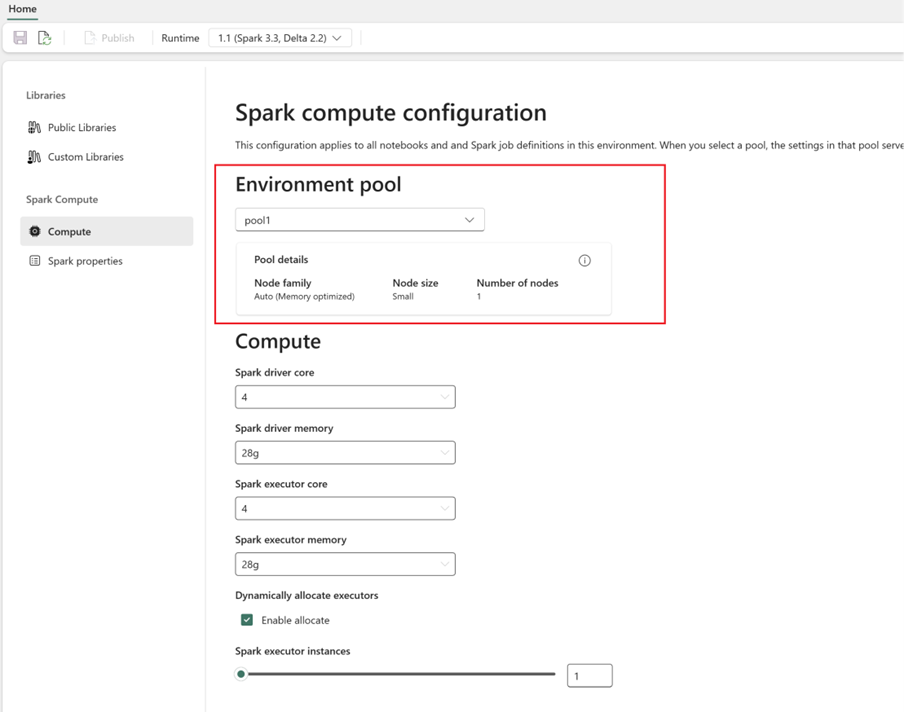

Spark 컴퓨팅 구성:

- 환경 내에서 Spark Compute>컴퓨팅으로 이동합니다.

- 새 환경에 대해 새로 만든 풀을 선택합니다.

- 드라이버 및 실행기 코어와 메모리를 구성할 수 있습니다.

- 환경에 대한 런타임 버전 선택을 합니다. 여기에서 사용 가능한 런타임을 참조하세요.

- 변경 내용 저장 및 게시를 클릭합니다.

환경 만들기 및 사용에 대해 자세히 알아보세요.