イベントストリーム のイベント ソースを追加および管理する

イベントストリームを作成したら、それをさまざまなデータ ソースと宛先に接続することができます。

Note

現在、イベントストリームを作成すると、拡張機能が既定で有効になります。 標準機能を使用して作成されたイベントストリームがある場合、それらのイベントストリームは引き続き機能します。 通常どおりに編集や使用を続けられます。 新しいイベントストリームを作成して標準のイベントストリームを置き換えることをお勧めします。そうすることで、強化されたイベントストリームの追加機能と利点を利用できます。

イベントストリーム を作成したら、それをさまざまなデータ ソースと宛先に接続することができます。

Eventstream を使用すると、Microsoft ソースからデータをストリーミングできるだけでなく、Google Cloud や Amazon Kinesis などのサードパーティプラットフォームからのインジェストと新しいメッセージング コネクタをサポートします。 この拡張された機能により、外部データ ストリームを Fabric にシームレスに統合できるため、柔軟性が向上し、複数のソースからリアルタイムの分析情報を得ることができます。

この記事では、イベントストリームに追加できるイベント ソースについて説明します。

前提条件

- 共同作成者以上のアクセス許可を使用した Fabric 容量ライセンス モード (または試用版ライセンス モード) でのワークスペースへのアクセス。

- 次のソース固有の記事に記載されている各ソースに固有の前提条件。

サポートされているソース

強化された機能を備えたファブリック イベント ストリームでは、次のソースがサポートされます。 各記事では、特定のソースを追加するための詳細と手順について説明します。

| ソース | 説明 |

|---|---|

| Azure Event Hubs | Azure イベント ハブがある場合は、イベントストリーム を使用してイベント ハブ データを Microsoft Fabric に取り込むことができます。 |

| Azure IoT Hub | Azure IoT ハブがある場合は、イベントストリーム を使用して IoT データを Microsoft Fabric に取り込むことができます。 |

| Azure SQL データベースの変更データ キャプチャ (CDC) | Azure SQL データベース CDC ソース コネクタを使用すると、Azure SQL データベース内の現在のデータのスナップショットをキャプチャできます。 コネクタは、このデータに対する将来の行レベルの変更を監視し、記録します。 |

| PostgreSQL データベースの CDC | PostgreSQL データベース変更データ キャプチャ (CDC) ソース コネクタを使用すると、PostgreSQL データベース内の現在のデータのスナップショットをキャプチャできます。 コネクタは、このデータに対する将来の行レベルの変更を監視し、記録します。 |

| MySQL Database CDC | Azure MySQL データベース変更データ キャプチャ (CDC) ソース コネクタを使用すると、Azure Database for MySQL データベース内の現在のデータのスナップショットをキャプチャできます。 監視するテーブルを指定でき、eventstream はテーブルに対する将来の行レベルの変更を記録します。 |

| Azure Cosmos DB の CDC | Microsoft Fabric イベントストリーム用の Azure Cosmos DB Change Data Capture (CDC) ソースコネクタを使用すると、Azure Cosmos DB データベース内の現在のデータのスナップショットを取得できます。 コネクタは、このデータに対する将来の行レベルの変更を監視し、記録します。 |

| SQL Server on Virtual Machine (VM) データベース (DB) CDC | Fabric イベント ストリーム用の SQL Server on VM DB (CDC) ソース コネクタを使うと、VM 上の SQL Server データベース内の現在のデータのスナップショットをキャプチャできます。 その後、このコネクタは、以降のデータに対する行レベルの変更を監視して記録します。 |

| Azure SQL Managed Instance CDC | Microsoft Fabric イベント ストリーム用の Azure SQL Managed Instance CDC ソース コネクタを使うと、SQL Managed Instance データベース内の現在のデータのスナップショットをキャプチャできます。 コネクタは、このデータに対する将来の行レベルの変更を監視し、記録します。 |

| Google Cloud Pub/Sub | Google Pub/Sub は、イベントのストリームを公開してサブスクライブできるメッセージング サービスです。 Google Pub/Sub をソースとしてイベントストリームに追加して、リアルタイムイベントをキャプチャ、変換し、ファブリック内のさまざまな宛先にルーティングできます。 |

| Amazon Kinesis Data ストリーム | Amazon Kinesis Data ストリーム は、ストリーミング データ用に最適化された、非常にスケーラブルで耐久性の高いデータ インジェストおよび処理サービスです。 Amazon Kinesis Data ストリームをイベントストリーム内のソースとして統合することで、リアルタイムデータストリームをファブリック内の複数の宛先にルーティングする前にシームレスに処理できます。 |

| Confluent Cloud Kafka | Confluent Cloud Kafka は、Apache Kafka を使用した強力なデータ ストリーミングと処理機能を提供するストリーミング プラットフォームです。 Confluent Cloud Kafka をイベントストリーム内のソースとして統合することで、リアルタイム データ ストリームをシームレスに処理してから、Fabric 内の複数の宛先にルーティングできます。 |

| Amazon MSK Kafka | Amazon MSK Kafka は、セットアップ、スケーリング、管理を簡素化するフル マネージドの Kafka サービスです。 Amazon MSK Kafka をイベントストリーム内のソースとして統合することで、MSK Kafka からリアルタイム イベントをシームレスに取り込み、それらを処理してから Fabric 内の複数の宛先にルーティングできます。 |

| サンプル データ | サンプル データ ソースとして Bicycles、Yellow Taxi、または Stock Market イベントを選択して、イベントストリームの設定中にデータ インジェストをテストできます。 |

| カスタム エンドポイント (すなわち、標準機能のカスタム アプリ) | カスタム エンドポイント機能を使用すると、アプリケーションまたは Kafka クライアントは接続文字列を使用して イベントストリーム に接続できるため、イベントストリーム へのストリーミング データのスムーズな取り込みを可能にします。 |

| Azure Service Bus (プレビュー) | Eventstream を使用して、Azure Service Bus キューまたはトピックのサブスクリプションから Microsoft Fabric にデータを取り込むことができます。 |

| Apache Kafka (プレビュー) | Apache Kafka は、スケーラブルでリアルタイムのデータ システムを構築するためのオープンソースの分散プラットフォームです。 Apache Kafka をイベントストリーム内のソースとして統合することで、Apache Kafka からリアルタイム イベントをシームレスに取り込み、それらを処理してから Fabric 内の複数の宛先にルーティングできます。 |

| Azure Blob Storage のイベント (プレビュー) | これらのイベントは、クライアントが BLOB REST API を呼び出して BLOB を作成、置換、または削除するときにトリガーされます。 コネクタを使用すると、Blob Storage イベントをリアルタイム ハブの Fabric イベントにリンクできます。 これらのイベントを連続データ ストリームに変換し、それらを変換してから、Fabric のさまざまな宛先にルーティングできます。 |

| Fabric ワークスペース項目イベント (プレビュー) | Fabric ワークスペース項目イベントは、Fabric ワークスペースに変更が加えられたときに発生する個別の Fabric イベントです。 これらの変更には、Fabric アイテムの作成、更新、または削除が含まれます。 Fabric イベント ストリームを使用すると、これらの Fabric ワークスペース イベントをキャプチャし、それらを変換し、さらに分析するために Fabric のさまざまな宛先にルーティングできます。 |

| Fabric OneLake イベント (プレビュー) | OneLake イベントを使用すると、OneLake のファイルとフォルダーの変更をサブスクライブし、それらの変更にリアルタイムで対応できます。 Fabric イベント ストリームを使用すると、これらの OneLake イベントをキャプチャして変換し、さらに分析するために Fabric のさまざまな宛先にルーティングできます。 Fabric イベント ストリーム内での OneLake イベントのシームレスな統合により、OneLake のアクティビティを監視および分析するための柔軟性が向上します。 |

| Fabric ジョブ イベント (プレビュー) | ジョブ イベントを使用すると、Fabric がジョブを実行したときに生成された変更をサブスクライブできます。 たとえば、セマンティック モデルの更新、スケジュールされたパイプラインの実行、ノートブックの実行時の変更に対応できます。 これらの各アクティビティは、対応するジョブを生成できます。これにより、対応するジョブ イベントのセットが生成されます。 Fabric イベント ストリームを使用すると、これらのジョブ イベントをキャプチャして変換し、さらに分析するために Fabric のさまざまな宛先にルーティングできます。 Fabric イベント ストリーム内でのジョブ イベントのシームレスな統合により、ジョブ内のアクティビティを監視および分析するための柔軟性が向上します。 |

Note

1 つのイベントストリームでのソースと宛先の合計数は 11 個までです。

関連するコンテンツ

前提条件

開始する前に、次の前提条件を満たしている必要があります。

- 共同作成者以上のアクセス許可を使用した Fabric 容量ライセンス モード (または試用版ライセンス モード) でのワークスペースへのアクセス。

- Azure Event Hubs または Azure IoT Hub を イベントストリーム ソースとして追加するには、そのポリシー キーにアクセスするための適切なアクセス許可が必要です。 これは、パブリックにアクセス可能であり、ファイアウォールの内側や、仮想ネットワークで保護されいない必要があります。

サポートされているソース

Fabric イベント ストリームでは、次のソースがサポートされています。 テーブルのリンクを使用して、特定のソースの追加に関する詳細を提供する記事に移動します。

| ソース | 説明 |

|---|---|

| Azure Event Hubs | Azure イベント ハブがある場合は、イベントストリーム を使用してイベント ハブ データを Microsoft Fabric に取り込むことができます。 |

| Azure IoT Hub | Azure IoT ハブがある場合は、イベントストリーム を使用して IoT データを Microsoft Fabric に取り込むことができます。 |

| サンプル データ | サンプル データ ソースとして Bicycles、Yellow Taxi、または Stock Market イベントを選択して、イベントストリームの設定中にデータ インジェストをテストできます。 |

| カスタム アプリ | カスタム アプリ機能を使用すると、アプリケーションまたは Kafka クライアントは接続文字列を使用して イベントストリーム に接続できるため、イベントストリーム へのストリーミング データのスムーズな取り込みを可能にします。 |

Note

1 つのイベントストリームでのソースと宛先の合計数は 11 個までです。

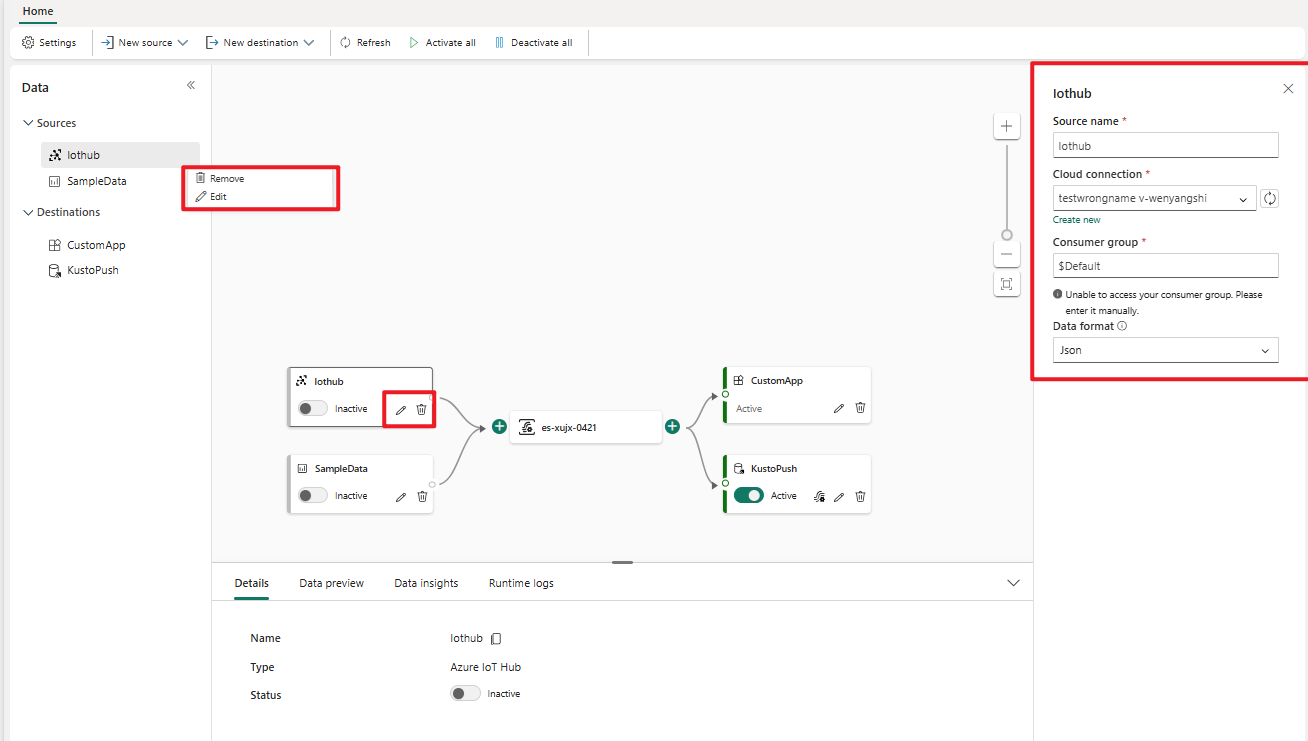

ソースを管理する

編集/削除: ナビゲーション ウィンドウまたはキャンバスで イベントストリーム ソースを選択して、編集または削除することができます。 [編集] を選択すると、メイン エディターの右側に編集ペインが開きます。

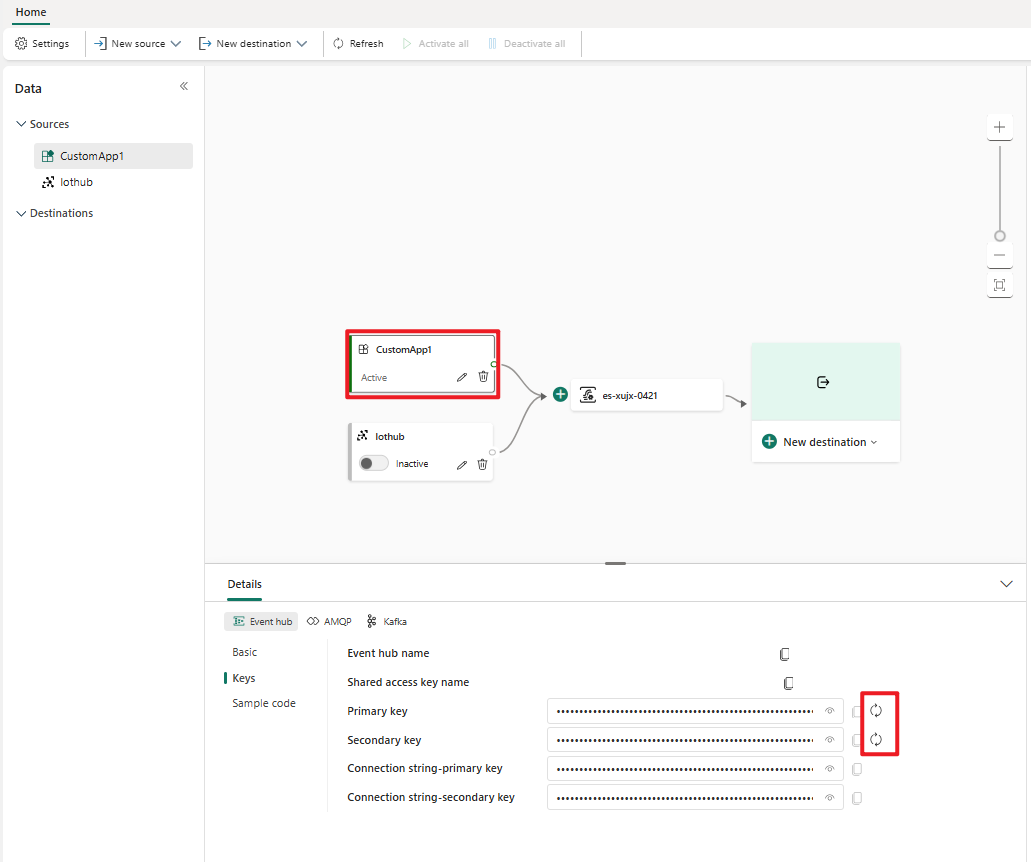

カスタム アプリのキーの再生成: アプリケーションの新しい接続キーを再生成する必要がある場合は、キャンバスでいずれかのカスタム アプリ ソースを選択し、[再生成] を選択して、新しい接続キーを取得します。