Prise en charge native de la qualité des données pour le format Iceberg (préversion)

La prise en charge native de Microsoft Purview pour le format de table ouverte Apache Iceberg est en préversion publique. Les clients Microsoft Purview utilisant Microsoft Azure Data Lake Storage (ADLS) Gen2, Microsoft Fabric Lakehouse, Amazon Web Services (AWS) S3 et Google Cloud Storage (GCP) Google Cloud Storage (GCP) peuvent désormais utiliser Microsoft Purview pour organiser, gouverner et effectuer le contrôle d’intégrité des données et l’évaluation de la qualité des données sur les ressources de données Iceberg.

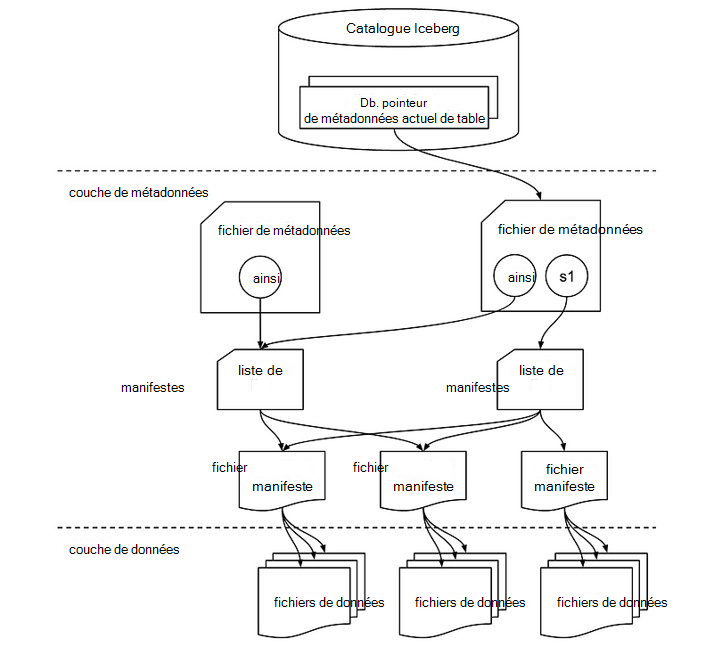

Structure de fichiers Iceberg

Une table Iceberg est bien plus qu’une simple collection de fichiers de données. Il inclut différents fichiers de métadonnées qui suivent l’état de la table et facilitent les opérations telles que les lectures, les écritures et l’évolution du schéma. Vous trouverez ci-dessous une exploration des composants critiques impliqués dans une table Iceberg. Les fichiers de données d’une table Iceberg sont généralement stockés dans des formats en colonnes comme Apache Parquet, Apache Avro ou Apache Optimized Row Columnar (ORC). Ces fichiers contiennent les données réelles avec lesquelles les utilisateurs interagissent pendant les requêtes.

Catalogue Iceberg

En haut se trouve le catalogue Iceberg, qui stocke le pointeur de métadonnées actuel pour chaque table. Ce catalogue permet de suivre l’état le plus récent d’une table en référençant le fichier de métadonnées actuel.

Couche de métadonnées

La couche de métadonnées est au cœur des fonctionnalités d’Iceberg et se compose de plusieurs éléments clés :

- Fichier de métadonnées : Ce fichier contient des informations sur le schéma, le partitionnement et les instantanés de la table. Dans le diagramme, s0 fait référence à une instantané, qui est essentiellement un enregistrement de l’état de la table à un moment donné dans le temps. S’il existe plusieurs instantanés, tels que s0 et s1, le fichier de métadonnées effectue le suivi des deux.

- Liste des manifestes : Cette liste pointe vers un ou plusieurs fichiers manifeste. Une liste de manifestes agit comme un conteneur de références à ces manifestes, et elle permet à Iceberg de gérer efficacement les fichiers de données qui doivent être lus ou écrits pendant différentes opérations. Chaque instantané peut avoir sa propre liste de manifestes.

Couche de données

Dans la couche de données, les fichiers manifestes jouent le rôle d’intermédiaire entre les métadonnées et les fichiers de données réels. Chaque fichier manifeste pointe vers une collection de fichiers de données, fournissant une carte des fichiers physiques stockés dans le lac de données.

- Fichiers manifeste : ces fichiers stockent les métadonnées d’un groupe de fichiers de données, y compris le nombre de lignes, les informations de partition et les chemins d’accès aux fichiers. Ils permettent à Iceberg d’élaguer et d’accéder rapidement à des fichiers spécifiques, ce qui permet une interrogation efficace.

- Fichiers de données : les données réelles résident dans ces fichiers, qui peuvent être dans des formats tels que Parquet, ORC ou Avro. Iceberg organise les fichiers de données en fonction des partitions, ce qui permet d’optimiser les performances pendant l’exécution des requêtes en réduisant les analyses de données inutiles.

Fonctionnement de l’ensemble

Lorsqu’une opération telle qu’une requête ou une mise à jour est effectuée, Iceberg recherche d’abord le fichier de métadonnées de la table via le catalogue. Le fichier de métadonnées fait référence à la instantané actuelle (ou plusieurs instantanés), qui pointe ensuite vers la liste des manifestes. La liste des manifestes contient des références aux fichiers manifeste, qui à leur tour répertorient les fichiers de données individuels. Cette structure hiérarchique permet à Iceberg de gérer efficacement les jeux de données volumineux tout en garantissant la cohérence transactionnelle, en activant des fonctionnalités telles que le voyage dans le temps et l’évolution du schéma.

Cette conception multicouche améliore les performances et la scalabilité des opérations de traitement par lots et de diffusion en continu, car seuls les fichiers de données nécessaires sont accessibles et les mises à jour sont gérées par le biais d’instantanés sans affecter l’ensemble du jeu de données.

Données iceberg dans OneLake

Vous pouvez consommer en toute transparence des données au format Iceberg dans Microsoft Fabric sans déplacement ou duplication de données. Vous pouvez utiliser les raccourcis OneLake pour pointer directement vers une couche de données.

Les données iceberg sont stockées dans OneLake, écrites à l’aide de Snowflake ou d’un autre enregistreur Iceberg. OneLake virtualise la table en tant que table Delta Lake, garantissant ainsi une compatibilité étendue entre les moteurs Fabric. Par exemple, vous pouvez créer un volume dans Snowflake et le pointer directement vers Fabric Lakehouse. Une fois la table créée dans Fabric OneLake, la synchronisation automatique garantit que toutes les mises à jour de données sont reflétées en temps réel. Ce processus simplifié facilite l’utilisation des données Iceberg dans Microsoft Fabric. Pour plus d’informations, consultez la documentation Snowflake.

Importante

Les données iceberg dans AWS S3 et GCS doivent également être synchronisées automatiquement en tant que delta pour organiser, gouverner, mesurer et surveiller la qualité des données.

Qualité des données pour les données Iceberg

Pour tous les utilisateurs qui hydratant en mode natif des données dans Iceberg on (Parquet, ORC, Avro) sur ADLS Gen2 ou Fabric Lakehouse doit simplement confiture une analyse pointant vers l’emplacement du répertoire hébergeant les données et les métadonnées des répertoires Iceberg. Suivez les étapes ci-dessous :

Configurez et exécutez une analyse dans Mappage de données Microsoft Purview.

Configurez la dir (hébergeant les données et les métadonnées) en tant que ressource de données et associez-la au produit de données. Il forme le jeu de données Iceberg. Associez des ressources de données Iceberg à un produit de données dans Catalogue unifié Microsoft Purview. Découvrez comment associer des ressources de données à un produit de données.

Dans Catalogue unifié, sous Gestion de l’intégrité, sélectionnez Vue qualité des données pour rechercher vos fichiers Iceberg (ressource de données) et configurer la connexion à la source de données.

3.1 Pour configurer la connexion AdlsG2, suivez les étapes décrites dans le document sur la connexion DQ

3.2 Pour configurer la connexion Fabric OneLake, suivez les étapes décrites dans le document DQ du patrimoine de données de structure.

Appliquez des règles de qualité des données et exécutez des analyses de qualité des données pour le scoring de qualité des données au niveau des colonnes et des tables.

Dans la page Schéma du fichier Iceberg sélectionné (ressource de données), sélectionnez Importer le schéma pour importer le schéma à partir de la source de données du fichier Iceberg.

Avant d’exécuter le travail de profilage ou d’analyse de la qualité des données, accédez à la page Vue d’ensemble du fichier Iceberg, puis, dans le menu déroulant Ressource de données , sélectionnez Iceberg.

Profilage et analyse de la qualité des données

Une fois que vous avez terminé la configuration de la connexion et la sélection du format de fichier de ressource de données, vous pouvez profiler, créer et appliquer des règles, et exécuter une analyse de la qualité des données de vos données dans les fichiers au format ouvert Iceberg. Suivez les instructions pas à pas décrites dans les documents ci-dessous :

- Comment configurer et exécuter le profilage des données de vos données

- Comment configurer et exécuter l’analyse de la qualité des données

Importante

- La prise en charge du format ouvert Iceberg dans les fonctionnalités de découverte de catalogue, de curation, de profilage des données et d’analyse de la qualité des données est désormais en préversion.

- Pour le profilage des données et l’évaluation de la qualité des données, vous devez récupérer et définir le schéma à partir de la page Schéma de qualité des données.

- Expérience de découverte des consommateurs : les consommateurs ne verront pas le schéma dans la vue des ressources de données, car data map ne prend pas encore en charge le format de table ouverte Iceberg. Le gestionnaire de la qualité des données peut importer le schéma à partir de la page du schéma de qualité des données.

Limitations

La version actuelle prend en charge les données créées au format Iceberg avec le catalogue Apache Hadoop uniquement.

Chemin Lakehouse et chemin ADLS Gen2

- Les métadonnées Iceberg stockent le chemin complet des données et des métadonnées. Veillez à utiliser le chemin d’accès complet pour ADLS Gen2 et Microsoft Fabric Lakehouse. En outre, pour le chemin d’accès Microsoft Fabric Lakehouse pendant l’écriture, assurez-vous de fonctionner (WRITE, UPSERTS) avec les chemins d’accès d’ID.

abfss://c4dd39bb-77e2-43d3-af10-712845dc2179@onelake.dfs.fabric.microsoft.com/5e8ea953-56fc-49c1-bc8c-0b3498cf1a9c/Files/CustomerData. - Système de fichiers en tant qu’ID et Lakehouse en tant qu’ID. Des chemins d’accès absolus et non relatifs sont nécessaires pour que Microsoft Purview effectue la DQ sur Iceberg. Pour valider, veillez à case activée le chemin d’accès des captures instantanées pour pointer comme chemins complets de nom de domaine complet (FQN).

Détection de schéma

- Data Map a une limitation quant à l’impossibilité de détecter le schéma Iceberg. Lors de l’organisation des répertoires Iceberg sur Fabric Lakehouse ou ADLS Gen2, vous ne pourrez pas examiner le schéma. Toutefois, le schéma de récupération de DQ est en mesure d’extraire le schéma de la ressource organisée.

Recommandations

- Si vous utilisez SNOWFLAKE Catalog pour le format Iceberg, avec le stockage VOLUME comme ADLS Gen2, AWS S3 ou GCS GCS, utilisez le raccourci Microsoft Fabric OneLake Table et effectuez DQ en tant que table DELTA. Pour info : prend uniquement en charge Iceberg avec le format de fichier Parquet.

- Si vous utilisez ADLS pour le format Iceberg avec le catalogue Hadoop, analysez directement le répertoire et utilisez le moteur DQ par défaut pour le format Iceberg pour DQ. Pour info : Prend en charge Iceberg avec le format de fichier Parquet, ORC, Avro.

- Si vous utilisez le format Snowflake pour Iceberg, vous pouvez pointer le stockage VOLUME directement vers le chemin d’accès Microsoft Fabric Lakehouse et utiliser OneLake Table pour créer ensuite une version compatible Delta pour DQ. Pour info : prend uniquement en charge Iceberg avec le format de fichier Parquet.

- Si vous utilisez Microsoft Fabric Lakehouse pour le format Iceberg avec le catalogue Hadoop, analysez directement le répertoire lakehouse et utilisez le moteur DQ par défaut pour le format Iceberg pour DQ. Pour info : Prend en charge Iceberg avec le format de fichier Parquet, ORC, Avro.