Qualité des données pour le patrimoine de données Fabric Lakehouse

Fabric OneLake est un lac de données unique, unifié et logique pour l’ensemble de votre organization. Un lac de données traite de grands volumes de données provenant de différentes sources. Comme Microsoft OneDrive, OneLake est fourni automatiquement avec chaque locataire Microsoft Fabric et est conçu pour être l’emplacement unique pour toutes vos données d’analyse. OneLake apporte aux clients :

- Un lac de données pour l’ensemble du organization

- Une copie des données à utiliser avec plusieurs moteurs analytiques

OneLake vise à vous donner le plus de valeur possible à partir d’une seule copie de données sans déplacement ou duplication de données. Vous n’avez plus besoin de copier des données simplement pour les utiliser avec un autre moteur ou pour décomposer les silos afin de pouvoir analyser les données avec des données provenant d’autres sources. Vous pouvez utiliser Microsoft Purview pour cataloguer le patrimoine de données de l’infrastructure et mesurer la qualité des données afin de régir et de piloter l’action d’amélioration.

Vous pouvez utiliser le raccourci pour référencer des données stockées dans d’autres emplacements de fichiers. Ces emplacements de fichiers peuvent se trouver dans le même espace de travail ou dans différents espaces de travail, dans OneLake ou externes à OneLake dans Azure Data Lake Storage (ADLS), Amazon Web Services (AWS) S3 ou Dataverse, avec d’autres emplacements cibles bientôt disponibles. L’emplacement de la source de données n’a pas autant d’importance. Les raccourcis OneLake font en sorte que les fichiers et les dossiers ressemblent à ceux que vous avez stockés localement. Lorsque les équipes travaillent indépendamment dans des espaces de travail distincts, les raccourcis vous permettent de combiner des données dans différents groupes d’entreprise et domaines dans un produit de données virtuel pour répondre aux besoins spécifiques d’un utilisateur.

Vous pouvez utiliser la mise en miroir pour regrouper des données provenant de différentes sources dans Fabric. La mise en miroir dans Fabric est une solution à faible coût et à faible latence pour regrouper les données de différents systèmes dans une seule plateforme d’analytique. Vous pouvez répliquer en continu votre patrimoine de données existant directement dans OneLake de Fabric, y compris les données de Azure SQL Database, Azure Cosmos DB et Snowflake. Avec les données les plus récentes dans un format interrogeable dans OneLake, vous pouvez désormais utiliser tous les différents services dans Fabric. Par exemple, l’exécution d’analyses avec Spark, l’exécution de notebooks, l’ingénierie des données, la visualisation via des rapports Power BI, etc. Les tables Delta peuvent ensuite être utilisées partout dans Fabric, ce qui permet aux utilisateurs d’accélérer leur parcours vers Fabric.

Inscrire Fabric OneLake

Pour configurer l’analyse data map, vous devez d’abord inscrire la source de données que vous souhaitez analyser. Pour analyser un espace de travail Fabric, aucune modification n’est apportée à l’expérience existante pour inscrire un locataire Fabric en tant que source de données. Pour inscrire une nouvelle source de données, procédez comme suit :

- Dans le portail Microsoft Purview, accédez à Data Map.

- Sélectionner Inscription.

- Dans Inscrire des sources, sélectionnez Structure.

Reportez-vous aux mêmes instructions de configuration de locataire et interlocataire .

Configurer l’analyse data map

Pour analyser les sous-objets Lakehouse, aucune modification n’est apportée à l’expérience existante dans Data Map pour configurer une analyse. Il existe une autre étape pour accorder les informations d’identification d’analyse avec au moins le rôle Contributeur dans les espaces de travail Fabric pour extraire les informations de schéma des formats de fichiers pris en charge.

Actuellement, seul le principal de service est pris en charge comme méthode d’authentification. La prise en charge MSI est toujours en souffrance.

Reportez-vous aux mêmes instructions de configuration de locataire et interlocataire .

Configurer la connexion pour l’analyse Fabric Lakehouse

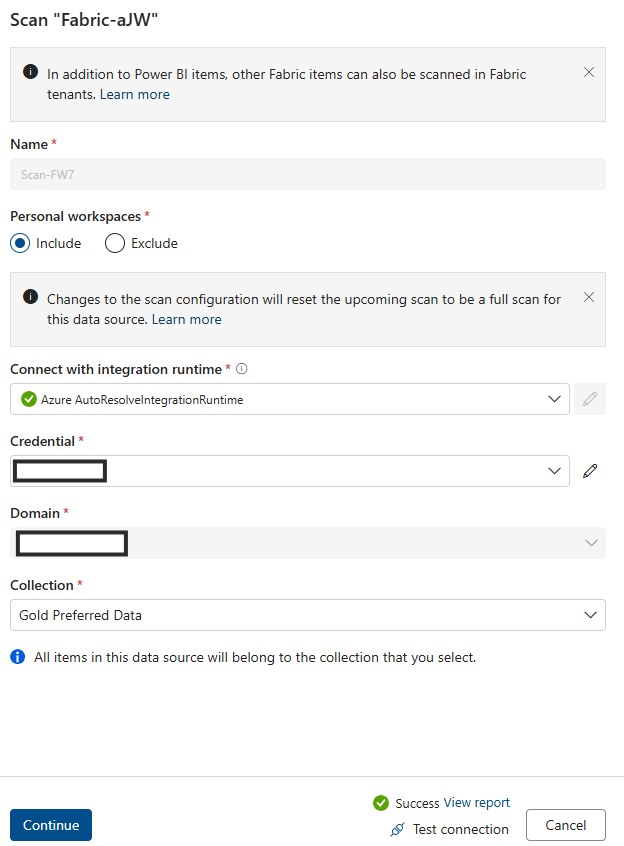

Après avoir inscrit Fabric Lakehouse en tant que source, vous pouvez sélectionner Fabric dans la liste de vos sources de données inscrites dans Data Map et sélectionner Nouvelle analyse. Ajoutez un ID de source de données, puis suivez les étapes ci-dessous :

Créer un groupe de sécurité et un principal de service

Veillez à ajouter ce principal de service et l’identité managée Purview à ce groupe de sécurité, puis fournissez ce groupe de sécurité.

Associer le groupe de sécurité au locataire Fabric

- Connectez-vous au portail d’administration Fabric.

- Sélectionnez la page Paramètres du locataire. Vous devez être un Administration Fabric pour afficher la page des paramètres du locataire.

- Sélectionnez Administration paramètres > de l’API Autoriser les principaux de service à utiliser les API d’administration en lecture seule.

- Sélectionnez Groupes de sécurité spécifiques.

- Sélectionnez Administration paramètres > de l’API Améliorer les réponses des API d’administration avec des métadonnées détaillées et Améliorer les réponses des API d’administration avec des expressions > DAX et mashup Activez le bouton bascule pour permettre aux Mappage de données Microsoft Purview de découvrir automatiquement les métadonnées détaillées des jeux de données Fabric dans le cadre de ses analyses. Après avoir mis à jour les paramètres de l’API Administration sur votre locataire Fabric, attendez environ 15 minutes avant d’inscrire une analyse et de tester la connexion.

Fournissez Administration’autorisation d’API en lecture seule des paramètres d’API à ce groupe de sécurité.

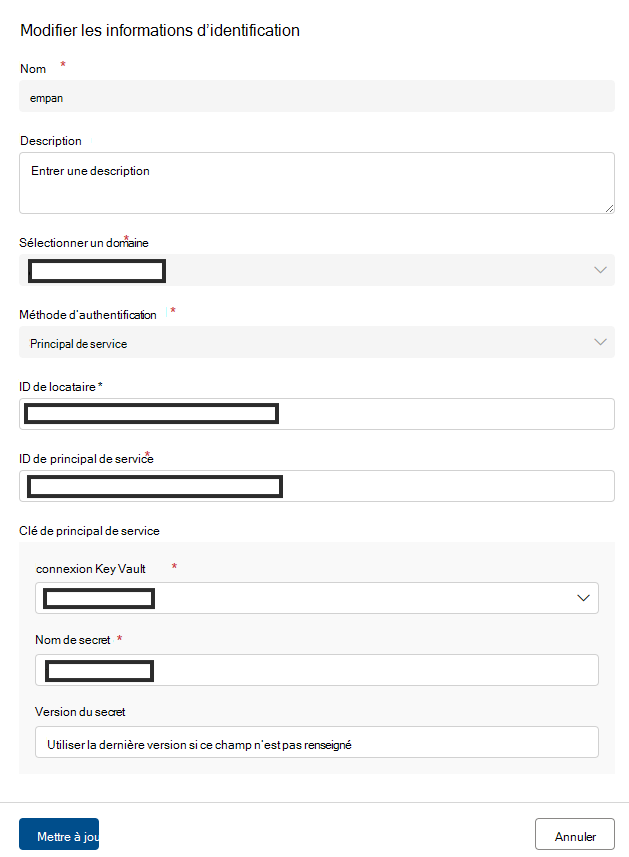

Ajoutez spn dans le champ Informations d’identification .

Ajoutez le nom de la ressource Azure.

Ajoutez l’ID de locataire.

Ajouter l’ID de principe de service.

Ajoutez Key Vault connexion.

Ajouter le nom du secret.

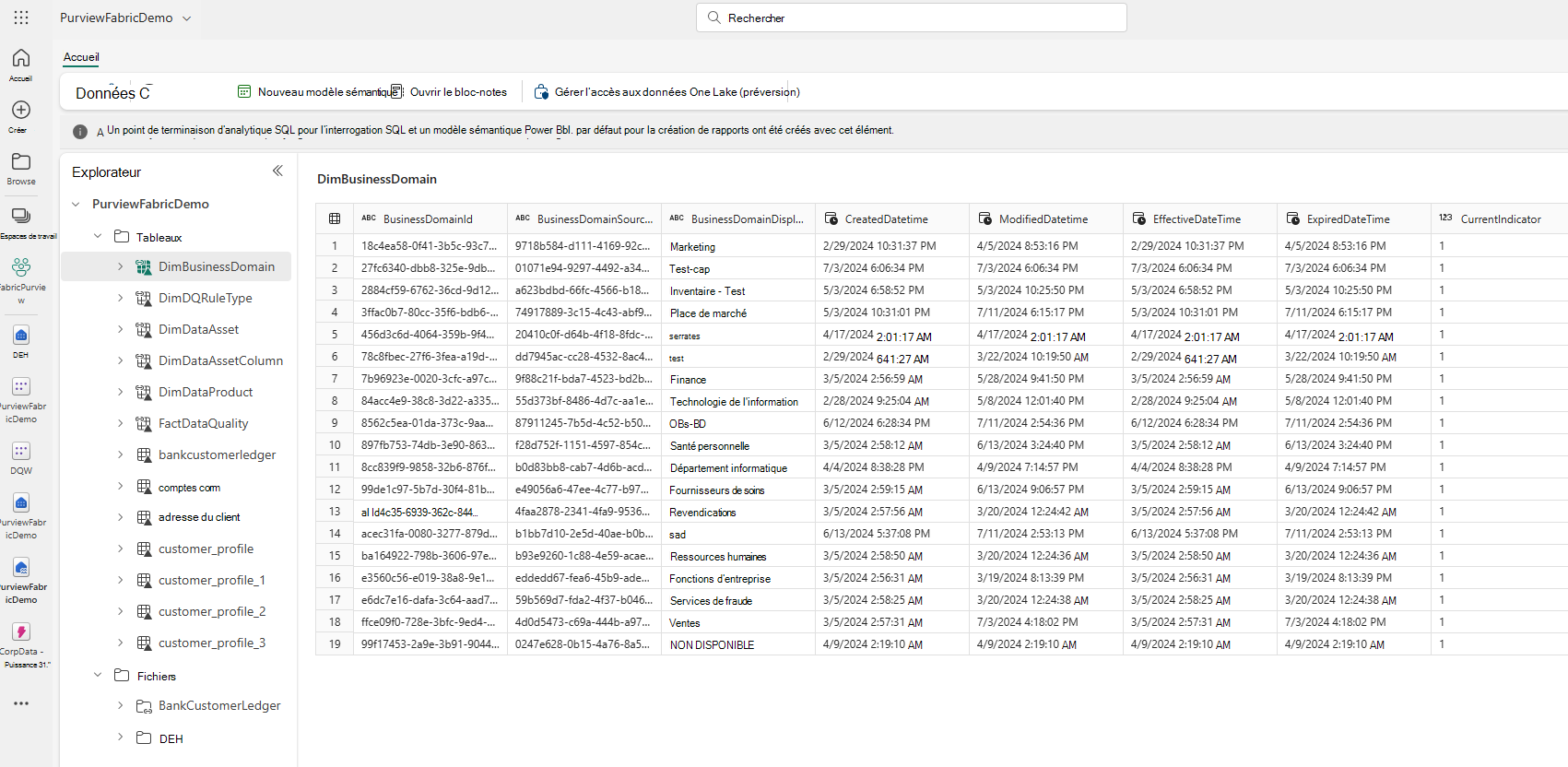

Une fois l’analyse data map terminée, localisez un instance Lakehouse dans Catalogue unifié.

- Dans le portail Microsoft Purview, ouvrez Catalogue unifié.

- Sélectionnez Découverte, puis Ressources de données.

- Dans la page Ressources de données , sélectionnez Microsoft Fabric.

- Sélectionnez Espaces de travail Fabric, puis sélectionnez un espace de travail dans la liste.

- Dans la page de l’espace de travail, recherchez le instance Lakehouse sous Nom de l’élément.

Pour parcourir les tables Lakehouse :

- Dans une page d’espace de travail, sélectionnez le nom de l’élément Tables.

- Sélectionnez une ressource de table Lakehouse répertoriée sous Nom de l’élément.

- Affichez la page des détails de la ressource pour rechercher des métadonnées telles que le schéma, la traçabilité et les propriétés.

Prérequis pour l’analyse de la qualité des données Fabric Lakehouse

- Raccourcissez, miroir ou chargez vos données dans Fabric Lakehouse au format delta.

Importante

Si vous avez ajouté de nouvelles tables, fichiers ou nouvel ensemble de données à Fabric Lakehouse par le biais de la mise en miroir ou du raccourci, vous devez exécuter une analyse de l’étendue Data Map pour cataloguer ces nouveaux jeux de données avant d’ajouter ces ressources de données à un produit de données pour l’évaluation de la qualité des données.

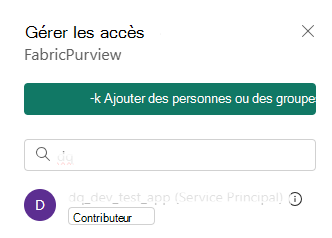

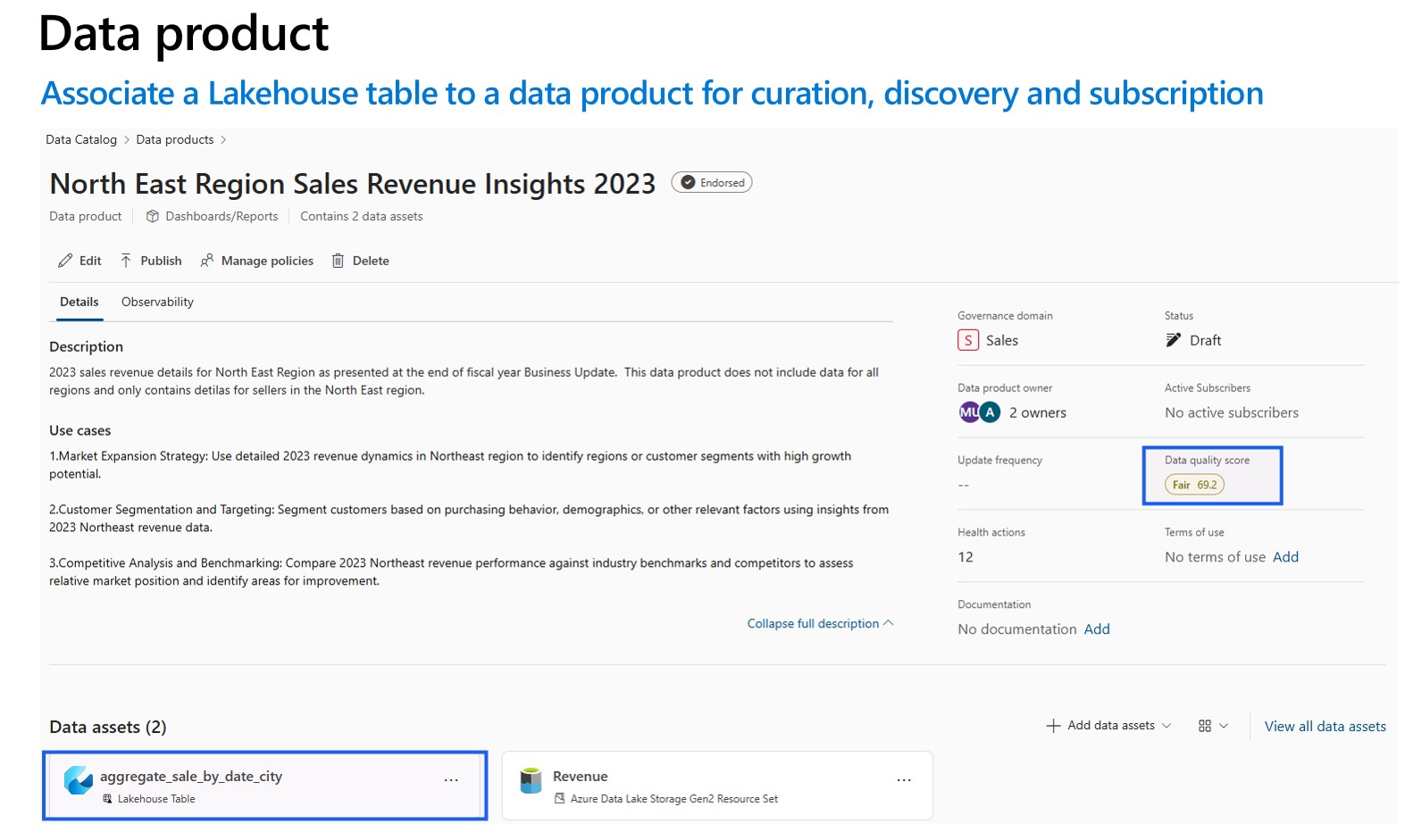

- Accorder le droit contributeur à votre espace de travail pour Purview MSI

- Ajoutez la ressource de données analysées de Lakehouse aux produits de données du domaine de gouvernance. Dans la page d’un produit de données dans Catalogue unifié, recherchez les ressources de données et sélectionnez Ajouter des ressources de données. Le profilage des données et l’analyse de la qualité des données ne peuvent être effectués que pour les ressources de données associées aux produits de données sous le domaine de gouvernance.

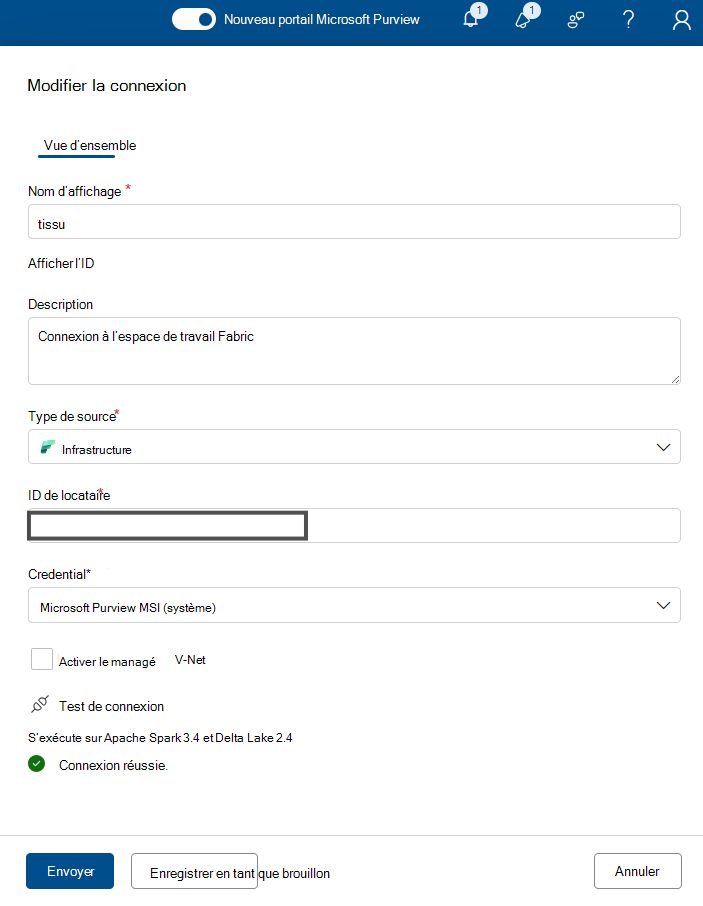

Pour le profilage des données et l’analyse de la qualité des données, vous devez créer une connexion à la source de données, car différents connecteurs sont utilisés pour connecter la source de données et pour analyser les données afin de capturer les faits et dimensions de la qualité des données. Pour configurer une connexion :

Dans Catalogue unifié, sélectionnez Gestion de l’intégrité, puis Qualité des données.

Sélectionnez un domaine de gouvernance, puis, dans la liste déroulante Gérer, sélectionnez Connections.

Sélectionnez Nouveau pour ouvrir la page de configuration de la connexion.

Ajoutez un nom d’affichage de connexion et une description.

Ajoutez le type de source Fabric.

Ajoutez l’ID de locataire.

Ajouter un ID d’espace de travail

Ajouter un ID Lakehouse

Ajouter les informations d’identification - Microsoft Purview MSI.

Testez la connexion pour vous assurer que la connexion configurée est réussie.

Importante

- Pour une analyse de la qualité des données, Microsoft Purview MSI doit avoir contributeur accès à l’espace de travail Fabric pour connecter l’espace de travail Fabric. Pour accorder contributeur accès, ouvrez votre espace de travail Fabric, sélectionnez trois points (...), sélectionnez Accès à l’espace de travail, puis Ajouter des personnes ou un groupe, puis ajoutez Purview MSI en tant que Contributeur.

- Les tables fabric doivent être au format Delta ou Iceberg.

Profilage et analyse de la qualité des données (DQ) dans Fabric Lakehouse

Une fois la configuration de la connexion terminée, vous pouvez profiler, créer et appliquer des règles, et exécuter une analyse de la qualité des données (DQ) de vos données dans Fabric Lakehouse. Suivez les instructions pas à pas décrites ci-dessous :

- Associez une table Lakehouse à un produit de données pour la curation, la découverte et l’abonnement. Découvrez comment créer et gérer des produits de données.

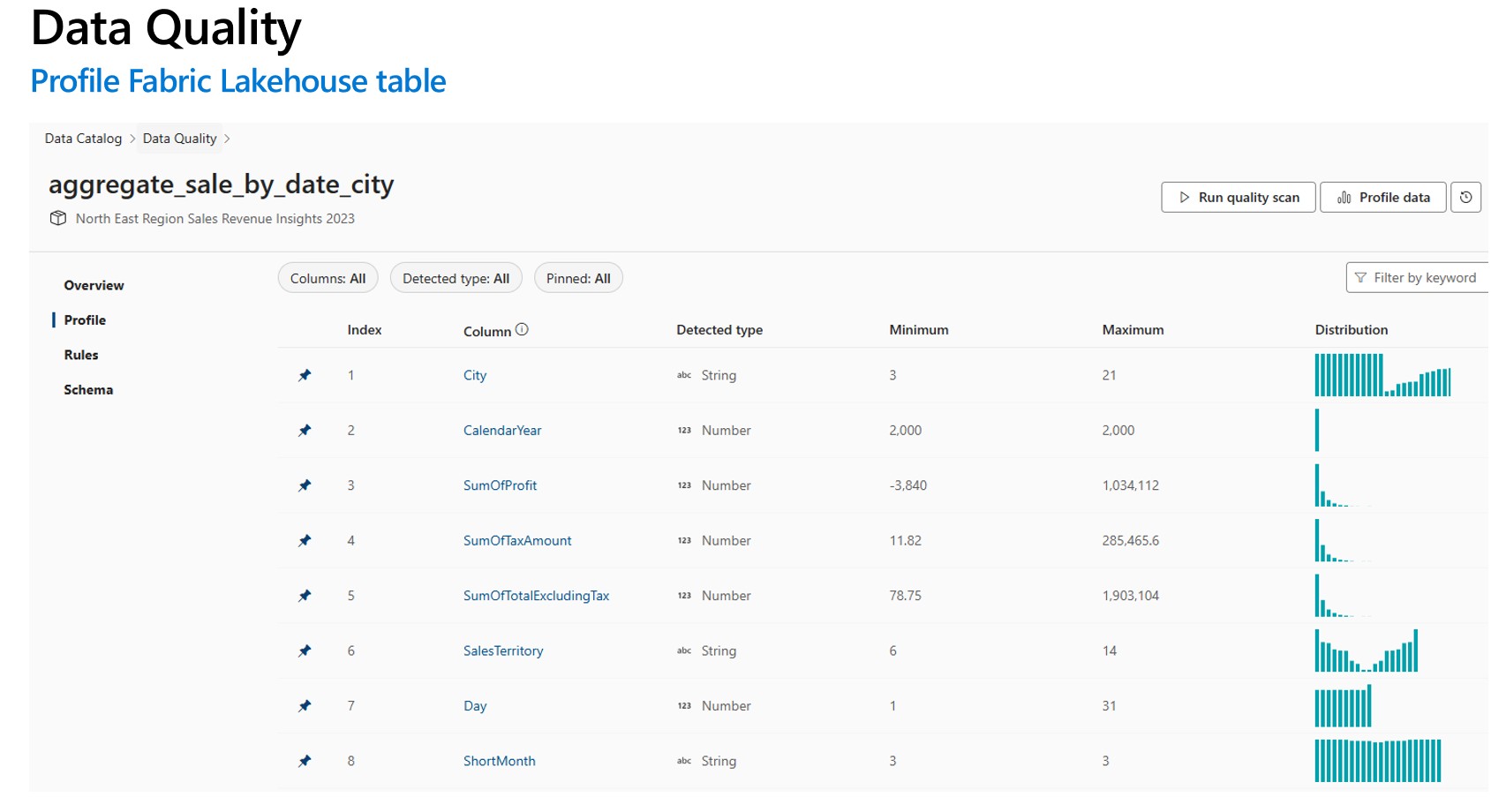

- Profiler la table Lakehouse fabric. Découvrez comment configurer et exécuter le profilage des données pour une ressource de données.

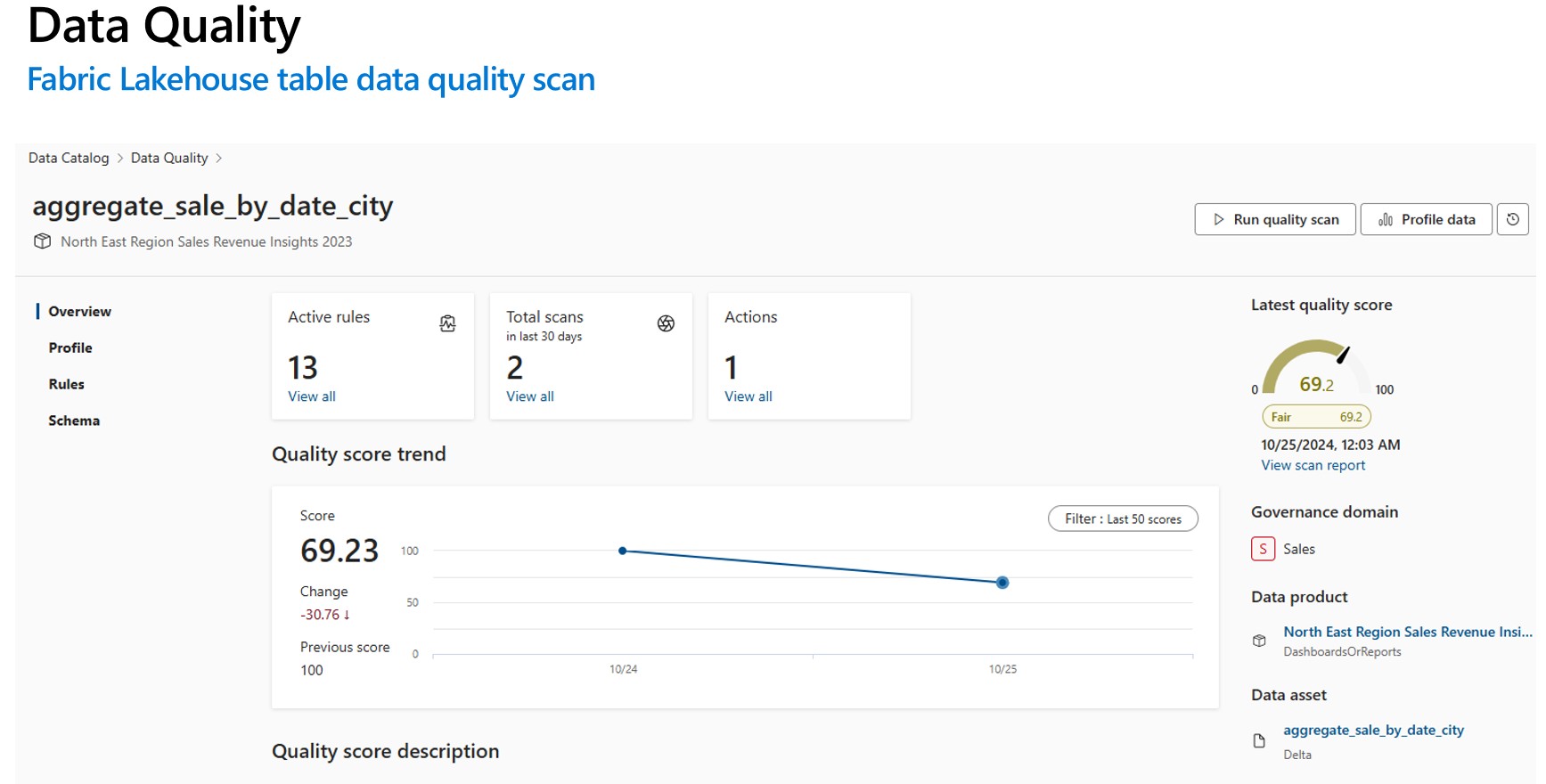

- Configurez et exécutez l’analyse de la qualité des données pour mesurer la qualité des données d’une table Fabric Lakehouse. Découvrez comment configurer et exécuter une analyse de la qualité des données.

Importante

- Assurez-vous que vos données sont au format Delta ou Iceberg.

- Assurez-vous que l’analyse data map s’est exécutée correctement. Si ce n’est pas le cas, réexécutez l’analyse.

Limitations

La qualité des données pour le fichier Parquet est conçue pour prendre en charge les points suivants :

- Répertoire avec fichier de composant Parquet. Par exemple : ./Sales/{Parquet Part Files}. Le nom complet doit suivre

https://(storage account).dfs.core.windows.net/(container)/path/path2/{SparkPartitions}. Assurez-vous qu’il n’existe aucun modèle {n} dans la structure des répertoires/sous-répertoires ; il doit plutôt s’agir d’un nom de domaine complet direct menant à {SparkPartitions}. - Répertoire avec des fichiers Parquet partitionnés, partitionnés par colonnes dans le jeu de données, comme les données de ventes partitionnée par année et par mois. Par exemple : ./Sales/{Year=2018}/{Month=Dec}/{Parquet Part Files}.

Ces deux scénarios essentiels qui présentent un schéma de jeu de données Parquet cohérent sont pris en charge. Limitation : il n’est pas conçu pour ou ne prend pas en charge N hiérarchies arbitraires de répertoires avec des fichiers Parquet. Nous conseillons au client de présenter des données dans (1) ou (2) structure construite. Il est donc recommandé au client de suivre la norme Parquet prise en charge ou de migrer ses données vers le format delta conforme ACID .

Conseil

Pour Data Map

- Vérifiez que le SPN dispose des autorisations d’espace de travail.

- Vérifiez que la connexion d’analyse utilise le SPN.

- L’exécution d’une analyse complète est suggérée si vous configurez une analyse Lakehouse pour la première fois.

- Vérifier que les ressources ingérées ont été mises à jour/actualisées

Catalogue unifié

- La connexion DQ doit utiliser des informations d’identification MSI.

- Dans l’idéal, créez un produit de données pour le premier test de l’analyse DQ des données Lakehouse

- Ajoutez les ressources de données ingérées, case activée que les ressources de données sont mises à jour.

- Essayez d’exécuter le profil d’exécution, en cas de réussite, essayez d’exécuter la règle DQ. En cas d’erreur, essayez d’actualiser le schéma de ressource (schéma> d’importation de gestion des schémas)

- Certains utilisateurs devaient également créer un lakehouse et échantillonner des données pour case activée tout fonctionne à partir de zéro. Dans certains cas, l’utilisation de ressources qui ont été ingérées précédemment dans data map n’est pas cohérente.

Ressources

- Configurer et exécuter le profilage des données de vos données

- Configurer et exécuter l’analyse de la qualité des données

- FAQ et aide autonome

- Configurer la connexion qualité des données

- En savoir plus sur la mise en miroir dans Fabric

- Raccourcis OneLake

- Qualité des données pour les sources de données mises en miroir fabric

- La qualité des données pour OneLake raccourcit les sources de données