Parcours d’intégration de Microsoft Fabric pour les ISV

Microsoft Fabric offre trois parcours distincts pour que les fournisseurs de logiciels indépendants (ISV) s’intègrent de façon fluide à Fabric. Pour un ISV qui entreprend ce parcours, nous voulons présenter différentes ressources qui sont disponibles sous chacune de ces voies.

Interop avec Fabric OneLake

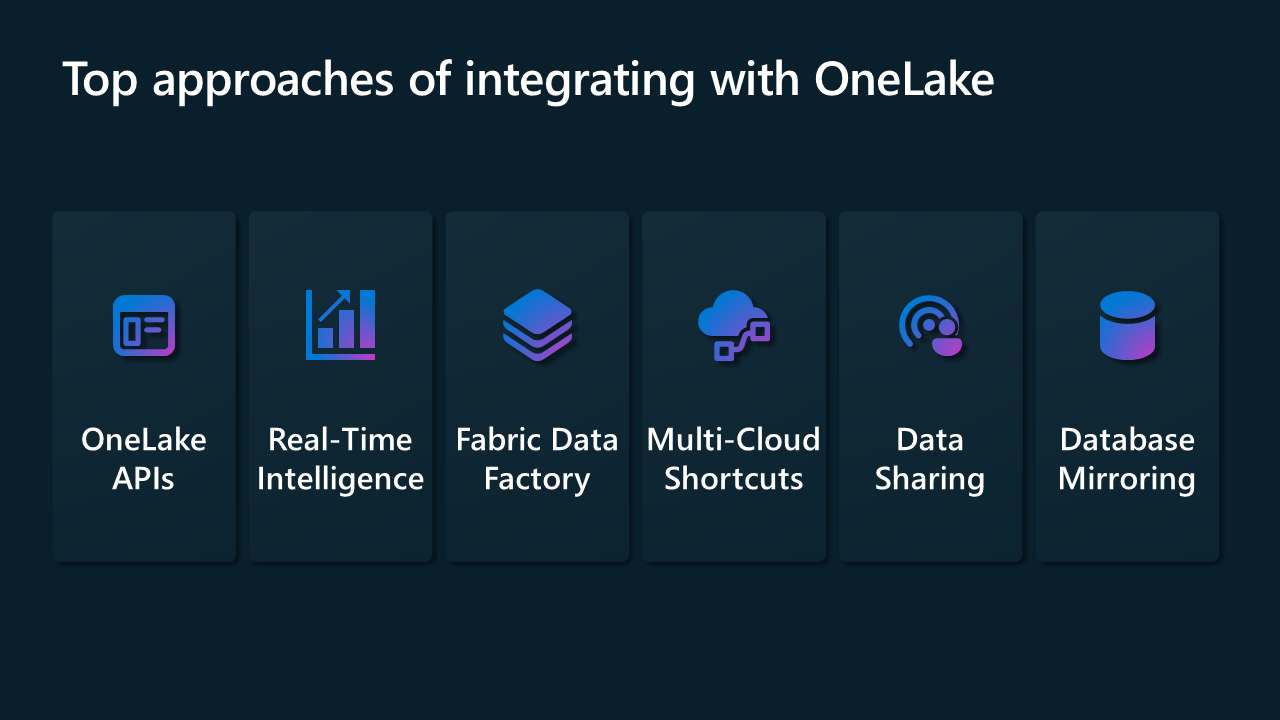

L’intérêt majeur du modèle d’interopérabilité est qu’il permet aux ISV d’intégrer leurs solutions à OneLake Foundation. Pour interopérer avec Microsoft Fabric, nous fournissons une intégration à l’aide d’une multitude de connecteurs dans Data Factory et dans Real-Time Intelligence, d’API REST pour OneLake, de raccourcis dans OneLake, de partage de données entre les locataires Fabric et de mise en miroir de base de données.

Les sections suivantes décrivent quelques-unes des façons dont vous pouvez commencer à utiliser ce modèle.

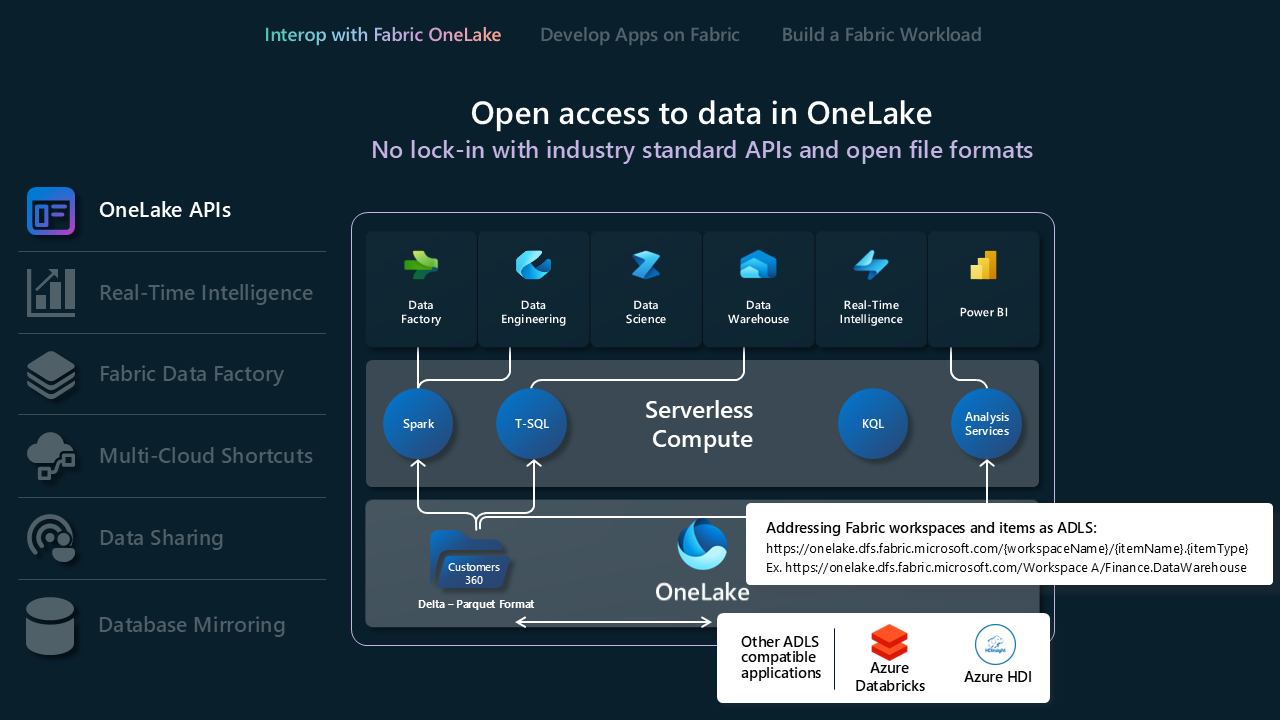

API OneLake

- OneLake prend en charge les API et SDK Azure Data Lake Storage (ADLS) Gen2 existants pour une interaction directe, ce qui permet aux développeurs de lire, d’écrire et de gérer leurs données dans OneLake. Découvrez-en plus sur les API REST ADLS Gen2 et la procédure de connexion à OneLake.

- Étant donné que toutes les fonctionnalités d’ADLS Gen2 ne sont pas directement mappées dans OneLake, OneLake applique également une structure de dossiers définie pour prendre en charge les espaces de travail et les éléments Fabric. Pour obtenir la liste complète des différents comportements entre OneLake et ADLS Gen2 lors de l’appel de ces API, consultez Parité des API OneLake.

- Si vous utilisez Databricks et que vous voulez vous connecter à Microsoft Fabric, Databricks fonctionne avec les API ADLS Gen2. Intégrer OneLake à Azure Databricks.

- Pour tirer pleinement parti de ce que le format de stockage Delta Lake peut faire pour vous, examinez et comprenez le format, l’optimisation des tables et V-Order. Optimisation des tables Delta Lake et V-Order.

- Une fois que les données se trouvent dans OneLake, explorez-les localement à l’aide de l’explorateur de fichiers OneLake. L’Explorateur de fichiers OneLake intègre en toute transparence OneLake à l’Explorateur de fichiers Windows. Cette application synchronise automatiquement tous les éléments OneLake auxquels vous avez accès dans Windows Explorateur de fichiers. Vous pouvez également utiliser un autre outil compatible avec ADLS Gen2, comme l’Explorateur Stockage Azure.

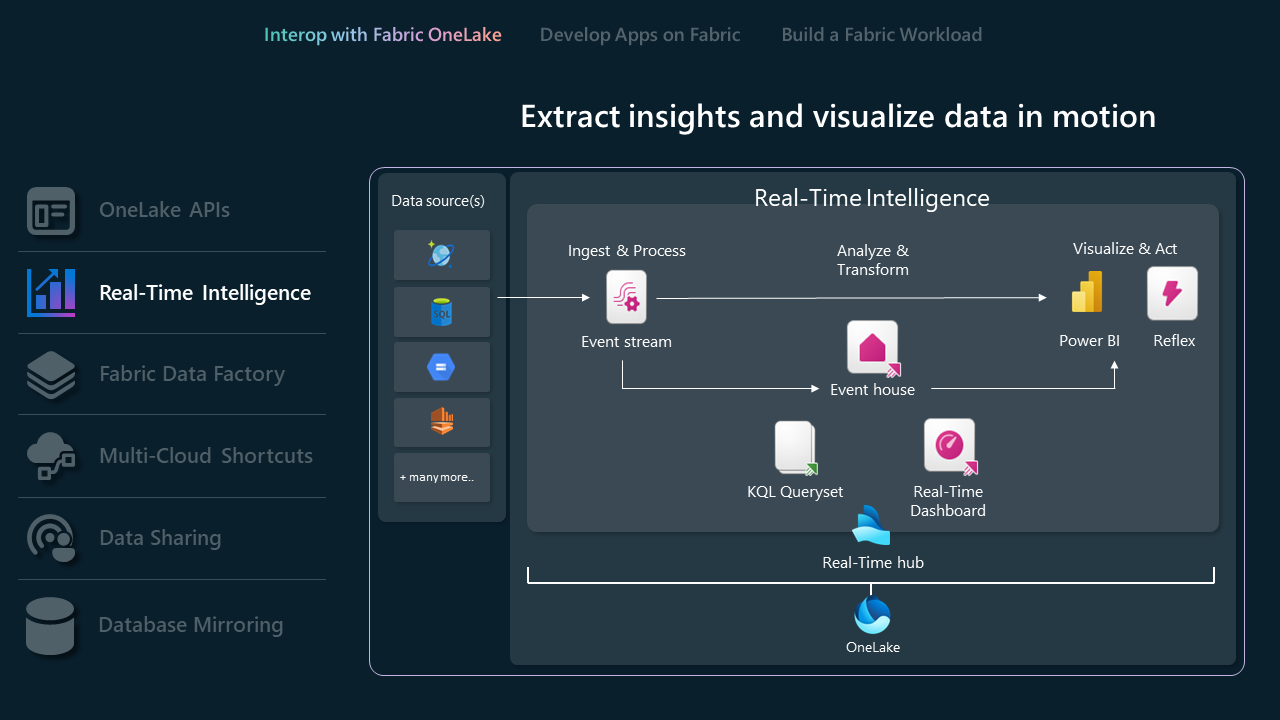

API d’informations en temps réel

Les informations en temps réel simplifient l’analyse et la visualisation des données, offrant une solution centralisée pour obtenir des insights et des actions immédiats sur les données en mouvement au sein d’une organisation. Elles gèrent efficacement de grands volumes de données grâce à des capacités de requête, de transformation et de stockage robustes.

- Les eventhouses sont spécifiquement conçus pour la diffusion en continu de données, compatibles avec le hub Real-Time et idéales pour les événements basés sur le temps. Les données sont automatiquement indexées et partitionnées en fonction du temps d’ingestion, vous offrant ainsi des capacités d’interrogation analytique incroyablement rapides et complexes sur des données de haute granularité auxquelles il est possible d'accéder dans OneLake pour les utiliser à travers la suite d’expériences de Fabric.. Eventhouses prend en charge les API et SDK Eventhouse existants pour une interaction directe, ce qui permet aux développeurs de lire, écrire et gérer leurs données dans Eventhouses. Apprenez-en davantage sur l’API REST.

- Les flux d’événements vous permettent d’apporter des événements en temps réel à partir de différentes sources et de les router vers différentes destinations, telles que OneLake, les bases de données KQL dans les eventhouses et Fabric Activator. En savoir plus sur les flux d’événements et l’API des flux d’événements.

- Si vous utilisez Databricks ou Jupyter Notebooks, vous pouvez utiliser la bibliothèque de client Kusto Python pour utiliser les bases de données KQL dans Fabric. En savoir plus sur le Kit de développement logiciel (SDK) Python Kusto.

- Vous pouvez utiliser les connecteurs Microsoft Logic Apps, Azure Data Factory ou Microsoft Power Automate existants pour interagir avec Eventhouses ou vos bases de données KQL.

- Les raccourcis de base de données dans Real-Time Intelligence sont des références intégrées dans un eventhouse à une base de données source. La base de données source peut être une base de données KQL dans Real-Time Intelligence ou une base de données Azure Data Explorer. Les raccourcis peuvent être utilisés pour le partage de données au sein d’un même client ou d’un client à l’autre. En savoir plus sur la gestion des raccourcis de base de données à l’aide de l’API.

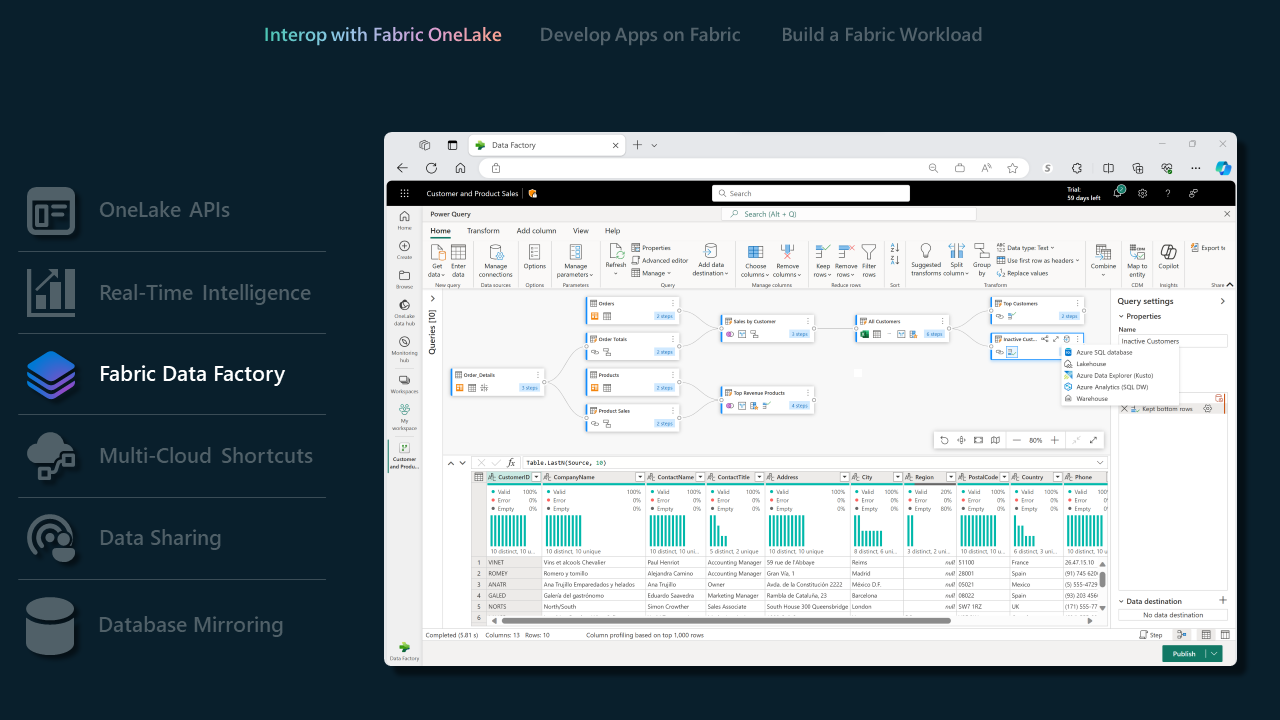

Data Factory dans Fabric

- Les pipelines de données offrent un ensemble complet de connecteurs, permettant aux ISV se connecter sans effort à une multitude de magasins de données. Que vous vous connectiez à des bases de données traditionnelles ou à des solutions cloud modernes, nos connecteurs garantissent un processus d’intégration fluide. Vue d’ensemble des connecteurs.

- Avec nos connecteurs Dataflow Gen2 pris en charge, les ISV peuvent maîtriser la puissance de Fabric Data Factory pour gérer des workflows de données complexes. Cette fonctionnalité est particulièrement utile pour les ISV qui cherchent à simplifier les tâches de traitement et de transformation des données. Connecteurs Dataflow Gen2 dans Microsoft Fabric.

- Pour obtenir la liste complète des fonctionnalités prises en charge par Data Factory dans Fabric, consultez ce blog Data Factory dans Fabric.

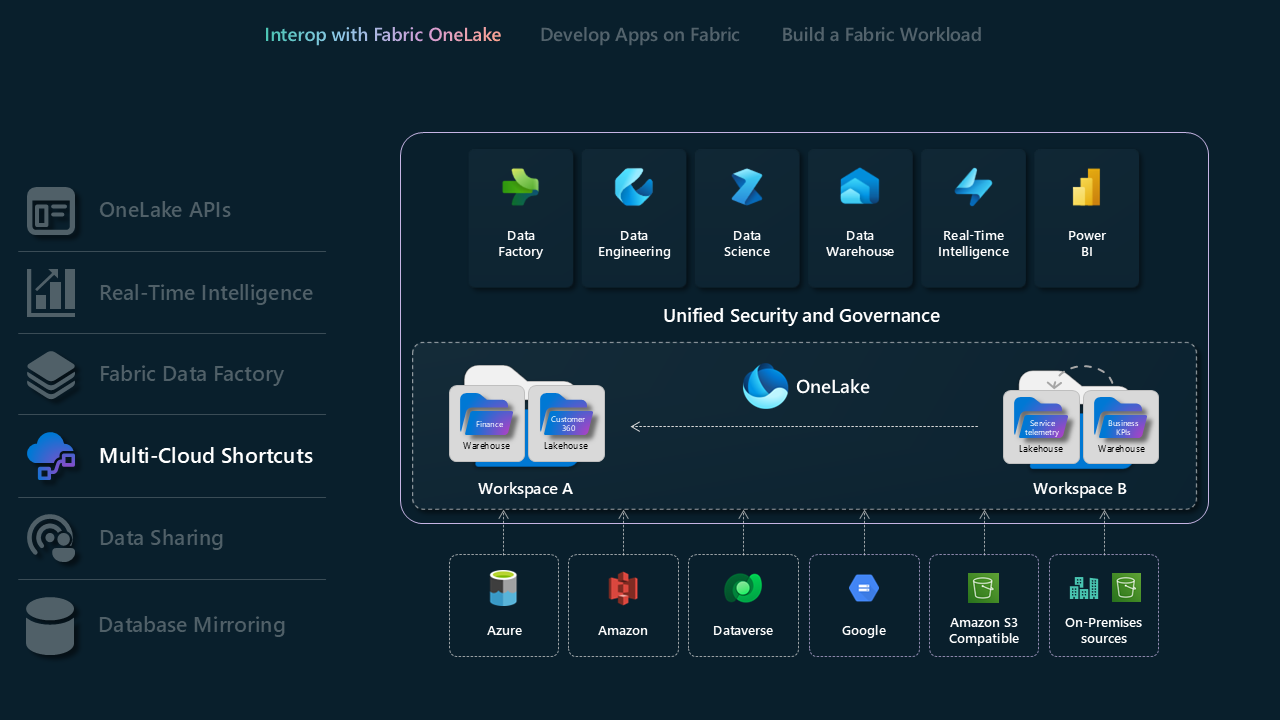

Raccourcis multiclouds

Les raccourcis dans Microsoft OneLake vous permettent d’unifier vos données entre des domaines, des clouds et des comptes en créant un seul lac de données virtuel pour l’ensemble de votre entreprise. L’ensemble des expériences et des moteurs analytiques Fabric peuvent pointer directement vers vos source de données existantes comme OneLake dans un autre locataire, Azure Data Lake Storage (ADLS) Gen2, des comptes de stockage Amazon S3, Google Cloud Storage (GCS), Sources de données compatibles S3 et Dataverse par le biais d’un espace de noms unifié. OneLake présente aux ISV une solution d’accès aux données de transformation, créant de façon fluide un pont pour l’intégration entre différents domaines et plateformes cloud.

- En savoir plus sur les raccourcis OneLake

- En savoir plus sur OneLake one logical copy

- En savoir plus sur les raccourcis de base de données KQL

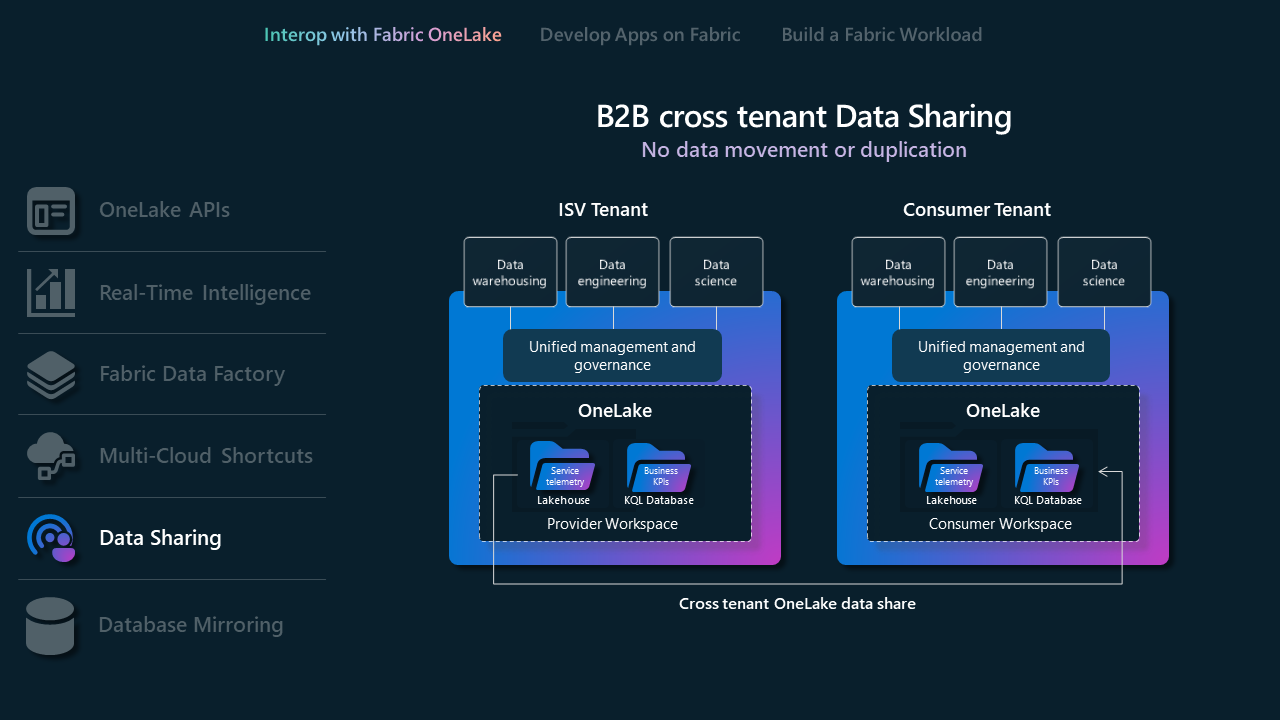

Partage des données

Le partage de données permet aux utilisateurs de Fabric de partager des données entre différents locataires Fabric sans la dupliquer. Cette fonctionnalité améliore la collaboration en permettant aux données d’être partagées « sur place » à partir des emplacements de stockage OneLake. Les données sont partagées en lecture seule, accessibles via divers moteurs de calcul Fabric, y compris SQL, Spark, KQL et modèles sémantiques. Pour utiliser cette fonctionnalité, les administrateurs Fabric doivent l’activer à la fois dans le partage et la réception des locataires. Le processus inclut la sélection de données dans le hub de données OneLake ou l’espace de travail, la configuration des paramètres de partage et l’envoi d’une invitation au destinataire prévu.

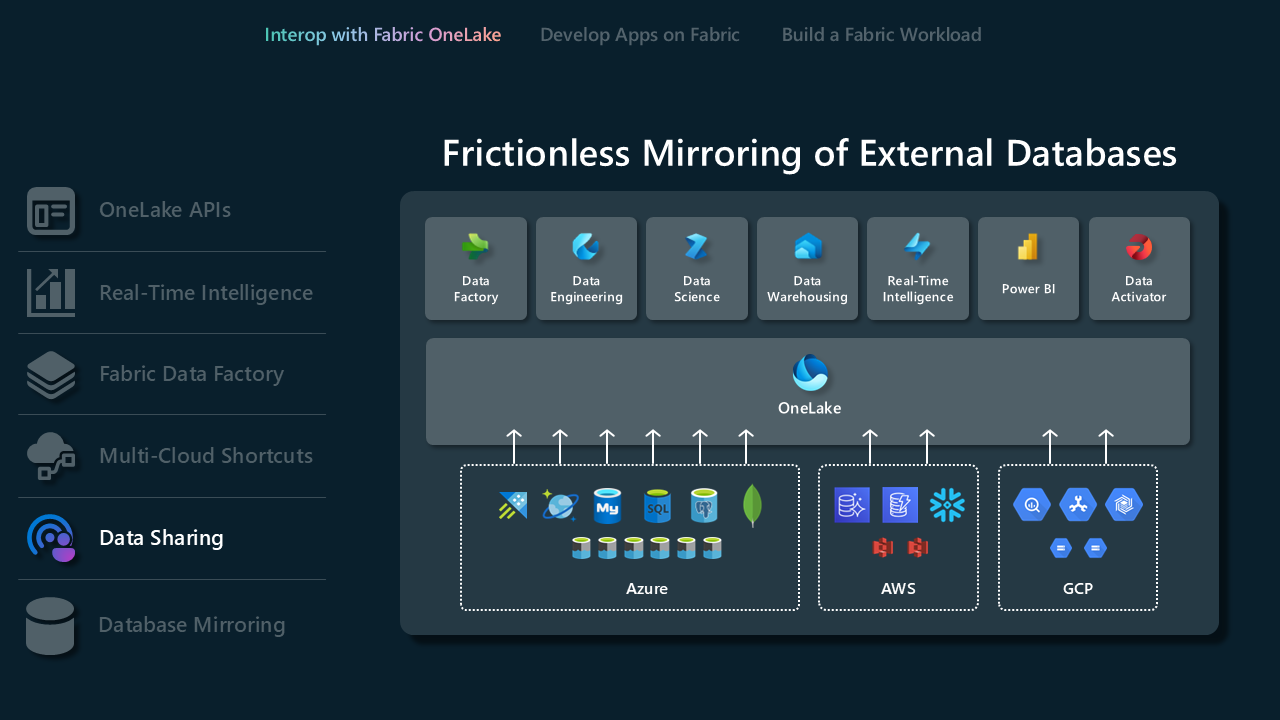

Mise en miroir de bases de données

La mise en miroir fournit un moyen moderne d’accéder à des données et de les ingérer en permanence et de manière fluide à partir de bases de données externes ou d’un entrepôt de données dans l’expérience d’entrepôt de données dans Microsoft Fabric. Une mise en miroir est totalement en quasi-temps réel, ce qui donne aux utilisateurs un accès immédiat aux changements dans la source. En savoir plus sur la mise en miroir et les bases de données prises en charge.

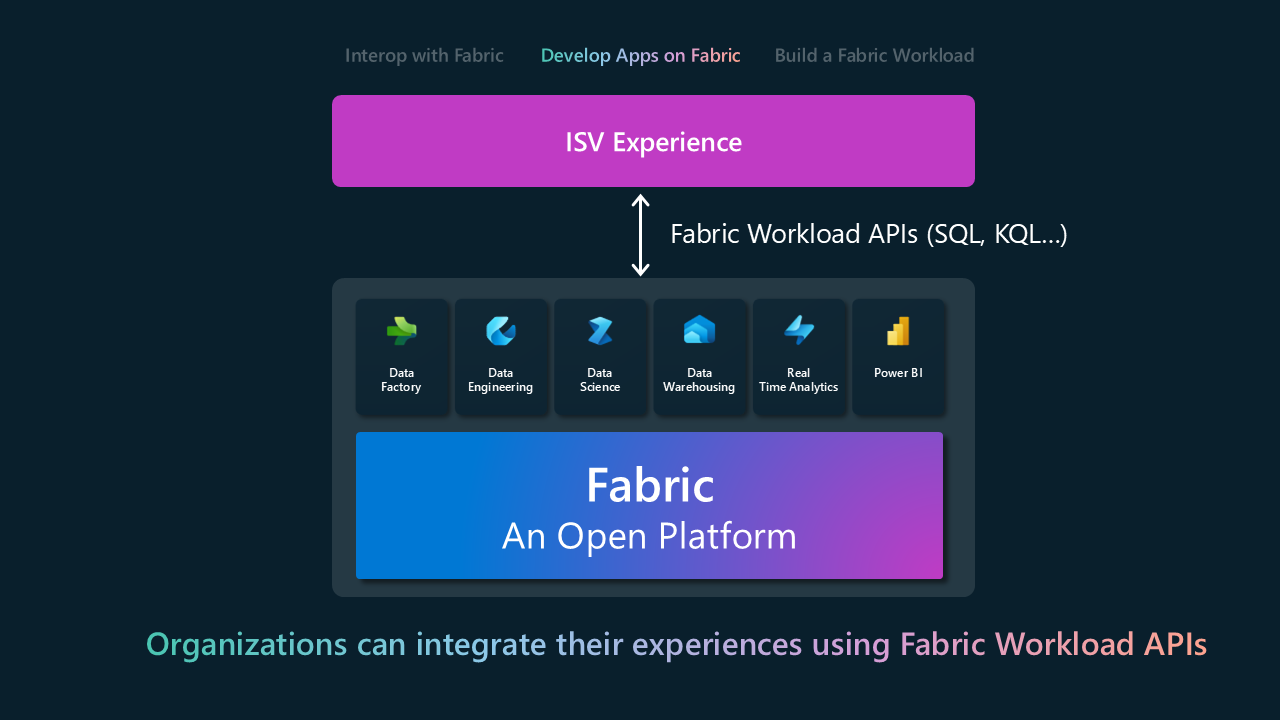

Développer sur Fabric

Avec le modèle Développer sur Fabric, les ISV peuvent générer leurs produits et services en s’appuyant sur Fabric ou incorporer de manière fluide les fonctionnalités de Fabric dans leurs applications existantes. Il s’agit d’une transition de l’intégration de base vers l’application active des fonctionnalités proposées par Fabric. La principale surface d’exposition de l’intégration s’effectue par le biais d’API REST pour différentes expériences Fabric. Le tableau suivant contient un sous-ensemble d’API REST regroupées par l’expérience Fabric. Pour obtenir une liste complète, consultez la documentation de l’API REST de Fabric.

| Expérience Fabric | API |

|---|---|

| entrepôt de données | - Entrepôt - Entrepôt mis en miroir |

| Engineering données | - Lakehouse - Spark - Définition de la tâche Spark - Tables - Tâches |

| Data Factory | - DataPipeline |

| Real-Time Intelligence | - Eventhouse - Base de données KQL - Ensemble de requêtes KQL - Flux d’événements |

| Science des données | - Notebook - Expérience ML - Modèle ML |

| OneLake | - Raccourci - API ADLS Gen2 |

| Power BI | - Report - Tableau de bord - Modèle sémantique |

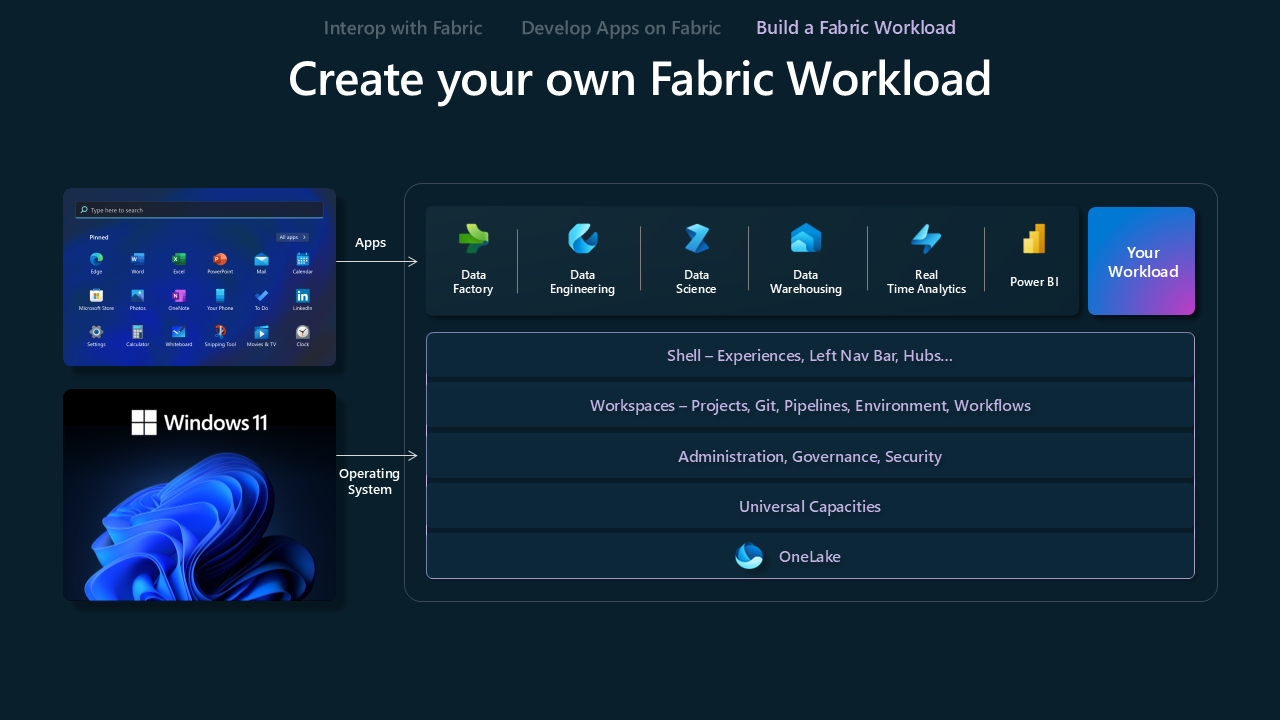

Créer une charge de travail Fabric

Créer un modèle de charge de travail Fabric est conçu pour permettre aux fournisseurs de logiciels indépendants (ISV) de créer des expériences personnalisées sur la plateforme Fabric. Il fournit aux éditeurs de logiciels indépendants les outils et fonctionnalités nécessaires pour aligner leurs offres avec l’écosystème Fabric, en optimisant la combinaison de leurs propositions de valeur unique avec les fonctionnalités étendues de Fabric.

Le Kit de développement de charge de travail Microsoft Fabric offre un kit de ressources complet aux développeurs pour intégrer des applications dans le hub Microsoft Fabric. Cette intégration permet l’ajout de nouvelles fonctionnalités directement dans l’espace de travail Fabric, ce qui améliore le parcours d’analytique pour les utilisateurs. Il fournit aux développeurs et aux éditeurs de logiciels indépendants une nouvelle avenue pour atteindre les clients, fournir des expériences familières et nouvelles, et tirer parti des applications de données existantes. Les administrateurs de Fabric peuvent gérer l’accès au hub de charge de travail, l’activer pour l’ensemble du locataire ou l’affecter avec une étendue spécifique pour contrôler l’accès au sein de l’organisation.