Configuración del proyecto de IA para usar la inferencia del modelo de Azure AI

Si ya tiene un proyecto de IA en Fundición de IA de Azure, el catálogo de modelos implementa modelos de proveedores de modelos externos como puntos de conexión independientes en su proyecto de manera predeterminada. Cada implementación de modelo tiene su propio conjunto de URI y credenciales para acceder a él. Por otro lado, los modelos de Azure OpenAI se implementan en el recurso de Servicios de Azure AI o en el recurso de Azure OpenAI Service.

Puede cambiar este comportamiento e implementar ambos tipos de modelos en los recursos de los Servicios de Azure AI utilizando la inferencia de modelos de Azure AI. Una vez se configuran, las implementaciones de modelos como servicio que admiten la facturación de pago por uso se realizan en el recurso conectado de Servicios de Azure AI en lugar de en el propio proyecto, lo que le proporciona un único conjunto de punto final y credencial para acceder a todos los modelos implementados en la Fundición de IA de Azure. Puede administrar los modelos de Azure OpenAI y de proveedores de modelos de terceros de la misma manera.

Además, la implementación de modelos en la inferencia del modelo de Azure AI aporta las ventajas adicionales de:

- Funcionalidad de enrutamiento.

- Filtros de contenido personalizado.

- Tipo de implementación de capacidad global.

- Autenticación sin claves con control de acceso basado en rol.

En este artículo, aprenderá a configurar el proyecto de IA para usar modelos implementados en la inferencia del modelo de Azure AI en la Fundición de IA de Azure.

Requisitos previos

Para completar este tutorial, necesita:

Suscripción a Azure. Si usa Modelos de GitHub, puede actualizar la experiencia y crear una suscripción de Azure en el proceso. Lea Actualización de modelos de GitHub a la inferencia del modelo de Azure AI si es su caso.

Recurso de Servicios de Azure AI. Para más información, vea Creación de un recurso de Servicios de Azure AI.

Un proyecto de Azure AI y Azure AI Hub.

Sugerencia

Cuando se aprovisiona el Centro de IA, se crea un recurso de los servicios de Azure AI con él y los dos recursos conectados. Para ver qué recurso de los servicios de Azure AI está conectado al proyecto, vaya al Portal de la Fundición de IA de Azure>Centro de gestión>Recursos conectados y busque las conexiones de tipo Servicios de IA.

Configuración del proyecto para usar la inferencia del modelo de Azure AI

Para configurar el proyecto para que use la funcionalidad de la inferencia del modelo de Azure AI en los servicios de Azure AI, siga estos pasos:

Visite el portal de Azure AI Foundry.

En la barra de navegación superior, en la esquina derecha, seleccione el icono Características de vista previa. Aparece una hoja contextual a la derecha de la pantalla.

Active la característica Implementación de modelos en el servicio de la inferencia del modelo de Azure AI.

Cierre el panel.

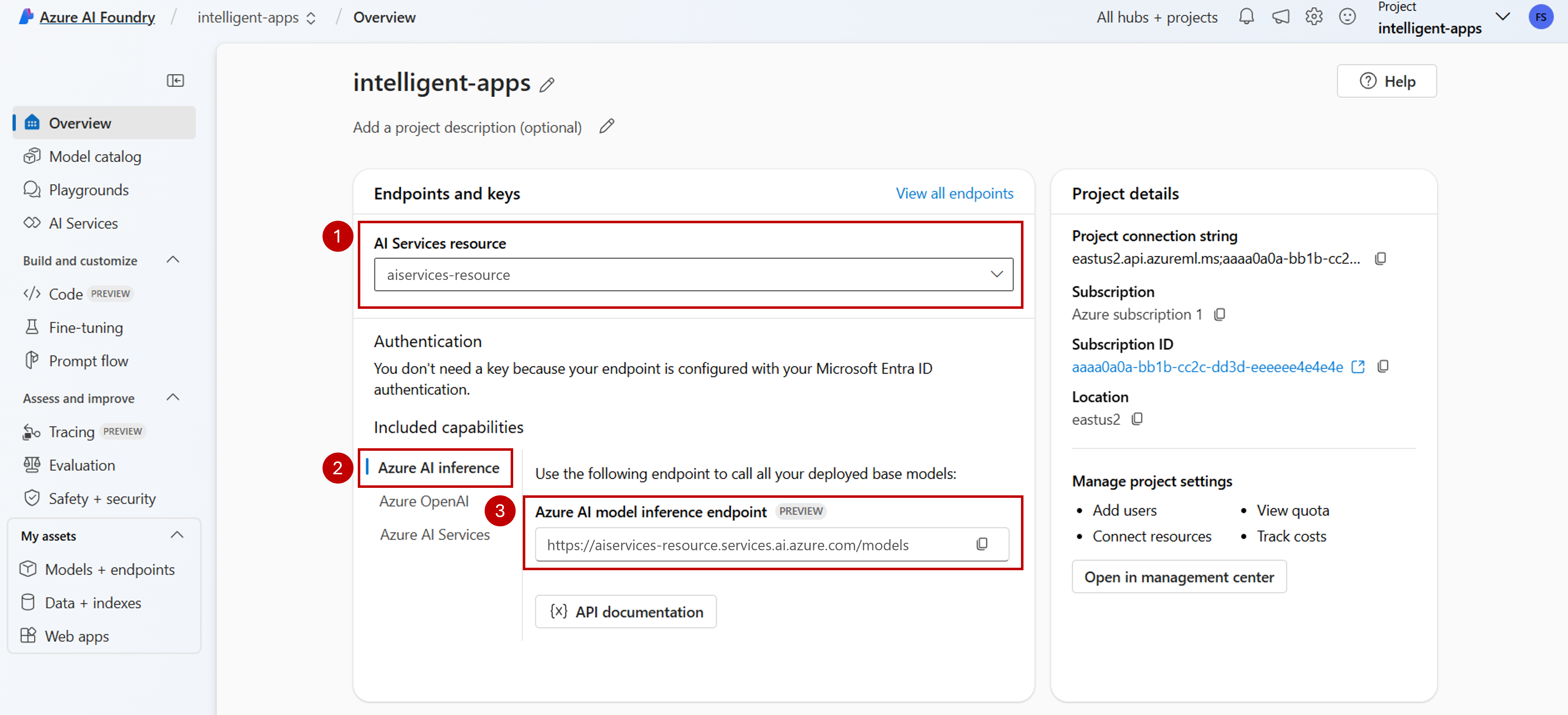

En la página de aterrizaje del proyecto, identifique el recurso de los servicios de Azure AI conectado al proyecto. Use la lista desplegable para cambiar el recurso que está conectado si es necesario.

Si no aparece ningún recurso en la lista desplegable, el Centro de IA no tiene un recurso de los servicios de Azure AI conectado a él. Cree una conexión mediante:

En la esquina inferior izquierda de la pantalla, seleccione Centro de gestión.

En la sección Conexiones seleccione Nueva conexión.

Seleccione Servicios de Azure AI.

En el explorador, busque un recurso de Servicios de Azure AI existente en la suscripción.

Seleccione Agregar conexión.

La nueva conexión se agrega al centro.

Vuelva a la página de aterrizaje del proyecto para continuar y seleccione la nueva conexión creada. Actualice la página si no aparece inmediatamente.

En Funcionalidades incluidas, asegúrese de seleccionar Inferencia de Azure AI. El URI del punto de conexión de la inferencia del modelo de Azure AI se muestra junto con las credenciales para obtener acceso a él.

Sugerencia

Cada recurso de los servicios de Azure AI tiene un único punto de conexión de la inferencia del modelo de Azure AI que se puede usar para acceder a cualquier implementación de modelos en él. El mismo punto de conexión sirve varios modelos en función de cuáles estén configurados. Obtenga información sobre cómo funciona el punto de conexión.

Tome nota de la URL del punto de conexión y de las credenciales.

Creación de la implementación de modelo en la inferencia del modelo de Azure AI

Para cada modelo que quiera implementar en la inferencia del modelo de Azure AI, siga estos pasos:

Vaya a la sección Catálogo de modelo del Portal de la Fundición de IA de Azure.

Desplácese hasta el modelo que le interese y selecciónelo.

Puede revisar los detalles del modelo en la tarjeta del modelo.

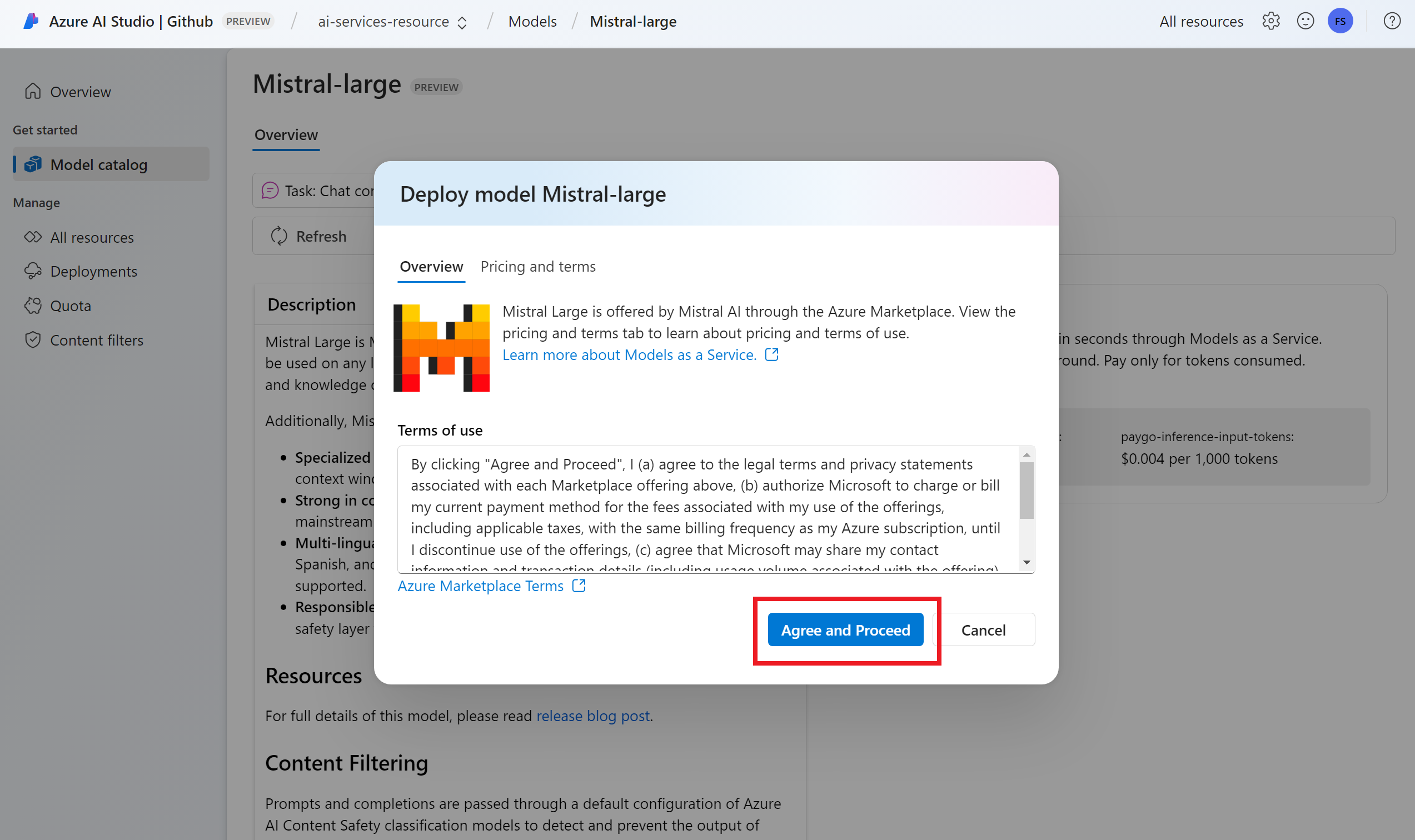

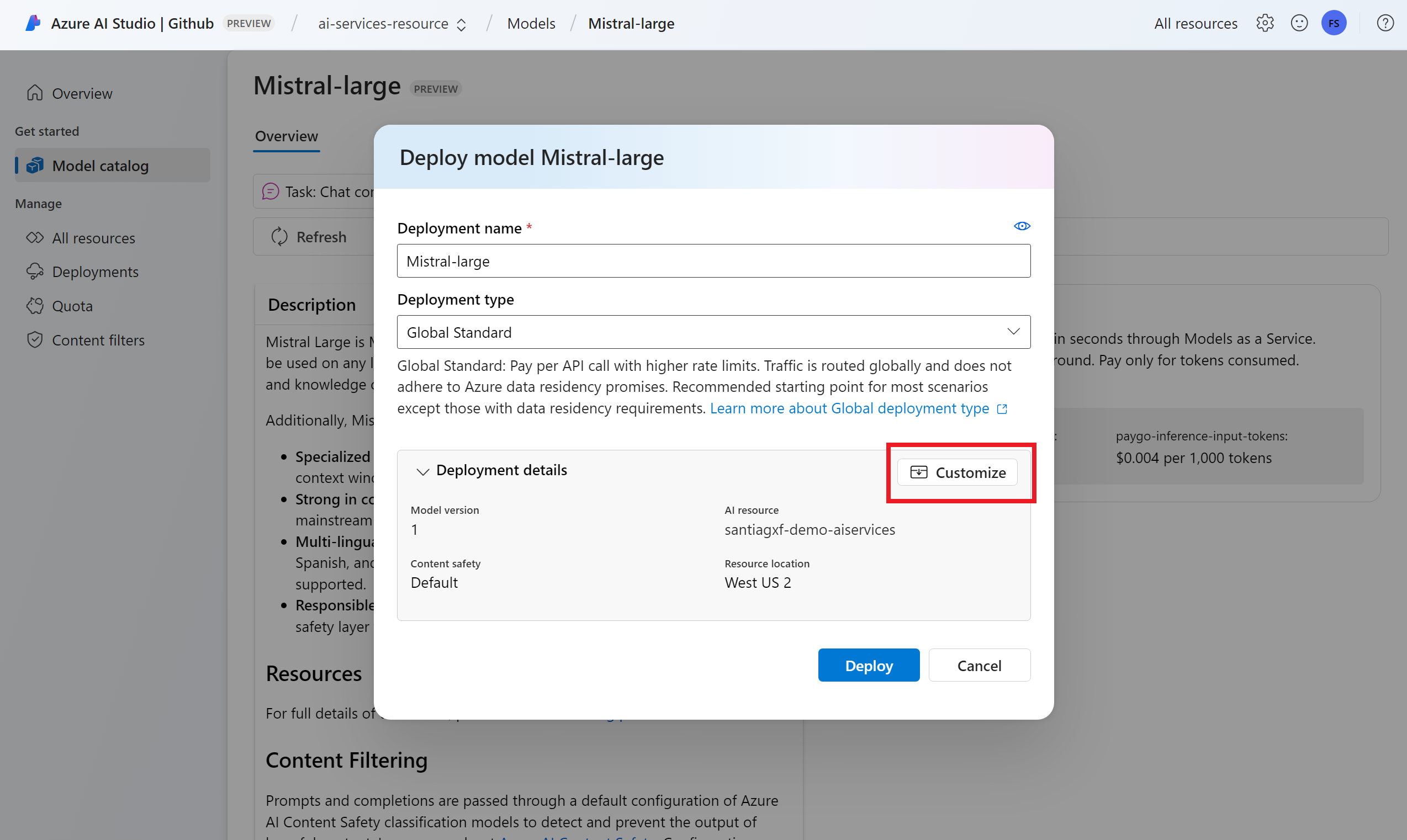

Seleccione Implementar.

En el caso de los proveedores de modelos que requieren más términos de contrato, se le pedirá que acepte esos términos. Para aceptar los términos de esos casos, seleccione Suscribir e implementar.

Puede configurar las opciones de implementación en este momento. De manera predeterminada, la implementación recibe el nombre del modelo que va a implementar. El nombre de la implementación se usa en el parámetro

modelpara solicitar que se enrute a esta implementación de modelo determinada. También le permite configurar nombres específicos para los modelos al adjuntar configuraciones específicas. Por ejemplo,o1-preview-safepara un modelo con un filtro de contenido de seguridad de contenido estricto.Seleccionamos automáticamente una conexión de Servicios de Azure AI en función del proyecto porque ha activado la característica Implementación de modelos en el servicio de la inferencia del modelo de Azure AI. Use la opción Personalizar para cambiar la conexión en función de sus necesidades. Si va a implementar en el tipo de implementación Estándar, los modelos deben estar disponibles en la región del recurso de los servicios de Azure AI.

Seleccione Implementar.

Una vez finalizada la implementación, verá la dirección URL del punto de conexión y las credenciales para obtener acceso al modelo. Tenga en cuenta que ahora la dirección URL y las credenciales proporcionadas son las mismas que se muestran en la página de aterrizaje del proyecto para el punto de conexión de la inferencia del modelo de Azure AI.

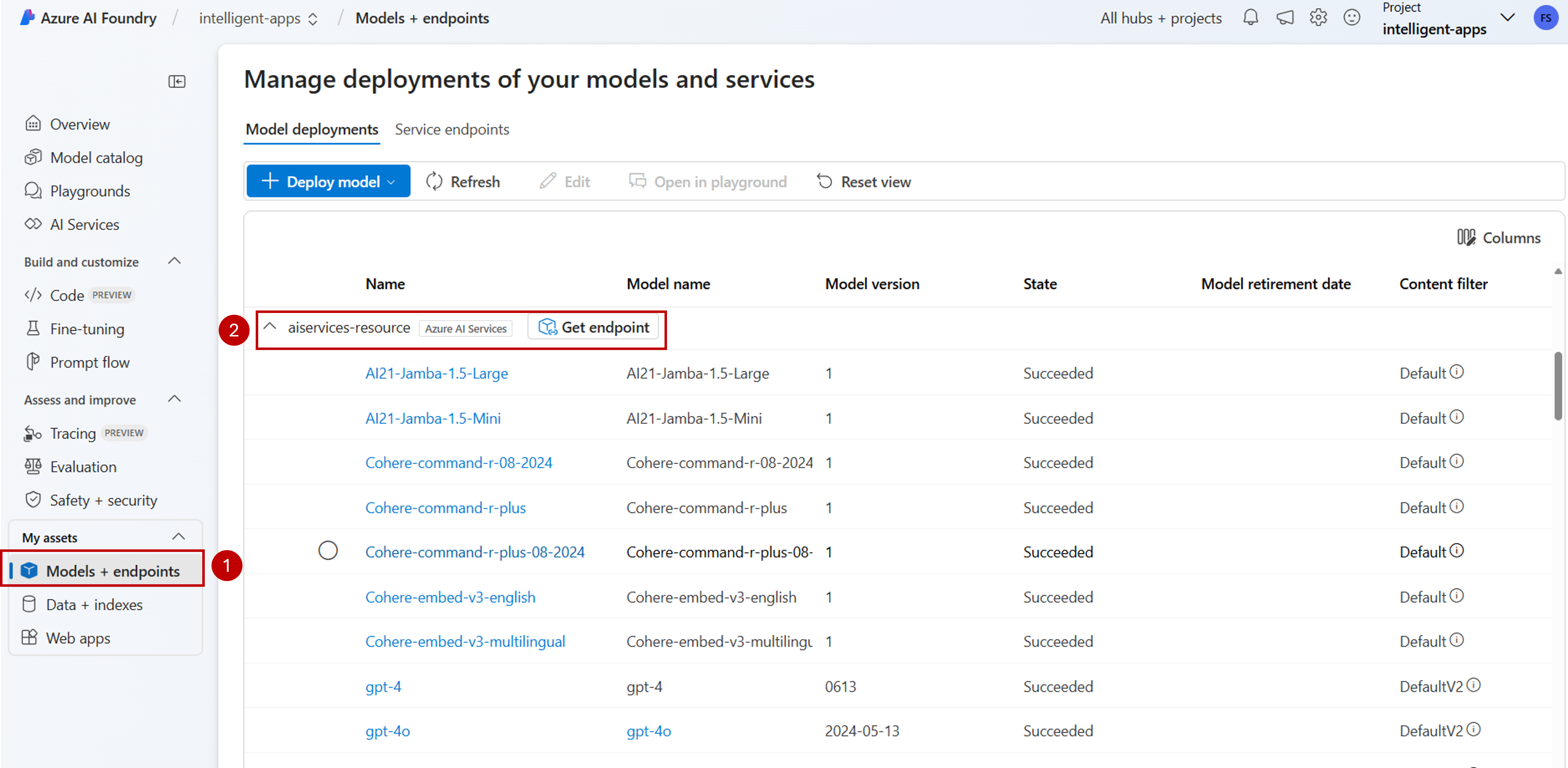

Puede ver todos los modelos disponibles en el recurso; para ello, vaya a la sección Modelos y puntos de conexión y busque el grupo para la conexión al recurso de los servicios de IA:

Actualización del código con el nuevo punto de conexión

Una vez que configure el recurso de Servicios de Azure AI, puede empezar a consumirlo desde el código. Necesita la dirección URL del punto de conexión y la clave, que se pueden encontrar en la sección Información general:

Puede usar cualquiera de los SDK admitidos para obtener predicciones desde el punto de conexión. Oficialmente se admiten los siguientes SDK:

- SDK de OpenAI

- SDK de Azure OpenAI

- SDK de inferencia de Azure AI

- SDK de Azure AI Foundry

Vea la sección Lenguajes y SDK admitidos para obtener más detalles y ejemplos. En el ejemplo siguiente se muestra cómo usar el SDK de inferencia del modelo de Azure AI con el modelo recién implementado:

Instale el paquete azure-ai-inference mediante el administrador de paquetes, como pip:

pip install azure-ai-inference>=1.0.0b5

Advertencia

El recurso de Servicios de Azure AI necesita la versión azure-ai-inference>=1.0.0b5 para Python.

A continuación, puede usar el paquete para consumir el modelo. En el ejemplo siguiente se muestra cómo crear un cliente para consumir finalizaciones de chat:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

model = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

Explore nuestros ejemplos y lea la documentación de referencia de API para empezar a trabajar.

Genere la primera finalización del chat:

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Use el parámetro model="<deployment-name> para enrutar la solicitud a esta implementación.

Las implementaciones funcionan como un alias de un modelo determinado en determinadas configuraciones. Vea la página de concepto Enrutamiento para obtener información sobre cómo se enrutan las implementaciones en Servicios de Azure AI.

Traslado de puntos de conexión de API sin servidor a la inferencia del modelo de Azure AI

Aunque configuró el proyecto para usar la inferencia del modelo de Azure AI, las implementaciones de modelos existentes siguen saliendo dentro del proyecto como puntos de conexión de API sin servidor. Esas implementaciones no se mueven por usted. Por lo tanto, puede actualizar progresivamente cualquier código existente que haga referencia a implementaciones de modelos anteriores. Para empezar a mover las implementaciones de modelo, se recomienda el siguiente flujo de trabajo:

Vuelva a crear la implementación de modelo en la inferencia del modelo de Azure AI. Esta implementación de modelo es accesible en el punto de conexión de la inferencia del modelo de Azure AI.

Actualice el código para usar el nuevo punto de conexión.

Limpie el proyecto quitando el punto de conexión de API sin servidor.

Actualización del código con el nuevo punto de conexión

Una vez implementados los modelos en los servicios de Azure AI, puede actualizar el código para usar el punto de conexión de la inferencia del modelo de Azure AI. La principal diferencia entre cómo funcionan los puntos de conexión de API sin servidor y la inferencia del modelo de Azure AI reside en la dirección URL del punto de conexión y el parámetro del modelo. Aunque los puntos de conexión de API sin servidor han establecido un URI y una clave por cada implementación de modelo, la inferencia del modelo de Azure AI solo tiene una para todos ellos.

En la siguiente tabla se resumen los cambios que debe introducir:

| Propiedad | Puntos de conexión de API sin servidor | Inferencia del modelo de Azure AI |

|---|---|---|

| Punto de conexión | https://<endpoint-name>.<region>.inference.ai.azure.com |

https://<ai-resource>.services.ai.azure.com/models |

| Credenciales | Uno por modelo o punto de conexión. | Uno por recurso de los servicios de Azure AI. También puede usar Microsoft Entra ID. |

| Parámetro del modelo | Ninguno. | Necesario. Use el nombre de la implementación de modelo. |

Limpieza de puntos de conexión de API sin servidor existentes desde el proyecto

Después de refactorizar el código, es posible que desee eliminar los puntos de conexión de API sin servidor existentes dentro del proyecto (si los hay).

Para cada modelo implementado como puntos de conexión de API sin servidor, siga estos pasos:

Visite el portal de Azure AI Foundry.

Seleccione Modelos y puntos de conexión.

Identifique los puntos de conexión de tipo Sin servidor y seleccione el que desea eliminar.

Seleccione la opción Eliminar.

Advertencia

Esta operación no se puede revertir. Asegúrese de que el punto de conexión no lo usa actualmente ningún otro usuario o fragmento de código.

Para confirmar la operación, seleccione Eliminar.

Si ha creado una conexión de API sin servidor a este punto de conexión desde otros proyectos, estas conexiones no se quitan y continúan apuntando al punto de conexión inexistente. Elimine cualquiera de esas conexiones para evitar errores.

Limitaciones

Tenga en cuenta las siguientes limitaciones al configurar el proyecto para usar la inferencia de modelos de Azure AI:

- Solo los modelos que admiten la facturación de pago por uso (Modelos como servicio) están disponibles para su implementación en la inferencia de modelos de Azure AI. Los modelos que requieren la cuota de proceso de la suscripción (proceso administrado), incluidos los modelos personalizados, solo se pueden implementar dentro de un proyecto determinado como puntos de conexión en línea administrados y seguir siendo accesibles mediante su propio conjunto de URI y credenciales de punto de conexión.

- Los modelos disponibles como ofertas de facturación de pago por uso y de proceso administrado están, de forma predeterminada, implementados en la inferencia de modelos de Azure AI en los recursos de los servicios de Azure AI. El portal de la Fundición de IA de Azure no ofrece una forma de implementarlos en puntos de conexión en línea administrados. Debe desactivar la característica mencionada en Configuración del proyecto para usar la inferencia de modelos de Azure AI o usar las plantillas de la CLI de Azure/SDK de Azure ML/ARM para realizar la implementación.

Pasos siguientes

- Agregar más modelos al punto de conexión.