Actualización de modelos de GitHub a la inferencia de modelos de Azure AI

Si quiere desarrollar una aplicación de IA generativa, puede usar Modelos de GitHub para buscar y experimentar con modelos de inteligencia artificial de forma gratuita. La utilización del área de juegos y el uso gratis de la API llevan una limitación de volumen que se aplica por solicitudes y minuto, solicitudes y día, tokens por solicitud y solicitudes simultáneas. Si obtiene una limitación de volumen, tendrá que esperar a alcanzarla antes de poder realizar más solicitudes.

Una vez que ya pueda llevar la aplicación a producción, puede actualizar la experiencia mediante la implementación de un recurso de Servicios de Azure AI en una suscripción de Azure y empezar a usar el servicio de inferencia del modelo de Azure AI. No es necesario cambiar nada en el código.

En el siguiente artículo se explica cómo empezar a trabajar desde Modelos de GitHub e implementar un recurso de Servicios de Azure AI con la inferencia del modelo de Azure AI.

Requisitos previos

Para completar este tutorial, necesita:

- Una cuenta de GitHub con acceso a Modelos de GitHub.

- Suscripción a Azure. Si no tiene una, se le pedirá que cree o actualice la cuenta de Azure a una cuenta de pago por uso cuando ya pueda implementar el modelo en producción.

Actualizar a la inferencia del modelo de Azure AI

Los límites de volumen para el área de juegos y la utilización gratis de la API están diseñados para ayudarle a experimentar con modelos y desarrollar la aplicación de IA. Cuando ya pueda llevar la aplicación a producción, use una clave y un punto de conexión de una cuenta de Azure de pago. No es necesario cambiar nada en el código.

Para obtener la clave y el punto de conexión:

Vaya a Modelos de GitHub y seleccione el modelo que le interesa.

En el área de juegos del modelo, seleccione Obtener clave de API.

Seleccione Obtener clave de producción.

Si no tiene una cuenta de Azure, seleccione Crear mi cuenta y siga los pasos para crear una.

Si tiene una cuenta de Azure, seleccione Iniciar sesión de nuevo.

Si la cuenta existente es una cuenta gratuita, primero debe actualizar a un plan de pago por uso. Una vez que realice la actualización, vuelva al área de juegos y seleccione Obtener clave de API de nuevo e inicie sesión con la cuenta actualizada.

Una vez que haya iniciado sesión en la cuenta de Azure, accederá a Estudio de IA de Azure > GitHub. Puede tardar uno o dos minutos en cargar los detalles iniciales del modelo en Estudio de IA.

La página se carga con los detalles del modelo. Seleccione el botón Implementar para implementar el modelo en su cuenta.

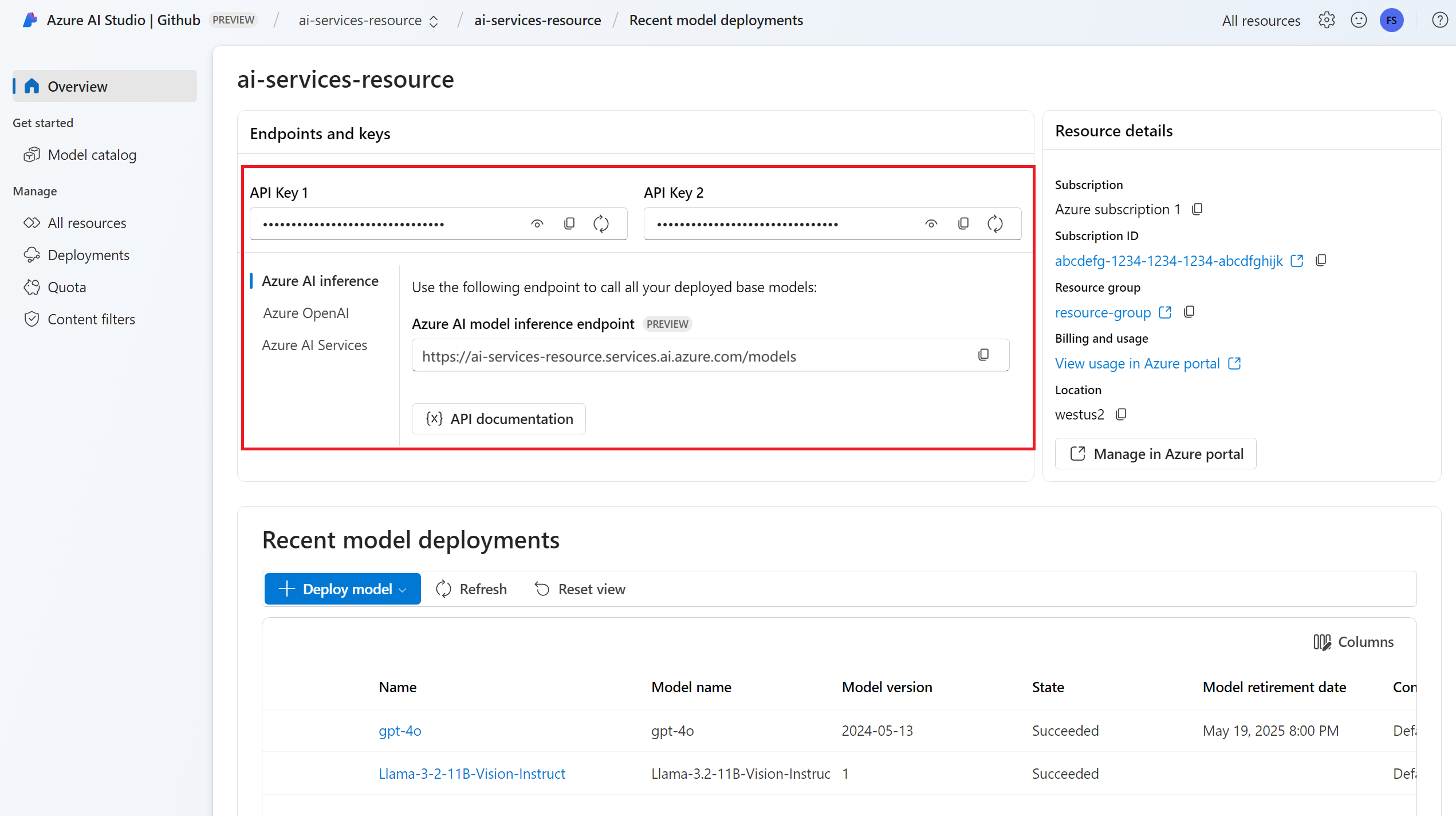

Una vez que se implemente, la clave de API y el punto de conexión del modelo se muestran en Información general. Use estos valores en el código para utilizar el modelo en el entorno de producción.

En este momento, el modelo seleccionado está listo para consumirse.

Actualización del código para usar el nuevo punto de conexión

Una vez que configure el recurso de Servicios de Azure AI, puede empezar a consumirlo desde el código. Para consumir el recurso de Servicios de Azure AI, necesita la dirección URL y la clave del punto de conexión, que están disponibles en la sección Información general:

Puede usar cualquiera de los SDK admitidos para obtener predicciones desde el punto de conexión. Oficialmente se admiten los siguientes SDK:

- SDK de OpenAI

- SDK de Azure OpenAI

- SDK de inferencia de Azure AI

Vea la sección Lenguajes y SDK admitidos para obtener más detalles y ejemplos. En el ejemplo siguiente se muestra cómo usar el SDK de inferencia del modelo de Azure AI con el modelo recién implementado:

Instale el paquete azure-ai-inference mediante el administrador de paquetes, como pip:

pip install azure-ai-inference

A continuación, puede usar el paquete para consumir el modelo. En el ejemplo siguiente se muestra cómo crear un cliente para consumir finalizaciones de chat:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

model = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

Explore nuestros ejemplos y lea la documentación de referencia de API para empezar a trabajar.

Genere la primera finalización del chat:

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Use el parámetro model="<deployment-name> para enrutar la solicitud a esta implementación.

Las implementaciones funcionan como un alias de un modelo determinado en determinadas configuraciones. Vea la página de concepto Enrutamiento para obtener información sobre cómo se enrutan las implementaciones en Servicios de Azure AI.

Importante

Al contrario de lo que sucede en Modelos de GitHub en los que ya están configurados todos los modelos, el recurso de Servicios de Azure AI permite controlar qué modelos están disponibles en el punto de conexión y en qué configuración. Agregue tantos modelos como planee usar antes de indicarlos en el parámetro model. Obtenga información sobre cómo agregar más modelos al recurso.

Explorar características adicionales

La inferencia del modelo de Azure AI admite más características que no están disponibles en Modelos de GitHub, entre las que se incluyen las siguientes:

- Explorar el catálogo de modelos para ver más modelos que no están disponibles en Modelos de GitHub.

- Configure la autenticación sin clave.

- Configurar filtros de contenido.

- Configurar la limitación de volumen (para modelos específicos).

- Explorar las SKU de implementación (para modelos específicos) adicionales.

- Configurar redes privadas.

¿Tiene algún problema?

Vea la sección Preguntas más frecuentes para explorar ayuda adicional.

Pasos siguientes

- Explorar el catálogo de modelo en Estudio de IA de Azure.

- Agregar más modelos al punto de conexión.