Punto de conexión de inferencia de modelos en Servicios de Azure AI

La inferencia del modelo de Azure AI en los servicios de Azure AI permite a los clientes consumir los modelos más eficaces de los proveedores de modelos insignia mediante un único punto de conexión y las mismas credenciales. Esto significa que puede cambiar entre modelos y consumirlos desde la aplicación sin cambiar una sola línea de código.

En el artículo se explica cómo se organizan los modelos dentro del servicio y cómo usar el punto de conexión de inferencia para invocarlos.

Implementaciones

La inferencia del modelo de Azure AI hace que los modelos estén disponibles mediante el concepto de implementación. Las implementaciones son una manera de asignar un nombre a un modelo en determinadas configuraciones. A continuación, puede invocar dicha configuración de modelo indicando su nombre en las solicitudes.

Captura de implementaciones:

- Un nombre de modelo

- Una versión de modelo

- Un tipo de aprovisionamiento o capacidad1

- Una configuración de filtrado de contenido1

- Una configuración de limitación de frecuencia1

1 Las configuraciones pueden variar en función del modelo seleccionado.

Un recurso de servicios de Azure AI puede tener tantas implementaciones de modelos como sea necesario y no se incurrirá en costos a menos que se realice la inferencia para esos modelos. Las implementaciones son recursos de Azure y, por tanto, están sujetas a directivas de Azure.

Para obtener más información sobre cómo crear implementaciones, consulte Agregar y configurar implementaciones de modelos.

Punto de conexión de inferencia de Azure AI

El punto de conexión de inferencia de Azure AI permite a los clientes usar un único punto de conexión con la misma autenticación y esquema para generar inferencia para los modelos implementados en el recurso. Este punto de conexión sigue la API de inferencia de modelos de Azure AI que es compatible con todos los modelos del servicio de inferencia de modelos de Azure AI. Admite las siguientes modalidades:

- Inserciones de texto

- Inserciones de imágenes

- Finalizaciones de chat

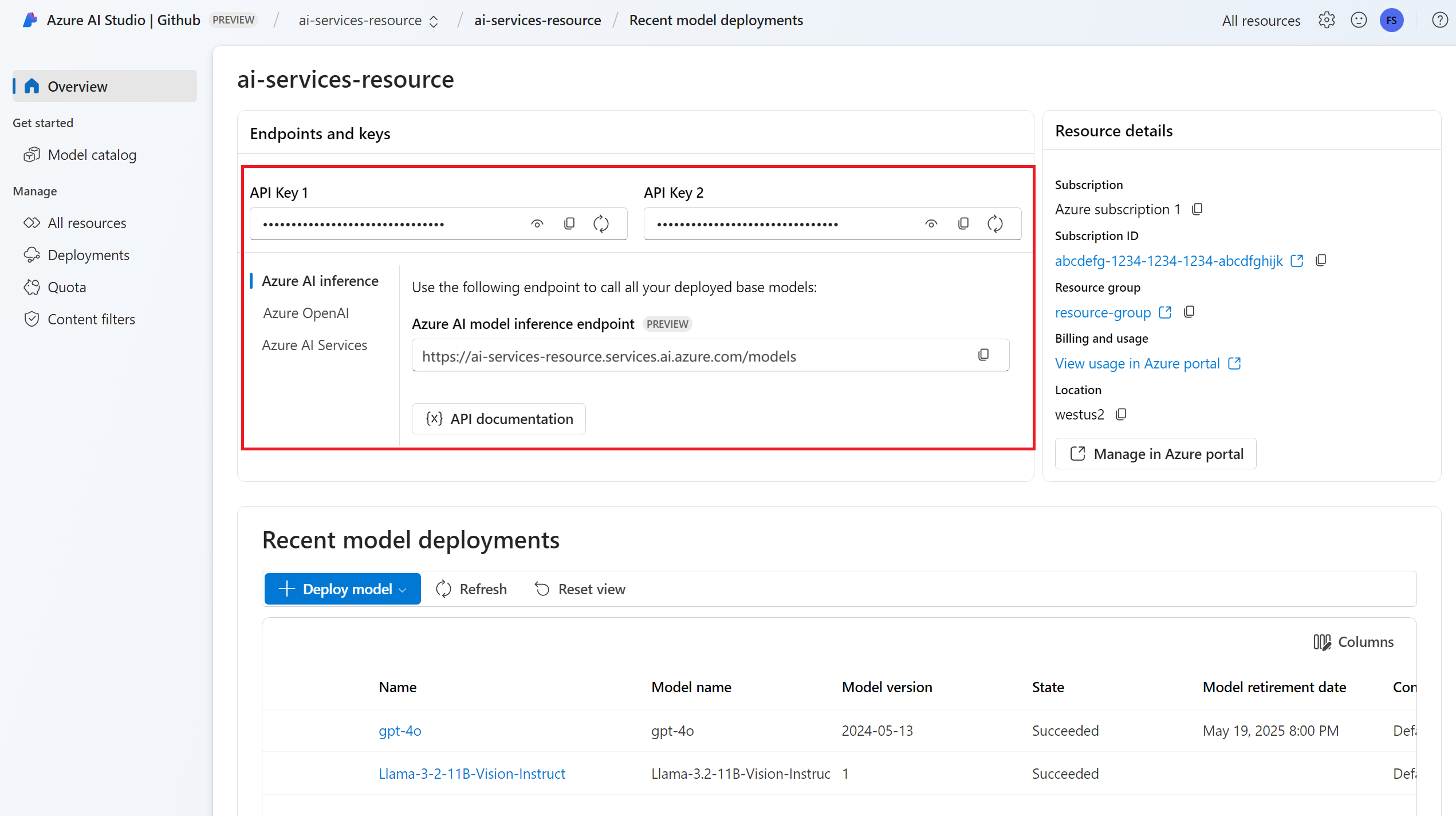

Puede ver la dirección URL del punto de conexión y las credenciales en la sección Información general:

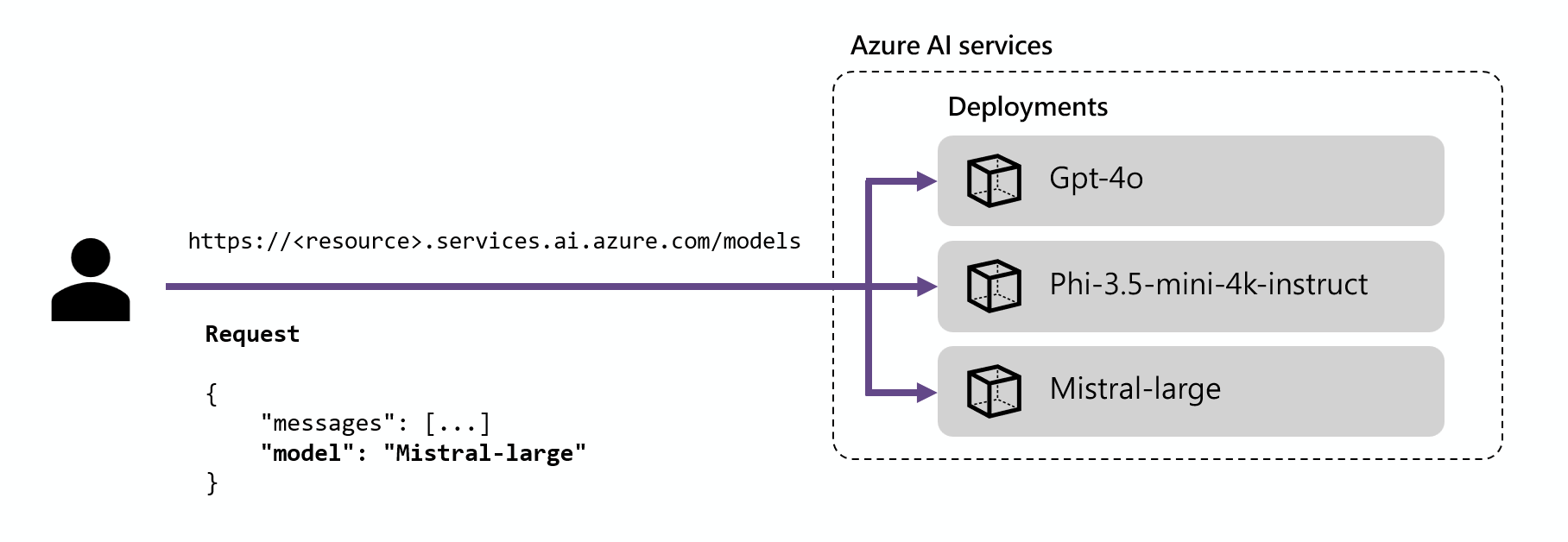

Enrutamiento

El punto de conexión de inferencia enruta las solicitudes a una implementación determinada mediante la coincidencia del parámetro name dentro de la solicitud con el nombre de la implementación. Esto significa que las implementaciones funcionan como un alias de un modelo determinado en determinadas configuraciones. Esta flexibilidad le permite implementar un modelo determinado varias veces en el servicio, pero en configuraciones diferentes si es necesario.

Por ejemplo, si crea una implementación denominada Mistral-large, esta implementación se puede invocar como:

Instale el paquete azure-ai-inference mediante el administrador de paquetes, como pip:

pip install azure-ai-inference>=1.0.0b5

Advertencia

El recurso de Servicios de Azure AI necesita la versión azure-ai-inference>=1.0.0b5 para Python.

A continuación, puede usar el paquete para consumir el modelo. En el ejemplo siguiente se muestra cómo crear un cliente para consumir finalizaciones de chat:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

model = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

Explore nuestros ejemplos y lea la documentación de referencia de API para empezar a trabajar.

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Sugerencia

El enrutamiento de implementación no distingue mayúsculas de minúsculas.

SDK

El punto de conexión de inferencia del modelo de Azure AI es compatible con varios SDK, incluido el SDK de inferencia de Azure AI, el SDK de la Fundición de IA de Azure y el SDK de Azure OpenAI, que están disponibles en varios idiomas. También se admiten varias integraciones en marcos populares como LangChain, LangGraph, Llama-Index, Semantic Kernel y AG2. Consulte los lenguajes de programación y SDK admitidos para obtener más información.

Punto de conexión de inferencia de Azure OpenAI

Los modelos de Azure OpenAI implementados en los servicios de IA también admiten la API de Azure OpenAI. Esta API expone las funcionalidades completas de los modelos de OpenAI y admite características adicionales, como asistentes, subprocesos, archivos e inferencia por lotes.

Los puntos de conexión de inferencia de Azure OpenAI funcionan en el nivel de implementación y tienen su propia dirección URL asociada a cada uno de ellos. Sin embargo, se puede usar el mismo mecanismo de autenticación para consumirlo. Obtenga más información en la página de referencia de la API de Azure OpenAI

Cada implementación tiene una dirección URL que es la concatenación de la dirección URL base de Azure OpenAI y la ruta /deployments/<model-deployment-name>.

Importante

No hay ningún mecanismo de enrutamiento para el punto de conexión de Azure OpenAI, ya que cada dirección URL es exclusiva para cada implementación de modelo.

SDK

El punto de conexión de Azure OpenAI es compatible con el SDK de OpenAI (claseAzureOpenAI) y con el SDK de Azure OpenAI, que están disponibles en varios idiomas: Para más información, consulte los idiomas admitidos.