Adición y configuración de modelos en la inferencia del modelo de Azure AI

Importante

Los elementos marcados (versión preliminar) en este artículo se encuentran actualmente en versión preliminar pública. Esta versión preliminar se ofrece sin acuerdo de nivel de servicio y no se recomienda para las cargas de trabajo de producción. Es posible que algunas características no sean compatibles o que tengan sus funcionalidades limitadas. Para más información, consulte Términos de uso complementarios de las Versiones Preliminares de Microsoft Azure.

Puede decidir y configurar qué modelos están disponibles para la inferencia en el punto de conexión de la inferencia. Cuando se configura un modelo determinado, puede generar predicciones a partir de él si indica su nombre de modelo o nombre de implementación en las solicitudes. No se requieren más cambios en el código para usarlo.

En este artículo, aprenderá a agregar un nuevo modelo a la inferencia de modelos de Azure AI en la Fundición de IA de Azure.

Requisitos previos

Para completar este artículo, necesitará lo siguiente:

Suscripción a Azure. Si usa Modelos de GitHub, puede actualizar la experiencia y crear una suscripción de Azure en el proceso. Lea Actualización de modelos de GitHub a la inferencia de modelos de Azure AI si es su caso.

Recurso de Servicios de Azure AI.

Un proyecto de inteligencia artificial conectado al recurso de los servicios de Azure AI con la característica Implementación de modelos en el servicio de la inferencia del modelo de Azure AI activado.

- Puede seguir los pasos descritos en Servicio de la inferencia del modelo de Azure AI en mi proyecto en la Fundición de IA de Azure.

Agregar un modelo

Puede agregar modelos al punto de conexión de la inferencia del modelo de Azure AI mediante los pasos siguientes:

Vaya a la sección Catálogo de modelo del Portal de la Fundición de IA de Azure.

Desplácese hasta el modelo que le interese y selecciónelo.

Puede revisar los detalles del modelo en la tarjeta del modelo.

Seleccione Implementar.

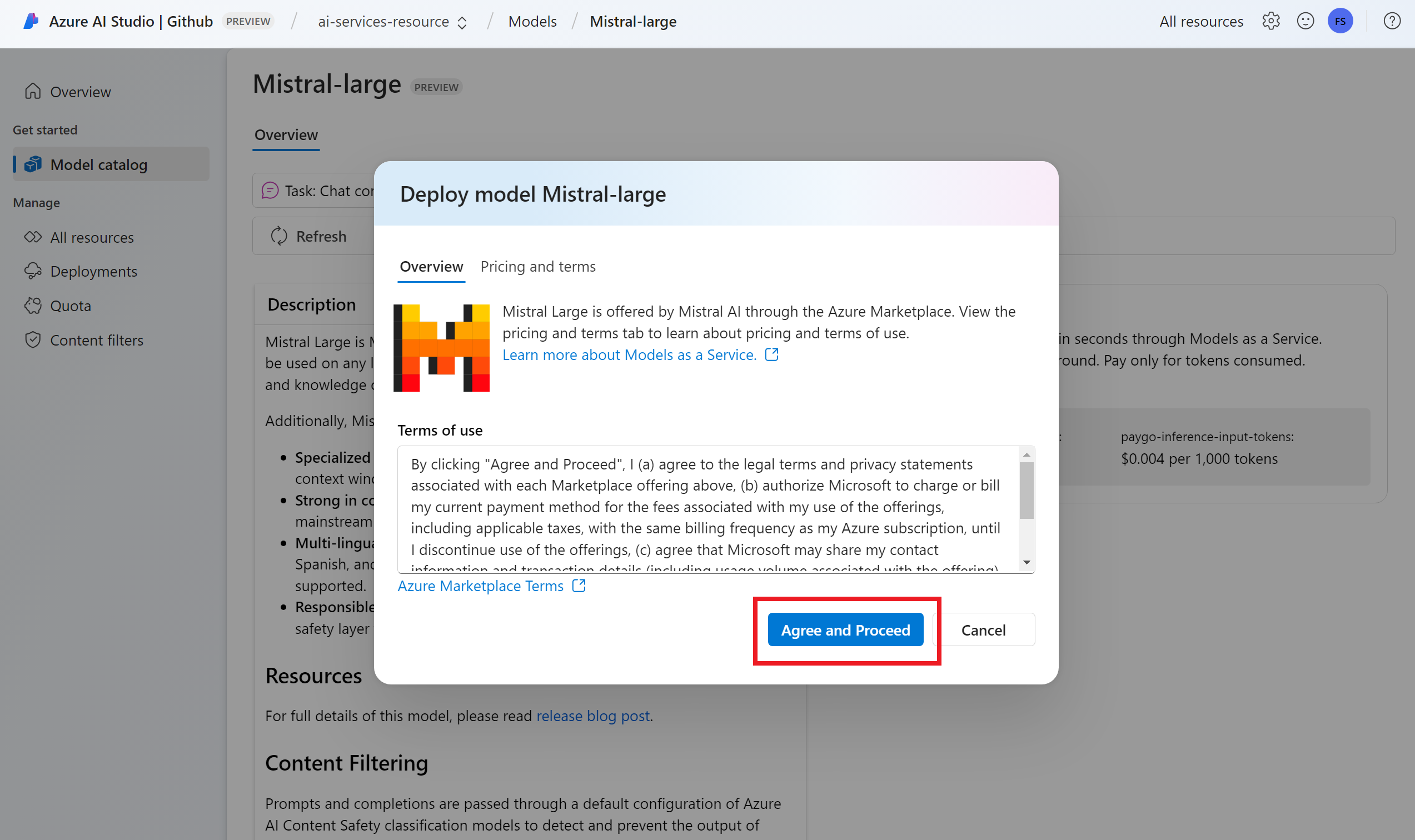

En el caso de los proveedores de modelos que requieren más términos de contrato, se le pedirá que acepte esos términos. Este es el caso de los modelos Mistral, por ejemplo. Para aceptar los términos de esos casos, seleccione Suscribir e implementar.

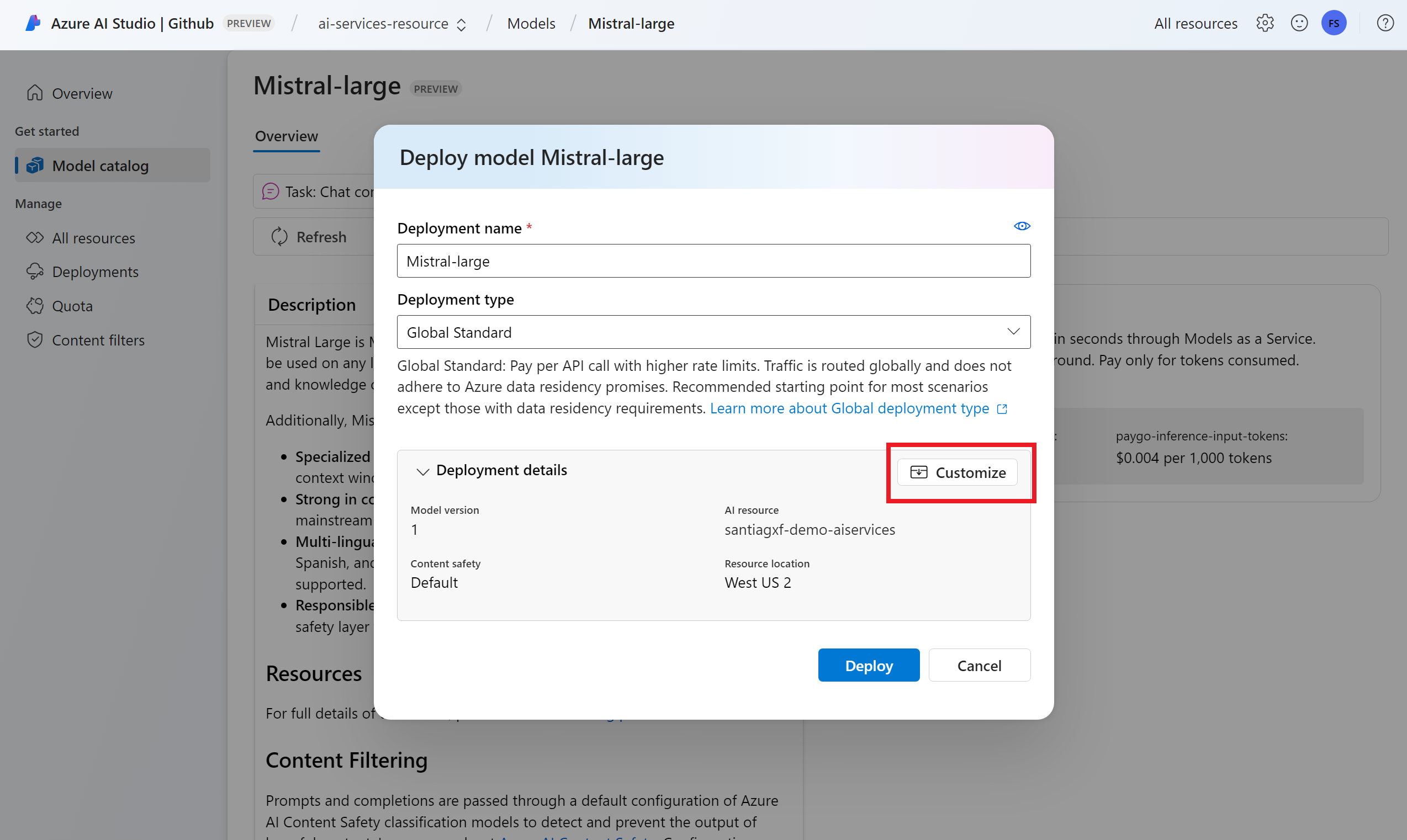

Puede configurar las opciones de implementación en este momento. De manera predeterminada, la implementación recibe el nombre del modelo que va a implementar. El nombre de la implementación se usa en el parámetro

modelpara solicitar que se enrute a esta implementación de modelo determinada. Esto también permite configurar nombres específicos para los modelos al adjuntar configuraciones específicas. Por ejemplo,o1-preview-safepara un modelo con un filtro de contenido de seguridad de contenido estricto.Sugerencia

Cada modelo puede admitir diferentes tipos de implementaciones, lo que proporciona garantías de residencia o rendimiento de datos diferentes. Vea Tipos de implementación para más información.

Seleccionamos automáticamente una conexión de los servicios de Azure AI en función del proyecto. Use la opción Personalizar para cambiar la conexión en función de sus necesidades. Si va a implementar en el tipo de implementación Estándar, los modelos deben estar disponibles en la región del recurso de los servicios de Azure AI.

Sugerencia

Si el recurso deseado no aparece en la lista, es posible que tenga que crear una conexión a él. Consulte Servicio de la inferencia del modelo de Azure AI en mi proyecto en el Portal de la Fundición de IA de Azure.

Seleccione Implementar.

Una vez que se completa la implementación, el nuevo modelo se mostrará en la página y estará listo para usarse.

Administración de modelos

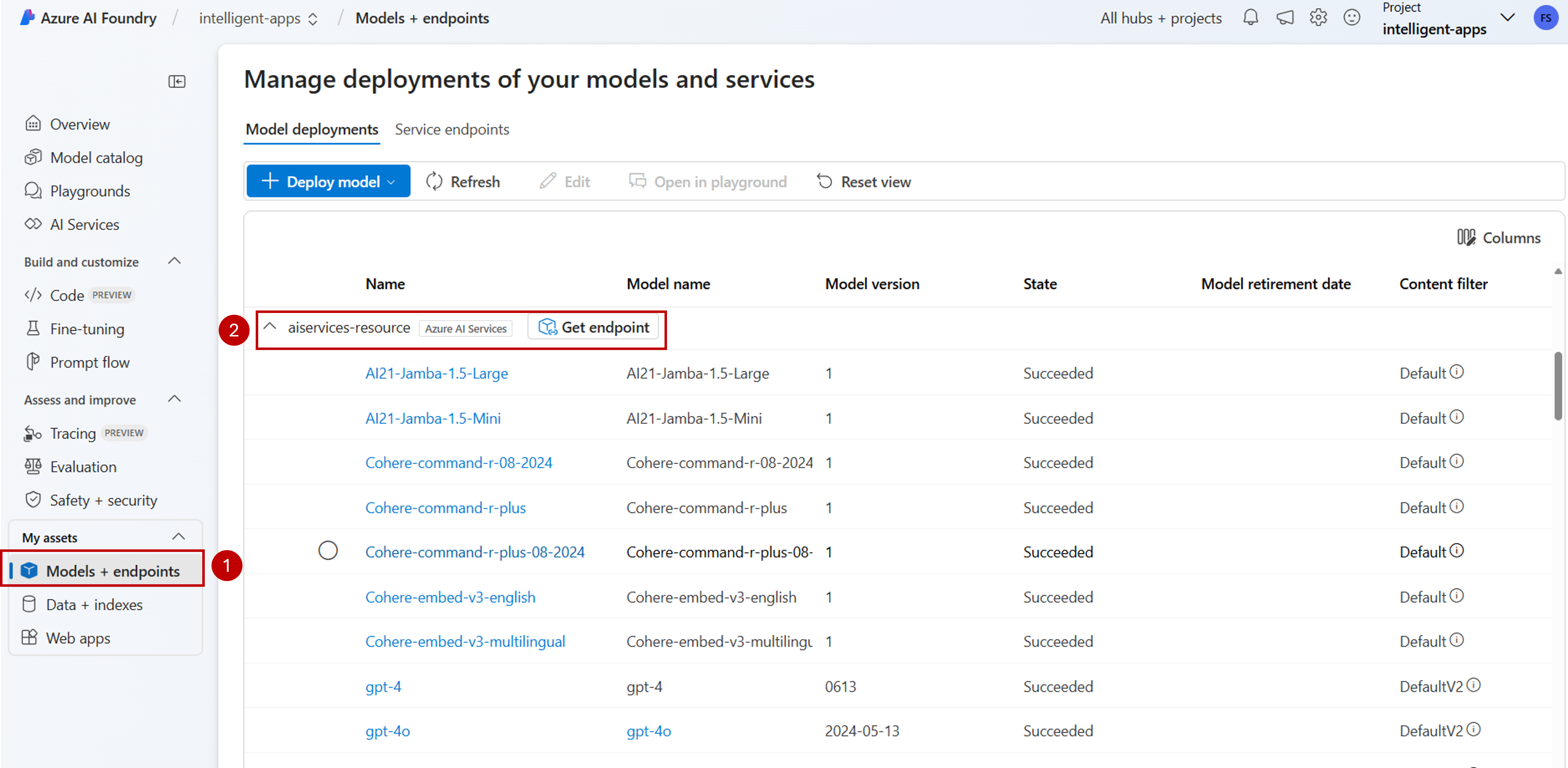

Puede administrar las implementaciones de modelos existentes en el recurso mediante el Portal de la Fundición de IA de Azure.

Vaya a la sección Modelos y puntos de conexión del Portal de la Fundición de IA de Azure.

Desplácese hasta la conexión al recurso de los servicios de Azure AI. Las implementaciones de modelos se agrupan y se muestran por conexión.

Verá una lista de modelos disponibles en cada conexión. Seleccione la implementación de modelo que le interesa.

Edite o Elimine la implementación según sea necesario.

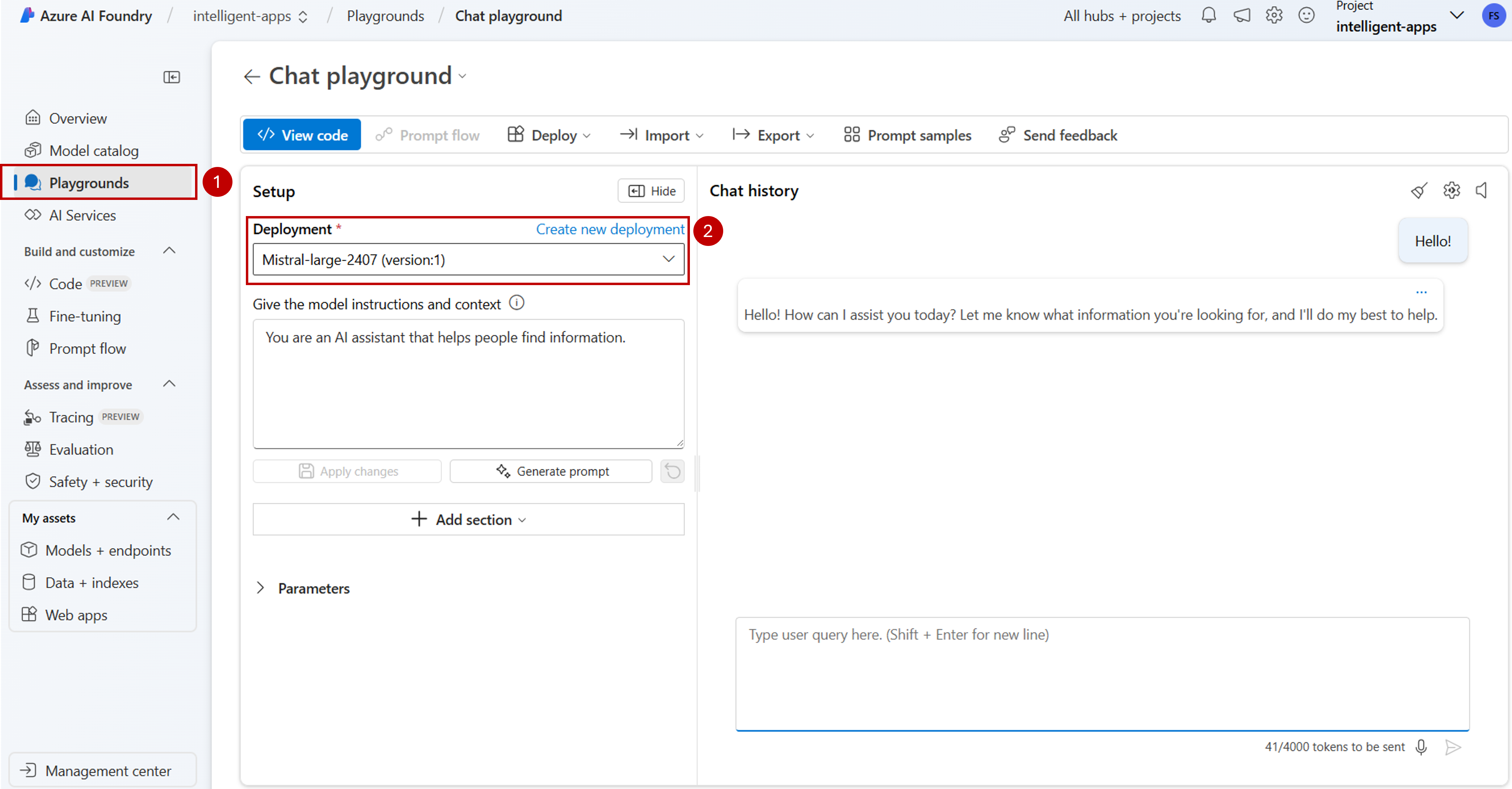

Prueba de la implementación en el área de juegos

Puede interactuar con el nuevo modelo en el Portal de la Fundición de IA de Azure mediante el área de juegos:

Nota:

El área de juegos solo está disponible cuando se trabaja con proyectos de inteligencia artificial en la Fundición de IA de Azure. Cree un proyecto de IA para obtener acceso completo a todas las funcionalidades de la Fundición de IA de Azure.

Vaya a la sección Áreas de juego en el Portal de la Fundición de IA de Azure.

En función del tipo de modelo implementado, seleccione el área de juegos necesaria. En este caso, seleccionamos Área de juegos de chat.

En la lista desplegable Implementación, en Programa de instalación seleccione el nombre de la implementación de modelo que ha creado.

Escriba el mensaje y vea las salidas.

Además, puede usar Ver código para ver detalles sobre cómo acceder a la implementación de modelo mediante programación.

Importante

Los elementos marcados (versión preliminar) en este artículo se encuentran actualmente en versión preliminar pública. Esta versión preliminar se ofrece sin acuerdo de nivel de servicio y no se recomienda para las cargas de trabajo de producción. Es posible que algunas características no sean compatibles o que tengan sus funcionalidades limitadas. Para más información, consulte Términos de uso complementarios de las Versiones Preliminares de Microsoft Azure.

Puede decidir y configurar qué modelos están disponibles para la inferencia en el punto de conexión de la inferencia. Cuando se configura un modelo determinado, puede generar predicciones a partir de él si indica su nombre de modelo o nombre de implementación en las solicitudes. No se requieren más cambios en el código para usarlo.

En este artículo, aprenderá a agregar un nuevo modelo a la inferencia de modelos de Azure AI en la Fundición de IA de Azure.

Requisitos previos

Para completar este artículo, necesitará lo siguiente:

Suscripción a Azure. Si usa Modelos de GitHub, puede actualizar la experiencia y crear una suscripción de Azure en el proceso. Lea Actualización de modelos de GitHub a la inferencia de modelos de Azure AI si es su caso.

Recurso de Servicios de Azure AI.

Instale la CLI de Azure y la extensión de

cognitiveservicespara Servicios de Azure AI:az extension add -n cognitiveservicesAlgunos de los comandos de este tutorial usan la herramienta

jq, que podría no estar instalada en el sistema. Para obtener las instrucciones de instalación, consulte Descargarjq.Identifique la siguiente información:

Su identificador de suscripción de Azure.

Nombre del recurso de Servicios de Azure AI.

El grupo de recursos donde se implementa el recurso de Servicios de Azure AI.

Agregar modelos

Para agregar un modelo, primero debe identificar el modelo que desea implementar. Puede consultar los modelos disponibles de la siguiente manera:

Inicie sesión en su suscripción de Azure:

az loginSi tiene más de una suscripción, seleccione la suscripción donde se encuentra el recurso:

az account set --subscription $subscriptionId>Establezca las siguientes variables de entorno con el nombre del recurso de Servicios de Azure AI que planea usar y el grupo de recursos.

accountName="<ai-services-resource-name>" resourceGroupName="<resource-group>"Si aún no tiene una cuenta de Servicios de Azure AI creada, puede crear una como se muestra a continuación:

az cognitiveservices account create -n $accountName -g $resourceGroupName --custom-domain $accountNameVeamos primero qué modelos están disponibles y con qué SKU. El siguiente comando muestra todas las definiciones de modelo disponibles:

az cognitiveservices account list-models \ -n $accountName \ -g $resourceGroupName \ | jq '.[] | { name: .name, format: .format, version: .version, sku: .skus[0].name, capacity: .skus[0].capacity.default }'Las salidas tienen el siguiente aspecto:

{ "name": "Phi-3.5-vision-instruct", "format": "Microsoft", "version": "2", "sku": "GlobalStandard", "capacity": 1 }Identifique el modelo que quiere implementar. Necesita las propiedades

name,format,versionysku. La capacidad también puede ser necesaria en función del tipo de implementación.Sugerencia

Observe que no todos los modelos están disponibles en todos los SKU.

Agregue la implementación de modelo al recurso. En el siguiente ejemplo se agrega

Phi-3.5-vision-instruct:az cognitiveservices account deployment create \ -n $accountName \ -g $resourceGroupName \ --deployment-name Phi-3.5-vision-instruct \ --model-name Phi-3.5-vision-instruct \ --model-version 2 \ --model-format Microsoft \ --sku-capacity 1 \ --sku-name GlobalStandardEl modelo está listo para consumirse.

Puede implementar el mismo modelo varias veces si es necesario siempre que esté bajo un nombre de implementación diferente. Esta funcionalidad puede ser útil en caso de que quiera probar configuraciones diferentes para un modelo determinado, incluida la seguridad del contenido.

Administración de implementaciones

Puede ver todas las implementaciones disponibles con la CLI:

Ejecute el comando siguiente para ver todas las implementaciones activas:

az cognitiveservices account deployment list -n $accountName -g $resourceGroupNamePuede ver los detalles de una implementación determinada:

az cognitiveservices account deployment show \ --deployment-name "Phi-3.5-vision-instruct" \ -n $accountName \ -g $resourceGroupNamePuede eliminar una implementación determinada de la siguiente manera:

az cognitiveservices account deployment delete \ --deployment-name "Phi-3.5-vision-instruct" \ -n $accountName \ -g $resourceGroupName

Uso del modelo

Los modelos implementados en la inferencia del modelo de Azure AI se pueden consumir mediante el punto de conexión de la inferencia del modelo de Azure AI para el recurso. Al construir la solicitud, indique el parámetro model e inserte el nombre de la implementación de modelo que ha creado. Puede obtener mediante programación el URI del punto de conexión de la inferencia mediante el siguiente código:

Punto de conexión de inferencia

az cognitiveservices account show -n $accountName -g $resourceGroupName | jq '.properties.endpoints["Azure AI Model Inference API"]'

Para realizar solicitudes al punto de conexión de la inferencia del modelo de Azure AI, anexe la ruta models, por ejemplo, https://<resource>.services.ai.azure.com/models. Puede ver la referencia de API para el punto de conexión en la página de referencia de API de la inferencia del modelo de Azure AI.

Claves de la inferencia

az cognitiveservices account keys list -n $accountName -g $resourceGroupName

Importante

Los elementos marcados (versión preliminar) en este artículo se encuentran actualmente en versión preliminar pública. Esta versión preliminar se ofrece sin acuerdo de nivel de servicio y no se recomienda para las cargas de trabajo de producción. Es posible que algunas características no sean compatibles o que tengan sus funcionalidades limitadas. Para más información, consulte Términos de uso complementarios de las Versiones Preliminares de Microsoft Azure.

Puede decidir y configurar qué modelos están disponibles para la inferencia en el punto de conexión de la inferencia. Cuando se configura un modelo determinado, puede generar predicciones a partir de él si indica su nombre de modelo o nombre de implementación en las solicitudes. No se requieren más cambios en el código para usarlo.

En este artículo, aprenderá a agregar un nuevo modelo a la inferencia de modelos de Azure AI en la Fundición de IA de Azure.

Requisitos previos

Para completar este artículo, necesitará lo siguiente:

Suscripción a Azure. Si usa Modelos de GitHub, puede actualizar la experiencia y crear una suscripción de Azure en el proceso. Lea Actualización de modelos de GitHub a la inferencia de modelos de Azure AI si es su caso.

Recurso de Servicios de Azure AI.

Instale la CLI de Azure.

Identifique la siguiente información:

Su identificador de suscripción de Azure.

Nombre del recurso de Servicios de Azure AI.

El grupo de recursos donde se implementa el recurso de los servicios de Azure AI.

El nombre del modelo, el proveedor, la versión y la SKU que desea implementar. Puede usar el Portal de la Fundición de IA de Azure o la CLI de Azure para identificarlo. En este ejemplo, se implementa el siguiente modelo:

-

Nombre del modelo::

Phi-3.5-vision-instruct -

Proveedor:

Microsoft -

Versión:

2 - Tipo de implementación: estándar global

-

Nombre del modelo::

Acerca de este tutorial

El ejemplo de este artículo se basa en los ejemplos de código incluidos en el repositorio Azure-Samples/azureai-model-inference-bicep. Para ejecutar los comandos localmente sin tener que copiar o pegar contenido de archivo, use los siguientes comandos para clonar el repositorio y vaya a la carpeta del lenguaje de codificación:

git clone https://github.com/Azure-Samples/azureai-model-inference-bicep

Los archivos de este ejemplo están en:

cd azureai-model-inference-bicep/infra

Agregar el modelo

Use la plantilla

ai-services-deployment-template.biceppara describir las implementaciones de modelos:ai-services-deployment-template.bicep

@description('Name of the Azure AI services account') param accountName string @description('Name of the model to deploy') param modelName string @description('Version of the model to deploy') param modelVersion string @allowed([ 'AI21 Labs' 'Cohere' 'Core42' 'DeepSeek' 'Meta' 'Microsoft' 'Mistral AI' 'OpenAI' ]) @description('Model provider') param modelPublisherFormat string @allowed([ 'GlobalStandard' 'Standard' 'GlobalProvisioned' 'Provisioned' ]) @description('Model deployment SKU name') param skuName string = 'GlobalStandard' @description('Content filter policy name') param contentFilterPolicyName string = 'Microsoft.DefaultV2' @description('Model deployment capacity') param capacity int = 1 resource modelDeployment 'Microsoft.CognitiveServices/accounts/deployments@2024-04-01-preview' = { name: '${accountName}/${modelName}' sku: { name: skuName capacity: capacity } properties: { model: { format: modelPublisherFormat name: modelName version: modelVersion } raiPolicyName: contentFilterPolicyName == null ? 'Microsoft.Nill' : contentFilterPolicyName } }Ejecute la implementación:

RESOURCE_GROUP="<resource-group-name>" ACCOUNT_NAME="<azure-ai-model-inference-name>" MODEL_NAME="Phi-3.5-vision-instruct" PROVIDER="Microsoft" VERSION=2 az deployment group create \ --resource-group $RESOURCE_GROUP \ --template-file ai-services-deployment-template.bicep \ --parameters accountName=$ACCOUNT_NAME modelName=$MODEL_NAME modelVersion=$VERSION modelPublisherFormat=$PROVIDER

Uso del modelo

Los modelos implementados en la inferencia del modelo de Azure AI se pueden consumir mediante el punto de conexión de la inferencia del modelo de Azure AI para el recurso. Al construir la solicitud, indique el parámetro model e inserte el nombre de implementación de modelo que ha creado.