Vocie-Funktionen konfigurieren

In diesem Artikel werden die Funktionen Copilot Studio beschrieben, die für die interaktive Sprachantwort mit Dynamics 365 Customer Service verfügbar sind.

Informationen dazu, wie Sie Ihren Agent auf Sprachdienste vorbereiten, finden Sie unter Integrieren eines sprachaktivierten Agents in Dynamics 365 Customer Service.

Eine Übersicht über die Sprachdienste finden Sie unter Verwenden der interaktiven Sprachantwort in Ihren Agenten.

Sprach- und MFV-Modalität

Ein sprachgesteuerter Agent unterscheidet sich von einem chatbasierten Agenten. Der sprachaktivierte Agent enthält spezifische Themen des Sprachsystems für die Bearbeitung von Sprachszenarien. Ein chatbasierter Agent verwendet standardmäßig die Textmodalität. Ein sprachgesteuerter Agent verwendet die Sprach- und MFV-Modalität. Die beiden Modalitäten sind nicht miteinander kompatibel.

Mit Optimierung für Sprache können Sie sprachaktivierte Agenten über verschiedene Modalitäten hinweg verfassen und sicherstellen, dass sprachbezogene Funktionen korrekt verfasst werden.

Für Sprachanrufe optimieren

Wenn Sie Ihren Agent nicht mit der Sprachvorlage gestartet haben, müssen Sie die Option Optimierung für Sprache in den Einstellungen des Agenten aktivieren.

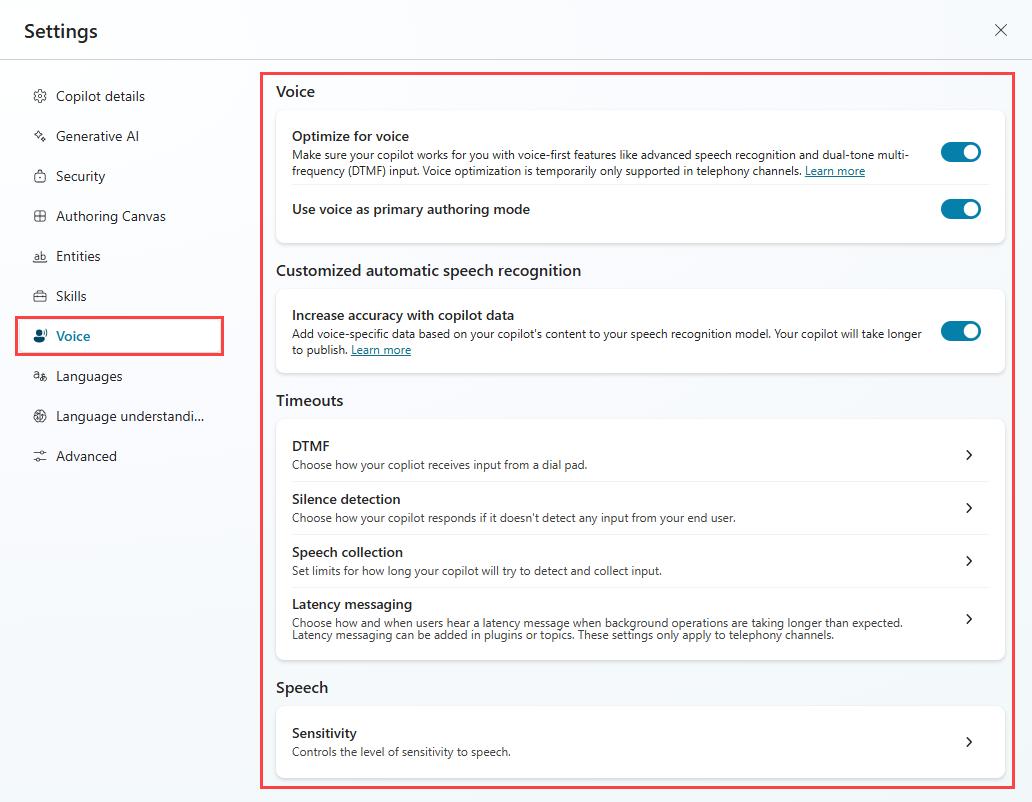

Wenn ein Agent geöffnet ist, gehen Sie zu Einstellungen>Sprache.

Wählen Sie Für Sprache optimieren aus. Die Option Sprache als primären Erstellungsmodus verwenden ist ebenfalls standardmäßig aktiviert.

Ihr Agent erhält die folgenden Updates, wenn Sie die Optionen Für Sprache optimieren und Stimme als primären Authoringmodus verwenden aktivieren:

- Die Möglichkeit, Sprachfunktionen zu erstellen, wenn von Text auf Sprache und MFV umgeschaltet wird.

- Die Sprachsystemthemen Stilleerkennung, Sprache nicht erkannt und Unbekannter Tastendruck werden automatisch hinzugefügt, um sprachbezogene Szenarien zu verarbeiten.

- Erhöhen Sie die Genauigkeit mit Agentendaten (standardmäßig aktiviert), wodurch die Genauigkeit der Spracherkennung verbessert wird.

- Es gibt keine Änderungen am vorhandenen Agentenflow, wie z. B. das Thema Hauptmenü zum Starten von Unterhaltungen mit zugeordneten DTMF-Triggern.

Wichtig

- Die Einstellung Für Sprache optimieren ändert nur die Funktionen zur Spracherstellung, nicht die Kanaleinstellung. Aktivieren Sie den Telefoniekanal für einen vollständig sprachaktivierten Agenten.

- Wenn Sie die Option Optimieren für Sprache für einen Agenten festlegen, der ursprünglich nicht für Sprachfunktionen konfiguriert wurde, hat der Agent das Thema Hauptmenü (Vorschauversion) nicht. Sie müssen Thema bei Bedarf neu erstellen.

- Wenn Sie die Option Für Sprache optimieren nicht aktivierenkönnen, überprüfen Sie die Power Platform Umgebung Ihres Agenten und stellen Sie sicher, dass die Option Neue Funktionen frühzeitig abrufen für diese Umgebung deaktiviert ist. Weitere Informationen finden Sie unter Für Sprache optimieren kann nicht aktiviert werden.

Deaktivieren Sie die Optimierung für Sprache

Sie können die Option Optimieren für Sprache in der Agentenerstellung deaktivieren, wenn Sie den Telefoniekanal nicht aktivieren. Nachdem Sie Für Sprache optimieren deaktiviert haben, ergeben sich die folgenden Änderungen:

- Keine Agentenerstellung für Sprachfunktionen wie MFV und Unterbrechung.

- Die Standardmodalität ist auf Text festgelegt.

- Keine Verbesserung der Spracherkennung, da keine Spracherkennung vorhanden ist.

- Keine Sprachsystemthemen oder globales MFV Thema.

Anmerkung

Bei einigen Themen werden während der Veröffentlichung möglicherweise Fehler gemeldet, wenn in anderen Themen auf das deaktivierte MFV Thema verwiesen wird.

- Keine Änderung der Einstellungen für den Agentenflow und den Kanal, da der Telefoniekanal durch das Deaktivieren der Optimierung nicht deaktiviert wird.

- Das Aktivieren oder Deaktivieren der Option Optimieren für Sprache wird erst wirksam, wenn Sie Ihren Agent veröffentlichen. Wenn der Agent versehentlich aktiviert oder deaktiviert wird und zwischen den Betriebsarten wechselt, haben Sie Zeit, das Problem zu beheben.

Wichtig

Wenn Ihre Telefoniekanäle aktiviert sind, kann Für Sprache optimieren Ihren Agent beeinträchtigen, da alle DTMF-Trigger automatisch deaktiviert werden.

Verwenden Sie die Sprache als primären Erstellungsmodus

Die Sprach- und MFV-Modalität sollte für jeden Knoten bei der Sprachfunktionserstellung ausgewählt werden. Sie können als Voreinstellung für die Agentenerstellung die Option Spracheingabe als primären Erstellungsmodus auswählen. Diese Einstellung stellt sicher, dass alle Eingabefelder die richtige Modalität haben. Wenn Sie Für Sprache optimieren bereits aktiviert haben, wird Verwenden Sie die Stimme als primären Erstellungsmodus standardmäßig aktiviert.

Meldungs-Verfügbarkeit

Die Verwendung der Text- oder Sprachmodalität kann sich unterschiedlich auf Ihren Kanal auswirken.

| Textmodalität | Sprachmodalität | Text- und Sprachkanal für Agenten |

|---|---|---|

| Meldung verfügbar | Meldung leer | Meldung verfügbar |

| Meldung leer | Meldung verfügbar | Meldung nicht verfügbar |

Benutzerdefinierte automatische Spracherkennung

Bei sprachgesteuerten Agenten für einen bestimmten Bereich, z. B. Medizin oder Finanzen, kann es vorkommen, dass Benutzende Finanzbegriffe oder medizinischen Fachjargon verwenden. Einige Begriffe und Fachbegriffe sind für den sprachgesteuerten Agenten schwer von Sprache in Text umzuwandeln.

Um eine korrekte Erkennung der Spracheingabe zu gewährleisten, können Sie die Spracherkennung verbessern:

Öffnen Sie Ihren Agenten und wählen Sie Einstellungen>Spracheaus.

Wählen Sie Genauigkeit mit Agentendaten erhöhen aus, um die benutzerdefinierten Standardeinstellungen für die automatische Spracherkennung des Agents zu aktivieren.

Wählen Sie Speichern aus, um Ihre Änderungen zu übernehmen.

Veröffentlichen Sie Ihren Agent, um die neuen Änderungen anzuzeigen.

Referenz zu Sprachoptionen auf Agentenebene

Auf der Einstellungsseite für Agentdetails können Sie Zeitüberschreitungen für verschiedene sprachbezogene Funktionen konfigurieren. Die auf dieser Seite angewendeten Einstellungen werden für Themen, die in Ihrem Agent erstellt werden, zum Standard.

So nehmen Sie Änderungen an den Timeout-Optionen auf Agentenebene vor:

Wenn ein Agent geöffnet ist, gehen Sie zu Einstellungen>Sprache.

Wählen Sie die gewünschten Einstellungen aus und passen Sie die Standardeinstellungen des Agenten an.

Wählen Sie Speichern aus, um Ihre Änderungen zu übernehmen.

Agentebeneneinstellungen

In der folgenden Tabelle sind die einzelnen Optionen und ihre Beziehung zu den Einstellungen auf Knotenebene aufgeführt.

| Abschnitt auf sprachgesteuerter Agentenebene | Einstellungen | Beschreibung | Default value | Knoten-Ebene außer Kraft setzen |

|---|---|---|---|---|

| MFV | Zwischenziffer-Timeout | Maximal zulässige Zeit (Millisekunden), während auf die nächste MFV-Tasteneingabe gewartet wird. Wendet mehrstellige MFV-Eingaben nur an, wenn Benutzer die maximale Eingabelänge nicht einhalten. | 3000 ms | Frageknoten mit Spracheigenschaften für mehrstellige MFV-Eingabe |

| MFV | Beendigungs-Timeout | Maximale Dauer (Millisekunden), die auf eine MFV-Beendigungstaste gewartet werden soll. Die Begrenzung gilt, wenn der Benutzer die maximale Eingabelänge erreicht und die Beendigungstaste nicht gedrückt hat. Gilt nur für mehrstellige MFV-Eingaben. Nachdem das Limit abgelaufen ist und der DTMF-Schlüssel nicht eintrifft, beendet der Agent die Erkennung und gibt das Ergebnis bis zu diesem Punkt zurück. Wenn diese Option auf „Fortsetzen ohne Wartezeit“ festgelegt ist, wartet der Agent nicht auf die Beendigungstaste. Der Agent gibt sofort nach der Eingabe der maximalen Länge durch den Benutzenden zurück. |

2000 ms | Frageknoten mit Spracheigenschaften für mehrstellige MFV-Eingabe |

| Stille-Erkennung | Timeout bei automatischer Erkennung | Maximal zulässige Stille (Millisekunden), während auf die nächste Benutzereingabe gewartet wird. Der Grenzwert gilt, wenn der Agent keine Benutzereingaben erkennt. Die Standardeinstellung ist kein Stille-Timeout. Agent wartet endlos auf die Eingabe des Benutzers. Die Sprachstilleerkennung misst die Zeitspanne, nachdem die Stimme zu Ende gesprochen hat. |

Kein Stille-Timeout | Frageknoten mit Spracheigenschaften für mehrstellige MFV-Eingabe Systemthema (Eigenschaften des Auslösers für Stilleerkennung) zum Konfigurieren der Stilleerkennung und Zeitüberschreitungen |

| Spracherfassung | Äußerungsende-Timeout | Die Begrenzung gilt, wenn der Benutzer während oder nach der Rede eine Pause macht. Wenn die Pause länger als das Timeout-Limit dauert, geht der Agent davon aus, dass der Benutzende zu Ende gesprochen hat. Der Maximalwert für das Timeout am Ende der Äußerung beträgt 3000 ms. Alles, was über 3000 ms liegt, reduziert sich auf 3000 ms. |

1500 ms | Fragenknoten mit Spracheigenschaften |

| Spracherfassung | Spracherkennungs-Timeout | Legt fest, wie viel Zeit der Agent für die Eingabe des Benutzers einräumt, sobald er zu sprechen beginnt. Der Standardwert ist 12000 Millisekunden (ca. 12 Sekunden). Kein Erkennungs-Timeout bedeutet unendliche Zeit. Agent stellt die Frage erneut. Wenn keine Antwort erfolgt, ist das Timeout der Spracherkennung überschritten. | 12,000 ms | Fragenknoten mit Spracheigenschaften |

| Latenznachrichten | Verzögerungsnachricht senden | Legt fest, wie lange der Agent wartet, bevor er die Latenznachricht übermittelt, nachdem eine Hintergrundvorgangsanforderung gestartet wurde. Die Zeit wird in Millisekunden eingestellt. | 500 ms | Aktionsknoteneigenschaften für lang andauernde Vorgänge |

| Latenznachrichten | Minimale Wiedergabezeit | Die Latenznachricht wird für eine Mindestzeit abgespielt, auch wenn der Hintergrundvorgang während der Wiedergabe der Nachricht abgeschlossen wird. Die Zeit wird in Millisekunden eingestellt. | 5000 ms | Aktionsmoduseigenschaften für lang andauernde Vorgänge |

| Sprachsensitivität | Sensitivität | Steuert, wie das System die Erkennung von Sprache und Hintergrundgeräuschen ausgleicht. Verringern Sie die Sensitivität für laute Umgebungen, öffentliche Orte undy den Freisprechbetrieb. Erhöhen Sie die Sensitivität für ruhige Umgebungen, leise sprechende Benutzende oder die Erkennung von Sprachbefehlen. Die Standardeinstellung ist 0.5. | 0.5 | Für dieses Steuerelement gibt es keine Überschreibungen auf Knotenebene. |

Barge-In aktivieren

Durch die Aktivierung von Unterbrechung können Ihre Agent-Benutzer Ihren Agent unterbrechen. Diese Funktion kann nützlich sein, wenn der Agent-Benutzer nicht die gesamte Nachricht hören soll. Beispielsweise ist es möglich, dass Anrufer die Menüoptionen bereits kennen, da sie diese schon einmal gehört haben. Mit Unterbrechung kann der Agent-Benutzer die gewünschte Option eingeben, auch wenn der Agent noch nicht alle Optionen aufgelistet hat.

Szenarien zum Deaktivieren des Barge-In

- Deaktivieren Sie Unterbrechen, wenn Sie kürzlich eine Agent-Nachricht aktualisiert haben oder wenn die Compliance-Nachricht nicht unterbrochen werden soll.

- Deaktivieren Sie Unterbrechung-In für die erste Agent-Nachricht, um sicherzustellen, dass Agent-Benutzer über neue oder wichtige Informationen informiert sind.

Spezifikationen

Unterbrechung unterstützt DTMF- und sprachbasierte Unterbrechungen durch den Agent-Benutzer.

Das Aufschalten kann mit jeder einzelnen Nachricht in einem Batch gesteuert werden.

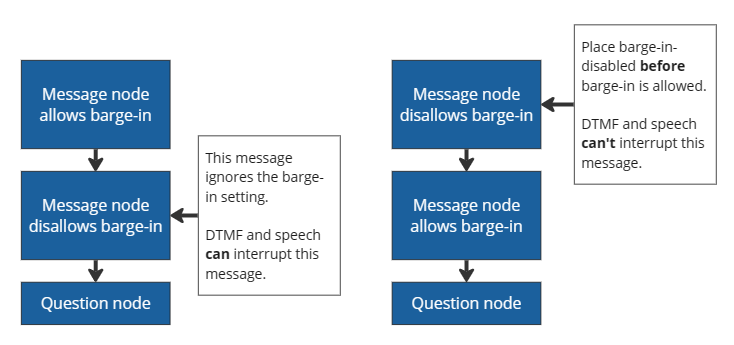

barge-in-disabledKnoten in der Reihenfolge vor jedem Knoten platzieren, bei dem ein Barge-In zulässig ist. Andernfalls wird „Barge-In deaktiviert“ als „Barge-In zulassen“-Nachricht behandelt.Sobald eine Batch-Warteschlange fertig ist, wird die automatische Barge-In-Einstellung für den nächsten Batch zurückgesetzt und bei jeder nachfolgenden Nachricht durch das Barge-In-Flag gesteuert. Sie können deaktivierte Barge-In-Knoten platzieren, wenn die Sequenz erneut gestartet wird.

Tipp

Wenn aufeinanderfolgende Nachrichtenknoten vorhanden sind, gefolgt von einem Fragenknoten, werden Sprachnachrichten für diese Knoten als ein Batch definiert. Ein Batch beginnt mit einem Nachrichtenknoten und endet beim Fragenknoten, der auf die Eingabe des Benutzers wartet.

Vermeiden Sie das Deaktivieren von Unterbrechung für längere Nachrichten, insbesondere wenn Sie davon ausgehen, dass Agent-Benutzer häufig mit dem Agenten interagieren. Wenn Ihr Agent-Benutzer die Menüoptionen bereits kennt, können Sie ihm die Möglichkeit geben, sich selbst zu bedienen und zu wählen, wohin sie gehen möchten.

Barge-In einrichten

Mit einem ausgewählten Nachricht oder Frage-Knoten legen Sie die gewünschte Modalität auf Sprache und MFV fest.

Symbol Mehr im (…) des Knotens auswählen und dann Eigenschaften auswählen.

Für Nachrichten.Knoten wird der Bereich Eigenschaften der Sendeaktivität an der Seite der Erstellungsfläche geöffnet.

Wählen Sie Barge-in zulassen aus.

Für Fragen Knoten wird das Fenster Frageneigenschaften geöffnet. Wählen Sie dort Sprache aus.

Wählen Sie in den Voice Eigenschaften die Option Barge-in zulassen aus.

Das Thema speichern, um Ihre Änderungen zu übernehmen.

Konfigurieren der Stilleerkennung und Zeitüberschreitungen

Mit der Stummschaltungserkennung können Sie konfigurieren, wie lange der Agent auf Benutzereingaben wartet und welche Aktion er ausführt, wenn keine Eingabe eingeht. Die Stilleerkennung ist besonders nützlich, wenn Sie auf eine Frage auf Knotenebene antworten oder wenn der Agent auf eine Triggerphrase wartet, um ein neues Thema zu beginnen.

Sie können die Standard-Timeouts für Themen konfigurieren.

Zum Überschreiben des Standards für einen Knoten:

Symbol Mehr im (…) des Knotens auswählen und dann Eigenschaften auswählen.

Der Bereich Frageeigenschaften wird geöffnet.

Wählen Sie Voice aund und nehmen Sie die folgenden Einstellungen vor:

Timeout-Option für Stilleerkennung Beschreibung Agenteinstellungen verwenden Knoten verwendet die globale Einstellung zur Stilleerkennung. Für diesen Knoten deaktivieren Der Agent wartet unbegrenzt auf eine Antwort. Millisekunden anpassen Der Agent wartet eine bestimmte Zeit, bevor er die Frage wiederholt.

Ausweichaktion

Sie können einige Verhaltensweisen als Fallback-Aktion konfigurieren:

- Wie oft der Agent eine Frage wiederholen soll

- Was die erneute Eingabeaufforderung enthalten soll

- Was der Agent nach einer bestimmten Anzahl an Wiederholungen tun soll

Spracheingabe

Für die Spracheingabe können Sie angeben:

- Zeitüberschreitung am Ende der Äußerung: Wie lange der Agent wartet, nachdem der Benutzer zu Ende gesprochen hat

- Spracherkennungs-Zeitüberschreitung: Wie viel Zeit der Agent dem Benutzer einräumt, sobald er zu antworten beginnt

Um das Verhalten der Stilleerkennung zu konfigurieren, wenn Ihr Agent auf eine Auslösephrase wartet, passen Sie die Einstellungen im Bei Stille Systemthema an.

Eine Meldung zur Latenz für einen zeitintensiven Vorgang hinzufügen

Bei langen Back-End-Vorgängen kann Ihr Agent eine Nachricht an die Benutzenden senden, um sie über die längeren Prozesse zu informieren. Agenten in einem Messaging-Kanal können ebenfalls eine Latenznachricht senden.

| Latenznachrichten-Audiowiedergabe | Latenzmeldung im Chat |

|---|---|

| Die Schleife wird fortgesetzt, bis der Vorgang abgeschlossen ist. | Wird nur einmal gesendet, wenn die angegebene Latenz erreicht wird. |

In Copilot Studio kann Ihr Agent eine Nachricht wiederholen, nachdem er einen Power Automate Flow ausgelöst hat:

Fügen Sie einen Aktion-Knoten hinzu, der einen Flow auslöst.

Symbol Mehr im (…) des Knotens auswählen und dann Eigenschaften auswählen. Der Bereich Aktionseigenschaften wird geöffnet.

Wählen Sie Nachricht senden.

Geben Sie in das Textfeld ein, was der Agent sagen soll. Sie können SSML verwenden, um den Ton der Nachricht zu ändern. Der Agent wiederholt die Nachricht, bis der Flow abgeschlossen ist.

Sie können einstellen, wie lange der Agent warten soll, bevor er die Nachricht wiederholt. Dies erfolgt im Abschnitt Verzögerung. Sie können eine Mindestwartezeit festlegen, auch wenn der Flow abgeschlossen ist.

Anrufbeendigung konfigurieren

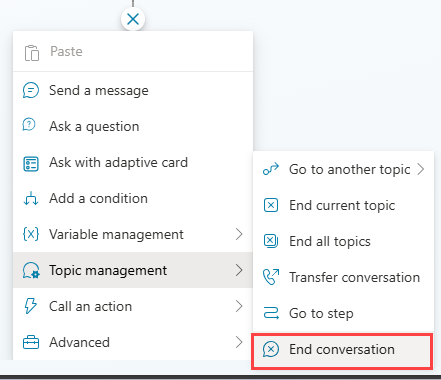

Um Ihren Agenten so zu konfigurieren, dass er den Anruf beendet und auflegt, fügen Sie einen neuen Knoten (+) hinzu und wählen Sie dann Themenverwaltung>Unterhaltung beenden aus.

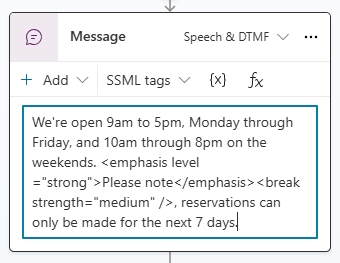

Formatieren der Sprachsynthese mit SSML

Sie können Speech Synthesis Markup Language (SSML) verwenden, um zu ändern, wie der Agent beim Vorlesen von Nachrichten klingt. So können Sie beispielsweise die Tonhöhe bzw. Frequenz der gesprochenen Wörter, die Geschwindigkeit und die Lautstärke verändern.

SSML verwendet Tags, um den zu ändernden Text einzuschließen, ähnlich wie HTML. Sie können Copilot Studio für die folgenden Aufgaben verwenden:

| SSML-Tag | Beschreibung | Link zur Dokumentation des Sprachdiensts |

|---|---|---|

<audio src="_URL to an audio file_"/> |

Fügen Sie innerhalb des Tags die URL zu einer Audiodatei hinzu. Der Agentenbenutzende muss auf die Datei zugreifen können. | Aufgezeichnetes Audio hinzufügen |

<break /> |

Fügen Sie Pausen oder Unterbrechungen zwischen Wörtern ein. Fügen Sie Unterbrechungsoptionen innerhalb des Tags ein. | Pause hinzufügen |

<emphasis>

Text, den Sie ändern möchten</emphasis> |

Fügen Sie Wörtern oder Sätzen Stress hinzu. Fügen Sie im öffnenden Tag Hervorhebungsoptionen hinzu. Fügen Sie das schließende Tag nach dem Text hinzu, den Sie ändern möchten. | Hervorhebungsoptionen anpassen |

<prosody>

Text, den Sie ändern möchten</prosody> |

Geben Sie Änderungen an Tonhöhe, Kontur, Bereich, Rate und Lautstärke an. Fügen Sie Prosodie-Optonen im öffnenden Tag hinzu. Fügen Sie das schließende Tag nach dem Text hinzu, den Sie ändern möchten. | Prosodie-Optionen anpassen |

<lang xml:lang="xx-XX">

Text, den Sie ändern möchten</lang> |

Passen Sie die Sprechsprache innerhalb derselben Nachricht an, wenn Sie eine mehrsprachige neuronale Stimme verwenden. | Anpassen der Sprachen |

Anmerkung

Wenn Sie das <audio src="_URL to an audio file_"/> Tag verwenden und die URL in einer Variablen gespeichert ist, muss die URL codiert werden, bevor sie in das Audio src SSML-Tag in der Nachricht eingefügt wird. Es wird empfohlen, die EncodeHTML PowerFx-Funktion zum Codieren der URL zu verwenden, wenn sie einer Variablen in der Aktion Zuweisen zugewiesen wird.

Suchen und Verwenden eines Tags

SSML verwendet Tags, um den zu ändernden Text einzuschließen, ähnlich wie HTML.

Sie können Copilot Studio für die folgenden Aufgaben verwenden:

Mit einem ausgewählten Nachrichten oder Frage-Knoten legen Sie die gewünschte Modalität auf Sprache und MFV fest.

Wählen Sie das Menü SSML-Tags und wählen Sie dann ein Tag aus.

Das Nachrichtenfeld wird mit dem Tag gefüllt. Wenn das Nachrichtenfeld bereits Text enthält, wird der Code des Tags an das Ende Ihrer Nachricht angehängt.

Umgeben Sie den Text, den Sie ändern möchten, mit den öffnenden und schließenden Tags. Dabei können Sie mehrere Tags kombinieren und einzelne Teile der Nachricht durch individuelle Tags individualisieren.

Tipp

Sie können SSML-Tags, die nicht im Hilfsmenü angezeigt werden, manuell eingeben. Weitere Informationen zu anderen verwendbaren Tags finden Sie unter Verbessern Sie die Synthese mit Speech Synthesis Markup Language.

Anruf an einen Mitarbeitenden oder an eine externe Telefonnummer weiterleiten

Erlauben Sie Agenten, den Anruf an eine externe Telefonnummer weiterzuleiten. In Copilot Studio wird die Blindweiterleitung an eine PSTN-Telefonnummer und die direkte Routing-Nummer unterstützt.

Anrufweiterleitung an externe Telefonnummer:

Fügen Sie in der Thema, die Sie ändern möchten, einen neuen Knoten (+) hinzu. Wählen Sie im Knotenmenü Themenverwaltung und wählen Sie dann Unterhaltung übertragen.

Wählen Sie unter Weiterleitungsart die Option Externe Rufnummernweiterleitung aus und geben Sie die Weiterleitungsnummer ein.

(Optional) Fügen Sie Telefonanruf einen SIP-UUI-Header hinzu.

Dieser Header ist eine Zeichenfolge aus

key=value-Paaren ohne Leerzeichen oder Sonderzeichen, die für das Lesen durch externe Systeme angezeigt wird.Symbol Mehr im (…) des Knotens auswählen und dann Eigenschaften auswählen. Der Bereich Unterhaltungseigenschaften übertragen wird geöffnet.

Geben Sie unter SIP-UUI-Header die Informationen ein, die Sie mit der Anrufweiterleitung senden möchten. Bei der Weiterleitung auf eine externe Rufnummer werden Variablen nicht unterstützt.

Vorsicht

Es werden nur die ersten 128 Zeichen der Zeichenfolge gesendet.

In der Kopfzeile sind nur Zahlen, Buchstaben, Gleichheitszeichen (

=) und Semikolons (;) zulässig. Alle anderen Zeichen, einschließlich Leerzeichen, Klammern und eckige Klammern sowie Formeln werden nicht unterstützt und können dazu führen, dass die Übertragung fehlschlägt.

Tipp

Fügen Sie in Ihrer Telefonnummer ein + für die entsprechende Landesvorwahl ein.

Für die ausgehende Übertragung mit SIP-UUI für die Zieltelefonnummer muss das direkte Routing verwendet werden. Telefonnummern im öffentlichen Telefonnetz (PSTN) unterstützen keine SIP-UUI-Header-Übertragungen.

Informationen zum Übertragen an einen Mitarbeitenden finden Sie unter Explizite Trigger.

Nur Voice-Variablen

Copilot Studio unterstützt die Besetzung von Variablen. Sie können vordefinierte Variablen verwenden oder benutzerdefinierte erstellen.

Anmerkung

- Weitere Informationen über die Verwendung und Erstellung von Variablen in Copilot Studio finden Sie unter Mit Variablen arbeiten.

- Informationen zu zusätzlichen Aktivitäts- und Unterhaltungsvariablen, die für sprachaktivierte Agenten verfügbar sind, finden Sie unter Variablen für sprachaktivierte Agenten.

Ein sprachaktivierter Agent in Copilot Studio unterstützt Kontextvariablen. Mithilfe dieser Variablen können Sie Ihre Agentenunterhaltungen beim Weiterleiten eines Falls in Dynamics 365 Customer Service integrieren.

Weitere Informationen zu Kontextvariablen in Dynamics 365 Customer Service finden Sie unter Kontextvariablen für Copilot Studio Bots.

Diese Integration unterstützt diese Szenarios mit den folgenden Variablen beim Übertragen:

| Variable | typ | Beschreibung |

|---|---|---|

System.Activity.From.Name |

String | Die Anrufer-ID des Agentenbenutzenden |

System.Activity.Recipient.Name |

String | Die Nummer, die zum Anrufen oder zum Herstellen einer Verbindung mit dem Agenten verwendet wird |

System.Conversation.SipUuiHeaderValue |

String | SIP-Headerwert bei der Weiterleitung über eine direkt weitergeleitete Rufnummer |

System.Activity.UserInputType |

String | Ob der Agent-Benutzer DTMF oder Sprache in der Unterhaltung verwendet hat |

System.Activity.InputDTMFKey |

String | Die unformatierte MFV-Eingabe des Agentenbenutzenden |

System.Conversation.OnlyAllowDTMF |

Boolesch | Wenn die Einstellung auf true gesetzt ist, ignoriert Voice die Spracheingabe |

System.Activity.SpeechRecognition.Confidence |

Number | Der Konfidenzwert (zwischen 0 und 1) des letzten Spracherkennungsereignisses |

System.Activity.SpeechRecognition.MinimalFormattedText |

String | Spracherkennungsergebnisse (als Rohtext) vor Copilot Studio Anwendung des speziellen Modells zum Verständnis natürlicher Sprache |

Anmerkung

- Die Veröffentlichung eines Agenten mit langen Triggerausdrücken und Entitätsdimensionierungen dauert länger.

- Wenn mehrere Benutzende denselben Agenten gleichzeitig veröffentlichen, wird Ihre Veröffentlichungsaktion blockiert. Sie müssen den Agent erneut veröffentlichen, nachdem andere ihre vorhandenen Änderungen am Agenten abgeschlossen haben.

Weitere Informationen zu den Grundlagen der Veröffentlichung finden Sie unter Hauptkonzepte: Veröffentlichen und Bereitstellen des Agents.