Hinzufügen und Verwalten einer Ereignisquelle in einem Ereignisstream

Nachdem Sie einen Eventstream erstellt haben, können Sie ihn mit verschiedenen Datenquellen und Zielen verbinden.

Hinweis

Erweiterte Funktionen sind standardmäßig aktiviert, wenn Sie jetzt Eventstreams erstellen. Wenn Sie Ereignisstreams haben, die mit Standardfunktionen erstellt wurden, funktionieren diese Ereignisstreams weiterhin. Sie können sie weiterhin wie gewohnt bearbeiten und verwenden. Es wird empfohlen, einen neuen Eventstream zu erstellen, um Standardeventstreams zu ersetzen, damit Sie zusätzliche Funktionen und Vorteile erweiterter Eventstreams nutzen können.

Nachdem Sie einen Ereignisstream erstellt haben, können Sie ihn mit verschiedenen Datenquellen und Zielen verbinden.

Mit Eventstream können Sie nicht nur Daten aus Microsoft-Quellen streamen, sondern auch die Aufnahme von Drittanbieterplattformen wie Google Cloud und Amazon Kinesis mit neuen Messaging-Connectors unterstützen. Diese erweiterte Funktion bietet eine nahtlose Integration externer Datenströme in Fabric und bietet eine größere Flexibilität und ermöglicht es Ihnen, Echtzeiteinblicke aus mehreren Quellen zu erhalten.

In diesem Artikel erfahren Sie mehr über die Ereignisquellen, die Sie einem Eventstream hinzufügen können.

Voraussetzungen

- Zugriff auf einen Arbeitsbereich im Fabric-Kapazitätslizenzmodus (oder) im Testlizenzmodus mit der Berechtigungsstufe „Mitwirkender“ oder höher.

- Voraussetzungen, die für jede Quelle spezifisch sind, die in den folgenden quellspezifischen Artikeln dokumentiert sind.

Unterstützte Quellen

Fabric-Ereignisstreams mit erweiterten Funktionen unterstützen die folgenden Quellen. Jeder Artikel enthält Details und Anweisungen zum Hinzufügen bestimmter Quellen.

| Quellen | Beschreibung |

|---|---|

| Azure Data Explorer | Wenn Sie über eine Azure Data Explorer-Datenbank und eine Tabelle verfügen, können Sie Daten aus der Tabelle mithilfe von Eventstream in Microsoft Fabric erfassen. |

| Azure Event Hubs | Wenn Sie über einen Azure Event Hub verfügen, können Sie Event Hub-Daten mithilfe von Eventstream in Microsoft Fabric erfassen. |

| Azure Event Grid | Wenn Sie über einen Azure Event Grid-Namespace verfügen, können Sie MQTT- oder Nicht-MQTT-Ereignisdaten mithilfe von Eventstream in Microsoft Fabric erfassen. |

| Azure Service Bus (Vorschau) | Sie können Daten aus einer Azure Service Bus-Warteschlange oder dem Abonnement eines Themas mithilfe von Eventstream in Microsoft Fabric erfassen. |

| Azure IoT Hub | Wenn Sie über einen Azure IoT Hub verfügen, können Sie IoT-Daten mithilfe von Eventstream in Microsoft Fabric erfassen. |

| Benutzerdefinierter Endpunkt (d. h. benutzerdefinierte App mit Standardfunktionalität) | Mit dem Feature für einen benutzerdefinierten Endpunkt können Ihre Anwendungen oder Kafka-Clients mithilfe einer Verbindungszeichenfolge eine Verbindung mit Eventstream herstellen – dies ermöglicht die reibungslose Erfassung von Streamingdaten in Eventstream. |

| Beispieldaten | Um beim Einrichten eines Ereignisstreams die Datenerfassung zu testen, können Sie Fahrräder, Yellow Taxi oder Börsenevents als Beispieldatenquelle auswählen. |

| Echtzeitwetter | Sie können einem Eventstream eine Echtzeit-Wetterquelle hinzufügen, um Wetterdaten aus verschiedenen Standorten in Echtzeit zu streamen. |

| Azure SQL Datenbank Change Data Capture (CDC) | Der Azure SQL-Datenbank CDC Source Connector ermöglicht Ihnen das Erfassen einer Momentaufnahme der aktuellen Daten in einer Azure SQL-Datenbank. Künftige Änderungen an diesen Daten auf Zeilenebene werden dann vom Konnektor überwacht und aufgezeichnet. |

| PostgreSQL Datenbank CDC | Der Postgre SQL-Datenbank Change Data Capture (CDC)-Quellconnector ermöglicht es Ihnen, eine Momentaufnahme der aktuellen Daten in einer PostgreSQL-Datenbank zu erfassen. Künftige Änderungen an diesen Daten auf Zeilenebene werden dann vom Konnektor überwacht und aufgezeichnet. |

| MySQL Datenbank CDC | Mit dem Azure My SQL-Datenbank Change Data Capture (CDC)-Quellconnector können Sie eine Momentaufnahme der aktuellen Daten in einer Azure-Datenbank für MySQL-Datenbank erfassen. Sie können die zu überwachenden Tabellen angeben, und der Eventstream zeichnet alle zukünftigen Änderungen auf Zeilenebene in den Tabellen auf. |

| Azure Cosmos DB CDC | Mit dem Azure Cosmos DB Change Data Capture (CDC)-Quellen-Konnektor für Microsoft Fabric-Eventstreams können Sie eine Momentaufnahme der aktuellen Daten in einer Azure Cosmos DB-Datenbank erfassen. Künftige Änderungen an diesen Daten auf Zeilenebene werden dann vom Konnektor überwacht und aufgezeichnet. |

| SQL Server auf CDC der Datenbank (DB) der virtuellen Maschine (VM) | Der Source Connector des SQL Server auf VM DB (CDC) für Fabric-Eventstreams ermöglicht es Ihnen, einen Snapshot der aktuellen Daten in einer SQL-Serverdatenbank auf einer VM zu erfassen. Künftige Änderungen an den Daten auf Zeilenebene werden dann vom Konnektor überwacht und erfasst. |

| Azure SQL Managed Instance CDC | Der CDC Source Connector der Azure SQL Managed Instance für Microsoft Fabric-Eventstreams ermöglicht es Ihnen, einen Snapshot der aktuellen Daten in einer SQL Managed Instance-Datenbank zu erfassen. Künftige Änderungen an diesen Daten auf Zeilenebene werden dann vom Konnektor überwacht und aufgezeichnet. |

| Fabric-Arbeitsbereichselement-Ereignisse | Fabric-Arbeitsbereichselement-Ereignisse sind diskrete Fabric-Ereignisse, die auftreten, wenn Änderungen an Ihrem Fabric-Arbeitsbereich vorgenommen werden. Zu diesen Änderungen gehören das Erstellen, Aktualisieren oder Löschen eines Fabric-Artikels. Mit Fabric-Eventstreams können Sie diese Fabric-Arbeitsbereichsereignisse erfassen, transformieren und zur weiteren Analyse an verschiedene Ziele in Fabric weiterleiten. |

| Fabric OneLake-Ereignisse | Mit OneLake-Ereignissen können Sie Änderungen an Dateien und Ordnern in OneLake abonnieren und dann in Echtzeit auf diese Änderungen reagieren. Mit Fabric-Ereignisstreams können Sie diese OneLake-Ereignisse erfassen, transformieren und zur weiteren Analyse an verschiedene Ziele in Fabric weiterleiten. Dank dieser nahtlosen Integration von OneLake-Events in Fabric-Eventstreams haben Sie eine größere Flexibilität bei der Überwachung und Analyse von Aktivitäten in OneLake. |

| Fabric Auftragsereignisse | Auftragsereignisse ermöglichen es Ihnen, Benachrichtigungen über Änderungen zu abonnieren, die erzeugt werden, wenn Fabric einen Auftrag ausführt. Sie können beispielsweise beim Aktualisieren eines Semantikmodells, beim Ausführen einer geplanten Pipeline oder beim Ausführen eines Notizbuchs auf Änderungen reagieren. Jede dieser Aktivitäten kann einen entsprechenden Auftrag generieren, der wiederum eine Reihe entsprechender Auftragsereignisse generiert. Mit den Ereignisstreams von Fabric können Sie diese Job-Ereignisse erfassen, transformieren und zur weiteren Analyse an verschiedene Ziele innerhalb von Fabric weiterleiten. Diese nahtlose Integration von Jobereignissen in Fabric-Ereignisstreams bietet Ihnen eine größere Flexibilität beim Überwachen und Analysieren von Aktivitäten in Ihrem Job. |

| Azure Blob Storage-Ereignisse | Azure Blob Storage-Ereignisse werden ausgelöst, wenn ein Client einen Blob erstellt, ersetzt oder löscht. Mit dem Connector können Sie Blob Storage-Ereignisse mit Fabric-Ereignissen im Echtzeithub verknüpfen. Sie können diese Ereignisse in fortlaufende Streams konvertieren und sie transformieren, bevor Sie sie an verschiedene Ziele in Fabric weiterleiten. |

| Google Cloud Pub/Sub | Google Pub/Sub ist ein Messaging-Dienst, mit dem Sie Datenströme von Ereignissen veröffentlichen und abonnieren können. Sie können Google Pub/Sub als Quelle zu Ihrem Eventstream hinzufügen, um Echtzeitereignisse zu erfassen, zu transformieren und zu verschiedenen Zielen in Fabric zu leiten. |

| Amazon Kinesis Data Streams | Amazon Kinesis Data Streams ist ein massiv skalierbarer, äußerst langlebiger Datenaufnahme- und Verarbeitungsdienst, der für Streamingdaten optimiert ist. Durch die Integration von Amazon Kinesis Data Streams als Quelle in Ihren Eventstream können Sie Echtzeit-Streams nahtlos verarbeiten, bevor Sie sie an mehrere Ziele innerhalb von Fabric weiterleiten. |

| Confluent Cloud Kafka | Confluent Cloud Kafka ist eine Streaming-Plattform, die leistungsstarkes Streaming und Verarbeitungsfunktionen mit Apache Kafka bietet. Durch die Integration von Confluent Cloud Kafka als Quelle in Ihren Eventstream können Sie Echtzeit-Streams nahtlos verarbeiten, bevor Sie sie an mehrere Ziele innerhalb von Fabric weiterleiten. |

| Apache Kafka (Vorschau) | Apache Kafka ist eine verteilte Open-Source-Plattform zum Erstellen skalierbarer Systeme mit Echtzeitdaten. Durch die Integration von Apache Kafka als Quelle in Ihren Eventstream können Sie Echtzeitereignisse aus Ihrem Apache Kafka nahtlos mitbringen und verarbeiten, bevor Sie sie an mehrere Ziele innerhalb von Fabric weiterleiten. |

| Amazon MSK Kafka | Amazon MSK Kafka ist ein vollständig verwalteter Kafka-Dienst, der die Einrichtung, Skalierung und Verwaltung vereinfacht. Durch die Integration von Amazon MSK Kafka als Quelle in Ihren Eventstream können Sie die Echtzeitereignisse nahtlos aus Ihrem MSK Kafka übertragen und verarbeiten, bevor Sie sie an mehrere Ziele innerhalb von Fabric weiterleiten. |

| MQTT | Mit Microsoft Fabric-Eventstreams können Sie eine Verbindung mit einem MQTT-Broker herstellen, bei dem Nachrichten im MQTT-Broker in Fabric Eventstream aufgenommen und an verschiedene Ziele innerhalb von Fabric weitergeleitet werden. |

| Solace PubSub+ | Mit Microsoft Fabric-Eventstreams können Sie eine Verbindung mit Solace PubSub+ herstellen, sodass Nachrichten von Solace PubSub+ in Fabric Eventstream aufgenommen und an verschiedene Ziele in Fabric weitergeleitet werden können. |

Hinweis

Die maximale Anzahl der Quellen und Ziele für einen Eventstream beträgt 11.

Zugehöriger Inhalt

Voraussetzungen

Bevor Sie beginnen, müssen die folgenden Voraussetzungen erfüllt sein:

- Zugriff auf einen Arbeitsbereich im Fabric-Kapazitätslizenzmodus (oder) im Testlizenzmodus mit der Berechtigungsstufe „Mitwirkender“ oder höher.

- Um eine Azure Event Hubs- oder Azure IoT Hub-Instanz als Ereignisstreamquelle hinzuzufügen, benötigen Sie die entsprechende Berechtigung für den Zugriff auf die zugehörigen Richtlinienschlüssel. Diese müssen öffentlich zugänglich sein und dürfen sich nicht hinter einer Firewall befinden oder in einem virtuellen Netzwerk geschützt sein.

Unterstützte Quellen

Die folgenden Quellen werden von Fabric-Eventstreams unterstützt. Über die Links in der Tabelle können Sie zu Artikeln navigieren, die weitere Details zum Hinzufügen bestimmter Quellen enthalten.

| Quellen | Beschreibung |

|---|---|

| Azure Event Hubs | Wenn Sie über einen Azure Event Hub verfügen, können Sie Event Hub-Daten mithilfe von Eventstream in Microsoft Fabric erfassen. |

| Azure IoT Hub | Wenn Sie über einen Azure IoT Hub verfügen, können Sie IoT-Daten mithilfe von Eventstream in Microsoft Fabric erfassen. |

| Beispieldaten | Um beim Einrichten eines Ereignisstreams die Datenerfassung zu testen, können Sie Fahrräder, Yellow Taxi oder Börsenevents als Beispieldatenquelle auswählen. |

| Benutzerdefinierte App | Mit dem Feature für eine benutzerdefinierte App können Ihre Anwendungen oder Kafka-Clients mithilfe einer Verbindungszeichenfolge eine Verbindung mit Eventstream herstellen – dies ermöglicht die reibungslose Erfassung von Streamingdaten in Eventstream. |

Hinweis

Die maximale Anzahl der Quellen und Ziele für einen Eventstream beträgt 11.

Verwalten einer Quelle

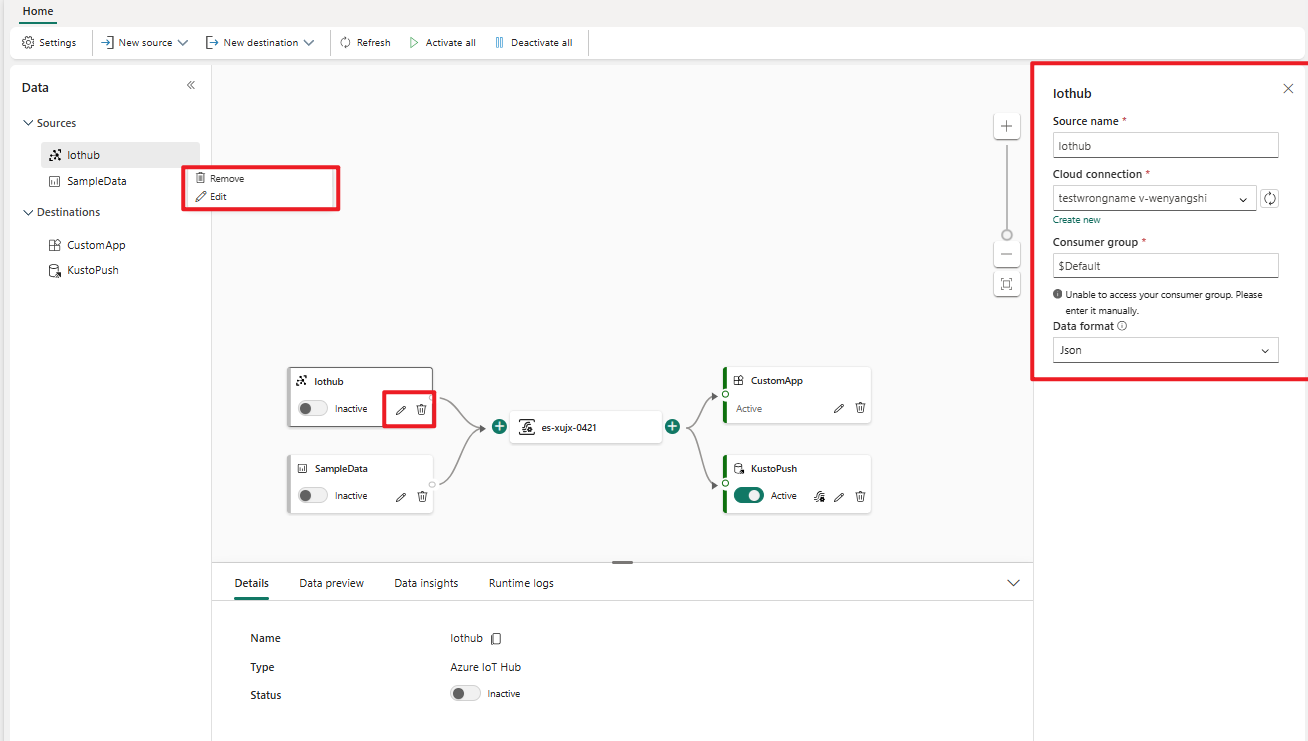

Bearbeiten/Entfernen: Sie können eine Ereignisstreamquelle entweder über den Navigationsbereich oder die Canvas auswählen, um sie zu bearbeiten oder zu entfernen. Wenn Sie Bearbeiten auswählen, wird der Bearbeitungsbereich rechts im Haupt-Editor geöffnet.

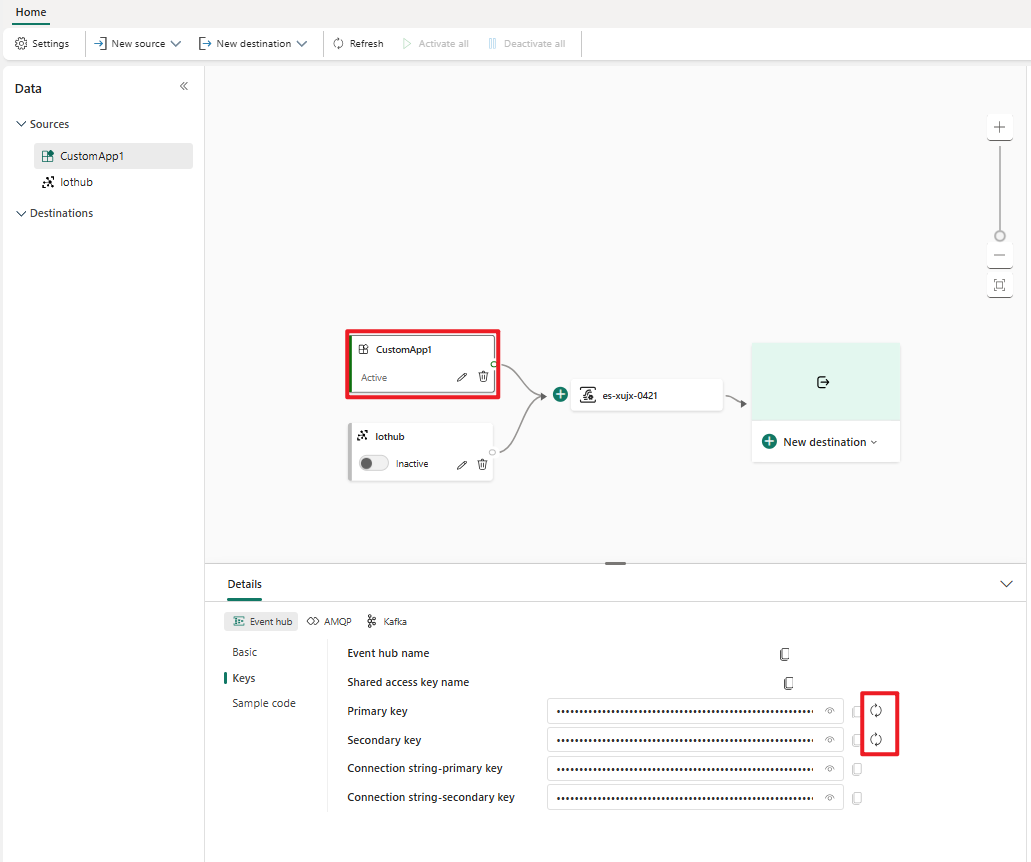

Schlüssel für eine benutzerdefinierte App erneut generieren: Wenn Sie einen neuen Verbindungsschlüssel für Ihre Anwendung erneut generieren möchten, wählen Sie eine Ihrer benutzerdefinierten App-Quellen in der Canvas aus, und wählen Sie Erneut generieren aus, um einen neuen Verbindungsschlüssel zu erhalten.