Was ist verantwortungsvolle KI?

GILT FÜR: Azure CLI ML-Erweiterung v2 (aktuell)

Azure CLI ML-Erweiterung v2 (aktuell) Python SDK azure-ai-ml v2 (aktuell)

Python SDK azure-ai-ml v2 (aktuell)

Verantwortungsvolle künstliche Intelligenz (KI) ist ein Ansatz für die Entwicklung, Bewertung und Bereitstellung von KI-Systemen auf eine sichere, vertrauenswürdige und ethische Weise. KI-Systeme sind das Ergebnis vieler Entscheidungen derjenigen, die sie entwickeln und bereitstellen. Vom Zweck des Systems bis hin zur Art und Weise, wie Menschen mit KI-Systemen interagieren, kann verantwortungsvolle KI dabei helfen, diese Entscheidungen proaktiv auf vorteilhaftere und gerechtere Ergebnisse auszurichten. Das bedeutet, dass wir den Menschen und seine Ziele in den Mittelpunkt der Entscheidungen über die Systemgestaltung stellen und dauerhafte Werte wie Fairness, Zuverlässigkeit und Transparenz respektieren.

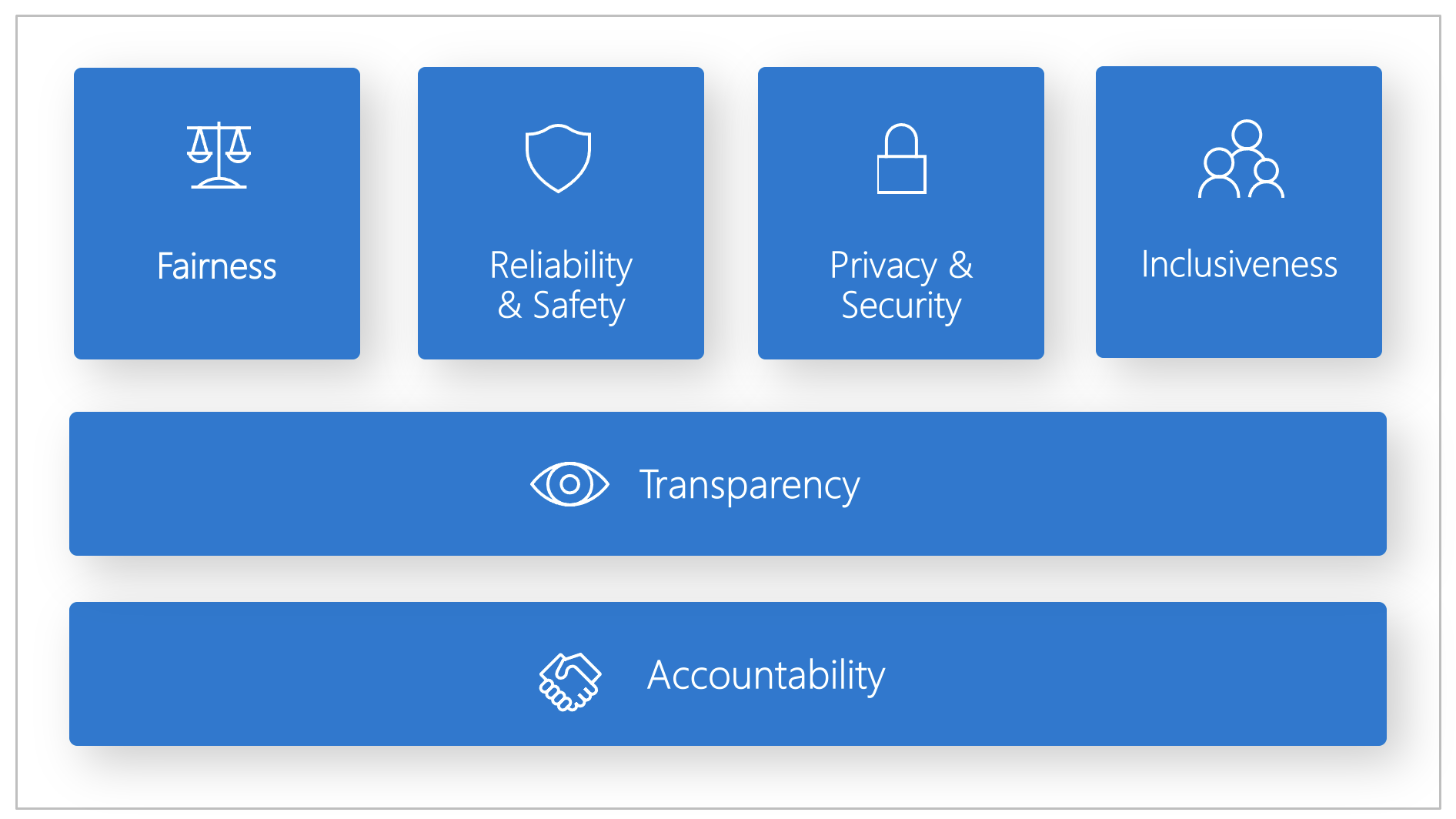

Microsoft hat einen Standard für verantwortungsvolle KI entwickelt. Dieser bildet einen Rahmen für das Erstellen von KI-Systemen gemäß sechs Prinzipien: Fairness, Zuverlässigkeit und Sicherheit, Datenschutz und Sicherheit, Inklusion, Transparenz und Verantwortlichkeit. Für Microsoft sind diese Prinzipien die Eckpfeiler eines verantwortungsbewussten und vertrauenswürdigen Umgangs mit KI, zumal intelligente Technologien in den Produkten und Diensten, die Menschen tagtäglich nutzen, immer mehr an Bedeutung gewinnen.

In diesem Artikel wird gezeigt, wie Azure Machine Learning Tools unterstützt, die es ML-Entwicklern und wissenschaftlichen Fachkräften für Daten ermöglichen, die sechs Prinzipien in der Praxis zu implementieren und zu operationalisieren.

Fairness und Inklusion

KI-Systeme sollten alle Menschen fair behandeln und vermeiden, Personengruppen in ähnlicher Lebenssituation auf unterschiedliche Weise zu beeinflussen. Wenn KI-Systeme beispielsweise Orientierungshilfe für medizinische Behandlung, Kreditanträge oder Beschäftigung bieten, sollten sie die gleichen Empfehlungen für alle Personen mit ähnlichen Symptomen, wirtschaftlichen Gegebenheiten oder beruflichen Qualifikationen abgeben.

Fairness und Inklusion in Azure Machine Learning: Die Komponente Bewertung der Fairness im Dashboard für verantwortungsvolle KI ermöglicht es wissenschaftlichen Fachkräften für Daten sowie Entwicklern, die Fairness von Modellen gegenüber sensiblen Gruppen zu bewerten, die sich über das Geschlecht, die ethnische Zugehörigkeit, das Alter und andere Eigenschaften definieren.

Zuverlässigkeit und Sicherheit

Um Vertrauen aufzubauen, ist es entscheidend, dass KI-Systeme zuverlässig, sicher und konsistent arbeiten. Diese Systeme sollten so betrieben werden können, wie sie ursprünglich entworfen wurden, bei unvorhergesehenen Bedingungen sicher reagieren und schädlichen Manipulationen trotzen. Wie sie sich verhalten und mit welchen unterschiedlichen Bedingungen sie umgehen können, spiegelt die Bandbreite der Situationen und Umstände wider, die Entwickler beim Entwerfen und Testen erwarten.

Zuverlässigkeit und Sicherheit in Azure Machine Learning: Die Komponente Fehleranalyse im Dashboard für verantwortungsvolle KI eröffnet wissenschaftlichen Fachkräften für Daten sowie Entwicklern folgende Möglichkeiten:

- Erlangen eines eingehenden Verständnisses für die Verteilung von Fehlern für ein Modell.

- Identifizieren von Kohorten (Teilmengen) von Daten mit einer höheren Fehlerrate als der Benchmark insgesamt.

Diese Abweichungen können auftreten, wenn das System oder das Modell bei bestimmten demografischen Gruppen oder selten beobachteten Eingabebedingungen in den Trainingsdaten unterdurchschnittlich abschneidet.

Transparency

Wenn KI-Systeme für Entscheidungen eingesetzt werden, die enorme Auswirkungen auf das Leben von Menschen haben, ist es wichtig, dass die Menschen verstehen, wie diese Entscheidungen getroffen wurden. Beispielsweise kann eine Bank ein KI-System zur Ermittlung der Kreditwürdigkeit einer Person einsetzen. Ein Unternehmen kann anhand eines KI-Systems die qualifiziertesten Kandidaten für eine Einstellung ermitteln.

Ein entscheidender Aspekt von Transparenz ist Verständlichkeit: die nützliche Erklärung des Verhaltens von KI-Systemen und ihren Komponenten. Um die Verständlichkeit zu verbessern, müssen die Beteiligten verstehen, wie KI-Systeme funktionieren und warum sie in dieser Weise arbeiten. Die Beteiligten können dann mögliche Leistungsprobleme, Probleme mit der Fairness, ausschließende Methoden oder unbeabsichtigte Ergebnisse identifizieren.

Transparenz in Azure Machine Learning: Die Komponenten Modellverständlichkeit und Kontrafaktisches Was-wäre-wenn im Dashboard für verantwortungsvolle KI ermöglichen es wissenschaftlichen Fachkräften für Daten sowie Entwicklern, für Menschen verständliche Beschreibungen der Vorhersagen eines Modells zu erstellen.

Die Komponente der Modellverständlichkeit bietet mehrere Einsichten in das Verhalten eines Modells:

- Globale Erklärungen. Welche Features wirken sich beispielsweise auf das Gesamtverhalten eines Kreditvergabemodells aus?

- Lokale Erklärungen. Warum wurde beispielsweise der Kreditantrag eines Kunden genehmigt oder abgelehnt?

- Modellerklärungen für eine ausgewählte Kohorte von Datenpunkten. Welche Features wirken sich beispielsweise auf das Gesamtverhalten eines Kreditvergabemodells für Antragsteller mit niedrigem Einkommen aus?

Die Komponente „Kontrafaktisches Was-wäre-wenn“ ermöglicht es, ein Machine Learning-Modell im Hinblick darauf zu verstehen und zu debuggen, wie es auf Featureänderungen und Störungen reagiert.

Azure Machine Learning unterstützt auch eine Scorecard für verantwortungsvolle KI. Bei der Scorecard handelt es sich um einen anpassbaren PDF-Bericht, den Entwickler auf einfache Weise konfigurieren, generieren, herunterladen und an technische und nicht technische Projektbeteiligte weitergeben können, um diese über die Integrität ihrer Datasets und Modelle zu informieren, Compliance zu erzielen und Vertrauen aufzubauen. Diese Scorecard kann auch bei Überprüfungen verwendet werden, um die Eigenschaften von Machine Learning-Modellen aufzudecken.

Datenschutz und -sicherheit

Mit zunehmender Verbreitung von KI wird der Schutz der Privatsphäre und die Absicherung persönlicher und geschäftlicher Informationen immer wichtiger und komplexer. Bei der KI bedürfen Fragen des Datenschutzes und der Datensicherheit besonderer Aufmerksamkeit, da der Zugang zu Daten für KI-Systeme unerlässlich ist, um genaue und fundierte Vorhersagen und Entscheidungen über Menschen zu treffen. KI-Systeme müssen datenschutzrechtlichen Bestimmungen entsprechen, die folgende Anforderungen stellen:

- Transparenz im Hinblick auf die Sammlung, Verwendung und Speicherung von Daten.

- Bereitstellen geeigneter Steuerelemente für Verbraucher, damit diese auswählen können, wie ihre Daten verwendet werden.

Datenschutz und Sicherheit in Azure Machine Learning: Azure Machine Learning ermöglicht es Administratoren und Entwicklern, eine sichere Konfiguration zu erstellen, die mit den Richtlinien ihrer Unternehmen konform ist. Mit Azure Machine Learning und der Azure-Plattform haben Benutzer folgende Möglichkeiten:

- Einschränken des Zugriffs auf Ressourcen und Vorgänge nach Benutzerkonto oder Gruppe

- Einschränken der eingehenden und ausgehenden Netzwerkkommunikation

- Verschlüsseln von Daten während der Übertragung und im Ruhezustand

- Überprüfen auf Sicherheitsrisiken

- Anwenden und Überwachen von Konfigurationsrichtlinien

Microsoft hat außerdem zwei Open-Source-Pakete erstellt, die eine weitere Implementierung der Datenschutz- und Sicherheitsprinzipien ermöglichen können:

SmartNoise: Differential Privacy umfasst eine Reihe von Systemen und Methoden, die dazu beitragen, die Daten von Einzelpersonen sicher und privat zu halten. In Machine Learning-Lösungen kann Differential Privacy erforderlich sein, um die Einhaltung gesetzlicher Bestimmungen zu gewährleisten. SmartNoise ist ein Open-Source-Projekt (mitentwickelt von Microsoft), das Komponenten für den Aufbau globaler Differential Privacy-Systeme umfasst.

Counterfit: Counterfit ist ein Open-Source-Projekt, das ein Befehlszeilentool und eine generische Automatisierungsebene umfasst, mit der Entwickler Cyberangriffe auf KI-Systeme simulieren können. Das Tool steht zum freien Download zur Verfügung und kann über Azure Cloud Shell im Browser ausgeführt oder lokal in einer Anaconda Python-Umgebung bereitgestellt werden. Es kann KI-Modelle bewerten, die in verschiedenen Cloudumgebungen, lokal oder im Edge gehostet werden. Das Tool ist unabhängig von KI-Modellen und unterstützt verschiedene Datentypen, darunter Text, Bilder oder generische Eingaben.

Verantwortlichkeit

Die Personen, die KI-Systeme entwerfen und bereitstellen, müssen dafür verantwortlich sein, wie sie ihre Systeme betreiben. Organisationen sollten sich auf Branchenstandards stützen, um Verantwortlichkeitsnormen zu entwickeln. Durch diese Normen kann sichergestellt werden, dass KI-Systeme nicht die letzte Instanz für Entscheidungen darstellen, die Menschenleben betreffen. Diese Normen können auch sicherstellen, dass Menschen eine entscheidende Kontrolle über ansonsten hoch autonome KI-Systeme behalten.

Verantwortlichkeit in Azure Machine Learning: Machine Learning Operations (MLOps) basieren auf DevOps-Prinzipien und -Praktiken, die die Effizienz von KI-Workflows erhöhen. Azure Machine Learning bietet die folgenden MLOps-Funktionen für eine bessere Verantwortlichkeit Ihrer KI-Systeme:

- Registrieren, Verpacken und Bereitstellen von Modellen von überall aus. Sie können auch die zugehörigen Metadaten nachverfolgen, die für die Verwendung des Modells erforderlich sind.

- Erfassen der Governancedaten für den vollständigen Machine Learning-Lebenszyklus. Die protokollierten Informationen zur Herkunft können umfassen, wer die Modelle veröffentlicht, warum Änderungen vorgenommen wurden und wann die Modelle bereitgestellt oder in der Produktionsumgebung verwendet wurden.

- Aktivieren von Benachrichtigungen und Warnungen im Machine Learning-Lebenszyklus. Beispiele für Ereignisse sind der Abschluss von Experimenten, die Registrierung und Implementierung von Modellen sowie die Erkennung von Datendrift.

- Überwachen von Anwendungen auf betriebsbezogene Probleme und Probleme im Zusammenhang mit maschinellem Lernen. Vergleichen Sie Modelleingaben zwischen Trainings- und Rückschlussphase, untersuchen Sie modellspezifische Metriken, und stellen Sie Überwachungsfunktionen und Warnungen für Ihre Machine Learning-Infrastruktur bereit.

Neben den MLOps-Funktionen sorgt die Scorecard für verantwortungsvolle KI in Azure Machine Learning für Verantwortlichkeit, indem sie die Kommunikation zwischen Projektbeteiligten ermöglicht. Die Scorecard stellt außerdem Verantwortlichkeit her, indem sie Entwicklern die Möglichkeit bereitstellt, ihre Erkenntnisse zur Modellintegrität zu konfigurieren, herunterzuladen und zu teilen und so ihre technischen und nicht technischen Projektbeteiligten über KI-Daten und Modellintegrität zu informieren. Die Freigabe dieser Erkenntnisse kann dazu beitragen, Vertrauen zu schaffen.

Die ML-Plattform ermöglicht außerdem die Entscheidungsfindung, indem Geschäftsentscheidungen anhand der folgenden Informationen getroffen werden:

- Datengestützte Erkenntnisse, die den Beteiligten helfen, kausale Behandlungseffekte für ein Ergebnis zu verstehen, wobei ausschließlich Verlaufsdaten verwendet werden. Beispiel: „Wie wirkt sich ein Medikament auf den Blutdruck eines Patienten aus?“ Diese Erkenntnisse werden über die Komponente Kausaler Rückschluss im Dashboard für verantwortungsvolle KI bereitgestellt.

- Modellgestützte Erkenntnisse, um die Fragen der Benutzer zu beantworten (Beispiel: „Was kann ich tun, um beim nächsten Mal ein anderes Ergebnis von Ihrer KI zu erhalten?“), damit die Benutzer Maßnahmen ergreifen können. Solche Erkenntnisse werden wissenschaftlichen Fachkräften für Daten über die Komponente Kontrafaktische Was-wäre-wenn im Dashboard für verantwortungsvolle KI zur Verfügung gestellt.

Nächste Schritte

- Weitere Informationen zur Implementierung von verantwortungsvoller KI in Azure Machine Learning finden Sie im Dashboard für verantwortungsvolle KI.

- Erfahren Sie, wie Sie das Dashboard für verantwortungsbewusste künstliche Intelligenz über CLI und SDK oder die Azure Machine Learning Studio-Benutzeroberfläche generieren.

- Erfahren Sie, wie Sie eine Scorecard für verantwortungsvolle KI auf Grundlage der im Dashboard für verantwortungsvolle KI beobachteten Erkenntnisse generieren.

- Erfahren Sie mehr über den Standard für verantwortungsvolle KI zum Erstellen von KI-Systemen gemäß den sechs Schlüsselprinzipien.