Generieren von Erkenntnissen aus verantwortungsvoller KI auf der Studio-Benutzeroberfläche

In diesem Artikel erstellen Sie ein Dashboard für verantwortungsvolle KI und eine Scorecard (Vorschau) ohne Codeerfahrung auf der Benutzeroberfläche von Azure Machine Learning Studio.

Wichtig

Dieses Feature ist zurzeit als öffentliche Preview verfügbar. Diese Vorschauversion wird ohne Vereinbarung zum Servicelevel bereitgestellt und ist nicht für Produktionsworkloads vorgesehen. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar.

Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

Gehen Sie wie folgt vor, um auf den Assistenten für die Dashboardgenerierung zuzugreifen und ein Dashboard für verantwortungsvolle KI zu generieren:

Registrieren Sie Ihr Modell in Azure Machine Learning, damit Sie auf die No-Code-Erfahrung zugreifen können.

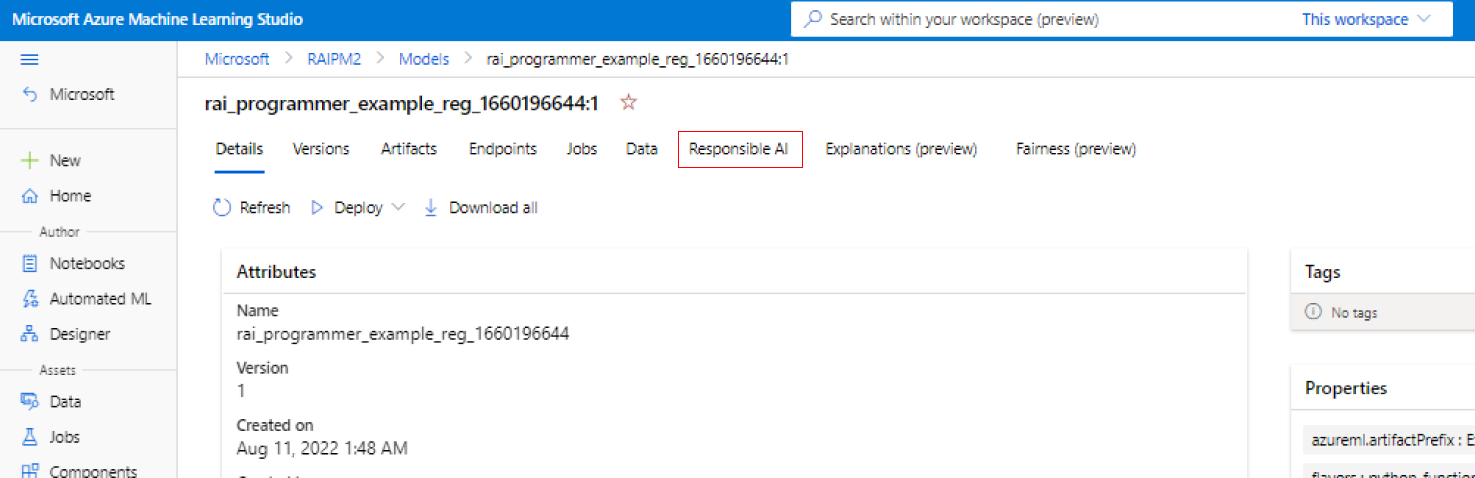

Wählen Sie im linken Bereich von Azure Machine Learning Studio die Registerkarte Modelle aus.

Wählen Sie das registrierte Modell aus, für das Sie Responsible AI Insights erstellen möchten, und wählen Sie dann die Registerkarte Details aus.

Wählen Sie Dashboard für verantwortungsvolle KI erstellen (Vorschau) aus.

Weitere Informationen zu unterstützten Modelltypen und Einschränkungen im Dashboard für verantwortungsvolle KI finden Sie unter Unterstützte Szenarien und Einschränkungen.

Der Assistent bietet eine Schnittstelle zur Eingabe aller erforderlichen Parameter, um Ihr Responsible AI-Dashboard zu erstellen, ohne Code berühren zu müssen. Die Erfahrung findet vollständig in der Benutzeroberfläche von Azure Machine Learning Studio statt. Das Studio präsentiert einen geführten Ablauf und einen Anleitungstext, um die Vielfalt der Auswahlmöglichkeiten darüber, mit welchen Komponenten der verantwortungsvollen KI Sie Ihr Dashboard füllen möchten, in einen Kontext zu setzen.

Der Assistent ist in fünf Abschnitte unterteilt:

- Trainingsdatasets

- Testdataset

- Modellierungsaufgabe

- Dashboardkomponenten

- Komponentenparameter

- Experimentkonfiguration

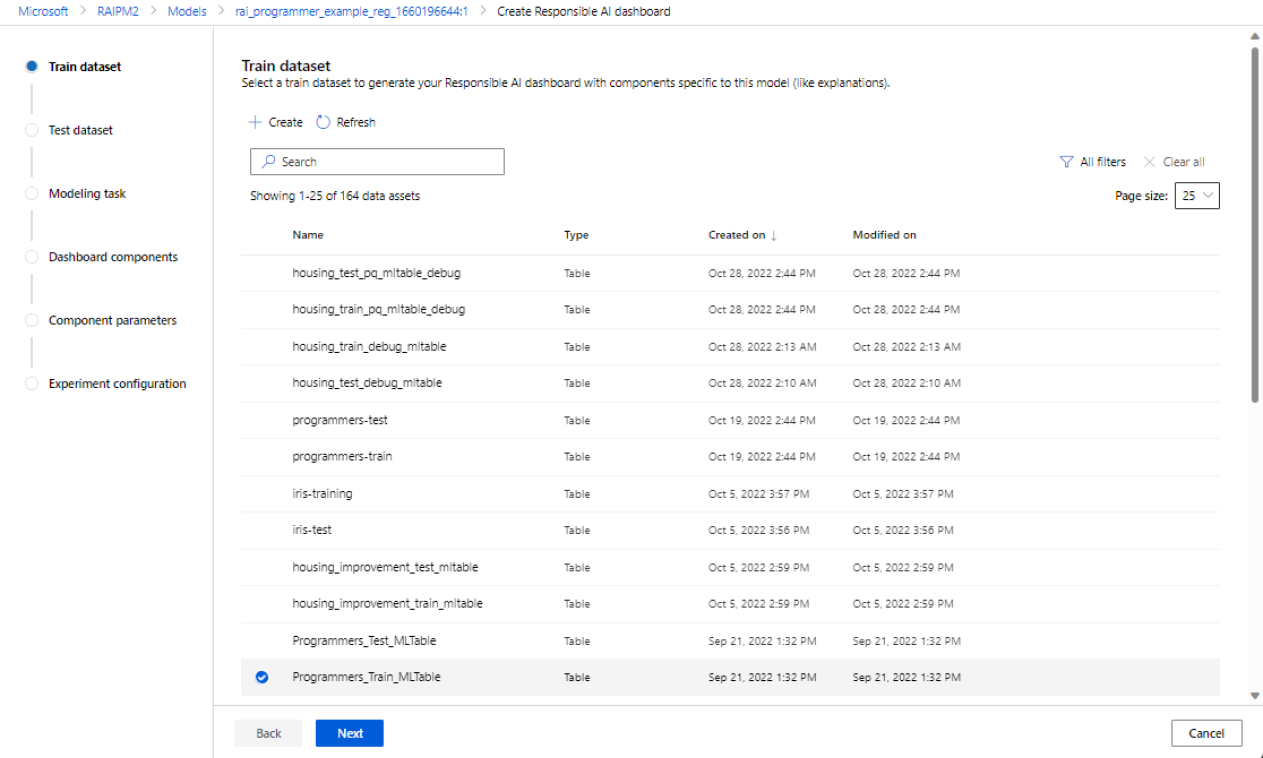

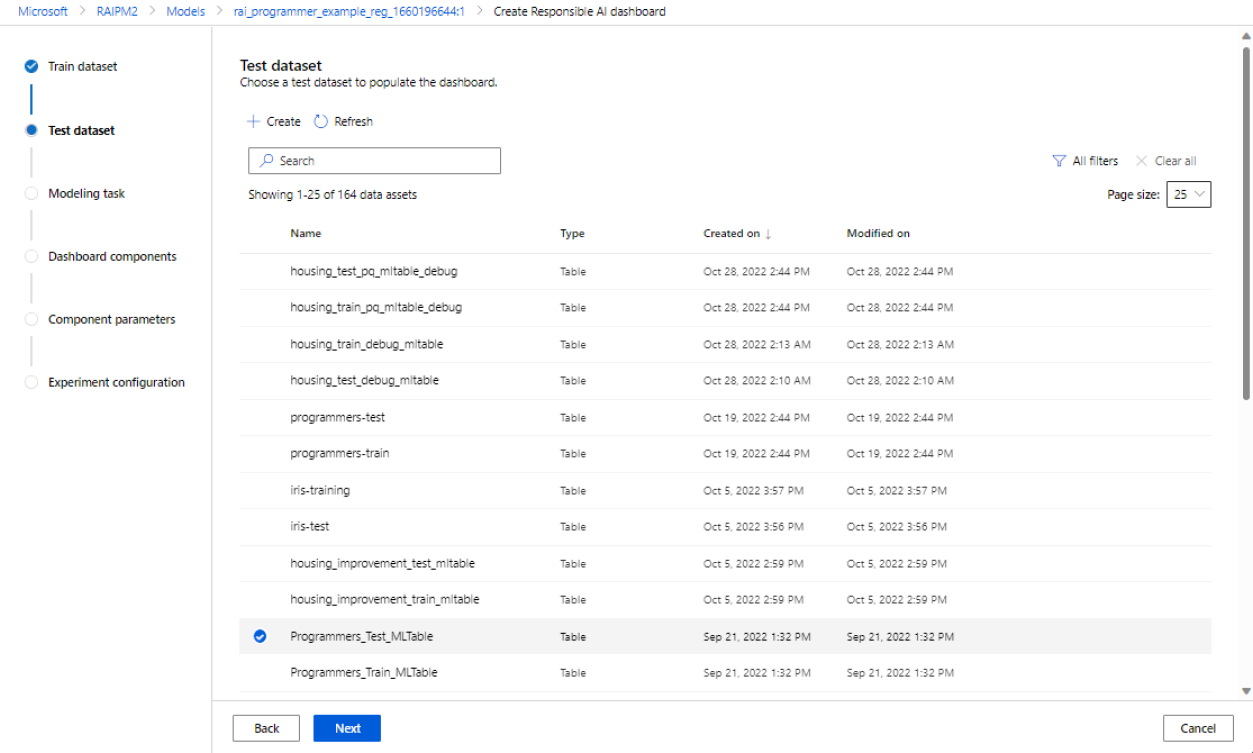

Auswählen Ihrer Datasets

In den ersten beiden Abschnitten wählen Sie die Trainings- und Testdatasets aus, die Sie beim Trainieren Ihres Modells zum Generieren von Erkenntnissen zum Debuggen des Modells verwendet haben. Für Komponenten wie die Kausalanalyse, für die kein Modell erforderlich ist, verwenden Sie das Train-Dataset, um das Kausalmodell zu trainieren, um die kausalen Erkenntnisse zu generieren.

Hinweis

Es werden nur tabellarische Datasetformate in MLTable unterstützt.

Wählen Sie ein Dataset für das Training aus: Wählen Sie in der Liste der registrierten Datasets im Azure Machine Learning-Arbeitsbereich das Dataset aus, das Sie verwenden möchten, um Erkenntnisse hinsichtlich der verantwortungsvollen KI für Komponenten zu generieren, z. B. Modellerklärungen und Fehleranalysen.

Wählen Sie einen Datensatz zum Testen aus: Wählen Sie in der Liste den Datensatz aus, den Sie verwenden möchten, um Ihre Visualisierungen zum Dashboard für verantwortungsvolle KI zu füllen.

Wenn das Trainings- oder Testdataset, das Sie verwenden möchten, nicht aufgeführt ist, wählen Sie Erstellen aus, um es hochzuladen.

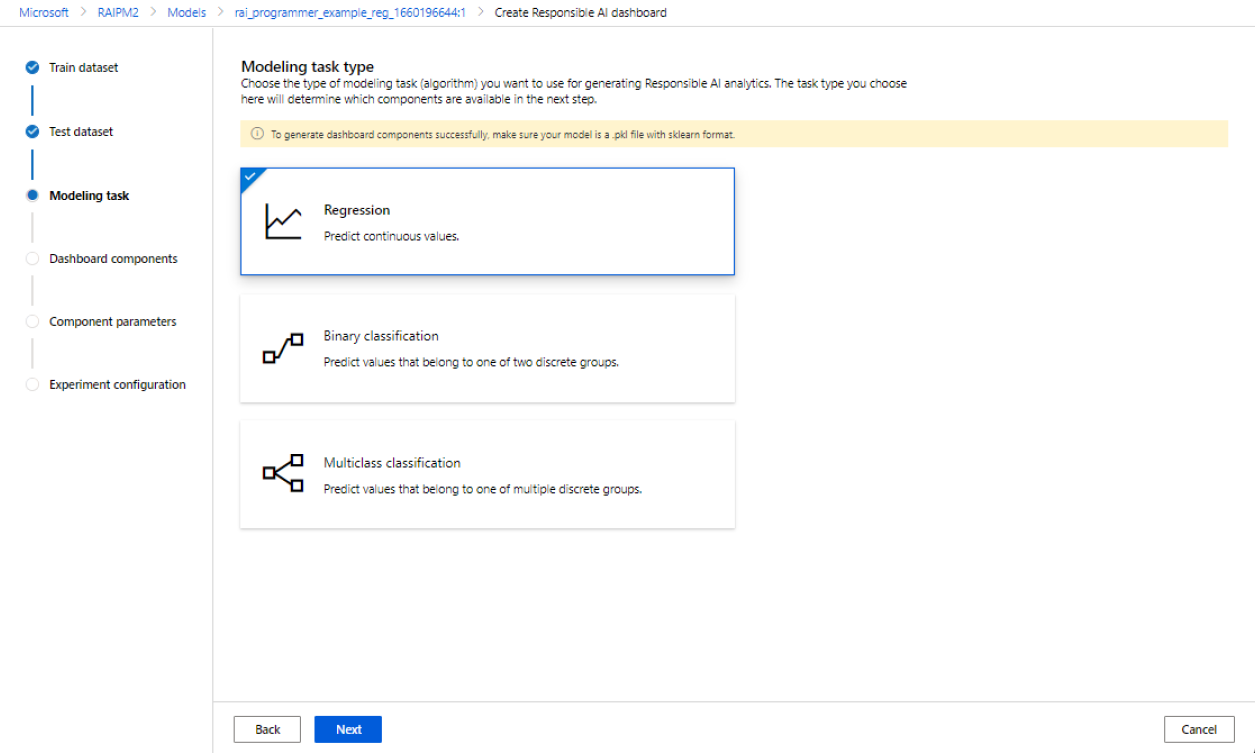

Auswählen Ihrer Modellierungsaufgabe

Nachdem Sie Ihre Datasets ausgewählt haben, wählen Sie Ihren Modellierungsaufgabentyp aus, wie in der folgenden Abbildung gezeigt:

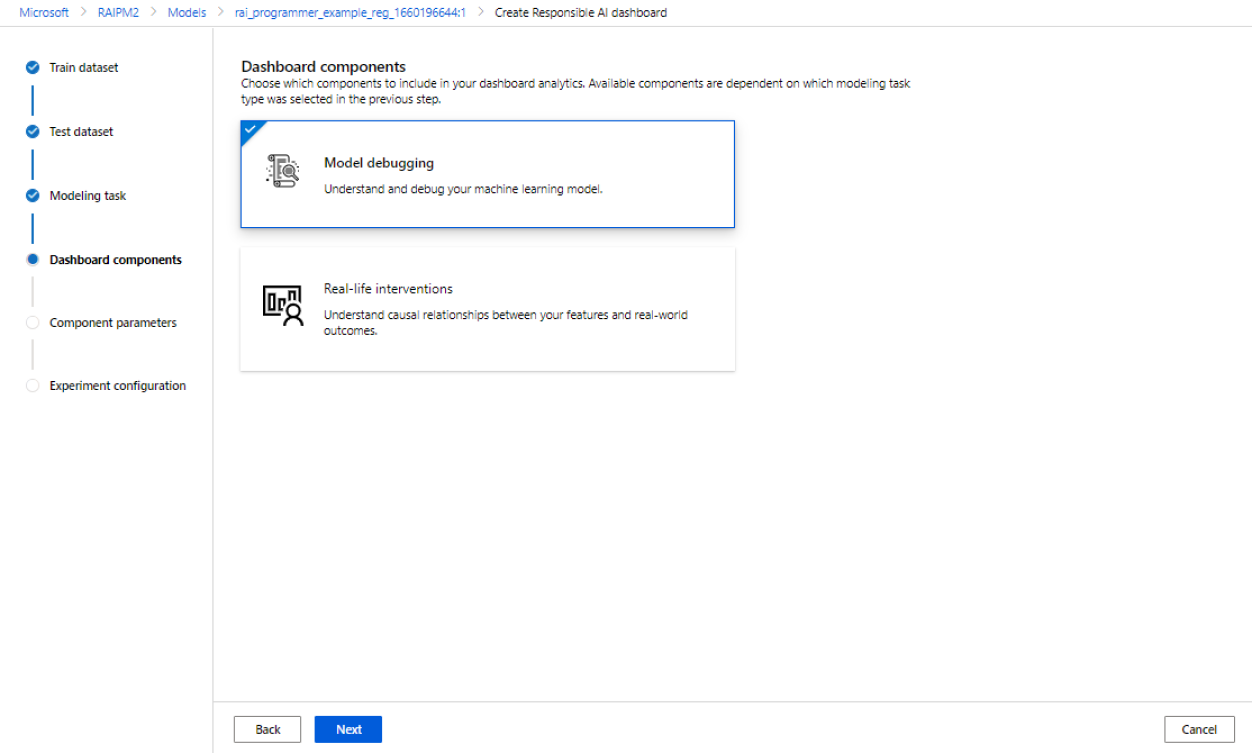

Auswählen Ihrer Dashboardkomponenten

Das Responsible AI-Dashboard bietet zwei Profile für empfohlene Tools, die Sie generieren können:

Modell-Debugging: Verstehen und debuggen Sie fehlerhafte Datenkohorten in Ihrem maschinellen Lernmodell, indem Sie Fehleranalysen, kontrafaktische Was-wäre-wenn-Beispiele und Erklärbarkeit des Modells verwenden.

Reale Interventionen: Verstehen und beheben Sie fehlerhafte Datenkohorten in Ihrem Modell für maschinelles Lernen mithilfe von Kausalanalysen.

Hinweis

Die Multi-Klassen-Klassifizierung unterstützt nicht das Analyseprofil der Real-Life-Interventionen.

- Wählen Sie das Profil aus, das Sie verwenden möchten.

- Wählen Sie Weiter aus.

Konfigurieren von Parametern für Dashboardkomponenten

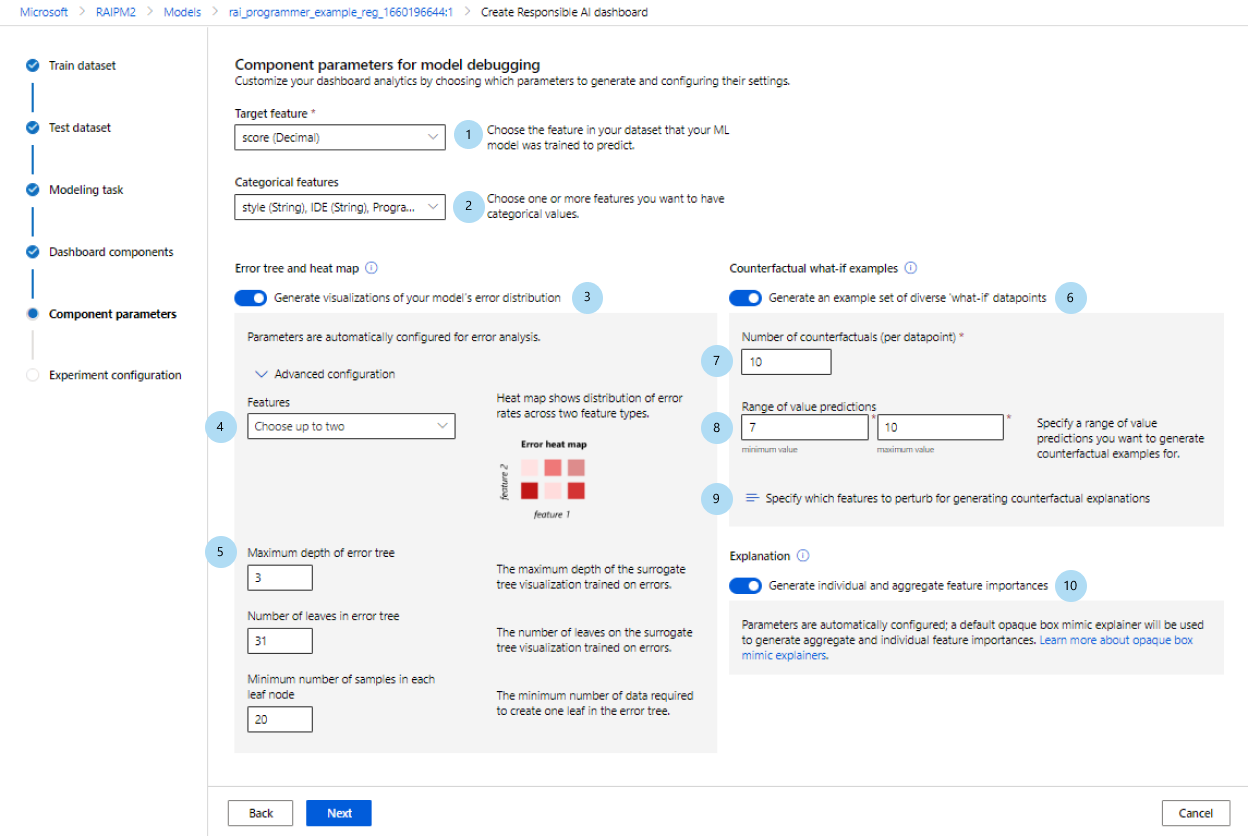

Nachdem Sie ein Profil ausgewählt haben, wird der Konfigurationsbereich Komponentenparameter für das Debuggen von Modellen für die entsprechenden Komponenten angezeigt.

Komponentenparameter für das Modelldebuggen:

Zielfunktion (erforderlich): Geben Sie die Funktion an, für deren Vorhersage Ihr Modell trainiert wurde.

Kategorische Features: Geben Sie an, welche Features kategorisch sind, um sie ordnungsgemäß als kategorische Werte in der Dashboardbenutzeroberfläche zu rendern. Dieses Feld wird basierend auf Ihren Dataset-Metadaten für Sie vorab geladen.

Fehlerbaum und Heatmap generieren: Aktivieren und deaktivieren Sie diese Option, um eine Fehleranalysekomponente für Ihr Responsible AI-Dashboard zu generieren.

Funktionen für Fehler-Heatmap: Wählen Sie bis zu zwei Features aus, für die Sie vorab eine Fehler-Heatmap generieren möchten.

Erweiterte Konfiguration: Geben Sie zusätzliche Parameter an, z. B. Maximale Tiefe des Fehlerbaums, Anzahl der Blätter in der Fehlerstruktur und Mindestanzahl der Stichproben in jedem Blattknoten.

Kontrafaktische Was-wäre-wenn-Beispiele generieren: Aktivieren und deaktivieren Sie diese Option, um eine kontrafaktische Was-wäre-wenn-Komponente für Ihr Responsible AI-Dashboard zu generieren.

Anzahl der kontrafaktischen Beispiele (erforderlich): Geben Sie die Anzahl der kontrafaktischen Beispiele an, die Sie pro Datenpunkt generieren möchten. Es sollten mindestens 10 generiert werden, um eine Balkendiagrammansicht der Features zu ermöglichen, die im Durchschnitt am stärksten gestört waren, um die gewünschte Vorhersage zu erreichen.

Bereich der Wertvorhersagen (erforderlich): Geben Sie für Regressionsszenarien den Bereich an, in dem kontrafaktische Beispiele Vorhersagewerte haben sollen. Für binäre Klassifizierungsszenarien wird der Bereich automatisch so eingestellt, dass Kontrafaktuale für die entgegengesetzte Klasse jedes Datenpunkts generiert werden. Verwenden Sie für Szenarios mit mehreren Klassifizierungen die Dropdown-Liste, um anzugeben, als welche Klasse jeder Datenpunkt vorhergesagt werden soll.

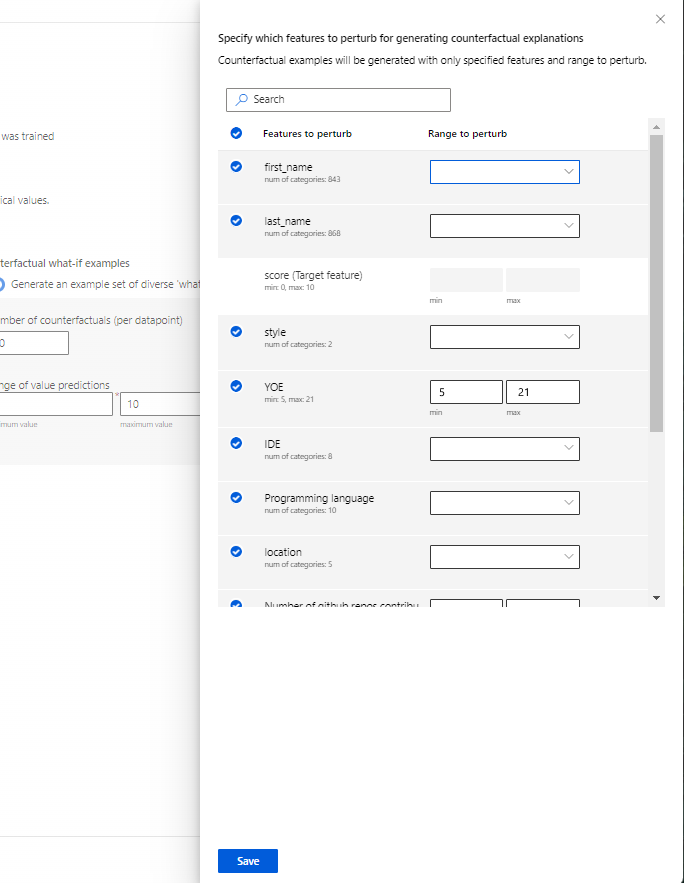

Zu störende Features angeben: Standardmäßig werden alle Funktionen gestört. Wenn Sie jedoch möchten, dass nur bestimmte Features gestört werden, wählen Sie Geben Sie an, welche Features gestört werden sollen, um kontrafaktische Erklärungen zu generieren, um einen Bereich mit einer Liste der auszuwählenden Features anzuzeigen.

Wenn Sie Zu störende Features angeben auswählen, können Sie den Bereich angeben, in dem Sie Störungen zulassen möchten. Beispiel: Geben Sie für das Merkmal YOE (Years of experience) an, dass Kontrafaktuale nur Merkmalswerte von 10 bis 21 haben sollen, anstatt der Standardwerte von 5 bis 21.

Erklärungen generieren: Aktivieren oder deaktivieren Sie diese Option, um eine Modellerklärungskomponente für Ihr Dashboard für verantwortungsvolle KI zu generieren. Es ist keine Konfiguration erforderlich, da ein Standarderklärer für undurchsichtige Kästchen verwendet wird, um die Wichtigkeit von Merkmalen zu generieren.

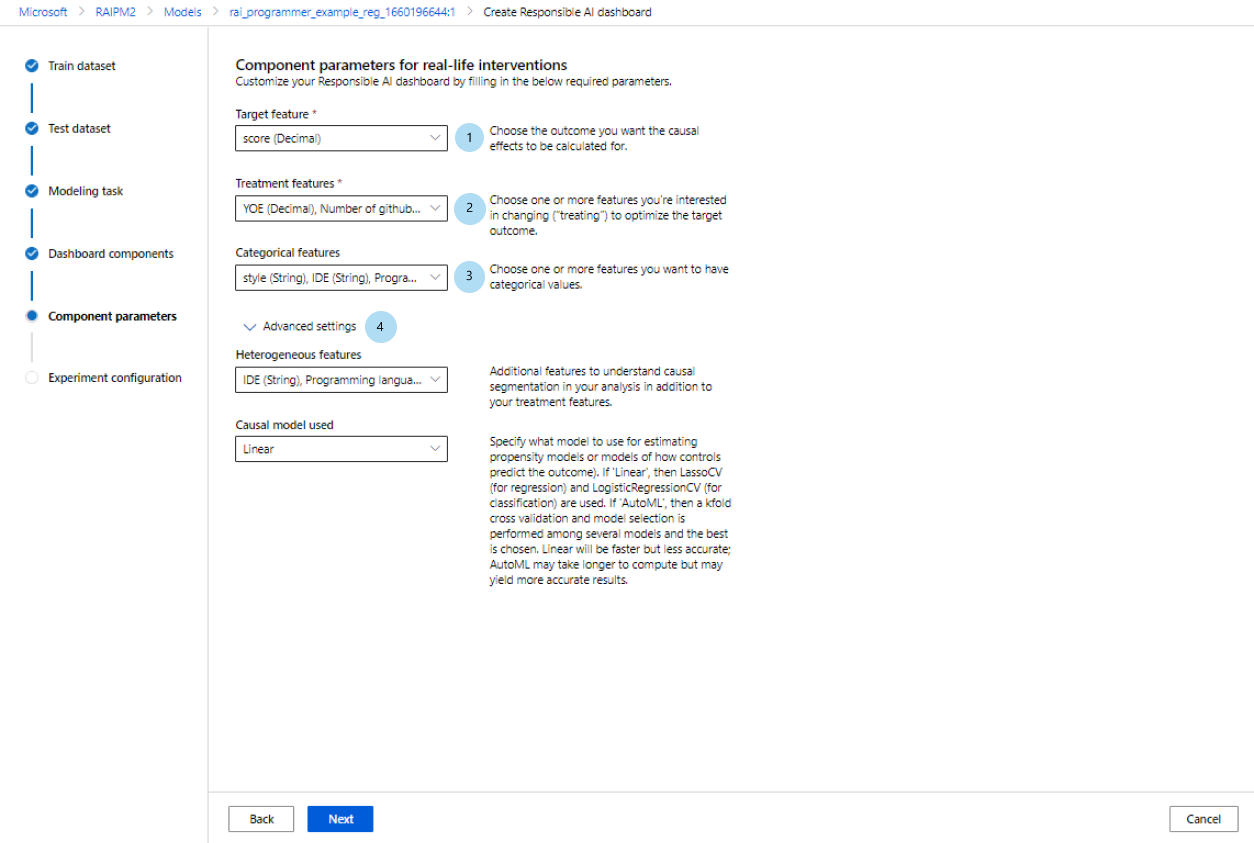

Wenn Sie alternativ das Profil für Reale Interventionen auswählen, sehen Sie den folgenden Bildschirm, der eine Ursachenanalyse generiert. Dies wird Ihnen helfen, die kausalen Auswirkungen von Funktionen, die Sie „behandeln“ möchten, auf ein bestimmtes Ergebnis zu verstehen, das Sie optimieren möchten.

Komponentenparameter für Interventionen im wirklichen Leben verwenden eine Kausalanalyse. Gehen Sie folgendermaßen vor:

- Zielfeature (erforderlich): Wählen Sie das Ergebnis aus, für das die kausalen Auswirkungen berechnet werden sollen.

- Behandlungsfunktionen (erforderlich): Wählen Sie eine oder mehrere Funktionen aus, die Sie ändern („behandeln“) möchten, um das Zielergebnis zu optimieren.

- Kategorische Features: Geben Sie an, welche Features kategorisch sind, um sie ordnungsgemäß als kategorische Werte in der Dashboardbenutzeroberfläche zu rendern. Dieses Feld wird basierend auf Ihren Dataset-Metadaten für Sie vorab geladen.

- Erweiterte Einstellungen: Geben Sie zusätzliche Parameter für Ihre Kausalanalyse an, z. B. heterogene Merkmale (d. h. zusätzliche Merkmale zum Verständnis der kausalen Segmentierung in Ihrer Analyse zusätzlich zu Ihren Behandlungsmerkmalen) und welches Kausalmodell Sie verwenden möchten.

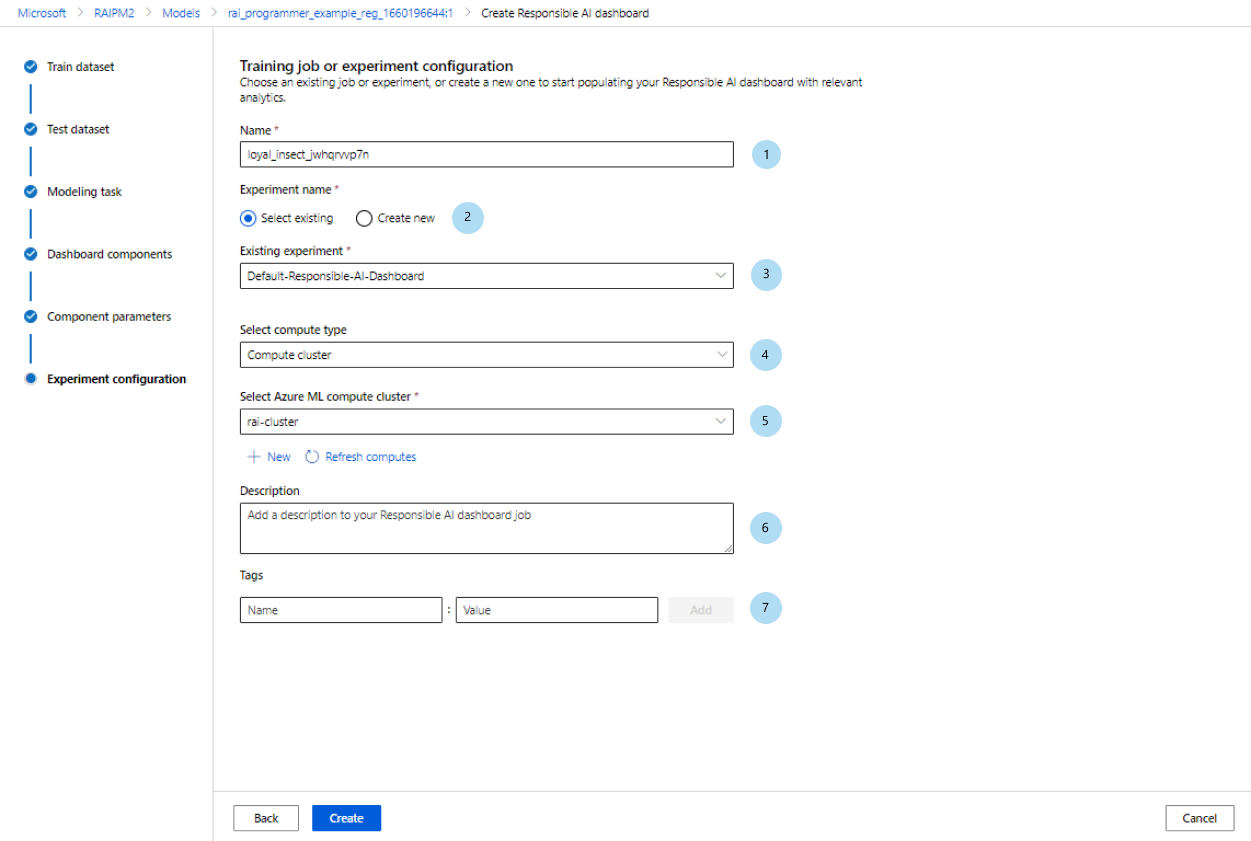

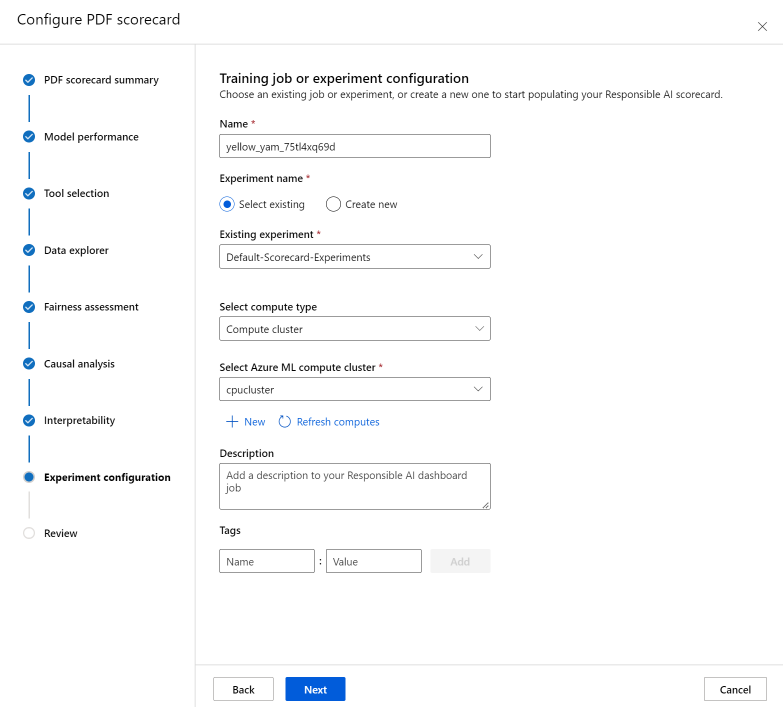

Konfigurieren Sie Ihr Experiment

Konfigurieren Sie zum Abschluss Ihr Experiment für das Starten eines Auftrags, durch den Ihr Dashboard für verantwortungsvolle KI generiert wird.

Gehen Sie im Bereich Trainingsauftrag oder Experimentkonfiguration wie folgt vor:

- Name: Geben Sie Ihrem Dashboard einen eindeutigen Namen, damit Sie es unterscheiden können, wenn Sie die Liste der Dashboards für ein bestimmtes Modell anzeigen.

- Experimentname: Wählen Sie ein vorhandenes Experiment aus, in dem der Auftrag ausgeführt werden soll, oder erstellen Sie ein neues Experiment.

- Vorhandenes Experiment: Wählen Sie in der Dropdown-Liste ein vorhandenes Experiment aus.

- Computetyp auswählen: Geben Sie an, welchen Computetyp Sie zum Ausführen Ihres Auftrags verwenden möchten.

- Compute auswählen: Wählen Sie in der Dropdown-Liste die Compute aus, die Sie verwenden möchten. Wenn keine Rechenressourcen vorhanden sind, wählen Sie das Pluszeichen (+), erstellen Sie eine neue Rechenressource und aktualisieren Sie dann die Liste.

- Beschreibung: Fügen Sie eine längere Beschreibung Ihres Responsible AI-Dashboards hinzu.

- Tags: Fügen Sie diesem Dashboard für verantwortungsvolle KI Tags hinzu.

Nachdem Sie die Konfiguration Ihres Experiments abgeschlossen haben, wählen Sie Erstellen aus, um mit der Generierung Ihres Dashboards für verantwortungsvolle KI zu beginnen. Sie werden zur Experimentseite weitergeleitet, um den Fortschritt Ihres Auftrags mit einem Link zum resultierenden Dashboard für verantwortungsvolle KI von der Auftragsseite nachzuverfolgen, wenn er abgeschlossen ist.

Informationen zum Anzeigen und Verwenden Ihres Dashboards für verantwortungsvolle KI finden Sie unter Verwenden des Dashboards für verantwortungsvolle KI in Azure Machine Learning Studio.

Generieren einer Scorecard für verantwortungsvolle KI (Vorschau)

Nachdem Sie ein Dashboard erstellt haben, können Sie eine Benutzeroberfläche ohne Code in Azure Machine Learning Studio verwenden, um eine Scorecard für verantwortungsvolle KI anzupassen und zu generieren. Auf diese Weise können Sie wichtige Erkenntnisse für eine verantwortungsvolle Bereitstellung Ihres Modells wie Fairness und Featurerelevanz mit nicht technischen und technischen Projektbeteiligten teilen. Ähnlich wie beim Erstellen eines Dashboards können Sie mit den folgenden Schritten auf den Assistenten zur Scorecardgenerierung zugreifen:

- Navigieren Sie in der linken Navigationsleiste von Azure Machine Learning Studio zur Registerkarte Modelle.

- Wählen Sie das registrierte Modell aus, für das Sie eine Scorecard erstellen möchten, und wählen Sie dann die Registerkarte Verantwortungsvolle KI aus.

- Wählen Sie im oberen Bereich Erkenntnisse zu verantwortungsvoller KI erstellen (Vorschau) und dann Neue PDF-Scorecard generieren aus.

Mit dem Assistenten können Sie Ihre PDF-Scorecard ohne Codeänderungen anpassen. Die Funktionalität findet vollständig im Azure Machine Learning Studio statt, um die Vielfalt der Auswahlmöglichkeiten der Benutzeroberfläche mit einem geführten Ablauf und Anleitungstext zu kontextualisieren, der Ihnen bei der Auswahl der Komponenten hilft, mit denen Sie Ihre Scorecard auffüllen möchten. Der Assistent ist in sieben Schritte unterteilt, wobei ein achter Schritt (Fairnessbewertung) nur für Modelle mit kategorischen Features angezeigt wird:

- PDF-Scorecardzusammenfassung

- Modellleistung

- Toolauswahl

- Datenanalyse (ehemals als Daten-Explorer bezeichnet)

- Ursachenanalyse

- Interpretierbarkeit

- Experimentkonfiguration

- Fairnessbewertung (wenn kategorische Features vorhanden sind)

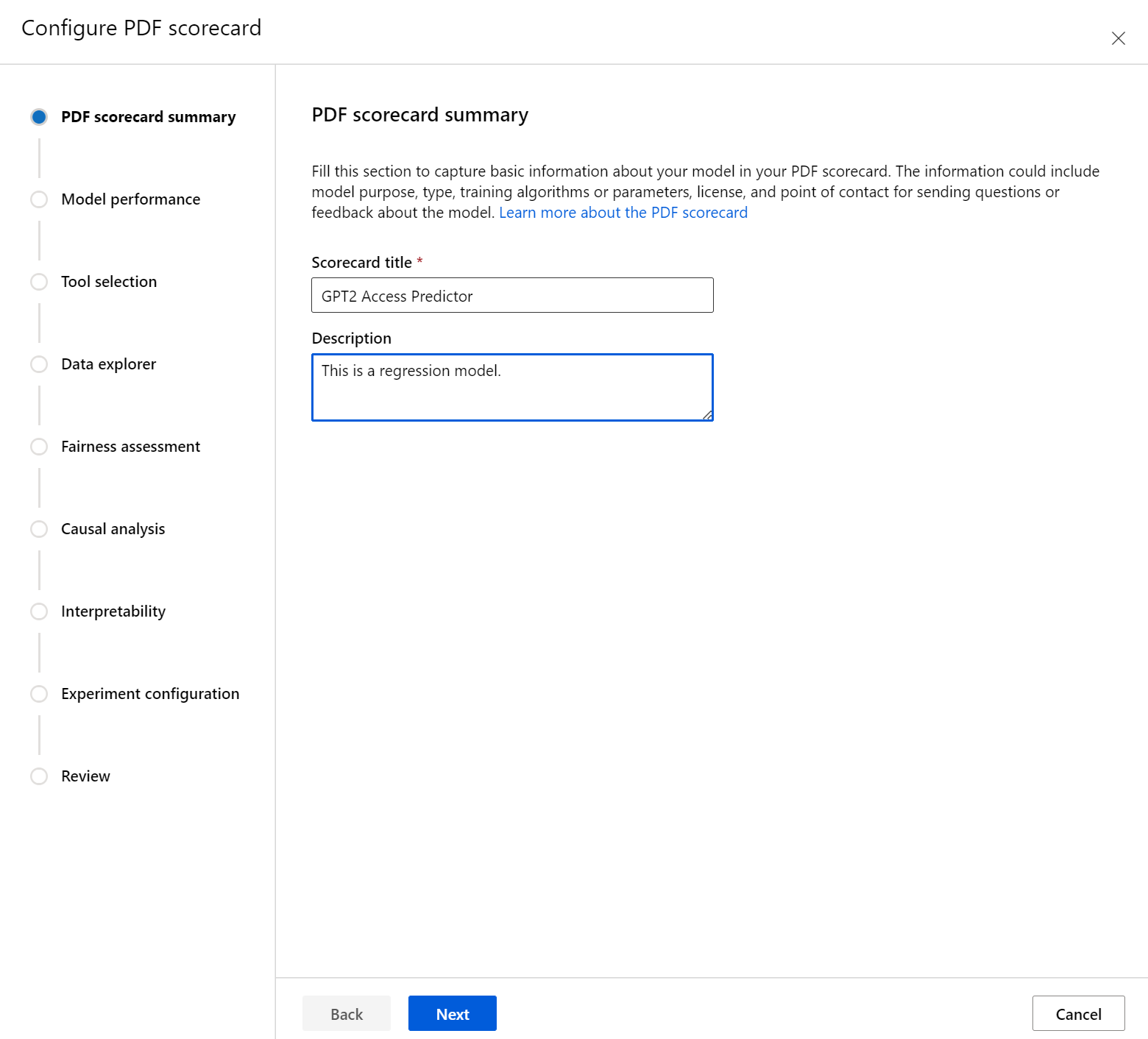

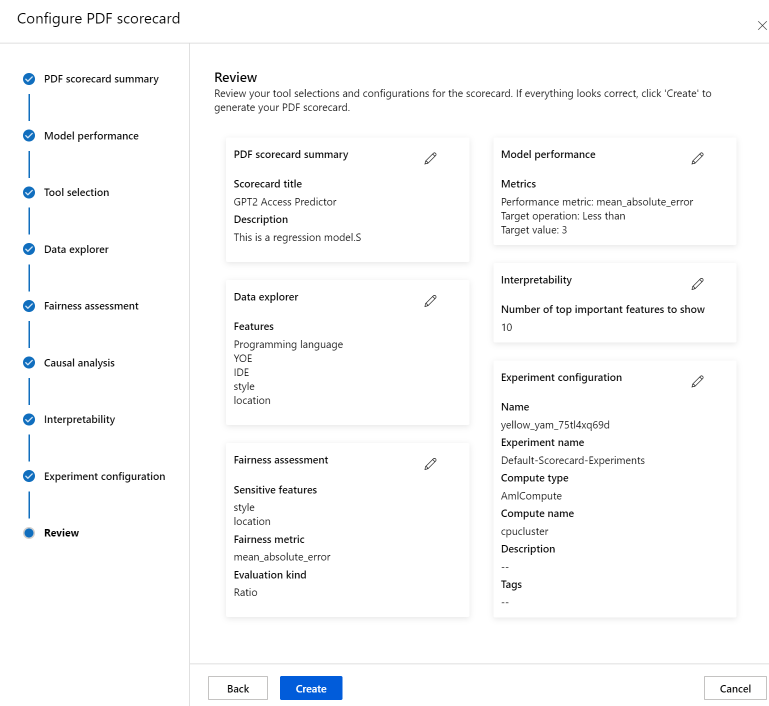

Konfigurieren Ihrer Scorecard

Geben Sie zunächst einen beschreibenden Titel für Ihre Scorecard ein. Sie können auch eine optionale Beschreibung über die Funktionalität des Modells, die Daten, für die es trainiert und ausgewertet wurde, den Architekturtyp und vieles mehr eingeben.

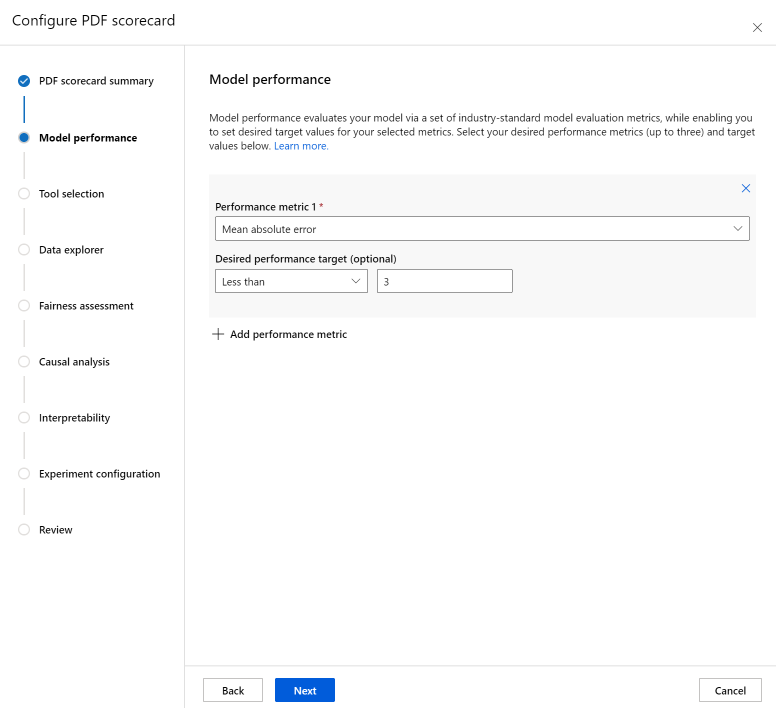

Im Abschnitt Modellleistung können Sie Metriken für die Auswertung von Modellen nach Branchenstandard in Ihre Scorecard integrieren und gleichzeitig die gewünschten Zielwerte für die ausgewählten Metriken festlegen. Wählen Sie die gewünschten Leistungsmetriken (bis zu drei) und die Zielwerte mithilfe der Dropdownlisten aus.

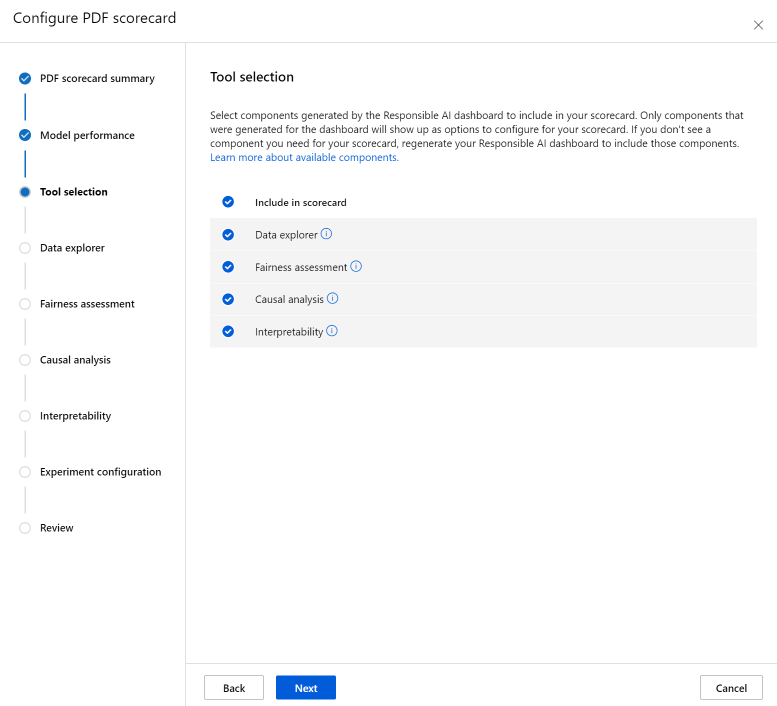

Mit dem Schritt Toolauswahl können Sie auswählen, welche nachfolgenden Komponenten Sie in Ihre Scorecard aufnehmen möchten. Aktivieren Sie „In Scorecard einschließen“, um alle Komponenten einzubeziehen, oder aktivieren/deaktivieren Sie jede Komponente einzeln. Wählen Sie das Infosymbol („i“ in einem Kreis) neben den Komponenten aus, um mehr über sie zu erfahren.

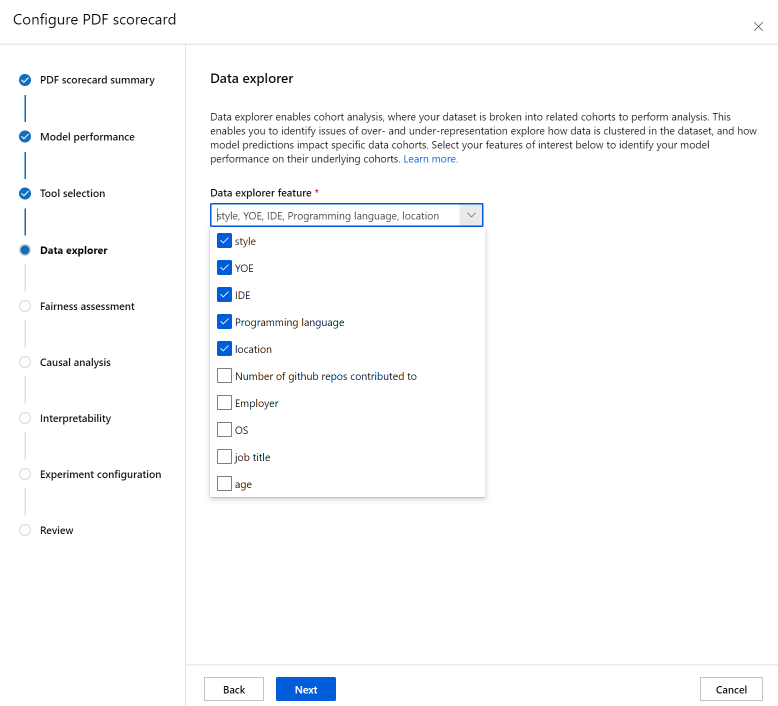

Der Abschnitt Datenanalyse (ehemals als Daten-Explorer bezeichnet) ermöglicht die Kohortenanalyse. Hier können Sie Probleme der Über- und Unterrepräsentation identifizieren und untersuchen, wie Daten im Dataset gruppiert werden und wie sich Modellvorhersagen auf bestimmte Datenkohorten auswirken. Verwenden Sie die Kontrollkästchen in der Dropdownliste, um Ihre gewünschten Features unten auszuwählen, um die Modellleistung für ihre zugrunde liegenden Kohorten zu identifizieren.

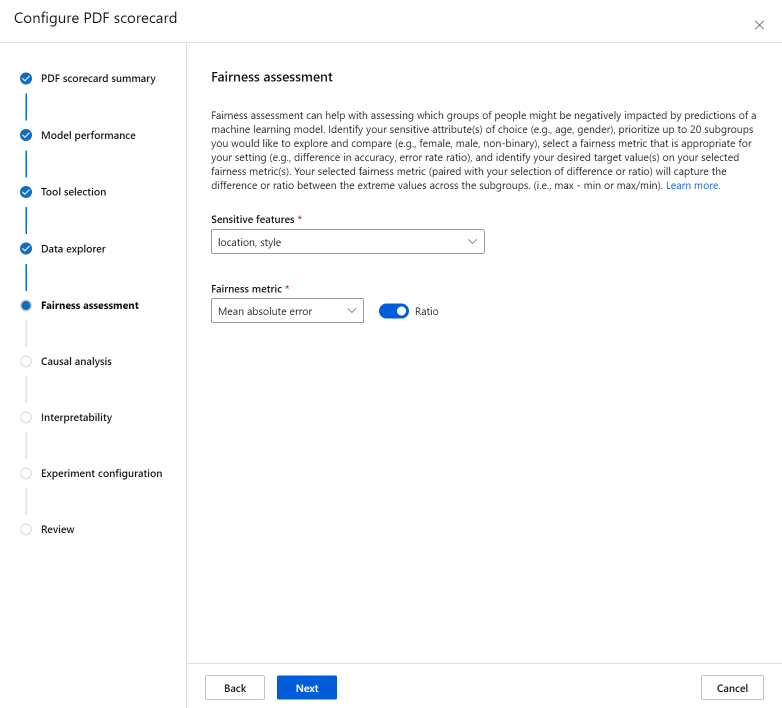

Der Abschnitt Fairnessbewertung kann ihnen dabei helfen, zu bewerten, welche Personengruppen von Vorhersagen eines Machine Learning-Modells negativ beeinflusst werden können. In diesem Abschnitt gibt es zwei Felder.

Sensibles Attribut: Identifizieren Sie die vertraulichen Attribute Ihrer Wahl (z. B. Alter, Geschlecht), indem Sie bis zu 20 Untergruppen priorisieren, die Sie untersuchen und vergleichen möchten.

Fairnessmetrik: Wählen Sie eine Fairnessmetrik aus, die für Ihre Einstellung geeignet ist (z. B. Differenz in der Genauigkeit, Fehlerratenverhältnis), und identifizieren Sie Ihre gewünschten Zielwerte für die ausgewählten Fairnessmetriken. Die ausgewählte Fairnessmetrik (gekoppelt mit der Differenz- oder Verhältnisauswahl über die Umschaltfläche) erfasst die Differenz oder das Verhältnis zwischen den Extremwerten in den Untergruppen. (max – min oder max/min).

Hinweis

Die Fairnessbewertung ist derzeit nur für kategorisch sensible Attribute wie das Geschlecht verfügbar.

Der Abschnitt Ursachenanalyse beantwortet reale „Was wäre wenn“-Fragen darüber, wie sich Änderungen der Behandlungen auf ein reales Ergebnis auswirken würden. Wenn die kausale Komponente im Dashboard für verantwortungsvolle KI aktiviert ist, für das Sie eine Scorecard generieren, ist keine weitere Konfiguration erforderlich.

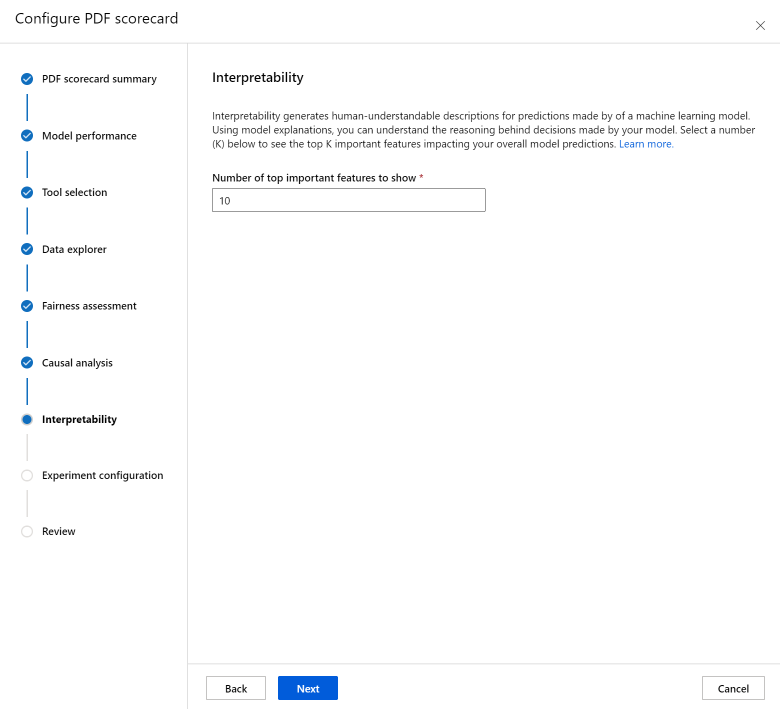

Der Abschnitt Interpretierbarkeit generiert für Menschen verständliche Beschreibungen für Vorhersagen, die von Ihrem Machine Learning-Modell erstellt werden. Mithilfe von Modellerklärungen können Sie die Gründe für die von Ihrem Modell getroffenen Entscheidungen nachvollziehen. Wählen Sie unten eine Zahl (K) aus, um die wichtigsten K Features anzuzeigen, die sich auf Ihre allgemeinen Modellvorhersagen auswirken. Der Standardwert für K lautet 10.

Schließlich konfigurieren Sie Ihr Experiment so, dass es einen Auftrag zum Generieren Ihrer Scorecard auslöst. Diese Konfigurationen sind mit denen für Ihr Dashboard für verantwortungsvolle KI identisch.

Überprüfen Sie schließlich Ihre Konfigurationen, und wählen Sie Erstellen aus, um Ihren Auftrag zu starten.

Sie werden zur Experimentseite umgeleitet, um den Fortschritt Ihres Auftrags nachzuverfolgen, nachdem Sie ihn gestartet haben. Informationen zum Anzeigen und Verwenden Ihrer Scorecard für verantwortungsvolle KI finden Sie unter Verwenden einer Scorecard für verantwortungsvolle KI (Vorschau).

Nächste Schritte

- Nachdem Sie Ihr Responsible AI-Dashboard generiert haben, sehen Sie sich an, wie Sie in Azure Machine Learning Studio darauf zugreifen und es verwenden.

- Erfahren Sie mehr über die Konzepte und Methoden hinter dem Dashboard für verantwortungsbewusste KI.

- Erfahren Sie mehr darüber, wie Sie Daten verantwortungsvoll sammeln.

- Erfahren Sie mehr darüber, wie Sie das Responsible AI-Dashboard und die Scorecard verwenden können, um Daten und Modelle zu debuggen und eine bessere Entscheidungsfindung in diesem Tech-Community-Blogbeitrag zu ermöglichen.

- Erfahren Sie in einer realen Kundengeschichte, wie das Responsible AI-Dashboard und die Scorecard vom britischen National Health Service (NHS) verwendet wurden.

- Erkunden Sie die Funktionen des Responsible AI-Dashboards in dieser interaktiven AI Lab-Webdemo.