Einrichten von Clustern in HDInsight mit Apache Hadoop, Spark, Kafka usw.

In diesem Artikel erfahren Sie, wie Sie Apache Hadoop, Apache Spark, Apache Kafka, Interactive Query oder Apache HBase in HDInsight einrichten und konfigurieren. Sie lernen darüber hinaus, wie Sie Cluster anpassen und Sicherheit hinzufügen, indem Sie sie mit einer Domäne verknüpfen.

Ein Hadoop-Cluster besteht aus mehreren virtuellen Computern (VMs, auch als Knoten bezeichnet), die zur verteilten Verarbeitung von Aufgaben verwendet werden. HDInsight behandelt die Implementierungsdetails der Installation und Konfiguration einzelner Knoten. Sie stellen nur allgemeine Konfigurationsinformationen bereit.

Wichtig

Die Abrechnung für einen HDInsight-Cluster beginnt, nachdem der Cluster erstellt wurde, und endet mit dem Löschen des Clusters. Die Gebühren werden anteilig nach Minuten erhoben. Löschen Sie daher Ihren Cluster, wenn Sie ihn nicht mehr verwenden. Erfahren Sie, wie Sie einen Cluster löschen.

Wenn Sie mehrere Cluster zusammen verwenden, sollten Sie ein virtuelles Netzwerk erstellen. Wenn Sie einen Spark-Cluster verwenden, sollten Sie außerdem Hive Warehouse Connector verwenden. Weitere Informationen finden Sie unter Planen eines virtuellen Netzwerks für Azure HDInsight sowie unter Integrieren von Apache Spark und Apache Hive per Hive Warehouse Connector.

Methoden für die Clustereinrichtung

Die folgende Tabelle zeigt die verschiedenen Methoden, die Sie zum Einrichten eines HDInsight-Clusters verwenden können.

| Verfahren zur Clustererstellung | Webbrowser | Befehlszeile | REST-API | SDK |

|---|---|---|---|---|

| Azure portal | ✅ | |||

| Azure Data Factory | ✅ | ✅ | ✅ | ✅ |

| Azure-Befehlszeilenschnittstelle | ✅ | |||

| Azure PowerShell | ✅ | |||

| cURL | ✅ | ✅ | ||

| Azure-Ressourcen-Manager-Vorlagen | ✅ |

Dieser Artikel enthält die Schritte im Azure-Portal zum Erstellen eines HDInsight-Clusters.

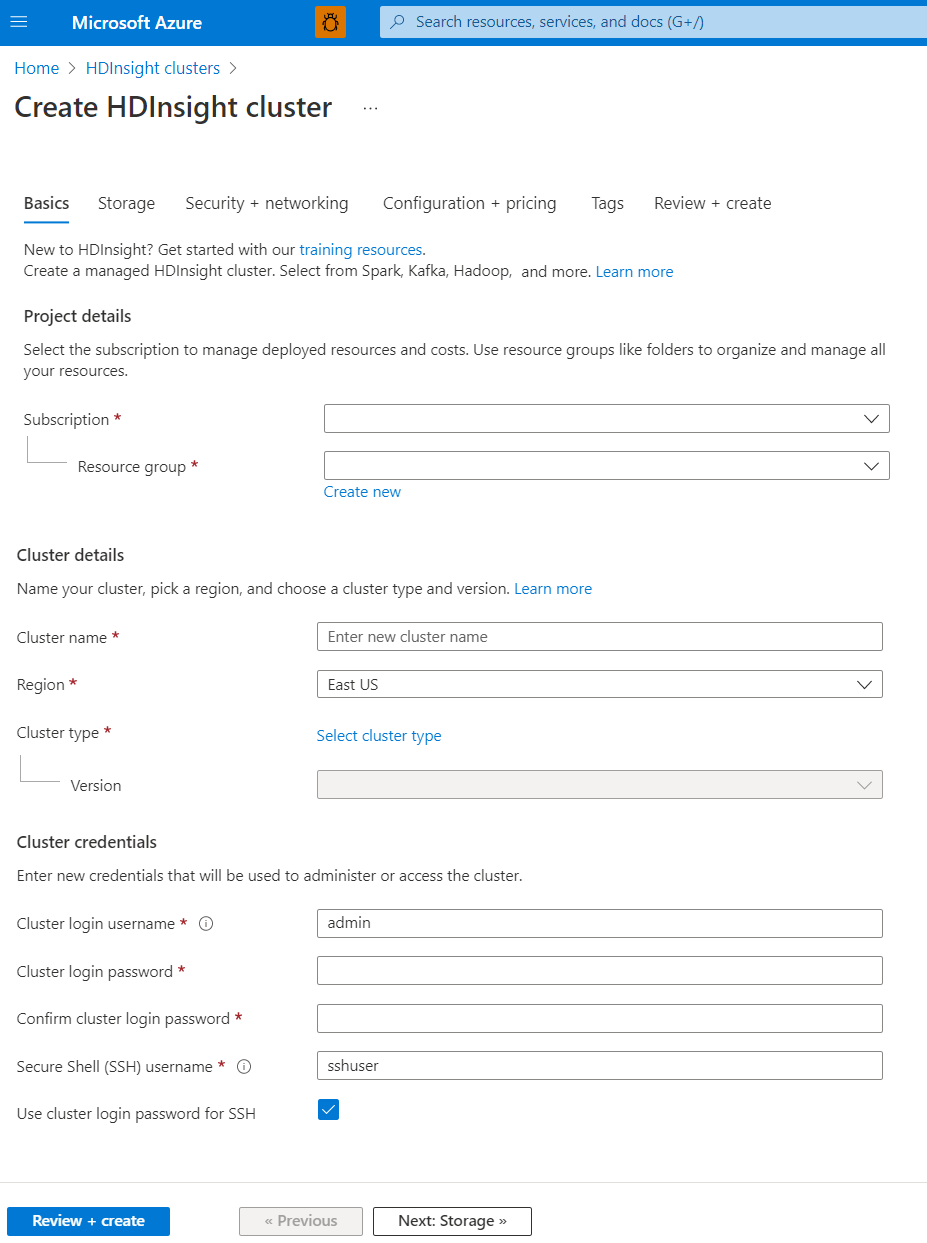

Grundlagen

Projektdetails

Mit Azure Resource Manager können Sie mit den Ressourcen in Ihrer Anwendung als Gruppe arbeiten. Dies wird als Azure-Ressourcengruppe bezeichnet. Sie können alle Ressourcen für Ihre Anwendung in einem einzigen, koordinierten Vorgang bereitstellen, aktualisieren, überwachen oder löschen.

Clusterdetails

Zu den Clusterdetails gehören Name, Region, Typ und Version.

Clustername

Für Namen von HDInsight-Clustern gelten folgende Einschränkungen:

- Zulässige Zeichen: a–z, 0–9 und A–Z

- Maximale Länge: 59

- Reservierte Namen: apps

- Benennungsbereich: Der Bereich gilt überall in Azure und in allen Abonnements. Der Clustername muss weltweit eindeutig sein. Die ersten sechs Zeichen müssen innerhalb eines virtuellen Netzwerks eindeutig sein.

Region

Sie müssen den Clusterstandort nicht explizit angeben. Der Cluster befindet sich an derselben Position wie der Standardspeicher. Um eine Liste der unterstützten Regionen anzuzeigen, wählen Sie unter HDInsight-Preise die Dropdownliste Region aus.

Clustertyp

In der folgenden Tabelle sind die von HDInsight derzeit bereitgestellten Clustertypen mit je einer Reihe von Komponenten angegeben, die bestimmte Funktionen bereitstellen.

Wichtig

HDInsight-Cluster sind jeweils für einzelne Workloads oder Technologien in verschiedenen Typen verfügbar. Es gibt keine unterstützte Methode zum Erstellen eines Clusters, bei der mehrere Typen kombiniert werden, z. B. HBase in einem Cluster. Wenn für Ihre Lösung Technologien erforderlich sind, die auf mehrere HDInsight-Clustertypen verteilt sind, können Sie die erforderlichen Clustertypen über ein virtuelles Azure-Netzwerk miteinander verbinden.

| Clustertyp | Funktionalität |

|---|---|

| Hadoop | Batchabfragen und -analysen gespeicherter Daten |

| HBase | Verarbeitung großen Mengen von schemalosen NoSQL-Daten |

| Interactive Query | Arbeitsspeicherinternes Caching für interaktive und schnellere Hive-Abfragen. |

| Kafka | Eine verteilte Streamingplattform, die Sie zum Erstellen von Datenpipelines und Anwendungen mit Echtzeitstreaming verwenden können |

| Spark | Arbeitsspeicherinterne Verarbeitung, interaktive Abfragen, Microbatch-Datenstromverarbeitung |

Version

Wählen Sie die Version von HDInsight für diesen Cluster aus. Weitere Informationen finden Sie unter Unterstützte HDInsight-Versionen.

Clusteranmeldeinformationen

Während der Clustererstellung ermöglichen die HDInsight-Cluster Ihnen das Konfigurieren von zwei Benutzerkonten:

- Benutzername für Clusteranmeldung: Der Standardbenutzername lautet admin. Für ihn gilt im Azure-Portal die Standardkonfiguration. Er wird auch als Clusterbenutzende oder HTTP-Benutzende bezeichnet.

- SSH-Benutzername (Secure Shell): Wird verwendet, um die Verbindung mit dem Cluster per SSH herzustellen. Weitere Informationen finden Sie unter Verwenden von SSH mit Linux-basiertem Hadoop in HDInsight unter Linux, Unix oder OS X.

Für den HTTP-Benutzernamen gelten folgende Einschränkungen:

- Zulässige Sonderzeichen: _ und @

- Unzulässige Zeichen: #;."',/:!*?$(){}[]<>|&--=+%~^Leerzeichen

- Maximale Länge: 20

Für den SSH-Benutzernamen gelten folgende Einschränkungen:

- Zulässige Sonderzeichen: _ und @

- Unzulässige Zeichen: #;."',/:!*?$(){}[]<>|&--=+%~^Leerzeichen

- Maximale Länge: 64

- Reservierte Namen: hadoop, users, oozie, hive, mapred, ambari-qa, zookeeper, tez, hdfs, sqoop, yarn, hcat, ams, hbase, administrator, admin, user, user1, test, user2, test1, user3, admin1, 1, 123, a, actuser, adm, admin2, aspnet, backup, console, David, guest, John, owner, root, server, sql, support, support_388945a0, sys, test2, test3, user4, user5, spark

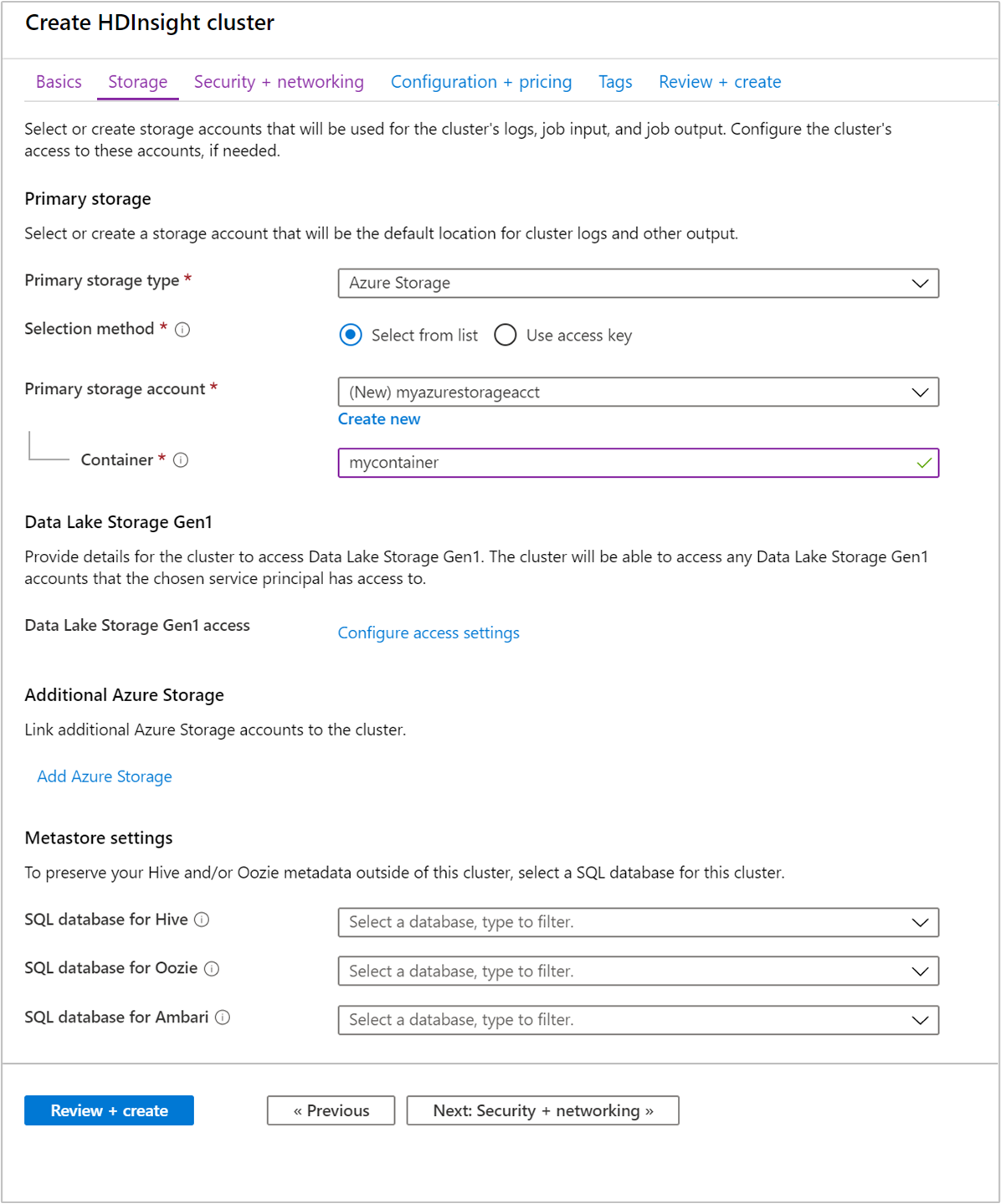

Storage

Obwohl eine lokale Installation von Hadoop HDFS (Hadoop Distributed File System) für die Speicherung im Cluster verwendet, nutzen Sie in der Cloud Speicherendpunkte, die mit dem Cluster verbunden sind. Durch Verwendung von Cloudspeicher können Sie die für Berechnungen verwendeten HDInsight-Cluster sicher löschen und gleichzeitig Ihre Daten beibehalten.

HDInsight-Cluster können die folgenden Speicheroptionen verwenden:

- Azure Data Lake Storage Gen2

- Azure Storage vom Typ „Allgemein v2“

- Azure Storage-Blockblob (nur als sekundärer Speicher unterstützt)

Weitere Informationen zu Speicheroptionen mit HDInsight finden Sie unter Vergleich der Speicheroptionen für die Verwendung mit Azure HDInsight-Clustern.

Die Verwendung weiterer Speicherkonten an einem anderen Ort als dem HDInsight-Cluster wird nicht unterstützt.

Während der Konfiguration geben Sie für den Standardspeicherendpunkt einen Blobcontainer für ein Speicherkonto oder eine Data Lake Storage-Instanz an. Der Standardspeicher enthält Anwendungs- und Systemprotokolle. Optional können Sie weitere verknüpfte Speicherkonten und Data Lake Storage-Konten angeben, auf die der Cluster zugreifen kann. Der HDInsight-Cluster und die abhängigen Speicherkonten müssen sich an demselben Azure-Standort befinden.

Hinweis

Das Feature, das eine sichere Übertragung vorschreibt, erzwingt eine sichere Verbindung für alle Anforderungen, die an Ihr Konto gerichtet werden. Dieses Feature wird erst ab HDInsight-Clusterversion 3.6 unterstützt. Weitere Informationen finden Sie unter Erstellen von Apache Hadoop-Clustern mit Speicherkonten mit sicherer Übertragung in Azure HDInsight.

Aktivieren Sie nicht die sichere Speicherübertragung nach dem Erstellen eines Clusters, da die Verwendung Ihres Speicherkontos zu Fehlern führen kann. Es ist besser, einen neuen Cluster mit einem Speicherkonto zu erstellen, bei dem die sichere Übertragung bereits aktiviert ist.

HDInsight überträgt, verschiebt oder kopiert Ihre im Speicher gespeicherten Daten nicht automatisch zwischen Regionen.

Metastore-Einstellungen

Sie können optionale Hive- oder Apache Oozie Metastores erstellen. Nicht alle Clustertypen unterstützen Metastores, und Azure Synapse Analytics ist nicht mit Metastores kompatibel.

Weitere Informationen finden Sie unter Verwenden von externen Metadatenspeichern in Azure HDInsight.

Verwenden Sie beim Erstellen eines benutzerdefinierten Metastores keinen Datenbanknamen, der Gedankenstriche, Bindestriche oder Leerzeichen enthält. Diese Zeichen können dazu führen, dass der Prozess der Clustererstellung fehlschlägt.

SQL-Datenbank für Hive

Verwenden Sie einen benutzerdefinierten Metastore, wenn Sie nach dem Löschen des HDInsight-Clusters Ihre Hive-Tabellen beibehalten möchten. Sie können diesen Metastore anschließend an einen anderen HDInsight-Cluster anfügen.

Ein HDInsight-Metastore, der für eine HDInsight-Clusterversion erstellt wurde, kann nicht für verschiedene HDInsight-Clusterversionen freigegeben werden. Eine Liste mit den HDInsight-Versionen finden Sie unter Unterstützte HDInsight-Versionen.

Sie können verwaltete Identitäten zur SQL-Datenbank-Authentifizierung für Hive verwenden. Weitere Informationen finden Sie unter Verwenden der Option „Verwaltete Identität“ für die SQL-Datenbank-Authentifizierung in Azure HDInsight.

Der Standardmetastore stellt eine SQL-Datenbank mit einem Basic-Tarif mit einer Begrenzung auf fünf DTUs (nicht aktualisierbar) bereit. Er eignet sich für grundlegende Testzwecke. Bei großen Workloads bzw. Produktionsworkloads empfiehlt sich die Migration zu einem externen Metastore.

SQL-Datenbank für Oozie

Verwenden Sie zur Erhöhung der Leistung bei Verwendung von Oozie einen benutzerdefinierten Metastore. Ein Metastore kann auch Zugriff auf Oozie-Auftragsdaten bieten, nachdem Sie Ihren Cluster gelöscht haben.

Sie können verwaltete Identitäten zur SQL-Datenbank-Authentifizierung für Oozie verwenden. Weitere Informationen finden Sie unter Verwenden der Option „Verwaltete Identität“ für die SQL-Datenbank-Authentifizierung in Azure HDInsight.

SQL-Datenbank für Ambari

Ambari wird zum Überwachen von HDInsight-Clustern, Vornehmen von Konfigurationsänderungen und Speichern von Informationen zur Clusterverwaltung sowie zum Auftragsverlauf verwendet. Mit der Funktion der benutzerdefinierten Ambari-Datenbank können Sie einen neuen Cluster bereitstellen und Ambari in einer externen Datenbank einrichten, die Sie verwalten. Weitere Informationen finden Sie unter Einrichten von HDInsight-Clustern mit einer benutzerdefinierten Ambari-Datenbank.

Sie können verwaltete Identitäten zur SQL-Datenbank-Authentifizierung für Ambari verwenden. Weitere Informationen finden Sie unter Verwenden der Option „Verwaltete Identität“ für die SQL-Datenbank-Authentifizierung in Azure HDInsight.

Ein benutzerdefinierter Oozie-Metastore kann nicht wiederverwendet werden. Wenn Sie einen benutzerdefinierten Oozie-Metastore verwenden möchten, müssen Sie beim Erstellen des HDInsight-Clusters eine leere SQL-Datenbank bereitstellen.

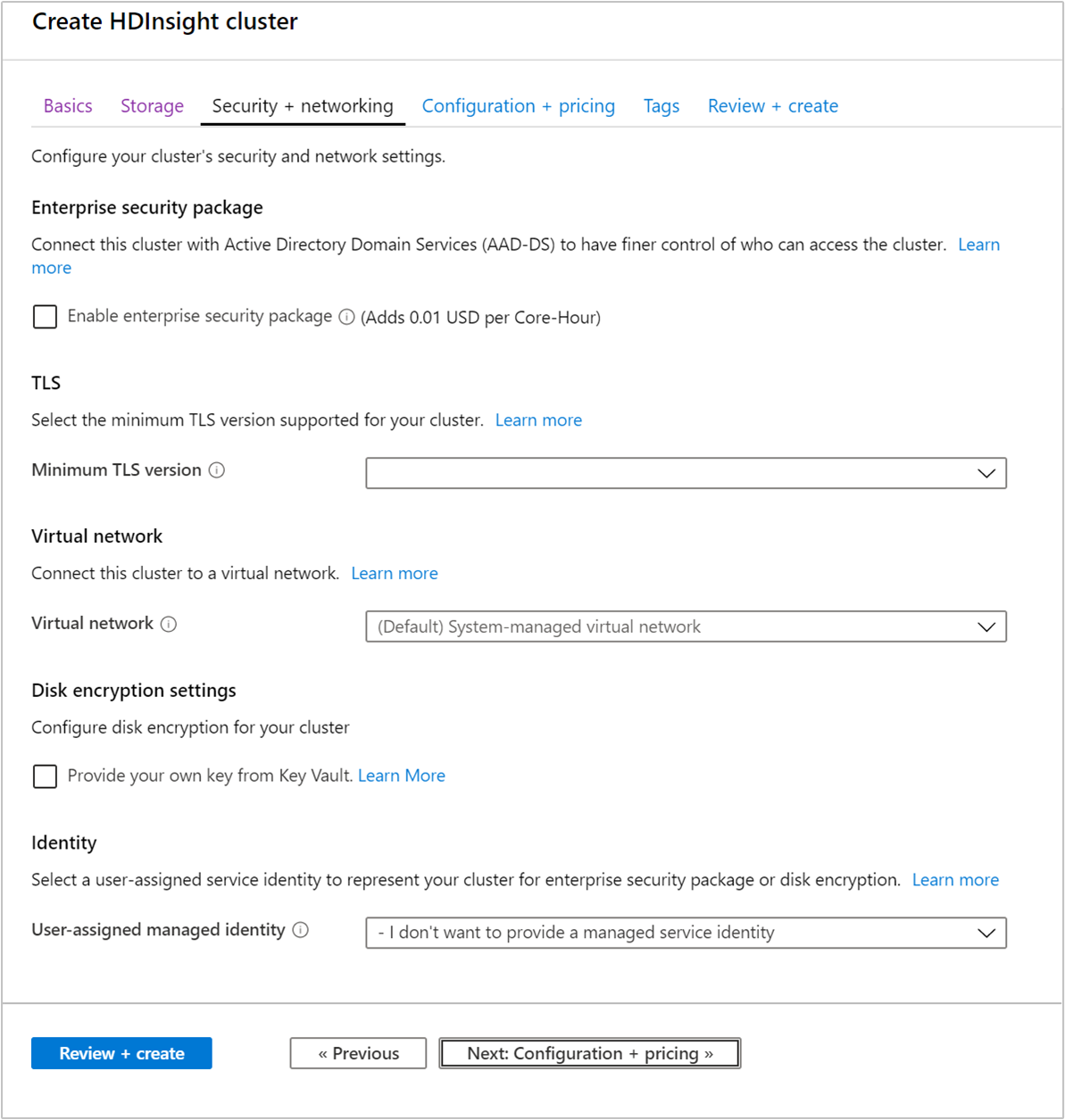

Sicherheit + Netzwerkbetrieb

Sicherheitspaket für Unternehmen

Für Cluster der Typen Hadoop, Spark, HBase, Kafka und Interactive Query können Sie das Enterprise-Sicherheitspaket aktivieren. Dieses Paket bietet die Möglichkeit, mithilfe von Apache Ranger und der Integration in Microsoft Entra eine sicherere Clustereinrichtung zu erreichen. Weitere Informationen finden Sie unter Übersicht über die Unternehmenssicherheit in Azure HDInsight.

Mit dem Enterprise-Sicherheitspaket können Sie HDInsight mit Microsoft Entra und Apache Ranger integrieren. Mithilfe des Enterprise-Sicherheitspakets können Sie mehrere Benutzende erstellen.

Weitere Informationen zum Erstellen eines in eine Domäne eingebundenen HDInsight-Clusters finden Sie unter Erstellen einer in eine Domäne eingebundenen HDInsight-Sandboxumgebung.

Transport Layer Security

Weitere Informationen finden Sie unter Transport Layer Security.

Virtuelles Netzwerk

Wenn für Ihre Lösung Technologien erforderlich sind, die auf mehrere HDInsight-Clustertypen verteilt sind, können Sie die erforderlichen Clustertypen über ein virtuelles Azure-Netzwerk miteinander verbinden. Durch diese Konfiguration können die Cluster und der gesamte Code, den Sie dafür bereitstellen, direkt miteinander kommunizieren.

Weitere Informationen zur Verwendung eines virtuellen Azure-Netzwerks mit HDInsight finden Sie unter Planen eines virtuellen Netzwerks für HDInsight.

Ein Beispiel für die Verwendung von zwei Clustertypen in einem virtuellen Azure-Netzwerk finden Sie unter Verwenden von strukturiertem Apache Spark-Streaming mit Apache Kafka. Weitere Informationen zur Verwendung von HDInsight mit einem virtuellen Netzwerk, einschließlich spezifischer Konfigurationsanforderungen für das virtuelle Netzwerk, finden Sie unter Planen eines virtuellen Netzwerks für HDInsight.

Datenträgerverschlüsselungs-Einstellung

Weitere Informationen finden Sie unter Datenträgerverschlüsselung mit kundenseitig verwalteten Schlüsseln.

Kafka-REST-Proxy

Diese Einstellung ist nur für den Clustertyp „Kafka“ verfügbar. Weitere Informationen finden Sie unter Interagieren mit Apache Kafka-Clustern in Azure HDInsight mithilfe eines REST-Proxys.

Identity

Weitere Informationen finden Sie unter Verwaltete Identitäten in Azure HDInsight.

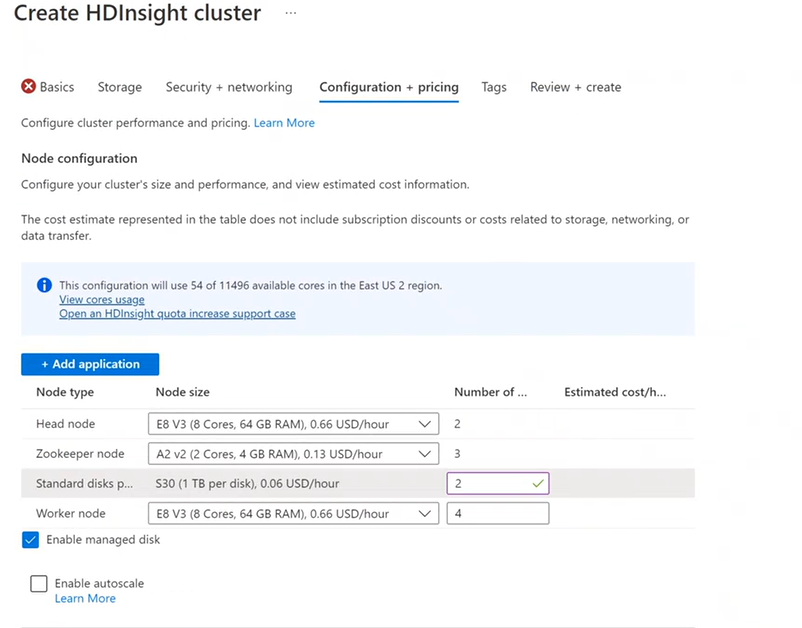

Konfiguration + Preise

Die Verwendung der Knoten wird so lange abgerechnet, wie der Cluster vorhanden ist. Die Abrechnung beginnt, sobald ein Cluster erstellt wurde, und sie endet, wenn der Cluster gelöscht wird. Die Zuweisung von Clustern kann nicht aufgehoben werden. Auch können Cluster nicht angehalten werden.

Knotenkonfiguration

Jeder Clustertyp verfügt über eine eigene Anzahl von Knoten, Terminologie für Knoten und eine VM-Standardgröße. In der folgenden Tabelle ist die Anzahl von Knoten für jeden Knotentyp in Klammern angegeben.

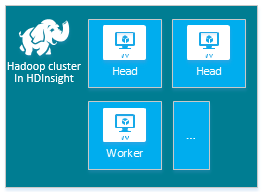

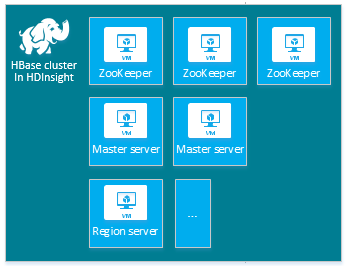

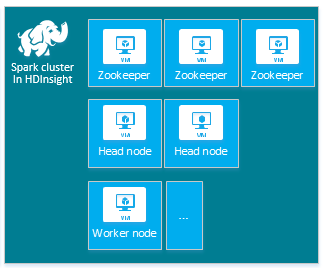

| type | Nodes | Diagramm |

|---|---|---|

| Hadoop | Hauptknoten (2), Workerknoten (1+) |

|

| hbase | Hauptserver (2), Regionsserver (1+), Master-/ZooKeeper-Knoten (3) |

|

| Spark | Hauptknoten (2), Workerknoten (1+), ZooKeeper-Knoten (3) (kostenlos für ZooKeeper-VMs der Größe A1) |

|

Weitere Informationen finden Sie unter Standardmäßige Knotenkonfiguration und VM-Größen für Cluster.

Die Kosten von HDInsight-Clustern ergeben sich aus der Anzahl der Knoten und den VM-Größen für die Knoten.

Unterschiedliche Clustertypen weisen verschiedene Knotentypen, eine unterschiedliche Anzahl von Knoten sowie verschiedene Knotengrößen auf:

Hadoop-Standardclustertyp:

- Zwei Hauptknoten

- Vier Workerknoten

Wenn Sie HDInsight testen, sollten Sie nur einen einzigen Workerknoten verwenden. Weitere Informationen zu den Preisen von HDInsight finden Sie unter HDInsight – Preise.

Hinweis

Die Begrenzung der Clustergröße variiert je nach Azure-Abonnement. Wenden Sie sich an den Azure-Abrechnungssupport, um diese Begrenzung zu erhöhen.

Wenn Sie das Azure-Portal zum Konfigurieren des Clusters verwenden, ist die Knotengröße über die Registerkarte Configuration + Pricing (Konfiguration + Preise) verfügbar. Außerdem werden im Portal die Kosten angezeigt, die den unterschiedlichen Knotengrößen zugeordnet sind.

Größen virtueller Computer

Wählen Sie bei der Bereitstellung von Clustern die Computeressourcen basierend auf der Lösung aus, die Sie bereitstellen möchten. Für HDInsight-Cluster werden die folgenden virtuellen Computer verwendet:

- VMs der Serien A und D1–4: Größen universeller Linux-VMs

- VMs der Serien D11–14: Größen speicheroptimierter Linux-VMs

Wenn Sie wissen möchten, welchen Wert Sie beim Erstellen eines Clusters mithilfe unterschiedlicher SDKs oder von Azure PowerShell als VM-Größe angeben sollten, lesen Sie unter VM-Größen für HDInsight-Cluster nach. Verwenden Sie im verknüpften Artikel in den Tabellen den Wert in der Spalte Größe.

Wichtig

Wenn Sie mehr als 32 Workerknoten benötigen, müssen Sie eine Hauptknotengröße von mindestens 8 Kernen und 14 GB Arbeitsspeicher (RAM) auswählen.

Weitere Informationen finden Sie unter Größen für VMs. Informationen zu den Preisen der unterschiedlichen Größen finden Sie unter HDInsight-Preise.

Anhängen von Datenträgern

Hinweis

Die hinzugefügten Datenträger werden nur für lokale Knoten-Manager-Verzeichnisse und nicht für Datenknotenverzeichnisse konfiguriert.

Ein HDInsight-Cluster weist basierend auf der Version einen vordefinierten Speicherplatz auf. Das Ausführen einiger großer Anwendungen kann zu unzureichendem Speicherplatz (mit dem Fehler „Voller Datenträger“– LinkId=221672#ERROR_NOT_ENOUGH_DISK_SPACE) und Auftragsfehlern führen.

Sie können dem Cluster mithilfe des neuen Features NodeManager (Knoten-Manager) des lokalen Verzeichnisses weitere Datenträger hinzufügen. Sie können bei der Erstellung des Hive- und Spark-Clusters die Anzahl der Datenträger auswählen und sie den Workerknoten hinzufügen. Die ausgewählten Datenträger können jeweils 1 TB umfassen und sind Teil der lokalen NodeManager-Verzeichnisse.

- Wählen Sie auf der Registerkarte Konfiguration + Preise die Option Aktivieren des verwalteten Datenträgers aus.

- Geben Sie unter Standarddatenträger die Anzahl der Datenträger ein.

- Wählen Sie Ihren Workerknoten aus.

Sie können die Anzahl der Datenträger auf der Registerkarte Überprüfen + erstellen unter Clusterkonfiguration überprüfen.

Anwendung hinzufügen

Sie können HDInsight-Anwendungen in einem Linux-basierten HDInsight-Cluster installieren. Sie können von Microsoft oder von Drittanbietern bereitgestellte Anwendungen oder selbst entwickelte Anwendungen verwenden. Weitere Informationen finden Sie unter Installieren von Apache Hadoop-Anwendungen von Drittanbietern in Azure HDInsight.

Die meisten HDInsight-Anwendungen werden auf einem leeren Edgeknoten installiert. Ein leerer Edgeknoten ist eine Linux-VM, auf der die gleichen Clienttools installiert und konfiguriert sind wie im Hauptknoten. Sie können den Edgeknoten zum Zugreifen auf den Cluster sowie zum Testen und Hosten Ihrer Clientanwendungen verwenden. Weitere Informationen finden Sie unter Use empty edge nodes in HDInsight(Verwenden leerer Edgeknoten in HDInsight).

Skriptaktionen

Sie können weitere Komponenten installieren oder die Clusterkonfiguration mithilfe von Skripts während der Erstellung anpassen. Solche Skripts werden mithilfe der Konfigurationsoption Skriptaktionen aufgerufen, die im Azure-Portal, in HDInsight Windows PowerShell-Cmdlets oder mit dem HDInsight .NET SDK verwendet werden kann. Weitere Informationen finden Sie unter Anpassen eines HDInsight-Clusters mithilfe von Skriptaktionen.

Einige native Java-Komponenten wie Apache Mahout und Cascading können im Cluster als JAR-Dateien (Java Archive) ausgeführt werden. Sie können diese JAR-Dateien an Speicher verteilen und mit den Verfahren zur Übermittlung von Hadoop-Aufträgen an HDInsight-Cluster senden. Weitere Informationen finden Sie unter Programmgesteuerte Übermittlung von Apache Hadoop-Aufträgen.

Hinweis

Wenn bei der Bereitstellung von JAR-Dateien für HDInsight-Cluster oder beim Aufrufen von JAR-Dateien für HDInsight-Cluster Probleme auftreten, wenden Sie sich an den Microsoft-Support.

HDInsight unterstützt keine Kaskadierung und ist nicht für den Microsoft-Support berechtigt. Listen der unterstützten Komponenten finden Sie unter Neuheiten in den von HDInsight bereitgestellten Clusterversionen.

Es kann vorkommen, dass Sie die folgenden Konfigurationsdateien während des Erstellungsprozesses bearbeiten möchten:

- clusterIdentity.xml

- core-site.xml

- gateway.xml

- hbase-env.xml

- hbase-site.xml

- hdfs-site.xml

- hive-env.xml

- hive-site.xml

- mapred-site

- oozie-site.xml

- oozie-env.xml

- tez-site.xml

- webhcat-site.xml

- yarn-site.xml

Weitere Informationen finden Sie unter Anpassen von HDInsight-Clustern mithilfe von Bootstrap.