Microsoft SQL Server 平台上的巨量資料選項

適用於:SQL Server 2019 (15.x) 和更新版本

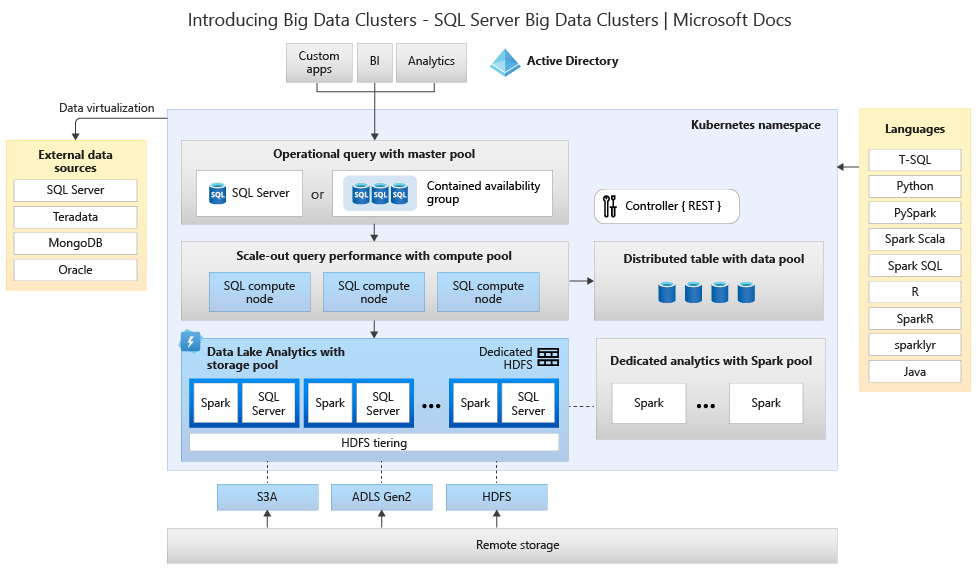

Microsoft SQL Server 2019 巨量叢集是適用於 SQL Server 平台的附加元件,可讓您部署於 Kubernetes 上執行的可調整 SQL Server、Spark 和 HDFS 容器叢集。 這些元件會並存執行,可供您使用 Transact-SQL 或 Spark 程式庫來讀取、寫入和處理巨量資料,讓您輕鬆地合併和分析具有非關聯式大量巨量資料的高價值關聯式資料。 巨量資料叢集也可讓您使用 PolyBase 來虛擬化資料,因此您可以使用外部資料表來查詢外部 SQL Server、Oracle、Teradata、MongoDB 和其他資料來源的資料。 Microsoft SQL Server 2019 巨量叢集附加元件使用 Always On 可用性群組技術,為 SQL Server 主要執行個體和所有資料庫提供高可用性。

SQL Server 2019 巨量資料叢集附加元件會針對任何 Kubernetes 的標準部署,在內部部署和使用 Kubernetes 平台在雲端中執行。 此外,SQL Server 2019 巨量資料叢集附加元件會與 Active Directory 整合,並包括角色型存取控制,以滿足企業的安全性和合規性需求。

淘汰 SQL Server 2019 巨量資料叢集附加元件

在 2025 年 2 月 28 日,我們將淘汰 SQL Server 2019 巨量資料叢集。 平台上將完全支援具有軟體保證的所有現有 SQL Server 2019 使用者,而且該軟體將會持續透過 SQL Server 累積更新來維護,直到該時間為止。 如需詳細資訊,請參閱公告部落格文章。

SQL Server 中的 PolyBase 支援變更

與 SQL Server 2019 巨量資料叢集淘汰有關的是與擴增查詢相關的一些功能。

已淘汰 Microsoft SQL Server 的 PolyBase 擴增群組功能。 向外延展群組功能會從 SQL Server 2022 (16.x) 中的產品移除。 SQL Server 2019、SQL Server 2017 和 SQL Server 2016 市場內版本將繼續支援這些功能,直到這些產品的生命週期結束。 PolyBase 資料虛擬化會在 SQL Server 中作為擴大功能來繼續受到完整支援。

所有 SQL Server 市場內版本也將淘汰 Cloudera (CDP) 和 Hortonworks (HDP) Hadoop 外部資料來源,而且這些外部資料來源將不會包括在 SQL Server 2022 中。 外部資料來源的支援受限於個別廠商主要支援中的產品版本。 建議您使用 SQL Server 2022 (16.x) 中提供的新物件儲存體整合。

在 SQL Server 2022 (16.x) 和更新版本中,使用者將必須設定其外部資料來源,才能在連線至 Azure 儲存體時使用新的連接器。 下表彙總這些變更。

| 外部資料來源 | 寄件者 | 收件者 |

|---|---|---|

| Azure Blob 儲存體 | wasb[s] |

abs |

| ADLS Gen 2 | abfs[s] |

adls |

注意

Azure Blob 儲存體 (abs) 將需要在資料庫範圍認證中使用 SECRET 的共用存取簽章 (SAS)。 在 SQL Server 2019 和更早版本中,wasb[s] 連接器已在向 Azure 儲存體帳戶進行驗證時,搭配使用儲存體帳戶金鑰與資料庫範圍認證。

了解取代和移轉選項的巨量資料叢集架構

若要為巨量資料儲存體和處理系統建立取代解決方案,請務必了解 SQL Server 2019 巨量資料叢集所提供的項目,而且其架構有助於通知您的選擇。 巨量資料叢集的架構如下所示:

此架構提供下列功能對應:

| 元件 | 優點 |

|---|---|

| Kubernetes | 適用於大規模部署和管理容器型應用程式的開放原始碼協調器。 提供宣告式方法,以針對具有彈性調整的整個環境建立和控制復原、備援和可攜性。 |

| 巨量資料叢集控制器 | 提供叢集的管理和安全性。 其中包含控制項服務、設定存放區,以及其他叢集層級的服務 (例如 Kibana、Grafana 和彈性搜尋)。 |

| 計算集區 | 將計算資源提供給叢集。 其中包含在 Linux Pod 上執行 SQL Server 的節點。 計算集區中的 Pod 會分割成 SQL 計算執行個體,以進行特定的處理工作。 此元件也使用 PolyBase 來提供資料虛擬化,以查詢外部資料來源,而不需要移動或複製資料。 |

| 資料集區 | 提供叢集的資料持續性。 資料集區由在 Linux 上執行 SQL Server 的一或多個 Pod 所組成。 用於從 SQL 查詢或 Spark 作業中內嵌資料。 |

| 儲存集區 | 存放集區包含由 Linux 上的 SQL Server、Spark 和 HDFS 組成的存放集區 Pod。 巨量資料叢集中的所有儲存體節點都是 HDFS 叢集的成員。 |

| 應用程式集區 | 提供介面來建立、管理和執行應用程式,以啟用巨量資料叢集上的應用程式部署。 |

如需這些函數的詳細資訊,請參閱 SQL Server 巨量資料叢集簡介。

巨量資料和 SQL Server 的功能取代選項

巨量資料叢集內 SQL Server 所促進的「操作」資料函數可以取代為混合式設定中的內部部署 SQL Server,或使用 Microsoft Azure 平台來取代。 Microsoft Azure 提供完全受控關聯式、NoSQL 和記憶體內部資料庫的選擇,跨越專屬和開放原始碼引擎,以符合新式應用程式開發人員的需求。 基礎結構管理 (包括可擴縮性、可用性和安全性) 是自動化進行,可節省您的時間和金錢,並可讓您專注於建置應用程式,而 Azure 受控資料庫可透過內嵌智慧來呈現效能深入解析、無限制地調整規模,以及管理安全性威脅,讓您的工作更為簡單。 如需詳細資訊,請參閱 Azure 資料庫。

下一個決策點是適用於「分析」的計算和資料儲存體位置。 這兩個架構選擇是雲端中和混合式部署。 大部分的分析工作負載都可以移轉至 Microsoft Azure 平台。 「在雲端中產生」的資料 (源自雲端式應用程式) 是這些技術的主要候選項目,而資料移動服務可以安全且快速地移轉大規模的內部部署資料。 如需資料移動選項的詳細資訊,請參閱資料傳輸解決方案。

Microsoft Azure 具有系統和認證,可在各種工具中允許安全資料和資料處理。 如需這些認證的詳細資訊,請參閱信任中心。

注意

Microsoft Azure 平台提供非常高的安全性層級、各種產業的多個認證,並接受政府需求的資料主權。 Microsoft Azure 也有適用於政府工作負載的專用雲端平台。 單獨安全性不應該是內部部署系統的主要決策點。 決定在內部部署保留巨量資料解決方案之前,您應該仔細評估 Microsoft Azure 所提供的安全性層級。

在「雲端中架構」選項中,所有元件都位於 Microsoft Azure 中。 您的責任在於您為工作負載儲存和處理所建立的資料和程式碼。 本文會更詳細地涵蓋這些選項。

- 此選項最適合用於儲存和處理資料的各種元件,以及當您想要專注於資料和處理建構而非基礎結構時。

在「混合式架構」選項中,某些元件會保留在內部部署,而其他元件則放在雲端提供者中。 兩者之間的連線是專為處理過度資料的最佳位置所設計。

- 如果您對內部部署技術和架構投資相當多,但想要使用 Microsoft Azure 的供應項目,或是您有位於內部部署或適用於全球受眾的處理和應用程式目標,則最適合使用此選項。

如需建置可調整架構的詳細資訊,請參閱建置適用於大量資料的可調整系統。

雲端中

使用 Synapse 的 Azure SQL

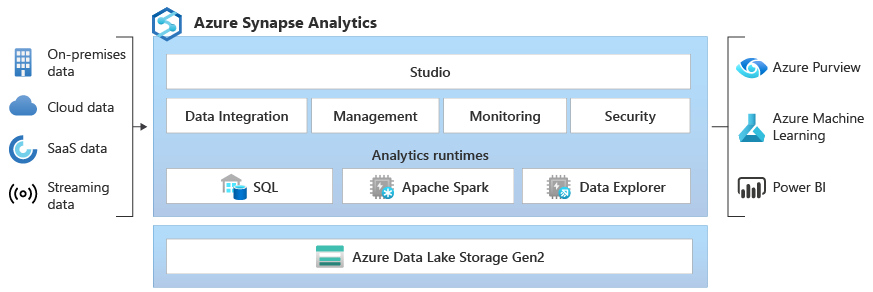

您可以針對操作資料使用一或多個 Azure SQL 資料庫選項,以及針對分析工作負載使用 Microsoft Azure Synapse,來取代 SQL Server 巨量資料叢集功能。

Microsoft Azure Synapse 是一項企業分析服務,可讓您使用分散式處理和資料建構以更快速地取得資料倉儲和巨量資料系統的深入解析。 Azure Synapse 會將企業資料倉儲中所用的 SQL 技術、巨量資料所用的 Spark 技術、用於資料整合和 ETL/ELT 的管道,以及與其他 Azure 服務 (例如 Power BI、CosmosDB 和 Azure Machine Learning) 的深度整合,結合在一起。

當您需要執行下列動作時,請使用 Microsoft Azure Synapse 來取代 SQL Server 2019 巨量資料叢集:

- 使用無伺服器和專用資源模型。 針對可預測的效能和成本,請建立專用 SQL 集區來為 SQL 資料表中所儲存的資料保留處理效能。

- 處理非計劃性或「高載」工作負載、存取永遠可用的無伺服器 SQL 端點。

- 使用內建串流功能,以將雲端資料來源中的資料放入 SQL 資料表。

- 使用機器學習模型來整合 AI 與 SQL,以利用 T-SQL PREDICT 函數來為資料評分。

- 使用 SparkML 演算法以及 Linux Foundation Delta Lake 所支援 Apache Spark 2.4 的 Azure Machine Learning 整合,來利用 ML 模型。

- 使用簡化的資源模型,讓您不必擔心如何管理叢集。

- 處理需要快速 Spark 啟動和積極自動調整的資料。

- 使用適用於 Spark 的 .NET 來處理資料,可讓您在 Spark 應用程式中重複使用您的 C# 專業知識和現有 .NET 程式碼。

- 使用資料湖中檔案上所定義的資料表,而 Spark 或 Hive 可以順暢地取用。

- 搭配使用 SQL 與 Spark,以直接探索和分析資料湖中所儲存的 Parquet、CSV、TSV 和 JSON 檔案。

- 在 SQL 與 Spark 資料庫之間啟用快速且可調整的資料載入。

- 從 90 個以上的資料來源內嵌資料。

- 啟用具有資料流程活動的「無程式碼」ETL。

- 協調筆記本、Spark 工作、預存程序、SQL 指令碼等。

- 監視 SQL 和 Spark 上的資源、使用方式和使用者。

- 使用角色型存取控制來簡化對分析資源的存取。

- 撰寫 SQL 或 Spark 程式碼,並與企業 CI/CD 程序整合。

Microsoft Azure Synapse 的架構如下所示:

如需 Microsoft Azure Synapse 的詳細資訊,請參閱什麼是 Azure Synapse Analytics?

Azure SQL 加上 Azure Machine Learning

您可以針對操作資料使用一或多個 Azure SQL 資料庫選項,以及針對預測性工作負載使用 Microsoft Azure Machine Learning,來取代 SQL Server 巨量資料叢集功能。

Azure Machine Learning 是雲端式服務,可用於任何一種機器學習:從傳統 ML 到深度學習、受監督和不受監督的學習。 無論您偏好使用 SDK 撰寫 Python 或 R 程式碼或在 Studio 中使用零程式碼/低程式碼選項,都可以在 Azure Machine Learning 工作區中建立、定型及追蹤機器學習和深度學習模型。 使用 Azure Machine Learning,您可以開始訓練您的本機電腦,然後擴增至雲端。 此服務也會與熱門的深度學習和增強式開放原始碼工具 (例如 PyTorch、TensorFlow、scikit-learn 和 Ray RLlib) 交互操作。

當您需要執行下列動作時,請使用 Microsoft Azure Machine Learning 來取代 SQL Server 2019 巨量資料叢集:

- Machine Learning 的設計工具型 Web 環境:拖放模組以建置實驗,然後在低程式碼環境中部署管線。

- Jupyter Notebook:使用我們的範例筆記本或建立您自己的筆記本,將適用於 Python 的 SDK 範例用於機器學習。

- R 指令碼或筆記本,而您可以在其中使用適用於 R 的 SDK 來撰寫您自己的程式碼,或在設計工具中使用 R 模組。

- 多種模型解決方案加速器建置在 Azure Machine Learning 上,可讓您訓練、操作和管理數百個甚至數千個機器學習模型。

- 適用於 Visual Studio Code (預覽) 的機器學習延伸模組提供功能完整的開發環境,供您建置和管理機器學習專案。

- Machine Learning 命令列介面 (CLI),Azure Machine Learning 包括 Azure CLI 延伸模組,可提供從命令列使用 Azure Machine Learning 資源進行管理的命令。

- 與 PyTorch、TensorFlow 和 scikit-learn 等這類開放原始碼架構的整合,以用於訓練、部署和管理端對端機器學習程序。

- 使用 Ray RLlib 的增強式學習。

- MLflow,以追蹤計量以及部署模型或 Kubeflow,來建置端對端工作流程管線。

Microsoft Azure Machine Learning 部署的架構如下所示:

如需 Microsoft Azure Machine Learning 的詳細資訊,請參閱 Azure Machine Learning 的運作方式。

從 Databricks 的 Azure SQL

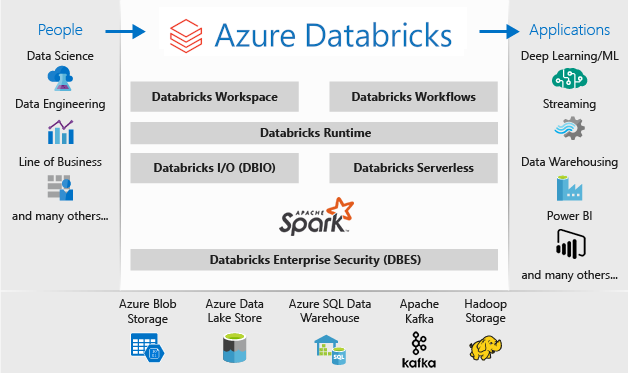

您可以針對操作資料使用一或多個 Azure SQL 資料庫選項,以及針對分析工作負載使用 Microsoft Azure Databricks,來取代 SQL Server 巨量資料叢集功能。

Azure Databricks 是一個針對 Microsoft Azure 雲端服務平台進行最佳化的資料分析平台。 Azure Databricks 提供兩個環境來開發資料密集的應用程式:Azure Databricks SQL 分析和 Azure Databricks 工作區。

Azure Databricks SQL 分析 為想要在資料湖上執行 SQL 查詢的分析師提供容易使用的平台、建立多個視覺效果類型來探索不同觀點的查詢結果,以及建立和共用儀表板。

Azure Databricks 工作區 提供互動式工作區,可讓資料工程師、資料科學家和機器學習工程師共同作業。 針對巨量資料管線,資料 (原始或結構化) 會透過 Azure Data Factory 分批內嵌到 Azure 中,或使用 Apache Kafka、事件中樞或 IoT 中樞以近乎即時的方式進行串流處理。 此資料會放置在 Data Lake 中長期持續儲存、在 Azure Blob 儲存體或 Azure Data Lake 儲存體中。 做為分析工作流程的一部分,請使用 Azure Databricks 從多個資料來源讀取資料,並使用 Spark 將其轉換為突破性的深入解析。

當您需要執行下列動作時,請使用 Microsoft Azure Databricks 來取代 SQL Server 2019 巨量資料叢集:

- 使用 Spark SQL 和資料框架的完整受控 Spark 叢集。

- 串流,以用於分析應用程式和互動式應用程式的即時資料處理和分析,與 HDFS、Flume 和 Kafka 整合。

- MLlib 程式庫的存取,包含常見的學習演算法和公用程式 (包括分類、迴歸、叢集、協同篩選、維度縮減,以及基礎最佳化基本項目)。

- 在筆記本中以 R、Python、Scala 或 SQL 來記載進度。

- 使用 Matplotlib、ggplot 或 d3 這類熟悉的工具,透過幾個步驟將資料視覺化。

- 互動式儀表板以建立動態報表。

- GraphX,用於圖表和圖表計算,適用於廣泛的使用案例範圍,從認知分析到資料探索。

- 使用動態自動調整叢集來建立叢集 (以秒為單位),並在小組之間進行共用。

- 使用 REST API 以透過程式設計方式來存取叢集。

- 立即存取每個版本的最新 Apache Spark 功能。

- Spark Core API:包括 R、SQL、Python、Scala 和 Java 的支援。

- 適用於探索和視覺化的互動式工作區。

- 雲端中的完全受控 SQL 端點。

- 在完全受控 SQL 端點上執行的 SQL 查詢,已根據查詢延遲和同時使用者數目來進行調整。

- 與 Microsoft Entra ID (前身為 Azure Active Directory) 整合。

- 角色型存取,以針對筆記本、叢集、工作和資料提供更細緻的使用者權限。

- 企業級 SLA。

- 儀表板,用於分享深入解析、合併視覺效果與文字,以共用從查詢中繪製的深入解析。

- 警示可協助您監視和整合,以及、查詢所傳回的欄位符合閾值時通知。 使用警示來監視您的業務,或將警示與工具整合來啟動工作流程,例如使用者上線或支援票證。

- 企業安全性,包括 Microsoft Entra ID 整合、角色型控制,以及可保護您資料和業務的 SLA。

- 與 Azure 服務和 Azure 資料庫及存放區的整合,包括 Synapse Analytics、Cosmos DB、Data Lake Store 和 Blob 儲存體。

- 與 Power BI 和其他 BI 工具 (例如 Tableau Software) 整合。

Microsoft Azure Databricks 部署的架構如下所示:

如需 Microsoft Azure Databricks 的詳細資訊,請參閱<什麼是 Databricks 資料科學和工程?>

混合式

網狀架構鏡像資料庫

作為數據復寫體驗,Fabric 中的資料庫鏡像是低成本且低延遲的解決方案,可將各種系統的數據結合到單一分析平臺。 可以持續將現有的資料資產直接複寫至 Fabric 的 OneLake,包括來自 Azure SQL 資料庫、Snowflake 和 Cosmos DB 的資料。

有了 OneLake 中可查詢格式的最新資料,您現在可以在 Fabric 中使用所有不同的服務,例如使用 Spark 執行分析、執行筆記本、資料工程、透過 Power BI 報表視覺化等等。

Fabric 中的鏡像提供輕鬆的體驗,以縮短深入解析和決策的價值實現時間,並打破技術解決方案之間的資料孤島,而不需要開發昂貴的擷取、轉換和載入 (ETL) 程序來移動資料。

使用 Fabric 中的鏡像時,您不需要將多個廠商的不同服務拼湊在一起。 相反地,您可以享受高度整合、端對端且易於使用的產品,其設計目的是簡化分析需求,並針對可讀取開放原始碼 Delta Lake 資料表格式的技術解決方案之間的開放和共同作業而建置。

如需詳細資訊,請參閱

- Microsoft網狀架構鏡像資料庫

- Microsoft Fabric 鏡像資料庫監控

- 使用 Microsoft Fabric 探索鏡像資料庫中的資料

- Microsoft Fabric 是什麼?

- Microsoft Fabric 預設 Power BI 語意模型的模型資料

- Lakehouse 的 SQL 分析端點是什麼?

- Direct Lake

搭配使用 SQL Server 2022 與 Azure Synapse Link for SQL

SQL Server 2022 (16.x) 包含一項新功能,可允許 SQL Server 資料表與 Microsoft Azure Synapse 平台之間的連線:Azure Synapse Link for SQL。 Azure Synapse Link for SQL Server 2022 (16.x) 提供自動變更摘要,以擷取 SQL Server 內的變更,並將其載入至 Azure Synapse Analytics。 其提供近乎即時的分析與混合式交易和分析處理,對作業系統的影響最小。 資料位於 Synapse 之後,不論大小、規模或格式為何,您都可以將其與許多不同的資料來源合併,以及使用您選擇的 Azure Machine Learning、Spark 或 Power BI 對所有資料執行功能強大的分析。 因為自動變更摘要只會推送新功能或不同的功能,所以資料傳輸速率會更快,而且現在允許近乎即時的深入解析,而且對 SQL Server 2022 年 2022 (16.x) 中來源資料庫的效能影響最小。

針對您的操作和甚至大部分的分析工作負載,SQL Server 可以處理大量資料庫大小;如需 SQL Server 容量規格上限的詳細資訊,請參閱依 SQL Server 版本的計算容量限制。 在具有分割 T-SQL 要求的不同機器上使用多個 SQL Server 執行個體,可讓應用程式使用擴增環境。

使用 PolyBase 可讓您的 SQL Server 執行個體直接從 SQL Server、Oracle、Teradata、MongoDB 和 Cosmos DB 使用 T-SQL 來查詢資料,而不需要個別安裝用戶端連線軟體。 您也可以使用 Microsoft Windows 型執行個體上的一般 ODBC 連接器,以使用協力廠商 ODBC 驅動程式來連線至其他提供者。 PolyBase 可讓 T-SQL 查詢將資料從外部來源聯結至 SQL Server 執行個體中的關聯式資料表。 這允許將資料保留在其原始位置和格式。 您可以在 SQL Server 執行個體中虛擬化外部資料,使其可在 SQL Server 中的其他任何資料表這類位置進行查詢。 SQL Server 2022 (16.x) 也允許透過物件存放區 (使用 S3 API) 硬體或軟體儲存體選項來進行特定查詢和備份/還原。

兩個一般參考架構是針對結構化資料查詢在獨立伺服器上使用 SQL Server,以及個別安裝擴增非關聯式系統 (例如 Apache Hadoop 或 Apache Spark) 以進行內部部署連結至 Synapse,而另一個選項是搭配使用 Kubernetes 叢集中的一組容器與您解決方案的所有元件。

Windows、Apache Spark 和物件儲存體內部部署上的 Microsoft SQL Server

您可以在 Windows 或 Linux 上安裝 SQL Server,以及擴大硬體架構,並使用 SQL Server 2022 (16.x) 物件存放區查詢功能和 PolyBase 功能,以在系統中啟用所有資料的查詢。

安裝和設定 Apache Hadoop 或 Apache Spark 這類擴增平台,可讓您大規模查詢非關聯式資料。 使用支援 S3 API 的一組中央物件儲存體系統,可讓 SQL Server 2022 (16.x) 和 Spark 在所有系統上都存取一組相同的資料。

適用於 SQL Server 和 Azure SQL 的 Microsoft Apache Spark 連接器也可讓您使用 Spark 工作直接從 SQL Server 查詢資料。 如需適用於 SQL Server 和 Azure SQL 的 Apache Spark 連接器的詳細資訊,請參閱<Apache Spark 連接器:SQL Server 和 Azure SQL>。

您也可以使用 Kubernetes 容器協調流程系統來進行部署。 這允許宣告式架構,可在內部部署或支援 Kubernetes 或 Red Hat OpenShift 平台的任何雲端中執行。 若要深入了解如何將 SQL Server 部署至 Kubernetes 環境,請參閱在<在 Azure 上部署 SQL Server 容器叢集>,或觀看在 Kubernetes 中部署 SQL Server 2019。

當您需要執行下列動作時,請使用 SQL Server 和 Hadoop/Spark 內部部署來取代 SQL Server 2019 巨量資料叢集:

- 在內部部署保留整個解決方案

- 針對解決方案的所有部分使用專用硬體

- 從相同架構存取關聯式和非關聯式資料,雙向

- 在 SQL Server 與擴增非關聯式系統之間共用一組非關聯式資料

執行移轉。

在您挑選位置 (雲端中或混合式) 進行移轉之後,應該考慮停機和成本向量,以判定您是否執行新的系統,並將資料從上一個系統即時移至新的系統 (並存移轉) 或備份與還原,或是從現有資料來源的全新系統 (就地移轉)。

您的下一個決策是使用新的架構選擇來重寫系統中的目前功能,或盡可能將大部分的程式碼移至新的系統。 雖然先前的選擇可能需要較長的時間,但可讓您使用新架構所提供的新方法、概念和優點。 在此情況下,資料存取和功能對應是您應該專注的主要規劃工作。

如果您打算盡可能在使用最少程式碼變更的情況下來移轉目前系統,則語言相容性是您規劃的主要焦點。

程式碼移轉

下一個步驟是稽核目前系統所使用的程式碼,以及針對新環境執行所需執行的變更。

程式碼移轉需要考量兩個主要向量:

- 來源和接收器

- 功能移轉

來源和接收器

程式碼移轉的第一項工作是識別程式碼用來存取所匯入資料、其路徑和最終目的地的資料來源連線方法、字串或 API。 記載這些來源,並建立新架構位置的地圖。

- 如果目前解決方案使用「管線」系統以透過系統來移動資料,則請將新的架構來源、步驟和接收器對應至管線的元件。

- 如果新的解決方案也會取代「管線」架構,則請針對規劃目的將系統視為新的安裝,即使您重複使用硬體或雲端平台作為取代項目也是一樣。

功能移轉

移轉所需的最複雜工作是參考、更新或建立目前系統功能的文件。 如果您要規劃就地升級,並嘗試盡可能減少程式碼重寫數量,則此步驟將花費最多時間。

不過,從先前的技術移轉通常是讓自己擁有最新技術並利用其所提供建構的最佳時機。 通常,您可以重寫目前系統,以獲得更多安全性、效能、功能選擇,甚至成本最佳化。

不論是哪一種情況,您都有兩個主要因素涉及移轉:新系統所支援的程式碼和語言,以及資料移動的選擇。 通常,您應該能夠將連接字串從目前的巨量資料叢集變更為 SQL Server 執行個體和 Spark 環境。 任何資料連線資訊和程式碼完全移轉應該最少。

如果您預想要重寫目前功能,則請將新的程式庫、套件和 DLL 對應至您為移轉所選擇的架構。 您將會找到每個程式庫、語言和函數的清單,而每個解決方案都會在先前各節所示的文件參考中提供這些程式庫、語言和函數。 對應任何可疑或不受支援的語言,並規劃以選擇的架構予以取代。

資料移轉選項

大規模分析系統中有兩種常見方式可進行資料移動。 第一個是建立「完全移轉」程序,讓原始系統繼續處理資料,並將該資料積存成一組較小的彙總報表資料來源。 新系統接著會使用全新資料開始,並從移轉日期開始使用。

在某些情況下,所有資料都需要從舊版系統移至新系統。 在此情況下,如果新系統支援原始檔案存放區,則可以從 SQL Server 巨量資料叢集掛接原始檔案存放區,然後將資料片段複製至新系統,或者您可以建立實體移動。

將目前資料從 SQL Server 2019 巨量資料叢集移轉至另一個系統高度相依於兩個因素:目前資料的位置,以及目的地為內部部署或雲端。

內部部署資料移轉

針對內部部署到內部部署移轉,您可以使用備份和還原策略來移轉 SQL Server 資料,也可以設定複寫來移動部分或所有關聯式資料。 SQL Server Integration Services 也可以用來將資料從 SQL Server 複製至另一個位置。 如需使用 SSIS 來移動資料的詳細資訊,請參閱 SQL Server Integration Services。

針對您目前 SQL Server 巨量資料叢集環境中的 HDFS 資料,標準方式是將資料掛接至獨立 Spark 叢集,並使用物件儲存體程序來移動資料,以讓 SQL Server 2022 (16.x) 執行個體可以對其進行存取,或保持原狀並繼續使用 Spark 工作來處理資料。

雲端中資料移轉

針對位於雲端儲存體或內部部署中的資料,您可以使用具有超過 90 個連接器可作為完整傳輸管線的 Azure Data Factory,以及排程、監視、警示和其他服務。 如需 Azure Data Factory 的詳細資訊,請參閱什麼是 Azure Data Factory?

如果您想要安全且快速地將大量資料從本機資料資產移至 Microsoft Azure,則可以使用 Azure 匯入/匯出服務。 Azure 匯入/匯出服務用來將硬碟運送到 Azure 資料中心,以安全地將大量資料匯入至 Azure Blob 儲存體和 Azure 檔案服務。 這項服務也能用來將資料從 Azure Blob 儲存體傳輸到磁碟機,然後運送到您的內部部署網站。 來自一或多個磁碟機的資料可匯入 Azure Blob 儲存體或 Azure 檔案服務中。 針對極大量資料,使用此服務可能是最快的路徑。

如果您想要使用由 Microsoft 提供的磁碟機來傳輸資料,則可以使用 Azure 資料箱磁碟將資料匯入到 Azure。 如需詳細資訊,請參閱什麼是 Azure 匯入/匯出服務?

如需這些選項和其隨附決策的詳細資訊,請參閱針對巨量資料需求使用 Azure Data Lake Storage Gen1。