封存的版本資訊

摘要

Azure HDInsight 是最受企業客戶歡迎的其中一項服務,可供 Azure 上的開放原始碼分析使用。 訂閱 HDInsight 版本資訊,以取得關於 HDInsight 和所有 HDInsight 版本的最新資訊。

若要訂閱,請按兩下橫幅中的「監看式」按鈕,並注意 HDInsight 版本。

版本資訊

發行日期:2024 年 8 月 30 日

注意

這是資源提供者的 Hotfix/維護版本。 如需詳細資訊,請參閱資源提供者。

Azure HDInsight 會定期發行維護更新,以提供錯誤修正、效能增強和安全性修補程式,以確保您隨時掌握這些更新保證最佳的效能和可靠性。

此發行備註適用於

HDInsight 5.1 版本。

HDInsight 5.0 版本。

HDInsight 4.0 版本。

在數天內,所有區域都可以使用 HDInsight 發行版本。 此發行備註適用於映像編號 2407260448。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 5.1:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

注意

Ubuntu 18.04 由 Azure Linux 小組的延伸安全性維護 (ESM) 支援 2023 年 7 月 Azure HDInsight 及更新版本。

如需工作負載特定版本,請參閱 HDInsight 5.x 元件版本。

已修正問題

- 預設 DB 錯誤修正。

即將推出

即將推出

- 基本 VM 和標準 A 系列 VM 淘汰。

- 我們會在 2024 年 8 月 31 日,淘汰基本和標準的 A 系列 VM。 在該日期之前,您必須將工作負載遷移至 Av2 系列 VM,此系列可提供每個 vCPU 更多的記憶體,以及在固態硬碟上 (SSD) 提供更快速的儲存體。

- 為了避免服務中斷,請在 2024 年 8 月 31 日之前移轉工作負載,從基本和標準 A 系列 VM 移轉至 Av2 系列 VM。

- HDInsight 4.0 和 HDInsight 5.0 的淘汰通知。

若您還有任何其他疑問,請連絡 Azure 支援。

您隨時可以在 Azure HDInsight - Microsoft Q&A 上向我們詢問 HDInsight 相關資訊。

我們會持續聽取您的意見:歡迎您在這裡新增更多想法和其他主題並進行投票 - HDInsight Ideas,並追蹤我們以取得更多 AzureHDInsight 社群的更新。

發行日期:2024 年 8 月 9 日

此發行備註適用於

HDInsight 5.1 版本。

HDInsight 5.0 版本。

HDInsight 4.0 版本。

在數天內,所有區域都可以使用 HDInsight 發行版本。 此發行備註適用於映像編號 2407260448。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 5.1:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

注意

Ubuntu 18.04 由 Azure Linux 小組的延伸安全性維護 (ESM) 支援 2023 年 7 月 Azure HDInsight 及更新版本。

如需工作負載特定版本,請參閱 HDInsight 5.x 元件版本。

更新

在 HDInsight 中新增適用於 Log Analytics 的 Azure 監視器代理程式

針對 Log Analytics 新增 SystemMSI 和自動化 DCR,因為已淘汰新的 Azure 監視器體驗 (預覽)。

注意

有效的映像編號 2407260448,使用入口網站進行記錄分析的客戶將會有預設的 Azure 監視器代理程式體驗。 如果您想要切換至 Azure 監視器體驗 (預覽),則可以建立支援要求,將叢集釘選到舊版映像。

發行日期:2024 年 7 月 05 日

注意

這是資源提供者的 Hotfix/維護版本。 如需詳細資訊,請參閱資源提供者

已修正的問題

HOBO 標記會覆寫使用者標記。

- HOBO 標記會在 HDInsight 叢集建立時覆寫子資源上的使用者標記。

發行日期:2024 年 6 月 19 日

此發行備註適用於

HDInsight 5.1 版本。

HDInsight 5.0 版本。

HDInsight 4.0 版本。

在數天內,所有區域都可以使用 HDInsight 發行版本。 此發行備註適用於映像編號 2406180258。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 5.1:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

注意

Ubuntu 18.04 由 Azure Linux 小組的延伸安全性維護 (ESM) 支援 2023 年 7 月 Azure HDInsight 及更新版本。

如需工作負載特定版本,請參閱 HDInsight 5.x 元件版本。

已修正的問題

安全性增強功能

改善具有 HDInsight 資源提供者系統受控識別支援的 HDInsight Log Analytics。

新增活動以升級舊映像 (在 2024 年之前建立) 的

mdsd代理程式版本。在閘道中啟用 MISE,作為 MSAL 移轉持續改善的一部分。

將 Spark Thrift 伺服器

Httpheader hiveConf併入 Jetty HTTP ConnectionFactory。還原 RANGER-3753 和 RANGER-3593。

Ranger 2.3.0 版本中給定的

setOwnerUser實作在 Hive 使用時會發生重大迴歸問題。 在 Ranger 2.3.0 中,HiveServer2 嘗試評估原則時,Ranger Client 會呼叫 setOwnerUser 函數中的 Metastore 來嘗試取得 Hive 資料表的擁有者,而此函數基本上會呼叫儲存體來檢查該資料表的存取權。 在 2.3.0 Ranger 上執行 Hive 時,此問題會導致查詢的執行速度變慢。

即將推出

- 基本 VM 和標準 A 系列 VM 淘汰。

- 我們會在 2024 年 8 月 31 日,淘汰基本和標準的 A 系列 VM。 在該日期之前,您必須將工作負載遷移至 Av2 系列 VM,此系列可提供每個 vCPU 更多的記憶體,以及在固態硬碟上 (SSD) 提供更快速的儲存體。

- 為了避免服務中斷,請在 2024 年 8 月 31 日之前移轉工作負載,從基本和標準 A 系列 VM 移轉至 Av2 系列 VM。

- HDInsight 4.0 和 HDInsight 5.0 的淘汰通知。

若您還有任何其他疑問,請連絡 Azure 支援。

您隨時可以在 Azure HDInsight - Microsoft Q&A 上向我們詢問 HDInsight 相關資訊。

我們會持續聽取您的意見:歡迎您在這裡新增更多想法和其他主題並進行投票 - HDInsight Ideas,並追蹤我們以取得更多 AzureHDInsight 社群的更新。

發行日期:2024 年 5 月 16 日

此發行備註適用於

HDInsight 5.0 版本。

HDInsight 4.0 版本。

在數天內,所有區域都可以使用 HDInsight 發行版本。 此發行備註適用於映像編號 2405081840。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

注意

Ubuntu 18.04 由 Azure Linux 小組的延伸安全性維護 (ESM) 支援 2023 年 7 月 Azure HDInsight 及更新版本。

如需工作負載特定版本,請參閱 HDInsight 5.x 元件版本。

已修正的問題

- 已在閘道中新增 API,以取得 Keyvault 的權杖,做為 SFI 計劃的一部分。

- 在新的記錄監視器

HDInsightSparkLogs資料表中,針對記錄類型SparkDriverLog,遺漏了部分欄位。 例如:LogLevel & Message。 此版本會將遺漏的欄位新增至SparkDriverLog的結構描述和固定格式設定。 - Log Analytics 監視

SparkDriverLog資料表中無法使用 Livy 記錄,這是因為 Livy 記錄來源路徑和SparkLivyLog設定中的記錄剖析 regex 發生問題。 - 任何使用 ADLS Gen2 做為主要儲存體帳戶的 HDInsight 叢集都可以運用 MSI 存取應用程式程式碼內使用的任何 Azure 資源 (例如 SQL、Keyvaults)。

即將推出

- 基本 VM 和標準 A 系列 VM 淘汰。

- 我們會在 2024 年 8 月 31 日,淘汰基本和標準的 A 系列 VM。 在該日期之前,您必須將工作負載遷移至 Av2 系列 VM,此系列可提供每個 vCPU 更多的記憶體,以及在固態硬碟上 (SSD) 提供更快速的儲存體。

- 為了避免服務中斷,請在 2024 年 8 月 31 日之前移轉工作負載,從基本和標準 A 系列 VM 移轉至 Av2 系列 VM。

- HDInsight 4.0 和 HDInsight 5.0 的淘汰通知。

若您還有任何其他疑問,請連絡 Azure 支援。

您隨時可以在 Azure HDInsight - Microsoft Q&A 上向我們詢問 HDInsight 相關資訊。

我們會持續聽取您的意見:歡迎您在這裡新增更多想法和其他主題並進行投票 - HDInsight Ideas,並追蹤我們以取得更多 AzureHDInsight 社群的更新。

發行日期:2024 年 4 月 15 日

此版本附註適用於 HDInsight 5.1 版。

在數天內,所有區域都可以使用 HDInsight 發行版本。 此發行備註適用於映像編號 2403290825。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 5.1:Ubuntu 18.04.5 LTS Linux Kernel 5.4

注意

Ubuntu 18.04 由 Azure Linux 小組的延伸安全性維護 (ESM) 支援 2023 年 7 月 Azure HDInsight 及更新版本。

如需工作負載特定版本,請參閱 HDInsight 5.x 元件版本。

已修正的問題

- Ambari DB、Hive Warehouse Controller (HWC)、Spark、HDFS 的 BUG 修正

- HDInsightSparkLogs 的 Log Analytics 模組錯誤修正

- HDInsight 資源提供者的 CVE 修正程式。

即將推出

- 基本 VM 和標準 A 系列 VM 淘汰。

- 我們會在 2024 年 8 月 31 日,淘汰基本和標準的 A 系列 VM。 在該日期之前,您必須將工作負載遷移至 Av2 系列 VM,此系列可提供每個 vCPU 更多的記憶體,以及在固態硬碟上 (SSD) 提供更快速的儲存體。

- 為了避免服務中斷,請在 2024 年 8 月 31 日之前移轉工作負載,從基本和標準 A 系列 VM 移轉至 Av2 系列 VM。

- HDInsight 4.0 和 HDInsight 5.0 的淘汰通知。

若您還有任何其他疑問,請連絡 Azure 支援。

您隨時可以在 Azure HDInsight - Microsoft Q&A 上向我們詢問 HDInsight 相關資訊。

我們會持續聽取您的意見:歡迎您在這裡新增更多想法和其他主題並進行投票 - HDInsight Ideas,並追蹤我們以取得更多 AzureHDInsight 社群的更新。

發行日期:2024 年 2 月 15 日

此版本適用於 HDInsight 4.x 和 5.x 版。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此版本適用於映像編號 2401250802。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1:Ubuntu 18.04.5 LTS Linux Kernel 5.4

注意

Ubuntu 18.04 由 Azure Linux 小組的延伸安全性維護 (ESM) 支援 2023 年 7 月 Azure HDInsight 及更新版本。

如需工作負載特定版本,請參閱

新功能

- Apache Ranger 在 Spark 3.3.0 (HDInsight 5.1 版) 中使用企業安全性套件支援 Spark SQL。 在此深入了解。

已修正的問題

- Ambari 和 Oozie 元件的安全性修正

即將推出

即將推出

- 基本 VM 和標準 A 系列 VM 淘汰。

- 我們會在 2024 年 8 月 31 日,淘汰基本和標準的 A 系列 VM。 在該日期之前,您必須將工作負載遷移至 Av2 系列 VM,此系列可提供每個 vCPU 更多的記憶體,以及在固態硬碟上 (SSD) 提供更快速的儲存體。

- 為了避免服務中斷,請在 2024 年 8 月 31 日之前移轉工作負載,從基本和標準 A 系列 VM 移轉至 Av2 系列 VM。

若您還有任何其他疑問,請連絡 Azure 支援。

您隨時可以在 Azure HDInsight - Microsoft Q&A 上向我們詢問 HDInsight 相關資訊

我們會持續聽取您的意見:歡迎您在這裡新增更多想法和其他主題並投票 - HDInsight Ideas,並追蹤我們以取得更多 AzureHDInsight 社群的更新

下一步

Azure HDInsight 是最受企業客戶歡迎的其中一項服務,可供 Azure 上的開放原始碼分析使用。 如果您要訂閱版本資訊,請在此 GitHub 存放庫上觀看發行版本。

發行日期:2024 年 1 月 10 日

此 Hotfix 版本適用於 HDInsight 4.x 和 5.x 版。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此版本適用於映像編號 2401030422。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1:Ubuntu 18.04.5 LTS Linux Kernel 5.4

注意

Ubuntu 18.04 由 Azure Linux 小組的延伸安全性維護 (ESM) 支援 2023 年 7 月 Azure HDInsight 及更新版本。

如需工作負載特定版本,請參閱

已修正的問題

- Ambari 和 Oozie 元件的安全性修正

即將推出

即將推出

- 基本 VM 和標準 A 系列 VM 淘汰。

- 我們會在 2024 年 8 月 31 日,淘汰基本和標準的 A 系列 VM。 在該日期之前,您必須將工作負載遷移至 Av2 系列 VM,此系列可提供每個 vCPU 更多的記憶體,以及在固態硬碟上 (SSD) 提供更快速的儲存體。

- 為了避免服務中斷,請在 2024 年 8 月 31 日之前移轉工作負載,從基本和標準 A 系列 VM 移轉至 Av2 系列 VM。

若您還有任何其他疑問,請連絡 Azure 支援。

您隨時可以在 Azure HDInsight - Microsoft Q&A 上向我們詢問 HDInsight 相關資訊

我們會持續聽取您的意見:歡迎您在這裡新增更多想法和其他主題並投票 - HDInsight Ideas,並追蹤我們以取得更多 AzureHDInsight 社群的更新

發行日期:2023 年 10 月 26 日

此版本適用於 HDInsight 4.x 和 5.x HDInsight 版本,將可在數天內供所有區域使用。 此版本適用於映像編號 2310140056。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1:Ubuntu 18.04.5 LTS Linux Kernel 5.4

如需工作負載特定版本,請參閱

最新功能

HDInsight 宣佈從 2023 年 11 月 1 日起正式發行 HDInsight 5.1。 此版本針對開放原始碼元件推出 Microsoft 提供的完整堆疊重新整理以及整合。

- 最新開放原始碼版本 – HDInsight 5.1 隨附最新的穩定開放原始碼版本。 客戶可受益於所有最新的開放原始碼功能、Microsoft 效能改進和錯誤修正。

- 安全 – 最新版本隨附最新的安全性修正,包括開放原始碼安全性修正和 Microsoft 提供的安全性改進。

- TCO 較低 – 客戶可以透過效能增強功能,以及增強型自動調整來降低營運成本。

安全記憶體的叢集權限

- 客戶可以 (在建立叢集期間) 指定安全通道是否應該用於 HDInsight 叢集節點,以連線記憶體帳戶。

使用自訂 VNet 建立 HDInsight 叢集。

- 若要改善 HDInsight 叢集的整體安全性態勢,使用自訂 VNET 的 HDInsight 叢集必須確保使用者必須具備

Microsoft Network/virtualNetworks/subnets/join/action權限,才能執行建立作業。 如果未啟用此檢查,客戶可能會面臨建立失敗。

- 若要改善 HDInsight 叢集的整體安全性態勢,使用自訂 VNET 的 HDInsight 叢集必須確保使用者必須具備

非 ESP ABFS 叢集 [Word 可讀取叢集權限]

- 非 ESP ABFS 叢集會限制非 Hadoop 群組使用者執行記憶體作業的 Hadoop 命令。 這項變更可改善叢集安全性態勢。

內嵌配額更新。

- 現在,您可以直接從 [我的配額] 頁面要求增加配額,並搭配直接 API 呼叫,速度會大幅提升。 如果 API 呼叫失敗,您可以建立增加配額的新支援要求。

即將推出

即將推出

叢集名稱的最大長度將從 59 個字元變更為 45 個字元,以改善叢集的安全性態勢。 從即將發行的發行版本開始,這項變更將會推出到所有區域。

基本 VM 和標準 A 系列 VM 淘汰。

- 我們會在 2024 年 8 月 31 日,淘汰基本和標準的 A 系列 VM。 在該日期之前,您必須將工作負載遷移至 Av2 系列 VM,此系列可提供每個 vCPU 更多的記憶體,以及在固態硬碟上 (SSD) 提供更快速的儲存體。

- 為了避免服務中斷,請在 2024 年 8 月 31 日之前移轉工作負載,從基本和標準 A 系列 VM 移轉至 Av2 系列 VM。

若您還有任何其他疑問,請連絡 Azure 支援。

您隨時可以在 Azure HDInsight - Microsoft Q&A 上向我們詢問 HDInsight 相關資訊

我們會持續聽取您的意見:歡迎您在這裡新增更多想法和其他主題並投票 - HDInsight Ideas,並追蹤我們以取得更多 AzureHDInsight 社群的更新

注意

此版本說明 MSRC 在 2023 年 9 月 12 日發行的下列 CVE。 動作是更新至最新的映像 2308221128 或 2310140056。 建議客戶據以進行規劃。

| CVE | 嚴重性 | CVE 標題 | 備註 |

|---|---|---|---|

| CVE-2023-38156 | 重要 | Azure HDInsight Apache Ambari 權限提高弱點 | 包含在映像 2308221128 或 2310140056 |

| CVE-2023-36419 | 重要 | Azure HDInsight Apache Oozie 工作流程排程器權限提高弱點 | 在叢集上套用指令碼動作,或更新為 2310140056 映像 |

發行日期:2023 年 9 月 7 日

此版本適用於 HDInsight 4.x 和 5.x HDInsight 版本,將可在數天內供所有區域使用。 此版本適用於映像編號 2308221128。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1:Ubuntu 18.04.5 LTS Linux Kernel 5.4

如需工作負載特定版本,請參閱

重要

此版本說明 MSRC 在 2023 年 9 月 12 日發行的下列 CVE。 動作是更新至最新的映像 2308221128。 建議客戶據以進行規劃。

| CVE | 嚴重性 | CVE 標題 | 備註 |

|---|---|---|---|

| CVE-2023-38156 | 重要 | Azure HDInsight Apache Ambari 權限提高弱點 | 包含在 2308221128 映像上 |

| CVE-2023-36419 | 重要 | Azure HDInsight Apache Oozie 工作流程排程器權限提高弱點 | 在叢集上套用指令碼動作 |

即將推出

- 叢集名稱的最大長度將從 59 個字元變更為 45 個字元,以改善叢集的安全性態勢。 這項變更將於 2023 年 9 月 30 日實施。

- 安全記憶體的叢集權限

- 客戶可以 (在建立叢集期間) 指定安全通道是否應該用於 HDInsight 叢集節點,以連絡記憶體帳戶。

- 內嵌配額更新。

- 要求配額會直接從 [我的配額] 頁面增加,這會是直接 API 呼叫,速度較快。 如果 APdI 呼叫失敗,則客戶必須建立配額增加的新支援要求。

- 使用自訂 VNet 建立 HDInsight 叢集。

- 若要改善 HDInsight 叢集的整體安全性態勢,使用自訂 VNET 的 HDInsight 叢集必須確保使用者必須具備

Microsoft Network/virtualNetworks/subnets/join/action權限,才能執行建立作業。 客戶必須據以進行規劃,因為這項變更是必要檢查,以避免在 2023 年 9 月 30 日之前發生叢集建立失敗。

- 若要改善 HDInsight 叢集的整體安全性態勢,使用自訂 VNET 的 HDInsight 叢集必須確保使用者必須具備

- 基本 VM 和標準 A 系列 VM 淘汰。

- 我們會在 2024 年 8 月 31 日,淘汰基本和標準的 A 系列 VM。 在該日期之前,您必須將工作負載遷移至 Av2 系列 VM,此系列可提供每個 vCPU 更多的記憶體,以及在固態硬碟上 (SSD) 提供更快速的儲存體。 為了避免服務中斷,請在 2024 年 8 月 31 日之前移轉工作負載,從基本和標準 A 系列 VM 移轉至 Av2 系列 VM。

- 非 ESP ABFS 叢集 [Word 可讀取的叢集權限]

- 規劃在非 ESP ABFS 叢集中引進變更,會限制非 Hadoop 群組使用者執行記憶體作業的 Hadoop 命令。 這項變更可改善叢集安全性態勢。 客戶必須在 2023 年 9 月 30 日之前規劃更新。

若您還有任何其他疑問,請連絡 Azure 支援。

您隨時可以在 Azure HDInsight - Microsoft Q&A 上向我們詢問 HDInsight 相關資訊

歡迎在這裡新增更多提案和想法及其他主題,並進行投票 - HDInsight 社群 (azure.com)。

發行日期:2023 年 7 月 25 日

此版本適用於 HDInsight 4.x 和 5.x HDInsight 版本,將可在數天內供所有區域使用。 此版本適用於映像編號 2307201242。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1:Ubuntu 18.04.5 LTS Linux Kernel 5.4

如需工作負載特定版本,請參閱

新功能

新功能

- ESP 叢集現在支援 HDInsight 5.1。

- 升級版本的 Ranger 2.3.0 和 Oozie 5.2.1 現在屬於 HDInsight 5.1

- Spark 3.3.1 (HDInsight 5.1) 叢集隨附 Hive Warehouse Connector (HWC) 2.1,可與 Interactive Query (HDInsight 5.1) 叢集搭配運作。

- Ubuntu 18.04 由 Azure Linux 小組的 ESM (延伸安全性維護) 支援 2023 年 7 月 Azure HDInsight 及更新版本。

重要

此版本說明 MSRC 在 2023 年 8 月 8 日發行的下列 CVE。 動作是更新至最新的映像 2307201242。 建議客戶據以進行規劃。

| CVE | 嚴重性 | CVE 標題 |

|---|---|---|

| CVE-2023-35393 | 重要 | Azure Apache Hive 詐騙弱點 |

| CVE-2023-35394 | 重要 | Azure HDInsight Jupyter Notebook 詐騙弱點 |

| CVE-2023-36877 | 重要 | Azure Apache Oozie 詐騙弱點 |

| CVE-2023-36881 | 重要 | Azure Apache Ambari 詐騙弱點 |

| CVE-2023-38188 | 重要 | Azure Apache Hadoop 詐騙弱點 |

即將推出

即將推出

- 叢集名稱的最大長度將從 59 個字元變更為 45 個字元,以改善叢集的安全性態勢。 客戶必須在 2023 年 9 月 30 日之前規劃更新。

- 安全記憶體的叢集權限

- 客戶可以 (在建立叢集期間) 指定安全通道是否應該用於 HDInsight 叢集節點,以連絡記憶體帳戶。

- 內嵌配額更新。

- 要求配額會直接從 [我的配額] 頁面增加,這會是直接 API 呼叫,速度較快。 如果 API 呼叫失敗,則客戶必須建立配額增加的新支援要求。

- 使用自訂 VNet 建立 HDInsight 叢集。

- 若要改善 HDInsight 叢集的整體安全性態勢,使用自訂 VNET 的 HDInsight 叢集必須確保使用者必須具備

Microsoft Network/virtualNetworks/subnets/join/action權限,才能執行建立作業。 客戶必須據以進行規劃,因為這項變更是必要檢查,以避免在 2023 年 9 月 30 日之前發生叢集建立失敗。

- 若要改善 HDInsight 叢集的整體安全性態勢,使用自訂 VNET 的 HDInsight 叢集必須確保使用者必須具備

- 基本 VM 和標準 A 系列 VM 淘汰。

- 我們會在 2024 年 8 月 31 日,淘汰基本和標準的 A 系列 VM。 在該日期之前,您必須將工作負載遷移至 Av2 系列 VM,此系列可提供每個 vCPU 更多的記憶體,以及在固態硬碟上 (SSD) 提供更快速的儲存體。 為了避免服務中斷,請在 2024 年 8 月 31 日之前移轉工作負載,從基本和標準 A 系列 VM 移轉至 Av2 系列 VM。

- 非 ESP ABFS 叢集 [Word 可讀取的叢集權限]

- 規劃在非 ESP ABFS 叢集中引進變更,會限制非 Hadoop 群組使用者執行記憶體作業的 Hadoop 命令。 這項變更可改善叢集安全性態勢。 客戶必須在 2023 年 9 月 30 日之前規劃更新。

若您還有任何其他疑問,請連絡 Azure 支援。

您隨時可以在 Azure HDInsight - Microsoft Q&A 上向我們詢問 HDInsight 相關資訊

歡迎在這裡新增更多提案和想法及其他主題,並進行投票 - HDInsight 社群 (azure.com) 並在 X 上追蹤我們以取得更多更新

發行日期:2023 年 5 月 08 日

此版本適用於 HDInsight 4.x 和 5.x HDInsight 版本,可在數天內供所有區域使用。 此版本適用於映像編號 2304280205。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

如需工作負載特定版本,請參閱

![]()

已更新 Azure HDInsight 5.1 與

- Apache HBase 2.4.11

- Apache Phoenix 5.1.2

- Apache Hive 3.1.2

- Apache Spark 3.3.1

- Apache Tez 0.9.1

- Apache Zeppelin 0.10.1

- Apache Livy 0.5

- Apache Kafka 3.2.0

注意

- 所有元件都與 Hadoop 3.3.4 和 ZK 3.6.3 整合

- 上述所有升級的元件現在都可在非 ESP 叢集中取得公開預覽。

![]()

HDInsight 的增強自動調整

Azure HDInsight 已大幅改善自動調整的穩定性和延遲,基本變更包括改善的調整決策意見反應迴圈、調整延遲的大幅改善,以及支援將已解除委任的節點重新委任、深入了解增強功能、如何自訂設定叢集,並將叢集移轉至增強自動調整。 在所有支援的區域中,增強的自動調整功能將於 2023 年 5 月 17 日生效。

適用於 Apache Kafka 2.4.1 的 Azure HDInsight ESP 現已正式推出。

Azure HDInsight ESP for Apache Kafka 2.4.1 自 2022 年 4 月起持續處於公開預覽狀態。 在 CVE 修正和穩定性的顯著改善之後,Azure HDInsight ESP Kafka 2.4.1 現在已正式推出,並針對生產環境工作負載進行準備,深入了解如何設定和移轉。

HDInsight 配額管理

HDInsight 目前會將配額配置給區域層級的客戶訂用帳戶。 配置給客戶的核心為泛型,而不是分類在 VM 系列層級 (例如,

Dv2、Ev3、Eav4等)。HDInsight 引進了改良的檢視,可提供系列層級 VM 配額的詳細資料和分類,此功能可讓客戶檢視 VM 系列層級區域的目前和剩餘配額。 透過增強的檢視,客戶對於規劃配額具有更豐富的可見度,以及較佳的使用者經驗。 此功能目前適用於美國東部 EUAP 區域的 HDInsight 4.x 和 5.x。 稍後要遵循的其他區域。

![]()

- 波蘭中部

- 叢集名稱的最大長度會從 59 個字元變更為 45 個字元,以改善叢集的安全性態勢。

- 安全記憶體的叢集權限

- 客戶可以 (在建立叢集期間) 指定安全通道是否應該用於 HDInsight 叢集節點,以連絡記憶體帳戶。

- 內嵌配額更新。

- 要求配額會直接從 [我的配額] 頁面增加,這是直接 API 呼叫,速度較快。 如果 API 呼叫失敗,則客戶必須建立配額增加的新支援要求。

- 使用自訂 VNet 建立 HDInsight 叢集。

- 若要改善 HDInsight 叢集的整體安全性態勢,使用自訂 VNET 的 HDInsight 叢集必須確保使用者必須具備

Microsoft Network/virtualNetworks/subnets/join/action權限,才能執行建立作業。 客戶必須據以進行規劃,因為這是必要檢查,以避免發生叢集建立失敗。

- 若要改善 HDInsight 叢集的整體安全性態勢,使用自訂 VNET 的 HDInsight 叢集必須確保使用者必須具備

- 基本 VM 和標準 A 系列 VM 淘汰。

- 我們會在 2024 年 8 月 31 日,淘汰基本和標準的 A 系列 VM。 在該日期之前,您必須將工作負載遷移至 Av2 系列 VM,此系列可提供每個 vCPU 更多的記憶體,以及在固態硬碟上 (SSD) 提供更快速的儲存體。 為了避免服務中斷,請在 2024 年 8 月 31 日之前移轉工作負載,從基本和標準 A 系列 VM 移轉至 Av2 系列 VM。

- 非 ESP ABFS 叢集 [Word 可讀取的叢集權限]

- 規劃在非 ESP ABFS 叢集中引進變更,會限制非 Hadoop 群組使用者執行記憶體作業的 Hadoop 命令。 這項變更可改善叢集安全性態勢。 客戶必須規劃更新。

發行日期:2023 年 2 月 28 日

此版本適用於 HDInsight 4.0。 和 5.0、5.1。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此版本適用於映像編號 2302250400。 如何檢查映像編號?

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

如需工作負載特定版本,請參閱

重要

Microsoft 已發行 CVE-2023-23408,目前版本已進行修正,建議客戶將其叢集升級至最新的映像。

![]()

HDInsight 5.1

我們已開始推出新版本的 HDInsight 5.1。 所有新的開放原始碼版本都會新增為 HDInsight 5.1 上的累加版本。

如需詳細資訊,請參閱 HDInsight 5.1.0 版

![]()

Kafka 3.2.0 升級 (預覽)

- Kafka 3.2.0 包含數個重要的新功能/改善項目。

- 已將 Zookeeper 升級至 3.6.3

- Kafka Streams 支援

- 預設會針對 Kafka 產生者啟用更強的傳遞保證。

log4j1.x 會取代為reload4j。- 將提示傳送至分割區負責人以復原分割區。

JoinGroupRequest和LeaveGroupRequest已附加原因。- 已新增 Broker 計數計量 8。

- 鏡像

Maker2改進項目。

HBase 2.4.11 升級 (預覽)

- 此版本有新功能,例如新增區塊快取的新快取機制類型、能夠改變

hbase:meta table以及從 HBase WEB UI 檢視hbase:meta資料表。

Phoenix 5.1.2 升級 (預覽)

- Phoenix 版本在此版本中已升級至 5.1.2。 此升級包含 Phoenix Query Server。 Phoenix Query Server 會 Proxy 標準 Phoenix JDBC 驅動程式,並提供回溯相容的有線通訊協定來叫用該 JDBC 驅動程式。

Ambari CVE

- 已修正多個 Ambari CVE。

注意

ESP 在此版本中不支援 Kafka 和 HBase。

![]()

下一步是什麼

- Autoscale

- 已改善延遲和數項改善的自動調整

- 叢集名稱變更限制

- 公開、Azure 中國和 Azure Government 中的叢集名稱最大長度會從 59 個變更為 45。

- 安全記憶體的叢集權限

- 客戶可以 (在建立叢集期間) 指定安全通道是否應該用於 HDInsight 叢集節點,以連絡記憶體帳戶。

- 非 ESP ABFS 叢集 [Word 可讀取的叢集權限]

- 規劃在非 ESP ABFS 叢集中引進變更,會限制非 Hadoop 群組使用者執行記憶體作業的 Hadoop 命令。 這項變更可改善叢集安全性態勢。 客戶必須規劃更新。

- 開放原始碼升級

- Apache Spark 3.3.0 和 Hadoop 3.3.4 正在 HDInsight 5.1 上進行開發,並包含數個顯著的新功能、效能和其他改善。

發行日期:2022 年 12 月 12 日

此版本適用於 HDInsight 4.0。 在數天內,所有區域都可以使用 5.0 HDInsight 發行版本。

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

作業系統版本

- HDInsight 4.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0:Ubuntu 18.04.5 LTS Linux Kernel 5.4

![]()

- Log Analytics - 客戶可以啟用傳統監視,以取得最新的 OMS 14.19 版。 若要移除舊版,請停用並啟用傳統監視。

- Ambari 使用者因為非使用狀態而自動 UI 登出。 如需詳細資訊,請參閱這裡

- Spark - 此發行版本中包含 Spark 3.1.3 的新版本和最佳化版本。 我們已使用 TPC-DS 基準測試了 Apache Spark 3.1.2 (舊版) 和 Apache Spark 3.1.3 (目前版本)。 測試是針對 1 TB 工作負載上的 Apache Spark 使用 E8 V3 SKU 進行。 針對使用相同硬體規格的 TPC-DS 查詢,Apache Spark 3.1.3 (目前版本) 總查詢執行階段的效能勝過 Apache Spark 3.1.2 (舊版) 超過 40%。 Microsoft Spark 小組已使用 Azure HDInsight 新增了可在 Azure Synapse 中使用的最佳化。 如需詳細資訊,請參閱 在 Azure Synapse 中使用 Apache Spark 3.1.2 效能更新來加速資料工作負載

![]()

- 卡達中部

- 德國北部

![]()

HDInsight 已從 Azul Zulu Java JDK 8 移轉至

Adoptium Temurin JDK 8,其支援高品質的 TCK 認證執行階段,以及跨 Java 生態系統使用的相關技術。HDInsight 已移轉至

reload4j。log4j變更適用於- Apache Hadoop \(英文\)

- Apache Zookeeper

- Apache Oozie

- Apache Ranger

- Apache Sqoop

- Apache Pig

- Apache Ambari

- Apache Kafka

- Apache Spark

- Apache Zeppelin

- Apache Livy

- Apache Rubix

- Apache Hive

- Apache Tez

- Apache HBase

- OMI

- Apache Pheonix

![]()

HDInsight 會持續實作 TLS1.2,而舊版會在平台上進行更新。 如果您是在 HDInsight 上執行任何應用程式,且這些應用程式使用 TLS 1.0 和 1.1,請升級至 TLS 1.2,以避免服務中斷。

如需詳細資訊,請參閱如何啟用傳輸層安全性 (TLS)

![]()

Ubuntu 16.04 LTS 上的 Azure HDInsight 叢集自 2022 年 11 月 30 日起已終止支援。 HDInsight 自 2021 年 6 月 27 日起開始使用 Ubuntu 18.04 發行叢集映像。 建議使用 Ubuntu 16.04 執行叢集的客戶在 2022 年 11 月 30 日前使用最新的 HDInsight 映像重建其叢集。

如需如何檢查 Ubuntu 版本叢集的詳細資訊,請參閱這裡

在終端機中執行命令 “lsb_release -a”。

如果輸出中 “Description” 屬性的值是 “Ubuntu 16.04 LTS”,則此更新適用於叢集。

![]()

- 支援 Kafka 和 HBase (寫入存取) 叢集的可用性區域選取項目。

開放原始碼錯誤 (bug) 修正

Hive Bug 修正

| 錯誤修正 | Apache JIRA |

|---|---|

| HIVE-26127 | INSERT OVERWRITE 錯誤 - 找不到檔案 |

| HIVE-24957 | 當子查詢在相互關聯述詞中包含 COALESCE 時發生錯誤的結果 |

| HIVE-24999 | HiveSubQueryRemoveRule 針對具有多個相互關聯的 IN 子查詢產生無效的計劃 |

| HIVE-24322 | 如果有直接插入,則在讀取資訊清單失敗時,必須檢查嘗試識別碼 |

| HIVE-23363 | 將 DataNucleus 相依性升級至 5.2 |

| HIVE-26412 | 建立介面以擷取可用的位置並新增預設值 |

| HIVE-26173 | 將 derby 升級至 10.14.2.0 |

| HIVE-25920 | 將 Xerce2 改為 2.12.2。 |

| HIVE-26300 | 將 Jackson 資料繫結版本升級至 2.12.6.1+ 以避免 CVE-2020-36518 |

發行日期:2022/08/10

此版本適用於 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

![]()

新功能

1.在 HDI Hadoop/Spark 叢集中連結外部磁碟

HDInsight 叢集隨附以 SKU 為基礎的預先定義磁碟空間。 在大型作業案例中,此空間可能不足。

這項新功能可讓您在叢集中新增更多磁碟,以做為節點管理員本機目錄使用。 在 HIVE 和 Spark 叢集建立期間,將磁碟數目新增至背景工作節點,而選取的磁碟為節點管理員本機目錄的一部分。

注意

新增的磁碟只會針對節點管理員本機目錄進行設定。

如需詳細資訊,請參閱這裡

2.選擇性記錄分析

選擇性記錄分析現已在所有區域提供公開預覽版。 您可以將叢集連線到 Log Analytics 工作區。 啟用之後,您可以看到 HDInsight 安全性記錄、Yarn Resource Manager、系統計量等記錄和計量。您可以監視工作負載,並查看其如何影響叢集穩定性。 選擇性記錄可讓您啟用/停用所有資料表,或啟用 Log Analytics 工作區中的選擇性資料表。 您可以調整每個資料表的來源類型,因為新版的 Geneva 監視中,一個資料表有多個來源。

- Geneva 監視系統使用 mdsd (MDS 精靈) 這個監視代理程式,並使用 fluentd 以透過整合記錄層來收集記錄。

- 選擇性記錄會使用指令碼動作來停用/啟用資料表及其記錄類型。 因為它不會開啟任何新的連接埠,或變更任何現有的安全性設定,因此沒有任何安全性變更。

- 指令碼動作會在所有指定的節點上平行執行,並變更停用/啟用資料表及其記錄類型的組態檔。

如需詳細資訊,請參閱這裡

![]()

已修正

記錄分析

與執行 OMS 第 13 版的 Azure HDInsight 整合的 Log Analytics 需要升級至 OMS 第 14 版,才能套用最新的安全性更新。 使用舊版叢集搭配 OMS 第 13 版的客戶必須安裝 OMS 第 14 版,以符合安全性需求。 (如何檢查目前的版本並安裝第 14 版)

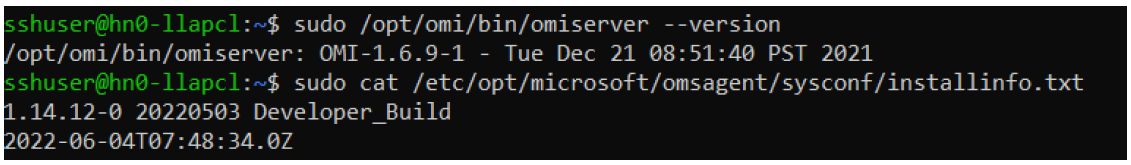

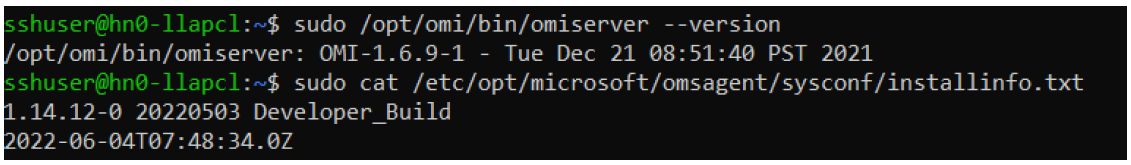

如何檢查您目前的 OMS 版本

- 使用 SSH 登入叢集。

- 在 SSH 用戶端中執行下列命令。

sudo /opt/omi/bin/ominiserver/ --version

如何將 OMS 版本從 13 升級至 14

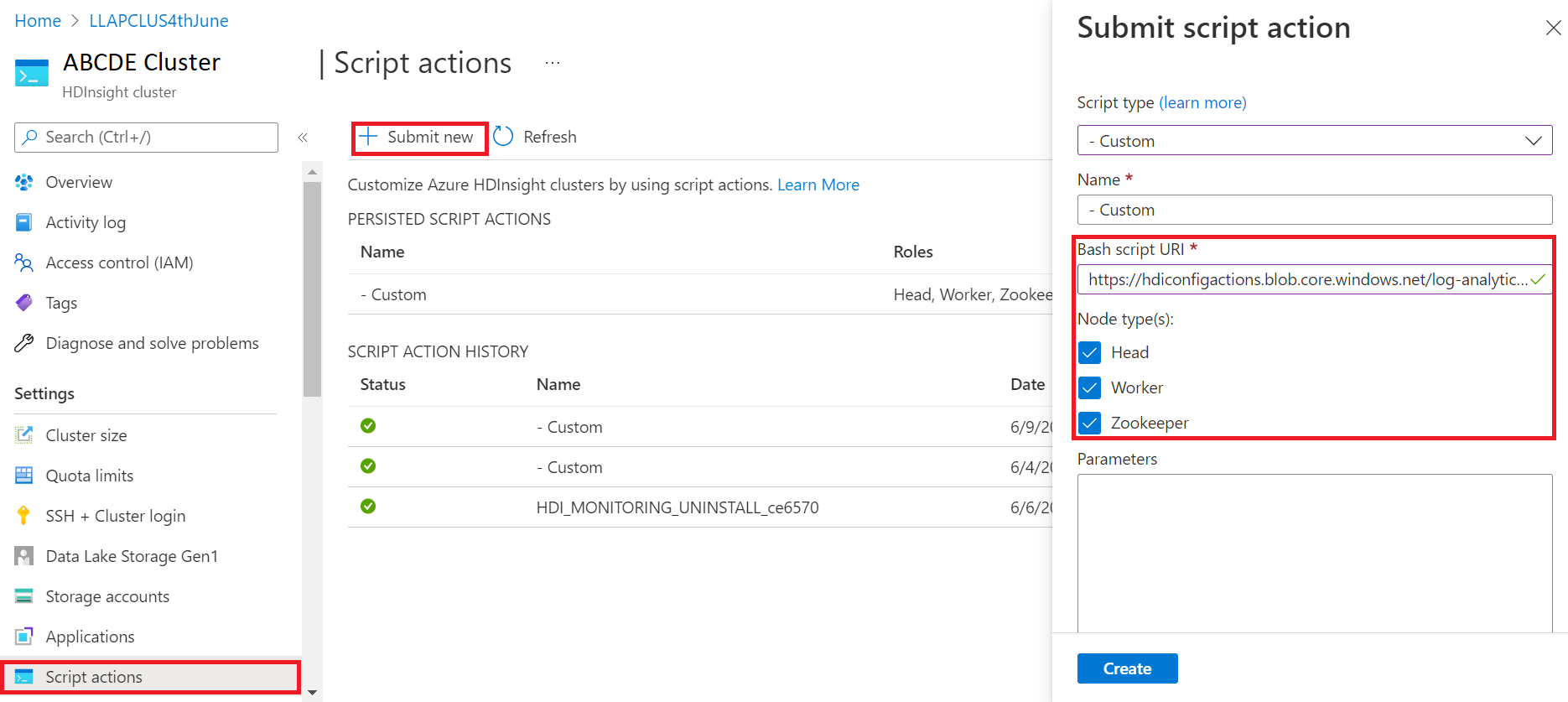

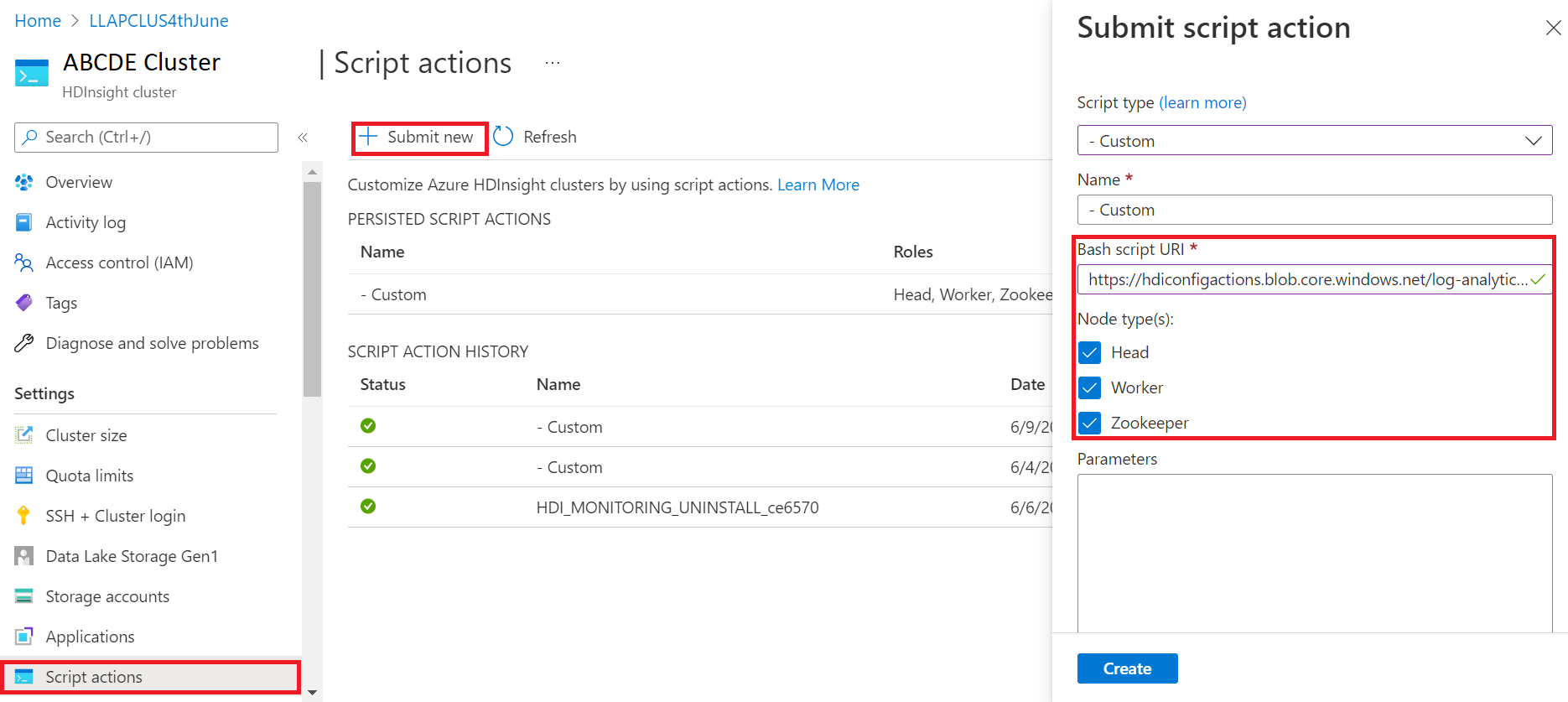

- 登入 Azure 入口網站

- 從資源群組中,選取 HDInsight 叢集資源

- 選取 [指令碼動作]

- 在 [提交指令碼動作] 面板中,選擇 [自訂] 作為 [指令碼類型]

- 在 [Bash 指令碼 URL] 方塊中,貼上下列連結 https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- 選取 [節點類型]

- 選取 [建立]

使用下列步驟確認修補檔安裝成功:

使用 SSH 登入叢集。

在 SSH 用戶端中執行下列命令。

sudo /opt/omi/bin/ominiserver/ --version

其他錯誤 (bug) 修正

- 如果有任何

TFile損毀或空白,Yarn 記錄的 CLI 就無法擷取記錄。 - 已解決從 Azure Active Directory 取得 OAuth 權杖時發生的服務主體詳細資料無效錯誤。

- 已改善設定超過 100 個工作節點時的叢集建立可靠性。

開放原始碼錯誤 (bug) 修正

TEZ Bug 修正

| 錯誤修正 | Apache JIRA |

|---|---|

| Tez 建置失敗:找不到 FileSaver.js | TEZ-4411 |

倉儲和 scratchdir 位於不同 FS 時的 FS 例外狀況不正確 |

TEZ-4406 |

| 大於 32 MB 的組態上的 TezUtils.createConfFromByteString 會擲回 com.google.protobuf.CodedInputStream 例外狀況 | TEZ-4142 |

| TezUtils::createByteStringFromConf 應使用 snappy 而不是 DeflaterOutputStream | TEZ-4113 |

| 將 protobuf 相依性更新為 3.x | TEZ-4363 |

Hive Bug 修正

| 錯誤修正 | Apache JIRA |

|---|---|

| ORC 分割產生中的效能最佳化 | HIVE-21457 |

| 當資料表名稱以 "delta" 開頭,但資料表並非交易式,且使用 BI 分割策略時,避免將資料表讀取為 ACID | HIVE-22582 |

| 從 AcidUtils#getLogicalLength 中移除 FS#exists 呼叫 | HIVE-23533 |

| 向量化 OrcAcidRowBatchReader.computeOffset 和貯體最佳化 | HIVE-17917 |

已知問題

HDInsight 與 Apache HIVE 3.1.2 相容。 由於此版本的錯誤 (bug),Hive 版本在 Hive 介面中會顯示為 3.1.0。 但其功能不受影響。

發行日期:2022/08/10

此版本適用於 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。

HDInsight 使用涉及逐步區域部署的安全部署做法。 最多可能需要 10 個工作天,才能在所有區域中使用新發行或新版本。

![]()

新功能

1.在 HDI Hadoop/Spark 叢集中連結外部磁碟

HDInsight 叢集隨附以 SKU 為基礎的預先定義磁碟空間。 在大型作業案例中,此空間可能不足。

這項新功能可讓您在叢集中新增更多磁碟,以作為節點管理員本機目錄使用。 在 HIVE 和 Spark 叢集建立期間,將磁碟數目新增至背景工作節點,而選取的磁碟為節點管理員本機目錄的一部分。

注意

新增的磁碟只會針對節點管理員本機目錄進行設定。

如需詳細資訊,請參閱這裡

2.選擇性記錄分析

選擇性記錄分析現已在所有區域提供公開預覽版。 您可以將叢集連線到 Log Analytics 工作區。 啟用之後,您可以看到 HDInsight 安全性記錄、Yarn Resource Manager、系統計量等記錄和計量。您可以監視工作負載,並查看其如何影響叢集穩定性。 選擇性記錄可讓您啟用/停用所有資料表,或啟用 Log Analytics 工作區中的選擇性資料表。 您可以調整每個資料表的來源類型,因為新版的 Geneva 監視中,一個資料表有多個來源。

- Geneva 監視系統使用 mdsd (MDS 精靈) 這個監視代理程式,並使用 fluentd 以透過整合記錄層來收集記錄。

- 選擇性記錄會使用指令碼動作來停用/啟用資料表及其記錄類型。 因為它不會開啟任何新的連接埠,或變更任何現有的安全性設定,因此沒有任何安全性變更。

- 指令碼動作會在所有指定的節點上平行執行,並變更停用/啟用資料表及其記錄類型的組態檔。

如需詳細資訊,請參閱這裡

![]()

已修正

記錄分析

與執行 OMS 第 13 版的 Azure HDInsight 整合的 Log Analytics 需要升級至 OMS 第 14 版,才能套用最新的安全性更新。 使用舊版叢集搭配 OMS 第 13 版的客戶必須安裝 OMS 第 14 版,以符合安全性需求。 (如何檢查目前的版本並安裝第 14 版)

如何檢查您目前的 OMS 版本

- 使用 SSH 登入叢集。

- 在 SSH 用戶端中執行下列命令。

sudo /opt/omi/bin/ominiserver/ --version

如何將 OMS 版本從 13 升級至 14

- 登入 Azure 入口網站

- 從資源群組中,選取 HDInsight 叢集資源

- 選取 [指令碼動作]

- 在 [提交指令碼動作] 面板中,選擇 [自訂] 作為 [指令碼類型]

- 在 [Bash 指令碼 URL] 方塊中,貼上下列連結 https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- 選取 [節點類型]

- 選取 [建立]

使用下列步驟確認修補檔安裝成功:

使用 SSH 登入叢集。

在 SSH 用戶端中執行下列命令。

sudo /opt/omi/bin/ominiserver/ --version

其他錯誤 (bug) 修正

- 如果有任何

TFile損毀或空白,Yarn 記錄的 CLI 就無法擷取記錄。 - 已解決從 Azure Active Directory 取得 OAuth 權杖時發生的服務主體詳細資料無效錯誤。

- 已改善設定超過 100 個工作節點時的叢集建立可靠性。

開放原始碼錯誤 (bug) 修正

TEZ Bug 修正

| 錯誤修正 | Apache JIRA |

|---|---|

| Tez 建置失敗:找不到 FileSaver.js | TEZ-4411 |

倉儲和 scratchdir 位於不同 FS 時的 FS 例外狀況不正確 |

TEZ-4406 |

| 大於 32 MB 的組態上的 TezUtils.createConfFromByteString 會擲回 com.google.protobuf.CodedInputStream 例外狀況 | TEZ-4142 |

| TezUtils::createByteStringFromConf 應使用 snappy 而不是 DeflaterOutputStream | TEZ-4113 |

| 將 protobuf 相依性更新為 3.x | TEZ-4363 |

Hive Bug 修正

| 錯誤修正 | Apache JIRA |

|---|---|

| ORC 分割產生中的效能最佳化 | HIVE-21457 |

| 當資料表名稱以 "delta" 開頭,但資料表並非交易式,且使用 BI 分割策略時,避免將資料表讀取為 ACID | HIVE-22582 |

| 從 AcidUtils#getLogicalLength 中移除 FS#exists 呼叫 | HIVE-23533 |

| 向量化 OrcAcidRowBatchReader.computeOffset 和貯體最佳化 | HIVE-17917 |

已知問題

HDInsight 與 Apache HIVE 3.1.2 相容。 由於此版本的錯誤 (bug),Hive 版本在 Hive 介面中會顯示為 3.1.0。 但其功能不受影響。

發行日期:06/03/2022

此發行版本適用於 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

版本要點

Spark v3.1.2 上的 Hive Warehouse Connector (HWC)

Hive Warehouse Connector (HWC) 可讓您利用 Hive 和 Spark 的獨特功能來建置功能強大的巨量資料應用程式。 HWC 目前僅支援 Spark v2.4。 此功能可藉由使用 Spark 在 Hive 資料表上允許 ACID 交易來增加商業價值。 此功能適用於在資料資產中使用 Hive 和 Spark 的客戶。 如需詳細資訊,請參閱 Apache Spark & Hive - Hive Warehouse Connector - Azure HDInsight | Microsoft Docs

Ambari

- 調整和佈建改善變更

- HDI Hive 現在與 OSS 版本 3.1.2 相容

HDI Hive 3.1 版本已升級至 OSS Hive 3.1.2。 此版本具有開放原始碼 Hive 3.1.2 版本中可用的所有修正和功能。

注意

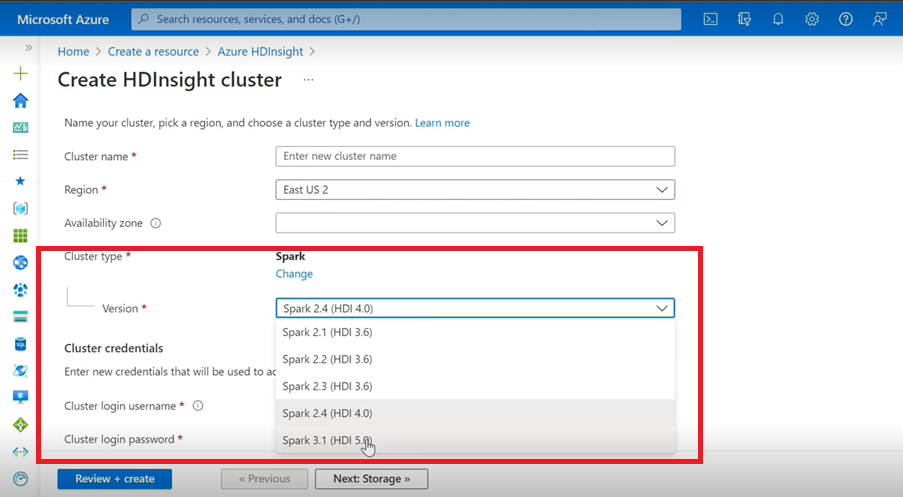

Spark

- 如果您使用 Azure 使用者介面來建立適用於 HDInsight 的 Spark 叢集,您將會在下拉式清單中看到其他版本 Spark 3.1.(HDI 5.0) 以及較舊的版本。 此版本是 Spark 3.1.(HDI 4.0) 已重新命名的版本。 這只是 UI 層級變更,這不會影響現有使用者和已在使用 ARM 範本的使用者。

注意

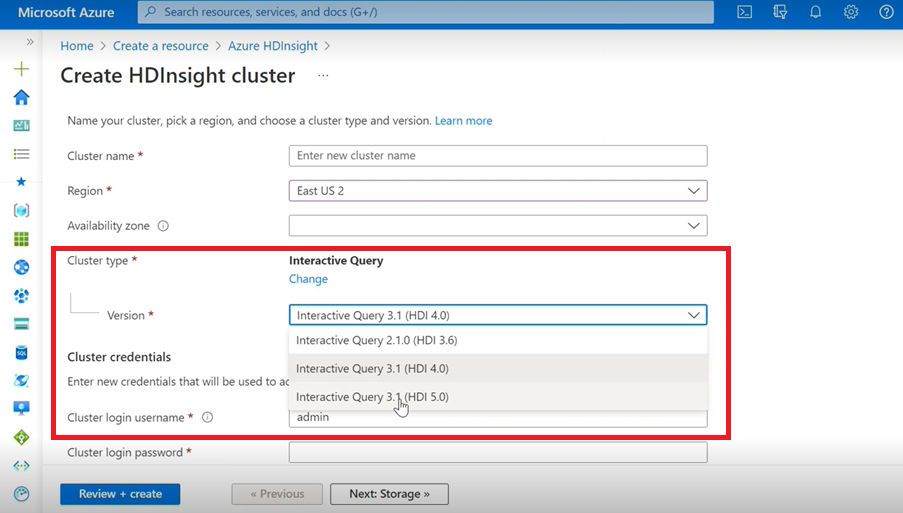

互動式查詢

- 如果您要建立 Interactive Query 叢集,您會在下拉式清單中看到其他版本為 Interactive Query 3.1 (HDI 5.0)。

- 如果您要使用 Spark 3.1 版本搭配需要 ACID 支援的 Hive,您必須選取此版本 Interactive Query 3.1 (HDI 5.0)。

TEZ Bug 修正

| 錯誤修正 | Apache JIRA |

|---|---|

| 大於 32 MB 的組態上的 TezUtils.createConfFromByteString 會擲回 com.google.protobuf.CodedInputStream 例外狀況 | TEZ-4142 |

| TezUtils createByteStringFromConf 應該使用 snappy 而不是 DeflaterOutputStream | TEZ-4113 |

HBase Bug 修正

| 錯誤修正 | Apache JIRA |

|---|---|

TableSnapshotInputFormat 應該針對掃描 HFiles 使用 ReadType.STREAM |

HBASE-26273 |

| 新增選項以在 TableSnapshotInputFormat 中停用 scanMetrics | HBASE-26330 |

| 執行平衡器時 ArrayIndexOutOfBoundsException 的修正 | HBASE-22739 |

Hive Bug 修正

| 錯誤修正 | Apache JIRA |

|---|---|

| 使用 'distribute by' 子句搭配動態部分排序最佳化插入資料時發生 NPE | HIVE-18284 |

| 卸載分割區時,具有分割區篩選的 MSCK REPAIR 命令失敗 | HIVE-23851 |

| 如果 capacity<=0,則擲回錯誤的例外狀況 | HIVE-25446 |

| 支援 HastTables - 介面的平行載入 | HIVE-25583 |

| 預設在 HiveServer2 中包含 MultiDelimitSerDe | HIVE-20619 |

| 從 jdbc-standalone jar 移除 glassfish.jersey 和 mssql-jdbc 類別 | HIVE-22134 |

| 針對 MM 資料表執行壓縮時發生 Null 指標例外狀況。 | HIVE-21280 |

透過 knox 的大型 Hive 查詢失敗,發生中斷管道寫入失敗 |

HIVE-22231 |

| 新增使用者設定繫結使用者的能力 | HIVE-21009 |

| 實作 UDF,以使用其內部標記法和西曆混合式行事曆來解譯日期/時間戳記 | HIVE-22241 |

| 顯示/不顯示執行報表的 Beeline 選項 | HIVE-22204 |

| Tez:SplitGenerator 嘗試尋找對 Tez 不存在的計劃檔案 | HIVE-22169 |

從 LLAP 快取 hotpath 移除成本高昂的記錄 |

HIVE-22168 |

| UDF:FunctionRegistry 在 org.apache.hadoop.hive.ql.udf.UDFType 類別上同步 | HIVE-22161 |

| 如果屬性設為 false,則防止查詢路由附加器的建立 | HIVE-22115 |

| 移除 partition-eval 的跨查詢同步 | HIVE-22106 |

| 在規劃期間略過設定 Hive 暫存目錄 | HIVE-21182 |

| 如果 RPC 開啟,則略過為 tez 建立暫存目錄 | HIVE-21171 |

將 Hive UDF 切換為使用 Re2J RegEx 引擎 |

HIVE-19661 |

| 在 hive 3 上使用 bucketing_version 1 移轉的叢集資料表會使用 bucketing_version 2 插入 | HIVE-22429 |

| 貯體:貯體版本 1 分割資料不正確 | HIVE-21167 |

| 將 ASF 授權標頭新增至新增的檔案 | HIVE-22498 |

| 支援 mergeCatalog 的結構描述工具增強功能 | HIVE-22498 |

| 具有 TEZ UNION ALL 和 UDTF 的 Hive 會導致資料遺失 | HIVE-21915 |

| 即使頁首/頁尾存在,還是分割文字檔 | HIVE-21924 |

| 當載入的檔案的資料行超過資料表結構描述中一次出現的數量時,MultiDelimitSerDe 會在最後一個資料行傳回錯誤的結果 | HIVE-22360 |

| LLAP 外部用戶端 - 需要減少 LlapBaseInputFormat#getSplits() 使用量 | HIVE-22221 |

| 查詢若具有聯結資料表,其遮罩資料行重新寫入時 (透過 Zoltan Haindrich 的 Zoltan Matyus),不會逸出具有保留關鍵字的資料行名稱 | HIVE-22208 |

在發生 AMReporter 相關 RuntimeException 時防止 LLAP 關閉 |

HIVE-22113 |

| LLAP 狀態服務驅動程式可能會因為錯誤的 Yarn 應用程式識別碼而停滯 | HIVE-21866 |

| OperationManager.queryIdOperation 無法正確清除多個 queryId | HIVE-22275 |

| 將節點管理員關閉會封鎖 LLAP 服務的重新啟動 | HIVE-22219 |

| 卸載許多分割區時發生 StackOverflowError | HIVE-15956 |

| 移除暫存目錄時,存取檢查失敗 | HIVE-22273 |

| 修正特定界限條件上左方外部聯結中的錯誤結果/ArrayOutOfBound 例外狀況 | HIVE-22120 |

| 從 pom.xml 移除散發管理標記 | HIVE-19667 |

| 如果有深層巢狀子查詢,剖析時間可能會很高 | HIVE-21980 |

針對 ALTER TABLE t SET TBLPROPERTIES ('EXTERNAL'='TRUE');TBL_TYPE 屬性變更不會對非 CAPS 反映 |

HIVE-20057 |

JDBC:HiveConnection 遮蔽 log4j 介面 |

HIVE-18874 |

更新 poms - branch 3.1 版本中的存放庫 URL |

HIVE-21786 |

主要和 branch-3.1 上的 DBInstall 測試中斷 |

HIVE-21758 |

| 將資料載入貯體資料表會忽略分割區規格,並將資料載入預設分割區 | HIVE-21564 |

| 查詢的聯結條件若具有時間戳記或時間戳記具有本機時區常值時,會擲出 SemanticException | HIVE-21613 |

| 分析保留在 HDFS 上暫存目錄的資料行的計算統計資料 | HIVE-21342 |

| Hive 貯體計算中不相容的變更 | HIVE-21376 |

| 當沒有其他授權者使用中時,提供後援授權者 | HIVE-20420 |

| 某些 alterPartitions 叫用擲回 'NumberFormatException: null' | HIVE-18767 |

| HiveServer2:在某些情況下,http 傳輸的預先驗證主體不會針對 http 通訊的整個期間保留 | HIVE-20555 |

發行日期:2022/03/10

此發行版本適用於 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

此發行版本的 OS 版本如下:

- HDInsight 4.0:Ubuntu 18.04.5

Spark 3.1 現已正式推出

HDInsight 4.0 版本現在已正式推出 Spark 3.1。 此版本包括

- 彈性查詢執行,

- 將排序合併聯結轉換為廣播雜湊聯結,

- Spark Catalyst 最佳化工具,

- 動態資料分割剪除,

- 客戶將能夠建立新的 Spark 3.1 叢集,而不是 Spark 3.0 (預覽) 叢集。

如需詳細資訊,請參閱 HDInsight - Microsoft Tech Community 現已正式推出的 Apache Spark 3.1。

如需完整的改善清單,請參閱 Apache Spark 3.1 版本資訊。

如需移轉的詳細資訊,請參閱移轉指南。

Kafka 2.4 現已正式推出

Kafka 2.4.1 現已正式推出。 如需詳細資訊,請參閱 Kafka 2.4.1 版本資訊。其他功能包括 MirrorMaker 2 可用性、新的計量類別 AtMinIsr 主題分割、改進透過延遲隨選索引檔案的 mmap 訊息代理程式啟動時間、更多取用者計量來觀察使用者輪詢行為。

HDInsight 4.0 現在支援 HWC 中的對應資料類型

此版本包含 HWC 1.0 (Spark 2.4) 的 Map Datatype Support (透過 Spark-shell 應用程式,以及 HWC 所支援的其他所有 Spark 用戶端)。 如同任何其他資料類型,包含下列改善:

使用者可以

- 使用包含 Map 資料類型的任何資料行來建立 Hive 資料表、將資料插入其中,並從中讀取結果。

- 使用對應類型來建立 Apache Spark 資料框架,並執行批次/串流讀取和寫入。

新區域

HDInsight 現在已將其地理位置擴充至兩個新區域:中國東部 3 和中國北部 3。

OSS 向後移植變更

Hive 中包含的 OSS 向後移植,包括支援 Map 資料類型的 HWC 1.0 (Spark 2.4)。

以下是此發行版本的 OSS 向下移植 Apache JIRA:

| 受影響的功能 | Apache JIRA |

|---|---|

| 使用 IN/(NOT IN) 的中繼存放區直接 SQL 查詢,應該根據 SQL DB 所允許的最大參數進行分割 | HIVE-25659 |

將 log4j 2.16.0 升級至 2.17.0 |

HIVE-25825 |

更新 Flatbuffer 版本 |

HIVE-22827 |

| 以箭號格式原生支援 Map 資料類型 | HIVE-25553 |

| LLAP 外部用戶端 - 當父結構為 Null 時,處理巢狀值 | HIVE-25243 |

| 將箭號版本升級至 0.11.0 | HIVE-23987 |

取代通知

HDInsight 上的 Azure 虛擬機器擴展集

HDInsight 將不再使用 Azure 虛擬機器擴展集來佈建叢集,預期不會有任何重大變更。 虛擬機器擴展集上的現有 HDInsight 叢集不會有任何影響,任何最新映像上的新叢集將不再使用虛擬機器擴展集。

現在僅支援使用手動調整來調整 Azure HDInsight HBase 工作負載

從 2022 年 3 月 1 日開始,HDInsight 僅支援 HBase 的手動調整,而執行中的叢集將沒有任何影響。 新的 HBase 叢集將無法啟用以排程為基礎的自動調整。 如需如何手動調整 HBase 叢集的詳細資訊,請參閱手動調整 Azure HDInsight 叢集上的文件

發行日期:2021/12/27

此發行版本適用於 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

此發行版本的 OS 版本如下:

- HDInsight 4.0:Ubuntu 18.04.5 LTS

HDInsight 4.0 映像已更新,以緩解 Microsoft 對 CVE-2021-44228 Apache Log4j 2 的回應中所述的 Log4j 弱點。

注意

- 在 2021 年 12 月 27 日 00:00 UTC 之後建立的任何 HDI 4.0 叢集都是使用映像的更新版本所建立,其可緩解

log4j弱點。 因此,客戶無需修補/重新啟動這些叢集。 - 對於 2021 年 12 月 16 日 01:15 UTC 和 2021 年 12 月 27 日 00:00 UTC 之間建立的新 HDInsight 4.0 叢集,HDInsight 3.6 或 2021 年 12 月 16 日之後的固定訂用帳戶,修補檔將在建立叢集的一小時內自動套用,但客戶必須重新啟動其節點,以完成修補 (自動重新啟動的 Kafka Management 節點除外)。

發行日期:2021/7/27

此發行適用於 HDInsight 3.6 和 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

此發行版本的 OS 版本如下:

- HDInsight 3.6:Ubuntu 16.04.7 LTS

- HDInsight 4.0:Ubuntu 18.04.5 LTS

新功能

Azure HDInsight 對受限公用連線能力的支援將於 2021 年 10 月 15 日正式推出

Azure HDInsight 現在支援所有區域的受限公共連線能力。 以下是此功能的一些主要重點:

- 能夠反轉資源提供者到叢集的通訊,使其從叢集輸出到資源提供者

- 支援為 HDInsight 叢集帶來您自己的 Private Link 啟用資源 (例如儲存體、SQL、金鑰保存庫),以便僅透過專用網路訪問資源

- 未佈建任何公用 IP 位址資源

透過使用新功能,您還可以跳過 HDInsight 管理 IP 的輸入網路安全性群組 (NSG) 服務標籤規則。 深入了解限制公用連線能力

Azure Private Link 的 Azure HDInsight 支援將於 2021 年 10 月 15 日正式推出

您現在可以使用私人端點以透過私人連結連線到 HDInsight 叢集。 在無法使用或未啟用 VNET 對等的跨 VNET 場景中,可以利用私人連結。

Azure Private Link 可讓您存取各項 Azure PaaS 服務 (例如 Azure 儲存體和 SQL Database),並透過虛擬網路中的私人端點裝載 Azure 的客戶擁有/合作夥伴服務。

虛擬網路及服務 (在 Microsoft 骨幹網路中傳遞) 之間的流量。 您的服務不再需要向公用網際網路公開。

如需更多內容,請參閱啟用私人連結。

全新 Azure 監視器整合體驗 (預覽)

全新 Azure 監視器整合體驗將隨此發行版本在美國東部和西歐進行預覽。 在此處了解有關全新 Azure 監視體驗的更多詳細資料。

棄用

HDInsight 3.6 版本已於 2022 年 10 月 1 日淘汰。

行為變更

HDInsight Interactive Query 僅支援以排程為基礎的自動調整

隨著客戶案例變得更加成熟且多樣化,我們已識別 Interactive Query (LLAP) 以負載為基礎自動調整的一些限制。 這些限制是由 LLAP 查詢動態的性質、未來負載預測正確性問題以及 LLAP 排程器任務重新分配中的問題所造成。 由於這些限制,當啟用自動調整時,使用者可能會看到他們的查詢在 LLAP 叢集上執行較慢。 對效能的影響可能超過自動調整的成本效益。

自 2021 年 7 月開始,HDInsight 中的 Interactive Query 工作負載僅支援以排程為基礎的自動調整。 您無法再對新的 Interactive Query 叢集啟用以負載為基礎的自動調整。 現有正在執行的叢集可在上述已知限制的情況下繼續執行。

Microsoft 建議您移至以排程為基礎的 LLAP 自動調整。 您可以透過 Grafana Hive 儀表板分析叢集的目前使用模式。 如需詳細資訊,請參閱自動調整 Azure HDInsight 叢集。

即將推出的變更

即將發行的版本中將會發生下列變更。

ESP Spark 叢集中的內建 LLAP 元件將遭到移除

HDInsight 4.0 ESP Spark 叢集具有在兩個前端節點上執行的內建 LLAP 元件。 ESP Spark 叢集中的 LLAP 元件最初是為 HDInsight 3.6 ESP Spark 所新增,但沒有 HDInsight 4.0 ESP Spark 的實際使用案例。 在排程於 2021 年 9 月發行的下一個版本中,HDInsight 將從 HDInsight 4.0 ESP Spark 叢集中移除內建 LLAP 元件。 此變更將有助於卸載前端節點的工作負載,並避免 ESP Spark 和 ESP Interactive Hive 叢集類型之間的混淆。

新區域

- 美國西部 3

Jio印度西部- 澳大利亞中部

元件版本變更

以下元件版本已隨此發行版本變更:

- ORC 版本從 1.5.1 至 1.5.9

您可以在此文件中尋找 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

向下移植 JIRA

以下是此發行版本的向下移植 Apache JIRA:

| 受影響的功能 | Apache JIRA |

|---|---|

| 日期 / 時間戳記 | HIVE-25104 |

| HIVE-24074 | |

| HIVE-22840 | |

| HIVE-22589 | |

| HIVE-22405 | |

| HIVE-21729 | |

| HIVE-21291 | |

| HIVE-21290 | |

| UDF | HIVE-25268 |

| HIVE-25093 | |

| HIVE-22099 | |

| HIVE-24113 | |

| HIVE-22170 | |

| HIVE-22331 | |

| ORC | HIVE-21991 |

| HIVE-21815 | |

| HIVE-21862 | |

| 資料表結構描述 | HIVE-20437 |

| HIVE-22941 | |

| HIVE-21784 | |

| HIVE-21714 | |

| HIVE-18702 | |

| HIVE-21799 | |

| HIVE-21296 | |

| 工作負載管理 | HIVE-24201 |

| 壓縮 | HIVE-24882 |

| HIVE-23058 | |

| HIVE-23046 | |

| 具體化檢視 | HIVE-22566 |

HDInsight Dv2 虛擬機器的定價修正

2021 年 4 月 25 日,針對 HDInsight 上的 Dv2 VM 系列修正了定價錯誤。 定價錯誤導致某些客戶在 4 月 25 日之前的帳單費用有所減少,並且透過修正,定價現在與 HDInsight 定價頁面和 HDInsight 定價計算機上的公告相符。 定價錯誤影響了以下區域使用 Dv2 VM 的客戶:

- 加拿大中部

- 加拿大東部

- 東亞

- 南非北部

- 東南亞

- 阿拉伯聯合大公國中部

自 2021 年 4 月 25 日開始,Dv2 VM 的修正金額將由您承擔。 客戶通知在變更之前已傳送給訂用帳戶擁有者。 您可以使用定價計算機、HDInsight 定價頁面或 Azure 入口網站中的 [建立 HDInsight 叢集] 刀鋒視窗查看您所在區域 Dv2 VM 的修正成本。

您無需採取其他動作。 價格修正僅適用於 2021 年 4 月 25 日當天或之後在指定區域的使用方式,而不適用於該日期之前的任何使用方式。 為了確保您擁有最具效能和成本效益的解決方案,建議您檢閱 Dv2 叢集的定價、VCPU 和 RAM,並將 Dv2 規格與 Ev3 VM 進行比較,以查看您的解決方案是否會從使用一個較新的 VM 系列中受益。

發行日期:2021/6/02

此發行適用於 HDInsight 3.6 和 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

此發行版本的 OS 版本如下:

- HDInsight 3.6:Ubuntu 16.04.7 LTS

- HDInsight 4.0:Ubuntu 18.04.5 LTS

新功能

OS 版本升級

正如 Ubuntu 的發行版本週期所提到,Ubuntu 16.04 核心將於 2021 年 4 月達到生命週期結束 (EOL)。 我們開始推出執行在 Ubuntu 18.04 上的新 HDInsight 4.0 叢集映像。 一旦可用後,新建立的 HDInsight 4.0 叢集預設會在 Ubuntu 18.04 上執行。 Ubuntu 16.04 上的現有叢集會以完整支援的形式執行。

HDInsight 3.6 將繼續在 Ubuntu 16.04 上執行。 自 2021 年 7 月 1 日開始,其將變更為基本支援 (從標準支援變更)。 如需日期和支援選項的詳細資訊,請參閱 Azure HDInsight 版本。 HDInsight 3.6 不支援 Ubuntu 18.04。 如果您想要使用 Ubuntu 18.04,您需要將叢集移轉至 HDInsight 4.0。

如果您想要將現有的 HDInsight 4.0 叢集移至 Ubuntu 18.04,您需要卸除並重新建立您的叢集。 計劃在 Ubuntu 18.04 支援可供使用後建立或重新建立叢集。

建立新叢集後,您可以透過 SSH 連線到您的叢集並執行 sudo lsb_release -a,以驗證其是否會在 Ubuntu 18.04 上執行。 我們建議您在移至生產環境之前,首先在測試訂用帳戶中測試應用程式。

HBase 加速寫入叢集的調整最佳化

HDInsight 對 HBase 加速可寫入叢集的調整進行一些改善和最佳化。 深入了解 HBase 加速寫入。

棄用

此版本中沒有淘汰。

行為變更

停用 Stardard_A5 VM 大小作為 HDInsight 4.0 的前端節點

HDInsight 叢集前端節點負責初始化和管理叢集。 Standard_A5 VM 大小作為 HDInsight 4.0 的前端節點存有可靠性問題。 從此發行版本開始,客戶無法使用 Standard_A5 VM 大小作為前端節點建立新叢集。 您可以使用其他雙核心 VM,如 E2_v3 或 E2s_v3。 現有叢集將按原樣執行。 強烈建議前端節點使用四核心 VM,以確保生產 HDInsight 叢集的高可用性和可靠性。

在 Azure 虛擬機器擴展集上執行的叢集看不到網路介面資源

HDInsight 正逐漸移轉至 Azure 虛擬機器擴展集。 對於使用 Azure 虛擬機器擴展集的叢集,客戶不再可以看到虛擬機器的網路介面。

即將推出的變更

即將發行的版本中將會發生下列變更。

HDInsight Interactive Query 僅支援以排程為基礎的自動調整

隨著客戶案例變得更加成熟且多樣化,我們已識別 Interactive Query (LLAP) 以負載為基礎自動調整的一些限制。 這些限制是由 LLAP 查詢動態的性質、未來負載預測正確性問題以及 LLAP 排程器任務重新分配中的問題所造成。 由於這些限制,當啟用自動調整時,使用者可能會看到他們的查詢在 LLAP 叢集上執行較慢。 對效能的影響可能超過自動調整的成本效益。

自 2021 年 7 月開始,HDInsight 中的 Interactive Query 工作負載僅支援以排程為基礎的自動調整。 您無法再對新的 Interactive Query 叢集啟用自動調整。 現有正在執行的叢集可在上述已知限制的情況下繼續執行。

Microsoft 建議您移至以排程為基礎的 LLAP 自動調整。 您可以透過 Grafana Hive 儀表板分析叢集的目前使用模式。 如需詳細資訊,請參閱自動調整 Azure HDInsight 叢集。

VM 主機命名將於 2021 年 7 月 1 日變更

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 此服務正逐漸移轉至 Azure 虛擬機器擴展集。 此移轉將變更叢集主機名稱 FQDN 名稱格式,並且不保證主機名稱中的數字按順序排列。 如果您想要取得每個節點的 FQDN 名稱,請參閱尋找叢集節點的主機名稱。

移至 Azure 虛擬機器擴展集

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 此服務將逐漸移轉至 Azure 虛擬機器擴展集。 整個流程可能需要幾個月的時間。 移轉區域和訂用帳戶後,新建立的 HDInsight 叢集將在虛擬機器擴展集上執行,而無需客戶動作。 預計不會發生中斷性變更。

發行日期:2021/3/24

新功能

Spark 3.0 預覽

HDInsight 將 Spark 3.0.0 支援作為預覽功能新增到 HDInsight 4.0。

Kafka 2.4 預覽

HDInsight 將 Kafka 2.4.1 支援作為預覽功能新增到 HDInsight 4.0。

Eav4 系列支援

HDInsight 在此發行版本中已新增 Eav4 系列支援。

移至 Azure 虛擬機器擴展集

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 此服務正逐漸移轉至 Azure 虛擬機器擴展集。 整個流程可能需要幾個月的時間。 移轉區域和訂用帳戶後,新建立的 HDInsight 叢集將在虛擬機器擴展集上執行,而無需客戶動作。 預計不會發生中斷性變更。

棄用

此版本中沒有淘汰。

行為變更

預設叢集版本已變更為 4.0

HDInsight 叢集的預設版本從 3.6 變更為 4.0。 如需可用版本的詳細資訊,請參閱可用的版本。 深入了解 HDInsight 4.0 的新增功能。

預設叢集 VM 大小已變更為 Ev3 系列

預設叢集 VM 大小從 D 系列變更為 Ev3 系列。 此變更適用於前端節點和背景工作角色節點。 為了避免此變更影響您的測試工作流程,請指定要在 ARM 範本中使用的 VM 大小。

在 Azure 虛擬機器擴展集上執行的叢集看不到網路介面資源

HDInsight 正逐漸移轉至 Azure 虛擬機器擴展集。 對於使用 Azure 虛擬機器擴展集的叢集,客戶不再可以看到虛擬機器的網路介面。

即將推出的變更

即將發行的版本中將會發生下列變更。

HDInsight Interactive Query 僅支援以排程為基礎的自動調整

隨著客戶案例變得更加成熟且多樣化,我們已識別 Interactive Query (LLAP) 以負載為基礎自動調整的一些限制。 這些限制是由 LLAP 查詢動態的性質、未來負載預測正確性問題以及 LLAP 排程器任務重新分配中的問題所造成。 由於這些限制,當啟用自動調整時,使用者可能會看到他們的查詢在 LLAP 叢集上執行較慢。 對效能的影響可能超過自動調整的成本效益。

自 2021 年 7 月開始,HDInsight 中的 Interactive Query 工作負載僅支援以排程為基礎的自動調整。 您無法再對新的 Interactive Query 叢集啟用自動調整。 現有正在執行的叢集可在上述已知限制的情況下繼續執行。

Microsoft 建議您移至以排程為基礎的 LLAP 自動調整。 您可以透過 Grafana Hive 儀表板分析叢集的目前使用模式。 如需詳細資訊,請參閱自動調整 Azure HDInsight 叢集。

OS 版本升級

HDInsight 叢集目前正在 Ubuntu 16.04 LTS 上執行。 正如 Ubuntu 的發行版本週期所提到, Ubuntu 16.04 核心將於 2021 年 4 月達到生命週期結束 (EOL)。 我們將於 2021 年 5 月開始推出在 Ubuntu 18.04 上執行的新 HDInsight 4.0 叢集映像。 新建立的 HDInsight 4.0 叢集預設會在 Ubuntu 18.04 上執行一次。 Ubuntu 16.04 上的現有叢集將會以完整支援的形式執行。

HDInsight 3.6 將繼續在 Ubuntu 16.04 上執行。 其將於 2021 年 6 月 30 日終止標準支援,並自 2021 年 7 月 1 日開始變更為基本支援。 如需日期和支援選項的詳細資訊,請參閱 Azure HDInsight 版本。 HDInsight 3.6 不支援 Ubuntu 18.04。 如果您想要使用 Ubuntu 18.04,您必須將叢集移轉至 HDInsight 4.0。

如果您想要將現有的叢集移至 Ubuntu 18.04,則需要卸除並重新建立您的叢集。 請計劃在 Ubuntu 18.04 支援可供使用後,建立或重新建立叢集。 新映像在所有區域可供使用後,我們將傳送另一個通知。

強烈建議您提前測試部署在 Ubuntu 18.04 虛擬機器 (VM) 邊緣節點上的指令碼動作和自訂用程式。 您可以在 18.04-LTS 上建立 Ubuntu Linux VM,然後在 VM 上建立並使用安全殼層 (SSH) 金鑰組來執行和測試部署在邊緣節點上的指令碼動作和自訂用程式。

停用 Stardard_A5 VM 大小作為 HDInsight 4.0 的前端節點

HDInsight 叢集前端節點負責初始化和管理叢集。 Standard_A5 VM 大小作為 HDInsight 4.0 的前端節點存有可靠性問題。 從 2021 年 5 月的下一個發行版本開始,客戶將無法使用 Standard_A5 VM 大小作為前端節點建立新叢集。 您可以使用其他雙核心 VM,如 E2_v3 或 E2s_v3。 現有叢集將按原樣執行。 強烈建議前端節點使用 4 核心 VM,以確保生產 HDInsight 叢集的高可用性和可靠性。

錯誤修正

HDInsight 會持續改善叢集的可靠性和效能。

元件版本變更

已新增對 Spark 3.0.0 和 Kafka 2.4.1 作為預覽的支援。 您可以在此文件中尋找 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

發行日期:2021/2/05

此發行適用於 HDInsight 3.6 和 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

新功能

Dav4 系列支援

HDInsight 在此發行版本中已新增 Dav4 系列支援。 在此處深入了解 Dav4 系列。

Kafka REST Proxy GA

Kafka REST Proxy 可讓您使用 REST API 透過 HTTP 與您的 Kafka 叢集互動。 從此發行版本開始,Kafka REST Proxy 正式推出。 在此處深入了解 Kafka REST Proxy。

移至 Azure 虛擬機器擴展集

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 此服務正逐漸移轉至 Azure 虛擬機器擴展集。 整個流程可能需要幾個月的時間。 移轉區域和訂用帳戶後,新建立的 HDInsight 叢集將在虛擬機器擴展集上執行,而無需客戶動作。 預計不會發生中斷性變更。

棄用

停用的 VM 大小

自 2021 年 1 月 9 日開始,HDInsight 將封鎖所有客戶使用 standand_A8、standand_A9、standand_A10 和 standand_A11 VM 大小建立叢集。 現有叢集將按原樣執行。 請考慮移至 HDInsight 4.0 以避免潛在的系統/支援中斷。

行為變更

預設叢集 VM 大小變更為 Ev3 系列

預設叢集 VM 大小將從 D 系列變更為 Ev3 系列。 此變更適用於前端節點和背景工作角色節點。 為了避免此變更影響您的測試工作流程,請指定要在 ARM 範本中使用的 VM 大小。

在 Azure 虛擬機器擴展集上執行的叢集看不到網路介面資源

HDInsight 正逐漸移轉至 Azure 虛擬機器擴展集。 對於使用 Azure 虛擬機器擴展集的叢集,客戶不再可以看到虛擬機器的網路介面。

即將推出的變更

即將發行的版本中將會發生下列變更。

預設叢集版本將變更為 4.0

自 2021 年 2 月開始,HDInsight 叢集的預設版本將從 3.6 變更為 4.0。 如需可用版本的詳細資訊,請參閱可用的版本。 深入了解 HDInsight 4.0 的新增功能。

OS 版本升級

HDInsight 正在將 OS 版本從 Ubuntu 16.04 升級至 18.04。 升級將於 2021 年 4 月之前完成。

HDInsight 3.6 於 2021 年 6 月 30 日終止支援

HDInsight 3.6 將終止支援。 自 2021 年 6 月 30 日開始,客戶無法建立新的 HDInsight 3.6 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮移至 HDInsight 4.0 以避免潛在的系統/支援中斷。

元件版本變更

此發行版本沒有任何元件版本變更。 您可以在此文件中尋找 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

發行日期:2020/11/18

此發行適用於 HDInsight 3.6 和 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

新功能

待用客戶受控金鑰加密的自動金鑰輪替

從此版本開始,客戶可以使用 Azure KeyValut 版本低於加密金鑰 URL 進行待用客戶受控金鑰加密。 HDInsight 將在金鑰過期或取代為新版本時自動輪替金鑰。 如需詳細資訊,請參閱此處。

能夠為 Spark、Hadoop 和 ML 服務選擇不同的 Zookeeper 虛擬機器大小

HDInsight 以前不支援為 Spark、Hadoop 和 ML 服務叢集類型自訂 Zookeeper 節點大小。 其預設為免費提供的 A2_v2/A2 虛擬機器大小。 在此版本中,您可以選取最適合您案例的 Zookeeper 虛擬機器大小。 虛擬機器大小不是 A2_v2/A2 的 Zookeeper 節點將予以收取費用。 A2_v2 和 A2 虛擬機器仍免費提供。

移至 Azure 虛擬機器擴展集

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 從此版本開始,此服務將逐漸移轉至 Azure 虛擬機器擴展集。 整個流程可能需要幾個月的時間。 移轉區域和訂用帳戶後,新建立的 HDInsight 叢集將在虛擬機器擴展集上執行,而無需客戶動作。 預計不會發生中斷性變更。

棄用

淘汰 HDInsight 3.6 ML 服務叢集

HDInsight 3.6 ML 服務叢集類型將於 2020 年 12 月 31 日終止支援。 客戶將無法在 2020 年 12 月 31 日之後建立新的 3.6 ML 服務叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請在此處查看 HDInsight 版本和叢集類型的支援到期日。

停用的 VM 大小

自 2020 年 11 月 16 日開始,HDInsight 將封鎖新客戶使用 standand_A8、standand_A9、standand_A10 和 standand_A11 VM 大小建立叢集。 在過去三個月內使用過這些 VM 大小的現有客戶不會受到影響。 自 2021 年 1 月 9 日開始,HDInsight 將封鎖所有客戶使用 standand_A8、standand_A9、standand_A10 和 standand_A11 VM 大小建立叢集。 現有叢集將按原樣執行。 請考慮移至 HDInsight 4.0 以避免潛在的系統/支援中斷。

行為變更

在調整作業之前新增 NSG 規則檢查

HDInsight 已新增網路安全性群組 (NSG) 和使用者定義路由 (UDR) 檢查並進行調整作業。 除了建立叢集外,還對叢集調整進行相同的驗證。 此驗證有助於防止不可預期的錯誤。 如果驗證未通過,則調整失敗。 深入了解如何正確設定 NSG 和 UDR,請參閱 HDInsight 管理 IP 位址。

元件版本變更

此發行版本沒有任何元件版本變更。 您可以在此文件中尋找 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

發行日期:2020/11/09

此發行適用於 HDInsight 3.6 和 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

新功能

HDInsight Identity Broker (HIB) 現已正式發行

HDInsight Identity Broker (HIB),此版本現已正式推出適用於 ESP 叢集的 OAuth 驗證。 在此版本之後建立的 HIB 叢集將具有最新的 HIB 功能:

- 高可用性 (HA)

- 支援多重要素驗證 (MFA)

- 同盟使用者登入時不需要密碼雜湊同步到 AAD-DS 如需詳細資訊,請參閱 HIB 文件。

移至 Azure 虛擬機器擴展集

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 從此版本開始,此服務將逐漸移轉至 Azure 虛擬機器擴展集。 整個流程可能需要幾個月的時間。 移轉區域和訂用帳戶後,新建立的 HDInsight 叢集將在虛擬機器擴展集上執行,而無需客戶動作。 預計不會發生中斷性變更。

棄用

淘汰 HDInsight 3.6 ML 服務叢集

HDInsight 3.6 ML 服務叢集類型將於 2020 年 12 月 31 日終止支援。 客戶將不會在 2020 年 12 月 31 日之後建立新的 3.6 ML 服務叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請在此處查看 HDInsight 版本和叢集類型的支援到期日。

停用的 VM 大小

自 2020 年 11 月 16 日開始,HDInsight 將封鎖新客戶使用 standand_A8、standand_A9、standand_A10 和 standand_A11 VM 大小建立叢集。 在過去三個月內使用過這些 VM 大小的現有客戶不會受到影響。 自 2021 年 1 月 9 日開始,HDInsight 將封鎖所有客戶使用 standand_A8、standand_A9、standand_A10 和 standand_A11 VM 大小建立叢集。 現有叢集將按原樣執行。 請考慮移至 HDInsight 4.0 以避免潛在的系統/支援中斷。

行為變更

此發行版本沒有任何行為變更。

即將推出的變更

即將發行的版本中將會發生下列變更。

能夠為 Spark、Hadoop 和 ML 服務選擇不同的 Zookeeper 虛擬機器大小

HDInsight 目前不支援為 Spark、Hadoop 和 ML 服務叢集類型自訂 Zookeeper 節點大小。 其預設為免費提供的 A2_v2/A2 虛擬機器大小。 在即將推出的版本中,您可以選取最適合您案例的 Zookeeper 虛擬機器大小。 虛擬機器大小不是 A2_v2/A2 的 Zookeeper 節點將予以收取費用。 A2_v2 和 A2 虛擬機器仍免費提供。

預設叢集版本將變更為 4.0

自 2021 年 2 月開始,HDInsight 叢集的預設版本將從 3.6 變更為 4.0。 如需可用版本的詳細資訊,請參閱受支援的版本。 深入了解 HDInsight 4.0 的新增功能

HDInsight 3.6 於 2021 年 6 月 30 日終止支援

HDInsight 3.6 將終止支援。 自 2021 年 6 月 30 日開始,客戶無法建立新的 HDInsight 3.6 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮移至 HDInsight 4.0 以避免潛在的系統/支援中斷。

錯誤修正

HDInsight 會持續改善叢集的可靠性和效能。

修正在叢集中重新啟動 VM 的問題

已修正在叢集中重新啟動 VM 的問題,您可以使用 PowerShell 或 REST API 再次重新啟動叢集中的節點。

元件版本變更

此發行版本沒有任何元件版本變更。 您可以在此文件中尋找 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

發行日期:2020/10/08

此發行適用於 HDInsight 3.6 和 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

新功能

沒有公用 IP 和私人連結的 HDInsight 私人叢集 (預覽)

HDInsight 現在支援在預覽中建立無公用 IP 和私人連結存取叢集的叢集。 客戶可以使用新的進階網路設定建立無公用 IP 的完全隔離叢集,並使用自己的私人端點存取叢集。

移至 Azure 虛擬機器擴展集

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 從此版本開始,此服務將逐漸移轉至 Azure 虛擬機器擴展集。 整個流程可能需要幾個月的時間。 移轉區域和訂用帳戶後,新建立的 HDInsight 叢集將在虛擬機器擴展集上執行,而無需客戶動作。 預計不會發生中斷性變更。

棄用

淘汰 HDInsight 3.6 ML 服務叢集

HDInsight 3.6 ML 服務叢集類型將於 2020 年 12 月 31 日終止支援。 此後,客戶將不會建立新的 3.6 ML 服務叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請在此處查看 HDInsight 版本和叢集類型的支援到期日。

行為變更

此發行版本沒有任何行為變更。

即將推出的變更

即將發行的版本中將會發生下列變更。

能夠為 Spark、Hadoop 和 ML 服務選擇不同的 Zookeeper 虛擬機器大小

HDInsight 目前不支援為 Spark、Hadoop 和 ML 服務叢集類型自訂 Zookeeper 節點大小。 其預設為免費提供的 A2_v2/A2 虛擬機器大小。 在即將推出的版本中,您可以選取最適合您案例的 Zookeeper 虛擬機器大小。 虛擬機器大小不是 A2_v2/A2 的 Zookeeper 節點將予以收取費用。 A2_v2 和 A2 虛擬機器仍免費提供。

錯誤修正

HDInsight 會持續改善叢集的可靠性和效能。

元件版本變更

此發行版本沒有任何元件版本變更。 您可以在此文件中尋找 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

發行日期:2020/9/28

此發行適用於 HDInsight 3.6 和 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

新功能

使用 HDInsight 4.0 自動調整 Interactive Query 現已正式推出

HDInsight 4.0 現已推出 (GA) Interactive Query 叢集類型的自動調整功能。 2020 年 8 月 27 日之後建立的所有 Interactive Query 4.0 叢集將有自動調整的 GA 支援。

HBase 叢集支援進階 ADLS Gen2

HDInsight 現在支援進階 ADLS Gen2 作為 HDInsight HBase 3.6 和 4.0 叢集的主要儲存體帳戶。 搭配加速寫入,您可以為 HBase 叢集取得更好的效能。

Azure 容錯網域上的 Kafka 分割散發

容錯網域是 Azure 資料中心內基礎硬體的邏輯群組。 每個容錯網域會共用通用電源和網路交換器。 在 HDInsight 之前,Kafka 可能會將所有分割區複本儲存在相同的容錯網域中。 從此版本開始,HDInsight 現在支援根據 Azure 容錯網域自動散發 Kafka 分割。

傳輸中加密

客戶可以使用帶有平台代控金鑰的 IPSec 加密在叢集節點之間啟用加密。 此選項可以在叢集建立時啟用。 請參閱如何啟用傳輸中加密的詳細資訊。

主機上的加密

當您啟用主機上的加密時,儲存在 VM 主機上的資料會在待用時加密,並將流量加密至儲存體服務。 從此版本開始,您可以在建立叢集時,於臨時資料磁碟上的主機上啟用加密。 主機加密僅在有限區域中的某些 VM SKU 上受支援。 HDInsight 支援以下節點設定和 SKU。 請參閱如何啟用主機上的加密詳細資訊。

移至 Azure 虛擬機器擴展集

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 從此版本開始,此服務將逐漸移轉至 Azure 虛擬機器擴展集。 整個流程可能需要幾個月的時間。 移轉區域和訂用帳戶後,新建立的 HDInsight 叢集將在虛擬機器擴展集上執行,而無需客戶動作。 預計不會發生中斷性變更。

棄用

此發行版本沒有淘汰任何功能。

行為變更

此發行版本沒有任何行為變更。

即將推出的變更

即將發行的版本中將會發生下列變更。

能夠為 Spark、Hadoop 和 ML 服務選取不同的 Zookeeper SKU

HDInsight 目前不支援為 Spark、Hadoop 和 ML 服務叢集類型變更 Zookeeper SKU。 其會針對 Zookeeper 節點使用 A2_v2/A2 SKU,並且不向客戶收費。 在即將推出的版本中,客戶可以視需要變更 Spark、Hadoop 和 ML 服務的 Zookeeper SKU。 SKU 不是 A2_v2/A2 的 Zookeeper 節點將予以收費。 預設 SKU 仍是 A2_V2/A2 且是免費的。

錯誤修正

HDInsight 會持續改善叢集的可靠性和效能。

元件版本變更

此發行版本沒有任何元件版本變更。 您可以在此文件中尋找 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

發行日期:2020/8/09

此發行版本僅適用於 HDInsight 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

新功能

支援 SparkCruise

SparkCruise 是 Spark 的自動計算重複使用系統。 其根據過去的查詢工作負載選取要具體化的通用子運算式。 SparkCruise 將這些子運算式具體化為查詢處理的一部分,並在背景中自動套用計算重複使用。 您可以從 SparkCruise 中受益,而無需對 Spark 程式碼進行任何修改。

支援 HDInsight 4.0 的 Hive 檢視

Apache Ambari Hive 檢視旨在協助您從 Web 瀏覽器撰寫、最佳化和執行 Hive 查詢。 從此版本開始,HDInsight 4.0 叢集原生支援 Hive 檢視。 其不適用於現有的叢集。 您需要卸除並重新建立叢集以取得內建 Hive 檢視。

支援 HDInsight 4.0 的 Tez 檢視

Apache Tez 檢視用於追蹤和偵錯 Hive Tez 工作的執行。 從此版本開始,HDInsight 4.0 原生支援 Tez 檢視。 其不適用於現有的叢集。 您需要卸除並重新建立叢集以取得內建 Tez 檢視。

棄用

淘汰 HDInsight 3.6 Spark 叢集中的 Spark 2.1 與 2.2

自 2020 年 7 月 1 日開始,客戶不能在 HDInsight 3.6 上使用 Spark 2.1 和 2.2 建立新的 Spark 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 3.6 上移至 Spark 2.3,以避免潛在的系統/支援中斷。

淘汰 HDInsight 4.0 Spark 叢集中的 Spark 2.3 \(部分機器翻譯\)

自 2020 年 7 月 1 日開始,客戶不能在 HDInsight 4.0 上使用 Spark 2.3 建立新的 Spark 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 4.0 上移至 Spark 2.4,以避免潛在的系統/支援中斷。

淘汰 HDInsight 4.0 Kafka 叢集中的 Kafka 1.1 \(部分機器翻譯\)

自 2020 年 7 月 1 日開始,客戶無法在 HDInsight 4.0 上使用 Kafka 1.1 建立新的 Kafka 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 4.0 上移至 Kafka 2.1,以避免潛在的系統/支援中斷。

行為變更

Ambari 堆疊版本變更

在此版本中,Ambari 版本會從 2.x.x.x 變更為 4.1。 您可以在 Ambari:Ambari > 使用者 > 版本中驗證堆疊版本 (HDInsight 4.1)。

即將推出的變更

沒有您需要注意即將發生的中斷性變更。

錯誤修正

HDInsight 會持續改善叢集的可靠性和效能。

下列 JIRA 已針對 Hive 向下移植:

下列 JIRA 已針對 HBase 向下移植:

元件版本變更

此發行版本沒有任何元件版本變更。 您可以在此文件中尋找 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

已知問題

已修正 Azure 入口網站中的問題,在此問題中,使用者在使用 SSH 驗證類型的公開金鑰建立 Azure HDInsight 叢集時會遇到錯誤。 當使用者按一下 [檢閱 + 建立] 時,會收到「不得包含來自 SSH 使用者名稱的任何三個連續字元」錯誤。已修正此問題,但您可能需要按下 CTRL + F5 來載入更正的檢視,以重新整理瀏覽器快取。 此問題的因應措施是使用 ARM 範本建立叢集。

發行日期:2020/7/13

此發行適用於 HDInsight 3.6 和 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

新功能

支援 Microsoft Azure 的客戶加密箱

Azure HDInsight 現在支援 Azure 客戶加密箱。 其為客戶提供檢閱及核准或拒絕客戶資料存取要求的介面。 當 Microsoft 工程師必須於支援要求期間存取客戶資料時,便會使用此功能。 如需詳細資訊,請參閱 Microsoft Azure 的客戶加密箱。

儲存體的服務端點原則

客戶現在可以在 HDInsight 叢集子網路上使用服務端點原則 (SEP)。 深入了解 Azure 服務端點原則。

棄用

淘汰 HDInsight 3.6 Spark 叢集中的 Spark 2.1 與 2.2

自 2020 年 7 月 1 日開始,客戶不能在 HDInsight 3.6 上使用 Spark 2.1 和 2.2 建立新的 Spark 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 3.6 上移至 Spark 2.3,以避免潛在的系統/支援中斷。

淘汰 HDInsight 4.0 Spark 叢集中的 Spark 2.3 \(部分機器翻譯\)

自 2020 年 7 月 1 日開始,客戶不能在 HDInsight 4.0 上使用 Spark 2.3 建立新的 Spark 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 4.0 上移至 Spark 2.4,以避免潛在的系統/支援中斷。

淘汰 HDInsight 4.0 Kafka 叢集中的 Kafka 1.1 \(部分機器翻譯\)

自 2020 年 7 月 1 日開始,客戶無法在 HDInsight 4.0 上使用 Kafka 1.1 建立新的 Kafka 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 4.0 上移至 Kafka 2.1,以避免潛在的系統/支援中斷。

行為變更

您無需注意任何行為變更。

即將推出的變更

即將發行的版本中將會發生下列變更。

能夠為 Spark、Hadoop 和 ML 服務選取不同的 Zookeeper SKU

HDInsight 目前不支援為 Spark、Hadoop 和 ML 服務叢集類型變更 Zookeeper SKU。 其會針對 Zookeeper 節點使用 A2_v2/A2 SKU,並且不向客戶收費。 在即將推出的版本中,客戶將能夠視需要變更 Spark、Hadoop 和 ML 服務的 Zookeeper SKU。 SKU 不是 A2_v2/A2 的 Zookeeper 節點將予以收費。 預設 SKU 仍是 A2_V2/A2 且是免費的。

錯誤修正

HDInsight 會持續改善叢集的可靠性和效能。

已修正 Hive Warehouse Connector 問題

在先前的版本中存在 Hive Warehouse 連接器可用性問題。 已修正此問題。

已修正 Zeppelin 筆記本截斷前置零的問題

Zeppelin 錯誤地截斷字串格式的表格輸出中的前置零。 我們已在此版本中修正問題。

元件版本變更

此發行版本沒有任何元件版本變更。 您可以在此文件中尋找 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

發行日期:2020/6/11

此發行適用於 HDInsight 3.6 和 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

新功能

移至 Azure 虛擬機器擴展集

HDInsight 現在使用 Azure 虛擬機器來佈建叢集。 從此版本開始,新建立的 HDInsight 叢集開始使用 Azure 虛擬機器擴展集。 此變更會逐漸推出。 您不應該期望有中斷性變更。 深入了解 Azure 虛擬機器擴展集。

重新啟動 HDInsight 叢集中的 VM

在此版本中,我們支援在 HDInsight 叢集中重新啟動 VM 以重新啟動沒有回應的節點。 目前,您只能透過 API、PowerShell 和 CLI 支援來執行此操作。 如需有關此 API 的詳細資訊,請參閱此文件。

棄用

淘汰 HDInsight 3.6 Spark 叢集中的 Spark 2.1 與 2.2

自 2020 年 7 月 1 日開始,客戶不能在 HDInsight 3.6 上使用 Spark 2.1 和 2.2 建立新的 Spark 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 3.6 上移至 Spark 2.3,以避免潛在的系統/支援中斷。

淘汰 HDInsight 4.0 Spark 叢集中的 Spark 2.3 \(部分機器翻譯\)

自 2020 年 7 月 1 日開始,客戶不能在 HDInsight 4.0 上使用 Spark 2.3 建立新的 Spark 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 4.0 上移至 Spark 2.4,以避免潛在的系統/支援中斷。

淘汰 HDInsight 4.0 Kafka 叢集中的 Kafka 1.1 \(部分機器翻譯\)

自 2020 年 7 月 1 日開始,客戶無法在 HDInsight 4.0 上使用 Kafka 1.1 建立新的 Kafka 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 4.0 上移至 Kafka 2.1,以避免潛在的系統/支援中斷。

行為變更

ESP Spark 叢集前端節點大小變更

ESP Spark 叢集允許的最小前端節點大小變更為 Standard_D13_V2。 由於 CPU 和記憶體容量相對較低,作為前端節點的核心和記憶體較低的 VM 可能會導致 ESP 叢集問題。 從發行版本開始,使用高於 Standard_D13_V2 和 Standard_E16_V3 的 SKU 作為 ESP Spark 叢集的前端節點。

前端節點必須至少有 4 核心 VM

前端節點必須至少有 4 核心 VM,才能確保 HDInsight 叢集的高可用性和可靠性。 自 2020 年 4 月 6 日起,客戶只能選擇 4 核心或以上的 VM 作為新 HDInsight 叢集的前端節點。 現有的叢集將會如預期般繼續執行。

叢集背景工作角色節點佈建變更

當 80% 的背景工作角色節點準備就緒時,叢集進入作業階段。 在此階段,客戶可以執行所有資料平面作業,如執行指令碼和工作。 但客戶無法執行任何控制平面作業,如放大/縮小。 僅支援刪除。

在作業階段之後,叢集會再等候 60 分鐘以等待剩餘 20% 的背景工作角色節點。 在此 60 分鐘期間結束時,叢集會移動至執行階段,即使所有背景工作節點仍然不可使用。 一旦叢集進入執行階段,您就可以如常使用。 已接受控制方案作業 (如放大/縮小) 和資料方案作業 (如執行指令碼和工作)。 如果某些要求的背景工作角色節點不可使用,則叢集將標記為部分成功。 您需要為成功部署的節點付費。

透過 HDInsight 建立新的服務主體

先前,透過建立叢集,客戶可以建立新的服務主體來存取 Azure 入口網站中已連接的 ADLS Gen 1 帳戶。 自 2020 年 6 月 15 日開始,無法在 HDInsight 建立工作流程中建立新的服務主體,僅支援現有的服務主體。 請參閱使用 Azure Active Directory 建立服務主體和證書。

叢集建立的指令碼動作逾時

HDInsight 支援透過叢集建立執行指令碼動作。 在此版本中,所有叢集建立的指令碼動作必須在 60 分鐘內完成,否則將逾時。提交至執行中叢集的指令碼動作不會受到影響。 如需詳細資訊,請參閱此處。

即將推出的變更

沒有您需要注意即將發生的中斷性變更。

錯誤修正

HDInsight 會持續改善叢集的可靠性和效能。

元件版本變更

HBase 2.0 升級至 2.1.6

HBase 版本從 2.0 升級至 2.1.6。

Spark 2.4.0 升級至 2.4.4

Spark 版本從 2.4.0 升級至 2.4.4。

Kafka 2.1.0 升級至 2.1.1

Kafka 版本從 2.1.0 升級至 2.1.1。

您可以在此文件中尋找 HDInsight 4.0 廣告 HDInsight 3.6 的目前元件版本

已知問題

Hive Warehouse Connector 問題

此版本中的 Hive Warehouse Connector 存在問題。 此修正將包含在下一個發行版本中。 在此版本之前建立的現有叢集不受影響。 請盡可能避免卸除和重新建立叢集。 如需要進一步的說明,請開啟支援票證。

發行日期:01/09/2020

此發行適用於 HDInsight 3.6 和 4.0。 在數天內,所有區域都可以使用 HDInsight 發行版本。 此處的發行日期為第一個區域發行日期。 如果您沒有看到下列變更,請稍做等待,幾天後將在您的區域發行。

新功能

TLS 1.2 強制執行

傳輸層安全性 (TLS) 和安全通訊端層 (SSL) 是密碼編譯通訊協定,可透過電腦網路提供通訊安全性。 進一步了解 TLS。 HDInsight 在公用 HTTP 端點上使用 TLS 1.2,但仍支援 TLS 1.1 以提供回溯相容性。

在此發行版本中,客戶只能對所有透過公用叢集端點的連線加入宣告 TLS 1.2。 為了支援這一點,引進 了新的屬性 minSupportedTlsVersion,並可在叢集建立期間指定。 如未設定此屬性,叢集仍然支援 TLS 1.0、1.1 和 1.2,如同目前的行為。 客戶可以將此屬性的值設定為 "1.2",這表示叢集僅支援 TLS 1.2 和更新版本。 如需詳細資訊,請參閱傳輸層安全性。

攜帶您自己的金鑰進行磁碟加密

HDInsight 中的所有受控磁碟都會使用 Azure 儲存體服務加密 (SSE) 來加以保護。 根據預設,這些磁碟上的資料會使用 Microsoft 所管理的金鑰來加密。 從這個發行版本開始,您可以攜帶您自己的金鑰 (BYOK) 進行磁碟加密,並使用 Azure Key Vault 管理它。 BYOK 加密是單步驟設定,可在叢集建立期間免費進行。 只要使用 Azure Key Vault 將 HDInsight 註冊為受控識別,並在建立叢集時新增加密金鑰即可。 如需詳細資訊,請參閱客戶管理的金鑰磁碟加密。

棄用

此發行版本沒有淘汰任何功能。 若要為近期將發生的淘汰做準備,請參閱即將推出的變更。

行為變更

此發行版本沒有任何行為變更。 若要為近期將發生的變更做準備,請參閱即將推出的變更。

即將推出的變更

即將發行的版本中將會發生下列變更。

淘汰 HDInsight 3.6 Spark 叢集中的 Spark 2.1 與 2.2

自 2020 年 7 月 1 日開始,客戶無法在 HDInsight 3.6 上使用 Spark 2.1 與 2.2 建立新的 Spark 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 3.6 上移至 Spark 2.3,以避免潛在的系統/支援中斷。

淘汰 HDInsight 4.0 Spark 叢集中的 Spark 2.3 \(部分機器翻譯\)

自 2020 年 7 月 1 日開始,客戶無法在 HDInsight 4.0 上使用 Spark 2.3 建立新的 Spark 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 4.0 上移至 Spark 2.4,以避免潛在的系統/支援中斷。

淘汰 HDInsight 4.0 Kafka 叢集中的 Kafka 1.1 \(部分機器翻譯\)

自 2020 年 7 月 1 日開始,客戶無法在 HDInsight 4.0 上使用 Kafka 1.1 建立新的 Kafka 叢集。 現有的叢集將會以現狀執行,不再有 Microsoft 支援。 請考慮在 2020 年 6 月 30 日前於 HDInsight 4.0 上移至 Kafka 2.1,以避免潛在的系統/支援中斷。 如需更多資訊,請參閱將 Apache Kafka 工作負載遷移至 Azure HDInsight 4.0。

HBase 2.0 升級至 2.1.6

在即將推出的 HDInsight 4.0 發行版本中,HBase 版本將從 2.0 版升級至2.1.6。

Spark 2.4.0 升級至 2.4.4

在即將推出的 HDInsight 4.0 發行版本中,Spark 版本將從 2.4.0 版升級至2.4.4。

Kafka 2.1.0 升級至 2.1.1

在即將推出的 HDInsight 4.0 發行版本中,Kafka 版本將從 2.1.0 版升級至2.1.1。

前端節點必須至少有 4 核心 VM

前端節點必須至少有 4 核心 VM,才能確保 HDInsight 叢集的高可用性和可靠性。 自 2020 年 4 月 6 日起,客戶只能選擇 4 核心或以上的 VM 作為新 HDInsight 叢集的前端節點。 現有的叢集將會如預期般繼續執行。

ESP Spark 叢集節點大小變更

在即將推出的發行版本中,ESP Spark 叢集允許的最小節點大小會變更為 Standard_D13_V2。 A 系列 VM 因為 CPU 和記憶體容量相對較低,可能會造成 ESP 叢集問題。 未來將無法再使用 A 系列 VM建立新的 ESP 叢集。

移至 Azure 虛擬機器擴展集

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 在即將推出的發行版本中,HDInsight 會改為使用 Azure 虛擬機器擴展集。 請深入了解 Azure 虛擬機器擴展集。

錯誤修正

HDInsight 會持續改善叢集的可靠性和效能。

元件版本變更

此發行版本沒有任何元件版本變更。 您可以在這裡找到 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

發行日期:2019/12/17

此發行適用於 HDInsight 3.6 和 4.0。

新功能

服務標籤

服務標籤讓您能夠輕鬆限制對 Azure 服務的網路存取,從而簡化 Azure 虛擬機器和 Azure 虛擬網路的安全性。 您可以在網路安全性群組 (NSG) 規則中使用服務標籤來允許或拒絕特定 Azure 服務的全域或每個 Azure 區域的流量。 Azure 提供對每個標籤下的 IP 位址維護。 網路安全性群組 (NSG) 的 HDInsight 服務標籤是健康情況和管理服務的 IP 位址群組。 這些群組有助於將建立安全性規則的複雜度降到最低。 HDInsight 客戶可以透過 Azure 入口網站、PowerShell 和 REST API 啟用服務標籤。 如需詳細資訊,請參閱 Azure HDInsight 的網路安全性群組 (NSG) 服務標記。

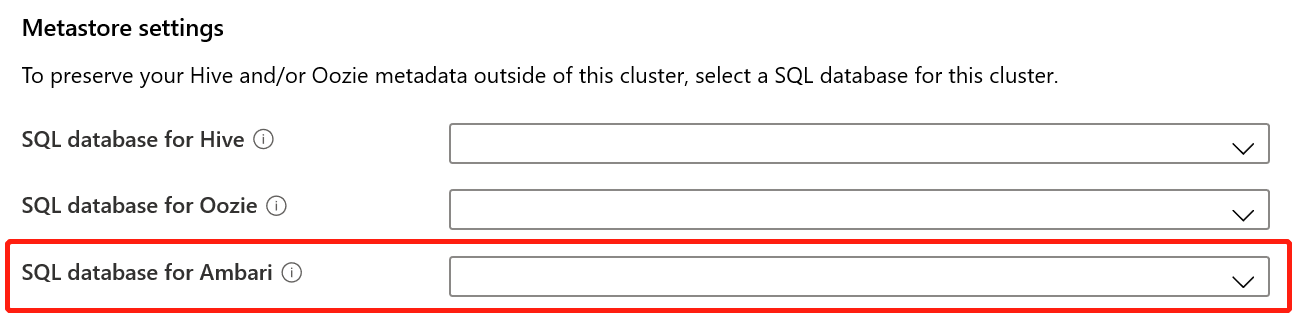

自訂 Ambari DB

HDInsight 現在允許您使用自己的 SQL DB for Apache Ambari。 您可以從 Azure 入口網站或透過 Resource Manager 範本設定此自訂 Ambari DB。 此功能允許您根據您的處理和容量需求選擇正確的 SQL DB。 您還可以輕鬆地升級以符合業務成長需求。 如需詳細資訊,請參閱使用自訂 Ambari DB 設定 HDInsight 叢集。

棄用

此發行版本沒有淘汰任何功能。 若要為近期將發生的淘汰做準備,請參閱即將推出的變更。

行為變更

此發行版本沒有任何行為變更。 若要為近期將發生的行為變更做準備,請參閱即將推出的變更。

即將推出的變更

即將發行的版本中將會發生下列變更。

傳輸層安全性 (TLS) 1.2 強制執行

傳輸層安全性 (TLS) 和安全通訊端層 (SSL) 是密碼編譯通訊協定,可透過電腦網路提供通訊安全性。 如需詳細資訊,請參閱傳輸層安全性。 雖然 Azure HDInsight 叢集在公用 HTTPS 端點上接受 TLS 1.2 連接,但仍支援 TLS 1.1 與舊版用戶端的回溯相容性。

從下一個版本開始,您將能夠選擇加入並將新的 HDInsight 叢集設定為僅接受 TLS 1.2 連接。

今年晚些時候,自 2020 年 6 月 30 日開始,Azure HDInsight 將對所有 HTTPS 連接強制執行 TLS 1.2 或更新版本。 建議您確保所有用戶端都已準備好使用 TLS 1.2 或更新版本。

移至 Azure 虛擬機器擴展集

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 自 2020 年 2 月開始 (具體日期將稍後通知),HDInsight 將使用 Azure 虛擬機器擴展集。 深入了解 Azure 虛擬機器擴展集。

ESP Spark 叢集節點大小變更

在即將推出的版本中:

- ESP Spark 叢集允許的最小節點大小將變更為 Standard_D13_V2。

- A 系列 VM 將遭到取代以建立新的 ESP 叢集,因為 A 系列 VM 由於 CPU 和記憶體容量相對較低,可能會導致 ESP 叢集問題。

HBase 2.0 升級至 2.1

在即將推出的 HDInsight 4.0 發行版本中,HBase 版本將從 2.0 版升級至 2.1。

錯誤修正

HDInsight 會持續改善叢集的可靠性和效能。

元件版本變更

我們已將 HDInsight 3.6 支援延期至 2020 年 12 月 31 日。 您可以在受支援的 HDInsight 版本中找到更多詳細資訊。

HDInsight 4.0 沒有任何元件版本變更。

HDInsight 3.6 上的 Apache Zeppelin:0.7.0-->0.7.3。

您可以從此文件中找到最新的元件版本。

新區域

阿拉伯聯合大公國北部

阿拉伯聯合大公國北部的管理 IP 為:65.52.252.96 和 65.52.252.97。

發行日期:2019/11/07

此發行適用於 HDInsight 3.6 和 4.0。

新功能

HDInsight Identity Broker (HIB) (預覽)

HDInsight Identity Broker (HIB) 可讓使用者使用多重要素驗證 (MFA) 登入 Apache Ambari,並取得所需的 Kerberos 票證,而無需在 Azure Active Directory Domain Services (AAD-DS) 中進行密碼雜湊。 目前 HIB 僅適用於透過 Azure Resource Management (ARM) 範本部署的叢集。

Kafka REST API Proxy (預覽)

Kafka REST API Proxy 透過安全的 Azure AD 授權和 OAuth 通訊協定,藉由 Kafka 叢集提供高可用性 REST Proxy 的一鍵式部署。

自動調整規模

Azure HDInsight 的自動調整現已正式推出,適用於 Apache Spark 和 Hadoop 叢集類型的所有區域。 此功能可讓您以更有成本效益且更具生產力的方式管理巨量資料分析工作負載。 現在您可以最佳化 HDInsight 叢集的使用,並且只需為您需要的部分付費。

視您的需求而定,您可以在負載式自動調整與排程式自動調整之間進行選擇。 以負載為基礎的自動調整可以根據目前的資源需求上下調整叢集大小,而以排程為基礎的自動調整可以根據預先定義的排程變更叢集大小。

針對 HBase 和 LLAP 工作負載的自動調整支援也是公開預覽。 如需詳細資訊,請參閱自動調整 Azure HDInsight 叢集。

適用於 Apache HBase 的 HDInsight 加速寫入

加速寫入會使用 Azure 高階 SSD 受控磁碟來改善 Apache HBase 預寫記錄檔 (WAL) 的效能。 如需詳細資訊,請參閱適用於 Apache HBase 的 Azure HDInsight 加速寫入。

自訂 Ambari DB

HDInsight 現在提供新的容量,讓客戶能夠使用自己的 SQL DB for Ambari。 現在,客戶可以選擇正確的 SQL DB for Ambari,並根據自己的業務成長需求輕鬆升級。 部署是使用 Azure Resource Manager 範本來完成。 如需詳細資訊,請參閱使用自訂 Ambari DB 設定 HDInsight 叢集。

F 系列虛擬機器現在可與 HDInsight 搭配使用

F 系列虛擬機器 (VM) 是開始使用 HDInsight 與輕量處理需求的絕佳選擇。 F 系列的每小時訂價較低,在 Azure 產品組合中,就每一 vCPU 的「Azure 計算單位」(ACU) 而言,具有最佳的價格/性能比表現。 如需詳細資訊,請參閱為 Azure HDInsight 叢集選取正確的 VM 大小。

棄用

G 系列虛擬機器淘汰

從此版本開始,HDInsight 不再提供 G 系列 VM。

Dv1 系列虛擬機器淘汰

從此版本開始,已淘汰搭配 HDInsight 使用的 Dv1 VM。 Dv1 的任何客戶要求都將自動透過 Dv2 提供。 Dv1 和 Dv2 VM 之間沒有價格差異。

行為變更

叢集受控磁碟大小變更

HDInsight 會提供叢集給受控磁碟空間。 從此版本開始,新建立叢集中每個節點的受管磁碟大小會變更為 128 GB。

即將推出的變更

即將發行的版本中將會發生下列變更。

移至 Azure 虛擬機器擴展集

HDInsight 現在會使用 Azure 虛擬機器來佈建叢集。 自 12 月開始,HDInsight 會改為使用 Azure 虛擬機器擴展集。 深入了解 Azure 虛擬機器擴展集。

HBase 2.0 升級至 2.1

在即將推出的 HDInsight 4.0 發行版本中,HBase 版本將從 2.0 版升級至 2.1。

ESP 叢集的 A 系列虛擬機器淘汰

A 系列 VM 由於 CPU 和記憶體容量相對較低,可能會造成 ESP 叢集問題。 在即將推出的版本中,將取代 A 系列 VM 建立新的 ESP 叢集。

錯誤修正

HDInsight 會持續改善叢集的可靠性和效能。

元件版本變更

此發行版本沒有任何元件版本變更。 您可以在此處找到 HDInsight 4.0 和 HDInsight 3.6 的目前元件版本。

發行日期:2019/8/07

元件版本

下列指定所有 HDInsight 4.0 元件的正式 Apache 版本。 列出的元件是可用的最新穩定版本的發行版本。

- Apache Ambari 2.7.1

- Apache Hadoop 3.1.1

- Apache HBase 2.0.0

- Apache Hive 3.1.0

- Apache Kafka 1.1.1、2.1.0

- Apache Mahout 0.9.0+

- Apache Oozie 4.2.0

- Apache Phoenix 4.7.0

- Apache Pig 0.16.0

- Apache Ranger 0.7.0

- Apache Slider 0.92.0

- Apache Spark 2.3.1、2.4.0

- Apache Sqoop 1.4.7

- Apache TEZ 0.9.1

- Apache Zeppelin 0.8.0

- Apache ZooKeeper 3.4.6

除了上面所列版本外,HDP 發佈中有時會有配套的 Apache 元件更新版本。 在此情況下,這些更新版本會列在「技術預覽」資料表中,且不應該在生產環境中取代上述清單中的 Apache 元件版本。

Apache 修補程式資訊

如需 HDInsight 4.0 中可用修補檔的詳細資訊,請參閱下列表格中每個產品的修補檔清單。

| 產品名稱 | 修補檔資訊 |

|---|---|

| Ambari | Ambari 修補檔資訊 |

| Hadoop | Hadoop 修補檔資訊 |

| hbase | HBase 修補檔資訊 |

| Hive | 此版本提供不含其他 Apache 修補檔的 Hive 3.1.0。 |

| Kafka | 此版本提供不含其他 Apache 修補檔的 Kafka 1.1.1。 |

| Oozie | Oozie 修補檔資訊 |

| Phoenix | Phoenix 修補檔資訊 |

| Pig | Pig 修補檔資訊 |

| Ranger | Ranger 修補檔資訊 |

| Spark | Spark 修補檔資訊 |

| Sqoop | 此版本提供不含其他 Apache 修補檔的 Sqoop 1.4.7。 |

| Tez | 此版本提供不含其他 Apache 修補檔的 Tez 0.9.1。 |

| Zeppelin | 此版本提供不含其他 Apache 修補檔的 Zeppelin 0.8.0。 |

| Zookeeper | Zookeeper 修補檔資訊 |

修正常見弱點與漏洞

如需此版本所解決之安全性問題的詳細資訊,請參閱 Hortonworks 的已修正 HDP 3.0.1 常見弱點與漏洞。

已知問題

預設安裝的安全 HBase 複寫已中斷

針對 HDInsight 4.0,請執行以下步驟:

啟用叢集間通訊。

登入作用中的前端節點。

下載指令碼以使用以下命令啟用複寫:

sudo wget https://raw.githubusercontent.com/Azure/hbase-utils/master/replication/hdi_enable_replication.sh鍵入

sudo kinit <domainuser>命令。輸入以下命令來執行指令碼:

sudo bash hdi_enable_replication.sh -m <hn*> -s <srclusterdns> -d <dstclusterdns> -sp <srcclusterpasswd> -dp <dstclusterpasswd> -copydata

若為 HDInsight 3.6

登入作用中的 HMaster ZK。

下載指令碼以使用以下命令啟用複寫:

sudo wget https://raw.githubusercontent.com/Azure/hbase-utils/master/replication/hdi_enable_replication.sh鍵入

sudo kinit -k -t /etc/security/keytabs/hbase.service.keytab hbase/<FQDN>@<DOMAIN>命令。輸入以下命令:

sudo bash hdi_enable_replication.sh -s <srclusterdns> -d <dstclusterdns> -sp <srcclusterpasswd> -dp <dstclusterpasswd> -copydata

Phoenix Sqlline 在將 HBase 叢集移轉到 HDInsight 4.0 後停止運作

執行下列步驟:

- 卸除下列 Phoenix 資料表:

SYSTEM.FUNCTIONSYSTEM.SEQUENCESYSTEM.STATSSYSTEM.MUTEXSYSTEM.CATALOG

- 如果無法刪除任何資料表,請重新啟動 HBase 以清除與資料表的任何連接。

- 請再次執行

sqlline.py。 Phoenix 將重新建立步驟 1 中刪除的所有資料表。 - 為 HBase 資料重新產生 Phoenix 資料表和檢視。

Phoenix Sqlline 在將 HBase Phoenix 中繼資料從 HDInsight 3.6 複寫到 4.0 後停止運作

執行下列步驟:

- 執行複寫之前,請移至目的地 4.0 叢集並執行

sqlline.py。 此命令將產生僅存在於 4.0 中的 Phoenix 資料表,例如SYSTEM.MUTEX和SYSTEM.LOG。 - 卸除以下資料表:

SYSTEM.FUNCTIONSYSTEM.SEQUENCESYSTEM.STATSSYSTEM.CATALOG

- 啟動 HBase 複寫

棄用

Apache Storm 和 ML 服務在 HDInsight 4.0 中不可使用。

發行日期:2019/4/14

新功能

新的更新和功能分為以下幾類:

更新 Hadoop 和其他開放原始碼專案 – 除了 20 多個開放原始碼專案中的 1000 多個錯誤 (bug) 修復外,此更新還包含新版的 Spark (2.3) 和 Kafka (1.0)。

將 R Server 9.1 更新為機器學習服務 9.3 – 在此版本中,我們為資料科學家和工程師提供最佳的增強式開放原始碼及演算法創新,而且作業方便,這些全部都以他們的偏好語言和 Apache Spark 的速度提供。 此版本擴展 R Server 中提供的功能,並進一步支援 Python,因而將叢集名稱從 R Server 改為 ML 服務。

支援 Azure Data Lake Storage Gen2 – HDInsight 將支援 Azure Data Lake Storage Gen2 的預覽版本。 在可用區域中,客戶能夠選擇 ADLS Gen2 帳戶作為其 HDInsight 叢集的主要或次要存放區。

HDInsight 企業安全性套件更新 (預覽) – (預覽) 虛擬網路服務端點支援 Azure Blob 儲存體、ADLS Gen1、Azure Cosmos DB 及 Azure DB。

元件版本

HDInsight 3.6 所有元件的官方 Apache 版本列示如下。 此處所列的元件都是最新可用穩定版本的官方 Apache 版本。

Apache Hadoop 2.7.3

Apache HBase 1.1.2

Apache Hive 1.2.1

Apache Hive 2.1.0

Apache Kafka 1.0.0

Apache Mahout 0.9.0+

Apache Oozie 4.2.0

Apache Phoenix 4.7.0

Apache Pig 0.16.0

Apache Ranger 0.7.0

Apache Slider 0.92.0

Apache Spark 2.2.0/2.3.0

Apache Sqoop 1.4.6

Apache Storm 1.1.0

Apache TEZ 0.7.0

Apache Zeppelin 0.7.3

Apache ZooKeeper 3.4.6

除了上面所列版本外,HDP 發佈中有時會有一些配套的 Apache 元件更新版本。 在此情況下,這些更新版本會列在「技術預覽」資料表中,且不應該在生產環境中取代上述清單中的 Apache 元件版本。

Apache 修補程式資訊

Hadoop

此版本提供 Hadoop Common 2.7.3 和下列 Apache 修補程式:

HADOOP-13190:會在 KMS HA 文件中提及 LoadBalancingKMSClientProvider。

HADOOP-13227:AsyncCallHandler 應該使用事件導向架構來處理非同步呼叫。

HADOOP-14104:用戶端應該一律向 namenode 要求 kms 提供者路徑。

HADOOP-14799:將 nimbus-jose-jwt 更新為 4.41.1。

HADOOP-14814:將 FsServerDefaults 上的不相容 API 變更修正為 HADOOP-14104。

HADOOP-14903:將 json-smart 明確新增至 pom.xml。

HADOOP-15042:Azure PageBlobInputStream.skip() 可在 numberOfPagesRemaining 為 0 時傳回負值。

HADOOP-15255:可對 LdapGroupsMapping 中的群組名稱支援大小寫轉換。

HADOOP-15265:從 hadoop-auth pom.xml 中明確排除 json-smart。

HDFS-7922:ShortCircuitCache#close 不會釋出 ScheduledThreadPoolExecutors。

HDFS-8496:在保有 FSDatasetImpl 鎖定的情況下呼叫 stopWriter(),可能會封鎖其他執行緒 (cmccabe)。

HDFS-10267:針對 FsDatasetImpl#recoverAppend 和 FsDatasetImpl#recoverClose 的額外「同步處理」。

HDFS-10489:取代 HDFS 加密區域的 dfs.encryption.key.provider.uri。

HDFS-11384:新增選項供平衡器分散 getBlocks 呼叫,以避免 NameNode 的 rpc.CallQueueLength 突然增加。

HDFS-11689:

DFSClient%isHDFSEncryptionEnabled擲回的新例外狀況會中斷hackyhive 程式碼。HDFS-11711:DN 不應刪除針對「開啟太多檔案」例外狀況的封鎖。

HDFS-12347:TestBalancerRPCDelay#testBalancerRPCDelay 頻繁失敗。

HDFS-12781:在

Datanode關閉之後,在NamenodeUIDatanode索引標籤中擲回警告訊息。HDFS-13054:處理

DFSClient刪除呼叫中的 PathIsNotEmptyDirectoryException。HDFS-13120:快照集差異可能會在 concat 之後損毀。

YARN-3742:如果

ZKClient建立逾時,YARN RM 將會關閉。YARN-6061:為 RM 中的重要執行緒新增 UncaughtExceptionHandler。

YARN-7558:如果啟用 UI 驗證,yarn logs 命令將無法取得執行中容器的記錄。

YARN-7697:即使記錄彙總已完成,仍無法擷取已完成應用程式的記錄。

HDP 2.6.4 提供了 Hadoop Common 2.7.3 和下列 Apache 修補程式:

HADOOP-13700:從 TrashPolicy#initialize 和 #getInstance 簽章中移除取消擲回

IOException。HADOOP-13709:能夠在處理序存在時清除由殼層繁衍的子處理序。

HADOOP-14059:

s3a重新命名 (self、subdir) 錯誤訊息中的錯字。HADOOP-14542:新增會接受 slf4j 記錄器 API 的 IOUtils.cleanupWithLogger。

HDFS-9887:WebHdfs 通訊端逾時應該是可設定的。

HDFS-9914:修正可設定的 WebhDFS 連線/讀取逾時。

MAPREDUCE-6698:增加 TestUnnecessaryBlockingOnHist oryFileInfo.testTwoThreadsQueryingDifferentJobOfSameUser 的逾時。

YARN-4550:TestContainerLanch 中的某些測試未能在非英文地區設定的環境中進行。

YARN-4717:TestResourceLocalizationService.testPublicResourceInitializesLocalDir 間歇性地失敗,因為清除時產生 IllegalArgumentException。

YARN-5042:以唯讀掛接的形式將 /sys/fs/cgroup 掛接到 Docker 容器。

YARN-5318:修正 TestRMAdminService#te stRefreshNodesResourceWithFileSystemBasedConfigurationProvider 的間歇性測試失敗。

YARN-5641:容器完成後,當地語系化工具會留下 tarball。

YARN-6004:重構 TestResourceLocalizationService#testDownloadingResourcesOnContainer,使其少於 150 行。

YARN-6078:容器會卡在當地語系化狀態。

YARN-6805:LinuxContainerExecutor 中的 NPE,因為 PrivilegedOperationException 結束代碼為 Null。

hbase

此版本提供 HBase 1.1.2 和下列 Apache 修補程式。

HBASE-13376:改善 Stochastic 負載平衡器。

HBASE-13716:停止使用 Hadoop 的 FSConstants。

HBASE-13848:透過認證提供者 API 存取 InfoServer SSL 密碼。

HBASE-13947:使用 MasterServices,而非 AssignmentManager 中的伺服器。

HBASE-14135:HBase 備份/還原第 3 階段:合併備份映像。

HBASE-14473:平行計算區域位置。

HBASE-14517:在 [主要狀態] 頁面中顯示

regionserver's的版本。HBASE-14606:在 Apache 上的主幹建置中,TestSecureLoadIncrementalHFiles 測試已逾時。

HBASE-15210:復原積極的負載平衡器記錄,速度為每毫秒數十行。

HBASE-15515:改善平衡器中的 LocalityBasedCandidateGenerator。

HBASE-15615:需要重試

RegionServerCallable時,睡眠時間錯誤。HBASE-16135:可能永遠不會刪除已移除同儕節點的 rs 下的 PeerClusterZnode。

HBASE-16570:在啟動時平行計算區域位置。

HBASE-16810:當

regionservers位於 /hbase/draining 的 znode 並卸載時,HBase 平衡器會擲回 ArrayIndexOutOfBoundsException。HBASE-16852:TestDefaultCompactSelection 已在 branch-1.3 上失敗。

HBASE-17387:減少 RegionActionResult 中針對 multi() 的例外狀況報告額外負荷。

HBASE-17850:備份系統修復公用程式。

HBASE-17931:將系統資料表指派給具有最高版本的伺服器。

HBASE-18083:在 HFileCleaner 中讓大型/小型檔案清除執行緒數目變成可供設定的狀態。

HBASE-18084:改善 CleanerChore,使其能從會取用更多磁碟空間的目錄中清除。

HBASE-18164:速度快上許多的位置成本函式和候選項目產生器。

HBASE-18212:在具有本機檔案系統 HBase 記錄警告訊息的獨立模式中:無法在 org.apache.hadoop.fs.FSDataInputStream 類別中叫用 'unbuffer' 方法。

HBASE-18808:BackupLogCleaner#getDeletableFiles() 中的設定檢查無效。

HBASE-19052:FixedFileTrailer 應該會辨識 branch-1.x 中的 CellComparatorImpl 類別。

HBASE-19065:HRegion#bulkLoadHFiles() 應該等候並行 Region#flush() 完成。

HBASE-19285:新增每一資料表的延遲長條圖。

HBASE-19393:使用 SSL 存取 HBase UI 時,出現 HTTP 413 FULL 標頭。

HBASE-19395:[branch-1] TestEndToEndSplitTransaction.testMasterOpsWhileSplitting 會失敗,並有 NPE。

HBASE-19421:branch-1 不會針對 Hadoop 3.0.0 進行編譯。

HBASE-19934:若已啟用讀取複本,並在區域分割之後擷取線上快照集,則會發生 HBaseSnapshotException。

HBASE-20008:[向下移植] 在分割區域之後還原快照集時,會發生 NullPointerException。

Hive

此版本提供 Hive 1.2.1 和 Hive 2.1.0,以及下列修補程式:

Hive 1.2.1 Apache 修補程式:

HIVE-10697:ObjectInspectorConvertors#UnionConvertor 會進行錯誤的轉換。

HIVE-11266:count(*) 會根據外部資料表的資料表統計資料,產生錯誤的結果。

HIVE-12245:HBase 支援的資料表可支援資料行註解。

HIVE-12315:修正除數為零的向量化雙精度浮點數。

HIVE-12360:在具有述詞下推的未壓縮 ORC 中會進行錯誤的搜尋。

HIVE-12378:HBaseSerDe.serialize 二進位欄位上的例外狀況。

HIVE-12785:檢視具有等位型別,且結構的 UDF 會中斷。

HIVE-14013:描述資料表未正確顯示 unicode。

HIVE-14205:Hive 不支援等位型別與 AVRO 檔案格式的搭配。

HIVE-14421:FS.deleteOnExit 會保存 _tmp_space.db 檔案的參考。

HIVE-15563:忽略 SQLOperation.runQuery 中不合法的作業狀態轉換例外狀況,以公開實際的例外狀況。

HIVE-15680:當 hive.optimize.index.filter=true 且查詢在 MR 模式中參考了相同的 ORC 資料表兩次時,會產生不正確的結果。

HIVE-15883:Hive 插入中的 HBase 對應資料表在使用小數點時會失敗。

HIVE-16232:對 QuotedIdentifier 中的資料行支援統計資料計算。

HIVE-16828:在啟用 CBO 的情況下,對已分割的檢視所進行的查詢會擲回 IndexOutOfBoundException。

HIVE-17013:根據對檢視的選取來刪除具有子查詢的要求。

HIVE-17063:若先置放資料分割,就無法對外部資料表插入覆寫資料分割。

HIVE-17259:Hive JDBC 無法辨識 UNIONTYPE 資料行。

HIVE-17419:ANALYZE TABLE...COMPUTE STATISTICS FOR COLUMNS 命令會顯示已遮罩資料表的計算統計資料。

HIVE-17530:轉換

uniontype時發生 ClassCastException。HIVE-17621:HCatInputFormat 分割計算期間會忽略 Hive 網站設定。

HIVE-17636:新增

blobstores的 multiple_agg.q 測試。HIVE-17729:新增資料庫並解說相關的 blobstore 測試。

HIVE-17731:在 HIVE-11985 中新增外部使用者的回溯

compat選項。HIVE-17803:使用 Pig 多重查詢時,若有 2 個 HCatStorers 寫入至相同的資料表,則會破壞彼此的輸出。

HIVE-17829:ArrayIndexOutOfBoundsException -

Hive2中具有 Avro 結構描述的 HBASE 支援資料表。HIVE-17845:如果目標資料表資料行不是小寫,插入會失敗。

HIVE-17900:在由 Compactor 觸發的資料行上分析統計資料,會產生資料分割資料行 > 1 個的錯誤格式 SQL。

HIVE-18026:Hive webhcat 主體設定最佳化。

HIVE-18031:針對 Alter Database 作業支援複寫。

HIVE-18090:透過 hadoop 認證連接中繼存放區時,acid 活動訊號會失敗。

HIVE-18189:將 hive.groupby.orderby.position.alias 設為 true 時,Hive 查詢會傳回錯誤結果。

HIVE-18258:向量化:具有重複資料行的 Reduce-Side GROUP BY MERGEPARTIAL 會中斷。

HIVE-18293:若資料夾不是由執行 HiveMetaStore 的身分識別所擁有的,Hive 就無法壓縮該資料夾內所包含的資料表。

HIVE-18327:移除 MiniHiveKdc 的不必要 HiveConf 相依性。

HIVE-18341:新增 repl 載入支援,可用於對具有相同加密金鑰的 TDE 新增「原始」命名空間。

HIVE-18352:在進行 REPL DUMP 以便與其他工具整合時,引進了 METADATAONLY 選項。

HIVE-18353:CompactorMR 應該呼叫 jobclient.close() 以觸發清除。

HIVE-18390:在 ColumnPruner 中查詢已分割的檢視時,發生 IndexOutOfBoundsException。

HIVE-18429:壓縮應該處理未產生任何輸出時的案例。

HIVE-18447:JDBC:提供方法供 JDBC 使用者透過連接字串傳遞 Cookie 資訊。

HIVE-18460:Compactor 不會將資料表屬性傳遞至 Orc 寫入器。

HIVE-18467:支援整個倉儲傾印/載入 + 建立/置放資料庫事件 (Anishek Agarwal,已由 Sankar Hariappan 檢閱)。

HIVE-18551:向量化:VectorMapOperator 嘗試為 Hybrid Grace 寫入太多向量資料行。

HIVE-18587:插入 DML 事件可能會嘗試對目錄計算總和檢查碼。

HIVE-18613:擴充 JsonSerDe 以支援 BINARY 類型。

HIVE-18626:Repl 載入 "with" 子句不會將設定傳遞給工作。

HIVE-18660:PCR 無法區別資料分割和虛擬資料行。

HIVE-18754:REPL STATUS 應該支援 'with' 子句。

HIVE-18754:REPL STATUS 應該支援 'with' 子句。

HIVE-18788:清除 JDBC PreparedStatement 中的輸入。

HIVE-18794:Repl 載入 "with" 子句不會將設定傳遞給非磁碟分割表格的工作。

HIVE-18808:統計資料更新失敗時,讓壓縮更穩固。

HIVE-18817:讀取 ACID 資料表期間,發生 ArrayIndexOutOfBounds 例外狀況。

HIVE-18833:「插入目錄中作為 orcfile」時,自動合併會失敗。

HIVE-18879:如果 xercesImpl.jar 位於 classpath 中,則必須能夠在 UDFXPathUtil 中不允許內嵌的元素。

HIVE-18907:建立公用程式以修正 HIVE-18817 中的 acid 金鑰索引問題。

Hive 2.1.0 Apache 修補程式:

HIVE-14013:描述資料表未正確顯示 unicode。

HIVE-14205:Hive 不支援等位型別與 AVRO 檔案格式的搭配。

HIVE-15563:忽略 SQLOperation.runQuery 中不合法的作業狀態轉換例外狀況,以公開實際的例外狀況。

HIVE-15680:當 hive.optimize.index.filter=true 且查詢在 MR 模式中參考了相同的 ORC 資料表兩次時,會產生不正確的結果。

HIVE-15883:Hive 插入中的 HBase 對應資料表在使用小數點時會失敗。

HIVE-16757:移除已淘汰 AbstractRelNode.getRows 的呼叫。

HIVE-16828:在啟用 CBO 的情況下,對已分割的檢視所進行的查詢會擲回 IndexOutOfBoundException。

HIVE-17063:若先置放資料分割,就無法對外部資料表插入覆寫資料分割。

HIVE-17259:Hive JDBC 無法辨識 UNIONTYPE 資料行。

HIVE-17530:轉換

uniontype時發生 ClassCastException。HIVE-17600:讓 OrcFile 的 enforceBufferSize 變成可由使用者設定。

HIVE-17601:改善 LlapServiceDriver 中的錯誤處理。

HIVE-17613:針對簡短的同一執行緒配置移除物件集區。

HIVE-17617:空白結果集的彙總應該包含空白群組集合的群組。

HIVE-17621:HCatInputFormat 分割計算期間會忽略 Hive 網站設定。

HIVE-17629:CachedStore:備有核准/未核准設定,以允許資料表/資料分割的選擇性快取,以及允許在預先準備時讀取。

HIVE-17636:新增

blobstores的 multiple_agg.q 測試。HIVE-17702:ORC 中的十進位讀取器有不正確的 isRepeating 處理。

HIVE-17729:新增資料庫並解說相關的 blobstore 測試。

HIVE-17731:在 HIVE-11985 中新增外部使用者的回溯

compat選項。HIVE-17803:使用 Pig 多重查詢時,若有 2 個 HCatStorers 寫入至相同的資料表,則會破壞彼此的輸出。

HIVE-17845:如果目標資料表資料行不是小寫,插入會失敗。

HIVE-17900:在由 Compactor 觸發的資料行上分析統計資料,會產生資料分割資料行 > 1 個的錯誤格式 SQL。

HIVE-18006:將 HLLDenseRegister 的記憶體使用量最佳化。

HIVE-18026:Hive webhcat 主體設定最佳化。

HIVE-18031:針對 Alter Database 作業支援複寫。

HIVE-18090:透過 hadoop 認證連接中繼存放區時,acid 活動訊號會失敗。

HIVE-18189:

cbo停用時,無法依位置排序。HIVE-18258:向量化:具有重複資料行的 Reduce-Side GROUP BY MERGEPARTIAL 會中斷。

HIVE-18269:LLAP:使用慢速處理管線進行快速

llapio 會導致 OOM。HIVE-18293:若資料夾不是由執行 HiveMetaStore 的身分識別所擁有的,Hive 就無法壓縮該資料夾內所包含的資料表。

HIVE-18318:即使未封鎖,LLAP 記錄讀取器也應該檢查中斷。

HIVE-18326:LLAP Tez 排程器 - 只有在工作之間有相依性時,才讓這些工作優先進行。

HIVE-18327:移除 MiniHiveKdc 的不必要 HiveConf 相依性。

HIVE-18331:新增在 TGT 到期時重新登入以及某些記錄/lambda。

HIVE-18341:新增 repl 載入支援,可用於對具有相同加密金鑰的 TDE 新增「原始」命名空間。

HIVE-18352:在進行 REPL DUMP 以便與其他工具整合時,引進了 METADATAONLY 選項。

HIVE-18353:CompactorMR 應該呼叫 jobclient.close() 以觸發清除。

HIVE-18384:

log4j2.x程式庫發生 ConcurrentModificationException。HIVE-18390:在 ColumnPruner 中查詢已分割的檢視時,發生 IndexOutOfBoundsException。

HIVE-18447:JDBC:提供方法供 JDBC 使用者透過連接字串傳遞 Cookie 資訊。

HIVE-18460:Compactor 不會將資料表屬性傳遞至 Orc 寫入器。

HIVE-18462:(針對有對應聯結的查詢所格式化的解釋,會具有資料行名稱未格式化的 columnExprMap)。

HIVE-18467:支援整個倉儲傾印/載入 + 建立/置放資料庫事件。

HIVE-18488:LLAP ORC 讀取器缺少某些 null 檢查。

HIVE-18490:具有 EXISTS 和 NOT EXISTS 與不相等述詞的查詢會產生錯誤的結果。

HIVE-18506:LlapBaseInputFormat - 負數的陣列索引。

HIVE-18517:向量化:修正 VectorMapOperator 以接受 VRBs,並檢查向量化旗標是否正確以支援 LLAP 快取)。

HIVE-18523:修正沒有輸入時的摘要資料列。

HIVE-18528:彙總 ObjectStore 中的統計資料會得到錯誤的結果。

HIVE-18530:複寫應該略過 MM 資料表 (暫時)。

HIVE-18548:修正

log4j匯入。HIVE-18551:向量化:VectorMapOperator 嘗試為 Hybrid Grace 寫入太多向量資料行。

HIVE-18577:SemanticAnalyzer.validate 有一些毫無意義的中繼存放區呼叫。

HIVE-18587:插入 DML 事件可能會嘗試對目錄計算總和檢查碼。

HIVE-18597:LLAP:一律封裝

org.apache.log4j的log4j2API jar。HIVE-18613:擴充 JsonSerDe 以支援 BINARY 類型。

HIVE-18626:Repl 載入 "with" 子句不會將設定傳遞給工作。

HIVE-18643:不要針對 ACID 作業檢查已封存的資料分割。

HIVE-18660:PCR 無法區別資料分割和虛擬資料行。

HIVE-18754:REPL STATUS 應該支援 'with' 子句。

HIVE-18788:清除 JDBC PreparedStatement 中的輸入。

HIVE-18794:Repl 載入 "with" 子句不會將設定傳遞給非磁碟分割表格的工作。

HIVE-18808:統計資料更新失敗時,讓壓縮更穩固。

HIVE-18815:移除 HPL/SQL 中未使用的功能。

HIVE-18817:讀取 ACID 資料表期間,發生 ArrayIndexOutOfBounds 例外狀況。

HIVE-18833:「插入目錄中作為 orcfile」時,自動合併會失敗。

HIVE-18879:如果 xercesImpl.jar 位於 classpath 中,則必須能夠在 UDFXPathUtil 中不允許內嵌的元素。

HIVE-18944:在 DPP 期間未正確設定群組集合位置。

Kafka

此版本提供 Kafka 1.0.0 和下列 Apache 修補程式。

KAFKA-4827:Kafka 連線:連接器名稱中的特殊字元有錯誤。

KAFKA-6118:kafka.api.SaslScramSslEndToEndAuthorizationTest.testTwoConsumersWithDifferentSaslCredentials 發生暫時性失敗。

KAFKA-6156:JmxReporter 無法處理 Windows 樣式的目錄路徑。

KAFKA-6164:ClientQuotaManager 執行緒可在遇到錯誤載入記錄時防止關機。

KAFKA-6167:資料流目錄上的時間戳記包含冒號,此字元不合法。

KAFKA-6179:RecordQueue.clear() 不會清除 MinTimestampTracker 的維護清單。

KAFKA-6185:如果向下轉換,OOM 很可能會發生選取器記憶體流失的情況。

KAFKA-6190:GlobalKTable 永遠不會在取用交易訊息時結束還原作業。

KAFKA-6210:如果將 1.0.0 用於 inter.broker.protocol.version 或 log.message.format.version,則會發生 IllegalArgumentException。

KAFKA-6214:搭配使用待命複本與記憶體中狀態存放區會造成資料流損毀。

KAFKA-6215:KafkaStreamsTest 在主幹中失敗。

KAFKA-6238:在套用目標為 1.0.0 的輪流升級時,通訊協定版本發生問題。

KAFKA-6260:AbstractCoordinator 未清楚地處理 NULL 例外狀況。

KAFKA-6261:如果 ack=0,要求記錄會擲回例外狀況。

KAFKA-6274:改善

KTable來源狀態存放區所自動產生的名稱。

Mahout

在 HDP 2.3.x 和 2.4.x 中,我們不會傳送特定 Apache 版本的 Mahout,而是會同步至 Apache Mahout 主幹上的特定修訂點。 此修訂點在 0.9.0 版本之後,但在 0.10.0 版本之前。 這會對 0.9.0 版本提供大量的錯誤修正和功能增強,但在完整轉換至 0.10.0 中的新 Spark 型 Mahout 之前,會提供穩定的 Mahout 功能版本。

針對 HDP 2.3.x 和 2.4.x 中的 Mahout 所選擇的修訂點,來自 Apache Mahout 的 "mahout-0.10.x" 分支,自 2014 年 12 月 19 日起,GitHub 中的修訂 0f037cb03e77c096。

在 HDP 2.5.x 和 2.6.x 中,我們已從 Mahout 移除 "commons-httpclient" 程式庫 (原因是我們將其視為可能有安全性問題的已淘汰程式庫),並已將 Mahout 中的 Hadoop-Client 升級到 2.7.3 版,和 HDP 2.5 中所使用的版本相同。 因此:

先前編譯的 Mahout 作業必須在 HDP 2.5 或 2.6 環境中重新編譯。

某些 Mahout 作業有一點可能會發生與 "org.apache.commons.httpclient"、"net.java.dev.jets3t" 或類別名稱前置詞相關的 "ClassNotFoundException" 或 "could not load class" 錯誤。 如果發生這些錯誤,請考慮是否要以手動方式在 classpath 中為作業安裝所需的 jar,前提是您的環境可接受已淘汰的程式庫中有安全性問題的風險。