用于将数据引入 Fabric 湖屋的选项

“获取数据”体验涵盖将数据引入湖屋的所有用户场景,例如:

- 连接到现有 SQL Server 并将数据复制到湖屋上的 Delta 表中。

- 从计算机上传文件。

- 将其他湖屋中的多个表复制并合并到新的 Delta 表中。

- 连接到流式处理源,将数据放入到湖屋中。

- 引用数据,而不从其他内部湖屋或外部源复制数据。

将数据加载湖屋的不同方法

在 Microsoft Fabric 中,有几种方法可将数据引入湖屋:

- 从本地计算机上传文件

- 在管道中运行复制工具

- 设置数据流

- 笔记本代码中的 Apache Spark 库

- 使用 Eventstream 流式传输实时事件

- 从 Eventhouse 获取数据

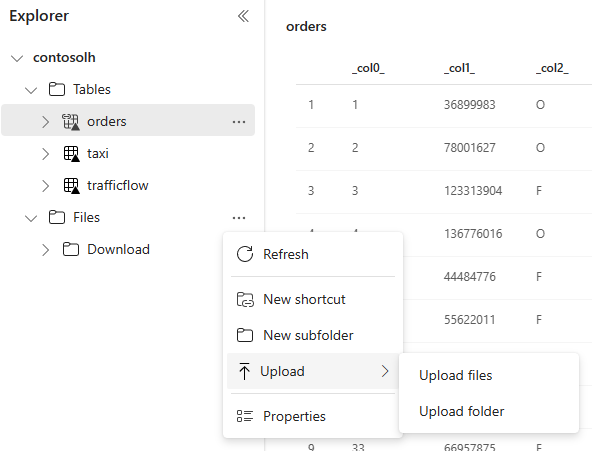

本地文件上传

还可上传在本地计算机上存储的数据。 可直接在湖屋资源管理器中执行此操作。

管道中的复制工具

复制工具是一种高度可缩放的数据集成解决方案,可用于连接到不同的数据源,并以原始格式加载数据或将其转换为 Delta 表。 复制工具是管道活动的一部分,可通过多种方式修改这些活动,例如根据事件进行计划或触发。 有关详细信息,请参阅如何通过复制活动来复制数据。

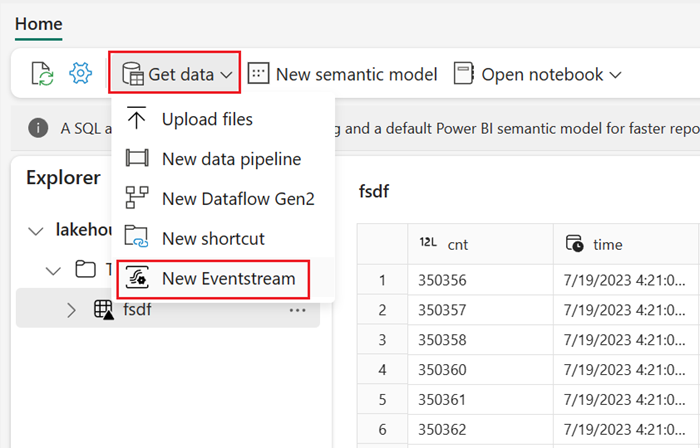

数据流

对于熟悉 Power BI 数据流的用户,可使用同一工具将数据加载到湖屋中。 可通过湖屋资源管理器的“获取数据”选项快速访问它,并通过 200 多个连接器加载数据。 有关详细信息,请参阅快速入门:创建你的第一个数据流来获取和转换数据。

笔记本代码

可使用可用的 Spark 库直接连接到数据源,将数据加载到数据帧,然后将其保存在湖屋中。 这是在湖屋中加载数据的最开放的方式,该湖屋由用户代码完全管理。

注意

使用 Spark 代码创建的外部 Delta 表对 SQL 分析终结点不可见。 使用表空间中的快捷方式使外部 Delta 表对 SQL 分析终结点可见。 若要了解如何创建快捷方式,请参阅 创建文件或表的快捷方式。

使用 Eventstream 流式传输实时事件

使用 Eventstream,可以从各种源获取、处理和路由大量实时事件。

若要了解如何将 Lakehouse 添加为 Eventstream 的目标,请参阅从湖屋中的 Eventstream 获取数据。

为了获得最佳流式处理性能,可以将 Eventstream 中的数据流式传输到 Eventhouse,然后启用 OneLake 可用性。

从 Eventhouse 获取数据

在 Eventhouse 中的数据上启用 OneLake 可用性时,在 OneLake 中创建 Delta 表。 可以使用快捷方式通过湖屋访问此 Delta 表。 有关详细信息,请参阅 OneLake 快捷方式。 有关详细信息,请参阅 Eventhouse OneLake 可用性。

选择数据加载方法时的注意事项

| 用例 | 建议 |

|---|---|

| 从本地计算机进行小型文件上传 | 使用本地文件上传 |

| 小型数据或特定连接器 | 使用数据流 |

| 大型数据源 | 使用管道中的复制工具 |

| 复杂数据转换 | 使用笔记本代码 |

| 流式处理数据 | 使用 Eventstream 将数据流式传输到 Eventhouse;启用 OneLake 可用性并从湖屋创建快捷方式 |

| 时序数据 | 从 Eventhouse 获取数据 |