Fabric 环境中的库管理

Microsoft Fabric 环境提供了用于运行 Spark 作业的灵活配置。 库提供了开发人员想要在其工作中添加的可重用代码。 除了每个 Spark 运行时附带的内置库外,还可以在 Fabric 环境中安装公共库和自定义库。 而且,你可以轻松地将环境附加到笔记本和 Spark 作业定义。

注意

修改特定包的版本可能会中断依赖于它的其他包。 例如,降级 azure-storage-blob 可能会导致依赖 Pandas 的 Pandas 和其他各种库出现问题,包括 mssparkutils、fsspec_wrapper 和 notebookutils。

可以在此处查看每个运行时的预安装包及其版本列表。

查看在 Microsoft Fabric 中管理库的更多选项和最佳做法。在 Microsoft Fabric 中管理 Apache Spark 库

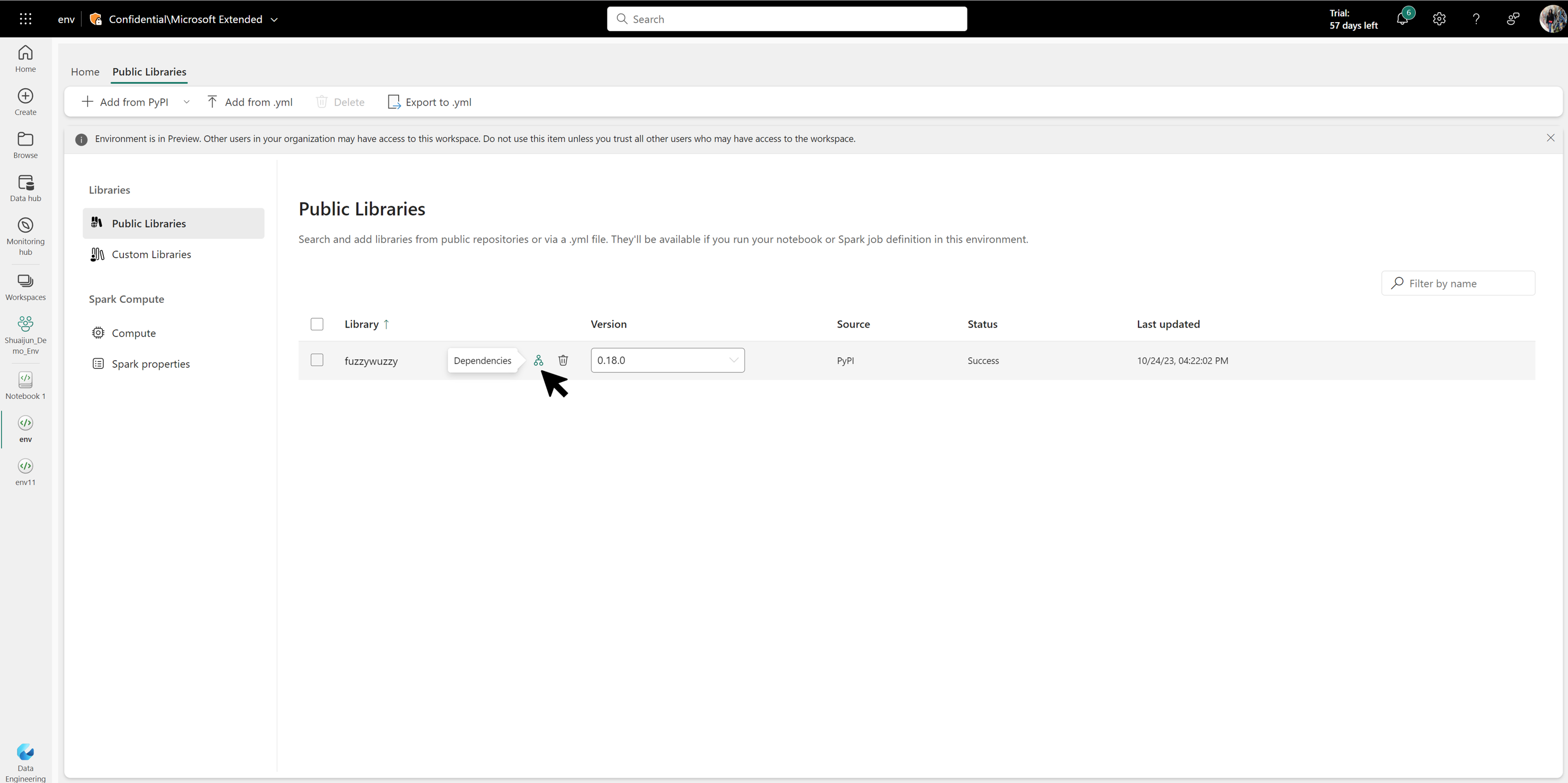

公共库

公共库源自 Fabric 当前支持的存储库(如 PyPI 和 Conda)。

添加新的公共库

若要添加新的公共库,请选择源并指定库的名称和版本。 也可上传 Conda 环境规范 .yml 文件来指定公用库。 上传的 .yml 文件的内容将被提取并追加到列表。

注意

在添加过程中,库名称的自动补全功能仅限于最常用的库。 如果要安装的库不在该列表中,则不会收到自动补全提示。 请改为通过输入相应库的全名直接在 PyPI 或 Conda 中搜索该库。 如果库名称有效,则会看到可用版本。 如果库名称无效,将收到一条警告,指出该库不存在。

批量添加公共库

支持上传 YAML 文件以批量管理多个公共库的环境。 将提取 YAML 的内容并将其追加到公共库列表中。

注意

当前不支持 YAML 文件中的自定义 conda 通道。 仅识别 PyPI 和 conda 中的库。

筛选公用库

在“公共库”页面上的搜索框中输入关键字,以筛选公共库列表并找到所需的库。

更新公共库

若要更新现有公共库的版本,请导航到你的环境,并打开“公共库”或“自定义库”。 选择所需的库,选择版本下拉列表,然后更新其版本。

删除公用库

将鼠标悬停在相应行上时,将显示每个库的回收站选项。 或者,也可以删除多个公共库,方法是选择这些库,然后选择功能区上的“删除”。

查看依赖项

每个公用库都有各种依赖项。 将鼠标悬停在相应行上时,将显示视图依赖项选项。

导出到 yaml

Fabric 提供了将完整的公共库列表导出到 YAML 文件并将其下载到本地目录的选项。

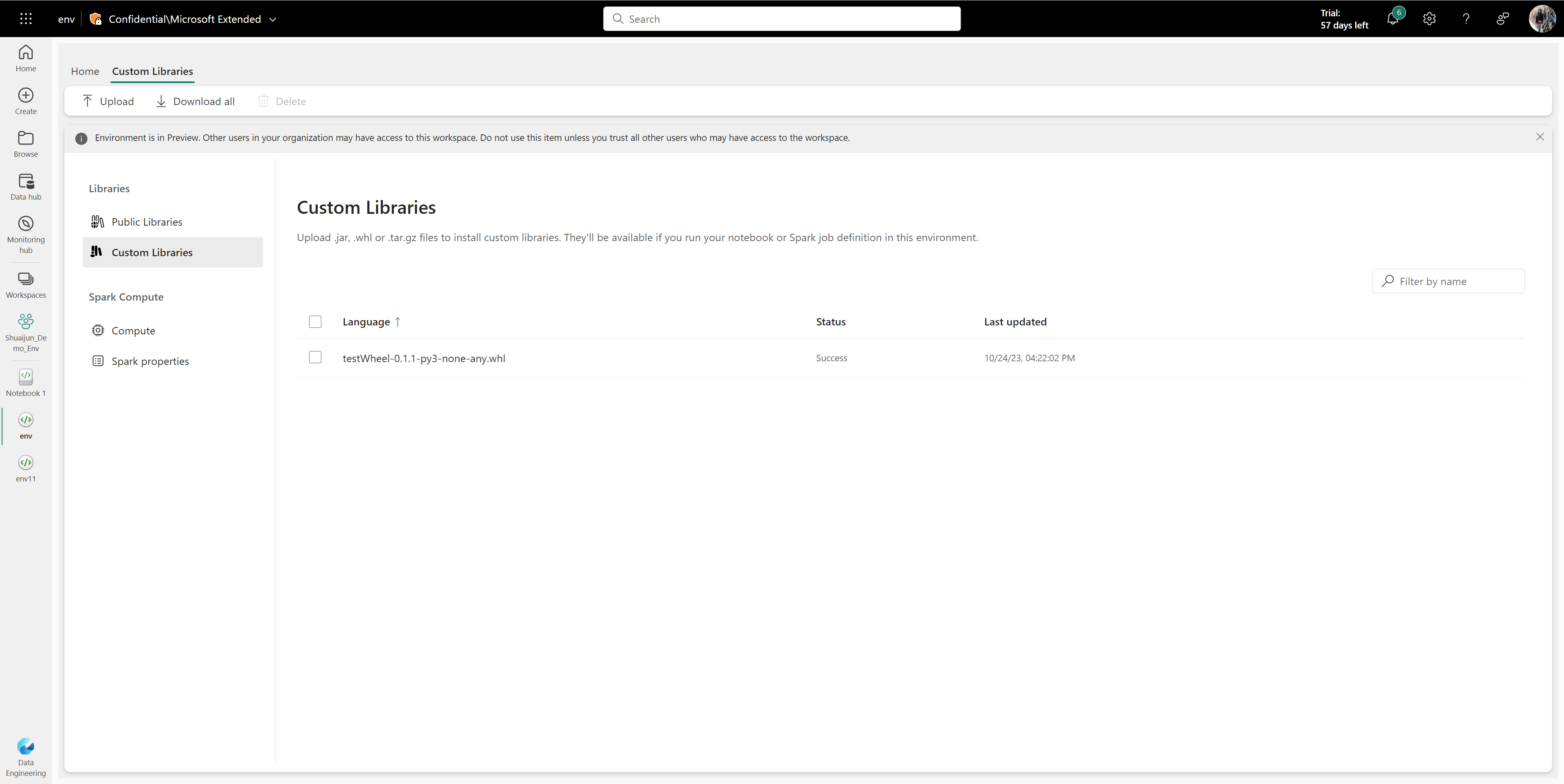

自定义库

自定义库是指由你或贵组织构建的代码。 Fabric 支持 .whl、.py、.jar 和 .tar.gz 格式的自定义库文件。

注意

Fabric 仅支持 R 语言的 .tar.gz 文件。 使用适用于 Python 语言的 .whl .py文件格式。

上传自定义库

你可以将自定义库从本地目录上传到 Fabric 环境。

删除自定义库

将鼠标悬停在相应行上时,将显示每个库的回收站选项。 或者,也可以删除多个自定义库,方法是选择这些库,然后选择功能区上的“删除”。

下载所有自定义库

被单击后,自定义库会逐个下载到本地默认下载目录。