เพิ่มและจัดการแหล่งข้อมูลเหตุการณ์ในเหตุการณ์

เมื่อคุณสร้างเหตุการณ์คุณสามารถเชื่อมต่อกับแหล่งข้อมูลและปลายทางต่าง ๆ ได้

หมายเหตุ

ความสามารถที่ปรับปรุงประสิทธิภาพแล้วจะเปิดใช้งานตามค่าเริ่มต้นเมื่อคุณสร้างเหตุการณ์สตรีมในขณะนี้ ถ้าคุณมีเหตุการณ์สตรีมที่สร้างขึ้นโดยใช้ความสามารถมาตรฐาน เหตุการณ์สตรีมเหล่านั้นจะยังคงทํางานต่อไป คุณยังคงสามารถแก้ไข และใช้ได้ตามปกติ เราขอแนะนําให้คุณสร้างเหตุการณ์สตรีมใหม่เพื่อแทนที่เหตุการณ์สตรีมมาตรฐานเพื่อให้คุณสามารถใช้ประโยชน์จากความสามารถและประโยชน์เพิ่มเติมของสตรีมเหตุการณ์ที่ปรับปรุงประสิทธิภาพแล้ว

เมื่อคุณสร้างเหตุการณ์คุณสามารถเชื่อมต่อกับแหล่งข้อมูลและปลายทางต่าง ๆ ได้

อีเวนต์สตรีมไม่เพียงช่วยให้คุณสามารถสตรีมข้อมูลจากแหล่งข้อมูลของ Microsoft แต่ยังสนับสนุนการนําเข้าจากแพลตฟอร์มของบุคคลที่สามเช่น Google Cloud และ Amazon Kinesis ด้วยตัวเชื่อมต่อข้อความใหม่ ความสามารถที่ขยายนี้ให้การรวมสตรีมข้อมูลภายนอกที่ราบรื่นลงใน Fabric ให้ความยืดหยุ่นมากขึ้น และช่วยให้คุณสามารถรับข้อมูลเชิงลึกแบบเรียลไทม์จากหลายแหล่งข้อมูลได้

ในบทความนี้ คุณจะได้เรียนรู้เกี่ยวกับแหล่งที่มาของเหตุการณ์ที่คุณสามารถเพิ่มลงในเหตุการณ์

ข้อกำหนดเบื้องต้น

- เข้าถึงพื้นที่ทํางานในโหมดสิทธิ์การใช้งาน Fabric capacity (หรือ) โหมดสิทธิ์การใช้งานรุ่นทดลองใช้ที่มีสิทธิ์ผู้สนับสนุนหรือสูงกว่า

- ข้อกําหนดเบื้องต้นเฉพาะสําหรับแต่ละแหล่งข้อมูลที่ระบุไว้ในบทความเฉพาะแหล่งข้อมูลต่อไปนี้

แหล่งที่มาที่สนับสนุน

สตรีมเหตุการณ์ Fabric ที่มีความสามารถที่เพิ่มขึ้นสนับสนุนแหล่งข้อมูลต่อไปนี้ แต่ละบทความแสดงรายละเอียดและคําแนะนําสําหรับการเพิ่มแหล่งข้อมูลที่เฉพาะเจาะจง

| ต้นทาง | คำอธิบาย |

|---|---|

| Azure Event Hubs | ถ้าคุณมีฮับเหตุการณ์ Azure คุณสามารถนําเข้าข้อมูลฮับเหตุการณ์ลงใน Microsoft Fabric โดยใช้ Eventstream ได้ |

| Azure IoT Hub | ถ้าคุณมีฮับ Azure IoT คุณสามารถนําเข้าข้อมูล IoT ลงใน Microsoft Fabric โดยใช้ Eventstream ได้ |

| ฐานข้อมูล Azure SQL เปลี่ยนแปลงการเก็บข้อมูล (CDC) | ตัวเชื่อมต่อแหล่ง CDC Azure SQL Database ช่วยให้คุณสามารถจับภาพสแนปช็อตของข้อมูลปัจจุบันในฐานข้อมูล Azure SQL ได้ ตัวเชื่อมต่อจะตรวจสอบและบันทึกการเปลี่ยนแปลงระดับแถวในอนาคตใดก็ตามในข้อมูลนี้ |

| ฐานข้อมูล PostgreSQL CDC | ตัวเชื่อมต่อแหล่งข้อมูล PostgreSQL Change Data Capture (CDC) ช่วยให้คุณสามารถจับภาพสแนปช็อตของข้อมูลปัจจุบันในฐานข้อมูล PostgreSQL ได้ ตัวเชื่อมต่อจะตรวจสอบและบันทึกการเปลี่ยนแปลงระดับแถวในอนาคตใดก็ตามในข้อมูลนี้ |

| ฐานข้อมูล MySQL CDC | ตัวเชื่อมต่อแหล่งข้อมูล Azure MySQL Change Data Capture (CDC) ช่วยให้คุณสามารถจับภาพสแนปช็อตของข้อมูลปัจจุบันในฐานข้อมูล Azure สําหรับฐานข้อมูล MySQL ได้ คุณสามารถระบุตารางเพื่อตรวจสอบ และบันทึกเหตุการณ์สตรีมจะบันทึกการเปลี่ยนแปลงระดับแถวในอนาคตไปยังตารางได้ |

| Azure Cosmos DB CDC | ตัวเชื่อมต่อแหล่งข้อมูล Azure Cosmos DB Change Data Capture (CDC) สําหรับสตรีมเหตุการณ์ Microsoft Fabric ช่วยให้คุณสามารถจับภาพสแนปช็อตของข้อมูลปัจจุบันในฐานข้อมูล Azure Cosmos DB ตัวเชื่อมต่อจะตรวจสอบและบันทึกการเปลี่ยนแปลงระดับแถวในอนาคตใดก็ตามในข้อมูลนี้ |

| SQL Server บนเครื่องเสมือน (VM) Database (DB) CDC | ตัวเชื่อมต่อแหล่งข้อมูล SQL Server บน VM DB (CDC) สําหรับสตรีมเหตุการณ์ Fabric ช่วยให้คุณสามารถจับภาพสแนปช็อตของข้อมูลปัจจุบันในฐานข้อมูล SQL Server บน VM ตัวเชื่อมต่อจะตรวจสอบและบันทึกการเปลี่ยนแปลงระดับแถวในอนาคตใดก็ตามในข้อมูล |

| CDC อินสแตนซ์ที่จัดการแล้วของ Azure SQL | ตัวเชื่อมต่อแหล่ง CDC อินสแตนซ์ที่จัดการแล้วของ Azure SQL สําหรับสตรีมเหตุการณ์ Microsoft Fabric ช่วยให้คุณสามารถจับภาพสแนปช็อตของข้อมูลปัจจุบันในฐานข้อมูล SQL Managed Instance ตัวเชื่อมต่อจะตรวจสอบและบันทึกการเปลี่ยนแปลงระดับแถวในอนาคตใดก็ตามในข้อมูลนี้ |

| ผับ/ย่อย Google Cloud | Google Pub/Sub เป็นบริการส่งข้อความที่ช่วยให้คุณสามารถเผยแพร่และสมัครสมาชิกสตรีมของเหตุการณ์ได้ คุณสามารถเพิ่ม Google Pub/Sub เป็นแหล่งข้อมูลให้กับเหตุการณ์ของคุณเพื่อจับภาพ แปลง และกําหนดเส้นทางเหตุการณ์แบบเรียลไทม์ไปยังปลายทางต่าง ๆ ใน Fabric ได้ |

| Amazon Kinesis Data Streams | Amazon Kinesis Data Streams เป็นการนําเข้าข้อมูลที่ปรับขนาดได้และทนทานสูงและการบริการการประมวลผลที่ปรับให้เหมาะสมสําหรับการสตรีมข้อมูล โดยการรวม Amazon Kinesis Data Streams เป็นแหล่งข้อมูลภายในเหตุการณ์ของคุณ คุณสามารถประมวลผลสตรีมข้อมูลแบบเรียลไทม์ได้อย่างราบรื่นก่อนที่จะกําหนดเส้นทางไปยังหลายปลายทางภายใน Fabric |

| Confluent Cloud Kafka | Confluent Cloud Kafka เป็นแพลตฟอร์มการสตรีมที่นําเสนอฟังก์ชันการสตรีมข้อมูลและการประมวลผลที่มีประสิทธิภาพโดยใช้ Apache Kafka โดยการรวม Confluent Cloud Kafka เป็นแหล่งข้อมูลภายในเหตุการณ์ของคุณ คุณสามารถประมวลผลสตรีมข้อมูลแบบเรียลไทม์ได้อย่างราบรื่นก่อนที่จะกําหนดเส้นทางไปยังหลายปลายทางภายใน Fabric |

| Amazon MSK Kafka | Amazon MSK Kafka เป็นบริการของ Kafka ที่มีการจัดการเต็มรูปแบบ ทําให้ง่ายต่อการตั้งค่า การปรับขนาด และการจัดการ โดยการรวม Amazon MSK Kafka เป็นแหล่งข้อมูลภายในเหตุการณ์ของคุณ คุณสามารถนําเหตุการณ์แบบเรียลไทม์จาก MSK Kafka ของคุณและประมวลผลก่อนกําหนดเส้นทางไปยังปลายทางหลายแห่งภายใน Fabric ได้อย่างราบรื่น |

| ข้อมูลตัวอย่าง | คุณสามารถเลือกเหตุการณ์จักรยาน รถแท็กซี่สีเหลือง หรือตลาดสินค้าคงคลังเป็นแหล่งข้อมูลตัวอย่างเพื่อทดสอบการนําเข้าข้อมูลในขณะตั้งค่าเหตุการณ์ |

| จุดสิ้นสุดแบบกําหนดเอง (นั่นคือแอปแบบกําหนดเองในความสามารถมาตรฐาน) | คุณลักษณะจุดสิ้นสุดแบบกําหนดเองช่วยให้แอปพลิเคชันหรือไคลเอ็นต์ Kafka ของคุณสามารถเชื่อมต่อกับ Eventstream โดยใช้สายอักขระการเชื่อมต่อ ช่วยให้การนําเข้าข้อมูลการสตรีมเป็นเหตุการณ์ได้อย่างราบรื่น |

| Azure Service Bus (ตัวอย่าง) | คุณสามารถนําเข้าข้อมูลจากคิว Azure Service Bus หรือการสมัครสมาชิกของหัวข้อลงใน Microsoft Fabric โดยใช้ Eventstream ได้ |

| Apache Kafka (ตัวอย่าง) | Apache Kafka เป็นโอเพนซอร์สแพลตฟอร์มแบบกระจายสําหรับการสร้างระบบข้อมูลแบบเรียลไทม์ที่ปรับขนาดได้ โดยการรวม Apache Kafka เป็นแหล่งข้อมูลภายในเหตุการณ์ของคุณ คุณสามารถนําเหตุการณ์แบบเรียลไทม์จาก Apache Kafka ของคุณได้อย่างราบรื่นและประมวลผลก่อนที่จะกําหนดเส้นทางไปยังหลายปลายทางภายใน Fabric |

| เหตุการณ์ที่เก็บข้อมูล Azure Blob (ตัวอย่าง) | เหตุการณ์ Azure Blob Storage จะถูกทริกเกอร์เมื่อไคลเอ็นต์สร้าง แทนที่ หรือลบ blob ตัวเชื่อมต่อช่วยให้คุณสามารถเชื่อมโยงเหตุการณ์ที่เก็บข้อมูล Blob ไปยัง Fabric เหตุการณ์ในฮับแบบเรียลไทม์ คุณสามารถแปลงเหตุการณ์เหล่านี้เป็นสตรีมข้อมูลแบบต่อเนื่องและแปลงได้ก่อนที่จะกําหนดเส้นทางไปยังปลายทางต่างๆ ใน Fabric |

| เหตุการณ์รายการพื้นที่ทํางานของ Fabric (ตัวอย่าง) | เหตุการณ์รายการพื้นที่ทํางานของ Fabric เป็นเหตุการณ์ Fabric ที่แยกจากกันซึ่งเกิดขึ้นเมื่อมีการเปลี่ยนแปลงในพื้นที่ทํางาน Fabric ของคุณ การเปลี่ยนแปลงเหล่านี้รวมถึงการสร้าง การอัปเดต หรือลบรายการ Fabric ด้วยสตรีมเหตุการณ์ Fabric คุณสามารถจับภาพเหตุการณ์พื้นที่ทํางาน Fabric เหล่านี้ แปลงข้อมูล และกําหนดเส้นทางไปยังปลายทางต่าง ๆ ใน Fabric เพื่อการวิเคราะห์เพิ่มเติม |

| เหตุการณ์ Fabric OneLake (ตัวอย่าง) | กิจกรรม OneLake ช่วยให้คุณสามารถสมัครสมาชิกการเปลี่ยนแปลงในไฟล์และโฟลเดอร์ใน OneLake และตอบสนองต่อการเปลี่ยนแปลงเหล่านั้นในแบบเรียลไทม์ ด้วยสตรีมเหตุการณ์ Fabric คุณสามารถจับภาพเหตุการณ์ OneLake เหล่านี้ แปลงและกําหนดเส้นทางไปยังปลายทางต่าง ๆ ใน Fabric เพื่อการวิเคราะห์เพิ่มเติม การรวมเหตุการณ์ OneLake ที่ราบรื่นภายในสตรีมเหตุการณ์ Fabric ช่วยให้คุณมีความยืดหยุ่นมากขึ้นสําหรับการตรวจสอบและวิเคราะห์กิจกรรมใน OneLake ของคุณ |

| เหตุการณ์งาน Fabric |

เหตุการณ์งานช่วยให้คุณสามารถสมัครสมาชิกการเปลี่ยนแปลงที่สร้างขึ้นเมื่อ Fabric เรียกใช้งาน ตัวอย่างเช่น คุณสามารถตอบสนองต่อการเปลี่ยนแปลงเมื่อรีเฟรชแบบจําลองความหมายเรียกใช้ไปป์ไลน์ตามกําหนดเวลาหรือเรียกใช้สมุดบันทึกได้ แต่ละกิจกรรมเหล่านี้สามารถสร้างงานที่สอดคล้องกันซึ่งจะสร้างชุดของเหตุการณ์งานที่สอดคล้องกันตามลําดับ ด้วยสตรีมเหตุการณ์ Fabric คุณสามารถจับภาพเหตุการณ์งานเหล่านี้ แปลงข้อมูล และกําหนดเส้นทางไปยังปลายทางต่าง ๆ ใน Fabric เพื่อการวิเคราะห์เพิ่มเติม การรวมเหตุการณ์งานที่ราบรื่นภายในสตรีมเหตุการณ์ Fabric ช่วยให้คุณมีความยืดหยุ่นมากขึ้นสําหรับการตรวจสอบและวิเคราะห์กิจกรรมในงานของคุณ |

หมายเหตุ

จํานวนสูงสุดของแหล่งข้อมูลและปลายทางสําหรับหนึ่งเหตุการณ์สตรีมคือ 11

เนื้อหาที่เกี่ยวข้อง

ข้อกำหนดเบื้องต้น

ก่อนที่คุณจะเริ่มต้น คุณต้องดําเนินการข้อกําหนดเบื้องต้นต่อไปนี้ให้เสร็จสมบูรณ์:

- เข้าถึงพื้นที่ทํางานในโหมดสิทธิ์การใช้งาน Fabric capacity (หรือ) โหมดสิทธิ์การใช้งานรุ่นทดลองใช้ที่มีสิทธิ์ผู้สนับสนุนหรือสูงกว่า

- หากต้องการเพิ่ม Azure Event Hubs หรือ Azure IoT Hub เป็นแหล่งข้อมูลเหตุการณ์ คุณจําเป็นต้องมีสิทธิ์ที่เหมาะสมในการเข้าถึงคีย์นโยบาย พวกเขาจะต้องสามารถเข้าถึงได้โดยสาธารณะและไม่ได้อยู่หลังไฟร์วอลล์หรือมีความปลอดภัยในเครือข่ายเสมือน

แหล่งที่มาที่สนับสนุน

สตรีมเหตุการณ์ Fabric สนับสนุนแหล่งข้อมูลต่อไปนี้ ใช้ลิงก์ในตารางเพื่อนําทางไปยังบทความที่มีรายละเอียดเพิ่มเติมเกี่ยวกับการเพิ่มแหล่งข้อมูลเฉพาะ

| ต้นทาง | คำอธิบาย |

|---|---|

| Azure Event Hubs | ถ้าคุณมีฮับเหตุการณ์ Azure คุณสามารถนําเข้าข้อมูลฮับเหตุการณ์ลงใน Microsoft Fabric โดยใช้ Eventstream ได้ |

| Azure IoT Hub | ถ้าคุณมีฮับ Azure IoT คุณสามารถนําเข้าข้อมูล IoT ลงใน Microsoft Fabric โดยใช้ Eventstream ได้ |

| ข้อมูลตัวอย่าง | คุณสามารถเลือกเหตุการณ์จักรยาน รถแท็กซี่สีเหลือง หรือตลาดสินค้าคงคลังเป็นแหล่งข้อมูลตัวอย่างเพื่อทดสอบการนําเข้าข้อมูลในขณะตั้งค่าเหตุการณ์ |

| แอปแบบกําหนดเอง | คุณลักษณะแอปแบบกําหนดเองช่วยให้แอปพลิเคชันหรือไคลเอ็นต์ Kafka ของคุณสามารถเชื่อมต่อกับ Eventstream โดยใช้สายอักขระการเชื่อมต่อ ช่วยให้การนําเข้าข้อมูลการสตรีมเป็นเหตุการณ์ได้อย่างราบรื่น |

หมายเหตุ

จํานวนสูงสุดของแหล่งข้อมูลและปลายทางสําหรับหนึ่งเหตุการณ์สตรีมคือ 11

จัดการแหล่งข้อมูล

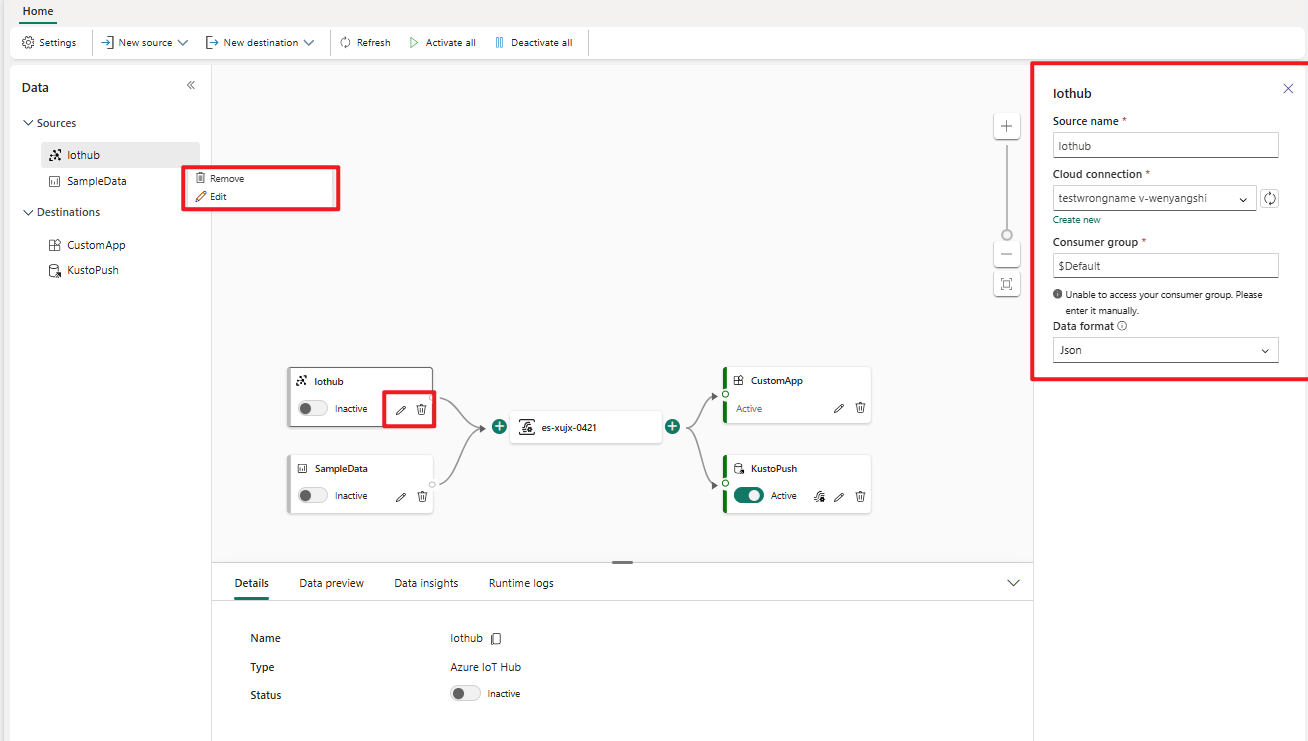

แก้ไข/ลบ: คุณสามารถเลือกแหล่งข้อมูลเหตุการณ์เพื่อแก้ไขหรือลบออกผ่านทางหน้าต่างนําทางหรือพื้นที่ทํางาน เมื่อคุณเลือก แก้ไข บานหน้าต่างแก้ไขจะเปิดขึ้นทางด้านขวาของตัวแก้ไขหลัก

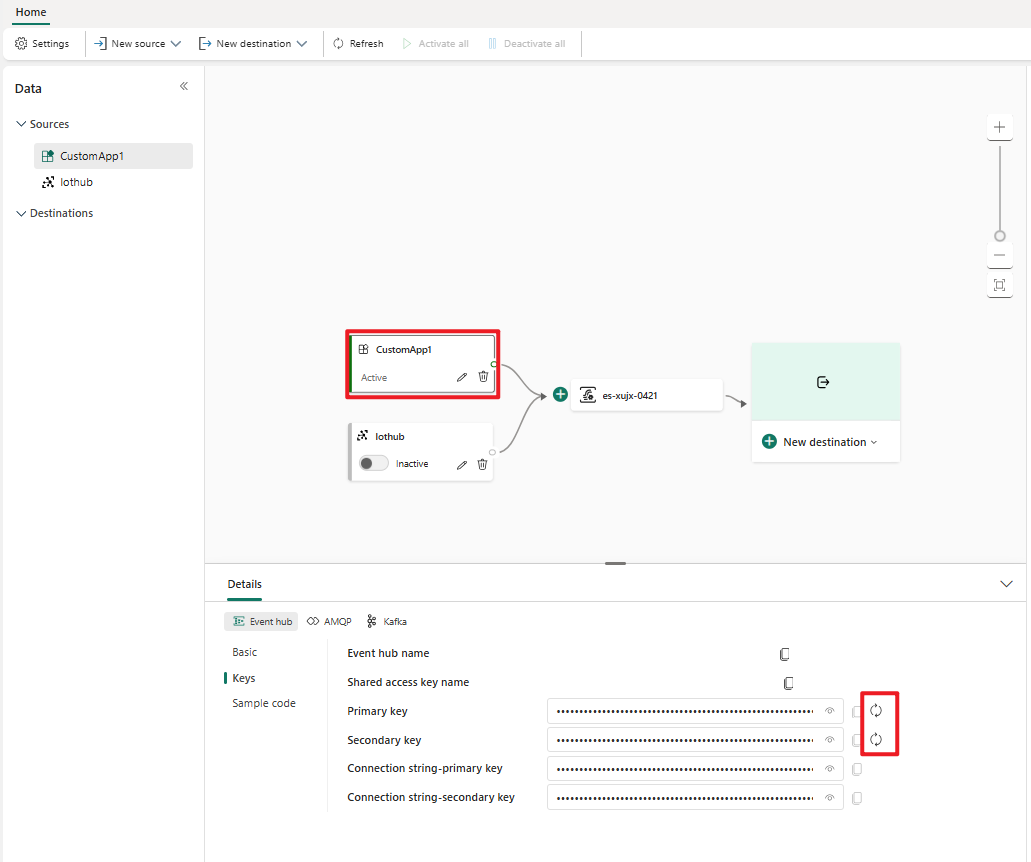

สร้างคีย์สําหรับแอปแบบกําหนดเองใหม่: ถ้าคุณต้องการสร้างคีย์การเชื่อมต่อใหม่สําหรับแอปพลิเคชันของคุณ ให้เลือกหนึ่งในแหล่งข้อมูลแอปแบบกําหนดเองของคุณบนพื้นที่ทํางาน และเลือก สร้าง ใหม่เพื่อรับคีย์การเชื่อมต่อใหม่